作者:Peter Bruce、Andrew Bruce 和 Peter Gedeck

版权所有 © 2020 Peter Bruce、Andrew Bruce 和 Peter Gedeck。保留所有权利。

在美国印刷。

由 O’Reilly Media, Inc. 出版,地址:1005 Gravenstein Highway North, Sebastopol, CA 95472。

O’Reilly 图书可用于教育、商业或销售推广用途。大多数书籍也提供在线版本(http://oreilly.com)。如需更多信息,请联系我们的企业/机构销售部门:800-998-9938 或 corporate@oreilly.com。

发布详情请参见 http://oreilly.com/catalog/errata.csp?isbn=9781492072942。

O’Reilly 标志是 O’Reilly Media, Inc. 的注册商标。《数据科学家实用统计学》、封面图像及相关商业外观均为 O’Reilly Media, Inc. 的商标。

本作品中表达的观点为作者观点,不代表出版商立场。虽然出版商和作者已尽善意努力确保本作品中包含的信息和说明准确无误,但出版商和作者对所有错误或遗漏不承担责任,包括但不限于因使用或依赖本作品而造成的损害责任。使用本作品中包含的信息和说明风险自负。如果本作品包含或描述的任何代码示例或其他技术受开源许可证或他人知识产权约束,您有责任确保您的使用符合此类许可证和/或权利。

978-1-492-07294-2

[LSI]

Peter Bruce 和 Andrew Bruce 谨将本书献给我们已故的父母 Victor G. Bruce 和 Nancy C. Bruce,他们培养了我们对数学和科学的热情;以及我们的早期导师 John W. Tukey 和 Julian Simon,还有我们的终生挚友 Geoff Watson,他们激励我们投身统计学事业。

Peter Gedeck 谨将本书献给 Tim Clark 和 Christian Kramer,深深感谢他们的科学合作和友谊。

本书面向具有一定 R 和/或 Python 编程语言基础,且曾经接触过统计学(可能是零散或短暂的)的数据科学家。两位作者从统计学领域进入数据科学世界,对统计学在数据科学艺术中所能做出的贡献有一定的认识。同时,我们也深知传统统计学教学的局限性:统计学作为一门学科已有一个半世纪的历史,大多数统计学教科书和课程都承载着如海轮般的惯性和惰性。本书中的所有方法都与统计学学科在历史或方法论上有某种联系。主要从计算机科学发展而来的方法,如neural nets,不包括在内。

本书的两个目标:

以易于理解、便于导航、易于查阅的形式列出与数据科学相关的统计学核心概念。

从数据科学的角度解释哪些概念重要且有用,哪些不那么重要,以及原因。

本书使用以下印刷约定:

表示新术语、URL、电子邮件地址、文件名和文件扩展名。

等宽字体用于程序清单,以及段落中引用程序元素,如变量或函数名、数据库、数据类型、环境变量、语句和关键字。

等宽粗体显示用户应该直接输入的命令或其他文本。

Data science 是多个学科的融合,包括统计学、计算机科学、信息技术和特定领域学科。因此,可能使用几个不同的术语来引用给定的概念。关键术语及其同义词将在全书中以此类侧边栏的形式突出显示。

此元素表示提示或建议。

此元素表示一般说明。

此元素表示警告或注意事项。

在所有情况下,本书首先给出 R 代码示例,然后是 Python 代码示例。为了避免不必要的重复,我们通常只显示由 R 代码创建的输出和图表。我们也跳过了加载所需package和数据集的代码。您可以在 https://github.com/gedeck/practical-statistics-for-data-scientists 找到完整的代码以及数据集的下载。

本书旨在帮助您完成工作。一般来说,如果本书提供了示例代码,您可以在您的程序和文档中使用它。除非您要复制代码的重要部分,否则无需联系我们获得许可。例如,编写使用本书中几个代码块的程序不需要许可。销售或分发 O’Reilly 图书中的示例需要许可。通过引用本书和引用示例代码来回答问题不需要许可。将本书中大量示例代码合并到您产品的文档中需要许可。

我们很感谢,但不要求署名。署名通常包括标题、作者、出版商和ISBN。例如:“Practical Statistics for Data Scientists by Peter Bruce, Andrew Bruce, and Peter Gedeck (O’Reilly). Copyright 2020 Peter Bruce, Andrew Bruce, and Peter Gedeck, 978-1-492-07294-2.”

如果您认为您对代码示例的使用超出了合理使用或上述许可的范围,请随时通过 permissions@oreilly.com 联系我们。

40多年来,O’Reilly Media 一直提供技术和商业培训、知识和洞察,帮助公司取得成功。

我们独特的专家和创新者网络通过书籍、文章和我们的在线学习平台分享他们的知识和专业技能。O’Reilly的在线学习平台为您提供实时培训课程、深度学习路径、交互式编程环境,以及来自O’Reilly和200多家其他出版商的大量文本和视频资源的按需访问。更多信息,请访问 http://oreilly.com。

请将有关本书的评论和问题发送给出版商:

我们为这本书建立了一个网页,在那里我们列出了勘误表、示例和任何其他信息。您可以在 https://oreil.ly/practicalStats_dataSci_2e 访问此页面。

发送邮件至 bookquestions@oreilly.com 来评论或询问有关本书的技术问题。

有关我们的书籍和课程的新闻和更多信息,请访问我们的网站 http://oreilly.com。

在Facebook上找到我们:http://facebook.com/oreilly

在Twitter上关注我们:http://twitter.com/oreillymedia

在YouTube上观看我们:http://www.youtube.com/oreillymedia

作者感谢许多帮助使这本书成为现实的人们。

数据挖掘公司Elder Research的CEO Gerhard Pilcher看过本书的早期草稿,给了我们详细和有帮助的更正和评论。同样,SAS的统计学家Anya McGuirk和Wei Xiao,以及O’Reilly作者Jay Hilfiger,对本书的初稿提供了有帮助的反馈。将第一版翻译成日语的Toshiaki Kurokawa在翻译过程中全面地进行了审查和更正工作。Aaron Schumacher和Walter Paczkowski彻底审查了本书的第二版,并提供了许多有帮助和有价值的建议,我们对此极其感激。不用说,任何遗留的错误都是我们自己的责任。

在O’Reilly,Shannon Cutt以良好的心情和适当的督促引导我们完成了出版过程,而Kristen Brown顺利地将我们的书带入了制作阶段。Rachel Monaghan和Eliahu Sussman细心耐心地更正和改进了我们的写作,而Ellen Troutman-Zaig准备了索引。Nicole Tache接管了第二版的工作,既有效地指导了整个过程,又提供了许多好的编辑建议来提高本书对广大读者的可读性。我们还要感谢Marie Beaugureau,她在O’Reilly发起了我们的项目,以及O’Reilly作者和Statistics.com讲师Ben Bengfort,他将我们介绍给了O’Reilly。

我们和这本书也受益于Peter多年来与其他书籍项目的合著者Galit Shmueli的许多对话。

最后,我们要特别感谢Elizabeth Bruce和Deborah Donnell,她们的耐心和支持使这项工作成为可能。

本章重点关注任何数据科学项目的第一步:探索数据。

古典统计学几乎完全专注于推断(inference),这是一套有时复杂的程序集合,用于基于小样本对大总体得出结论。1962年,John W. Tukey([图 1-1])在他的开创性论文《数据分析的未来》中呼吁对统计学进行改革。他提出了一个称为数据分析(data analysis)的新科学学科,其中统计推断仅是其中一个组成部分。Tukey与工程和计算机科学社区建立了联系(他创造了bit一词,是binary digit的缩写,以及software一词),他的原始原则出人意料地持久,并构成了数据科学基础的一部分。探索性数据分析(exploratory data analysis)领域随着Tukey 1977年的经典著作《探索性数据分析》而建立。Tukey提出了简单的图表(例如,箱线图、散点图),这些图表与汇总统计量(均值、中位数、分位数等)一起,有助于描绘数据集的图像。

随着计算能力的便利可用性和表达性数据分析软件的出现,探索性数据分析已经远远超越了其原始范围。这一学科的主要驱动力是新技术的快速发展、对更多更大数据的访问,以及在各种学科中更多地使用定量分析。斯坦福大学统计学教授、Tukey的前本科学生David Donoho,基于他在新泽西州普林斯顿Tukey百年纪念研讨会上的演讲撰写了一篇优秀文章。Donoho追溯了数据科学的起源,可以追溯到Tukey在数据分析方面的开创性工作。

数据来自许多来源:传感器测量、事件、文本、图像和视频。物联网(Internet of Things, IoT)正在喷涌出信息流。这些数据大部分是非结构化的:图像是像素的集合,每个像素包含RGB(红、绿、蓝)颜色信息。文本是单词和非单词字符的序列,通常按章节、小节等组织。点击流是用户与应用程序或网页交互的操作序列。实际上,数据科学的一个主要挑战是将这种原始数据洪流转化为可操作的信息。要应用本书涵盖的统计概念,非结构化原始数据必须被加工和处理成结构化形式。结构化数据最常见的形式之一是带有行和列的表格——正如数据可能来自关系数据库或为研究而收集的数据。

结构化数据有两种基本类型:数值型(numeric)和分类型(categorical)。数值型数据有两种形式:连续型(continuous),例如风速或持续时间,以及离散型(discrete),例如事件发生的计数。分类型(categorical)数据只取固定的值集合,例如电视屏幕类型(等离子、LCD、LED等)或州名(阿拉巴马州、阿拉斯加州等)。二元型(binary)数据是分类数据的一个重要特例,只取两个值中的一个,例如0/1、是/否或真/假。另一种有用的分类数据类型是序数型(ordinal)数据,其中类别是有序的;一个例子是数值评级(1、2、3、4或5)。

为什么我们要费心建立数据类型的分类法? 事实证明,对于数据分析和预测建模的目的而言,数据类型对于帮助确定视觉显示、数据分析或统计模型的类型非常重要。实际上,数据科学软件,如R和Python,使用这些数据类型来提高计算性能。更重要的是,变量的数据类型决定了软件如何处理该变量的计算。

在数值尺度上表达的数据。

可以在一个区间内取任何值的数据。(同义词: interval, float, numeric)

只能取整数值的数据,如计数。(同义词: integer, count)

只能取特定值集合的数据,表示一组可能的类别。(同义词: enums, enumerated, factors, nominal)

分类数据的一种特殊情况,只有两个类别的值,例如0/1、true/false。(同义词: dichotomous, logical, indicator, boolean)

具有明确排序的分类数据。(同义词: ordered factor)

软件工程师和数据库程序员可能会疑惑,为什么我们在分析中甚至需要分类型和有序型数据的概念。 毕竟,类别只是文本(或数值)值的集合,底层数据库会自动处理内部表示。然而,明确识别数据为分类型,与文本区分开来,确实提供了一些优势:

知道数据是分类型的可以作为一个信号,告诉软件统计程序(如生成图表或拟合模型)应该如何行为。特别是,有序数据可以在R中表示为ordered.factor,在图表、表格和模型中保持用户指定的排序。在Python中,scikit-learn通过sklearn.preprocessing.OrdinalEncoder支持有序数据。

存储和索引可以被优化(如在关系数据库中)。

给定分类变量可以取的可能值在软件中被强制执行(如enum)。

第三个”好处”可能导致意外或不期望的行为:R中数据导入函数(例如read.csv)的默认行为是自动将文本列转换为factor。

对该列的后续操作将假设该列只允许最初导入的值,分配新的文本值将引入警告并产生NA(缺失值)。Python中的pandas包不会自动进行这种转换。但是,您可以在read_csv函数中明确指定列为分类型。

数据通常在软件中按类型分类。

数据类型包括数值型(连续型、离散型)和分类型(二元型、有序型)。

软件中的数据类型作为软件如何处理数据的信号。

pandas文档描述了不同的数据类型以及如何在Python中操作它们。

数据类型可能令人困惑,因为类型可能重叠,一个软件中的分类法可能与另一个软件中的不同。 R

Tutorial网站涵盖了R的分类法。pandas文档描述了不同的数据类型以及如何在Python中操作它们。

数据库在数据类型分类方面更加详细,包含精度级别、固定或可变长度字段等考虑因素;参见W3Schools SQL指南。

数据科学分析的典型参考框架是一个矩形数据对象,如电子表格或数据库表。

矩形数据是二维矩阵的通用术语,行表示记录(案例),列表示特性(变量);data frame是R和Python中的特定格式。数据并不总是以这种形式开始:非结构化数据(如文本)必须经过处理和操作,以便可以在矩形数据中表示为一组特性(参见[“结构化数据的要素”])。关系数据库中的数据必须提取并放入单个表中,用于大多数数据分析和建模任务。

矩形数据(如电子表格)是统计和机器学习模型的基本数据结构。

表中的列通常称为feature。

attribute, input, predictor, variable

许多数据科学项目涉及预测一个outcome——通常是是/否结果(在表1-1中,它是”拍卖是否竞争激烈”)。features有时用于在实验或研究中预测outcome。

dependent variable, response, target, output

表中的行通常称为record。

case, example, instance, observation, pattern, sample

| Category | currency | sellerRating | Duration | endDay | ClosePrice | OpenPrice | Competitive? |

|---|---|---|---|---|---|---|---|

| Music/Movie/Game | US | 3249 | 5 | Mon | 0.01 | 0.01 | 0 |

| Music/Movie/Game | US | 3249 | 5 | Mon | 0.01 | 0.01 | 0 |

| Automotive | US | 3115 | 7 | Tue | 0.01 | 0.01 | 0 |

| Automotive | US | 3115 | 7 | Tue | 0.01 | 0.01 | 0 |

| Automotive | US | 3115 | 7 | Tue | 0.01 | 0.01 | 0 |

| Automotive | US | 3115 | 7 | Tue | 0.01 | 0.01 | 0 |

| Automotive | US | 3115 | 7 | Tue | 0.01 | 0.01 | 1 |

| Automotive | US | 3115 | 7 | Tue | 0.01 | 0.01 | 1 |

在表1-1中,有测量或计数数据(如持续时间和价格)和分类数据(如类别和货币)的混合。如前所述,分类变量的一种特殊形式是二元(是/否或0/1)变量,见表1-1最右列——一个指示变量,显示拍卖是否竞争激烈(有多个投标者)。当场景是预测拍卖是否竞争激烈时,这个指示变量恰好也是一个outcome变量。

传统数据库表有一个或多个列被指定为索引,本质上是行号。这可以大大提高某些数据库查询的效率。在Python中,使用pandas库,基本的矩形数据结构是DataFrame对象。默认情况下,基于行的顺序为DataFrame创建自动整数索引。在pandas中,还可以设置多级/分层索引来提高某些操作的效率。

在R中,基本的矩形数据结构是data.frame对象。data.frame也有基于行顺序的隐式整数索引。原生R

data.frame不支持用户指定或多级索引,尽管可以通过row.names属性创建自定义键。为了克服这一不足,两个新包正获得广泛使用:data.table和dplyr。两者都支持多级索引,并在处理data.frame时提供显著的速度提升。

矩形数据的术语可能会令人困惑。统计学家和数据科学家对同一事物使用不同的术语。对统计学家来说,predictor variables(预测变量)用于模型中预测response(响应)或dependent variable(因变量)。对数据科学家来说,features(特征)用于预测target(目标)。有一个同义词特别令人困惑:计算机科学家会使用术语sample(样本)来指代单行数据;而对统计学家来说,sample(样本)意味着行的集合。

除了矩形数据之外还有其他数据结构。

时间序列数据记录同一变量的连续测量值。它是统计预测方法的原材料,也是设备产生数据的关键组成部分——物联网。

空间数据结构用于地图和位置分析,比矩形数据结构更复杂且更多样化。在object(对象)表示法中,数据的焦点是一个对象(例如,一栋房子)及其空间坐标。相比之下,field(场)视图关注小的空间单元和相关指标的值(例如像素亮度)。

图(或网络)数据结构用于表示物理、社会和抽象关系。例如,社交网络(如Facebook或LinkedIn)的图可能表示网络中人与人之间的连接。通过道路连接的配送中心是物理网络的一个例子。图结构对某些类型的问题很有用,如网络优化和推荐系统。

这些数据类型中的每一种在数据科学中都有其专门的方法论。本书的重点是矩形数据,这是预测建模的基本构建块。

在计算机科学和信息技术中,术语graph(图)通常指实体间连接的描述,以及底层数据结构。在统计学中,graph(图)用于指代各种图表和visualizations(可视化),不仅仅是实体间的连接,该术语仅适用于可视化,而不适用于数据结构。

数据科学中的基本数据结构是矩形矩阵,其中行是记录,列是变量(特征)。

术语可能令人困惑;由于对数据科学有贡献的不同学科(统计学、计算机科学和信息技术),存在各种同义词。

具有测量或计数数据的变量可能有成千上万个不同的值。探索数据的基本步骤是获得每个特征(变量)的”典型值”:对大部分数据所在位置(即其中心趋势)的估计。

所有值的总和除以值的数量。

平均值

所有值乘以权重的总和除以权重的总和。

加权平均值

使得一半数据位于其上方和下方的值。

第50百分位数

使得P百分比的数据位于其下方的值。

分位数

使得权重总和的一半位于排序数据的上方和下方的值。

去除固定数量极值后所有值的平均值。

截断均值

对极值不敏感。

抗性的

与大多数数据差异很大的数据值。

极值

乍一看,数据汇总似乎相当简单:只需取数据的均值即可。实际上,虽然均值易于计算且使用方便,但它可能并不总是衡量中心值的最佳指标。因此,统计学家已经开发并推广了几种均值的替代估计方法。

统计学家经常使用术语估计值来表示从手头数据计算出的值,以区分我们从数据中看到的内容与理论上真实或确切的情况。数据科学家和业务分析师更倾向于将这样的值称为指标。这种差异反映了统计学与数据科学方法的不同:不确定性的考虑是统计学学科的核心,而具体的业务或组织目标是数据科学的重点。因此,统计学家进行估计,数据科学家进行测量。

位置的最基本估计是均值,即平均值。均值是所有值的总和除以值的数量。考虑以下数字集合:{3 5 1 2}。均值是(3 + 5 + 1 + 2) / 4 = 11 / 4 = 2.75。你会遇到符号(读作”x-bar”)用来表示总体样本的均值。计算一组n个值的均值公式是:

N(或n)指的是记录或观测值的总数。在统计学中,如果指的是总体,则大写;如果指的是总体的样本,则小写。在数据科学中,这种区别并不重要,所以你可能会看到两种形式。

均值的一个变体是修剪均值(trimmed mean),它通过在每端去除固定数量的排序值,然后取剩余值的平均值来计算。用排序值表示,其中是最小值,是最大值,去除最小和最大值的修剪均值计算公式是:

修剪均值消除了极值的影响。例如,在国际跳水比赛中,从五位裁判的评分中去除最高分和最低分,最终得分是剩余三位裁判评分的平均值。这使得单个裁判难以操纵分数,可能偏向本国选手。修剪均值被广泛使用,在许多情况下比使用普通均值更可取——参见[“中位数和稳健估计”]了解进一步讨论。

另一种均值类型是加权均值(weighted mean),它通过将每个数据值乘以用户指定的权重,然后将它们的总和除以权重的总和来计算。加权均值的公式是:

使用加权平均值的两个主要动机:

某些值本质上比其他值更具有可变性,高度可变的观察值被赋予较低的权重。例如,如果我们从多个传感器获取平均值,而其中一个传感器精度较低,那么我们可能会降低来自该传感器的数据权重。

收集的数据并不能平等地代表我们感兴趣测量的不同组别。例如,由于在线实验的进行方式,我们可能没有准确反映用户群体中所有组别的数据集。为了纠正这一点,我们可以对代表性不足的组别的数值给予更高的权重。

中位数是排序数据列表中的中间数。如果数据值是偶数个,则中间值实际上不在数据集中,而是将排序数据分为上半部分和下半部分的两个值的平均值。与使用所有观察值的平均值相比,中位数只依赖于排序数据中心的值。虽然这可能看起来是一个劣势,因为平均值对数据更加敏感,但在许多情况下,中位数是更好的位置度量指标。假设我们想要查看西雅图华盛顿湖周围社区的典型家庭收入。在比较梅迪纳社区和温德米尔社区时,使用平均值会产生截然不同的结果,因为比尔·盖茨住在梅迪纳。如果我们使用中位数,比尔·盖茨有多富有并不重要——中间观察值的位置将保持不变。

出于使用加权平均值的相同原因,也可以计算加权中位数。与中位数一样,我们首先对数据进行排序,尽管每个数据值都有一个相关的权重。加权中位数不是中间数,而是使排序列表的下半部分和上半部分的权重之和相等的值。与中位数一样,加权中位数对异常值具有稳健性。

中位数被称为位置的稳健估计,因为它不受可能使结果偏斜的异常值(extreme cases)的影响。异常值是数据集中与其他值距离很远的任何值。异常值的确切定义有些主观,尽管在各种数据摘要和图表中使用了某些约定(参见[“百分位数和箱线图”])。异常值本身并不使数据值无效或错误(如前面比尔·盖茨的例子)。然而,异常值通常是数据错误的结果,例如混合不同单位的数据(公里与米)或传感器的错误读数。当异常值是错误数据的结果时,平均值将导致位置估计不佳,而中位数仍然有效。无论如何,应该识别异常值,通常值得进一步调查。

与典型的数据分析形成对比,在典型数据分析中异常值有时是信息性的,有时是干扰,而在异常检测中,感兴趣的点是异常值,更大的数据量主要用于定义测量异常的”正常”标准。

中位数不是唯一的稳健位置估计。实际上,修剪平均值被广泛用于避免异常值的影响。例如,修剪数据的底部和顶部10%(常见选择)将在除最小数据集之外的所有数据集中提供针对异常值的保护。修剪平均值可以被认为是中位数和平均值之间的折中:它对数据中的极值具有稳健性,但使用更多数据来计算位置估计。

统计学家已经开发了大量其他位置估计器,主要目标是开发比平均值更稳健、效率更高(即更好地辨别数据集之间的小位置差异)的估计器。虽然这些方法对小数据集可能有用,但对于大型甚至中等规模的数据集,它们不太可能提供额外的好处。

表1-2显示了包含美国各州人口和谋杀率(单位:每年每10万人的谋杀数)的数据集中的前几行(2010年人口普查)。

State Population Murder rate Abbreviation

--- ------------- ------------ ------------- --------------

1 Alabama 4,779,736 5.7 AL

2 Alaska 710,231 5.6 AK

3 Arizona 6,392,017 4.7 AZ

4 Arkansas 2,915,918 5.6 AR

5 California 37,253,956 4.4 CA

6 Colorado 5,029,196 2.8 CO

7 Connecticut 3,574,097 2.4 CT

8 Delaware 897,934 5.8 DE: 表1-2. 各州人口和谋杀率data.frame状态的几行数据

使用R计算人口的均值、截尾均值和中位数:

> state <- read.csv('state.csv')

> mean(state[['Population']])

[1] 6162876

> mean(state[['Population']], trim=0.1)

[1] 4783697

> median(state[['Population']])

[1] 4436370要在Python中计算均值和中位数,我们可以使用数据框的pandas方法。截尾均值需要使用scipy.stats中的trim_mean函数:

state = pd.read_csv('state.csv')

state['Population'].mean()

trim_mean(state['Population'], 0.1)

state['Population'].median()均值大于截尾均值,截尾均值大于中位数。

这是因为截尾均值排除了最大和最小的五个州(trim=0.1从两端各去掉10%)。如果我们要计算全国的平均谋杀率,我们需要使用加权均值或中位数来考虑各州不同的人口。由于R基础包没有加权中位数函数,我们需要安装一个包,比如matrixStats:

> weighted.mean(state[['Murder.Rate']], w=state[['Population']])

[1] 4.445834

> library('matrixStats')

> weightedMedian(state[['Murder.Rate']], w=state[['Population']])

[1] 4.4NumPy提供了加权均值。对于加权中位数,我们可以使用专门的包wquantiles:

np.average(state['Murder.Rate'], weights=state['Population'])

wquantiles.median(state['Murder.Rate'], weights=state['Population'])在这种情况下,加权均值和加权中位数大致相同。

位置的基本度量是均值,但它对极值(异常值)可能敏感。

其他度量(中位数、截尾均值)对异常值和异常分布不太敏感,因此更稳健。

维基百科关于集中趋势的文章包含了对各种位置度量的广泛讨论。

John Tukey 1977年的经典著作探索性数据分析(Pearson)至今仍被广泛阅读。

位置只是概括特征的一个维度。第二个维度,变异性,也称为离散性,衡量数据值是紧密聚集还是分散的。变异性是统计学的核心:测量它、减少它、区分随机变异性和真实变异性、识别真实变异性的各种来源,以及在其存在下做出决策。

观察值与位置估计之间的差异。

误差、残差

均值平方偏差之和除以n - 1,其中n是数据值的数量。

均方误差

方差的平方根。

与均值偏差的绝对值的平均值。

l1-norm,Manhattan norm

与中位数偏差的绝对值的中位数。

数据集中最大值和最小值之间的差异。

基于从小到大排序的数据值的度量。

ranks

使得P百分比的值取此值或更小值,(100–P)百分比的值取此值或更大值的数值。

quantile

第75百分位数与第25百分位数之间的差异。

IQR

正如测量位置有不同方法(均值、中位数等),测量变异性也有不同方法。

最广泛使用的变异估计基于位置估计与观测数据之间的差异或偏差。对于数据集{1, 4, 4},均值是3,中位数是4。与均值的偏差为:1 – 3 = –2,4 – 3 = 1,4 – 3 = 1。这些偏差告诉我们数据围绕中心值的分散程度。

测量变异性的一种方法是估计这些偏差的典型值。对偏差本身求平均值并不能告诉我们太多信息——负偏差抵消了正偏差。实际上,与均值偏差的总和恰好为零。相反,一个简单的方法是取与均值偏差绝对值的平均值。在前面的例子中,偏差的绝对值是{2 1 1},它们的平均值是(2 + 1 + 1) / 3 = 1.33。这被称为mean absolute deviation,计算公式为:

其中是样本均值。

最著名的变异性估计是variance和standard deviation,它们基于平方偏差。Variance是平方偏差的平均值,standard deviation是variance的平方根:

Standard deviation比variance更容易解释,因为它与原始数据的尺度相同。尽管如此,由于其更复杂和不太直观的公式,standard deviation在统计学中比mean absolute deviation更受青睐可能看起来很奇怪。它的重要地位源于统计理论:从数学角度来说,处理平方值比绝对值方便得多,特别是对于统计模型。

在统计学教科书中,总是有一些关于为什么我们在variance公式的分母中使用n – 1而不是n的讨论,这引出了自由度的概念。这种区别并不重要,因为n通常足够大,无论你除以n还是n – 1都不会有太大差别。但如果你感兴趣,以下是原因。这基于你想要根据样本对总体进行估计的前提。

如果你在variance公式中使用直观的分母n,你将低估总体中variance和standard deviation的真实值。这被称为有偏估计。然而,如果你除以n – 1而不是n,variance就变成了无偏估计。

要完全解释为什么使用 n 会导致有偏估计,需要涉及自由度的概念,它考虑了计算估计值时的约束数量。在这种情况下,有 n - 1 个自由度,因为存在一个约束:标准差的计算依赖于样本均值的计算。对于大多数问题,数据科学家不需要担心自由度问题。

方差、标准差和平均绝对偏差都不能抵抗异常值和极值的影响(参见“中位数和稳健估计”中关于位置稳健估计的讨论)。方差和标准差对异常值特别敏感,因为它们基于平方偏差。

一个变异性的稳健估计是中位数绝对偏差或MAD:

其中 m 是中位数。与中位数一样,MAD不受极值影响。也可以计算类似于修剪均值的修剪标准差(参见“均值”)。

方差、标准差、平均绝对偏差和中位数绝对偏差不是等价的估计,即使在数据来自正态分布的情况下也是如此。实际上,标准差总是大于平均绝对偏差,而平均绝对偏差本身又大于中位数绝对偏差。有时,中位数绝对偏差会乘以一个常数缩放因子,以便在正态分布情况下将MAD与标准差置于同一尺度。常用的因子1.4826意味着50%的正态分布落在范围内(例如,参见https://oreil.ly/SfDk2)。

估计离散程度的另一种方法是基于观察排序数据的分布。基于排序(排名)数据的统计量称为顺序统计量。最基本的度量是范围:最大值和最小值之间的差值。最小值和最大值本身很有用,有助于识别异常值,但范围对异常值极其敏感,作为数据离散程度的一般度量不是很有用。

为了避免对异常值的敏感性,我们可以在从两端去除值后观察数据的范围。形式上,这些类型的估计基于百分位数之间的差值。在数据集中,第P个百分位数是这样一个值:至少P百分比的值取这个值或更小,至少(100 - P)百分比的值取这个值或更大。例如,要找到第80个百分位数,先对数据排序。然后,从最小值开始,前进到最大值的80%位置。注意中位数与第50个百分位数是同一概念。百分位数本质上与分位数相同,分位数用分数索引(所以0.8分位数与第80个百分位数相同)。

变异性的常见度量是第25个百分位数和第75个百分位数之间的差值,称为四分位距(或IQR)。这里是一个简单的示例:{3,1,5,3,6,7,2,9}。我们将其排序得到{1,2,3,3,5,6,7,9}。第25个百分位数是2.5,第75个百分位数是6.5,所以四分位距是6.5 - 2.5 = 4。软件可能采用略有不同的方法产生不同的答案(参见以下提示);通常,这些差异较小。

对于非常大的数据集,计算精确的百分位数在计算上可能非常昂贵,因为它需要对所有数据值进行排序。机器学习和统计软件使用特殊算法,如[Zhang-Wang-2007],来获得可以非常快速计算并保证具有一定精度的近似百分位数。

如果我们有偶数个数据(n是偶数),那么在前面的定义下百分位数是模糊的。实际上,我们可以取阶次统计量和之间的任何值,其中j满足:

形式上,百分位数是加权平均:

对于0到1之间的某个权重w。统计软件在选择w时有略微不同的方法。实际上,R函数quantile提供了九种不同的替代方法来计算quantile。除了小数据集,您通常不需要担心百分位数的精确计算方式。在撰写本文时,Python的numpy.quantile仅支持一种方法,即线性插值。

表1-3(为方便起见从表1-2重复)显示了包含每个州人口和谋杀率数据集的前几行。

| 州 | 人口 | 谋杀率 | 缩写 | |

|---|---|---|---|---|

| 1 | Alabama | 4,779,736 | 5.7 | AL |

| 2 | Alaska | 710,231 | 5.6 | AK |

| 3 | Arizona | 6,392,017 | 4.7 | AZ |

| 4 | Arkansas | 2,915,918 | 5.6 | AR |

| 5 | California | 37,253,956 | 4.4 | CA |

| 6 | Colorado | 5,029,196 | 2.8 | CO |

| 7 | Connecticut | 3,574,097 | 2.4 | CT |

| 8 | Delaware | 897,934 | 5.8 | DE |

使用R内置函数计算标准差、四分位距(IQR)和绝对中位差(MAD),我们可以计算州人口数据的变异性估计:

> sd(state[['Population']])

[1] 6848235

> IQR(state[['Population']])

[1] 4847308

> mad(state[['Population']])

[1] 3849870pandas数据框提供了计算标准差和quantiles的方法。使用quantiles,我们可以轻松确定IQR。对于robust

MAD,我们使用statsmodels包中的robust.scale.mad函数:

state['Population'].std()

state['Population'].quantile(0.75) - state['Population'].quantile(0.25)

robust.scale.mad(state['Population'])标准差几乎是MAD的两倍(在R中,默认情况下,MAD的尺度被调整为与均值相同的尺度)。这并不奇怪,因为标准差对异常值敏感。

方差和标准差是最广泛和常规报告的变异性统计量。

两者都对异常值敏感。

更robust的指标包括平均绝对偏差、绝对中位差和百分位数(quantiles)。

我们涵盖的每个估计都用单个数字来总结数据,以描述数据的位置或变异性。探索数据的整体分布情况也很有用。

Tukey引入的一种快速可视化数据分布的图表。

box and whiskers plot

数值数据值落入一组区间(bins)的计数统计表。

以 x 轴表示组距、y 轴表示计数(或比例)的频数表图形。虽然视觉上相似,但柱状图不应与直方图混淆。参见[“探索二元和分类数据”]了解两者差异的讨论。

直方图的平滑版本,通常基于核密度估计 (kernel density estimate)。

在[“基于百分位数的估计”]中,我们探讨了如何使用百分位数来衡量数据的离散程度。百分位数对于总结整个分布也很有价值。通常报告四分位数(第25、50、75百分位数)和十分位数(第10、20、…、90百分位数)。百分位数对于总结分布的尾部(外围范围)特别有价值。流行文化创造了one-percenters这个词来指代财富处于第99百分位数顶端的人群。

[表 1-4]

显示了各州谋杀率的一些百分位数。在R中,这可以通过quantile函数生成:

quantile(state[['Murder.Rate']], p=c(.05, .25, .5, .75, .95))

5% 25% 50% 75% 95%

1.600 2.425 4.000 5.550 6.510Python中的pandas data

frame方法quantile提供了同样的功能:

state['Murder.Rate'].quantile([0.05, 0.25, 0.5, 0.75, 0.95])| 5% | 25% | 50% | 75% | 95% |

|---|---|---|---|---|

| 1.60 | 2.42 | 4.00 | 5.55 | 6.51 |

中位数是每10万人中有4起谋杀案,但存在相当大的变异性:第5百分位数仅为1.6,第95百分位数为6.51。

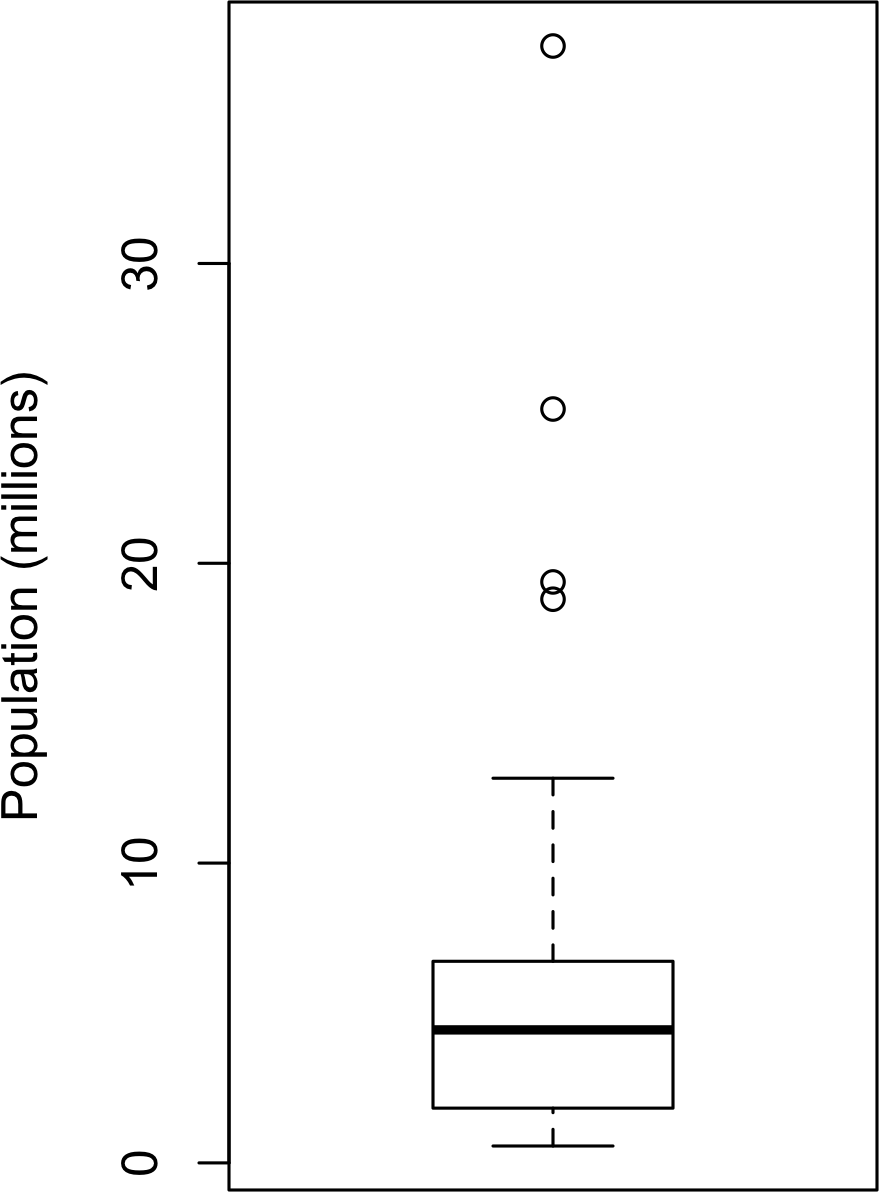

箱线图 (Boxplots)由Tukey引入,基于百分位数,提供了一种快速可视化数据分布的方法。[图 1-2] 显示了R生成的各州人口箱线图:

boxplot(state[['Population']]/1000000, ylab='Population (millions)')pandas为data

frame提供了许多基本的探索性图表;其中之一就是箱线图:

ax = (state['Population']/1_000_000).plot.box()

ax.set_ylabel('Population (millions)')

从这个箱线图我们可以立即看出,各州人口的中位数约为500万,一半的州人口在约200万到约700万之间,还有一些高人口离群值。箱子的顶部和底部分别是第75和第25百分位数。中位数由箱子中的水平线表示。从箱子顶部和底部延伸出的虚线称为须线

(whiskers),表示大部分数据的范围。箱线图有许多变体;例如,参见R函数boxplot的文档。默认情况下,R函数将须线延伸到箱子外最远的点,但不会超过IQR的1.5倍。Matplotlib使用相同的实现;其他软件可能使用不同的规则。

须线之外的任何数据都会绘制为单独的点或圆圈(通常被认为是离群值)。

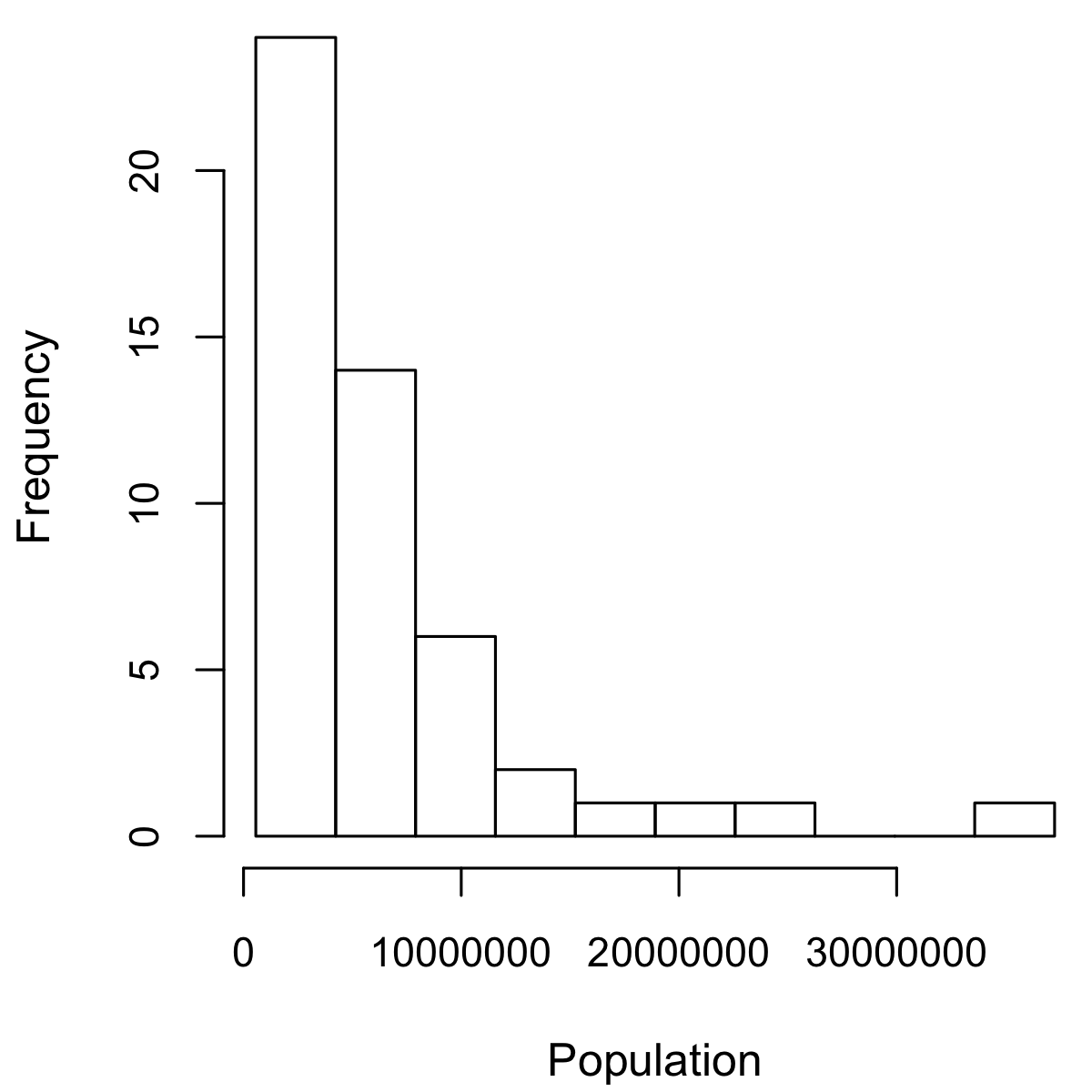

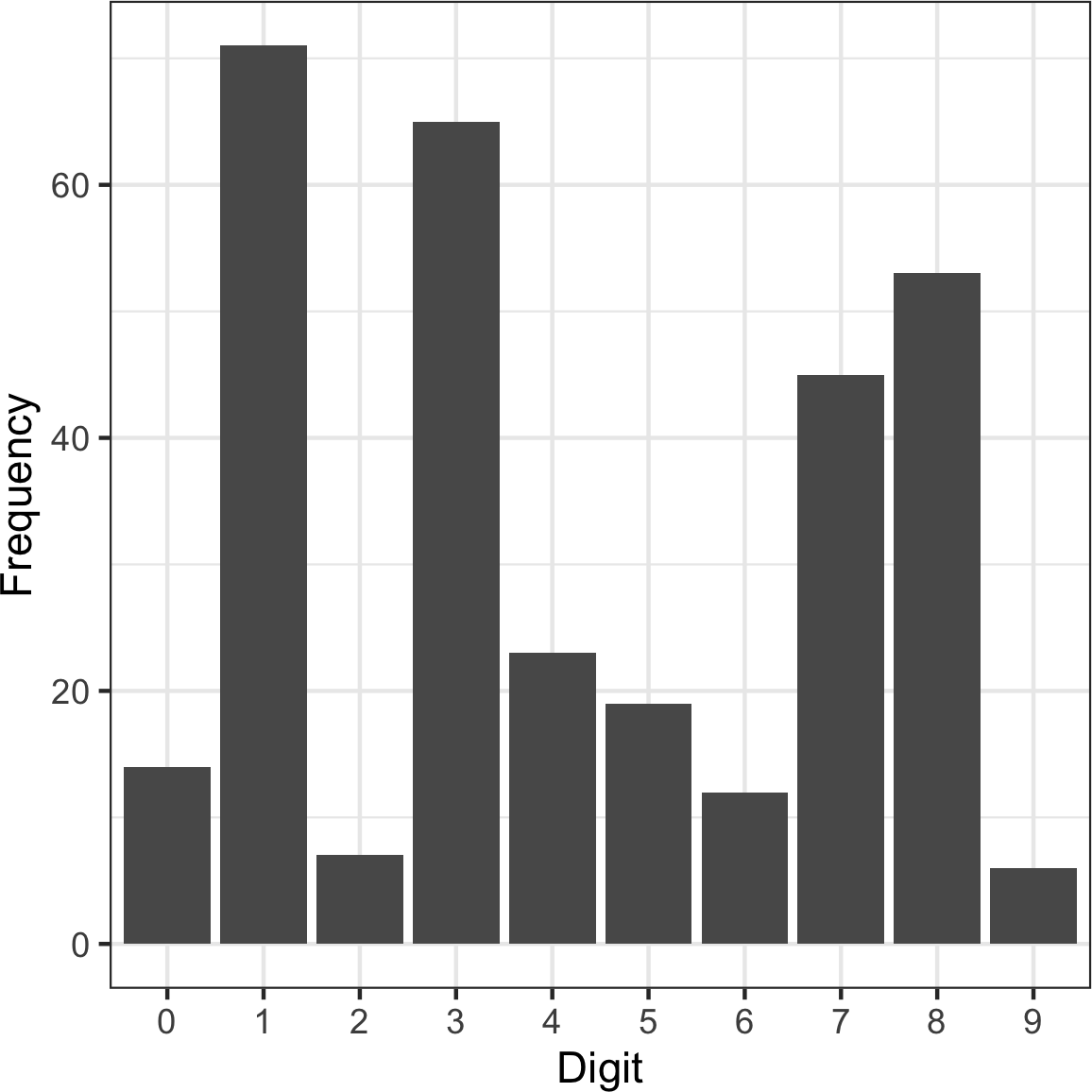

变量的频率表将变量范围划分为等间距的段,并告诉我们有多少值落在每个段内。[表1-5]显示了在R中计算的各州人口频率表:

breaks <- seq(from=min(state[['Population']]),

to=max(state[['Population']]), length=11)

pop_freq <- cut(state[['Population']], breaks=breaks,

right=TRUE, include.lowest=TRUE)

table(pop_freq)函数pandas.cut创建一个将值映射到段中的series。使用value_counts方法,我们得到频率表:

binnedPopulation = pd.cut(state['Population'], 10)

binnedPopulation.value_counts()| BinNumber | BinRange | Count | States |

|---|---|---|---|

| 1 | 563,626–4,232,658 | 24 | WY,VT,ND,AK,SD,DE,MT,RI,NH,ME,HI,ID,NE,WV,NM,NV,UT,KS,AR,MS,IA,CT,OK,OR |

| 2 | 4,232,659–7,901,691 | 14 | KY,LA,SC,AL,CO,MN,WI,MD,MO,TN,AZ,IN,MA,WA |

| 3 | 7,901,692–11,570,724 | 6 | VA,NJ,NC,GA,MI,OH |

| 4 | 11,570,725–15,239,757 | 2 | PA,IL |

| 5 | 15,239,758–18,908,790 | 1 | FL |

| 6 | 18,908,791–22,577,823 | 1 | NY |

| 7 | 22,577,824–26,246,856 | 1 | TX |

| 8 | 26,246,857–29,915,889 | 0 | |

| 9 | 29,915,890–33,584,922 | 0 | |

| 10 | 33,584,923–37,253,956 | 1 | CA |

表1-5. 各州人口频率表

人口最少的州是Wyoming,有563,626人,人口最多的是California,有37,253,956人。这给我们一个范围37,253,956 – 563,626 = 36,690,330,我们必须将其划分为等大小的bins——比如说10个bins。使用10个等大小的bins,每个bin的宽度为3,669,033,所以第一个bin将从563,626跨越到4,232,658。相比之下,顶部的bin,33,584,923到37,253,956,只有一个州:California。California下面的两个bins是空的,直到我们到达Texas。包含空bins是很重要的;这些bins中没有值的事实是有用的信息。使用不同的bin大小进行实验也是有用的。如果它们太大,分布的重要特征可能被遮蔽。如果它们太小,结果过于细粒度,看到大局的能力就会丢失。

频率表和百分位数都通过创建bins来汇总数据。一般来说,四分位数和十分位数在每个bin中将有相同的计数(等计数bins),但bin大小会不同。相比之下,频率表在bins中会有不同的计数(等大小bins),bin大小会相同。

histogram是可视化频率表的一种方式,x轴为bins,y轴为数据计数。例如在[图1-3]中,以1000万为中心的bin大约从800万跨越到1200万,该bin中有六个州。要在R中创建对应[表1-5]的histogram,使用带有breaks参数的hist函数:

hist(state[['Population']], breaks=breaks)pandas使用DataFrame.plot.hist方法为data

frames支持histograms。使用关键字参数bins来定义bins的数量。各种plot方法返回一个axis对象,允许使用Matplotlib进一步微调可视化:

ax = (state['Population'] / 1_000_000).plot.hist(figsize=(4, 4))

ax.set_xlabel('Population (millions)')histogram如[图1-3]所示。一般来说,histograms是这样绘制的:

空bins包含在图中。

Bins具有相等的宽度。

bins的数量(或等价地,bin大小)由用户决定。

条形图是连续的——条形图之间不显示空白空间,除非有空bin。

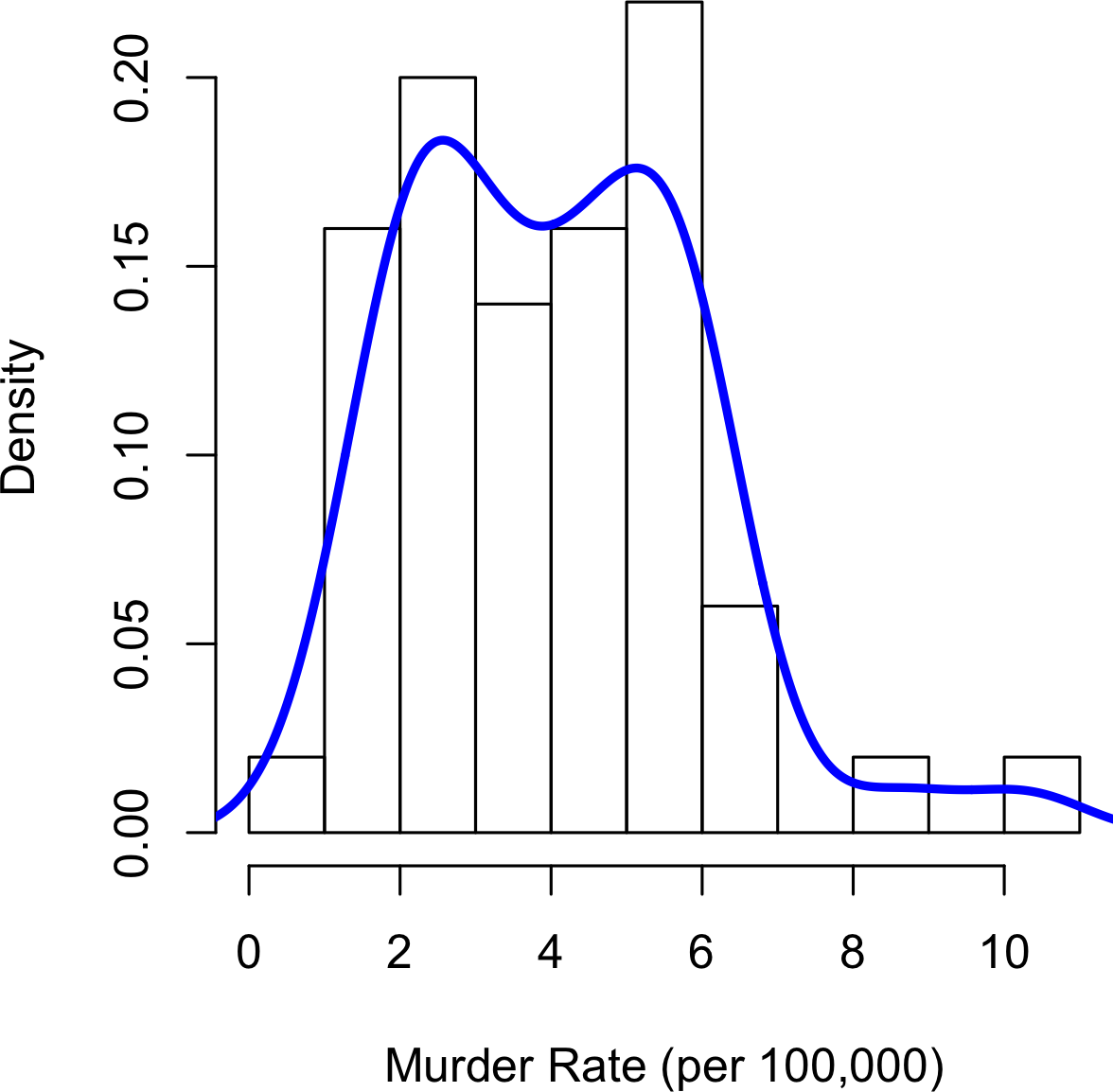

在统计学理论中,位置和变异性被称为分布的第一和第二moments。 第三和第四个moments被称为skewness和kurtosis。 Skewness指的是数据是否向较大或较小的值偏斜,而kurtosis表示数据具有极值的倾向性。通常,不使用度量来测量skewness和kurtosis;相反,这些是通过可视化显示来发现的,如图1-2和1-3所示。

与直方图相关的是密度图,它将数据值的分布显示为连续的线。 密度图可以被认为是平滑的直方图,尽管它通常通过kernel

density estimate(内核密度估计)直接从数据计算得出(参见[Duong-2001]的简短教程)。图1-4显示了叠加在直方图上的密度估计。在R中,您可以使用density函数计算密度估计:

hist(state[['Murder.Rate']], freq=FALSE)

lines(density(state[['Murder.Rate']]), lwd=3, col='blue')pandas提供了density方法来创建密度图。使用参数bw_method来控制密度曲线的平滑度:

ax = state['Murder.Rate'].plot.hist(density=True, xlim=[0,12], bins=range(1,12))

state['Murder.Rate'].plot.density(ax=ax)

ax.set_xlabel('Murder Rate (per 100,000)')

绘图函数通常接受一个可选的轴(ax)参数,这将使绘图添加到同一图形中。

与图1-3中绘制的直方图的一个关键区别是y轴的比例:密度图对应于将直方图绘制为比例而不是计数(在R中使用参数freq=FALSE指定此选项)。请注意,密度曲线下的总面积=1,而不是在箱中计数,您计算x轴上任意两点之间曲线下的面积,这对应于分布在这两点之间的比例。

密度估计是统计文献中历史悠久的丰富主题。实际上,已经发布了20多个R包,提供密度估计功能。[Deng-Wickham-2011]对R包进行了全面评述,特别推荐了ASH或KernSmooth。pandas和scikit-learn中的密度估计方法也提供了良好的实现。对于许多数据科学问题,无需担心各种类型的密度估计;使用基础函数就足够了。

频率直方图在y轴上绘制频率计数,在x轴上绘制变量值;它可以一目了然地了解数据的分布。

频率表是在直方图中找到的频率计数的表格版本。

箱线图——箱子的顶部和底部分别位于第75和第25百分位数——也能快速了解数据的分布;它经常用于并排显示以比较分布。

密度图是直方图的平滑版本;它需要一个函数来基于数据估计图形(当然,可能有多个估计)。

SUNY Oswego教授提供了一个创建箱线图的分步指南。

R中的密度估计在Henry Deng和Hadley Wickham的同名论文中有所涵盖。

R-Bloggers有一个关于R中直方图的有用帖子,包括自定义元素,如分箱(breaks)。

R-Bloggers也有一篇关于R中boxplot的类似文章。

Matthew Conlen发布了一个交互式演示,展示了选择不同kernel和bandwidth对kernel密度估计的影响。

对于分类数据,简单的比例或百分比就能讲述数据的故事。

数据集中出现最频繁的类别或值。

当类别可以与数值相关联时,这给出了基于类别出现概率的平均值。

每个类别的频率或比例以条形图的形式绘制。

每个类别的频率或比例以饼图中的扇形绘制。

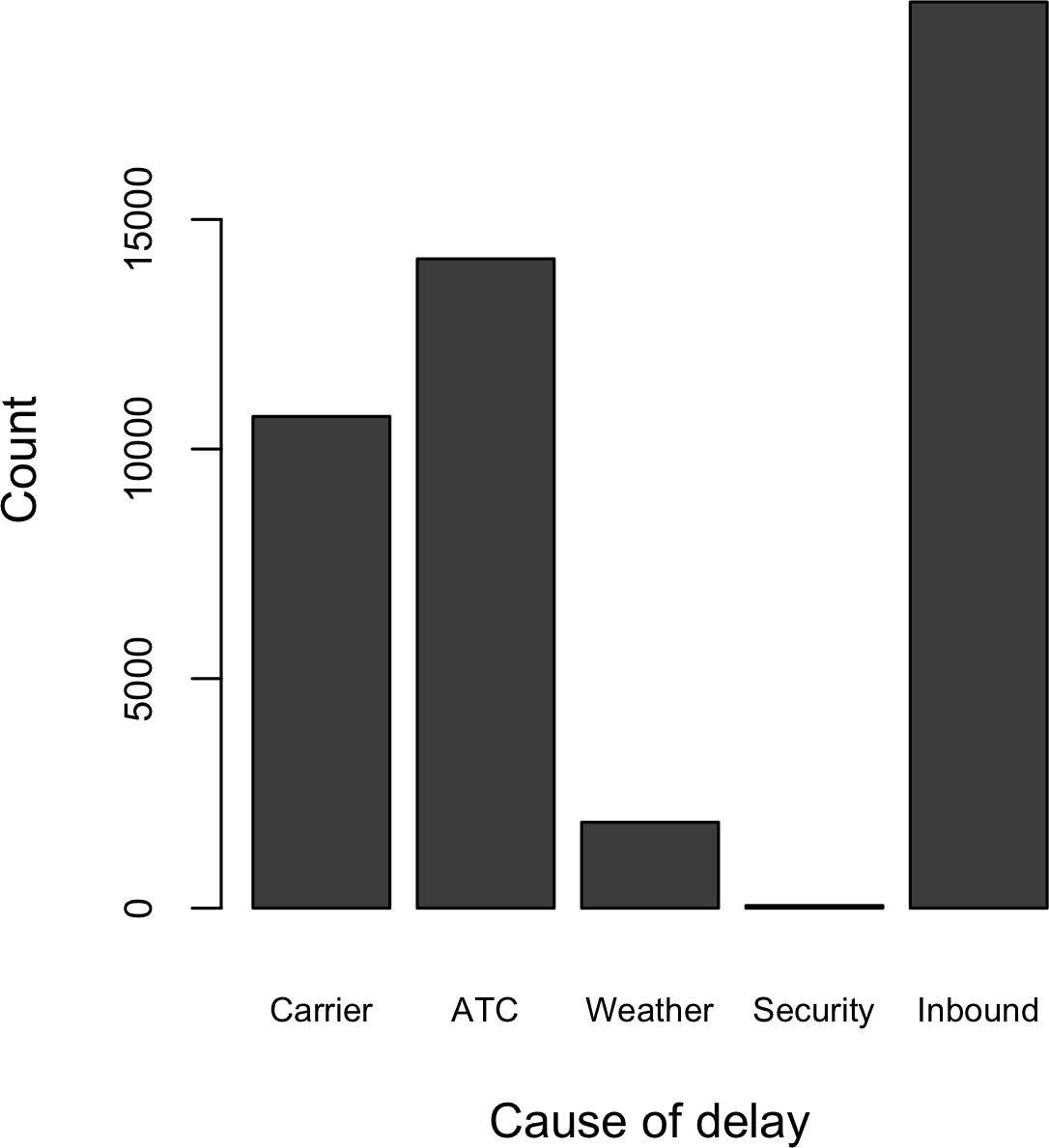

获取二元变量或具有少数几个类别的分类变量的摘要是相当容易的事情:我们只需要计算出1的比例,或重要类别的比例。例如,表1-6显示了2010年以来达拉斯/沃思堡机场按延误原因分类的延误航班百分比。延误被分类为承运人控制因素、空管系统(ATC)延误、天气、安全或晚到的入港航班等原因。

| 承运人 | ATC | 天气 | 安全 | 入港 |

|---|---|---|---|---|

| 23.02 | 30.40 | 4.03 | 0.12 | 42.43 |

Bar

charts在大众媒体中经常看到,是显示单个分类变量的常见可视化工具。类别列在x轴上,频率或比例列在y轴上。图1-5显示了达拉斯/沃思堡(DFW)按原因分类的年度机场延误情况,它是用R函数barplot生成的:

barplot(as.matrix(dfw) / 6, cex.axis=0.8, cex.names=0.7,

xlab='Cause of delay', ylab='Count')pandas也支持数据框的bar charts:

ax = dfw.transpose().plot.bar(figsize=(4, 4), legend=False)

ax.set_xlabel('Cause of delay')

ax.set_ylabel('Count')

注意bar chart类似于histogram;在bar chart中,x轴代表因子变量的不同类别,而在histogram中,x轴代表单个变量在数值尺度上的值。在histogram中,条形通常显示为相互接触,间隙表示数据中未出现的值。在bar chart中,条形彼此分离显示。

Pie charts是bar charts的替代选择,尽管统计学家和数据可视化专家通常避免使用pie charts,认为它们在视觉信息方面不够有效(参见[Few-2007])。

在“频率表和直方图”中,我们查看了基于数据分箱的频率表。这隐式地将数值数据转换为有序因子。 从这个意义上说,直方图和柱状图是相似的,除了柱状图中x轴上的类别没有排序。将数值数据转换为分类数据是数据分析中一个重要且广泛使用的步骤,因为它降低了数据的复杂性(和大小)。这有助于发现特征之间的关系,特别是在分析的初始阶段。

众数是在数据中出现最频繁的值——如果有并列的情况则是多个值。 例如,达拉斯/沃斯堡机场延误原因的众数是”入港”。再比如,在美国大部分地区,宗教偏好的众数应该是基督教。众数是分类数据的一个简单汇总统计量,通常不用于数值数据。

一种特殊类型的分类数据是其类别表示或可以映射到同一尺度上离散值的数据。 例如,一个新云技术的营销人员提供两个服务级别,一个定价为每月300美元,另一个为每月50美元。营销人员提供免费网络研讨会来产生潜在客户,公司估计5%的参与者会注册300美元的服务,15%会注册50美元的服务,80%不会注册任何服务。出于财务目的,这些数据可以汇总为一个”期望值”,这是一种加权平均的形式,其中权重是概率。

期望值的计算如下:

将每个结果乘以其发生概率。

将这些值相加。

在云服务示例中,网络研讨会参与者的期望值因此为每月22.50美元,计算如下:

期望值实际上是加权平均的一种形式:它结合了未来期望和概率权重的概念,通常基于主观判断。期望值是企业估值和资本预算中的基本概念——例如,新收购项目五年利润的期望值,或诊所新患者管理软件的期望成本节约。

我们在上面提到了一个值发生的概率。 大多数人对概率有直观的理解,在天气预报(下雨的可能性)或体育分析(获胜的概率)中经常遇到这个概念。体育和游戏更常用赔率表示,赔率可以很容易地转换为概率(如果一个团队获胜的赔率是2比1,其获胜概率为2/(2+1) = 2/3)。然而,令人惊讶的是,在定义概率概念时,它可能成为深入哲学讨论的源泉。幸运的是,我们这里不需要正式的数学或哲学定义。就我们的目的而言,事件发生的概率是如果情况可以无数次重复,它发生的次数比例。这通常是一个想象的构造,但它是对概率的充分操作理解。

分类数据通常以比例汇总,可以在柱状图中可视化。

类别可能代表不同的事物(苹果和橙子,男性和女性),因子变量的水平(低、中、高),或已分箱的数值数据。

期望值是值乘以其发生概率的总和,通常用于汇总因子变量水平。

没有一门统计学课程是完整的,如果没有关于误导性图表的课程,这通常涉及柱状图和饼图。

许多建模项目(无论是在data science还是研究中)的exploratory data analysis都涉及检查预测变量之间以及预测变量与目标变量之间的correlation。如果变量X的高值对应变量Y的高值,X的低值对应Y的低值,则称变量X和Y(每个都有测量数据)呈正相关。如果X的高值对应Y的低值,反之亦然,则变量呈负相关。

一个衡量数值变量之间关联程度的度量(范围从-1到+1)。

一个表格,其中变量显示在行和列上,单元格值是变量之间的correlation。

一个图表,其中x轴是一个变量的值,y轴是另一个变量的值。

考虑这两个变量,在每个都从低到高的意义上完全相关:

乘积的向量和是。现在尝试打乱其中一个并重新计算——乘积的向量和永远不会高于32。因此这个乘积和可以用作度量;也就是说,观察到的32可以与大量随机打乱进行比较(实际上,这个想法与基于重采样的估计相关;参见”Permutation Test”)。不过,除了参考重采样分布外,这个度量产生的值并不那么有意义。

更有用的是标准化变体:correlation coefficient,它提供了两个变量之间correlation的估计,总是位于相同的尺度上。要计算Pearson’s correlation coefficient,我们将变量1与均值的偏差乘以变量2的偏差,然后除以标准差的乘积:

注意我们除以n-1而不是n;更多详情请参见”Degrees of Freedom, and n or n-1?“。Correlation coefficient总是介于+1(完全正相关)和-1(完全负相关)之间;0表示无相关性。

变量可能有非线性的关联,在这种情况下correlation coefficient可能不是有用的度量。税率与税收收入之间的关系就是一个例子:当税率从零开始增加时,税收收入也增加。然而,一旦税率达到高水平并接近100%,避税行为增加,税收收入实际上会下降。

表1-7,称为correlation matrix,显示了2012年7月至2015年6月期间电信股票日收益之间的correlation。从表中可以看出,Verizon (VZ)和ATT (T)具有最高的correlation。Level 3 (LVLT)是一家基础设施公司,与其他公司的correlation最低。注意对角线上的1(股票与自身的correlation为1)以及对角线上方和下方信息的冗余。

| T | CTL | FTR | VZ | LVLT | |

|---|---|---|---|---|---|

| T | 1.000 | 0.475 | 0.328 | 0.678 | 0.279 |

| CTL | 0.475 | 1.000 | 0.420 | 0.417 | 0.287 |

| FTR | 0.328 | 0.420 | 1.000 | 0.287 | 0.260 |

| VZ | 0.678 | 0.417 | 0.287 | 1.000 | 0.242 |

| LVLT | 0.279 | 0.287 | 0.260 | 0.242 | 1.000 |

表1-7. 电信股票收益之间的Correlation

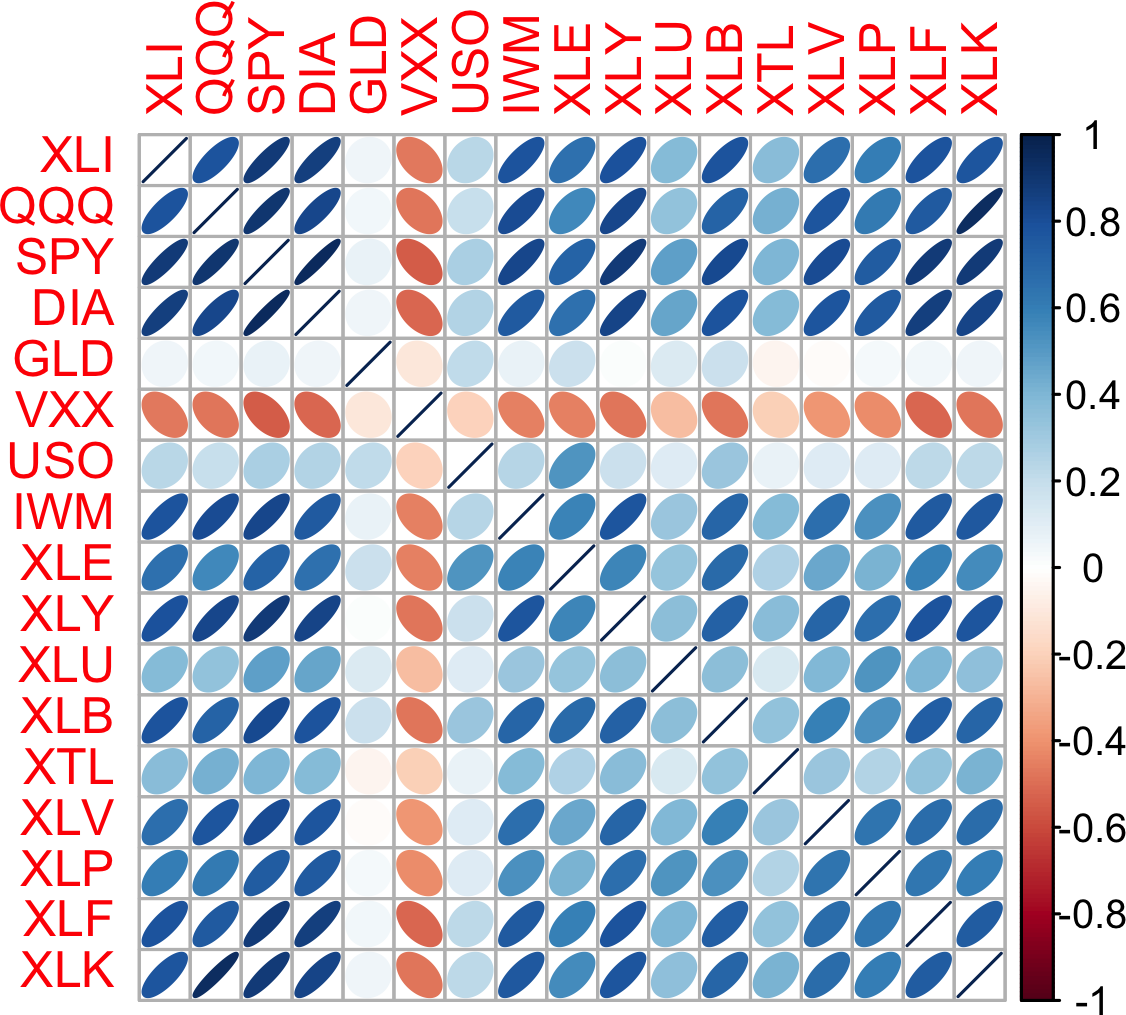

像表1-7这样的correlation表通常被绘制出来以直观显示多个变量之间的关系。图1-6显示了主要exchange-traded

funds

(ETFs)日收益之间的correlation。在R中,我们可以使用corrplot包轻松创建这个图:

etfs <- sp500_px[row.names(sp500_px) > '2012-07-01',

sp500_sym[sp500_sym$sector == 'etf', 'symbol']]

library(corrplot)

corrplot(cor(etfs), method='ellipse')在Python中创建相同的图是可能的,但在常见包中没有实现。然而,大多数都支持使用热力图(heatmaps)可视化correlation

matrices。以下代码使用seaborn.heatmap包演示了这一点。在随附的源代码库中,我们包含了生成更全面可视化的Python代码:

etfs = sp500_px.loc[sp500_px.index > '2012-07-01',

```python

sp500_sym[sp500_sym['sector'] == 'etf']['symbol']]

sns.heatmap(etfs.corr(), vmin=-1, vmax=1,

cmap=sns.diverging_palette(20, 220, as_cmap=True))S&P 500的ETF(SPY)和道琼斯指数的ETF(DIA)具有高度相关性。同样,主要由科技公司组成的QQQ和XLK呈正相关。防御性ETF,如追踪黄金价格(GLD)、石油价格(USO)或市场波动率(VXX)的ETF,往往与其他ETF呈弱相关或负相关。椭圆的方向表示两个变量是正相关(椭圆指向右上方)还是负相关(椭圆指向左上方)。椭圆的阴影和宽度表示关联强度:更细更暗的椭圆对应更强的关系。

与均值和标准差一样,相关系数对数据中的异常值很敏感。软件包提供了经典相关系数的robust替代方案。例如,R包robust使用函数covRob来计算相关性的robust估计。scikit-learn模块sklearn.covariance中的方法实现了各种方法。

统计学家很久以前就提出了其他类型的相关系数,如Spearman’s rho或Kendall’s tau。这些是基于数据排名的相关系数。由于它们使用排名而不是数值,这些估计对异常值具有鲁棒性,并且可以处理某些类型的非线性关系。然而,数据科学家通常可以坚持使用Pearson相关系数及其robust替代方案进行探索性分析。基于排名的估计主要适用于较小的数据集和特定的假设检验。

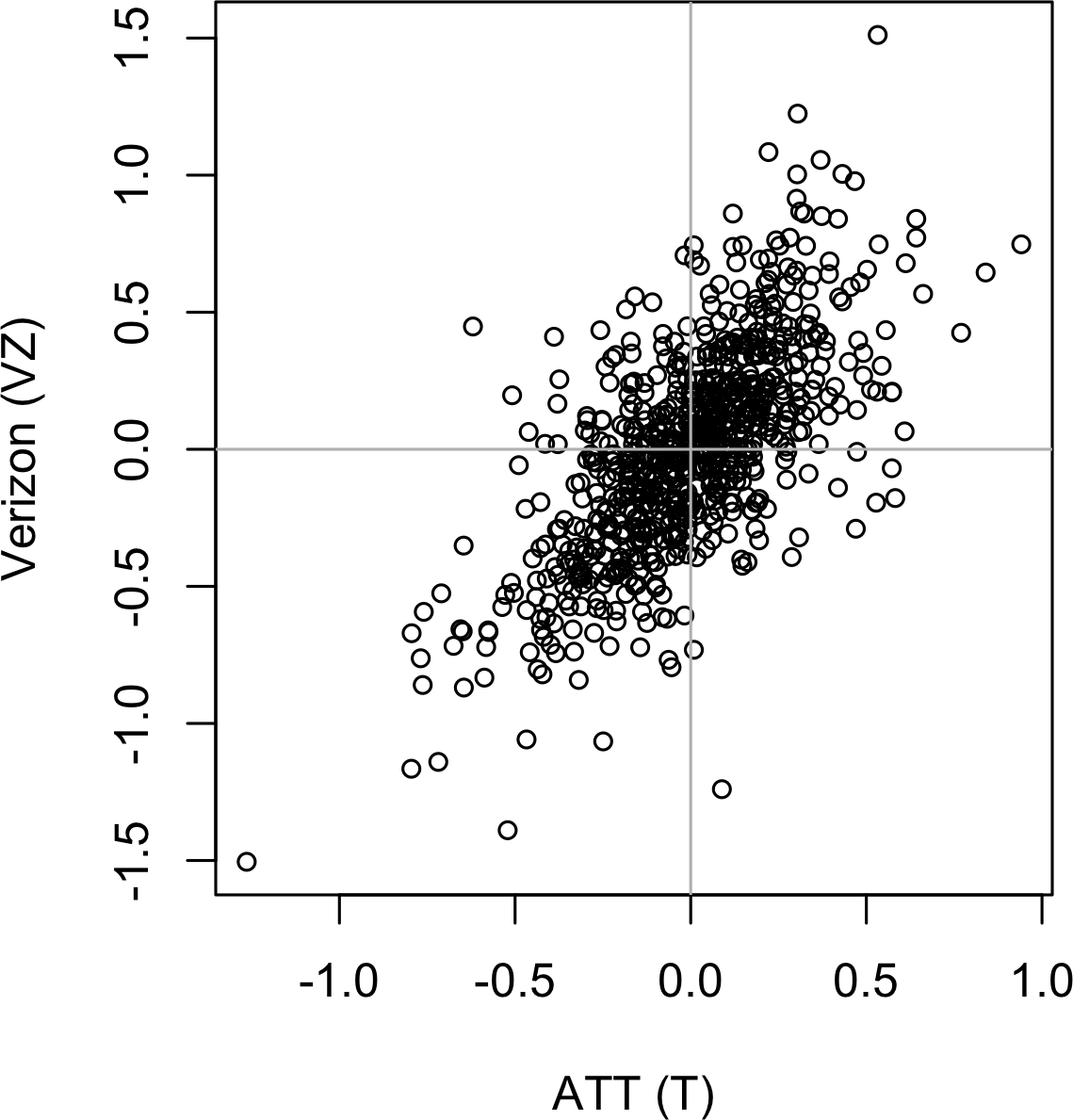

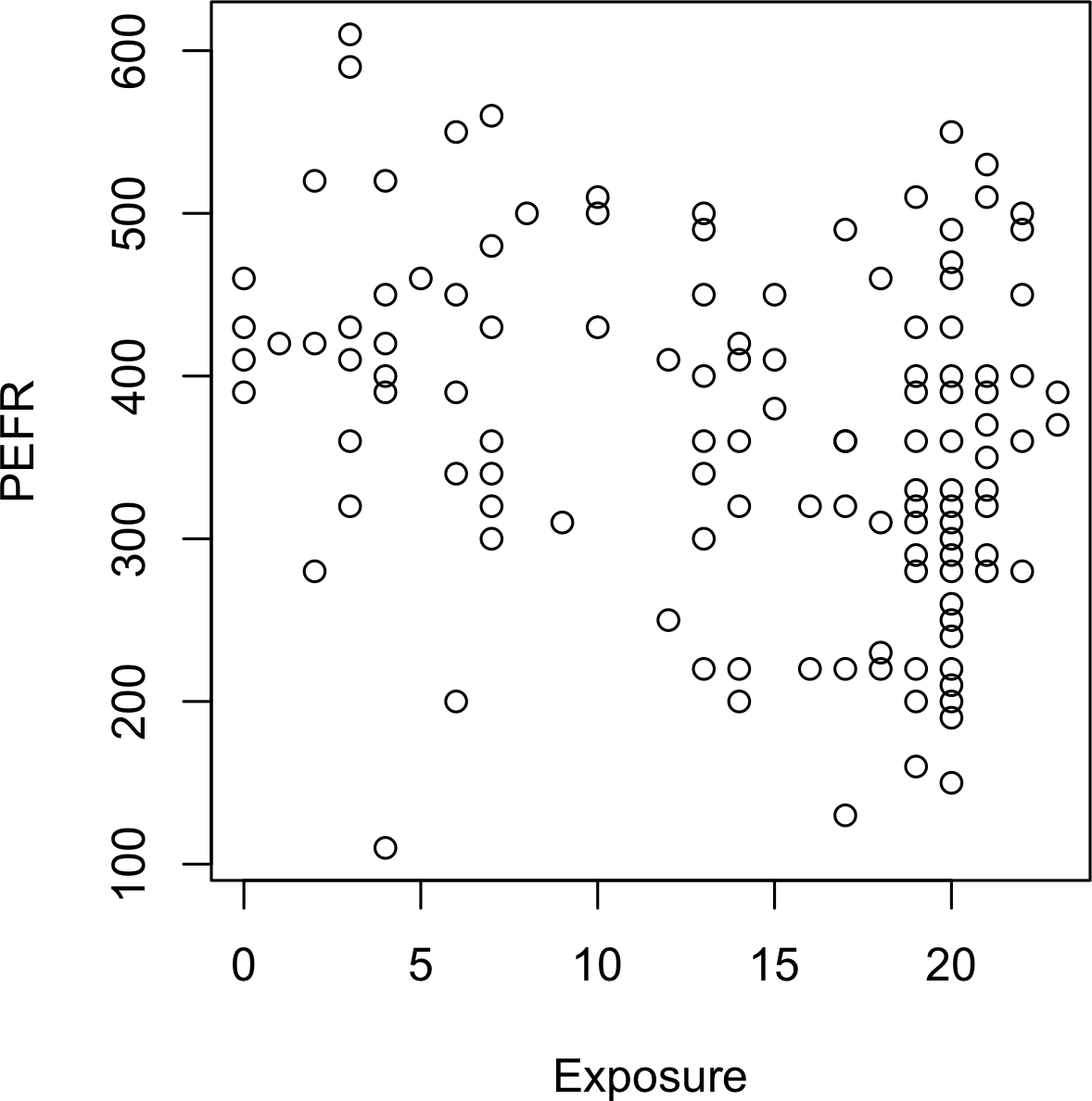

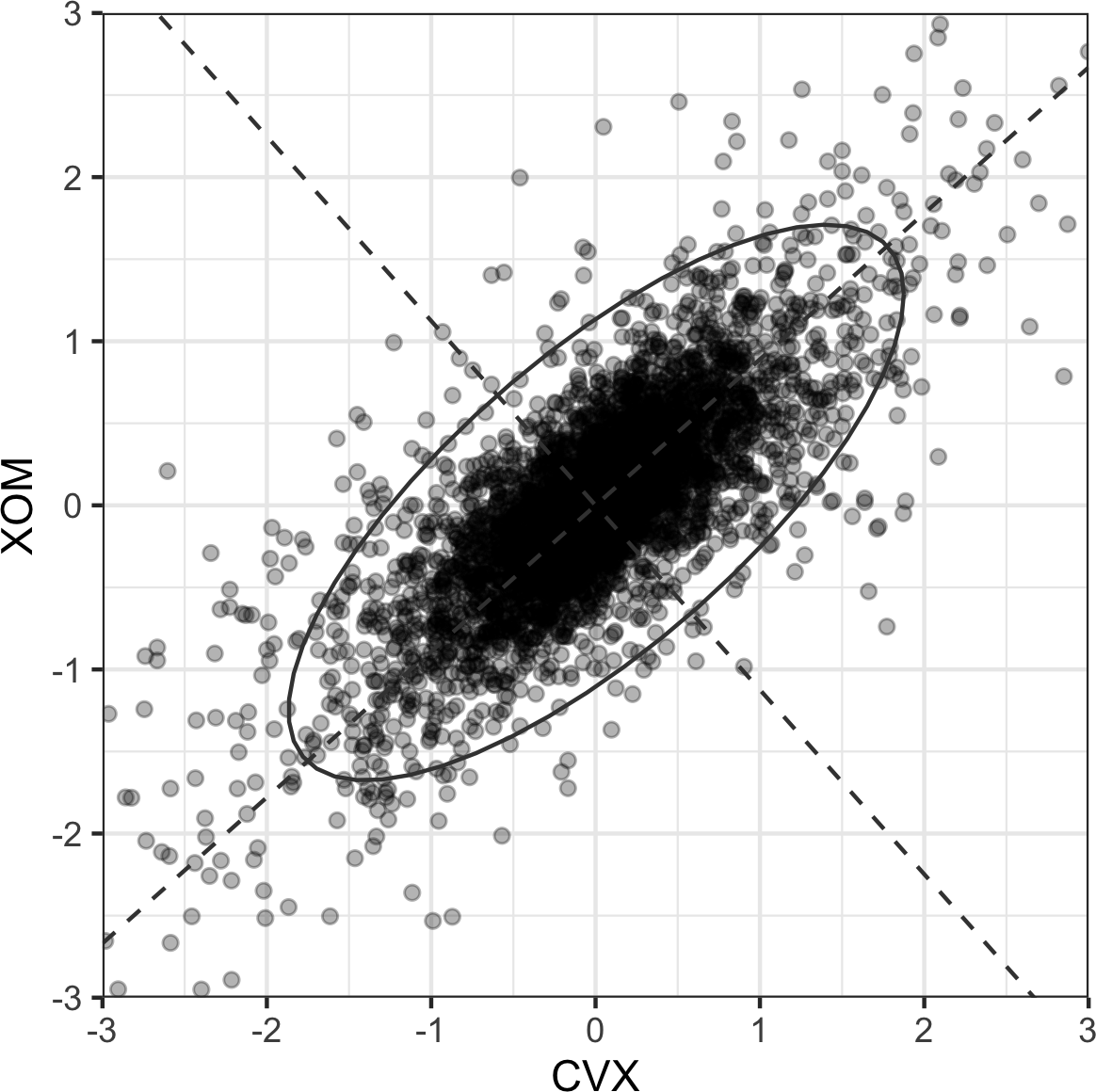

可视化两个测量数据变量之间关系的标准方法是散点图。x轴代表一个变量,y轴代表另一个变量,图上的每个点都是一个记录。参见图1-7,展示了ATT和Verizon日回报率之间的相关性图。这在R中使用以下命令生成:

plot(telecom$T, telecom$VZ, xlab='ATT (T)', ylab='Verizon (VZ)')同样的图形可以在Python中使用pandas的scatter方法生成:

ax = telecom.plot.scatter(x='T', y='VZ', figsize=(4, 4), marker='$\u25EF$')

ax.set_xlabel('ATT (T)')

ax.set_ylabel('Verizon (VZ)')

ax.axhline(0, color='grey', lw=1)

ax.axvline(0, color='grey', lw=1)回报率表现出正相关关系:虽然它们围绕零聚集,但在大多数日子里,这两只股票同涨同跌(右上和左下象限)。很少有日子出现一只股票大幅下跌而另一只股票上涨的情况,反之亦然(右下和左上象限)。

虽然图1-7只显示了754个数据点,但很明显在图的中间部分识别细节是多么困难。我们稍后将看到如何通过为点添加透明度,或使用六角形分箱和密度图,来帮助发现数据中的额外结构。

相关系数测量两个配对变量(例如,个体的身高和体重)之间的关联程度。

当v1的高值与v2的高值相伴时,v1和v2呈正关联。

当 v1 的高值对应 v2 的低值时,v1 和 v2 呈负相关。

相关系数是一个标准化度量,始终在 -1(完全负相关)到 +1(完全正相关)之间变化。

相关系数为零表示无相关性,但需要注意的是,数据的随机排列仅凭偶然也会产生正负相关系数值。

David Freedman、Robert Pisani 和 Roger Purves 合著的《Statistics》第4版(W. W. Norton,2007)对相关性有精彩的讨论。

类似均值和方差这样的常见估计量一次只观察一个变量(单变量分析)。相关性分析(参见”相关性”)是比较两个变量的重要方法(双变量分析)。在本节中,我们将探讨额外的估计和图表,以及两个以上的变量(多变量分析)。

两个或多个分类变量之间计数的统计表。

将记录分箱到六边形中的两个数值变量图表。

显示两个数值变量密度的图表,类似地形图。

类似箱线图但显示密度估计。

与单变量分析一样,双变量分析涉及计算汇总统计量和制作可视化显示。适当的双变量或多变量分析类型取决于数据的性质:数值型与分类型。

当数据值相对较少时,散点图很有效。图1-7中的股票收益图大约只涉及750个点。对于有数十万或数百万记录的数据集,散点图会过于密集,因此我们需要不同的方式来可视化关系。为了说明这一点,考虑数据集kc_tax,它包含华盛顿州金县住宅物业的税收评估值。为了专注于数据的主要部分,我们使用subset函数剔除了非常昂贵和非常小或大的住宅:

kc_tax0 <- subset(kc_tax, TaxAssessedValue < 750000 &

SqFtTotLiving > 100 &

SqFtTotLiving < 3500)

nrow(kc_tax0)在pandas中,我们如下过滤数据集:

kc_tax0 = kc_tax.loc[(kc_tax.TaxAssessedValue < 750000) &

(kc_tax.SqFtTotLiving > 100) &

(kc_tax.SqFtTotLiving < 3500), :]

kc_tax0.shape

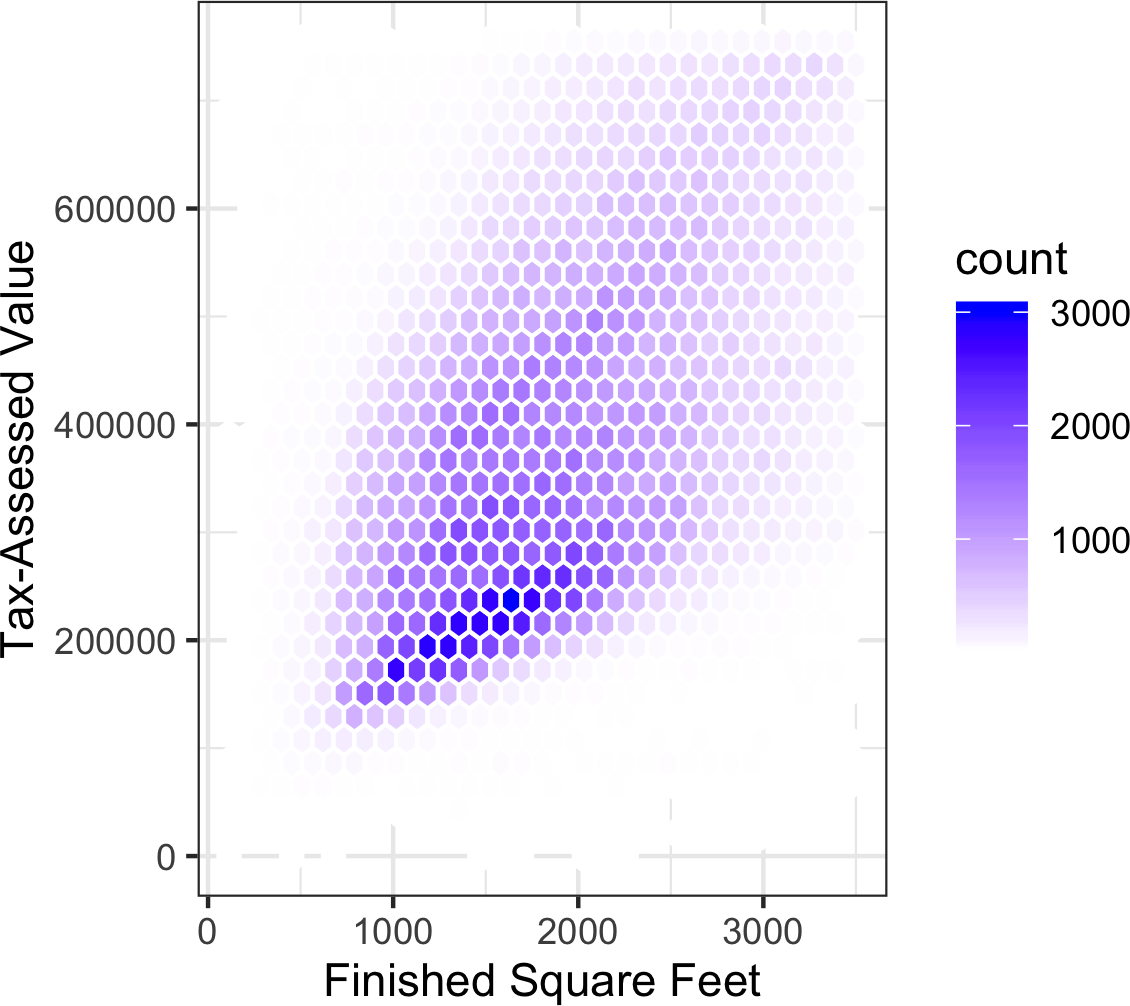

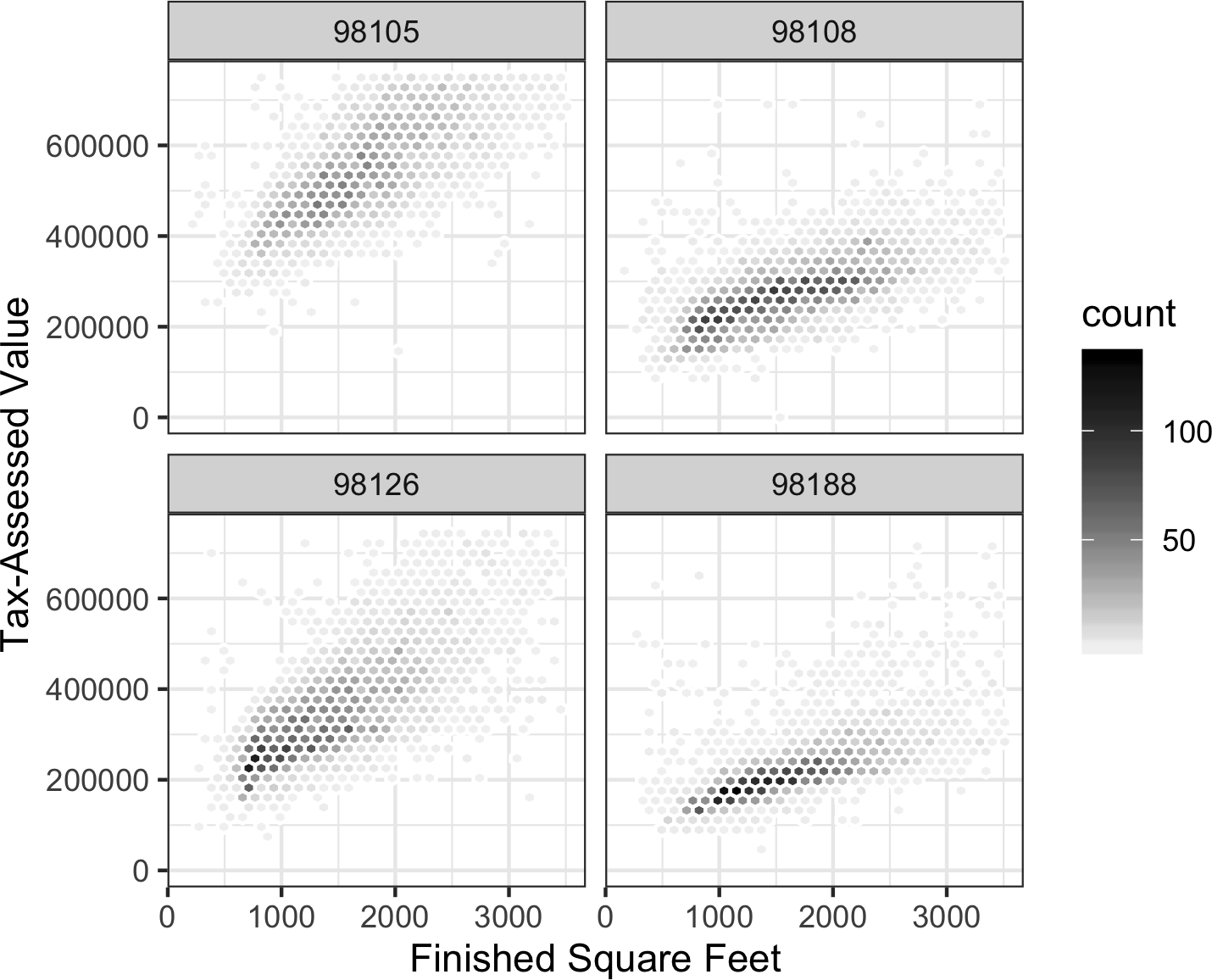

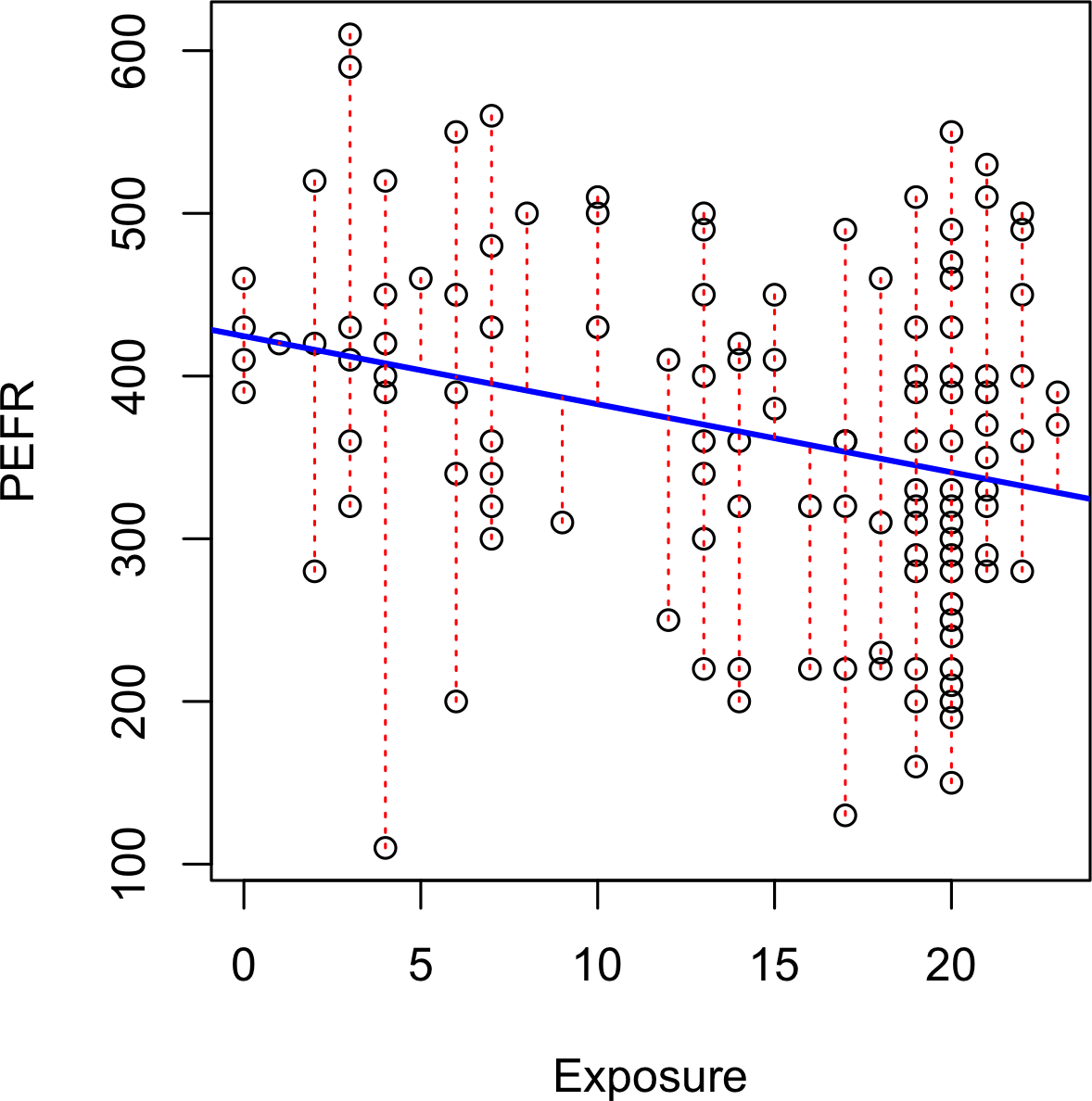

(432693, 3)[图1-8]是King County住宅的完工平方英尺与税收评估价值之间关系的六边形分箱图。该图没有绘制点(这会显示为单一的黑色云团),而是将记录分组到六边形分箱中,并用颜色表示该分箱中记录数量的六边形来绘制。在此图表中,平方英尺与税收评估价值之间的正相关关系非常明显。一个有趣的特征是主要(最暗)底部区带之上还有额外区带的迹象,表明有些住宅与主要区带中的住宅具有相同的平方英尺,但税收评估价值更高。

[图1-8]是由Hadley

Wickham开发的强大R包ggplot2生成的。ggplot2是用于数据高级探索性可视化分析的几个新软件库之一;参见[“多变量可视化”]:

ggplot(kc_tax0, (aes(x=SqFtTotLiving, y=TaxAssessedValue))) +

stat_binhex(color='white') +

theme_bw() +

scale_fill_gradient(low='white', high='black') +

labs(x='Finished Square Feet', y='Tax-Assessed Value')在Python中,使用pandas data

frame方法hexbin可以轻松创建六边形分箱图:

ax = kc_tax0.plot.hexbin(x='SqFtTotLiving', y='TaxAssessedValue',

gridsize=30, sharex=False, figsize=(5, 4))

ax.set_xlabel('Finished Square Feet')

ax.set_ylabel('Tax-Assessed Value')

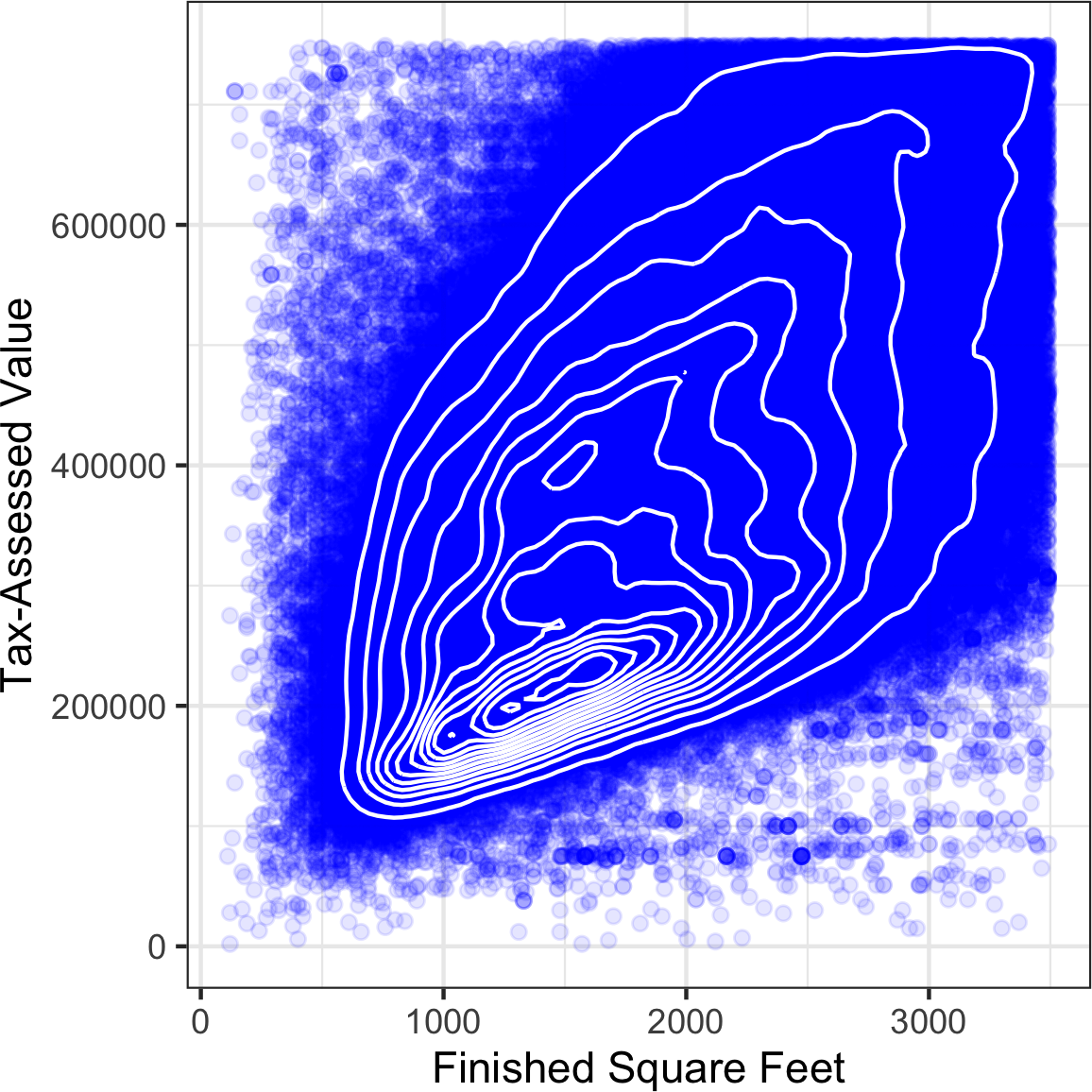

[图1-9]使用覆盖在散点图上的等高线来可视化两个数值变量之间的关系。等高线本质上是两个变量的地形图;每个等高线带代表特定的点密度,随着接近”峰值”而增加。此图显示了与[图1-8]类似的情况:在主峰的”北部”有一个次峰。此图表也是使用ggplot2的内置geom_density2d函数创建的:

ggplot(kc_tax0, aes(SqFtTotLiving, TaxAssessedValue)) +

theme_bw() +

geom_point(alpha=0.1) +

geom_density2d(color='white') +

labs(x='Finished Square Feet', y='Tax-Assessed Value')Python中的seaborn

kdeplot函数可以创建等高线图:

ax = sns.kdeplot(kc_tax0.SqFtTotLiving, kc_tax0.TaxAssessedValue, ax=ax)

ax.set_xlabel('Finished Square Feet')

ax.set_ylabel('Tax-Assessed Value')

其他类型的图表也用于显示两个数值变量之间的关系,包括热力图。热力图、六边形分箱和等高线图都提供了二维密度的可视化表示。这样,它们是直方图和密度图的自然类比。

汇总两个categorical变量的一个有用方法是列联表——按类别计数的表格。表1-8显示了个人贷款等级与该贷款结果之间的列联表。这些数据来自Lending Club,一家peer-to-peer借贷业务的领导者。等级从A(高)到G(低)。结果要么是完全还清、当前、逾期或核销(预计不会收回贷款余额)。这个表格显示了计数和行百分比。与低等级贷款相比,高等级贷款的逾期/核销百分比非常低。

| 等级 | 核销 | 当前 | 完全还清 | 逾期 | 总计 |

|---|---|---|---|---|---|

| A | 1562 | 50051 | 20408 | 469 | 72490 |

| 0.022 | 0.690 | 0.282 | 0.006 | 0.161 | |

| B | 5302 | 93852 | 31160 | 2056 | 132370 |

| 0.040 | 0.709 | 0.235 | 0.016 | 0.294 | |

| C | 6023 | 88928 | 23147 | 2777 | 120875 |

| 0.050 | 0.736 | 0.191 | 0.023 | 0.268 | |

| D | 5007 | 53281 | 13681 | 2308 | 74277 |

| 0.067 | 0.717 | 0.184 | 0.031 | 0.165 | |

| E | 2842 | 24639 | 5949 | 1374 | 34804 |

| 0.082 | 0.708 | 0.171 | 0.039 | 0.077 | |

| F | 1526 | 8444 | 2328 | 606 | 12904 |

| 0.118 | 0.654 | 0.180 | 0.047 | 0.029 | |

| G | 409 | 1990 | 643 | 199 | 3241 |

| 0.126 | 0.614 | 0.198 | 0.061 | 0.007 | |

| 总计 | 22671 | 321185 | 97316 | 9789 | 450961 |

表1-8. 贷款等级和状态的列联表

列联表可以只查看计数,也可以包括列百分比和总百分比。Excel中的pivot

table可能是创建列联表最常用的工具。在R中,descr包中的CrossTable函数产生列联表,以下代码用于创建表1-8:

library(descr)

x_tab <- CrossTable(lc_loans$grade, lc_loans$status,

prop.c=FALSE, prop.chisq=FALSE, prop.t=FALSE)pivot_table方法在Python中创建pivot

table。aggfunc参数允许我们获得计数。计算百分比稍微复杂一些:

crosstab = lc_loans.pivot_table(index='grade', columns='status',

aggfunc=lambda x: len(x), margins=True)

df = crosstab.loc['A':'G',:].copy()

df.loc[:,'Charged Off':'Late'] = df.loc[:,'Charged Off':'Late'].div(df['All'],

axis=0)

df['All'] = df['All'] / sum(df['All'])

perc_crosstab = df

margins关键字参数将添加列和行的总和。

我们创建pivot table的副本,忽略列总和。

我们用行总和除以行。

我们用'All'列的总和除以该列。

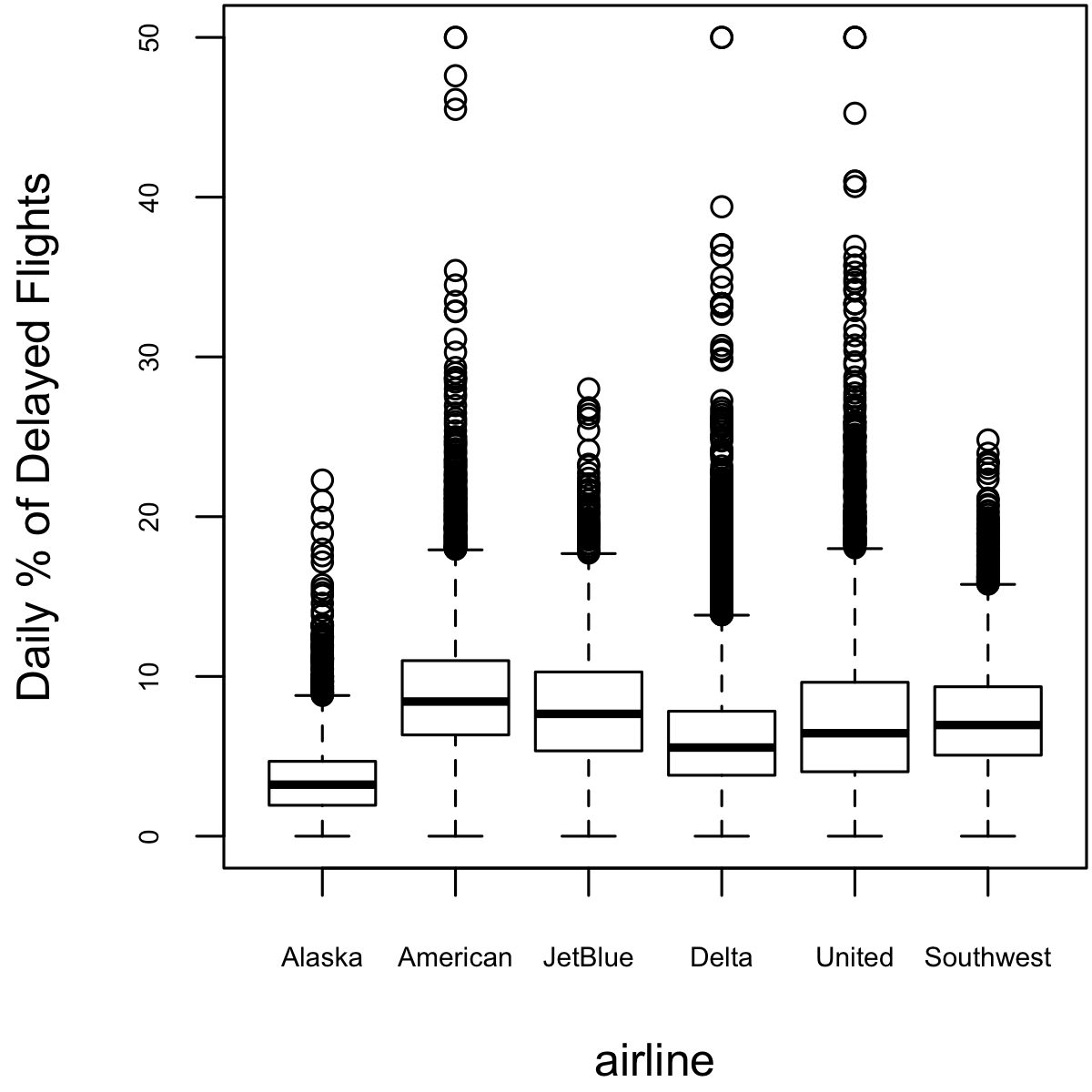

Boxplot(见”百分位数和Boxplot”)是一种简单的方法,可以直观地比较根据categorical变量分组的numeric变量的分布。例如,我们可能想比较航班延误百分比在不同航空公司之间的变化情况。图1-10显示了一个月内航班延误的百分比,其中延误在承运商控制范围内:

boxplot(pct_carrier_delay ~ airline, data=airline_stats, ylim=c(0, 50))pandas的boxplot方法采用by参数,将数据集分成组并创建单独的boxplot:

ax = airline_stats.boxplot(by='airline', column='pct_carrier_delay')

ax.set_xlabel('')

ax.set_ylabel('Daily % of Delayed Flights')

plt.suptitle('')

Alaska航空延误最少,而American航空延误最多:American航空的下四分位数高于Alaska航空的上四分位数。

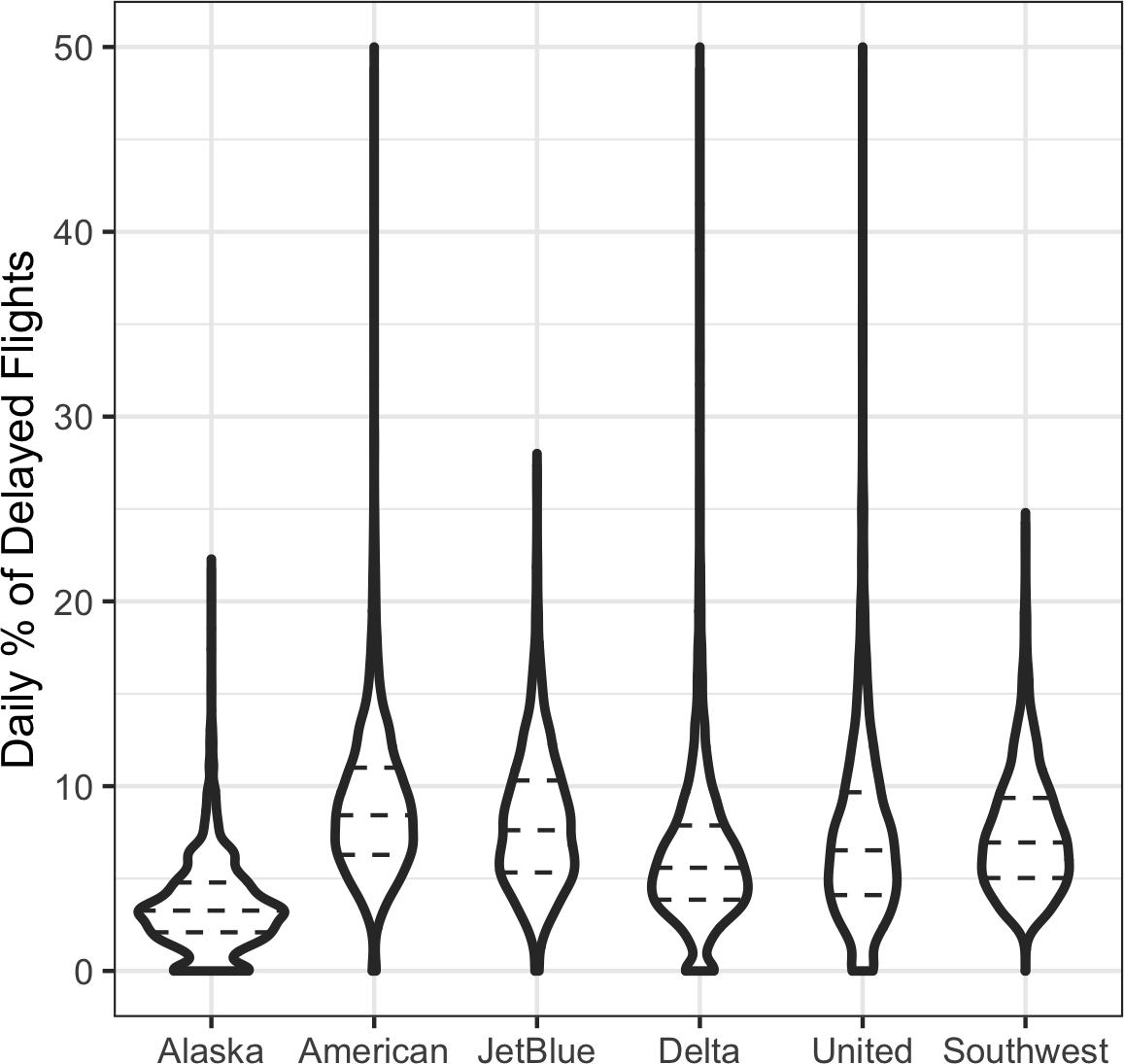

violin plot(小提琴图)由[Hintze-Nelson-1998]提出,是对箱线图的增强,它绘制密度估计,密度在y轴上。密度被镜像和翻转,生成的形状被填充,创建一个类似小提琴的图像。小提琴图的优势在于它可以显示箱线图无法感知的分布细节。另一方面,箱线图更清楚地显示数据中的异常值。在ggplot2中,可以使用geom_violin函数创建小提琴图:

ggplot(data=airline_stats, aes(airline, pct_carrier_delay)) +

ylim(0, 50) +

geom_violin() +

labs(x='', y='Daily % of Delayed Flights')小提琴图可通过seaborn包的violinplot方法获得:

ax = sns.violinplot(airline_stats.airline, airline_stats.pct_carrier_delay,

inner='quartile', color='white')

ax.set_xlabel('')

ax.set_ylabel('Daily % of Delayed Flights')对应的图表显示在图1-11中。小提琴图显示Alaska航空的分布在接近零处有集中现象,Delta航空也有类似但程度较轻的现象。这一现象在箱线图中不那么明显。你可以通过添加geom_boxplot将小提琴图与箱线图结合(尽管这在使用颜色时效果最佳)。

用于比较两个变量的图表类型——散点图、六边形分箱和箱线图——通过条件化的概念可以轻松扩展到更多变量。作为示例,回顾图1-8,该图显示了住宅建筑面积与税务评估价值之间的关系。我们观察到似乎有一群住宅的每平方英尺税务评估价值更高。深入研究,图1-12通过绘制一组邮政编码的数据来解释位置的影响。现在图片更加清晰:某些邮政编码(98105, 98126)的税务评估价值比其他邮政编码(98108, 98188)高得多。这种差异导致了图1-8中观察到的聚类现象。

我们使用ggplot2和facets(面)的概念创建了图1-12,或者称为条件变量(在这种情况下是邮政编码):

ggplot(subset(kc_tax0, ZipCode %in% c(98188, 98105, 98108, 98126)),

aes(x=SqFtTotLiving, y=TaxAssessedValue)) +

stat_binhex(color='white') +

theme_bw() +

scale_fill_gradient(low='white', high='blue') +

labs(x='Finished Square Feet', y='Tax-Assessed Value') +

facet_wrap('ZipCode')

使用ggplot函数facet_wrap和facet_grid来指定条件变量。

大多数 Python 包的可视化都基于

Matplotlib。虽然原则上可以使用 Matplotlib

创建分面图,但代码可能会很复杂。幸运的是,seaborn

有一种相对简单的方法来创建这些图:

zip_codes = [98188, 98105, 98108, 98126]

kc_tax_zip = kc_tax0.loc[kc_tax0.ZipCode.isin(zip_codes),:]

kc_tax_zip

def hexbin(x, y, color, **kwargs):

cmap = sns.light_palette(color, as_cmap=True)

plt.hexbin(x, y, gridsize=25, cmap=cmap, **kwargs)

g = sns.FacetGrid(kc_tax_zip, col='ZipCode', col_wrap=2)

g.map(hexbin, 'SqFtTotLiving', 'TaxAssessedValue',

extent=[0, 3500, 0, 700000])

g.set_axis_labels('Finished Square Feet', 'Tax-Assessed Value')

g.set_titles('Zip code {col_name:.0f}')

使用参数 col 和 row

来指定条件变量。对于单个条件变量,使用 col 配合

col_wrap 将分面图包装成多行。

map 方法调用 hexbin

函数,使用原始数据集的子集处理不同的邮政编码。extent 定义了

x 轴和 y 轴的范围。

图形系统中条件变量的概念是由 Trellis graphics 开创的,由

Rick Becker、Bill Cleveland

和其他人在贝尔实验室开发。这一理念已经传播到各种现代图形系统,如

R 中的 lattice 和 ggplot2 包,以及

Python 中的 seaborn 和 Bokeh

模块。条件变量也是商业智能平台(如 Tableau 和

Spotfire)的核心组成部分。随着强大计算能力的出现,现代可视化平台已经远远超越了探索性数据分析的简陋起点。然而,半个世纪前开发的关键概念和工具(例如简单的箱线图)仍然构成了这些系统的基础。

六边形分组(hexagonal binning)和等高线图是有用的工具,允许对两个数值变量进行图形检查,而不会被大量数据淹没。

列联表(contingency tables)是查看两个分类变量计数的标准工具。

箱线图和小提琴图允许您将数值变量与分类变量对比绘制。

Benjamin Baumer、Daniel Kaplan 和 Nicholas Horton 的《Modern Data

Science with R》(Chapman & Hall/CRC Press, 2017)

对”图形语法”(ggplot 中的”gg”)有出色的阐述。

Hadley Wickham 的《ggplot2: Elegant Graphics for Data

Analysis》(Springer, 2009) 是 ggplot2

创建者提供的优秀资源。

Josef Fruehwald 有一个关于 ggplot2

的网络教程。

探索性数据分析(EDA)由 John Tukey 开创,为数据科学领域奠定了基础。EDA 的核心思想是,任何基于数据的项目中第一个也是最重要的步骤是观察数据。通过总结和可视化数据,您可以获得有价值的直觉和对项目的理解。

本章回顾了从简单指标(如位置和变异性估计)到探索多个变量之间关系的丰富视觉展示等概念,如图 1-12 所示。开源社区开发的多样化工具和技术,结合 R 和 Python 语言的表达力,创造了大量探索和分析数据的方法。探索性分析应该成为任何数据科学项目的基石。

一个流行的误解认为大数据时代意味着不再需要抽样。实际上,各种质量和相关性数据的大量增加强化了抽样作为有效处理各种数据和最小化偏差工具的需求。即使在大数据项目中,预测模型通常也是用样本开发和试验的。样本也用于各种测试(例如,比较网页设计对点击的影响)。

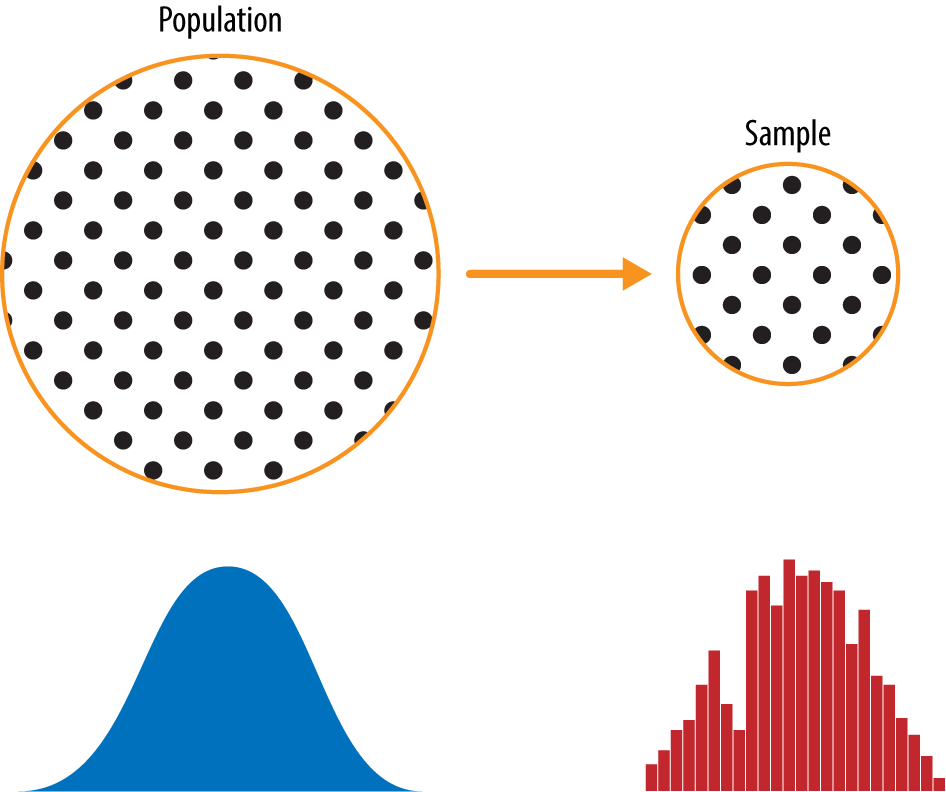

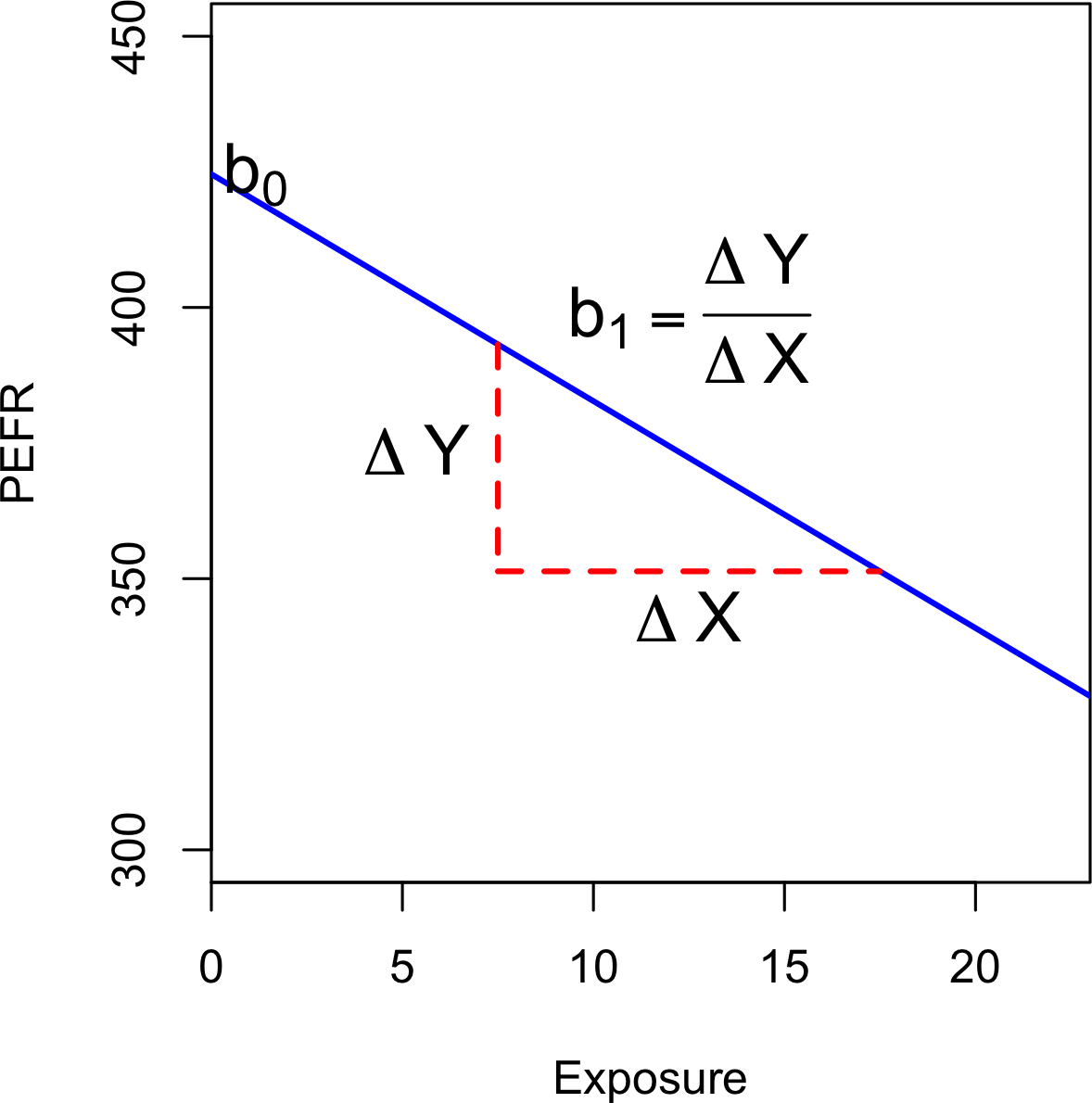

图2-1显示了一个概念图,它支撑着我们将在本章讨论的概念——数据和抽样分布。左侧代表一个总体,在统计学中,假设它遵循一个潜在但未知的分布。所有可用的只是样本数据及其经验分布,如右侧所示。从左侧到右侧,使用了一个抽样程序(用箭头表示)。传统统计学非常关注左侧,使用基于对总体强假设的理论。现代统计学已转向右侧,在这里不需要这样的假设。

一般来说,数据科学家不需要担心左侧的理论性质,而应该专注于抽样程序和手头的数据。但有一些值得注意的例外。有时数据是由可以建模的物理过程产生的。最简单的例子是抛硬币:这遵循二项分布。任何现实生活中的二项情况(买或不买,欺诈或无欺诈,点击或不点击)都可以通过硬币有效建模(当然,正面朝上的概率会修改)。在这些情况下,我们可以通过理解总体来获得额外的洞察。

样本是来自更大数据集的数据子集;统计学家称这个更大的数据集为总体。统计学中的总体与生物学中的不同——它是一个大的、定义的(但有时是理论的或想象的)数据集。

随机抽样是一个过程,其中被抽样总体的每个可用成员在每次抽取时都有相等的被选中机会。由此产生的样本称为简单随机样本。抽样可以有放回进行,其中观察值在每次抽取后被放回总体中,以备将来可能重新选择。或者可以无放回进行,在这种情况下,观察值一旦被选中,就不可用于未来的抽取。

在基于样本进行估计或建模时,数据质量往往比数据数量更重要。数据科学中的数据质量涉及完整性、格式一致性、清洁度和单个数据点的准确性。统计学增加了代表性的概念。

来自更大数据集的子集。

更大的数据集或数据集的概念。

总体(样本)的大小。

随机将元素抽入样本。

将总体分成层,并从每层随机抽样。

具有共同特征的总体的同质子群。

从未分层的总体中随机抽样得到的样本。

系统性误差。

错误代表总体的样本。

经典例子是1936年Literary Digest的民意调查,它预测Alf Landon战胜Franklin Roosevelt。当时的主要期刊Literary Digest调查了其全部订阅者以及其他个人名单,总共超过1000万人,并预测Landon会取得压倒性胜利。Gallup Poll的创始人George Gallup仅对2000人进行双周调查,准确预测了Roosevelt的胜利。差异在于被调查者的选择。

《Literary Digest》选择了数量而非方法,他们对选择方法几乎不加注意。他们最终调查的是那些相对较高社会经济地位的人群(他们自己的订阅者,加上那些因拥有电话和汽车等奢侈品而出现在营销商名单上的人)。结果产生了样本偏差;也就是说,样本在某种有意义且非随机的方式上与它所要代表的更大总体不同。非随机这个词很重要——几乎任何样本,包括随机样本,都不会完全代表总体。样本偏差发生在差异有意义时,并且可以预期以同样方式抽取的其他样本会继续存在这种差异。

你在Yelp等社交媒体网站上阅读的餐厅、酒店、咖啡厅等评论容易产生偏差,因为提交评论的人不是随机选择的;相反,他们自己主动写了评论。这导致了自选择偏差——有写评论动机的人可能有过糟糕的体验,可能与该机构有关联,或者可能只是与那些不写评论的人有着不同的人格类型。需要注意的是,虽然自选择样本可能不是真实情况的可靠指标,但在简单比较一个机构与类似机构时可能更可靠;同样的自选择偏差可能适用于每个机构。

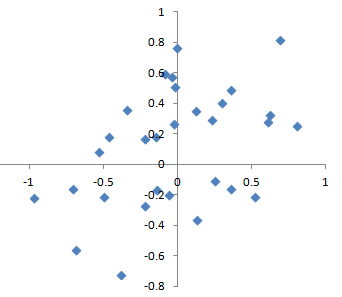

统计偏差指的是由测量或抽样过程产生的系统性测量或抽样误差。应该区分由于随机机会导致的误差和由于偏差导致的误差。考虑枪射击目标的物理过程。它不会每次都击中目标的绝对中心,甚至很少击中。无偏差的过程会产生误差,但它是随机的,不会强烈倾向于任何方向(见图2-2)。图2-3中显示的结果表明了一个有偏差的过程——在x和y方向上仍然存在随机误差,但也存在偏差。射击倾向于落在右上象限。

偏差有不同形式,可能是可观察的或不可见的。当结果确实表明存在偏差时(例如,通过参考基准或实际值),它通常表明统计或机器学习模型被错误指定,或者遗漏了重要变量。

为了避免导致《Literary Digest》预测Landon而非Roosevelt的样本偏差问题,George Gallup(如图2-4所示)选择了更科学的方法来获得代表美国选民的样本。现在有多种方法来实现代表性,但所有这些方法的核心都是随机抽样。

随机抽样并不总是容易的。正确定义可获得的总体是关键。假设我们想要生成客户的代表性档案,我们需要进行客户调查试点。调查需要具有代表性,但劳动密集。

首先,我们需要定义谁是客户。我们可能选择所有购买金额>0的客户记录。我们是否包括所有过去的客户?我们是否包括退款?内部测试购买?转销商?账单代理和客户都包括吗?

接下来,我们需要指定一个抽样程序。它可能是”随机选择100名客户”。当涉及到从流中抽样时(例如,实时客户交易或网站访问者),时间考虑可能很重要(例如,工作日上午10点的网站访问者可能与周末晚上10点的网站访问者不同)。

在分层抽样中,总体被分为层,并从每一层中进行随机抽样。政治民调者可能试图了解白人、黑人和西班牙裔的选举偏好。从总体中抽取的简单随机样本产生的黑人和西班牙裔太少,因此在分层抽样中可以对这些层进行过度加权,以产生相等的样本量。

在大数据时代,有时令人惊讶的是,较小的反而更好。花费在随机抽样上的时间和精力不仅减少了偏差,还允许更多地关注数据探索和数据质量。例如,缺失数据和异常值可能包含有用信息。在数百万条记录中追踪缺失值或评估异常值可能成本过高,但在几千条记录的样本中这样做可能是可行的。如果数据太多,数据绘图和人工检查会陷入困境。

那么什么时候需要大量数据呢?

大数据价值的经典场景是当数据不仅庞大而且稀疏时。考虑Google接收的搜索查询,其中列是术语,行是单个搜索查询,单元格值为0或1,取决于查询是否包含术语。目标是确定给定查询的最佳预测搜索目标。英语中有超过150,000个单词,Google每年处理超过一万亿个查询。这产生了一个巨大的矩阵,其绝大多数条目都是”0”。

这是一个真正的大数据问题——只有积累了如此巨大数量的数据,才能为大多数查询返回有效的搜索结果。积累的数据越多,结果越好。对于热门搜索词来说,这不是什么问题——可以相当快地为特定时间趋势的少数极其热门话题找到有效数据。现代搜索技术的真正价值在于能够为大量搜索查询返回详细和有用的结果,包括那些频率只有百万分之一的查询。

考虑搜索短语”Ricky Ricardo and Little Red Riding Hood”。在互联网早期,这个查询可能会返回关于乐队指挥Ricky Ricardo、该角色出现的电视节目I Love Lucy以及儿童故事Little Red Riding Hood的结果。这些单个项目都会有很多搜索引用,但组合的搜索会很少。后来,现在已经积累了数万亿个搜索查询,这个搜索查询返回确切的I Love Lucy剧集,其中Ricky以戏剧性的方式向他的婴儿儿子讲述Little Red Riding Hood故事,用英语和西班牙语的滑稽混合。

请记住,实际相关记录的数量——那些出现这个确切搜索查询或非常相似的查询(以及人们最终点击了什么链接的信息)——可能只需要数千个就有效。然而,需要数万亿个数据点才能获得这些相关记录(当然,随机抽样不会有帮助)。另请参见“长尾分布”。

符号(读作”x-bar”)用于表示来自总体的样本均值,而用于表示总体均值。为什么要做这种区分?关于样本的信息是观察到的,而关于大总体的信息通常是从较小的样本中推断出来的。统计学家喜欢在符号体系中将这两件事分开。

即使在大数据时代,随机抽样仍然是数据科学家工具箱中的重要武器。

当测量或观察由于不代表完整总体而系统性错误时,就会发生偏差。

数据质量往往比数据数量更重要,随机抽样可以减少偏差并促进质量改进,否则这种改进的成本将过于昂贵。

关于抽样程序的有用综述可以在Ronald Fricker的章节”在线调查的抽样方法”中找到,该章节收录在Nigel G. Fielding、Raymond M. Lee和Grant Blank编辑的《在线研究方法SAGE手册》第2版中(SAGE Publications, 2016)。该章节包括对随机抽样修改方法的综述,这些修改方法通常出于成本或可行性的实际原因而使用。

《文学文摘》民调失败的故事可以在Capital Century网站上找到。

套用Yogi Berra的话:如果你不知道要找什么,那就努力寻找,你总会找到的。

选择偏差是指有意识或无意识地选择性地选择数据的做法,这种做法会导致误导性或短暂性的结论。

由观察结果选择方式造成的偏差。

在数据中大量搜寻以寻找有趣内容。

由重复数据建模或使用大量预测变量建模数据而导致的偏差或不可重现性。

如果你指定一个假设并进行精心设计的实验来测试它,你可以对结论有很高的信心。然而,实际情况往往并非如此。通常,人们会查看可用数据并尝试识别模式。但是这些模式是真实的吗?还是它们只是数据窥探的产物——即在数据中大量搜寻直到有趣的内容出现? 统计学家中有句谚语:“如果你折磨数据足够长时间,它迟早会招供的。”

使用实验测试假设时验证的现象与通过查看可用数据发现的现象之间的区别可以通过以下思想实验来说明。

想象有人告诉你他们可以抛硬币并让接下来的10次都正面朝上。你挑战他们(相当于一个实验),他们继续抛硬币10次,所有抛掷都是正面朝上。显然你会认为这个人有某种特殊才能——10次抛硬币都是正面朝上的概率仅为千分之一。

现在想象体育场的播音员要求在场的20,000人每人抛硬币10次,如果连续得到10个正面就向引座员报告。体育场中有人得到10个正面的概率极高(超过99%——这是1减去没有人得到10个正面的概率)。显然,事后选择在体育场得到10个正面的人并不表明他们有任何特殊才能——这很可能只是运气。

由于反复审查大数据集是数据科学的一个关键价值主张,选择偏差是需要担心的问题。数据科学家特别关心的一种选择偏差形式是John Elder(Elder Research的创始人,一家受人尊敬的数据挖掘咨询公司)所称的大量搜索效应。 如果你用大数据集反复运行不同的模型并询问不同的问题,你必然会找到有趣的东西。但是你发现的结果真的是有趣的东西,还是偶然的异常值?

我们可以通过使用留置集来防范这种情况,有时甚至使用多个留置集来验证性能。Elder还倡导使用他所谓的目标洗牌(本质上是置换检验)来测试数据挖掘模型建议的预测关联的有效性。

统计学中典型的选择偏差形式,除了大量搜索效应外,还包括非随机抽样(见“随机抽样和样本偏差”)、挑选数据、选择强化特定统计效应的时间间隔,以及当结果看起来”有趣”时停止实验。

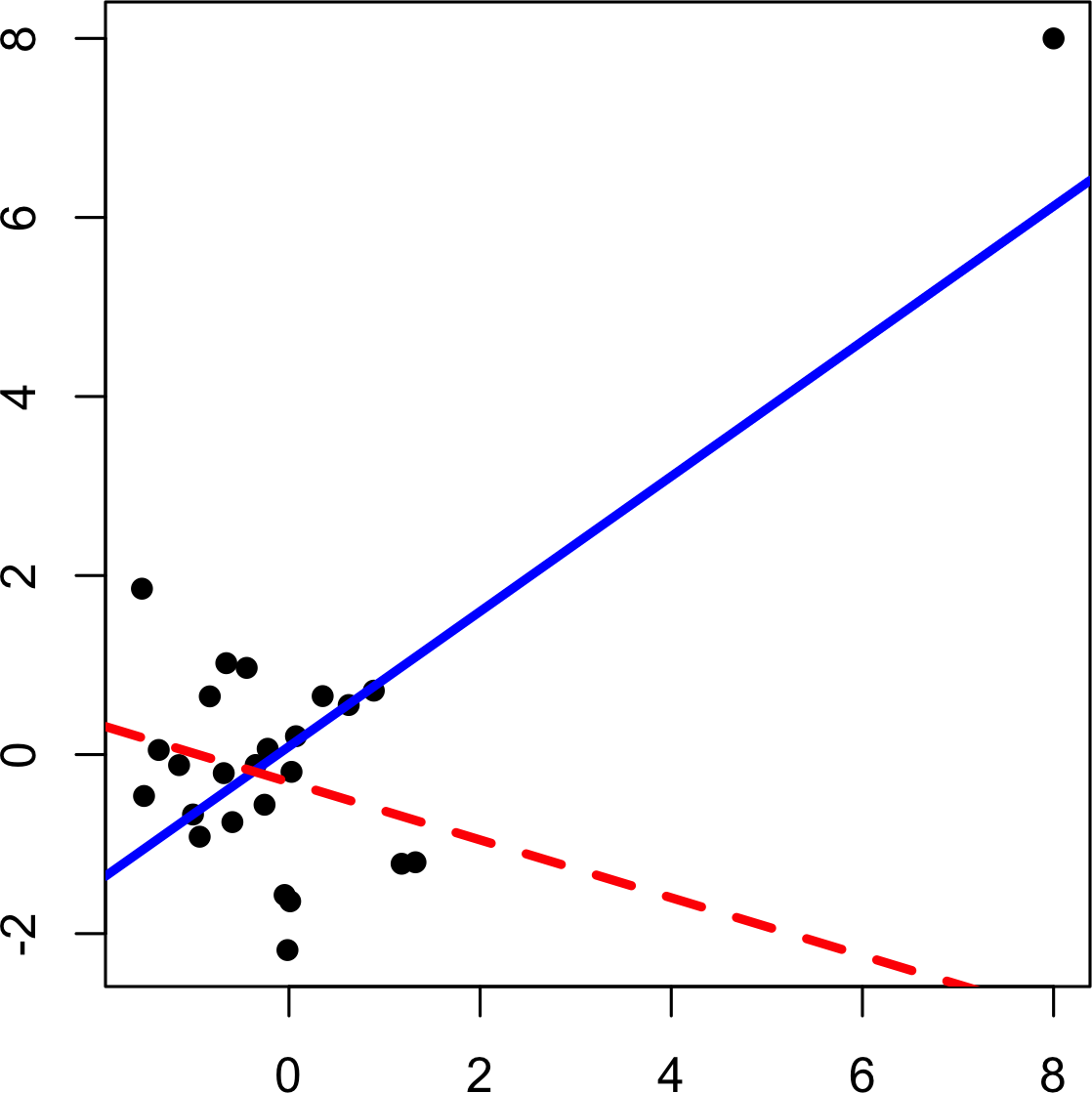

Regression to the mean 是指涉及给定变量连续测量的一种现象:极端观测值往往会被更接近中心的值所跟随。将特殊关注和意义赋予极端值可能导致一种选择偏差的形式。

体育迷对”年度新秀,二年级低迷”现象很熟悉。在某个赛季开始职业生涯的运动员(新秀班)中,总有一个表现比其他所有人都好。通常,这个”年度新秀”在第二年表现不如第一年。为什么会这样?

在几乎所有主要体育项目中,至少是那些用球或冰球进行的项目,有两个因素影响整体表现:

技能

运气

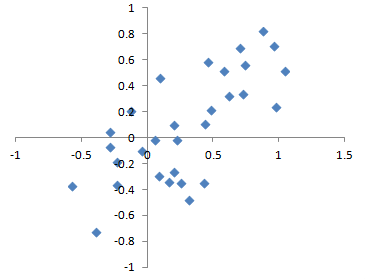

Regression to the mean 是特定形式选择偏差的结果。当我们选择表现最佳的新秀时,技能和好运气可能都在起作用。在他的下个赛季,技能仍然存在,但运气通常不会再有,所以他的表现会下降——会回归。这一现象最初由Francis Galton在1886年发现 [Galton-1886],他在遗传倾向方面对此进行了描述;例如,极高男性的孩子往往不如他们的父亲高(见图 2-5)。

Regression to the mean,意思是”回归”,与linear regression的统计建模方法不同,后者是在预测变量和结果变量之间估计线性关系。

指定假设然后遵循随机化和随机抽样原则收集数据确保避免偏差。

所有其他形式的数据分析都存在由数据收集/分析过程导致偏差的风险(data mining中重复运行模型、研究中的data snooping,以及事后选择有趣事件)。

Christopher J. Pannucci和Edwin G. Wilkins在(令人惊讶的不是统计学期刊)Plastic and Reconstructive Surgery(2010年8月)中的文章”Identifying and Avoiding Bias in Research”对可能进入研究的各种偏差类型进行了出色的回顾,包括选择偏差。

Michael Harris的文章“Fooled by Randomness Through Selection Bias”从交易员的角度对股票市场交易方案中的选择偏差考虑因素进行了有趣的回顾。

抽样分布这一术语指的是从同一总体中抽取的许多样本上某个样本统计量的分布。经典统计学的大部分内容都涉及从(小)样本对(非常大的)总体进行推断。

为从更大总体中抽取的数据样本计算的度量。

数据集中个别值的频率分布。

样本统计量在许多样本或重抽样中的频率分布。

随着样本量增加,抽样分布趋向于呈正态分布形状的趋势。

样本统计量在多个样本中的变异性(标准差)(不要与标准差本身混淆,标准差本身指的是单个数据值的变异性)。

通常,抽取样本的目标是测量某些内容(使用样本统计量)或建模某些内容(使用统计或机器学习模型)。由于我们的估计或模型基于样本,它可能存在误差;如果我们抽取不同的样本,结果可能会不同。因此我们关心结果可能有多大差异——一个关键问题是抽样变异性。如果我们有大量数据,我们可以抽取额外的样本并直接观察样本统计量的分布。通常,我们会使用尽可能多的可用数据来计算估计值或模型,所以从总体中抽取额外样本的选择并不容易获得。

区分单个数据点的分布(称为数据分布)和样本统计量的分布(称为抽样分布)是很重要的。

样本统计量(如均值)的分布可能比数据本身的分布更规律、更呈钟形。统计量所基于的样本越大,这一点越正确。同样,样本越大,样本统计量分布越窄。

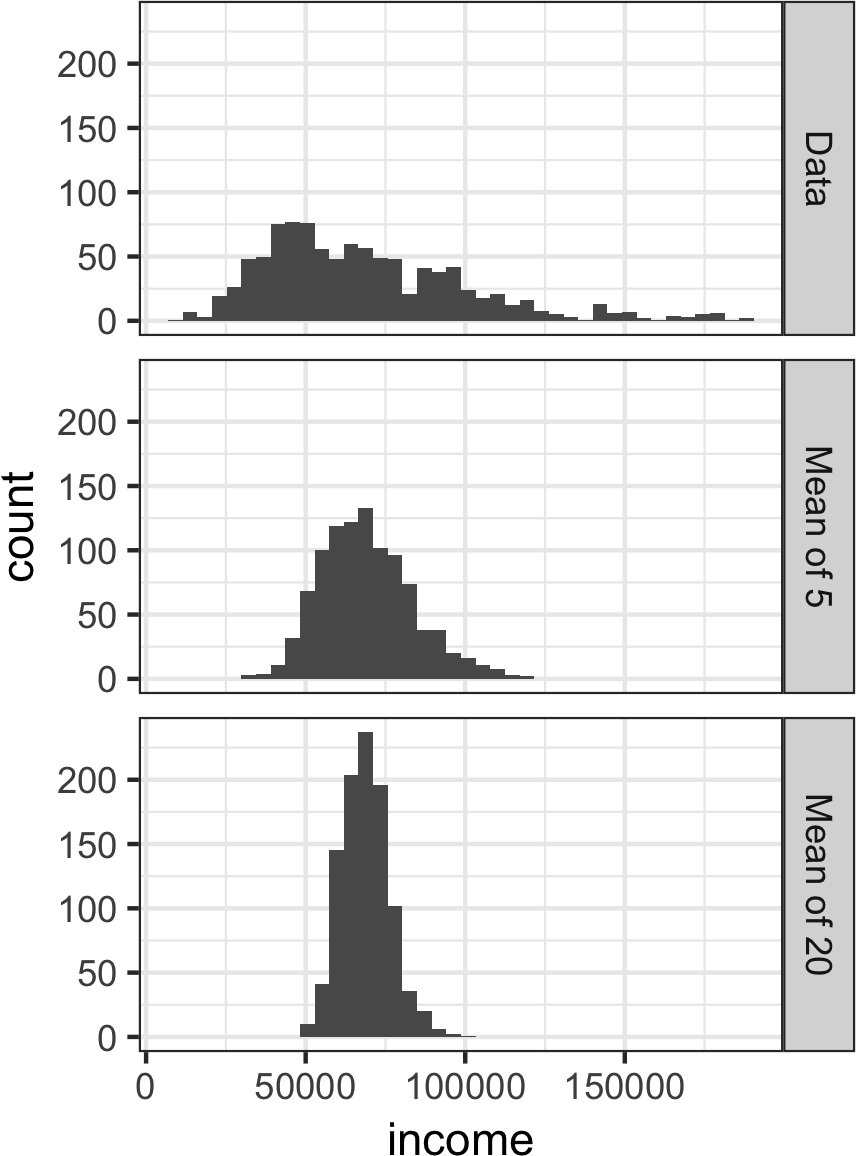

这通过一个使用LendingClub贷款申请人年收入的例子来说明(有关数据描述,请参见”小例子:预测贷款违约”)。从这些数据中取三个样本:1,000个值的样本、1,000个5值均值的样本,以及1,000个20值均值的样本。然后绘制每个样本的直方图以生成图2-6。

单个数据值的直方图分布广泛且向较高值偏斜,这在收入数据中是预期的。5个和20个值均值的直方图越来越紧凑,更呈钟形。以下是使用可视化包ggplot2生成这些直方图的R代码:

library(ggplot2)

# 取一个简单随机样本

samp_data <- data.frame(income=sample(loans_income, 1000),

type='data_dist')

# 取5个值均值的样本

samp_mean_05 <- data.frame(

income = tapply(sample(loans_income, 1000*5),

rep(1:1000, rep(5, 1000)), FUN=mean),

type = 'mean_of_5')

# 取20个值均值的样本

samp_mean_20 <- data.frame(

income = tapply(sample(loans_income, 1000*20),

rep(1:1000, rep(20, 1000)), FUN=mean),

type = 'mean_of_20')

# 绑定data.frames并将type转换为因子

income <- rbind(samp_data, samp_mean_05, samp_mean_20)

income$type = factor(income$type,

levels=c('data_dist', 'mean_of_5', 'mean_of_20'),

labels=c('Data', 'Mean of 5', 'Mean of 20'))

# 绘制直方图

ggplot(income, aes(x=income)) +

geom_histogram(bins=40) +

facet_grid(type ~ .)Python代码使用seaborn的FacetGrid来显示三个直方图:

import pandas as pd

import seaborn as sns

sample_data = pd.DataFrame({

'income': loans_income.sample(1000),

'type': 'Data',

})

sample_mean_05 = pd.DataFrame({

'income': [loans_income.sample(5).mean() for _ in range(1000)],

'type': 'Mean of 5',

})

sample_mean_20 = pd.DataFrame({

'income': [loans_income.sample(20).mean() for _ in range(1000)],

'type': 'Mean of 20',

})

results = pd.concat([sample_data, sample_mean_05, sample_mean_20])

g = sns.FacetGrid(results, col='type', col_wrap=1, height=2, aspect=2)

g.map(plt.hist, 'income', range=[0, 200000], bins=40)

g.set_axis_labels('Income', 'Count')

g.set_titles('{col_name}')我们刚才描述的现象被称为中心极限定理。它说明从多个样本中抽取的均值将呈现熟悉的钟形正态曲线(参见[“正态分布”]),即使源总体不是正态分布的,只要样本量足够大且数据偏离正态性的程度不是太大。中心极限定理允许在计算用于推断的抽样分布时使用正态近似公式(如t分布),即置信区间和假设检验。

中心极限定理在传统统计学教科书中受到很多关注,因为它是假设检验和置信区间机制的基础,而这些内容本身占据了此类教科书一半的篇幅。数据科学家应该了解这一作用;然而,由于正式的假设检验和置信区间在数据科学中作用很小,而且bootstrap(参见[“Bootstrap方法”])在任何情况下都可以使用,所以中心极限定理在数据科学实践中并不那么重要。

标准误差是一个单一指标,它总结了统计量抽样分布中的变异性。标准误差可以使用基于样本值标准差s和样本量n的统计量来估计:

随着样本量的增加,标准误差减少,这与图2-6中观察到的情况相符。标准误差与样本量之间的关系有时被称为n的平方根规则:要将标准误差减少2倍,样本量必须增加4倍。

标准误差公式的有效性源于中心极限定理。实际上,你不需要依赖中心极限定理来理解标准误差。考虑以下测量标准误差的方法:

从总体中收集许多全新的样本。

对于每个新样本,计算统计量(例如,均值)。

计算步骤2中计算的统计量的标准差;将此作为标准误差的估计。

在实践中,这种收集新样本来估计标准误差的方法通常不可行(而且在统计上非常浪费)。幸运的是,事实证明没有必要抽取全新的样本;相反,你可以使用bootstrap重抽样。在现代统计学中,bootstrap已成为估计标准误差的标准方法。它几乎可以用于任何统计量,且不依赖于中心极限定理或其他分布假设。

不要混淆标准差(衡量单个数据点的变异性)和标准误差(衡量样本指标的变异性)。

样本统计量的频率分布告诉我们该指标在不同样本中会如何不同地表现。

这种抽样分布可以通过bootstrap或依赖于中心极限定理的公式来估计。

总结样本统计量变异性的一个关键指标是其标准误差。

David Lane的统计学在线多媒体资源有一个有用的模拟工具,允许你选择样本统计量、样本量和迭代次数,并可视化结果频率分布的直方图。

估计统计量或模型参数抽样分布的一种简单有效的方法是从样本本身有放回地抽取额外样本,并为每个重抽样重新计算统计量或模型。这个过程称为bootstrap,它不一定涉及关于数据或样本统计量正态分布的任何假设。

从观察数据集中进行有放回抽样得到的样本。

从观察数据中进行重复抽样的过程;包括bootstrap和permutation(排列)程序。

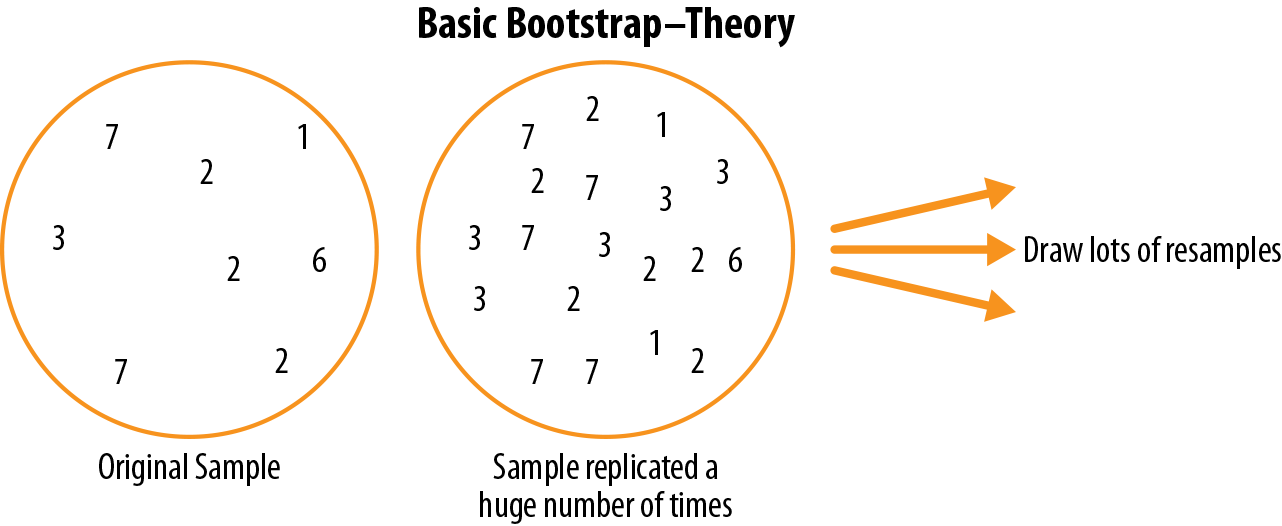

从概念上讲,你可以将bootstrap想象为将原始样本复制数千或数百万次,这样你就有了一个假设总体,它包含了原始样本的所有知识(只是规模更大)。然后你可以从这个假设总体中抽取样本,用于估计抽样分布;见图2-7。

在实践中,并不需要真的将样本复制大量次数。我们只需在每次抽取后替换每个观察值;也就是说,我们进行有放回抽样。通过这种方式,我们有效地创建了一个无限总体,其中元素被抽取的概率在每次抽取中保持不变。对于大小为n的样本,均值bootstrap重采样的算法如下:

抽取一个样本值,记录它,然后替换它。

重复n次。

记录n个重采样值的均值。

重复步骤1-3共R次。

使用R个结果来:

计算它们的标准差(这估计了样本均值的标准误差)。

产生直方图或箱线图。

找到置信区间。

R,bootstrap的迭代次数,设置得相当任意。你做的迭代越多,对标准误差或置信区间的估计就越准确。这个程序的结果是一个bootstrap样本统计量集合或估计的模型参数,然后你可以检查它们的变异性。

R包boot将这些步骤合并在一个函数中。例如,以下将bootstrap应用于贷款人的收入:

library(boot)

stat_fun <- function(x, idx) median(x[idx])

boot_obj <- boot(loans_income, R=1000, statistic=stat_fun)函数stat_fun为由索引idx指定的给定样本计算中位数。结果如下:

Bootstrap Statistics :

original bias std. error

t1* 62000 -70.5595 209.1515中位数的原始估计是$62,000。bootstrap分布表明该估计有大约-$70的偏差和$209的标准误差。算法连续运行之间的结果会略有不同。

主要的Python包没有提供bootstrap方法的实现。它可以使用scikit-learn方法resample来实现:

results = []

for nrepeat in range(1000):

sample = resample(loans_income)

results.append(sample.median())

results = pd.Series(results)

print('Bootstrap Statistics:')

print(f'original: {loans_income.median()}')

print(f'bias: {results.mean() - loans_income.median()}')

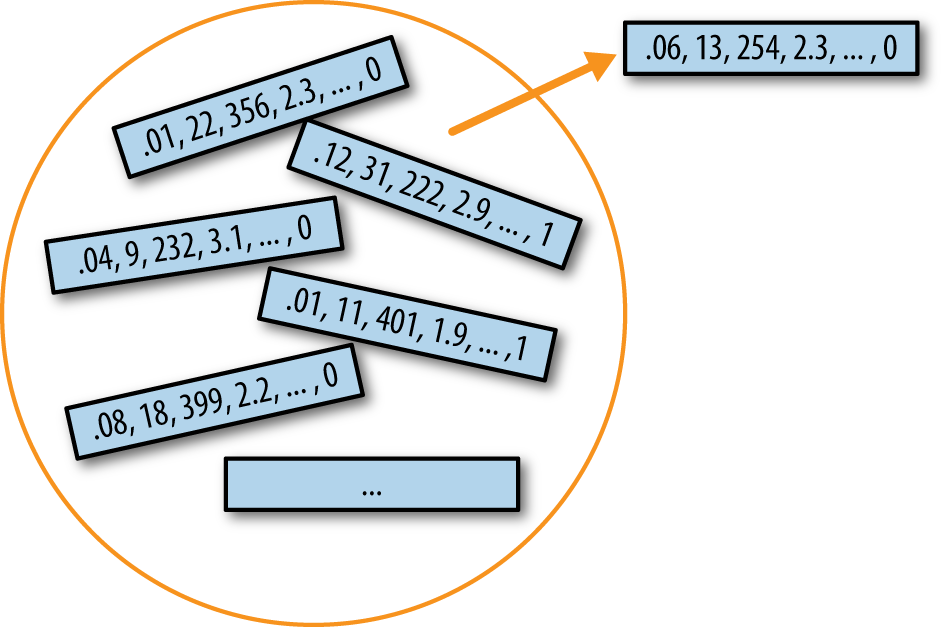

print(f'std. error: {results.std()}')Bootstrap可以用于多变量数据,其中行作为单位进行抽样(见图2-8)。然后可以在bootstrap数据上运行模型,例如,估计模型参数的稳定性(变异性),或提高预测能力。对于分类和回归树(也称为决策树),在bootstrap样本上运行多个树然后平均它们的预测(或者,对于分类,采用多数投票)通常比使用单个树表现更好。这个过程称为bagging(“bootstrap聚合”的缩写;见”Bagging和Random Forest”)。

Bootstrap的重复抽样在概念上很简单,经济学家和人口学家Julian Simon在其1969年的著作Basic Research Methods in Social Science (Random House)中发表了包括bootstrap在内的抽样示例汇编。然而,这种方法在计算上也很密集,在计算能力广泛普及之前并不是一个可行的选择。该技术在1970年代末和1980年代初通过斯坦福统计学家Bradley Efron发表的几篇期刊文章和一本书而得名并流行起来。它在使用统计学但不是统计学家的研究人员中特别受欢迎,并且用于没有现成数学近似的指标或模型。均值的抽样分布自1908年以来就已经很好地建立了;许多其他指标的抽样分布却没有。Bootstrap可用于样本量确定;尝试不同的n值来看抽样分布如何受到影响。

Bootstrap在首次引入时遇到了相当大的怀疑;对许多人来说,它有着点石成金的光环。这种怀疑源于对bootstrap目的的误解。

Bootstrap不能补偿小样本量;它不会创造新数据,也不会填补现有数据集中的空洞。它只是告诉我们,当从像我们原始样本这样的总体中抽取时,大量额外样本将如何表现。

有时resampling一词与bootstrapping一词同义使用,如刚才所述。 更常见的是,resampling一词还包括置换程序(permutation procedures)(参见“Permutation Test”),其中多个样本被合并,抽样可能在不放回的情况下进行。无论如何,bootstrap一词总是意味着从观察到的数据集中进行有放回抽样。

Bootstrap(从数据集中有放回抽样)是评估样本统计量变异性的强大工具。

Bootstrap可以在各种不同情况下以类似方式应用,无需对抽样分布的数学近似进行广泛研究。

它还允许我们估计尚未开发数学近似的统计量的抽样分布。

当应用于预测模型时,聚合多个bootstrap样本预测(bagging)比使用单一模型表现更好。

Bradley Efron和Robert Tibshirani的An Introduction to the Bootstrap (Chapman & Hall, 1993)是第一本关于bootstrap的书籍长度处理。它仍然被广泛阅读。

Statistical Science 2003年5月号(vol. 18, no. 2)中关于bootstrap的回顾文章讨论了(在Peter Hall的”A Short Prehistory of the Bootstrap”中的其他先例中)Julian Simon在1969年对bootstrap的初步发表。

参见Gareth James、Daniela Witten、Trevor Hastie和Robert Tibshirani的An Introduction to Statistical Learning (Springer, 2013)中关于bootstrap特别是bagging的章节。

频率表、直方图、箱线图和标准误差都是理解样本估计中潜在误差的方法。 Confidence intervals是另一种方法。

从同一总体以相同方式构建的confidence intervals中,预期包含感兴趣统计量的百分比。

Confidence interval的上限和下限。

人类对不确定性有天然的厌恶;人们(特别是专家)很少说”我不知道”。分析师和管理者,虽然承认不确定性,但当估计以单一数字(点估计)形式呈现时,仍然对估计过度信任。 将估计不作为单一数字而是作为一个范围来呈现是对抗这种倾向的一种方式。Confidence intervals以基于统计抽样原理的方式做到这一点。

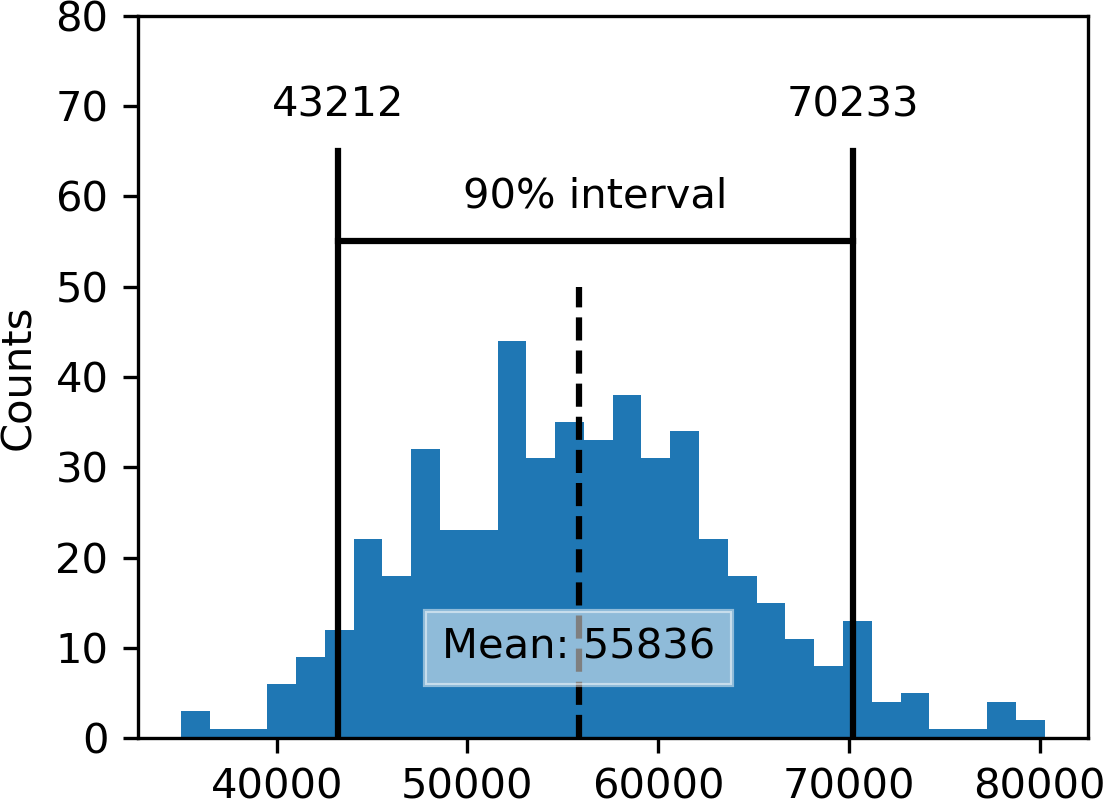

Confidence intervals总是带有覆盖水平,表示为(高)百分比,比如90%或95%。思考90% confidence interval的一种方式如下:它是包围样本统计量bootstrap抽样分布中央90%的区间(参见“The Bootstrap”)。更一般地,围绕样本估计的x% confidence interval平均应该在x%的时间内包含类似的样本估计(当遵循类似的抽样程序时)。

给定大小为 n 的样本和感兴趣的样本统计量,bootstrap confidence interval 的算法如下:

从数据中有放回地抽取大小为 n 的随机样本(重采样)。

记录重采样的感兴趣统计量。

重复步骤 1-2 多次(R 次)。

对于 x% confidence interval,从分布的两端修剪 [(100-x) / 2]% 的 R 个重采样结果。

修剪点是 x% bootstrap confidence interval 的端点。

图 2-9 显示了基于 20 个样本的贷款申请人年收入均值的 90% confidence interval,其中均值为 $62,231。

Bootstrap 是一个通用工具,可用于为大多数统计量或模型参数生成 confidence intervals。统计教科书和软件,其根源在于超过半个世纪的无计算机统计分析,也会引用由公式生成的 confidence intervals,特别是 t-distribution(参见”Student’s t-Distribution”)。

当然,当我们有样本结果时,我们真正感兴趣的是:“真实值位于某个区间内的概率是多少?” 这并不是 confidence interval 真正回答的问题,但最终这是大多数人解释答案的方式。

与 confidence interval 相关的概率问题以”给定采样程序和总体,…的概率是多少”这一短语开始。要反向思考,“给定样本结果,(关于总体的某事为真)的概率是多少?”涉及更复杂的计算和更深层的难题。

与 confidence interval 相关的百分比称为 level of confidence。confidence level 越高,区间越宽。同样,样本越小,区间越宽(即不确定性越大)。两者都有道理:你想要的信心越强,拥有的数据越少,就必须使 confidence interval 越宽,以充分确保捕获真实值。

对于 data scientist 来说,confidence interval 是一个可用于了解样本结果可能有多大变异性的工具。Data scientists 使用这些信息不是为了发表学术论文或向监管机构提交结果(如研究人员可能做的),而很可能是为了传达估计中的潜在误差,也许是为了了解是否需要更大的样本。

Confidence intervals 是将估计作为区间范围呈现的典型方式。

拥有的数据越多,样本估计的变异性就越小。

你能容忍的 confidence level 越低,confidence interval 就越窄。

Bootstrap 是构建 confidence intervals 的有效方法。

关于 confidence intervals 的 bootstrap 方法,参见 Peter Bruce 的《Introductory Statistics and Analytics: A Resampling Perspective》(Wiley, 2014)或 Robin Lock 和其他四位 Lock 家族成员的《Statistics: Unlocking the Power of Data》第 2 版(Wiley, 2016)。

工程师需要了解其测量的精度,可能比大多数学科更多地使用 confidence intervals,Thomas Ryan 的《Modern Engineering Statistics》(Wiley, 2007)讨论了 confidence intervals。它还回顾了一个同样有用但关注较少的工具:prediction intervals(围绕单个值的区间,而不是均值或其他汇总统计量)。

钟形的normal distribution(正态分布)是传统统计学中的标志性分布。1 样本统计量的分布通常呈正态分布这一事实,使其成为开发近似这些distributions的数学公式的强大工具。

数据点与预测值或平均值之间的差异。

减去均值并除以标准差。

个体数据点标准化的结果。

均值=0、标准差=1的正态分布。

用于可视化样本分布与指定分布(如正态分布)接近程度的图形。

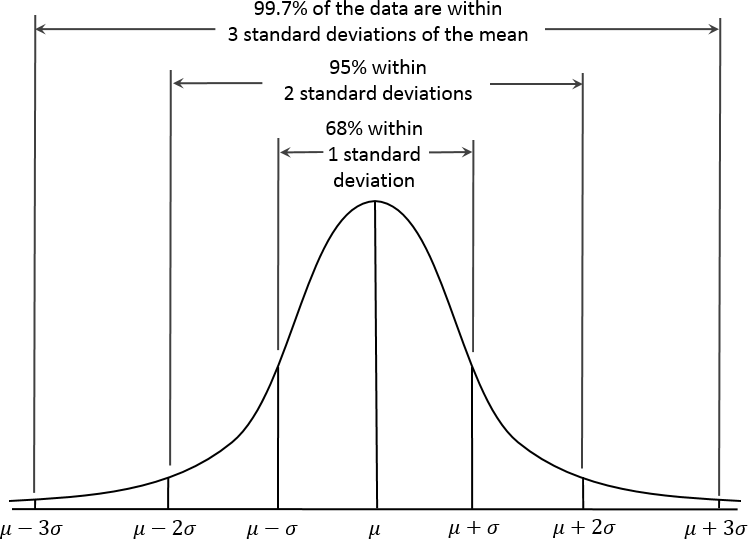

在正态分布中(Figure 2-10),68%的数据位于均值的一个标准差范围内,95%位于两个标准差范围内。

一个常见的误解是认为正态分布之所以被称为”正态”是因为大多数数据都遵循正态分布——即这是正常的情况。 在典型的数据科学项目中使用的大多数变量——实际上大多数原始数据——都不是正态分布的:参见“Long-Tailed Distributions”。正态分布的效用来自这样一个事实:许多统计量在其抽样分布中是正态分布的。即便如此,正态性假设通常是最后的手段,只有在经验概率分布或bootstrap分布不可用时才使用。

正态分布也被称为Gaussian分布,以Carl Friedrich Gauss的名字命名,他是18世纪末19世纪初德国的杰出数学家。 正态分布以前使用的另一个名称是”error”分布。从统计学角度来说,error是实际值与统计估计值(如样本均值)之间的差异。例如,标准差(参见“Estimates of Variability”)是基于数据均值的误差。Gauss对正态分布的发展来自他对天文测量误差的研究,这些误差被发现是正态分布的。

Standard normal分布是指x轴上的单位以距离均值的标准差数量来表示的分布。 要将数据与标准正态分布进行比较,你需要减去均值然后除以标准差;这也被称为normalization或standardization(参见“Standardization (Normalization, z-Scores)”)。请注意,这里的”standardization”与数据库记录标准化(转换为通用格式)无关。 变换后的值称为z-score,正态分布有时也被称为z-distribution。

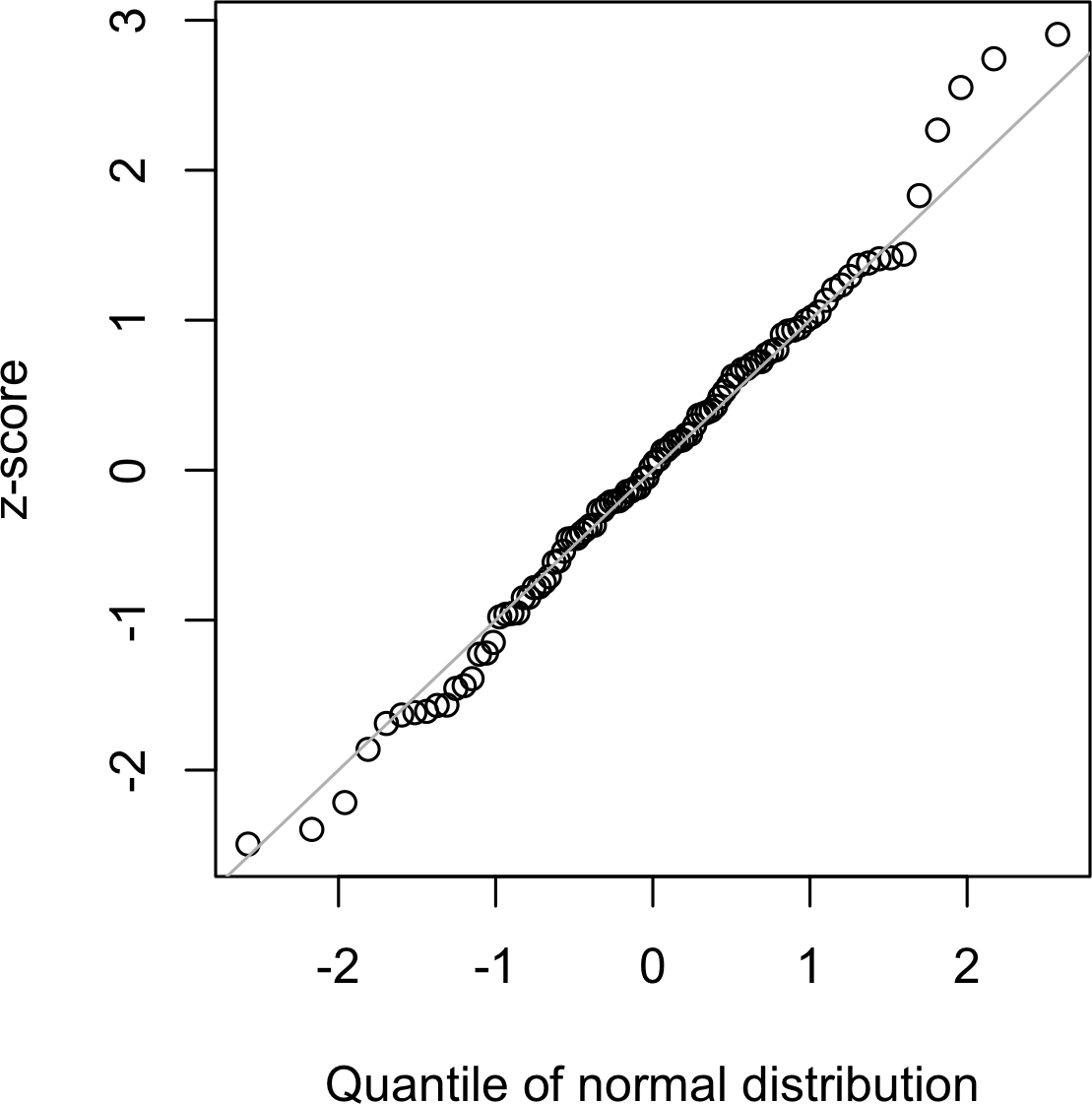

QQ-Plot

用于直观地确定一个样本与指定分布(在这种情况下是正态分布)的接近程度。QQ-Plot

将 z 分数从低到高排序,并在 y 轴上绘制每个值的 z

分数;x

轴是该值排名对应的正态分布分位数。由于数据已标准化,单位对应于距离均值的标准差数量。如果点大致落在对角线上,则可以认为样本分布接近正态。图 2-11 显示了从正态分布中随机生成的 100

个值样本的 QQ-Plot;如预期的那样,这些点紧密跟随该线。这个图可以在

R 中使用 qqnorm 函数产生:

norm_samp <- rnorm(100)

qqnorm(norm_samp)

abline(a=0, b=1, col='grey')在 Python 中,使用方法 scipy.stats.probplot

创建 QQ-Plot:

fig, ax = plt.subplots(figsize=(4, 4))

norm_sample = stats.norm.rvs(size=100)

stats.probplot(norm_sample, plot=ax)

将数据转换为 z 分数(即标准化或归一化数据)不会使数据呈正态分布。 它只是将数据放在与标准正态分布相同的尺度上,通常用于比较目的。

正态分布对统计学的历史发展至关重要,因为它允许对不确定性和变异性进行数学近似。

虽然原始数据通常不呈正态分布,但误差通常是正态分布的,大样本中的平均值和总和也是如此。

要将数据转换为 z 分数,你需要减去数据的均值并除以标准差;然后你可以将数据与正态分布进行比较。

尽管正态分布在统计学历史上很重要,并且与名称所暗示的相反,数据通常不呈正态分布。

频率分布的长而窄的部分,其中相对极值以低频率出现。

分布的一条尾部比另一条更长的情况。

虽然正态分布在误差分布和样本统计量的分布方面通常是适当和有用的,但它通常不能描述原始数据的分布特征。有时,分布是高度偏斜的(不对称),如收入数据;或者分布可以是离散的,如二项式数据。对称和不对称分布都可能有长尾。分布的尾部对应于极值(小值和大值)。长尾及其防范在实际工作中被广泛认知。Nassim Taleb 提出了黑天鹅理论,该理论预测异常事件(如股市崩盘)比正态分布所预测的更可能发生。

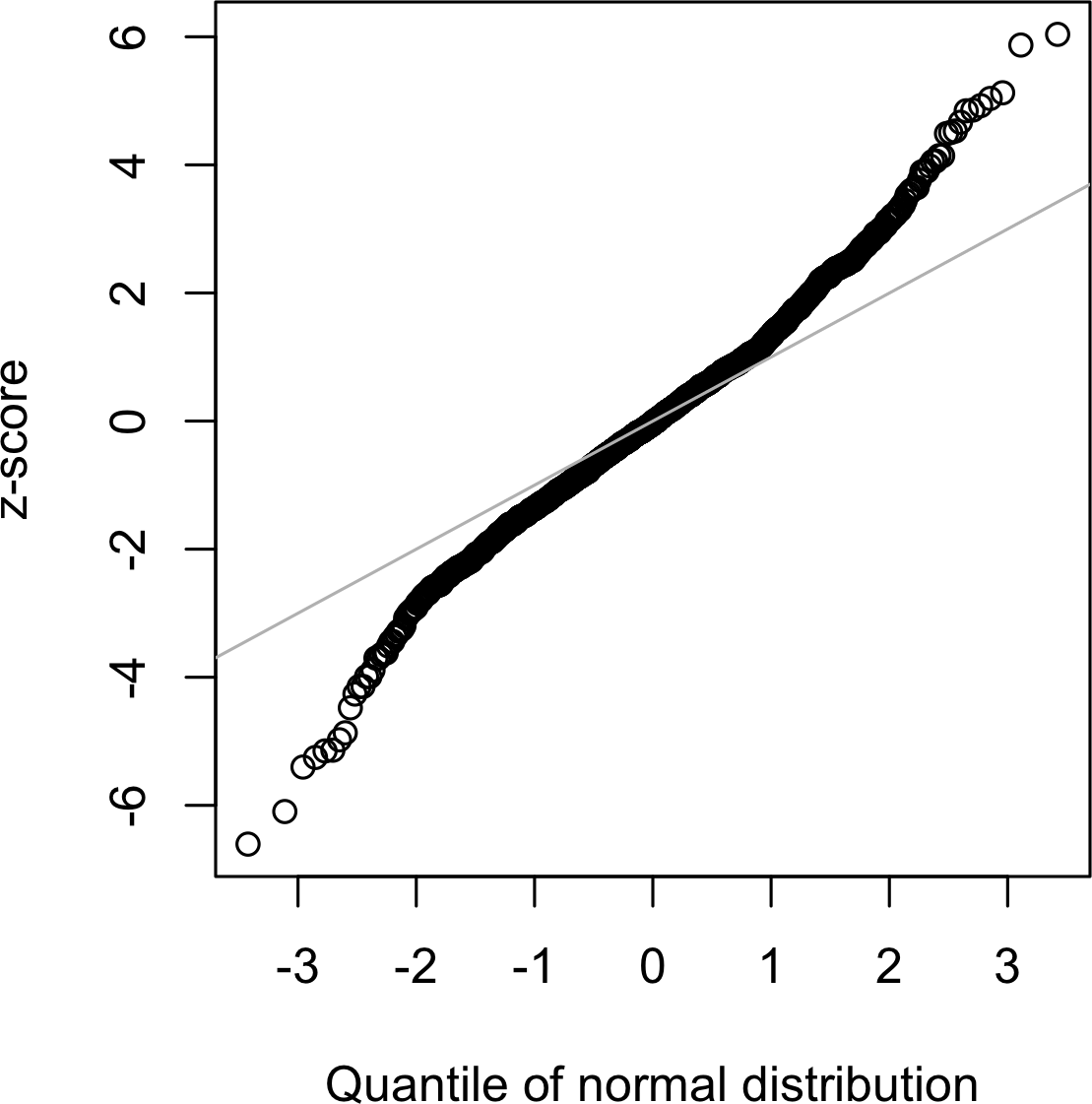

说明数据长尾性质的一个好例子是股票回报。图 2-12 显示了 Netflix (NFLX) 日股票回报的 QQ-Plot。这在 R 中通过以下方式生成:

nflx <- sp500_px[,'NFLX']

nflx <- diff(log(nflx[nflx>0]))

qqnorm(nflx)

abline(a=0, b=1, col='grey')相应的 Python 代码是:

nflx = sp500_px.NFLX

nflx = np.diff(np.log(nflx[nflx>0]))

fig, ax = plt.subplots(figsize=(4, 4))

stats.probplot(nflx, plot=ax)

与[图2-11]相比,这些点在低值时远低于直线,在高值时远高于直线,表明数据不是正态分布的。这意味着我们观察到极值的可能性远远大于数据具有正态分布时的预期。[图2-12]显示了另一个常见现象:对于均值一个标准差范围内的数据,这些点接近直线。Tukey将这种现象称为数据”中间正态”但具有更长的尾部(参见[Tukey-1987])。

关于将统计分布拟合到观测数据的任务,有大量的统计文献。要警惕过度以数据为中心的方法,这项工作既是艺术也是科学。数据是可变的,表面上通常与多种形状和类型的分布一致。通常情况下,必须运用领域知识和统计知识来确定哪种类型的分布适合模拟给定情况。例如,我们可能有关于服务器在许多连续五秒时间段内互联网流量水平的数据。了解建模”每个时间段的事件”的最佳分布是Poisson分布是有用的(参见[“Poisson分布”])。

大多数数据不是正态分布的。

假设正态分布可能导致对极端事件(“黑天鹅”)的低估。

《黑天鹅》第2版,纳西姆·尼古拉斯·塔勒布著(Random House出版社,2010年)

《统计分布手册及其应用》第2版,K. Krishnamoorthy著(Chapman & Hall/CRC Press出版社,2016年)

t-分布是一个正态形状的分布,除了它在尾部稍微更厚更长。它被广泛用于描述样本统计量的分布。样本均值的分布通常形状像t-分布,并且有一系列t-分布根据样本大小的不同而不同。样本越大,t-分布就越接近正态形状。

样本大小。

一个参数,允许t-分布适应不同的样本大小、统计量和组数。

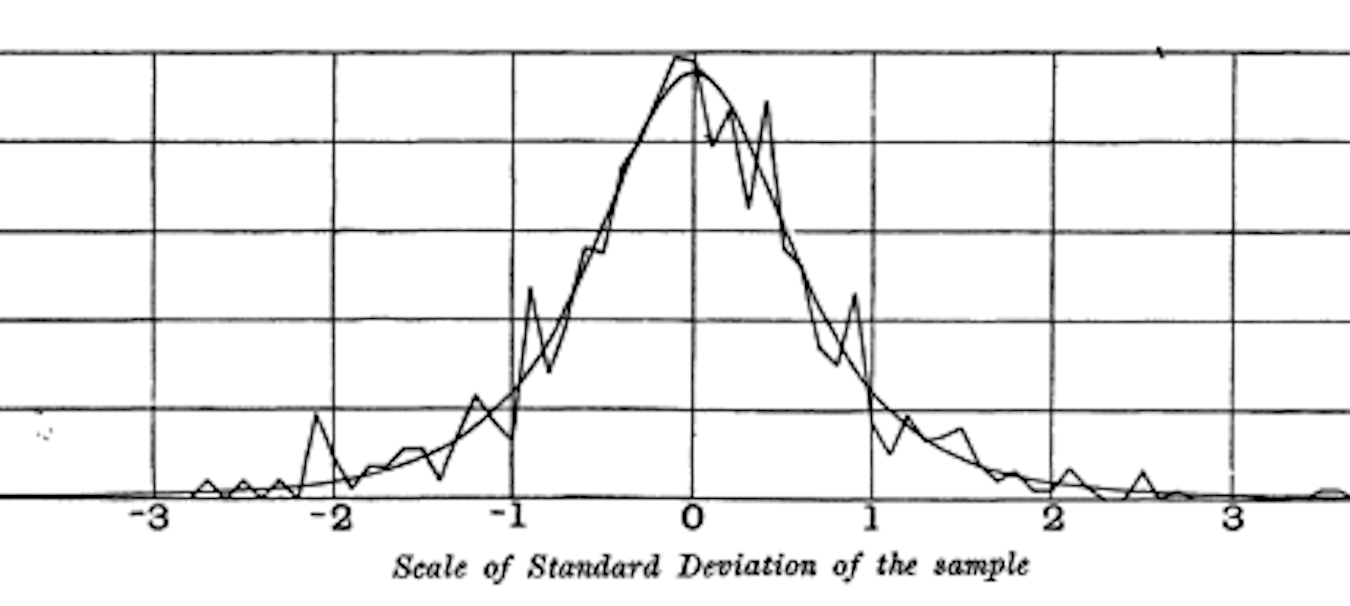

t-分布通常被称为Student’s t,因为它是由W. S. Gosset在1908年以”Student”的名字在《Biometrika》上发表的。Gosset的雇主,吉尼斯啤酒厂,不希望竞争对手知道它正在使用统计方法,因此坚持要求Gosset不要在文章上使用他的真名。

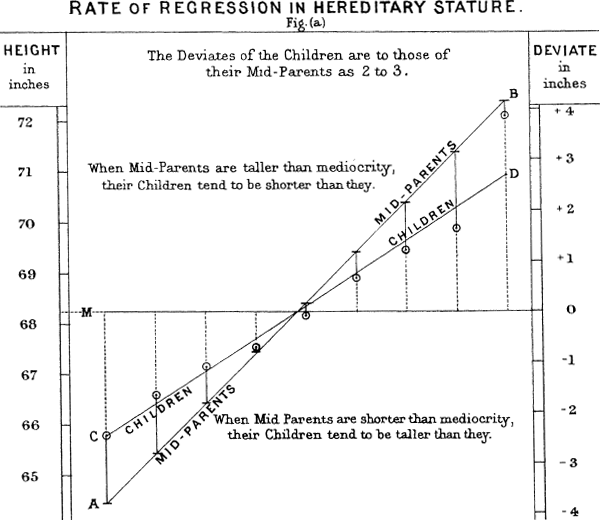

Gosset想要回答这个问题:“从更大总体中抽取的样本均值的抽样分布是什么?”他从一个重抽样实验开始——从包含3000个罪犯身高和左中指长度测量值的数据集中随机抽取大小为4的样本。(这是优生学时代,人们对罪犯数据非常感兴趣,并且热衷于发现犯罪倾向与身体或心理特征之间的相关性。)Gosset将标准化结果(z-分数)绘制在x轴上,将频率绘制在y轴上。另外,他推导出了一个现在被称为Student’s t的函数,并且他将这个函数拟合到样本结果上,绘制了比较图(见[图2-13])。

许多不同的统计量在标准化后都可以与t-分布进行比较,以便在考虑抽样变异的情况下估计置信区间。考虑一个大小为n的样本,已计算出样本均值。如果s是样本标准差,则样本均值周围的90%置信区间由以下公式给出:

其中t统计量的值具有(n - 1)个自由度(见[“自由度”]),在t分布的两端各”切掉”5%。t分布已被用作样本均值分布、两个样本均值之间差异、回归参数和其他统计量分布的参考。

如果在1908年计算能力就已广泛可得,统计学无疑会从一开始就更多地依赖计算密集型的重采样方法。由于缺乏计算机,统计学家转向数学和t分布等函数来近似抽样分布。计算机能力在1980年代使实用的重采样实验成为可能,但到那时,t分布和类似分布的使用已经深深嵌入教科书和软件中。

t分布在描述样本统计量行为方面的准确性要求该样本统计量的分布像正态分布一样成形。事实证明,样本统计量通常是正态分布的,即使底层总体数据不是正态分布(这一事实导致了t分布的广泛应用)。这让我们回到了被称为central limit theorem(见[“Central Limit Theorem”])的现象。

data scientist需要了解t分布和central limit theorem的哪些内容?不是很多。t分布在经典统计推断中使用,但对data science的目的并不那么核心。理解和量化不确定性和变异对data scientist很重要,但经验bootstrap抽样可以回答关于抽样误差的大多数问题。但是,data scientist会在统计软件和R中的统计程序输出中经常遇到t统计量——例如,在A/B测试和回归中——因此熟悉其目的是有帮助的。

t分布实际上是一个分布族,类似于正态分布但具有更厚的尾部。

t分布被广泛用作样本均值分布、两个样本均值之间差异、回归参数等的参考基础。

是/否(binomial)结果位于analytics的核心,因为它们通常是决策或其他过程的结果;买/不买、点击/不点击、生存/死亡等等。理解binomial distribution的核心是一组试验的概念,每次试验有两个具有确定概率的可能结果。

例如,抛硬币10次是一个有10次试验的binomial实验,每次试验有两个可能的结果(正面或反面);见图2-14。这样的是/否或0/1结果被称为binary结果,它们不需要有50/50的概率。任何总和为1.0的概率都是可能的。在统计学中,通常将”1”结果称为success结果;也通常将”1”分配给更罕见的结果。使用术语success并不意味着结果是理想的或有益的,但它确实倾向于指示感兴趣的结果。例如,贷款违约或欺诈交易是我们可能有兴趣预测的相对不常见的事件,因此它们被称为”1”或”success”。

具有离散结果的事件(例如,抛硬币)。

试验感兴趣的结果。

“1”(相对于”0”)

有两个结果。

是/否,0/1,binary

有两个结果的试验。

Bernoulli trial

x 次试验中成功次数的分布。

Bernoulli distribution

Binomial distribution是在给定试验次数(n)中成功次数(x)的频率分布,每次试验的成功概率为(p)。根据n和p的值,存在一系列binomial distribution。Binomial distribution可以回答如下问题:

如果点击转化为销售的概率是0.02,那么在200次点击中观察到0次销售的概率是多少?

R函数dbinom计算binomial概率。例如:

dbinom(x=2, size=5, p=0.1)将返回0.0729,即在5次试验中观察到恰好x =

2次成功的概率,其中每次试验的成功概率为p =

0.1。对于我们上面的例子,我们使用x = 0,size =

200,和p =

0.02。使用这些参数,dbinom返回概率0.0176。

通常我们感兴趣的是确定在n次试验中x次或更少成功的概率。在这种情况下,我们使用函数pbinom:

pbinom(2, 5, 0.1)这将返回0.9914,即在5次试验中观察到两次或更少成功的概率,其中每次试验的成功概率为0.1。

scipy.stats模块实现了大量的统计分布。对于binomial

distribution,使用函数stats.binom.pmf和stats.binom.cdf:

stats.binom.pmf(2, n=5, p=0.1)

stats.binom.cdf(2, n=5, p=0.1)Binomial distribution的均值是;你也可以将其视为在n次试验中的期望成功次数,成功概率 = p。

方差是。在足够多的试验次数下(特别是当p接近0.50时),binomial distribution实际上与normal distribution无法区分。事实上,用大样本量计算binomial概率在计算上是很繁重的,大多数统计程序使用normal distribution作为近似,其均值和方差。

Binomial结果很重要需要建模,因为它们代表了基本决策(购买或不购买,点击或不点击,生存或死亡等)。

Binomial trial是一个有两种可能结果的实验:一个概率为p,另一个概率为1 – p。

当n很大,且p不太接近0或1时,binomial distribution可以用normal distribution近似。

阅读关于“quincunx”的内容,这是一个类似弹球的模拟装置,用于说明binomial distribution。

Binomial distribution是统计学入门的基础内容,所有统计学入门教材都会有一到两章专门讲述它。

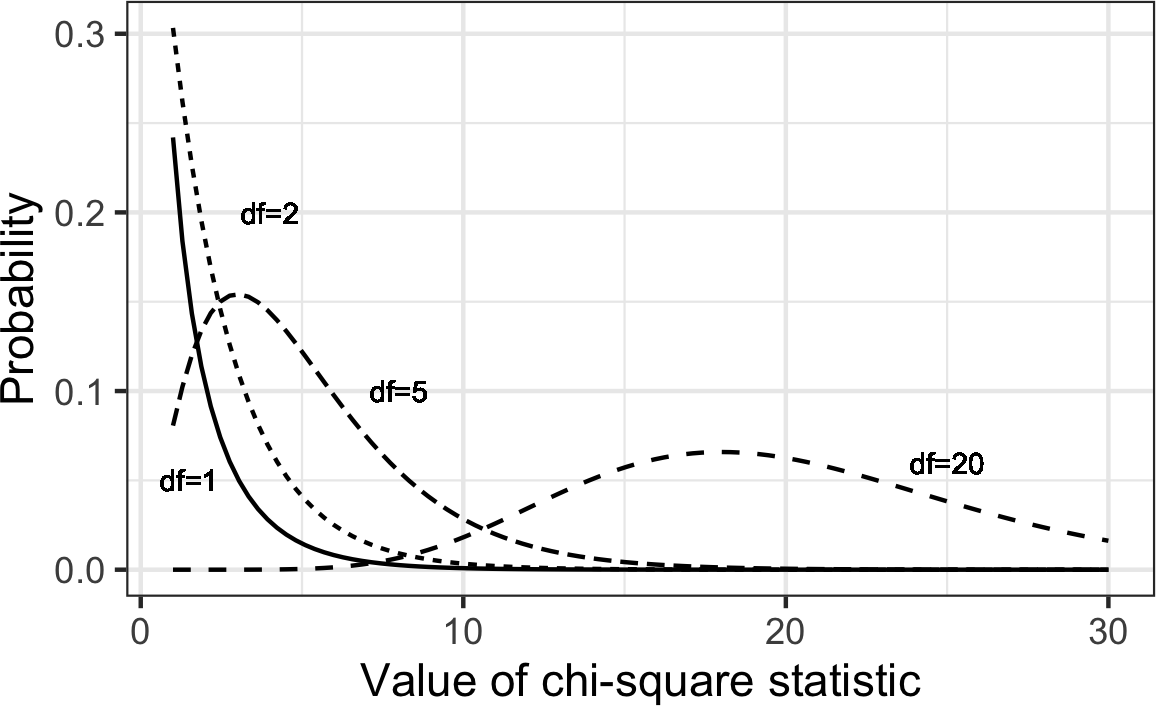

统计学中一个重要概念是偏离期望,特别是关于类别计数。期望被宽泛地定义为”数据中没有异常或值得注意的东西”(例如,变量之间没有相关性或可预测的模式)。这也被称为”null hypothesis”或”null model”(见“The Null Hypothesis”)。例如,你可能想测试一个变量(比如代表性别的行变量)是否独立于另一个变量(比如代表”工作中是否得到晋升”的列变量),并且你有数据表中每个单元格的计数。测量结果偏离独立性null期望程度的统计量是chi-square统计量。它是观察值和期望值之间的差异,除以期望值的平方根,然后平方,再在所有类别中求和。这个过程标准化了统计量,使其可以与参考分布进行比较。更一般的表述方式是注意到chi-square统计量是衡量一组观察值”拟合”指定分布程度的度量(“goodness-of-fit”检验)。它对于确定多个处理(“A/B/C…检验”)在效果上是否彼此不同很有用。

Chi-square分布是在从零假设模型的重复重采样抽取中该统计量的分布—详细算法请参见[“Chi-Square Test”]和数据表的chi-square公式。对于一组计数,较低的chi-square值表明它们与期望分布密切相符。较高的chi-square值表明它们与期望值明显不同。存在多种与不同自由度相关的chi-square分布(例如,观察数量—参见[“Degrees of Freedom”])。

Chi-square分布通常涉及落入各类别中的主体或项目的计数。

Chi-square统计量衡量偏离零假设模型期望值的程度。

Chi-square分布在现代统计学中的地位要归功于伟大的统计学家Karl Pearson和假设检验的诞生—在David Salsburg的《The Lady Tasting Tea: How Statistics Revolutionized Science in the Twentieth Century》(W. H. Freeman, 2001)中了解更多信息。

有关更详细的阐述,请参见本书中关于chi-square检验的章节([“Chi-Square Test”])。

科学实验中的一个常见程序是在各组之间测试多种处理—例如,在田地的不同区块上使用不同的肥料。这类似于chi-square分布中提到的A/B/C测试(参见[“Chi-Square Distribution”]),除了我们处理的是测量的连续值而不是计数。在这种情况下,我们关心的是组间均值的差异在多大程度上超出了正常随机变异下的预期。F统计量衡量这一点,它是组间均值变异性与各组内变异性(也称为残差变异性)的比值。这种比较被称为方差分析(参见[“ANOVA”])。F统计量的分布是在所有组均值相等的情况下(即零假设模型)随机排列数据所产生的所有值的频率分布。存在多种与不同自由度相关的F分布(例如,组数—参见[“Degrees of Freedom”])。F的计算在ANOVA章节中有说明。F统计量也用于线性回归中,比较回归模型解释的变异与数据总变异。F统计量由R和Python作为回归和ANOVA例程的一部分自动生成。

F分布用于涉及测量数据的实验和线性模型。

F统计量比较感兴趣因素引起的变异与总体变异。

George Cobb的《Introduction to Design and Analysis of Experiments》(Wiley, 2008)包含了方差成分分解的出色阐述,有助于理解ANOVA和F统计量。

许多过程以给定的总体速率随机产生事件—访问者到达网站,或汽车到达收费站(事件在时间上分布);一平方米织物中的缺陷,或每100行代码中的错字(事件在空间上分布)。

事件发生的速率(每单位时间或空间)。

在采样的时间或空间单位中事件数量的频率分布。

从一个事件到下一个事件的时间或距离的频率分布。

指数分布的泛化版本,其中事件速率允许随时间变化。

根据先前的汇总数据(例如,每年流感感染的数量),我们可以估计每单位时间或空间内事件的平均数量(例如,每日感染人数,或每个普查单位的感染人数)。我们也可能想知道不同时间/空间单位之间的差异程度。Poisson分布告诉我们当采样许多这样的单位时,每单位时间或空间内事件的分布情况。它在解决排队问题时很有用,比如”我们需要多少容量才能95%确信能完全处理服务器在任何五秒钟内到达的互联网流量?”

Poisson分布的关键参数是λ,或lambda。这是在指定时间或空间间隔内发生的事件的平均数量。Poisson分布的方差也是λ。

一种常见技术是从Poisson分布生成随机数作为排队仿真的一部分。R中的rpois函数可以做到这一点,只需要两个参数——所需随机数的数量和lambda:

rpois(100, lambda=2)相应的scipy函数是stats.poisson.rvs:

stats.poisson.rvs(2, size=100)这段代码将从λ = 2的Poisson分布生成100个随机数。例如,如果入站客户服务电话平均每分钟两个,这段代码将模拟100分钟,返回这100分钟中每分钟的通话数量。

使用我们在Poisson分布中使用的相同参数,我们还可以对事件之间的时间分布进行建模:网站访问之间的时间或汽车到达收费站之间的时间。它也用于工程中对故障时间建模,以及在流程管理中建模,例如,每次服务调用所需的时间。R代码从指数分布生成随机数需要两个参数:n(要生成的数字数量)和rate(每时间段的事件数量)。例如:

rexp(n=100, rate=0.2)在函数stats.expon.rvs中,参数的顺序是相反的:

stats.expon.rvs(0.2, size=100)这段代码将从指数分布生成100个随机数,其中每时间段的平均事件数量是0.2。因此,您可以使用它来模拟100个服务调用之间的间隔(以分钟为单位),其中入站调用的平均速率是每分钟0.2次。

Poisson分布或指数分布的任何仿真研究中的一个关键假设是速率λ在所考虑的期间内保持恒定。这在全局意义上很少是合理的;例如,道路或数据网络上的流量因一天中的时间和一周中的天数而变化。然而,时间段或空间区域通常可以分为足够同质的段,使得在这些期间内的分析或仿真是有效的。

在许多应用中,事件率λ是已知的或可以从先前数据估计出来。然而,对于罕见事件,这并不一定如此。例如,飞机发动机失效足够罕见(幸运的是),对于给定的发动机类型,可能很少有数据可以作为估计失效间隔时间的基础。没有数据时,几乎没有基础来估计事件率。然而,您可以做一些猜测:如果在20小时后没有看到事件,您可以很确定速率不是每小时1次。通过仿真或概率的直接计算,您可以评估不同的假设事件率,并估计速率不太可能低于的阈值。如果有一些数据但不足以提供精确、可靠的速率估计,可以将拟合优度检验(参见”卡方检验”)应用于各种速率,以确定它们与观察数据的拟合程度。

在许多情况下,事件率并不会随时间保持恒定。如果其变化的时间段远长于事件之间的典型间隔,就没有问题;你只需将分析细分为事件率相对恒定的片段,如前所述。然而,如果事件率在间隔时间内发生变化,指数(或Poisson)分布就不再有用了。这在机械故障中很可能出现——故障风险随着时间推移而增加。Weibull分布是指数分布的扩展,其中允许事件率根据形状参数的规定而改变。如果>1,事件概率随时间增加;如果<1,概率下降。由于Weibull分布用于时间-故障分析而非事件率,第二个参数以特征寿命而非每间隔事件率来表示。使用的符号是,希腊字母eta。它也被称为尺度参数。

对于Weibull分布,估计任务现在包括对两个参数和的估计。使用软件对数据建模并产生最佳拟合Weibull分布的估计。

R代码从Weibull分布生成随机数需要三个参数:n(要生成的数字数量)、shape和scale。例如,以下代码将从形状为1.5、特征寿命为5,000的Weibull分布生成100个随机数(寿命):

rweibull(100, 1.5, 5000)要在Python中实现相同功能,使用函数stats.weibull_min.rvs:

stats.weibull_min.rvs(1.5, scale=5000, size=100)对于以恒定速率发生的事件,每单位时间或空间的事件数量可以建模为Poisson分布。

你也可以将一个事件到下一个事件之间的时间或距离建模为指数分布。

随时间变化的事件率(例如,设备故障概率的增加)可以用Weibull分布建模。

Thomas Ryan的Modern Engineering Statistics(Wiley,2007)有一章专门介绍工程应用中使用的概率分布。

在大数据时代,当需要准确估计时,随机抽样的原则仍然重要。数据的随机选择可以减少偏差,产生比仅使用方便可得数据更高质量的数据集。对各种抽样和数据生成分布的了解使我们能够量化由于随机变异可能导致的估计中的潜在误差。同时,bootstrap(从观察到的数据集中有放回抽样)是一种有吸引力的”一刀切”方法,用于确定样本估计中可能的误差。

1 钟形曲线具有标志性但可能被高估了。乔治·W·科布(George W. Cobb),这位以对统计学入门教学哲学贡献而闻名的蒙特霍利约克统计学家,在2015年11月《美国统计学家》的一篇社论中论证,“以正态分布为中心的标准入门课程,其中心地位的有用性已经过时。”

实验设计是统计学实践的基石,几乎在所有研究领域都有应用。目标是设计实验以确认或拒绝假设。数据科学家通常需要进行持续的实验,特别是在用户界面和产品营销方面。本章回顾传统实验设计,讨论数据科学中的一些常见挑战。它还涵盖统计推断中一些经常引用的概念,并解释它们对数据科学的意义和相关性(或缺乏相关性)。

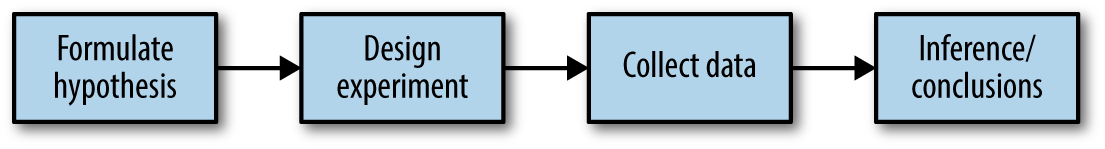

每当你看到统计显著性(statistical significance)、t-tests或p-values的引用时,通常都是在经典统计推断”pipeline”的背景下(见图3-1)。这个过程从一个假设开始(“药物A比现有标准药物更好”,或”价格A比现有价格B更有利可图”)。设计一个实验(可能是A/B测试)来检验假设——以这样一种方式设计,希望能够提供结论性的结果。收集和分析数据,然后得出结论。术语推断(inference)反映了将涉及有限数据集的实验结果应用到更大过程或总体的意图。

A/B测试是一个有两个组的实验,用来确定两种treatment、产品、程序等中哪一种更优。通常两种treatment中的一种是标准的现有treatment,或者没有treatment。如果使用标准(或无)treatment,则称为对照组(control)。典型的假设是新treatment比对照组更好。

受试者接触的某种东西(药物、价格、网页标题)。

接触特定treatment的受试者组。

接触无(或标准)treatment的受试者组。

将受试者随机分配到treatment的过程。

接触treatment的项目(网站访问者、患者等)。

用于衡量treatment效果的指标。

A/B测试在网页设计和营销中很常见,因为结果很容易测量。A/B测试的一些例子包括:

测试两种土壤treatment以确定哪种产生更好的种子发芽

测试两种疗法以确定哪种更有效地抑制癌症

测试两种价格以确定哪种产生更多的净利润

测试两个网页标题以确定哪个产生更多点击(图3-2)

测试两个网页广告以确定哪个产生更多转化

适当的A/B测试有可以分配到一种或另一种treatment的受试者。受试者可能是一个人、一粒植物种子、一个网站访问者;关键是受试者接触treatment。理想情况下,受试者被随机化(随机分配)到treatment。这样,你知道treatment组之间的任何差异都是由以下两种情况之一造成的:

不同treatment的效果

哪些受试者被分配到哪些treatment的抽签运气(即,随机分配可能导致自然表现更好的受试者集中在A或B中)

你还需要注意用于比较A组和B组的测试统计量或指标。也许data science中最常见的指标是二元变量:点击或不点击,购买或不购买,欺诈或无欺诈,等等。这些结果将汇总在2×2表中。表3-1是实际价格测试的2×2表(参见”统计显著性和p-Values”以进一步讨论这些结果)。

| 结果 | 价格A | 价格B |

|---|---|---|

| 转化 | 200 | 182 |

| 无转化 | 23,539 | 22,406 |

表3-1. 电商实验结果的2×2表

如果指标是连续变量(购买金额、利润等)或计数变量(如住院天数、访问页面数),结果可能会以不同方式显示。如果感兴趣的不是转化率而是每页面浏览收入,那么表3-1中价格测试的结果在典型的默认软件输出中可能看起来像这样:

价格A的收入/页面浏览:均值 = 3.87,SD = 51.10

价格B的收入/页面浏览:均值 = 4.11,SD = 62.98

“SD”指的是每组内数值的标准差。

仅仅因为统计软件——包括R和Python——默认生成输出,并不意味着所有输出都有用或相关。你可以看到前面的标准差并不是很有用;表面上它们暗示许多值可能是负数,而负收入是不可能的。这些数据由一小部分相对较高的值(有转化的页面浏览)和大量的0值(无转化的页面浏览)组成。用单一数字来总结这类数据的变异性是困难的,尽管平均绝对偏差(A为7.68,B为8.15)比标准差更合理。

为什么不跳过对照组,只对一个组进行感兴趣的处理实验,然后将结果与之前的经验进行比较?

没有对照组,就无法保证”其他所有条件都相等”,任何差异真的是由于处理(或偶然)造成的。当你有对照组时,它与处理组受到相同的条件影响(除了感兴趣的处理)。如果你只是与”基线”或之前的经验进行比较,除了处理之外的其他因素可能会有所不同。

盲法研究是指受试者不知道自己接受的是处理A还是处理B的研究。知道接受特定处理可能会影响反应。双盲研究是指研究者和协助者(如医学研究中的医生和护士)也不知道哪些受试者接受哪种处理的研究。当处理的性质是透明的时候,盲法是不可能的——例如,计算机认知疗法与心理学家认知疗法的比较。

数据科学中的A/B测试通常用于网络环境。处理可能是网页设计、产品价格、标题措辞或其他项目。需要一些思考来保持随机化原则。通常实验中的受试者是网站访问者,我们感兴趣测量的结果是点击、购买、访问时长、访问页面数、是否访问特定页面等。在标准A/B实验中,你需要提前决定一个指标。可能会收集多个行为指标并且都感兴趣,但如果实验预期会导致在处理A和处理B之间做出决定,就需要事先建立单一指标或测试统计量。在实验完成之后选择测试统计量会为研究者偏见打开大门。

A/B测试在营销和电子商务领域很受欢迎,但远非唯一的统计实验类型。可以包含额外的处理。受试者可能进行重复测量。在受试者稀缺、昂贵且随时间获得的药物试验中,有时会设计多次停止实验并得出结论的机会。

传统的统计实验设计专注于回答关于指定处理效果的静态问题。数据科学家对以下问题较少感兴趣:

价格A和价格B之间的差异在统计上是否显著?

而对以下问题更感兴趣:

在多个可能的价格中,哪个是最好的?

为此,使用了一种相对较新的实验设计:multi-arm bandit(参见“Multi-Arm Bandit Algorithm”)。

在涉及人类受试者的科学和医学研究中,通常需要获得他们的许可,以及获得机构审查委员会的批准。作为日常运营一部分进行的商业实验几乎从不这样做。在大多数情况下(例如,定价实验,或关于显示哪个标题或应该提供哪个优惠的实验),这种做法被广泛接受。然而,Facebook 在2014年进行用户新闻提要情感倾向实验时违背了这种普遍接受度。Facebook 使用情感分析将新闻提要帖子分类为积极或消极,然后改变向用户显示内容的积极/消极平衡。一些随机选择的用户体验到更多积极帖子,而其他用户体验到更多消极帖子。Facebook 发现体验到更积极新闻提要的用户更有可能自己发布积极帖子,反之亦然。然而,效果的幅度很小,Facebook 因在用户不知情的情况下进行实验而面临很多批评。一些用户推测,如果极度抑郁的用户收到消极版本的提要,Facebook 可能会把他们推向崩溃边缘。

受试者被分配到两个(或更多)组,这些组的处理方式完全相同,除了所研究的处理在不同组之间有所不同。

理想情况下,受试者被随机分配到各组。

两组比较(A/B测试)是传统统计的基础,几乎任何入门统计教材都会广泛涵盖设计原则和推理程序。如需将A/B测试置于更多数据科学背景并使用重采样的讨论,请参见 Peter Bruce 的《Introductory Statistics and Analytics: A Resampling Perspective》(Wiley,2014)。

对于网页测试,测试的后勤方面可能与统计方面一样具有挑战性。一个好的起点是 Google Analytics 实验帮助部分。

当心在网络上随处可见的A/B测试指南中找到的建议,比如某个指南中的这些话:“等待大约1000个总访客,确保测试运行一周。”这种一般的经验法则在统计上没有意义;更多细节请参见[“功效和样本大小”]。

假设检验,也称为显著性检验,在已发表研究的传统统计分析中无处不在。其目的是帮助您了解随机机会是否可能是观察到的效应的原因。

机会是罪魁祸首的假设。

零假设的对立面(您希望证明的内容)。

仅在一个方向上计算机会结果的假设检验。

在两个方向上计算机会结果的假设检验。

A/B测试(参见[“A/B测试”])通常是在心中有假设的情况下构建的。例如,假设可能是价格B产生更高利润。为什么我们需要假设?为什么不直接查看实验结果,选择表现更好的处理方法呢?

答案在于人类心理倾向于低估自然随机行为的范围。这种表现的一个方面是未能预料到极端事件,或所谓的”黑天鹅”(参见“长尾分布”)。另一个表现是倾向于将随机事件误解为具有某种重要意义的模式。统计假设检验被发明用来保护研究人员免受随机机会的欺骗。

你可以在这个实验中观察到人类低估随机性的倾向。让几个朋友发明一系列50次抛硬币:让他们写下一系列随机的H和T。然后让他们实际抛硬币50次并写下结果。让他们把真实的抛硬币结果放在一堆,把编造的结果放在另一堆。很容易辨别哪些结果是真实的:真实的结果会有更长的H或T的连续序列。在50次真实抛硬币中,连续出现五六次H或T是完全正常的。然而,当我们大多数人在编造随机抛硬币结果时,如果连续得到三四次H,我们会告诉自己,为了让序列看起来随机,我们最好转换到T。

这个硬币的另一面是,当我们确实看到现实世界中相当于连续六次H的情况(例如,当一个标题比另一个表现好10%),我们倾向于将其归因于某种真实的原因,而不仅仅是偶然。

在设计良好的A/B测试中,你以这样的方式收集处理A和B的数据,即A和B之间任何观察到的差异必须归因于:

受试者分配中的随机机会

A和B之间的真实差异

统计假设检验是对A/B测试或任何随机实验的进一步分析,用来评估随机机会是否是观察到的A组和B组之间差异的合理解释。

假设检验使用以下逻辑:“鉴于人类倾向于对不寻常但随机的行为做出反应并将其解释为有意义和真实的东西,在我们的实验中,我们将要求证明组间差异比机会可能合理产生的更极端。”这涉及一个基线假设,即处理是等效的,组间任何差异都是由于机会。这个基线假设被称为零假设。然后,我们的希望是实际上能够证明零假设错误,并表明A组和B组的结果比机会可能产生的更不同。

做到这一点的一种方法是通过重采样置换程序,我们将A组和B组的结果混合在一起,然后反复将数据分成相似大小的组,然后观察我们得到与观察到的差异一样极端的差异的频率。来自A组和B组的合并混合结果,以及从中重采样的程序,体现了A组和B组等效且可互换的零假设,称为零模型。更多详细内容请参见“重采样”。

假设检验本质上不仅涉及零假设,还涉及相对的备择假设。以下是一些例子:

零假设 = “A组和B组的均值没有差异”;备择假设 = “A与B不同”(可能更大或更小)

零假设 = “A ≤ B”;备择假设 = “A > B”

零假设 = “B不比A大X%”;备择假设 = “B比A大X%”

零假设和备择假设结合起来,必须涵盖所有可能性。零假设的性质决定了假设检验的结构。

在A/B测试中,你通常会测试一个新选项(比如B)对比一个已确立的默认选项(A),而假设是你会坚持使用默认选项,除非新选项证明自己明显更好。在这种情况下,你希望hypothesis test保护你不被偏向B方向的随机性所愚弄。你不关心另一个方向的随机愚弄,因为除非B明确证明更好,否则你会坚持使用A。所以你需要一个定向的备择假设(B比A更好)。在这种情况下,你使用单向(或单尾)hypothesis test。这意味着只有一个方向的极端随机结果会计入p-value。

如果你希望hypothesis test保护你不被任何方向的随机性愚弄,备择假设是双向的(A与B不同;可能更大或更小)。在这种情况下,你使用双向(或双尾)hypothesis test。这意味着两个方向的极端随机结果都会计入p-value。

单尾hypothesis

test通常符合A/B决策的性质,在这种决策中需要做出决定,一个选项通常被指定为”默认”状态,除非另一个选项证明更好。然而,软件(包括R和Python中的scipy)通常在其默认输出中提供双尾测试,许多统计学家选择更保守的双尾测试只是为了避免争议。单尾versus双尾是一个令人困惑的主题,对数据科学来说不是特别相关,因为p-value计算的精确性并不十分重要。

零假设是一个逻辑构造,体现了没有发生特殊事情的概念,你观察到的任何效应都是由于随机机会。

Hypothesis test假设零假设为真,创建一个”零模型”(概率模型),并测试你观察到的效应是否是该模型的合理结果。

Leonard Mlodinow的The Drunkard’s Walk(Pantheon出版社,2008年)是对”随机性统治我们生活”方式的可读性调查。

David Freedman、Robert Pisani和Roger Purves的经典统计学教材Statistics第4版(W. W. Norton出版社,2007年),对包括hypothesis testing在内的大多数统计学主题都有出色的非数学处理。

Peter Bruce的Introductory Statistics and Analytics: A Resampling Perspective(Wiley出版社,2014年)使用resampling开发hypothesis testing概念。

统计学中的Resampling意味着从观察数据中重复抽样值,一般目标是评估统计量的随机变异性。它还可以用于评估和改进某些机器学习模型的准确性(例如,在多个bootstrapped数据集上构建的决策树模型的预测可以在称为bagging的过程中进行平均——参见”Bagging and the Random Forest”)。

有两种主要类型的resampling程序:bootstrap和permutation tests。Bootstrap用于评估估计的可靠性;在前一章中讨论过(参见”The Bootstrap”)。Permutation tests用于测试假设,通常涉及两个或更多组,我们在本节中讨论这些。

将两个或更多样本组合在一起,并随机(或穷尽地)将观察值重新分配给重采样的程序。

Randomization test、random permutation test、exact test

从观察数据集中抽取额外样本(“重新样本”)。

在抽样中,是否在下次抽取前将项目放回样本中。

在permutation程序中,涉及两个或更多样本,通常是A/B或其他假设检验中的组别。Permute意味着改变一组数值的顺序。假设permutation test的第一步是将A组和B组(如果使用的话,还有C、D…组)的结果合并。这是零假设的逻辑体现,即各组所接受的处理没有差异。然后我们通过从这个合并集中随机抽取组别并观察它们之间的差异程度来检验该假设。Permutation程序如下:

将不同组别的结果合并到单一数据集中。

打乱合并后的数据,然后随机抽取(无放回)一个与A组大小相同的重新样本(显然它会包含来自其他组的一些数据)。

从剩余数据中,随机抽取(无放回)一个与B组大小相同的重新样本。

对C、D组等做同样操作。现在你已经收集了一组反映原始样本大小的重新样本。

无论为原始样本计算了什么统计量或估计值(例如,组间比例差异),现在为重新样本计算它,并记录;这构成一次permutation迭代。

重复前面的步骤R次,以产生检验统计量的permutation分布。

现在回到观察到的组间差异,将其与permutation差异集进行比较。如果观察到的差异完全处于permutation差异集的范围内,那么我们没有证明任何东西——观察到的差异在偶然可能产生的范围内。然而,如果观察到的差异位于大部分permutation分布之外,那么我们得出结论认为偶然不是原因。用技术术语来说,差异是统计显著的。(参见[“Statistical Significance and p-Values”])

一家销售相对高价值服务的公司想要测试两种web展示中哪一种能更好地完成销售工作。由于所销售服务的高价值,销售不频繁且销售周期很长;积累足够的销售数据来了解哪种展示更优秀需要太长时间。因此公司决定使用proxy变量来衡量结果,使用描述服务的详细内页。

Proxy变量是代替真正感兴趣变量的变量,后者可能不可获得、成本太高或测量耗时太长。例如,在气候研究中,古代冰芯的氧含量被用作温度的proxy。至少拥有一些关于真正感兴趣变量的数据是有用的,这样可以评估它与proxy的关联强度。

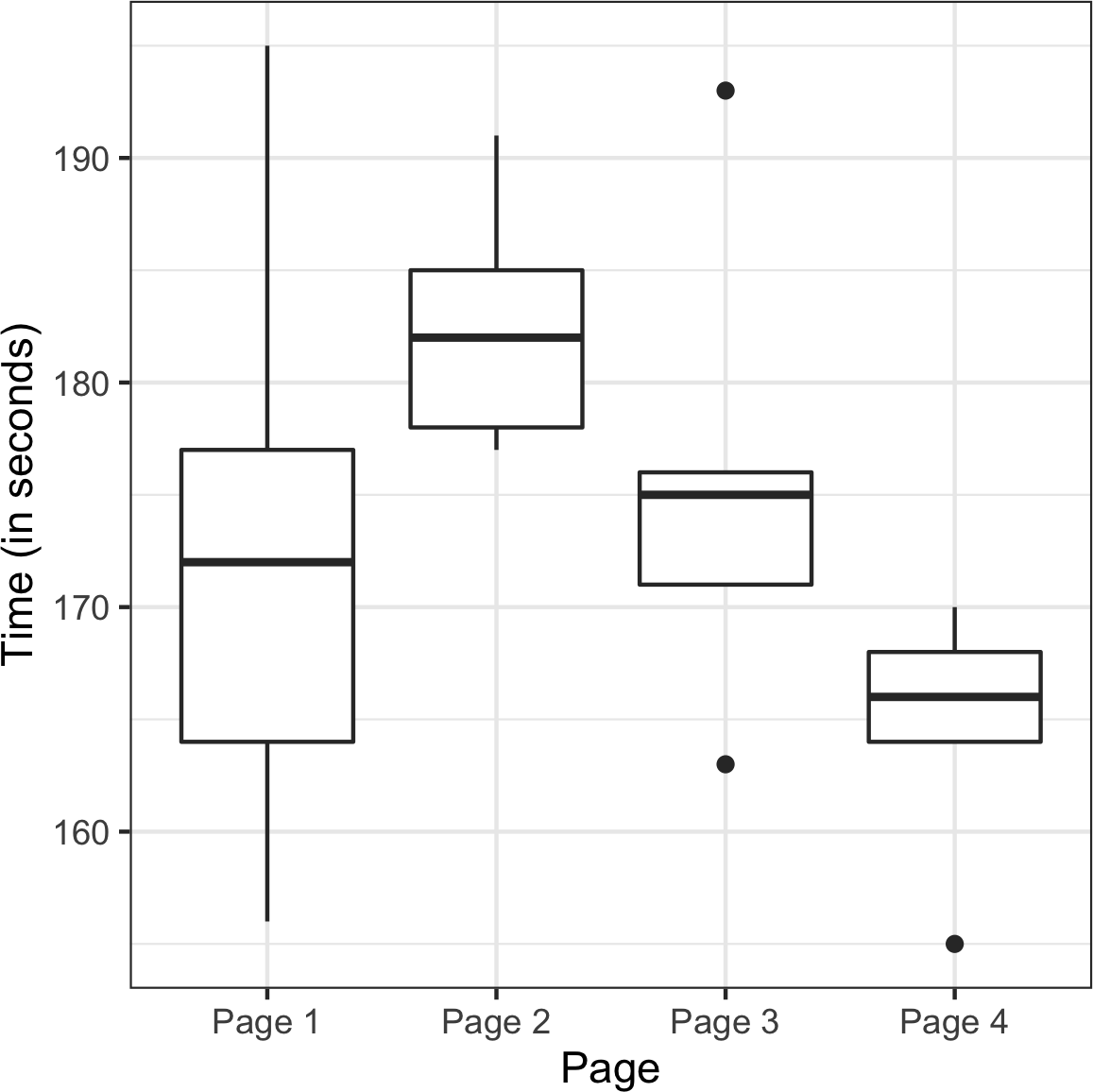

对我们公司来说,一个潜在的proxy变量是详细着陆页的点击次数。更好的一个是人们在页面上花费的时间。合理地认为,能够更长时间吸引人们注意力的web展示(页面)将带来更多销售。因此,我们的指标是平均会话时间,比较页面A与页面B。

由于这是一个内部的、特殊用途的页面,它没有接收到大量访问者。还要注意,Google

Analytics(我们测量会话时间的方式)无法测量某人访问的最后一个会话的会话时间。Google

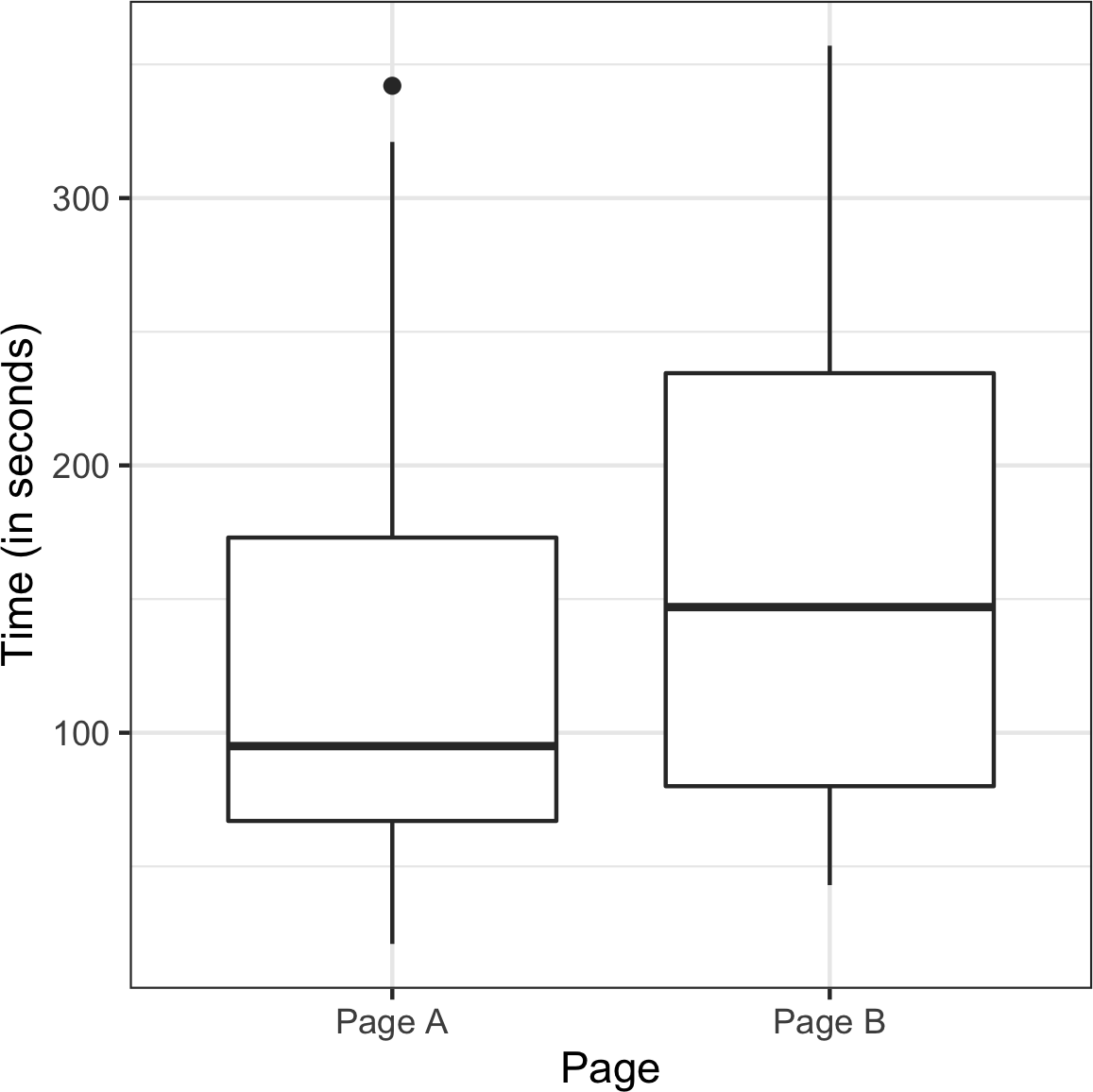

Analytics不是从数据中删除该会话,而是将其记录为零,因此数据需要额外处理来移除这些会话。结果是两种不同展示总共有36个会话,页面A有21个,页面B有15个。使用ggplot,我们可以使用并排箱线图直观地比较会话时间:

ggplot(session_times, aes(x=Page, y=Time)) +

geom_boxplot()pandas的boxplot命令使用关键字参数by创建图形:

ax = session_times.boxplot(by='Page', column='Time')

ax.set_xlabel('')

ax.set_ylabel('Time (in seconds)')

plt.suptitle('')如图 Figure 3-3 所示的箱形图表明,页面B比页面A带来更长的会话时间。在R中,每组的均值可以按如下方式计算:

mean_a <- mean(session_times[session_times['Page'] == 'Page A', 'Time'])

mean_b <- mean(session_times[session_times['Page'] == 'Page B', 'Time'])

mean_b - mean_a

[1] 35.66667在Python中,我们首先按页面过滤pandas数据框,然后确定Time列的均值:

mean_a = session_times[session_times.Page == 'Page A'].Time.mean()

mean_b = session_times[session_times.Page == 'Page B'].Time.mean()

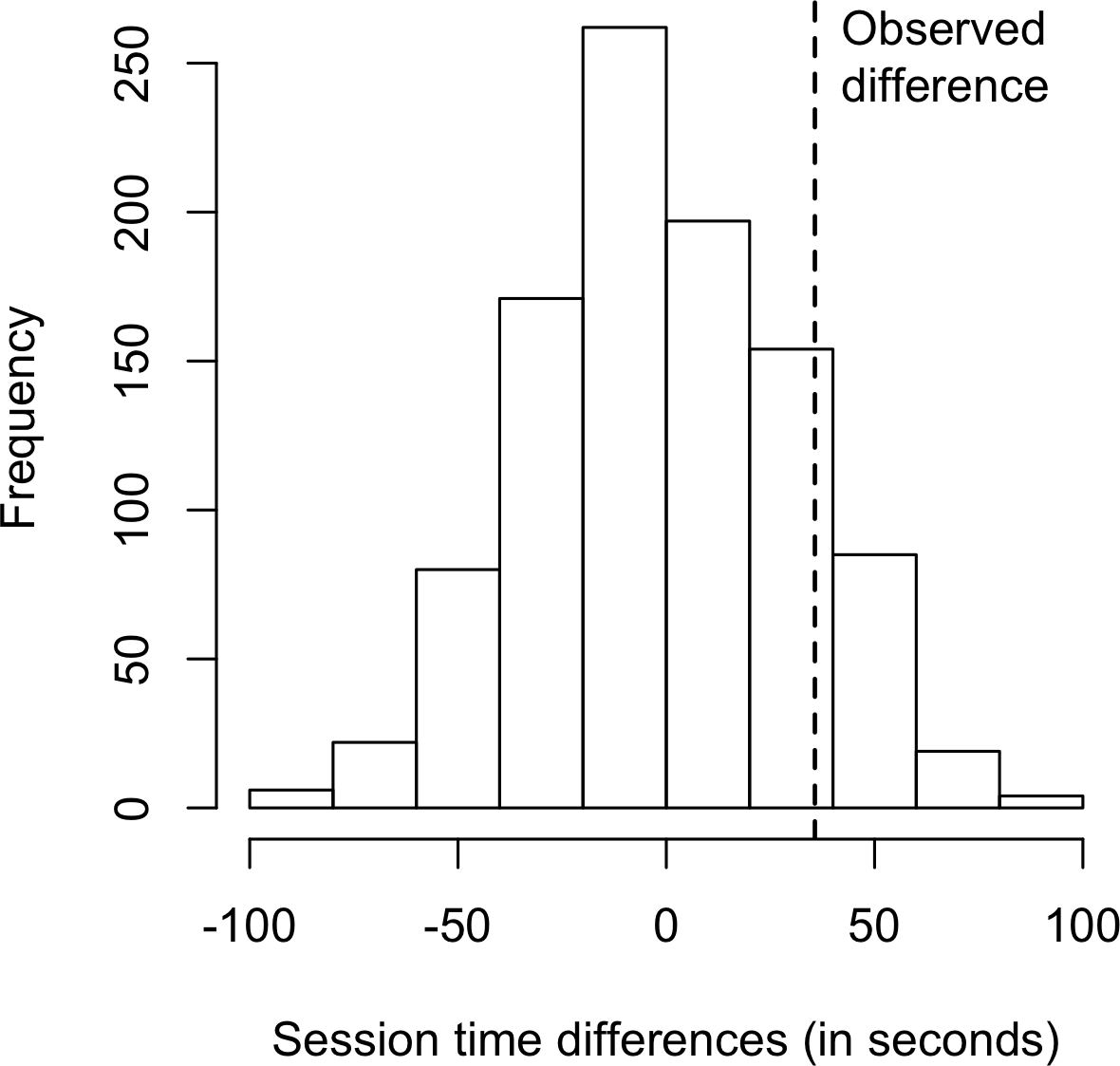

mean_b - mean_a页面B的会话时间平均比页面A长35.67秒。问题是这种差异是否在随机机会可能产生的范围内,即是否具有统计显著性。回答这个问题的一种方法是应用permutation test——将所有会话时间合并在一起,然后重复打乱并将它们分为21个一组(回想一下,这是页面A的数量)和15个一组(页面B的数量)。

要应用permutation test,我们需要一个函数来随机将36个会话时间分配给21个一组(页面A)和15个一组(页面B)。这个函数的R版本是:

perm_fun <- function(x, nA, nB)

{

n <- nA + nB

idx_b <- sample(1:n, nB)

idx_a <- setdiff(1:n, idx_b)

mean_diff <- mean(x[idx_b]) - mean(x[idx_a])

return(mean_diff)

}这个permutation test的Python版本如下:

def perm_fun(x, nA, nB):

n = nA + nB

idx_B = set(random.sample(range(n), nB))

idx_A = set(range(n)) - idx_B

return x.loc[idx_B].mean() - x.loc[idx_A].mean()

这个函数通过采样(不放回)索引并将它们分配给B组来工作;剩余的索引被分配给A组。返回两个均值之间的差异。调用这个函数R

=

1,000次并指定参数,会产生会话时间差异的分布,可以绘制成直方图。在R中,使用hist函数可以这样做:

perm_diffs <- rep(0, 1000)

for (i in 1:1000) {

perm_diffs[i] = perm_fun(session_times[, 'Time'], 21, 15)

}

hist(perm_diffs, xlab='Session time differences (in seconds)')

abline(v=mean_b - mean_a)在Python中,我们可以使用matplotlib创建类似的图形:

perm_diffs = [perm_fun(session_times.Time, nA, nB) for _ in range(1000)]

fig, ax = plt.subplots(figsize=(5, 5))

ax.hist(perm_diffs, bins=11, rwidth=0.9)

ax.axvline(x = mean_b - mean_a, color='black', lw=2)

ax.text(50, 190, 'Observed\ndifference', bbox={'facecolor':'white'})

ax.set_xlabel('Session time differences (in seconds)')

ax.set_ylabel('Frequency')如图 Figure 3-4 所示的直方图显示,随机permutation的均值差异经常超过观察到的会话时间差异(垂直线)。在我们的结果中,这种情况在12.6%的案例中发生:

mean(perm_diffs > (mean_b - mean_a))

---

0.126由于模拟使用随机数,百分比会有所变化。例如,在Python版本中,我们得到了12.1%:

np.mean(perm_diffs > mean_b - mean_a)

---

0.121这表明页面A和页面B之间观察到的会话时间差异完全在偶然变异的范围内,因此不具有统计显著性。

除了前面的随机打乱程序,也称为随机permutation test或随机化测试,还有两种permutation test的变体:

穷举permutation test

bootstrap permutation test

在穷尽排列检验中,我们不是仅仅随机洗牌和划分数据,而是实际计算出所有可能的划分方式。这只对相对较小的样本量才实用。通过大量重复洗牌,随机排列检验结果会接近穷尽排列检验的结果,并在极限情况下收敛。穷尽排列检验有时也被称为精确检验,这是由于它们具有统计性质,能够保证零模型不会以超过检验的 alpha 水平的频率被测试为”显著”(参见“统计显著性和 p 值”)。

在 bootstrap 排列检验中,随机排列检验第2步和第3步中概述的抽取是有放回的,而不是无放回的。这样,重抽样程序不仅模拟了治疗分配给受试者的随机要素,还模拟了从总体中选择受试者的随机要素。这两种程序在统计学中都会遇到,它们之间的区别有些复杂,在数据科学实践中并不重要。

排列检验是探索随机变异作用的有用启发式程序。它们相对容易编码、解释和说明,并且提供了一个有用的绕道,避开了基于公式统计的形式主义和”虚假决定论”,在这种方法中,公式”答案”的精确性往往暗示着不当的确定性。

与公式方法相比,重抽样的一个优点是它更接近于一种适用于所有推断的万能方法。数据可以是数值型或二元型。样本量可以相同或不同。不需要关于正态分布数据的假设。

在排列检验中,将多个样本组合然后洗牌。

然后将洗牌后的值分成重抽样,并计算感兴趣的统计量。

重复这个过程,并制表重抽样统计量。

将观察到的统计量值与重抽样分布进行比较,可以让你判断样本间观察到的差异是否可能由于偶然发生。

Eugene Edgington 和 Patrick Onghena 著《随机化检验》第4版(Chapman & Hall/CRC Press, 2007)——但不要过于深入非随机抽样的复杂问题

Peter Bruce 著《统计学和分析学入门:重抽样视角》(Wiley, 2014)

统计显著性是统计学家衡量实验(甚至是对现有数据的研究)是否产生比偶然可能产生的结果更极端结果的方法。如果结果超出了随机变异的范围,就被称为统计显著的。

给定一个体现零假设的偶然模型,p 值是获得与观察结果一样异常或极端的结果的概率。

偶然结果必须超越的”异常性”概率阈值,实际结果才能被认为是统计显著的。

错误地得出结论认为某种效应是真实的(当它实际上是由于偶然)。

第二类错误

:错误地认为某个效应是由偶然因素造成的(实际上是真实的)。

考虑[表3-2]中所示的早期网络测试结果。

| 结果 | 价格A | 价格B |

|---|---|---|

| 转化 | 200 | 182 |

| 未转化 | 23,539 | 22,406 |

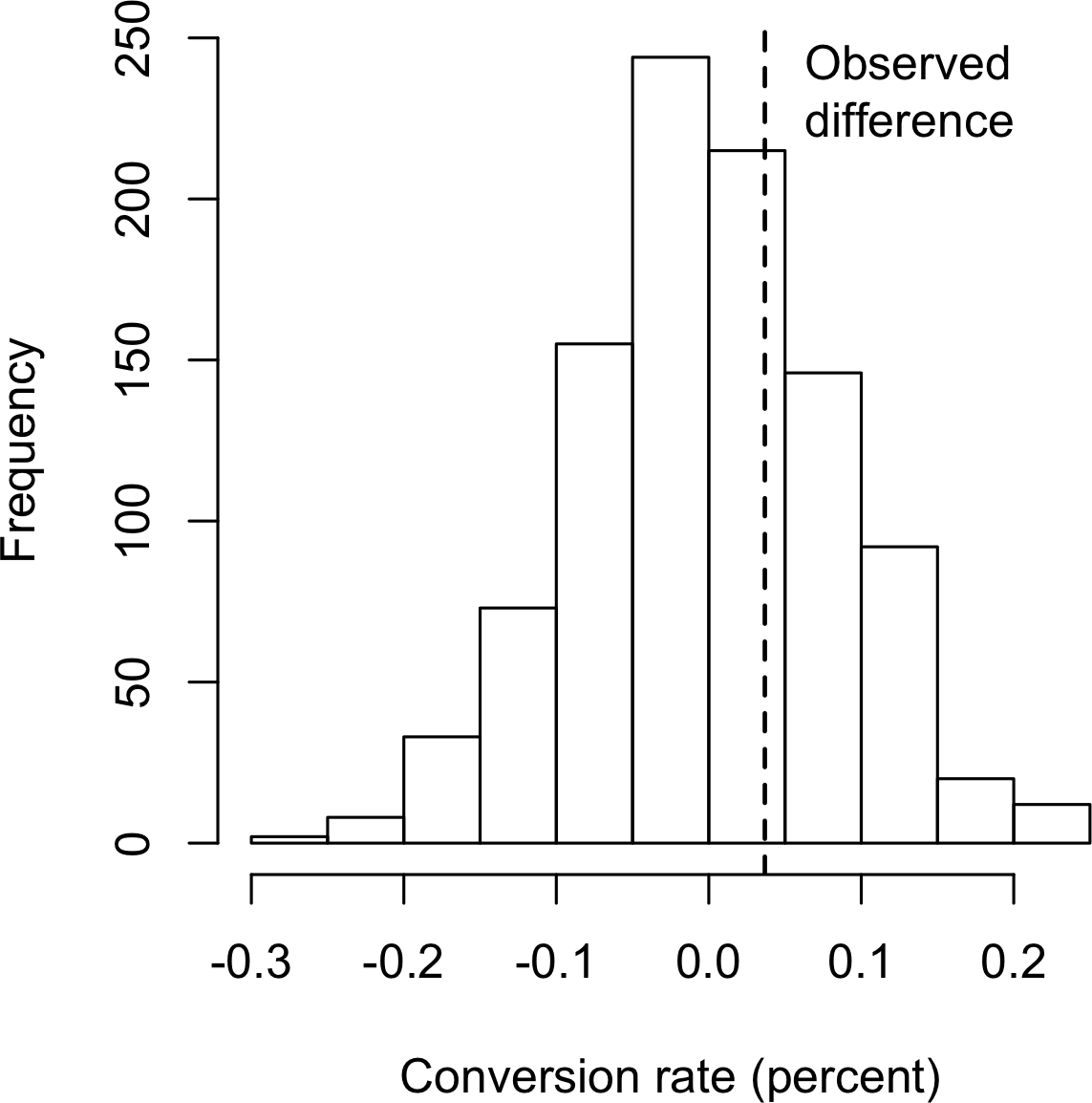

价格A的转化率比价格B高出近5%(0.8425% = 200/(23539+200)100,对比0.8057% = 182/(22406+182)100——差异为0.0368个百分点),在高流量业务中这种差异足够有意义。我们这里有超过45,000个数据点,很容易将其视为”大数据”,不需要统计显著性检验(主要用于解释小样本中的抽样变异性)。然而,转化率非常低(不到1%),真正有意义的数值——转化数——只有几百个,所需的样本量实际上由这些转化数决定。我们可以检验价格A和B之间的转化差异是否在偶然变异范围内,使用重抽样程序。偶然变异是指概率模型产生的随机变异,该模型体现了两个价格之间没有差异的零假设(见[“零假设”])。以下排列程序提出问题:“如果两个价格具有相同的转化率,偶然变异能否产生5%这样大的差异?”

在一个盒子里放标记为1和0的卡片:这代表假设的共同转化率,382个1和45,945个0 = 0.008246 = 0.8246%。

洗牌并抽取大小为23,739的重抽样(与价格A相同的n),记录有多少个1。

记录剩余22,588个中1的数量(与价格B相同的n)。

记录1的比例差异。

重复步骤2-4。

差异>=0.0368的频率是多少?

重用在[“示例:网站粘性”]中定义的函数perm_fun,我们可以在R中创建随机排列的转化率差异直方图:

obs_pct_diff <- 100 * (200 / 23739 - 182 / 22588)

conversion <- c(rep(0, 45945), rep(1, 382))

perm_diffs <- rep(0, 1000)

for (i in 1:1000) {

perm_diffs[i] = 100 * perm_fun(conversion, 23739, 22588)

}

hist(perm_diffs, xlab='Conversion rate (percent)', main='')

abline(v=obs_pct_diff)对应的Python代码是:

obs_pct_diff = 100 * (200 / 23739 - 182 / 22588)

print(f'Observed difference: {obs_pct_diff:.4f}%')

conversion = [0] * 45945

conversion.extend([1] * 382)

conversion = pd.Series(conversion)

perm_diffs = [100 * perm_fun(conversion, 23739, 22588)

for _ in range(1000)]

fig, ax = plt.subplots(figsize=(5, 5))

ax.hist(perm_diffs, bins=11, rwidth=0.9)

ax.axvline(x=obs_pct_diff, color='black', lw=2)

ax.text(0.06, 200, 'Observed\ndifference', bbox={'facecolor':'white'})

ax.set_xlabel('Conversion rate (percent)')

ax.set_ylabel('Frequency')参见[图3-5]中1,000次重抽样结果的直方图:在这种情况下,观察到的0.0368%的差异恰好在偶然变异的范围内。

仅仅看图表并不是测量统计显著性的精确方法,所以更重要的是p值。这是偶然模型产生比观察结果更极端结果的频率。我们可以通过计算排列检验产生等于或大于观察差异的比例来估计排列检验的p值:

mean(perm_diffs > obs_pct_diff)

[1] 0.308np.mean([diff > obs_pct_diff for diff in perm_diffs])这里,R和Python都利用了true被解释为1而false被解释为0的特性。

p值为0.308,这意味着我们预期仅凭随机偶然因素就能在超过30%的时间里获得如此极端或更极端的结果。

在这种情况下,我们不需要使用排列检验来获取p值。由于我们有二项分布,我们可以近似p值。在R代码中,我们使用函数prop.test来做这件事:

> prop.test(x=c(200, 182), n=c(23739, 22588), alternative='greater')

2-sample test for equality of proportions with continuity correction

data: c(200, 182) out of c(23739, 22588)

X-squared = 0.14893, df = 1, p-value = 0.3498

alternative hypothesis: greater

95 percent confidence interval:

-0.001057439 1.000000000

sample estimates:

prop 1 prop 2

0.008424955 0.008057376参数 x 是每组的成功次数,参数 n

是试验次数。

方法 scipy.stats.chi2_contingency

接受如表3-2所示的值:

survivors = np.array([[200, 23739 - 200], [182, 22588 - 182]])

chi2, p_value, df, _ = stats.chi2_contingency(survivors)

print(f'p-value for single sided test: {p_value / 2:.4f}')正态近似产生的p值为0.3498,这与置换检验得到的p值接近。

统计学家反对将结果是否”太不寻常而不可能由偶然发生”的判断留给研究者自行决定的做法。相反,应该预先指定一个阈值,如”比5%的偶然(零假设)结果更极端”;这个阈值被称为alpha。典型的alpha水平是5%和1%。任何选择的水平都是任意决定——没有什么过程能保证在x%的时间内做出正确决定。这是因为要回答的概率问题不是”这种情况由偶然发生的概率是多少?“而是”给定一个偶然模型,出现如此极端结果的概率是多少?“然后我们反向推断偶然模型的适当性,但这种判断不带有概率。这一点一直是混淆的根源。

近年来,p值的使用引起了相当大的争议。一本心理学期刊甚至”禁止”在投稿论文中使用p值,理由是仅基于p值做出的发表决定导致了劣质研究的发表。太多研究者只是模糊地知道p值的真正含义,在数据中四处挖掘,在不同可能的假设中寻找,直到他们找到一个产生显著p值的组合,因此得到一篇适合发表的论文。

真正的问题是人们希望从p值中获得比它所包含的更多含义。以下是我们希望p值传达的内容:

结果由偶然引起的概率。

我们希望得到一个低值,这样我们就可以得出我们已经证明了某些东西的结论。这是许多期刊编辑解释p值的方式。但这是p值实际代表的内容:

在给定偶然模型的情况下,出现与观察结果一样极端的结果的概率。

差异细微但真实。显著的p值并不能像看起来那样将你带到”证明”的道路上那么远。当理解p值的真实含义时,“统计显著”结论的逻辑基础有些薄弱。

2016年3月,美国统计协会经过大量内部讨论后,发布了一份关于p值使用的警告声明,揭示了对p值误解的程度。ASA声明强调了研究者和期刊编辑应遵循的六项原则:

P值可以表明数据与指定统计模型的不兼容程度。

P值不能衡量所研究假设为真的概率,或数据仅由随机偶然产生的概率。

科学结论和商业或政策决策不应仅基于p值是否通过特定阈值。

适当的推论需要完整的报告和透明度。

P值或统计显著性不能衡量效应的大小或结果的重要性。

P值本身不能为模型或假设提供良好的证据衡量。

即使结果在统计上显著,也不意味着它具有实际意义。如果样本量足够大,一个没有实际意义的微小差异也可能在统计上显著。大样本确保即使是微小的、无意义的效应也足以排除偶然性作为解释。排除偶然性并不能神奇地使本质上不重要的结果变得重要。

在评估统计显著性时,可能出现两种类型的错误:

Type 1 错误,即你错误地认为一个效应是真实的,而实际上它只是由于偶然性造成的

Type 2 错误,即你错误地认为一个效应不是真实的(即由于偶然性),而实际上它是真实的

实际上,Type 2 错误与其说是错误,不如说是判断样本量太小而无法检测到效应。当p值未达到统计显著性(例如,超过5%)时,我们实际上是在说”效应未被证明”。更大的样本可能会产生更小的p值。

显著性检验(也称为假设检验)的基本功能是防止被随机偶然性愚弄;因此它们通常被设计为最小化Type 1错误。

Data scientist所做的工作通常不是为了在科学期刊上发表,所以关于p值价值的争论在某种程度上是学术性的。对于data scientist来说,p值是一个有用的指标,适用于你想知道一个看起来有趣和有用的模型结果是否在正常偶然变异范围内的情况。作为实验中的决策工具,p值不应被视为控制性的,而只是影响决策的另一个信息点。例如,p值有时被用作某些统计或机器学习模型的中间输入——一个特征可能根据其p值被包含在模型中或从模型中排除。

显著性检验用于确定观察到的效应是否在null hypothesis模型的偶然变异范围内。

p值是在给定null hypothesis模型的情况下,可能出现与观察结果一样极端结果的概率。

alpha值是null hypothesis偶然模型中”异常性”的阈值。

显著性检验对正式的研究报告比对data science更相关(但最近即使对前者也在减少)。

Stephen Stigler,“Fisher and the 5% Level”,Chance 21,no. 4 (2008): 12。这篇文章是对Ronald Fisher 1925年著作Statistical Methods for Research Workers (Oliver & Boyd)的简短评论,以及对Fisher强调5%显著性水平的评论。

另见[“假设检验”]和那里提到的延伸阅读。

根据数据是计数数据还是测量数据、样本数量以及测量内容的不同,存在多种类型的significance tests。一个非常常见的检验是t-test,以Student’s t-distribution命名,最初由W. S. Gosset开发,用于近似单个样本均值的分布(参见“Student’s t-Distribution”)。

衡量感兴趣的差异或效应的指标。

常见test statistics(如均值)的标准化版本。

一个参考分布(在这种情况下来源于原假设),可以将观察到的t-statistic与之进行比较。

所有significance tests都要求您指定一个test statistic来衡量您感兴趣的效应,并帮助您确定观察到的效应是否位于正常偶然变异的范围内。在resampling test中(参见“Permutation Test”中关于排列的讨论),数据的规模并不重要。您从数据本身创建参考(原假设)分布,并按原样使用test statistic。

在20世纪20年代和30年代,当统计假设检验正在发展时,随机打乱数据数千次来进行resampling test是不可行的。统计学家发现,基于Gosset’s t-distribution的t-test是排列(打乱)分布的良好近似。它用于非常常见的双样本比较——A/B test——其中数据是数值型的。但为了在不考虑规模的情况下使用t-distribution,必须使用test statistic的标准化形式。

经典统计学教科书在这个阶段会展示各种包含Gosset’s

distribution的公式,并演示如何标准化数据以将其与标准t-distribution进行比较。这里不展示这些公式,因为所有统计软件以及R和Python都包含体现这些公式的命令。在R中,函数是t.test:

> t.test(Time ~ Page, data=session_times, alternative='less')

Welch Two Sample t-test

data: Time by Page

t = -1.0983, df = 27.693, p-value = 0.1408

alternative hypothesis: true difference in means is less than 0

95 percent confidence interval:

-Inf 19.59674

sample estimates:

mean in group Page A mean in group Page B

126.3333 162.0000在Python中可以使用函数scipy.stats.ttest_ind:

res = stats.ttest_ind(session_times[session_times.Page == 'Page A'].Time,

session_times[session_times.Page == 'Page B'].Time,

equal_var=False)

print(f'p-value for single sided test: {res.pvalue / 2:.4f}')备择假设是页面A的会话时间均值小于页面B的均值。p-value为0.1408,与permutation test的p-values 0.121和0.126相当接近(参见“Example: Web Stickiness”)。

在resampling模式中,我们构造解决方案来反映观察到的数据和要检验的假设,而不用担心数据是数值型还是二元型、样本大小是否平衡、样本方差或其他各种因素。在公式世界中,出现了许多变体,它们可能令人困惑。统计学家需要导航那个世界并学习其地图,但数据科学家不需要——他们通常不像准备论文发表的研究人员那样需要在假设检验和置信区间的细节上下功夫。

在计算机出现之前,resampling tests不实用,统计学家使用标准参考分布。

然后可以将test statistic标准化并与参考distribution进行比较。

其中一个广泛使用的标准化统计量是t-statistic。

任何统计学入门教科书都会有t-statistic及其用法的例子;其中两本好书是David Freedman、Robert Pisani和Roger Purves的Statistics第4版(W. W. Norton,2007年),以及David S. Moore、William I. Notz和Michael A. Fligner的The Basic Practice of Statistics第8版(W. H. Freeman,2017年)。

关于t检验和重采样程序的并行处理,请参见Peter Bruce的《统计学和分析入门:重采样视角》(Wiley, 2014)或Robin Lock和其他四位Lock家族成员的《统计学:释放数据的力量》第2版(Wiley, 2016)。

正如我们之前提到的,统计学中有一句话:“只要折磨数据足够长时间,它就会招供。”这意味着如果你从足够多的不同角度审视数据并提出足够多的问题,几乎总是会发现一个统计显著效应。

例如,如果你有20个预测变量和一个结果变量,全部都是随机生成的,如果你在alpha = 0.05水平上进行一系列20次显著性检验,至少有一个预测变量(错误地)显示为统计显著的几率相当高。如前所述,这被称为Type 1错误。你可以通过首先找出所有变量在0.05水平上正确地检验为不显著的概率来计算这个概率。一个变量正确检验为不显著的概率是0.95,所以所有20个变量都正确检验为不显著的概率是0.95 × 0.95 × 0.95…,或0.9520 = 0.36。至少一个预测变量(错误地)检验为显著的概率是这个概率的另一面,或1 – (所有变量都不显著的概率) = 0.64。这被称为alpha膨胀。

这个问题与数据挖掘中的过拟合问题相关,或称为”将模型拟合到噪声”。你添加的变量越多,或运行的模型越多,某些东西仅仅因为偶然而显示为”显著”的概率就越大。

错误地得出一个效应具有统计显著性的结论。

在多重检验中,犯Type 1错误的比率。

多重检验现象,其中alpha(犯Type 1错误的概率)随着你进行更多检验而增加。

对同一数据进行多重检验的解释。

拟合噪声。

在监督学习任务中,模型在未见过的数据上进行评估的保留集可以缓解这种风险。在不涉及标记保留集的统计和机器学习任务中,基于统计噪声得出结论的风险依然存在。

在统计学中,有一些程序旨在处理非常特定情况下的这个问题。例如,如果你要比较多个处理组的结果,你可能会问多个问题。所以,对于处理A-C,你可能会问:

A与B是否不同?

B与C是否不同?

A与C是否不同?

或者,在临床试验中,你可能想要查看治疗在多个阶段的结果。在每种情况下,你都在问多个问题,每问一个问题,就增加被偶然性愚弄的机会。统计学中的调整程序可以通过设置比单一假设检验更严格的统计显著性标准来补偿这一点。这些调整程序通常涉及根据检验数量”分配alpha”。这导致每个检验的alpha更小(即统计显著性的标准更严格)。其中一个程序,Bonferroni调整,简单地将alpha除以比较次数。另一个用于比较多个组均值的程序是Tukey的”诚实显著差异”,或Tukey’s HSD。这个检验适用于组均值间的最大差异,将其与基于t分布的基准进行比较(大致相当于将所有值混合在一起,重新分配与原始组相同大小的重采样组,并找到重采样组均值间的最大差异)。

然而,多重比较问题超越了这些高度结构化的情况,与反复数据”挖掘”现象相关,这种现象产生了关于折磨数据的说法。换句话说,给定足够复杂的数据,如果你没有发现有趣的东西,你只是没有足够长时间地努力寻找。现在比以往任何时候都有更多数据可用,期刊文章发表数量在2002年到2010年间几乎翻了一番。这产生了大量在数据中找到有趣内容的机会,包括多重性问题,如:

检查组间多个成对差异