MACHINE LEARNING

Marc Peter Deisenroth

A. Aldo Faisal

Cheng Soon Ong

前言 1

第一部分 数学基础 9

1 介绍与动机 11 1.1 为直觉寻找语言 12 1.2 阅读本书的两种方式 13 1.3 练习与反馈 16

2 线性代数 17 2.1 线性方程组 19 2.2 矩阵 22 2.3 求解线性方程组 27 2.4 向量空间 35 2.5 线性无关 40 2.6 基与秩 44 2.7 线性映射 48 2.8 仿射空间 61 2.9 延伸阅读 63 练习 64

3 解析几何 70 3.1 范数 71 3.2 内积 72 3.3 长度与距离 75 3.4 角度与正交性 76 3.5 标准正交基 78 3.6 正交补 79 3.7 函数的内积 80 3.8 正交投影 81 3.9 旋转 91 3.10 延伸阅读 94 练习 96

4 矩阵分解 98 4.1 行列式与迹 99

i 本资料由Cambridge University Press出版,书名为《Mathematics for Machine Learning》,作者为Marc Peter Deisenroth、A. Aldo Faisal和Cheng Soon Ong (2020)。此版本免费供个人使用查看和下载。不得重新分发、转售或用于衍生作品。 ©by M. P. Deisenroth, A. A. Faisal, and C. S. Ong, 2023. https://mml-book.com

ii 目录

4.2 特征值与特征向量 105 4.3 Cholesky分解 114 4.4 特征分解与对角化 115 4.5 奇异值分解 119 4.6 矩阵近似 129 4.7 矩阵系统发生学 134 4.8 延伸阅读 135 练习 137

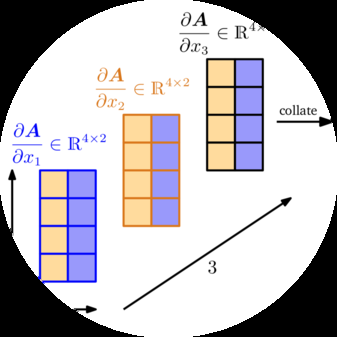

5 向量微积分 139 5.1 单变量函数的微分 141 5.2 偏微分与梯度 146 5.3 向量值函数的梯度 149 5.4 矩阵的梯度 155 5.5 计算梯度的有用恒等式 158 5.6 反向传播与自动微分 159 5.7 高阶导数 164 5.8 线性化与多变量Taylor级数 165 5.9 延伸阅读 170 练习 170

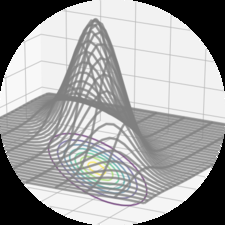

6 概率与分布 172 6.1 概率空间的构造 172 6.2 离散与连续概率 178 6.3 和法则、积法则与Bayes定理 183 6.4 汇总统计与独立性 186 6.5 Gaussian分布 197 6.6 共轭性与指数族 205 6.7 变量变换/逆变换 214 6.8 延伸阅读 221 练习 222

7 连续优化 225 7.1 使用梯度下降的优化 227 7.2 约束优化与Lagrange乘数 233 7.3 凸优化 236 7.4 延伸阅读 246 练习 247

第二部分 Machine Learning核心问题 249

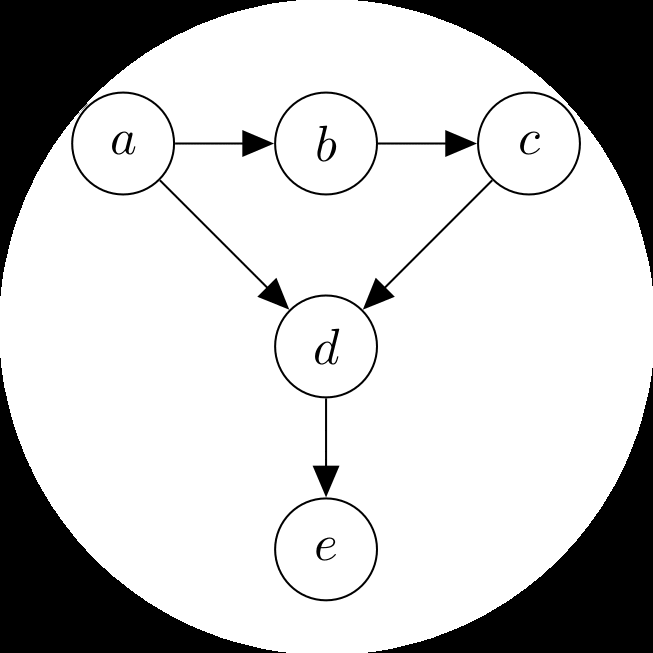

8 当模型遇到数据 251 8.1 数据、模型与学习 251 8.2 经验风险最小化 258 8.3 参数估计 265 8.4 概率建模与推断 272 8.5 有向图模型 278

《Mathematics for Machine Learning》草稿 (2023-10-18)。反馈:https://mml-book.com 目录 iii

8.6 模型选择 283

9 线性回归 289 9.1 问题表述 291 9.2 参数估计 292 9.3 Bayesian线性回归 303 9.4 最大似然作为正交投影 313 9.5 延伸阅读 315

10 主成分分析降维 317 10.1 问题设定 318 10.2 最大方差视角 320 10.3 投影视角 325 10.4 特征向量计算与低秩近似 333 10.5 高维PCA 335 10.6 PCA实践中的关键步骤 336 10.7 潜变量视角 339 10.8 延伸阅读 343

11 Gaussian混合模型密度估计 348 11.1 Gaussian混合模型 349 11.2 通过最大似然进行参数学习 350 11.3 EM算法 360 11.4 潜变量视角 363 11.5 延伸阅读 368

12 支持向量机分类 370 12.1 分离超平面 372 12.2 原始支持向量机 374 12.3 对偶支持向量机 383 12.4 核 388 12.5 数值解 390 12.6 延伸阅读 392

参考文献 395 索引 407

©2023 M. P. Deisenroth, A. A. Faisal, C. S. Ong. 由Cambridge University Press出版 (2020)。

前言

Machine learning是人类尝试将人类知识和推理提炼成适合构建机器和工程自动化系统形式的最新尝试。随着machine learning变得更加无处不在,其软件包变得更易于使用,将低级技术细节抽象化并对从业者隐藏是自然且理想的。然而,这带来了从业者可能会忽略设计决策因而忽略machine learning算法局限性的危险。

对于有兴趣了解成功machine learning算法背后魔力的热忱从业者,目前面临着一系列令人望而生畏的先决知识:

编程语言和数据分析工具

大规模计算及其相关框架

数学和统计学以及machine learning如何建立在其基础之上

在大学中,machine learning入门课程往往在课程的早期部分涵盖这些先决条件中的一些。由于历史原因,machine learning课程通常在计算机科学系教授,那里的学生通常在前两个知识领域接受培训,但在数学和统计学方面则不那么多。

当前的machine learning教科书主要关注machine learning算法和方法论,并假设读者在数学和统计学方面是有能力的。因此,这些书籍只花一两章介绍背景数学,要么在书的开头,要么作为附录。我们发现许多想要深入研究基本machine learning方法基础的人在阅读machine learning教科书所需的数学知识方面存在困难。在大学教授本科和研究生课程后,我们发现高中数学与阅读标准machine learning教科书所需数学水平之间的差距对许多人来说太大了。

本书将基本machine learning概念的数学基础提到前台,并将信息收集在一个地方,以便缩小甚至消除这种技能差距。

[本材料由Cambridge University Press出版,书名为] [Mathematics for Machine Learning] [作者为] [Marc Peter Deisenroth, A. Aldo Faisal, and Cheng Soon Ong (2020). 此版本仅供个人使用免费查看] [和下载。不得重新分发、转售或用于衍生作品。]

[©by M. P. Deisenroth, A. A. Faisal, and C. S. Ong, 2023.] [https://mml-book.com]

Machine learning建立在数学语言之上来表达那些看似直观明显但却难以形式化的概念。一旦正确形式化,我们就能深入了解我们想要解决的任务。全球数学学生的一个常见抱怨是,所涵盖的主题似乎与实际问题几乎没有关联。我们相信machine learning是人们学习数学的一个明显而直接的动机。

[“数学在大众心理中] [本书旨在成为构成现代machine learning基础的庞大数学文]

[与恐惧症和] [献的指南书。我们通过直接指出数学概念在基本]

[焦虑联系在一起。你会] [machine learning问题背景下的有用性来激发对数学概念的需求。为了]

[认为我们在讨论]

[蜘蛛。” [(Strogatz,]] [保持本书简短,许多细节和更高级的概念被省略了。配备了这里]

[[2014,] 第281页)] [呈现的基本概念,以及它们如何融入machine learning的更大背景,]

读者可以找到许多进一步学习的资源,我们在相应章节的末尾提供了这些资源。对于有数学背景的读者,本书提供了machine learning的简要但精确的概述。与其他专注于machine learning方法和模型 [(MacKay, 2003;] [Bishop, 2006;] [Alpaydin, 2010; Bar-] [ber, 2012;] [Murphy, 2012;] [Shalev-Shwartz and Ben-David, 2014;] [Rogers] [and Girolami, 2016)] 或machine learning编程方面 [(Müller] [and Guido, 2016;] [Raschka and Mirjalili, 2017;] [Chollet and Allaire, 2018)] 的书籍不同,我们只提供四个machine learning算法的代表性例子。相反,我们专注于模型本身背后的数学概念。我们希望读者能够更深入地理解machine learning中的基本问题,并将使用machine learning产生的实际问题与数学模型中的基本选择联系起来。

我们的目标不是写一本经典的machine learning书籍。相反,我们的意图是提供数学背景,应用于四个核心machine learning问题,以便更容易阅读其他machine learning教科书。

随着machine learning的应用在社会中变得广泛,我们相信每个人都应该对其基本原理有一些理解。本书以学术数学风格编写,这使我们能够对machine learning背后的概念保持精确。我们鼓励不熟悉这种看似简洁风格的读者坚持下去,并牢记每个主题的目标。我们在整个文本中穿插评论和备注,希望能为大局提供有用的指导。

本书假设读者具有通常的数学知识

[草稿 (2023-10-18) “Mathematics for Machine Learning”. 反馈:] [https://mml-book.com] [前言]

已在高中数学和物理中涵盖。 例如,读者应该之前接触过导数和积分,以及二维或三维的几何向量。从这些基础开始,我们将推广这些概念。因此,本书的目标读者包括大学本科生、夜校学习者和参加在线机器学习课程的学习者。

以音乐为类比,人们与机器学习有三种类型的互动:

敏锐的听众 [机器学习的民主化通过开源软件、在线教程和基于云的工具的提供,让用户无需担心管道的具体细节。用户可以专注于使用现成工具从数据中提取见解。这使得非技术领域专家能够从机器学习中受益。这类似于听音乐;用户能够在不同类型的机器学习之间进行选择和辨别,并从中受益。更有经验的用户就像音乐评论家,对机器学习在社会中的应用提出重要问题,如伦理、公平性和个人隐私。我们希望这本书为思考机器学习系统的认证和风险管理提供基础,并允许他们使用自己的领域专业知识来构建更好的机器学习系统。]

经验丰富的艺术家 [机器学习的熟练从业者可以将不同的工具和库插入到分析管道中。典型的从业者是数据科学家或工程师,他们理解机器学习接口及其用例,能够从数据中进行出色的预测。这类似于演奏音乐的大师,高技能的从业者可以让现有乐器焕发生机,为观众带来享受。使用这里提供的数学作为入门,从业者将能够理解他们喜爱方法的优点和局限性,并扩展和推广现有的机器学习算法。我们希望这本书能为更严格和有原则的机器学习方法开发提供推动力。]

初出茅庐的作曲家 [随着机器学习应用到新领域,机器学习的开发者需要开发新方法并扩展现有算法。他们通常是需要理解机器学习数学基础并揭示不同任务之间关系的研究人员。这类似于音乐作曲家,在音乐理论的规则和结构内,创作新的令人惊叹的作品。我们希望这本书为想要成为机器学习作曲家的人提供其他技术书籍的高级概述。社会非常需要能够提出和探索新方法来应对从数据中学习的诸多挑战的新研究人员。]

[©2023 M. P. Deisenroth, A. A. Faisal, C. S. Ong. 由剑桥大学出版社出版 (2020).]

我们感谢许多人查看了本书的早期草稿,并忍受了痛苦的概念阐述。我们试图实施他们提出的我们并不强烈反对的想法。我们要特别感谢Christfried Webers仔细阅读了本书的许多部分,以及他对结构和呈现的详细建议。许多朋友和同事也慷慨地为每章的不同版本提供了他们的时间和精力。我们很幸运地受益于在线社区的慷慨,他们通过https://github.com提出了改进建议,这大大改进了这本书。

以下人员发现了错误,提出了澄清建议并推荐了相关文献,无论是通过https://github.com还是个人交流。他们的姓名按字母顺序排列。

Abdul-Ganiy Usman Ellen Broad Adam Gaier Fengkuangtian Zhu Adele Jackson Fiona Condon Aditya Menon Georgios Theodorou Alasdair Tran He Xin Aleksandar Krnjaic Irene Raissa Kameni Alexander Makrigiorgos Jakub Nabaglo Alfredo Canziani James Hensman Ali Shafti Jamie Liu Amr Khalifa Jean Kaddour Andrew Tanggara Jean-Paul Ebejer Angus Gruen Jerry Qiang Antal A. Buss Jitesh Sindhare Antoine Toisoul Le Cann John Lloyd Areg Sarvazyan Jonas Ngnawe Artem Artemev Jon Martin Artyom Stepanov Justin Hsi Bill Kromydas Kai Arulkumaran Bob Williamson Kamil Dreczkowski Boon Ping Lim Lily Wang Chao Qu Lionel Tondji Ngoupeyou Cheng Li Lydia Knüfing Chris Sherlock Mahmoud Aslan Christopher Gray Mark Hartenstein Daniel McNamara Mark van der Wilk Daniel Wood Markus Hegland Darren Siegel Martin Hewing David Johnston Matthew Alger Dawei Chen Matthew Lee

Maximus McCann Shakir Mohamed

Mengyan Zhang Shawn Berry

Michael Bennett Sheikh Abdul Raheem Ali

Michael Pedersen Sheng Xue

Minjeong Shin Sridhar Thiagarajan

Mohammad Malekzadeh Syed Nouman Hasany

Naveen Kumar Szymon Brych

Nico Montali Thomas Bühler

Oscar Armas Timur Sharapov

Patrick Henriksen Tom Melamed

Patrick Wieschollek

Vincent Adam

Pattarawat Chormai

Vincent Dutordoir

Paul Kelly

Vu Minh

Petros Christodoulou

Wasim Aftab

Piotr Januszewski

Wen Zhi

Pranav Subramani

Wojciech Stokowiec

Quyu Kong

Ragib Zaman Xiaonan Chong

Rui Zhang Xiaowei Zhang

Ryan-Rhys Griffiths Yazhou Hao

Salomon Kabongo Yicheng Luo

Samuel Ogunmola Young Lee

Sandeep Mavadia Yu Lu

Sarvesh Nikumbh Yun Cheng

Sebastian Raschka Yuxiao Huang

Senanayak Sesh Kumar Karri Zac Cranko

Seung-Heon Baek Zijian Cao

Shahbaz Chaudhary Zoe Nolan

通过GitHub贡献的人员,其真实姓名未在其GitHub档案中列出的有:

SamDataMad insad empet

bumptiousmonkey HorizonP victorBigand

idoamihai cs-maillist 17SKYE

deepakiim kudo23 jessjing1995

我们也非常感谢Parameswaran Raman和许多匿名审稿人,他们由剑桥大学出版社组织,阅读了早期版本手稿的一个或多个章节,并提供了建设性的批评,这些批评带来了相当大的改进。特别要提到的是Dinesh Singh Negi,我们的L[A]TEX支持,他对L[A]TEX相关问题提供了详细和及时的建议。最后但同样重要的是,我们非常感谢我们的编辑Lauren Cowles,她一直耐心地指导我们完成这本书的创作过程。

[©2023 M. P. Deisenroth, A. A. Faisal, C. S. Ong. Published by Cambridge University Press (2020).]

| 符号 | 典型含义 |

|---|---|

| a, b, c, α, β, γ | 标量为小写字母 |

| x, y, z | 向量为粗体小写字母 |

| A, B, C | 矩阵为粗体大写字母 |

| x⊤, A⊤ | 向量或矩阵的转置 |

| A⁻¹ | 矩阵的逆 |

| ⟨x, y⟩ | x和y的内积 |

| x⊤y | x和y的点积 |

| B = (b₁, b₂, b₃) | (有序)元组 |

| B = [b₁, b₂, b₃] | 水平堆叠的列向量矩阵 |

| B = {b₁, b₂, b₃} | 向量集合(无序) |

| Z, N | 分别为整数和自然数 |

| R, C | 分别为实数和复数 |

| Rⁿ | n维实数向量空间 |

| ∀x | 全称量词:对于所有x |

| ∃x | 存在量词:存在x |

| a := b | a定义为b |

| a =: b | b定义为a |

| a ∝ b | a与b成正比,即a = 常数 · b |

| g ◦ f | 函数复合:“f之后的g” |

| ⇐⇒ | 当且仅当 |

| ⇒ | 蕴含 |

| A, C | 集合 |

| a ∈ A | a是集合A的元素 |

| ∅ | 空集 |

| A | A去掉B:A中存在但B中不存在的元素集合 |

| D | 维数;由d = 1, …, D索引 |

| N | 数据点数;由n = 1, …, N索引 |

| Iₘ | m × m大小的单位矩阵 |

| 0ₘ,ₙ | m × n大小的零矩阵 |

| 1ₘ,ₙ | m × n大小的全1矩阵 |

| eᵢ | 标准/规范向量(其中i是值为1的分量) |

| dim | 向量空间的维数 |

| rk(A) | 矩阵A的秩 |

| Im(Φ) | 线性映射Φ的像 |

| ker(Φ) | 线性映射Φ的核(零空间) |

| span[b₁] | b₁的张成(生成集) |

| tr(A) | A的迹 |

| det(A) | A的行列式 |

| | · | | 绝对值或行列式(取决于上下文) |

| ∥·∥ | 范数;除非另有说明,指欧几里得范数 |

| λ | 特征值或拉格朗日乘子 |

| E[λ] | 对应于特征值λ的特征空间 |

[Draft (2023-10-18) of “Mathematics for Machine Learning”. Feedback:] [https://mml-book.com]

| 符号 | 典型含义 |

|---|---|

| x ⊥ y | 向量x和y正交 |

| V | 向量空间 |

| V⊥ | 向量空间V的正交补 |

| ∑ᴺₙ₌₁ xₙ | xₙ的和:x₁ + … + xₙ |

| ∏ᴺₙ₌₁ xₙ | xₙ的积:x₁ · … · xₙ |

| θ | 参数向量 |

| ∂f/∂x | f关于x的偏导数 |

| df/dx | f关于x的全导数 |

| ∇ | 梯度 |

| f* = minₓ f(x) | f的最小函数值 |

| x* ∈ arg minₓ f(x) | 使f最小的值x*(注意:arg min返回值的集合) |

| L | 拉格朗日函数 |

| L | 负对数似然 |

| (n k) | 二项式系数,n选k |

| VX | x关于随机变量X的方差 |

| EX | x关于随机变量X的期望 |

| Cov[X,Y][x, y] | x和y之间的协方差 |

| X ⊥⊥ Y | Z | 给定Z的条件下,X与Y条件独立 |

| X ∼ p | 随机变量X按分布p分布 |

| N(μ, Σ) | 均值为μ、协方差为Σ的高斯分布 |

| Ber(μ) | 参数为μ的伯努利分布 |

| Bin(N, μ) | 参数为N, μ的二项分布 |

| Beta(α, β) | 参数为α, β的Beta分布 |

| 缩略词 | 含义 |

|---|---|

| e.g. | Exempli gratia(拉丁语:例如) |

| GMM | 高斯混合模型 |

| i.e. | Id est(拉丁语:即) |

| i.i.d. | 独立同分布 |

| MAP | 最大后验 |

| MLE | 最大似然估计/估计器 |

| ONB | 标准正交基 |

| PCA | 主成分分析 |

| PPCA | 概率主成分分析 |

| REF | 行阶梯形式 |

| SPD | 对称正定 |

| SVM | 支持向量机 |

[©2023 M. P. Deisenroth, A. A. Faisal, C. S. Ong. Published by Cambridge University Press (2020).]

[This material is published by Cambridge University Press as] [Mathematics for Machine Learning] [by] [Marc Peter Deisenroth, A. Aldo Faisal, and Cheng Soon Ong (2020). This version is free to view] [and download for personal use only. Not for re-distribution, re-sale, or use in derivative works.]

[©by M. P. Deisenroth, A. A. Faisal, and C. S. Ong, 2023.] [https://mml-book.com]

Machine learning是关于设计能够自动从数据中提取有价值信息的算法。这里强调的是”自动”,即machine learning关注的是可以应用于许多数据集的通用方法,同时产生有意义的结果。Machine learning的核心有三个概念:数据、模型和学习。

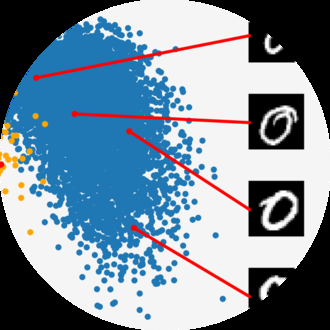

由于machine learning本质上是数据驱动的,数据是machine learning的核心。Machine learning的目标是设计通用方法来从数据中提取有价值的模式,理想情况下不需要太多特定领域的专业知识。例如,给定大量文档语料库(如许多图书馆中的书籍),machine learning方法可以用来自动发现文档间共享的相关主题(Hoffman et al., 2010)。为了实现这个目标,我们设计模型,这些模型通常与生成数据的过程相关,类似于我们给定的数据集。例如,在回归设置中,模型将描述一个将输入映射到实值输出的函数。

引用Mitchell (1997)的话:如果一个模型在考虑数据后在给定任务上的性能有所改善,那么就说该模型从数据中学习。目标是找到能够很好地泛化到未见数据的好模型,这些数据是我们将来可能关心的。Learning可以理解为一种[[learning]]通过优化模型参数来自动发现数据中的模式和结构的方法。

虽然machine learning已经有许多成功案例,并且有现成的软件可以设计和训练丰富灵活的machine learning系统,但我们相信machine learning的数学基础对于理解更复杂的machine learning系统所建立的基本原理很重要。理解这些原理可以促进创建新的machine learning解决方案,理解和调试现有方法,以及了解我们所使用方法的内在假设和局限性。

Mathematics for Machine Learning 由Marc Peter Deisenroth, A. Aldo Faisal, and Cheng Soon Ong (2020)著,Cambridge University Press出版。此版本免费供个人查看和下载使用。不得重新分发、转售或用于衍生作品。

©by M. P. Deisenroth, A. A. Faisal, and C. S. Ong, 2023. https://mml-book.com

我们在machine learning中经常面临的一个挑战是概念和词汇很滑溜,machine learning系统的特定组件可以抽象为不同的数学概念。例如,“algorithm”这个词在machine learning的语境中至少有两种不同的含义。第一种含义是,我们使用”machine learning algorithm”这个短语来指基于输入数据进行预测的系统。我们将这些algorithm称为predictor。第二种含义是,我们使用完全相同的短语”machine learning algorithm”来指调整predictor的一些内部参数使其在未来未见输入数据上表现良好的系统。这里我们将这种调整称为training系统。

本书不会解决歧义问题,但我们想预先强调,根据上下文,相同的表达可能意味着不同的事情。然而,我们试图使上下文足够清晰以减少歧义程度。

本书的第一部分介绍了讨论machine learning系统三个主要组件所需的数学概念和基础:数据、模型和学习。我们将在这里简要概述这些组件,并在讨论了必要的数学概念后在第8章重新审视它们。

虽然不是所有数据都是数值的,但将数据考虑为数字格式通常是有用的。在本书中,我们假设data已经被适当地转换为适合读入计算机程序的数值表示。因此,我们将数据视为向量。作为词汇微妙性的另一个例证,至少有三种不同的方式来思考向量:向量作为数字数组(计算机科学观点),向量作为具有方向和大小的箭头(物理学观点),以及向量作为遵循加法和缩放的对象(数学观点)。

model通常用于描述生成数据的过程,类似于手头的数据集。因此,好的模型也可以被认为是真实(未知)数据生成过程的简化版本,捕获与建模数据和从中提取隐藏模式相关的方面。好的模型然后可以用于预测在现实世界中会发生什么,而无需进行现实世界的实验。

我们现在来到问题的关键,machine learning的learning组件。假设我们得到一个数据集和一个合适的模型。Training模型意味着使用可用数据来优化模型的一些参数,相对于评估模型预测训练数据能力的效用函数。大多数训练方法可以被认为是类似于爬山到达山峰的方法。在这个类比中,山峰对应于某个期望性能度量的最大值。然而,在实践中,我们感兴趣的是模型在未见数据上表现良好。在我们已经见过的数据(训练数据)上表现良好可能只意味着我们找到了记忆数据的好方法。然而,这可能无法很好地泛化到未见数据,并且在实际应用中,我们经常需要将我们的machine learning系统暴露于它以前没有遇到过的情况。

让我们总结一下本书涵盖的machine learning的主要概念:

我们将数据表示为向量。

我们选择适当的模型,使用概率或优化观点。

我们通过使用数值优化方法从可用数据中学习,目标是模型在未用于训练的数据上表现良好。

我们可以考虑理解machine learning数学的两种策略:

自下而上:从基础概念构建到更高级的概念。这通常是更技术性领域(如数学)中的首选方法。这种策略的优势是读者在任何时候都能够依赖他们以前学过的概念。不幸的是,对于从业者来说,许多基础概念并不

自身特别有趣,缺乏动机意味着大多数基础定义很快就会被遗忘。

自上而下: 从实际需求深入到更基本的要求。这种目标驱动的方法的优势在于读者始终知道为什么需要学习特定概念,并且有清晰的所需知识路径。这种策略的缺点是知识建立在可能不稳固的基础之上,读者必须记住一系列他们无法理解的词汇。

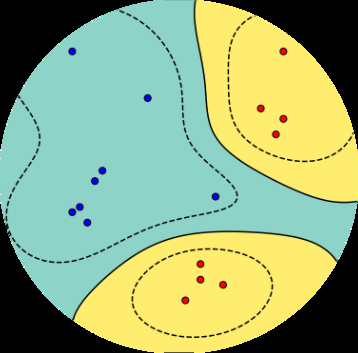

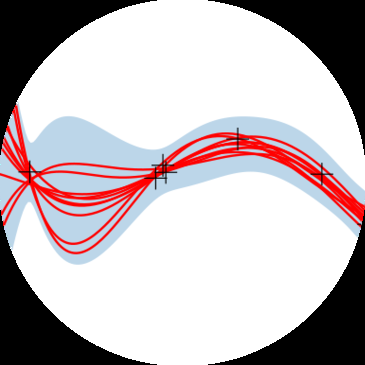

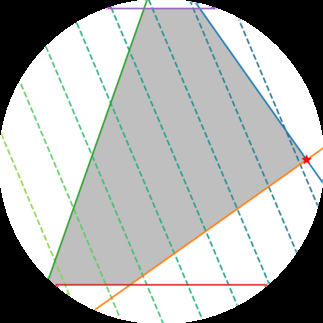

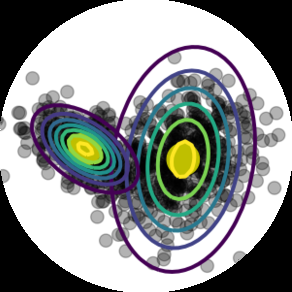

我们决定以模块化的方式编写本书,将基础(数学)概念与应用分离,这样本书可以用两种方式阅读。本书分为两个部分,第一部分奠定数学基础,第二部分将第一部分的概念应用到一系列基础机器学习问题中,这些问题构成了机器学习的四个支柱,如图1.1所示:回归、降维、密度估计和分类。第一部分的章节主要建立在前面章节的基础上,但如果需要,可以跳过某个章节并向后回顾。第二部分的章节之间联系较松散,可以按任何顺序阅读。两个部分之间有许多前向和后向指针

[©2023 M. P. Deisenroth, A. A. Faisal, C. S. Ong. Published by Cambridge University Press (2020).]

[14] [[Introduction and Motivation]]

图1.1 机器学习的基础和四个支柱。

降维 密度

回归 降维 估计 分类

向量微积分 概率与分布 优化

线性代数 解析几何 矩阵分解

来连接数学概念与

机器学习算法。

当然阅读本书的方式不止两种。 大多数读者

使用自上而下和自下而上方法的结合来学习,有时在尝试更复杂的概念之前建立基础数学技能,但也会根据机器学习的应用来选择主题。

我们在本书中涵盖的机器学习四个支柱(见图1.1)需要坚实的数学基础,这在第一部分中进行了阐述。

我们将数值数据表示为向量,将此类数据的表格表示为矩阵。向量和矩阵的研究称为线性代数,我们在第2章中介绍。向量集合作为矩阵也在那里描述。

给定代表现实世界中两个对象的两个向量,我们想要对它们的相似性做出陈述。其思想是相似的向量应该被我们的机器学习算法(我们的预测器)预测为具有相似的输出。为了形式化向量之间相似性的概念,我们需要引入以两个向量作为输入并返回表示其相似性的数值的运算。相似性和距离的构造是解析几何的核心,在第3章中讨论。

在第4章中,我们介绍了关于矩阵和矩阵分解的一些基本概念。矩阵上的某些运算在机器学习中极其有用,它们允许对数据进行直观的解释和更高效的学习。

我们经常将数据视为某些真实潜在信号的噪声观测。我们希望通过应用机器学习能够从噪声中识别信号。这要求我们有一种量化”噪声”含义的语言。我们通常还希望有允许我们表达某种不确定性的预测器,例如,量化我们对特定测试数据点预测值的置信度。不确定性的量化是概率论的领域,

[Draft (2023-10-18) of “Mathematics for Machine Learning”. Feedback:] [https://mml-book.com][.] [1.2 Two Ways to Read This Book] [15]

在第6章中涵盖。

为了训练机器学习模型,我们通常寻找最大化某种性能指标的参数。许多优化技术需要梯度的概念,它告诉我们搜索解决方案的方向。第5章关于向量微积分,详细介绍了梯度的概念,我们随后在第7章中使用,其中我们讨论寻找函数极大值/极小值的优化。

本书的第二部分介绍了机器学习的四个支柱,如图1.1所示。我们说明了本书第一部分介绍的数学概念如何成为每个支柱的基础。从广义上讲,章节按难度排序(按升序)。

在第8章中,我们以数学方式重述机器学习的三个组成部分(数据、模型和参数估计)。此外,我们提供了一些构建实验设置的指导原则,以防止对机器学习系统过于乐观的评估。回想一下,目标是构建在未见数据上表现良好的预测器。

在第9章中,我们将仔细研究线性回归,其中我们的

目标是找到将输入 [D] x ∈ R 映射到相应观测函数值 y ∈ R 的函数,我们可以将其解释为各自输入的标签。我们将讨论通过最大似然和最大后验估计进行的经典模型拟合(参数估计),以及贝叶斯线性回归,其中我们对参数进行积分而不是优化它们。

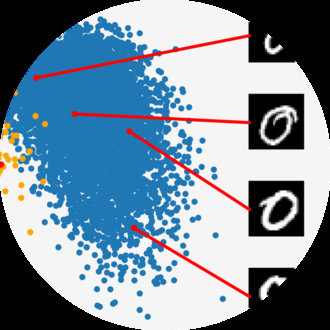

ure [1.1] 中的第二个支柱,使用主成分分析。降维的关键目标是找到高维数据 [D] x ∈ R 的紧凑、低维表示,这通常比原始数据更容易分析。与回归不同,降维仅关注对数据进行建模——没有与数据点 x 相关联的标签。

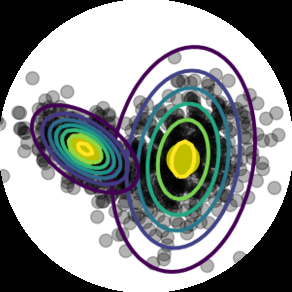

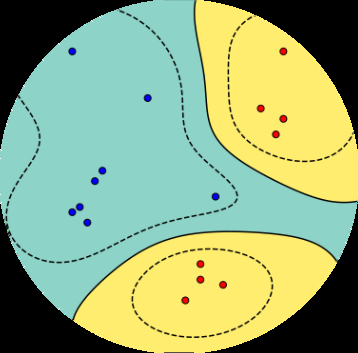

在第 [11] 章中,我们将转向第三个支柱:密度估计。[[density estimation]]

密度估计的目标是找到描述给定数据集的概率分布。我们将专注于高斯混合模型,并讨论找到该模型参数的迭代方案。与降维一样,没有与数据点 [D] x ∈ R 相关联的标签。然而,我们不寻求数据的低维表示。相反,我们对描述数据的密度模型感兴趣。

[©2023 M. P. Deisenroth, A. A. Faisal, C. S. Ong. Published by Cambridge University Press (2020).]

[16] [[引言和动机]]

[classification] 支柱:分类。我们将在支持向量机的背景下讨论分类。与回归(第 9 章)类似,我们有输入 x 和相应的标签 y。然而,与标签为实值的回归不同,分类中的标签是整数,这需要特别注意。

1.3 练习和反馈

我们在第一部分提供了一些练习,大部分可以用纸笔完成。对于第二部分,我们提供编程教程(jupyter notebooks)来探索本书讨论的机器学习算法的一些特性。

我们感谢 Cambridge University Press 强烈支持我们的目标,即通过在以下网址免费提供本书下载来实现教育和学习的民主化:

在那里可以找到教程、勘误表和其他材料。可以使用上述网址报告错误和提供反馈。

[Draft (2023-10-18) of “Mathematics for Machine Learning”. Feedback:] [https://mml-book.com][.]

[2]

线性代数

在形式化直观概念时,一种常见的方法是构造一组对象(符号)和一组操作这些对象的规则。这被称为代数。线性代数是研究向量和操作向量的某些规则的学科。我们许多人从学校了解的向量是

被称为”几何向量”的向量,通常用字母上方的小箭头表示,例如 − → − → x 和 y。在本书中,我们讨论更一般的向量概念,并使用粗体字母表示它们,例如 x 和 y。

一般来说,向量是可以相加并与标量相乘以产生同种类型的另一个对象的特殊对象。从抽象数学观点来看,满足这两个性质的任何对象都可以被认为是向量。以下是此类向量对象的一些例子:

几何向量。这种向量的例子可能在高中数学和物理中很熟悉。几何向量——见图 [2.1(a)]——是有向线段,可以绘制(至少在二维中)。两个几何向量 [→] [→] [→] [→] [→] x、y 可以相加,使得 x + y = z 是另一个几何向量。此外,与标量 λ [→] x、λ ∈ R 的乘法也是几何向量。实际上,它是按 λ 缩放的原始向量。因此,几何向量是前面介绍的向量概念的实例。将向量解释为几何向量使我们能够使用关于方向和大小的直觉来推理数学运算。

多项式也是向量;见图 [2.1(b)]:两个多项式可以

[→] [4] [图 2.1] [→]

x [+] [y] [[不同类型的]]

[2] [[向量。向量可以]]

[0] [是令人惊讶的]

[y] [[对象,包括]]

[→] [−][2] [[(a)] 几何] x [→] [向量]

[y] [4]

[和 [(b)] 多项式。]

− [2] [−] [0] [2]

[(a) 几何向量。] [(b) 多项式。]

[17]

[This material is published by Cambridge University Press as] [Mathematics for Machine Learning] [by] [Marc Peter Deisenroth, A. Aldo Faisal, and Cheng Soon Ong (2020). This version is free to view] [and download for personal use only. Not for re-distribution, re-sale, or use in derivative works.]

[©by M. P. Deisenroth, A. A. Faisal, and C. S. Ong, 2023.] [https://mml-book.com][.]

[18] [[线性代数]]

相加,结果是另一个多项式;它们可以与标量 λ ∈ R 相乘,结果也是多项式。因此,多项式是向量的(相当不寻常的)实例。注意多项式与几何向量非常不同。虽然几何向量是具体的”图形”,但多项式是抽象概念。然而,它们都是前面描述意义上的向量。

数字。我们可以将音频信号相加,它们的和是一个新的音频信号。如果我们缩放一个音频信号,我们也会得到一个音频信号。因此,音频信号也是一种向量。

a = [1, 2, 3]^T ∈ R^3 (2.1)

是一个三元数组的例子。将两个向量 a, b ∈ R^n 按分量相加会得到另一个向量:a + b = c ∈ R^n。此外,将 a ∈ R^n 乘以 λ ∈ R 会得到一个缩放向量 λa ∈ R^n。

将向量视为 R^n 的元素还有一个额外的好处,即它大致对应于计算机上的实数数组。许多编程语言支持数组运算,这允许方便地实现涉及向量运算的算法。

线性代数专注于这些向量概念之间的相似性。我们可以将它们相加并乘以标量。我们将主要关注 R^n 中的向量,因为线性代数中的大多数算法都是在 R^n 中制定的。我们将在第8章中看到,我们经常将数据视为 R^n 中的向量。在本书中,我们将专注于有限维向量空间,在这种情况下,任何类型的向量与 R^n 之间存在一一对应关系。当方便时,我们将使用关于几何向量的直觉并考虑基于数组的算法。

数学中的一个主要思想是”闭合”的概念。这是一个问题:我提出的运算可能产生的所有事物的集合是什么?在向量的情况下:从一小组向量开始,将它们相加并缩放它们,可能产生的向量集合是什么?这导致了向量空间(第2.4节)。向量空间的概念及其性质是机器学习的基础。本章介绍的概念总结在图2.2中。

本章主要基于 Drumm 和 Weil (2001)、Strang (2003)、Hogben (2013)、Liesen 和 Mehrmann (2015) 的讲义和书籍,以及 Pavel Grinfeld 的线性代数系列。其他优秀的

图2.2 本章介绍的概念的思维导图,以及它们在本书其他部分中的使用位置。

资源包括 Gilbert Strang 在 MIT 的线性代数课程和 3Blue1Brown 的线性代数系列。

线性代数在机器学习和一般数学中发挥着重要作用。本章介绍的概念在第3章中进一步扩展,包括几何的概念。在第5章中,我们将讨论向量微积分,其中矩阵运算的有原则的知识是必不可少的。在第10章中,我们将使用投影(将在第3.8节中介绍)进行主成分分析(PCA)的降维。在第9章中,我们将讨论线性回归,其中线性代数在解决最小二乘问题中发挥核心作用。

线性方程组是线性代数的核心部分。许多问题可以表述为线性方程组,线性代数为我们提供了解决它们的工具。

例 2.1

一家公司生产产品 N₁, …, Nₙ,需要资源 R₁, …, Rₘ。为了生产一单位产品 Nⱼ,需要 aᵢⱼ 单位资源 Rᵢ,其中 i = 1, …, m 和 j = 1, …, n。

目标是找到一个最优生产计划,即如果总共有 bᵢ 单位资源 Rᵢ 可用且(理想情况下)没有资源剩余,应该生产多少单位 xⱼ 的产品 Nⱼ 的计划。

如果我们生产 x₁, …, xₙ 单位相应的产品,我们需要总共

aᵢ₁x₁ + ··· + aᵢₙxₙ (2.2)

单位资源 Rᵢ。因此,一个最优生产计划 (x₁, …, xₙ) ∈ Rⁿ 必须满足以下方程组:

a₁₁x₁ + ··· + a₁ₙxₙ = b₁ ⋮ aₘ₁x₁ + ··· + aₘₙxₙ = bₘ (2.3)

其中 aᵢⱼ ∈ R 和 bᵢ ∈ R。

方程(2.3)是线性方程组的一般形式,x₁, …, xₙ 是该系统的未知数。满足(2.3)的每个n元组 (x₁, …, xₙ) ∈ Rⁿ 都是线性方程组的解。

例 2.2

线性方程组

x1 + x[2] + x3 = 3 (1) x1 − x[2] + 2x3 = 2 (2) (2.4)

无解:将前两个方程相加得到 2x1+3x3 = 5,这与第三个方程 (3) 矛盾。

让我们看看线性方程组

x1 + x[2] + x3 = 3 (1) x1 − x[2] + 2x3 = 2 (2) . (2.5)

x[2] + x3 = 2 (3)

从第一个和第三个方程,可以得出 x1 = 1。从 (1)+(2),我们得到 2x1 + 3x3 = 5,即 x3 = 1。从 (3),我们得到 x[2] = 1。因此,(1, 1, 1) 是唯一可能的唯一解(通过代入验证 (1, 1, 1) 是一个解)。

作为第三个例子,我们考虑

x1 + x[2] + x3 = 3 (1) x1 − x[2] + 2x3 = 2 (2) . (2.6)

由于 (1) +(2)=(3),我们可以省略第三个方程(冗余)。从 (1) 和 (2),我们得到 2x1 = 5 −3x3 和 2x[2] = 1+x3。我们定义 x3 = a ∈ R 作为自由变量,这样任何三元组

5/2 − 3a/2, 1/2 + a/2, a , a ∈ R (2.7)

都是线性方程组的解,即我们得到一个包含无穷多解的解集。

一般来说,对于实值线性方程组,我们得到要么无解、恰好一个解,要么无穷多解。线性回归(第9章)在我们无法求解线性方程组时解决例2.1的一个版本。

备注(线性方程组的几何解释)。在有两个变量 x1, x[2] 的线性方程组中,每个线性方程在 x1x[2]-平面上定义一条直线。由于线性方程组的解必须同时满足所有方程,解集是这些直线的交集。这个交集可以是一条直线(如果线性方程描述同一条直线)、一个点,或空集(当直线平行时)。图2.3给出了系统的示例

4x1 + 4x[2] = 5 2x1 − 4x[2] = 1 (2.8)

其中解空间是点 (x1, x[2]) = (1, 1/4)。类似地,对于三个变量,每个线性方程在三维空间中确定一个平面。当我们求这些平面的交集,即同时满足所有线性方程时,我们可以得到一个解集,它是一个平面、一条直线、一个点或空集(当平面没有公共交点时)。♢

为了系统地求解线性方程组,我们将介绍一个有用的紧凑记号。我们将系数 a[ij] 收集到向量中,并将向量收集到矩阵中。换句话说,我们将来自(2.3)的系统写成以下形式:

a[11] a[12] · · · a[1n] b[1]

⋮ ⋮ ⋱ ⋮ · x[1] + x[2] + · · · + x[n] = ⋮ . (2.9)

a[m1] a[m2] · · · a[mn] b[m]⇐⇒ a[11] · · · a[1n] x1 b1 ⋮ ⋱ ⋮ ⋮ = ⋮ . (2.10) a[m1] · · · a[mn] x[n] b[m]

在下面,我们将仔细看看这些矩阵并定义计算规则。我们将在第2.3节回到求解线性方程。

矩阵在线性代数中起着核心作用。它们可以用来紧凑地表示线性方程组,但它们也表示线性函数(线性映射),我们将在第2.7节看到。在我们讨论这些有趣的话题之前,让我们首先定义什么是矩阵以及我们可以对矩阵进行什么样的运算。我们将在第4章看到矩阵的更多性质。

定义2.1(矩阵)。对于 m, n ∈ N,实值 (m, n) 矩阵 A 是元素 a[ij], i = 1, . . . , m, j = 1, . . . , n 的 m ·n-元组,按照由 m 行和 n 列组成的矩形方案排列:

a[11] a[12] · · · a[1n] a[21] a[22] · · · a[2n] A = ⋮ ⋮ ⋱ ⋮ , a[ij] ∈ R . (2.11) a[m1] a[m2] · · · a[mn]

按照惯例,(1, n)-矩阵称为行,(m, 1)-矩阵称为列。这些特殊矩阵也称为行/列向量。R[m×n] 是所有实值 (m, n)-矩阵的集合。A ∈ R[m×n] 可以等价地表示为 a ∈ R[mn],通过将矩阵的所有 n 列堆叠成一个长向量;见图2.4。

两个矩阵 A ∈ R[m×n], B ∈ R[m×n] 的和定义为逐元素和,即

a[11] + b[11] · · · a[1n] + b[1n] A + B := ⋮ ⋱ ⋮ ∈ R[m×n] . (2.12) a[m1] + b[m1] · · · a[mn] + b[mn]

对于矩阵 A ∈ R[m×n], B ∈ R[n×k],乘积 C = AB ∈ R[m×k] 的元素 c[ij] 计算为

c[ij] = Σ[l=1 to n] a[il]b[lj], i = 1, . . . , m, j = 1, . . . , k. (2.13)

这意味着,要计算元素 c[ij],我们将第 i

第[i]行[[A]]和[[B]]的第j列的[[n]]行与求和。稍后在3.2节中,

我们称这为对应行和列的点积。在需要明确表示我们正在执行乘法的情况下,我们使用符号A·B来表示乘法(明确显示”·“)。

备注。矩阵只有在其”相邻”维数匹配时才能相乘。例如,n×k矩阵A可以与k×m矩阵B相乘,但只能从左侧:

A B = C (2.14) |{z} |{z} |{z} n×k k×m n×m

如果m≠n,由于相邻维数不匹配,乘积BA未定义。♢

备注。矩阵乘法不是定义为矩阵元素的逐元素运算,即cij≠aijbij(即使A、B的大小选择得当)。这种逐元素乘法在编程语言中经常出现,当我们将(多维)数组相乘时,称为Hadamard乘积。♢

例2.3

对于A = [1 2 3; 3 2 1] ∈ R^(2×3),B = [0 2; 1 -1; 0 1] ∈ R^(3×2),我们得到

AB = [1 2 3; 3 2 1] [0 2; 1 -1; 0 1] = [2 3; 2 5] ∈ R^(2×2),(2.15)

BA = [0 2; 1 -1; 0 1] [1 2 3; 3 2 1] = [6 4 2; -2 0 2; 3 2 1] ∈ R^(3×3)。(2.16)

图2.5 即使两个矩阵乘法AB和BA都有定义,结果的维数也可能不同。

从这个例子中,我们已经可以看出矩阵乘法不满足交换律,即AB≠BA;也见图2.5的图解。

定义2.2(单位矩阵)。在R^(n×n)中,我们定义单位矩阵

I_n := [1 0 ··· 0 ··· 0; 0 1 ··· 0 ··· 0; … … … … … …; 0 0 ··· 1 ··· 0; … … … … … …; 0 0 ··· 0 ··· 1] ∈ R^(n×n) (2.17)

作为对角线上包含1、其他地方都是0的n×n矩阵。

现在我们定义了矩阵乘法、矩阵加法和单位矩阵,让我们看看矩阵的一些性质:

结合律: ∀A∈R(m×n),B∈R(n×p),C∈R^(p×q):(AB)C = A(BC) (2.18)

分配律: ∀A,B∈R(m×n),C,D∈R(n×p):(A+B)C = AC+BC (2.19a) A(C+D) = AC+AD (2.19b)

与单位矩阵的乘法: ∀A∈R^(m×n):I_m A = AI_n = A (2.20)

注意对于m≠n,I_m≠I_n。

定义2.3(逆矩阵)。考虑方阵A∈R(n×n)。设矩阵B∈R(n×n)具有性质AB = I_n = BA。B称为A的逆矩阵,记作A^(-1)。

不幸的是,并非每个矩阵A都有逆矩阵A^(-1)。如果这个逆矩阵存在,A称为正则/可逆/非奇异的,否则称为奇异/不可逆的。当矩阵逆存在时,它是唯一的。在2.3节中,我们将讨论通过求解线性方程组来计算矩阵逆的一般方法。

备注(2×2矩阵逆矩阵的存在性)。考虑矩阵

A := [a11 a12; a21 a22] ∈ R^(2×2)。(2.21)

如果我们将A与

A’ := [a22 -a12; -a21 a11] (2.22)

相乘,我们得到

AA’ = [a11a22-a12a21 0; 0 a11a22-a12a21] = (a11a22-a12a21)I。(2.23)

因此,

A^(-1) = 1/(a11a22-a12a21) [a22 -a12; -a21 a11] (2.24)

当且仅当a11a22-a12a21≠0。在4.1节中,我们将看到a11a22-

a12a21是2×2矩阵的行列式。此外,我们通常可以使用行列式来检查矩阵是否可逆。♢

例2.4(逆矩阵)

矩阵

A = [1 2 1; 4 4 5; 6 7 7],B = [-7 -7 6; 2 1 -1; 4 5 -4] (2.25)

互为逆矩阵,因为AB = I = BA。

定义2.4(转置)。对于A∈R(m×n),矩阵B∈R(n×m)中bij = aji称为A的转置。我们写作B = A^T。

一般来说,AT可以通过将A的列写作AT的行来获得。以下是逆矩阵和转置的重要性质:

矩阵的主对角线(有时称为”主对角线”、“首对角线”、“前导对角线”或”主要对角线”)是矩阵A中i=j的元素Aij的集合。

AA^(-1) = I = A^(-1)A (2.26)

(AB)^(-1) = B(-1)A(-1) (2.27)

(A+B)^(-1) ≠ A(-1)+B(-1) (2.28)

(2.28)的标量情况是1/(2+4) ≠ 1/2 + 1/4 = 6。

(AT)T = A (2.29)

(AB)^T = B^T A^T (2.30)

(A+B)^T = AT+BT (2.31)

定义2.5(对称矩阵)。矩阵A∈R(n×n)是对称的,如果AT = A。

注意只有(n,n)矩阵才能是对称的。一般来说,我们也称(n,n)矩阵为方阵,因为它们具有相同的行数和列数。此外,如果AT可逆,那么A也可逆,且(A(-1))^T = (AT)(-1) =: A^(-T)。

备注(对称矩阵的和与积):对称矩阵 A, B ∈ R1 的和总是对称的。然而,虽然它们的乘积总是有定义的,但通常不是对称的:

1 0 1 1 1 1 = . (2.32) 0 0 1 1 0 0

♢

让我们看看当矩阵与标量相乘时会发生什么。设 A ∈ R2 和 λ ∈ R。则 λA = K,其中 K_ij = λa_ij。

实际上,λ 缩放 A 的每个元素。对于 λ, ψ ∈ R,以下关系成立:

(λψ)C = λ(ψC),C ∈ R3 λ(BC) = (λB)C = B(λC) = (BC)λ,B ∈ R4,C ∈ R5 注意这允许我们移动标量值。

(λC)^⊤ = C^⊤λ = C^⊤λ = λC^⊤,因为对于所有 λ ∈ R,λ^⊤ = λ。

(λ + ψ)C = λC + ψC,C ∈ R6 λ(B + C) = λB + λC,B, C ∈ R7

例 2.5(分配律)

如果我们定义

1 2C := 3 4 (2.33)

那么对于任意 λ, ψ ∈ R,我们得到

(λ + ψ)1 (λ + ψ)2 λ + ψ 2λ + 2ψ(λ + ψ)C = (λ + ψ)3 (λ + ψ)4 = 3λ + 3ψ 4λ + 4ψ (2.34a)

λ 2λ ψ 2ψ= 3λ 4λ + 3ψ 4ψ = λC + ψC . (2.34b)

如果我们考虑线性方程组

2x₁ + 3x₂ + 5x₃ = 1 4x₁ - 2x₂ - 7x₃ = 8 (2.35) 9x₁ + 5x₂ - 3x₃ = 2

并使用矩阵乘法的规则,我们可以将这个方程组写成更紧凑的形式:

2 3 5 x₁ 1

4 -2 -7 x₂ = 8 . (2.36)

9 5 -3 x₃ 2注意 x₁ 缩放第一列,x₂ 缩放第二列,x₃ 缩放第三列。

一般来说,线性方程组可以用其矩阵形式紧凑地表示为 Ax = b;参见 (2.3),乘积 Ax 是 A 的列的(线性)组合。我们将在第 2.5 节中更详细地讨论线性组合。

在 (2.3) 中,我们介绍了方程组的一般形式,即

a₁₁x₁ + ··· + a₁ₙxₙ = b₁ ⋮ (2.37) aₘ₁x₁ + ··· + aₘₙxₙ = bₘ

其中 aᵢⱼ ∈ R 和 bᵢ ∈ R 是已知常数,xⱼ 是未知数,i = 1,…,m,j = 1,…,n。到目前为止,我们看到矩阵可以用作表述线性方程组的紧凑方式,因此我们可以写成 Ax = b,参见 (2.10)。此外,我们定义了基本的矩阵运算,如矩阵的加法和乘法。接下来,我们将专注于求解线性方程组,并提供一个求矩阵逆的算法。

在讨论如何一般性地求解线性方程组之前,让我们看一个例子。考虑方程组

1 0 8 -4 x₁ 42

x₂ = . (2.38)

0 1 2 12 x₃ 8

x₄该系统有两个方程和四个未知数。因此,一般来说我们期望有无穷多个解。这个方程组具有特别简单的形式,其中前两列由 1 和 0 组成。记住我们想要找到标量 x₁,…,x₄,使得 Σ⁴ᵢ₌₁ xᵢcᵢ = b,其中我们定义 cᵢ 为矩阵的第 i 列,b 为 (2.38) 的右端。问题 (2.38) 的解可以通过取第一列的 42 倍和第二列的 8 倍立即找到,使得

42 1 0b = 8 = 42 × 0 + 8 × 1 . (2.39)

因此,一个解是 [42, 8, 0, 0]ᵀ。这个解称为特解或特殊解。但是,这不是该线性方程组的唯一解。为了捕获所有其他解,我们需要巧妙地使用矩阵的列以非平凡的方式生成 0:向我们的特解添加 0 不会改变特解。为此,我们使用前两列(它们具有这种非常简单的形式)来表示第三列

8 1 0= 8 × 0 + 2 × 1 (2.40) 2

因此 0 = 8c₁ + 2c₂ - 1c₃ + 0c₄,即 (x₁, x₂, x₃, x₄) = (8, 2, -1, 0)。实际上,这个解的任意标量倍数 λ₁ ∈ R 都产生 0 向量,即

1 0 8 -4 8

λ₁ 2 = λ₁(8c₁ + 2c₂ - c₃) = 0 . (2.41)

0 1 2 12 -1

0按照同样的推理路线,我们使用前两列来表示 (2.38) 中矩阵的第四列,并生成另一组 0 的非平凡版本

1 0 8 -4 -4

λ₂ 12 = λ₂(-4c₁ + 12c₂ - c₄) = 0 (2.42)

0 1 2 12 0

-1对于任意 λ₂ ∈ R。综合所有内容,我们得到 (2.38) 中方程组的所有解,称为通解,为集合

42 8 -4x ∈ R⁴: x = 8 + λ₁ 2 + λ₂ 12 , λ₁, λ₂ ∈ R . (2.43) 0 -1 0 0 0 -1

备注:我们遵循的一般方法包括以下三个步骤:

通解和特解都不是唯一的。[♢]

前面例子中的线性方程组很容易求解,因为 (2.38) 中的矩阵具有这种特别方便的形式,

这使我们能够通过检查找到特解和通解。然而,一般的方程组并不具有这种简单的形式。

幸运的是,存在一种构造性的算法方法,可以将任何线性方程组转换为这种特别简单的形式:高斯消元法。高斯消元法的关键是线性方程组的基本变换,这些变换将方程组转换为简单形式。然后,我们可以将刚才在[(2.38)]例子中讨论的三个步骤应用到简单形式上。

2.3.2 基本变换

解线性方程组系统的关键是基本变换,这些变换保持解集不变,但将方程组转换为更简单的形式:

[Mathematics for Machine Learning草稿(2023-10-18)。反馈:https://mml-book.com. 2.3 解线性方程组 29]

交换两个方程(表示方程组的矩阵中的行)

用常数λ ∈ R\{0}乘以一个方程(行)

两个方程(行)相加

例2.6

对于a ∈ R,我们求以下方程组的所有解:

−2x1 + 4x[2] − 2x3 − x[4] + 4x[5] = −3

4x1 − 8x[2] + 3x3 − 3x[4] + x[5] = 2 . (2.44) x1 − 2x[2] + x3 − x[4] + x[5] = 0

x1 − 2x[2] − 3x[4] + 4x[5] = a

我们首先将这个方程组转换为紧凑的矩阵记号Ax = b。我们不再明确提及变量x,并构建增广矩阵(形式为A | b)

− 2 4 − 2 − 1 4 − 3 与R3交换 4 − 8 3 − 3 1

2

1 − 2 1 − 1 1 0 与R1交换 1 − 2 0 − 3 4 a

其中我们使用竖线来分隔[(2.44)]中的左边和右边。我们使用⇝来表示使用基本变换对增广矩阵的变换。增广矩阵[A | b]紧凑地表示线性方程组Ax = b。

交换第1行和第3行得到

1 − 2 1 − 1 1 0

4 − 8 3 − 3 1 2 +2R1 − 2 4 − 2 − 1 4 − 3

1 − 2 0 − 3 4 a −R1

当我们现在应用指定的变换(例如,从第2行减去第1行的四倍)时,我们得到

1 − 2 1 − 1 1 0

0 0 − 1 1 − 3 2

0 0 0 − 3 6 − 3

0 0 − 1 − 2 3 a −R[2] − R3

⇝ 1 − 2 1 − 1 1 0

0 0 − 1 1 − 3 2 ·(−1) 0 0 0 3 6 3 ·(−1/3) 0 0 0 0 0 a+ 1

⇝ 1 − 2 1 − 1 1 0

0 0 1 − 1 3 − 2 0 0 0 1 2 1 0 0 0 0 0 a+ 1

[©2023 M. P. Deisenroth, A. A. Faisal, C. S. Ong. Published by Cambridge University Press (2020).]

线性代数

这个(增广)矩阵处于一种方便的形式,即行阶梯形式(REF)。将这种紧凑记号转换回包含我们所求变量的显式记号,我们得到

x1 − 2x[2] + x3 − x[4] + x[5] = 0

x3 − x[4] + 3x[5] = −2 . (2.45) x[4] − 2x[5] = 1

0 = a + 1

只有当a = −1时,这个系统才能被解决。一个特解是

x[1] 2

x[2] 0x = x3 = −1 . (2.46) x[4] 1 x[5] 0

通解,它捕获所有可能解的集合,是

2 2 2

0 1 0x ∈ R : x = −1 + λ1 0 + λ[2] −1 , λ1, λ[2] ∈ R . (2.47) 1 0 2 0 0 1

在下面,我们将详细介绍获得线性方程组特解和通解的构造性方法。

注释(主元和阶梯结构)。一行的首项系数(从左边开始的第一个非零数)称为主元,并且总是严格位于其上一行主元的右侧。因此,任何处于行阶梯形式的方程组总是具有”阶梯”结构。♢

定义2.6(行阶梯形式)。如果矩阵满足以下条件,则称其处于行阶梯形式:

只包含零的所有行都位于矩阵的底部;相应地,至少包含一个非零元素的所有行都位于只包含零的行的上方。

仅看非零行,从左边开始的第一个非零数(也称为主元或首项系数)总是严格位于其上一行主元的右侧。在其他文献中,有时要求主元为1。

注释(基本变量和自由变量)。在行阶梯形式中对应于主元的变量称为基本变量,其他变量是自由变量。例如,在[(2.45)]中,x1、x3、x[4]是基本变量,而x[2]、x[5]是自由变量。♢

注释(获得特解)。当我们需要确定特解时,行阶梯形式使

[Mathematics for Machine Learning草稿(2023-10-18)。反馈:https://mml-book.com. 2.3 解线性方程组 31]

我们的工作变得更容易。为此,我们使用主元列来表示方程组的右边,使得b = Σ[i=1到P] λ[i]p[i],其中p[i],i = 1,…,P,是主元列。如果我们从最右边的主元列开始并向左工作,λ[i]最容易确定。

1 1 −1 0

0 1 −1 −2λ1 + λ[2] + λ3 = . (2.48) 0 0 1 1 0 0 0 0

从这里,我们可以相对直接地找到 λ3 = 1,λ[2] = −1,λ1 = 2。当我们把所有内容整合在一起时,我们不能忘记非主元列,对于这些列我们隐式地将系数设为0。因此,我们得到特解 x⊤ = [2, 0, −1, 1, 0]。♢

注释 (简化行阶梯形式)。一个方程组处于简化行阶梯形式(也称为行简化阶梯形式或行标准形式),当满足以下条件时:

它处于行阶梯形式。

每个主元都是1。

主元是其所在列中唯一的非零项。

♢

简化行阶梯形式在第2.3.3节中将发挥重要作用,因为它允许我们以直接的方式确定线性方程组的通解。

注释 (高斯消元法)。高斯消元法是一种算法,通过执行基本变换将线性方程组转换为简化行阶梯形式。♢

验证以下矩阵处于简化行阶梯形式(主元用粗体标出):

1 3 0 0 3 A = 0 0 1 0 9 . (2.49) 0 0 0 1 −4

寻找Ax = 0解的关键思想是观察非主元列,我们需要将它们表示为主元列的(线性)组合。简化行阶梯形式使这变得相对简单,我们用左侧主元列的和与倍数来表示非主元列:第二列是第一列的3倍(我们可以忽略第二列右侧的主元列)。因此,为了得到0,我们需要从第一列的三倍中减去第二列。现在,我们观察第五列,这是我们的第二个非主元列。第五列可以表示为第一个主元列的3倍,第二个主元列的9倍,以及第三个主元列的−4倍。我们需要记录主元列的索引,并将其转换为第一列的3倍,第二列的0倍(这是一个非主元列),第三列的9倍(这是我们的第二个主元列),以及第四列的−4倍(这是第三个主元列)。然后我们需要减去第五列以得到0。最终,我们仍在求解一个齐次方程组。

总结,Ax = 0,x ∈ R⁵的所有解由以下给出:

3 3

−1 0x ∈ R⁵ : x = λ₁ 0 + λ₂ 9 , λ₁, λ₂ ∈ R . (2.50) 0 −4 0 −1

接下来,我们介绍一个实用技巧来读出齐次线性方程组Ax = 0的解x,其中A ∈ R^(k×n),x ∈ R^n。

首先,我们假设A处于简化行阶梯形式,没有任何只包含零的行,即:

[ 0 ··· 0 1 ∗ ··· ∗ 0 ∗ ··· ∗ 0 ∗ ··· ∗] [ .. .. .. .. ..] [ . . 0 0 ··· 0 1 ∗ ··· ∗ . . .] A = .. [ .. .. .. .. .. .. .. .. ..] [ . . . . 0 . . . . .] . [ ,] [ .. .. .. .. .. .. .. .. .. ..] [ . . . . . . . . 0 . .] [] 0 ··· 0 0 0 ··· 0 0 0 ··· 0 1 ∗ ··· ∗

(2.51)

其中∗可以是任意实数,约束条件是每行的第一个非零项必须是1,相应列中的所有其他项必须是0。带有主元的列j₁, …, j_k(用粗体标记)是标准单位向量e₁, …, e_k ∈ R^k。我们通过添加n − k行形式为

0 ··· 0 −1 0 ··· 0 (2.52)

的行将此矩阵扩展为Ã n × n矩阵,使得增广矩阵Ã的对角线包含1或−1。

然后,包含−1作为主元的Ã列是齐次方程组Ax = 0的解。更准确地说,这些列形成Ax = 0解空间的基(第2.6.1节),我们稍后将称其为核或零空间(见第2.7.3节)。

让我们重新审视矩阵(2.49),它已经处于简化REF形式:

1 3 0 0 3 A = 0 0 1 0 9 . (2.53) 0 0 0 1 −4

我们现在通过在对角线上主元缺失的位置添加形式为(2.52)的行,将此矩阵增广为5 × 5矩阵,得到:

1 3 0 0 3 0 −1 0 0 0 Ã = 0 0 1 0 9 . (2.54) 0 0 0 1 −4

0 0 0 0 −1

从这种形式,我们可以通过取Ã中在对角线上包含−1的列立即读出Ax = 0的解:

3 3

−1 0

x ∈ R⁵ : x = λ₁ 0 + λ₂ 9 , λ₁, λ₂ ∈ R , (2.55) 0 −4 0 −1

这与我们通过”洞察”在(2.50)中得到的解完全相同。

为了计算A ∈ R^(n×n)的逆矩阵A⁻¹,我们需要找到一个满足AX = I_n的矩阵X。那么,X = A⁻¹。我们可以将此写成一组同时线性方程AX = I_n,其中我们求解X = [x₁ | ··· |x_n]。我们使用增广矩阵记号来紧凑表示这组线性方程组,得到:

A | I_n ⇝ ··· ⇝ I_n | A⁻¹ . (2.56)

这意味着如果我们将增广方程组转换为简化行阶梯形式,我们可以在方程组的右侧读出逆矩阵。因此,确定矩阵的逆等同于求解线性方程组。

[©2023 M. P. Deisenroth, A. A. Faisal, C. S. Ong. 由剑桥大学出版社出版 (2020).]

[34] 线性代数

例 2.9 (通过高斯消元法计算逆矩阵)

要确定以下矩阵的逆矩阵:

1 0 2 0 1 1 0 0 A = (2.57) 1 2 0 1 1 1 1 1

我们写出增广矩阵:

1 0 2 0 1 0 0 0 1 1 0 0 0 1 0 0 1 2 0 1 0 0 1 0

1 1 1 1 0 0 0 1

并使用高斯消元法将其化为简化行阶梯形式:

1 0 0 0 − 1 2 − 2 2 0 1 0 0 1 − 1 2 − 2 , − − 0 0 1 0 1 1 1 1 0 0 0 1 −1 0 −1 2

这样所需的逆矩阵就由其右侧给出:

− 1 2 − 2 2 A⁻¹ = 1 − 1 2 − 2 . (2.58) − − 1 1 1 1 −1 0 −1 2

我们可以通过进行A⁻¹A的乘法运算来验证(2.58)确实是逆矩阵,观察到我们恢复了I₄。

在下文中,我们简要讨论求解形如Ax = b的线性方程组的方法。我们假设解存在。如果没有解,我们需要求助于近似解,这在本章中不涉及。解决近似问题的一种方式是使用线性回归的方法,我们将在第9章中详细讨论。

在特殊情况下,我们可能能够确定逆矩阵A⁻¹,这样Ax = b的解就给出为x = A⁻¹b。然而,这只有在A是方阵且可逆时才可能,而这通常不是情况。否则,在温和的假设下(即A需要有线性无关的列),我们可以使用变换:

A⊤Ax = A⊤b ⇔ x = (A⊤A)⁻¹A⊤b (2.59)

[《机器学习数学基础》草稿 (2023-10-18)。反馈:https://mml-book.com] 2.4 向量空间 35

并使用Moore-Penrose伪逆(A⊤A)⁻¹A⊤来确定解(2.59),它解决了Ax = b,这也对应于最小范数最小二乘解。这种方法的缺点是它需要大量计算来进行矩阵-矩阵乘积和计算A⊤A的逆。此外,出于数值精度的原因,通常不建议计算逆或伪逆。因此,在下文中,我们简要讨论求解线性方程组的替代方法。

高斯消元法在计算行列式(第4.1节)、检查向量集是否线性无关(第2.5节)、计算矩阵的逆(第2.2.2节)、计算矩阵的秩(第2.6.2节)以及确定向量空间的基(第2.6.1节)时起着重要作用。高斯消元法是解决有数千个变量的线性方程组的直观且构造性的方法。然而,对于有数百万变量的系统,它是不实用的,因为所需的算术运算数量与同时方程的数量成三次方关系。

在实践中,许多线性方程的系统是间接求解的,要么通过静态迭代方法,如Richardson方法、Jacobi方法、Gauß-Seidel方法和逐次超松弛方法,要么通过Krylov子空间方法,如共轭梯度法、广义最小残差法或双共轭梯度法。我们参考Stoer和Burlirsch (2002)、Strang (2003)以及Liesen和Mehrmann (2015)的书籍以获得更多细节。

设x*是Ax = b的解。这些迭代方法的关键思想是建立形式为

x^(k+1) = Cx^(k) + d (2.60)

的迭代,对于合适的C和d,它在每次迭代中减少残差误差∥x^(k+1) - x∥并收敛到x。我们将在第3.1节中介绍范数∥·∥,它允许我们计算向量之间的相似性。

到目前为止,我们已经研究了线性方程组以及如何求解它们(第2.3节)。我们看到线性方程组可以用矩阵-向量记号(2.10)紧凑地表示。在下文中,我们将更仔细地研究向量空间,即向量所在的结构化空间。

在本章开始时,我们非正式地将向量描述为可以相加并与标量相乘的对象,并且它们仍然是相同类型的对象。现在,我们准备将此正式化,我们将从引入群的概念开始,群是一组元素和在这些元素上定义的运算,它保持集合的某种结构完整。

[©2023 M. P. Deisenroth, A. A. Faisal, C. S. Ong. 由剑桥大学出版社出版 (2020).]

[36] 线性代数

群在计算机科学中起着重要作用。除了为集合上的运算提供基本框架外,它们在密码学、编码理论和图形学中被大量使用。

定义 2.7 (群)。考虑一个集合G和在G上定义的运算⊗:G × G → G。如果以下条件成立,则G := (G, ⊗)被称为群:

注释。 逆元素是相对于运算⊗定义的,不一定意味着1/x。

如果另外∀x, y ∈ G:x ⊗ y = y ⊗ x,则G = (G, ⊗)是Abel群(可交换的)。

例 2.10 (群)

让我们看一些集合及其相关运算的例子,看看它们是否为群:

(Z, +) 是一个 Abelian group。

[N][0] [:=] [N] [∪ {][0][}] (N[0], +) 不是群:虽然 (N[0], +) 拥有中性元素 (0),但缺少逆元素。(Z, ·) 不是群:虽然 (Z, ·) 包含中性元素 (1),但对于任何 z ∈ Z, z ̸= ±1,都缺少逆元素。(R, ·) 不是群,因为 0 没有逆元素。(R \{0}, ·) 是 Abelian 的。

( [n] [n] R , +) , ( Z, +), n ∈ N 是 Abelian 的,如果 + 按分量定义,即:

(x1, · · · , x[n]) + (y1, · · · , y[n]) = (x1 + y1, · · · , x[n] + y[n]). [(2.61)]

那么,− ( x , · · · , x ) := (−x , · · · , −x ) 是逆元素,1 [n] 1 [n] e = (0, · · · , 0) 是中性元素。( [m] [×][n] R, +),即 m × n 矩阵的集合是 Abelian 的(按 [(2.61)] 中定义的分量加法)。

让我们更仔细地看看 [n] [×][n] ( R, ·),即具有矩阵乘法(按 [(2.13)] 中定义)的 n × n 矩阵集合。

– 封闭性和结合律直接从矩阵乘法的定义得出。

– 中性元素:单位矩阵 I [n] 是 [n] [×][n] ( R, ·) 中关于矩阵乘法 ” · ” 的中性元素。

[Draft (2023-10-18) of “Mathematics for Machine Learning”. Feedback:] [https://mml-book.com][.] [2.4 Vector Spaces]

– − 逆元素:如果逆元素存在(A 是正则的),那么 A 是 [n][×][n] [n][×][n] A ∈ R 的逆元素,在这种情况下(且仅在这种情况下)( R , ·) 是一个群,称为 general linear group。

Definition 2.8 (General Linear Group). 正则(可逆)矩阵 [n] [×][n] A ∈ R 的集合关于 [(2.13)] 中定义的矩阵乘法构成一个群,称为 general linear group GL(n, R)。然而,由于矩阵乘法不满足交换律,该群不是 Abelian 的。

当我们讨论群时,我们考虑的是集合 G 和 G 上的内运算,即仅对 G 中元素进行运算的映射 G × G → G。在下面的内容中,我们将考虑除了内运算 + 之外还包含外运算 · 的集合,即向量 x ∈ G 与标量 λ ∈ R 的乘法。我们可以将内运算视为一种加法,将外运算视为一种缩放。注意内/外运算与内/外积无关。

Definition 2.9 (Vector Space). 实值 vector space V = ( V , +, ·) 是一个集合 V 具有两个运算

+ : V × V → V (2.62) · : R × V → V (2.63)

其中

1. ( V, +) 是一个 Abelian group

2. 分配律:

1. ∀λ ∈ R, x, y ∈ V : λ · (x + y) = λ · x + λ · y 2. ∀λ, ψ ∈ R, x ∈ V : (λ + ψ) · x = λ · x + ψ · x

3. 结合律(外运算):∀λ, ψ ∈ R, x ∈ V : λ·(ψ ·x) = (λψ)·x 4. 关于外运算的中性元素:∀x ∈ V : 1 ·x = x

元素 x ∈ V 称为 vectors。(V , +) 的中性元素是零向量 [⊤] 0 = [0 , . . . , 0],内运算 + 称为 vector addition。元素 λ ∈ R 称为 scalars,外运算 · 是 multiplication by scalars。注意标量积是不同的概念,我们将在第 [3.2] 节中讨论。

Remark. [n] “向量乘法” ab,a , b ∈ R 是未定义的。理论上,我们可以定义分量乘法,使得 c = ab 其中 c [j] = a[j]b[j]。这种”数组乘法”在许多编程语言中很常见,但使用标准矩阵乘法规则在数学上意义有限:通过将向量视为 n × 1 矩阵

[©2023 M. P. Deisenroth, A. A. Faisal, C. S. Ong. Published by Cambridge University Press (2020).]

(我们通常这样做),我们可以使用 [(2.13)] 中定义的矩阵乘法。然而,这样向量的维度不匹配。只有以下向量乘法是定义的:[⊤] [n][×][n] ab ∈ R (outer product),[⊤] ab ∈ R (inner/scalar/dot product)。♢

Example 2.11 (Vector Spaces)

让我们看一些重要的例子:

V [n] = R, n ∈ N 是一个 vector space,运算定义如下: – 加法:x+y = (x1, . . . , x[n])+(y1, . . . , y[n]) = (x1+y1, . . . , x[n] +y[n]) 对于所有 [n] x , y ∈ R

– 标量乘法:λ x = λ(x 1, . . . , x[n]) = (λx1, . . . , λx[n]) 对于所有 [n] λ ∈ R , x ∈ R

V [m] [×][n] = R, m, n ∈ N 是一个 vector space,具有

a + b · · · a + b [11] [11] [1][n] [1][n] – 加法:A + B = .. .. 对所有 A, B ∈ V 按分量定义。 . am + bm · · · a[mn] + b[mn]

λa · · · λa [11] [1][n] – 标量乘法:λA = .. .. 如第 [2.2] 节中定义。 . λam · · · λa[mn]

记住 [m] [×][n] [mn] R 等价于 R。

V = C,具有复数加法的标准定义。

Remark. 在下面的内容中,当 + 和 · 是标准向量加法和标量乘法时,我们将用 V 来表示 vector space (V , +, ·)。此外,我们将使用记号 x ∈ V 表示 V 中的向量以简化记号。♢

Remark. [n] [n][×]1 [1][×][n] vector spaces R , R , R 只是在向量书写方式上不同。在下面的内容中,我们不区分 [n] [n][×]1 R 和 R,这允许我们将 n 元组写成列向量

x 1

x = .. . [(2.64)] . x[n]

这简化了关于 vector space 运算的记号。然而,我们确实区分 [n][×]1 [1][×][n] R 和 R(行向量)以避免混淆

融合与矩阵乘法。默认情况下,我们用 x 表示列向量,行向量用 x⊤ 表示,即 x 的转置。♢

2.4.3 向量子空间

在下面的内容中,我们将介绍向量子空间。直观地说,它们是包含在原始向量空间中的集合,具有这样的性质:当我们对该子空间内的元素执行向量空间运算时,我们永远不会离开它。从这个意义上说,它们是”封闭的”。向量子空间是机器学习中的一个关键概念。例如,第10章演示了如何使用向量子空间进行降维。

定义 2.10(向量子空间)。设 V = (V, +, ·) 是一个向量空间,U ⊆ V,U ≠ ∅。则 U = (U, +, ·) 称为 V 的向量子空间(或线性子空间),如果 U 是一个向量空间,其向量空间运算 + 和 · 限制在 U × U 和 R × U 上。我们写作 U ⊆ V 来表示 V 的子空间 U。

如果 U ⊆ V 且 V 是向量空间,那么 U 自然地直接从 V 继承许多性质,因为它们对所有 x ∈ V 都成立,特别是对所有 x ∈ U ⊆ V。这包括 Abelian 群的性质、分配律、结合律和零元素。要确定 (U, +, ·) 是否为 V 的子空间,我们仍需证明:

例 2.12(向量子空间)

让我们看一些例子:

对于每个向量空间 V,平凡子空间是 V 本身和 {0}。

图2.6中只有例子 D 是 R² 的子空间(使用通常的内/外运算)。在 A 和 C 中,封闭性质被违反;B 不包含 0。

齐次线性方程组 Ax = 0 的解集,其中有 n 个未知数 x = [x₁, …, xₙ]⊤,是 Rⁿ 的子空间。

非齐次线性方程组 Ax = b,b ≠ 0 的解不是 Rⁿ 的子空间。

任意多个子空间的交集本身也是子空间。

图 2.6 并非 R² 的所有子集都是子空间。在 A 和 C 中,封闭性质被违反;B 不包含 0。只有 D 是子空间。

注记。 每个子空间 U ⊆ (Rⁿ, +, ·) 都是齐次线性方程组 Ax = 0 对 x ∈ Rⁿ 的解空间。♢

在下面的内容中,我们将仔细研究我们可以用向量(向量空间的元素)做什么。特别地,我们可以将向量相加并用标量乘以它们。封闭性质保证我们最终得到同一向量空间中的另一个向量。我们可以找到一组向量,通过将它们相加和缩放,我们可以表示向量空间中的每个向量。这组向量是一个基,我们将在第2.6.1节中讨论它们。在此之前,我们需要引入线性组合和线性无关性的概念。

定义 2.11(线性组合)。考虑向量空间 V 和有限个向量 x₁, …, xₖ ∈ V。则每个形式为

v = λ₁x₁ + ··· + λₖxₖ = Σᵢ₌₁ᵏ λᵢxᵢ ∈ V (2.65)

的 v ∈ V,其中 λ₁, …, λₖ ∈ R,称为向量 x₁, …, xₖ 的线性组合。

零向量总是可以写成 k 个向量 x₁, …, xₖ 的线性组合,因为 0 = Σᵢ₌₁ᵏ 0·xᵢ 总是成立的。在下面的内容中,我们对表示 0 的向量集合的非平凡线性组合感兴趣,即向量 x₁, …, xₖ 的线性组合,其中 (2.65) 中并非所有系数 λᵢ 都为 0。

定义 2.12(线性(无)关性)。让我们考虑向量空间 V,其中 k ∈ N 且 x₁, …, xₖ ∈ V。如果存在非平凡线性组合,使得 0 = Σᵢ₌₁ᵏ λᵢxᵢ 且至少有一个 λᵢ ≠ 0,则向量 x₁, …, xₖ 是线性相关的。如果只有平凡解存在,即 λ₁ = … = λₖ = 0,则向量 x₁, …, xₖ 是线性无关的。

线性无关性是线性代数中最重要的概念之一。直观地说,一组线性无关向量由没有冗余的向量组成,即如果我们从集合中移除任何一个向量,我们将失去某些东西。在接下来的章节中,我们将更正式地阐述这种直觉。

例 2.13(线性相关向量)

一个地理例子可能有助于澄清线性无关性的概念。一个在内罗毕(肯尼亚)的人描述基加利(卢旺达)在哪里可能会说:“你可以先向西北方向走506公里到坎帕拉(乌干达),然后向西南方向走374公里到达基加利。”这是描述基加利位置的充分信息,因为地理坐标系可以被视为一个二维向量空间(忽略海拔和地球的曲面)。这个人可能会补充说:“它距离这里大约751公里向西。”尽管这最后的陈述是正确的,但它对于

在基加利给定的前述信息中找到 基加利(见图[2.7]的说明)。在这个例子中,“506公里西北”向量(蓝色)和”374公里西南”向量(紫色)是线性无关的。这意味着西南向量不能用西北向量来描述,反之亦然。然而,第三个”751公里西”向量(黑色)是其他两个向量的线性组合,它使得向量集合线性相关。等价地,给定”751公里西”和”374公里西南”可以线性组合得到”506公里西北”。

坎帕拉 [图 2.7]

506 [[地理示例]]

w 北 [近似到] 西 公里 [(粗略地)]

南 [西 [[基本方向)]]]

内罗毕 [线性]

公里 [[相关向量]]

374 [在一个] 751 公里 西

西 [[二维]]

w [[空间(平面)。]]

基加利

南

公里

注. 以下性质对于确定向量是否线性无关很有用:

k个向量要么线性相关,要么线性无关。没有第三种选择。

如果向量 x1, . . . , x[k] 中至少有一个是 0,那么它们是线性相关的。如果两个向量相同,情况也是如此。

向量 {x1, . . . , x[k] : x[i] ̸= 0, i = 1, . . . , k}, k ⩾ 2,是线性相关的当且仅当其中(至少)一个是其他向量的线性组合。特别地,如果一个向量是另一个向量的倍数,即 x[i] = λx[j], λ ∈ R,那么集合 {x1, . . . , x[k] : x[i] ̸= 0, i = 1, . . . , k} 是线性相关的。

检查向量 x1, . . . , x[k] ∈ V 是否线性无关的实用方法是使用高斯消元法:将所有向量写成矩阵 A 的列,并执行高斯消元直到矩阵达到行阶梯形式(这里不需要简化行阶梯形式):

[©2023 M. P. Deisenroth, A. A. Faisal, C. S. Ong. Published by Cambridge University Press (2020).]

[42] [[线性代数]]

– 主元列表示与左侧向量线性无关的向量。注意在构建矩阵时存在向量的排序。

– 非主元列可以表示为其左侧主元列的线性组合。例如,行阶梯形式

1 3 0 (2.66) 0 0 2

告诉我们第一列和第三列是主元列。第二列是非主元列,因为它是第一列的三倍。

所有列向量都线性无关当且仅当所有列都是主元列。如果至少存在一个非主元列,则列(因此相应的向量)是线性相关的。

♢

例 2.14

考虑 R[4] 中的

1 1 − 1 2 1 − 2x1 = , x[2] = , x3 = . (2.67) 3 0 1 4 2 1

为了检查它们是否线性相关,我们遵循一般方法并求解

1 1 − 1 2 1 − 2λ1 x1 + λ[2]x[2] + λ3x3 = λ1 + λ[2] + λ3 = 0 (2.68) 3 0 1 4 2 1

对于 λ1, . . . , λ3。我们将向量 x[i], i = 1, 2, 3 写成矩阵的列,并应用基本行变换直到我们识别出主元列:

1 1 − 1 1 1 − 1

2 1 − 2 0 1 0 · · · ⇝ ⇝ . (2.69)

3 0 1 0 0 14 2 1 0 0 0

这里,矩阵的每一列都是主元列。因此,不存在非平凡解,我们需要 λ1 = 0, λ[2] = 0, λ3 = 0 来求解方程组。因此,向量 x1, x[2], x3 是线性无关的。

[Draft (2023-10-18) of “Mathematics for Machine Learning”. Feedback:] [https://mml-book.com][.] [2.5 线性无关] [[43]]

注. 考虑一个向量空间 V,其中有 k 个线性无关向量 b1, . . . , b[k] 和 m 个线性组合

[k] x X = λ b , 1 i [i] [i][=1]

.. [(2.70) .]

[k] x X = λ b . [m] [im] [i] [i][=1]

定义 B = [b1, . . . , b[k] ] 为列是线性无关向量 b1, . . . , b[k] 的矩阵,我们可以写成

λ [1][j]

x[j] = Bλ[j] , λ[j] = .. , j = 1, . . . , m , (2.71) . λ [kj]

这是一种更紧凑的形式。

我们想要测试 x1, . . . , x[m] 是否线性无关。为此,我们遵循测试 P [m] ψ x = 0 的一般方法。 [j][=1] [j] [j]

用 [(2.71)],我们得到

[m] [m] [m] X X X ψ x = ψ Bλ = B ψ λ . (2.72) [j] [j] [j] [j] [j] [j] [j][=1] [j][=1] [j][=1]

这意味着 {x1, . . . , x[m]} 线性无关当且仅当列向量 {λ1, . . . , λ[m]} 线性无关。

♢

注. 在向量空间 V 中,如果 m > k,那么 k 个向量 x1, . . . , x[k] 的 m 个线性组合是线性相关的。 [♢]

例 2.15

考虑一组线性无关向量 b1, b[2], b3, b[4] ∈ R[n] 和

x[2] = −4b1 − 2b[2] + 4b[4] . (2.73) x 3 = 2 b 1 + 3 b [2] − b 3 − 3 b [4] x[4] = 17b1 − 10b[2] + 11b3 + b[4]

向量 x1, . . . , x[4] ∈ R[n] 是线性无关的吗?为了回答这个问题,我们研究列向量

1 4 − 2 17

− 2 − 2 3 − 10

, , , (2.74)

1 0 − 1 11

− 1 4 − 3 1[©2023 M. P. Deisenroth, A. A. Faisal, C. S. Ong. Published by Cambridge University Press (2020).]

[44] [[线性代数]]

是否线性无关。对应的线性方程组的系数矩阵的简化行阶梯形式

1 − 4 2 17 − 2 − 2 3 − 10 A = (2.75) 1 0 − 1 11 −1 4 −3 1

给出为

1 0 0 − 7 0 1 0 − 15 . (2.76) 0 0 1 18 0 0 0 0

我们看到对应的线性方程组是非平凡可解

因此,x₁, …, x₄ 线性相关,因为 x₄ 可以表示为 x₁, …, x₃ 的线性组合。

在向量空间 V 中,我们特别关注具有以下性质的向量集合 A:V 中的任何向量 v 都可以通过 A 中向量的线性组合得到。这些向量是特殊的向量,在下面我们将对它们进行刻画。

定义 2.13(生成集和张成)。考虑向量空间 V = (V, +, ·) 和向量集合 A = {x₁, …, xₖ} ⊆ V。如果 V 中的每个向量 v 都可以表示为 x₁, …, xₖ 的线性组合,则称 A 为 V 的生成集。A 中所有向量的线性组合的集合称为 A 的张成。如果 A 张成向量空间 V,我们记作 V = span[A] 或 V = span[x₁, …, xₖ]。

生成集是张成向量(子)空间的向量集,即每个向量都可以表示为生成集中向量的线性组合。现在,我们将更加具体地刻画张成向量(子)空间的最小生成集。

定义 2.14(基)。考虑向量空间 V = (V, +, ·) 和 A ⊆ V。如果不存在更小的集合 Ã ⊊ A ⊆ V 张成 V,则称 V 的生成集 A 是最小的。V 的每个线性无关的生成集都是最小的,称为 V 的基。

设 V = (V, +, ·) 是向量空间,B ⊆ V,B ≠ ∅。则以下陈述等价:

基是最小的生成集和最大的线性无关向量集。

x = Σᵢ₌₁ᵏ λᵢbᵢ = Σᵢ₌₁ᵏ ψᵢbᵢ (2.77)

其中 λᵢ, ψᵢ ∈ ℝ,bᵢ ∈ B,则有 λᵢ = ψᵢ,i = 1, …, k。

例 2.16

在 ℝ³ 中,标准基是

B = {[1;0;0], [0;1;0], [0;0;1]} (2.78)

ℝ³ 中的不同基有

B₁ = {[1;0;0], [1;1;0], [1;1;1]},B₂ = {[0.5;0.8;0.4], [1.8;0.3;0.3], [-2.2;-1.3;3.5]} (2.79)

集合

A = {[1;3;4], [2;0;2], [1;0;-4]} (2.80)

是线性无关的,但不是 ℝ⁴ 的生成集(也不是基):例如,向量 [1,0,0,0]ᵀ 不能通过 A 中元素的线性组合得到。

注释。每个向量空间 V 都有一个基 B。前面的例子表明,向量空间 V 可能有许多基,即基不是唯一的。然而,所有基都有相同数量的元素,即基向量。♢

我们只考虑有限维向量空间 V。在这种情况下,V 的维数是 V 的基向量的数量,记作 dim(V)。如果 U ⊆ V 是 V 的子空间,则 dim(U) ≤ dim(V),且 dim(U) = dim(V) 当且仅当 U = V。直观地,向量空间的维数可以看作该向量空间中独立方向的数量。

注释。向量空间的维数不一定等于向量中元素的数量。例如,向量空间 V = span[[0;1]] 是一维的,尽管基向量有两个元素。♢

注释。子空间 U = span[x₁, …, xₘ] ⊆ ℝⁿ 的基可以通过执行以下步骤找到:

♢

例 2.17(确定基)

对于向量子空间 U ⊆ ℝ⁵,由向量

x₁ = [1;-1;-1;-1], x₂ = [2;1;2;-2], x₃ = [3;3;5;-3], x₄ = [-1;-5;-6;1] ∈ ℝ⁵ (2.81)

张成,我们想要找出哪些向量 x₁, …, x₄ 是 U 的基。

为此,我们需要检查 x₁, …, x₄ 是否线性无关。因此,我们需要求解

Σᵢ₌₁⁴ λᵢxᵢ = 0 (2.82)

这导致齐次线性方程组,其矩阵为

[x₁, x₂, x₃, x₄] = [1 2 3 -1; -1 1 3 -5; -1 2 5 -6; -1 -2 -3 1] (2.83)

通过线性方程组的基本变换规则,我们得到行阶梯形

[1 2 3 -1; -1 1 3 -5; -1 2 5 -6; -1 -2 -3 1] ⟹ … ⟹ [1 2 3 -1; 0 1 2 -2; 0 0 0 1; 0 0 0 0; 0 0 0 0]

由于主元列表示哪一组向量线性无关,从行阶梯形可以看出 x₁, x₂, x₄ 线性无关(因为线性方程组 λ₁x₁ + λ₂x₂ + λ₄x₄ = 0 只能用 λ₁ = λ₂ = λ₄ = 0 求解)。因此,{x₁, x₂, x₄} 是 U 的基。

2.6.2 秩(Rank)

矩阵 A ∈ R^(m×n) 的线性无关列数等于线性无关行数,称为 A 的秩,记作 rk(A)。

备注。 矩阵的秩具有一些重要性质:

rk(A^⊤) = rk(A),即列秩等于行秩。

A ∈ R^(m×n) 的列张成子空间 U ⊆ R^m,其中 dim(U) = rk(A)。稍后我们将称此子空间为像或值域。通过对 A 应用高斯消元法识别主元列,可以找到 U 的基。

A ∈ R^(m×n) 的行张成子空间 W ⊆ R^n,其中 dim(W) = rk(A)。通过对 A^⊤ 应用高斯消元法,可以找到 W 的基。

对于所有 A ∈ R^(n×n),A 是正则的(可逆的)当且仅当 rk(A) = n。

对于所有 A ∈ R^(m×n) 和所有 b ∈ R^m,线性方程组 Ax = b 有解当且仅当 rk(A) = rk(A|b),其中 A|b 表示增广矩阵。

对于 A ∈ R^(m×n),Ax = 0 的解空间的维数为 n - rk(A)。稍后,我们将称此子空间为核或零空间。

如果矩阵 A ∈ R^(m×n) 的秩等于相同维数矩阵可能的最大秩,则称该矩阵具有满秩。这意味着满秩矩阵的秩是行数和列数中的较小者,即 rk(A) = min(m, n)。如果矩阵不具有满秩,则称其为秩亏缺的。

♢

例 2.18 (秩)

A = [1 0 1] [0 1 1] [0 0 0]

A 有两个线性无关的行/列,所以 rk(A) = 2。

A = [1 2 1] [-2 -3 1] [3 5 0]

我们使用高斯消元法来确定秩:

[1 2 1] [1 2 1] [-2 -3 1] ⇝ ··· ⇝ [0 1 3] (2.84) [3 5 0] [0 0 0]

这里,我们看到线性无关行数和列数是 2,因此 rk(A) = 2。

在接下来的内容中,我们将研究保持向量空间结构的映射,这将使我们能够定义坐标的概念。

在本章开始时,我们说向量是可以相加并与标量相乘的对象,结果对象仍然是向量。我们希望在应用映射时保持这个性质:

考虑两个实向量空间 V, W。如果映射 Φ : V → W 满足

Φ(x + y) = Φ(x) + Φ(y) (2.85) Φ(λx) = λΦ(x) (2.86)

对于所有 x, y ∈ V 和 λ ∈ R,则该映射保持向量空间的结构。我们可以在以下定义中总结这一点:

定义 2.15 (线性映射)。对于向量空间 V, W,映射 Φ : V → W 称为线性映射(或向量空间同态/线性变换),如果

∀x, y ∈ V, ∀λ, ψ ∈ R : Φ(λx + ψy) = λΦ(x) + ψΦ(y). (2.87)

事实证明,我们可以将线性映射表示为矩阵(第 2.7.1 节)。回想一下,我们也可以将向量集合作为矩阵的列来收集。在处理矩阵时,我们必须记住矩阵代表什么:线性映射还是向量的集合。我们将在第 4 章中看到更多关于线性映射的内容。在继续之前,我们将简要介绍特殊映射。

定义 2.16 (单射、满射、双射)。考虑映射 Φ : V → W,其中 V, W 可以是任意集合。则 Φ 称为

单射,如果 ∀x, y ∈ V : Φ(x) = Φ(y) ⟹ x = y。满射,如果 Φ(V) = W。双射,如果它既是单射又是满射。

如果 Φ 是满射的,那么 W 中的每个元素都可以通过使用 Φ 从 V “到达”。双射的 Φ 可以被”撤销”,即存在映射 Ψ : W → V 使得 Ψ ∘ Φ(x) = x。这个映射 Ψ 称为 Φ 的逆,通常记作 Φ^(-1)。

根据这些定义,我们介绍向量空间 V 和 W 之间线性映射的以下特殊情况:

同构:Φ : V → W 线性且双射自同态:Φ : V → V 线性自同构:Φ : V → V 线性且双射

我们定义 id_V : V → V, x ↦ x 为 V 中的恒等映射或恒等自同构。

例 2.19 (同态)

映射 Φ : R² → C, Φ([x₁; x₂]) = x₁ + ix₂,是一个同态:

Φ([x₁; x₂] + [y₁; y₂]) = (x₁ + y₁) + i(x₂ + y₂) = x₁ + ix₂ + y₁ + iy₂ = Φ([x₁; x₂]) + Φ([y₁; y₂])

Φ(λ[x₁; x₂]) = λx₁ + λix₂ = λ(x₁ + ix₂) = λΦ([x₁; x₂]) (2.88)

这也证明了为什么复数可以表示为 R² 中的元组:存在一个双射线性映射,将 R² 中元组的逐元素加法转换为具有相应加法的复数集合。注意我们只证明了线性性,但没有证明双射性。

定理 2.17 (定理 3.59 在 [Axler (2015)] 中)。有限维向量空间 V 和 W 同构当且仅当 dim(V) = dim(W)。

定理 2.17 表明,在相同维数的两个向量空间之间存在线性双射映射。直观地说,这意味着相同维数的向量空间某种意义上是相同的东西,因为它们可以相互转换而不会产生任何损失。

定理 2.17 也为我们将 R^(m×n)(m × n 矩阵的向量空间)和 R^(mn)(长度为 mn 的向量的向量空间)视为相同提供了理由,因为它们的维数都是 mn,并且存在将一个转换为另一个的线性双射映射。

备注. 考虑向量空间 V, W, X。那么:

对于线性映射 Φ : V → W 和 Ψ : W → X,映射 Ψ ◦ Φ : V → X 也是线性的。

如果 Φ : V → W 是一个同构映射,那么 Φ : W → V 也是一个同构映射。

[©2023 M. P. Deisenroth, A. A. Faisal, C. S. Ong. Published by Cambridge University Press (2020).]

[50] [[Linear Algebra]]

图 2.8 由两组基向量定义的两个不同坐标系。根据选择的坐标系不同,向量 x 具有不同的坐标表示 x_b 和 x_e。

如果 Φ : V → W, Ψ : V → W 是线性的,那么 Φ + Ψ 和 λΦ, λ ∈ R,也是线性的。

♢

任何 n 维向量空间都与 R^n 同构(定理 2.17)。我们考虑 n 维向量空间 V 的一组基 {b₁, . . . , bₙ}。在下面的讨论中,基向量的顺序将很重要。因此,我们写作

B = (b₁, . . . , bₙ) (2.89)

并称这个 n 元组为 V 的有序基。

备注(记号). 我们现在到了记号变得有些复杂的地方。因此,我们在这里总结一些部分。B = (b₁, . . . , bₙ) 是一个有序基,B = {b₁, . . . , bₙ} 是一个(无序)基,B = [b₁, . . . , bₙ] 是一个以向量 b₁, . . . , bₙ 为列的矩阵。♢

定义 2.18(坐标). 考虑向量空间 V 和 V 的有序基 B = (b₁, . . . , bₙ)。对于任何 x ∈ V,我们得到唯一的表示(线性组合)

x = α₁b₁ + . . . + αₙbₙ (2.90)

其中 α₁, . . . , αₙ 是 x 关于 B 的坐标,向量

α = [α₁; …; αₙ] ∈ Rⁿ (2.91)

是 x 关于有序基 B 的坐标向量/坐标表示。

[Draft (2023-10-18) of “Mathematics for Machine Learning”. Feedback: https://mml-book.com.] 2.7 Linear Mappings [51]

基实际上定义了一个坐标系。我们熟悉二维中的 Cartesian 坐标系,它由标准基向量 e₁, e₂ 张成。在这个坐标系中,向量 x ∈ R² 有一个表示,告诉我们如何线性组合 e₁ 和 e₂ 来得到 x。但是,R² 的任何基都定义了一个有效的坐标系,之前的同一个向量 x 在 (b₁, b₂) 基中可能有不同的坐标表示。在图 2.8 中,x 关于标准基 (e₁, e₂) 的坐标是 [2, 2]ᵀ。但是,关于基 (b₁, b₂),同一个向量 x 表示为 [1.09, 0.72]ᵀ,即 x = 1.09b₁ + 0.72b₂。在接下来的章节中,我们将发现如何获得这种表示。

例 2.20

让我们看一个几何向量 x ∈ R²,其关于 R² 的标准基 (e₁, e₂) 的坐标为 [2, 3]ᵀ。这意味着,我们可以写作 x = 2e₁ + 3e₂。但是,我们不必选择标准基来表示这个向量。如果我们使用基向量 b₁ = [1, -1]ᵀ, b₂ = [1, 1]ᵀ,我们将得到坐标 [-1/2, 5/2]ᵀ 来表示关于 (b₁, b₂) 的同一个向量(见图 2.9)。

图 2.9 向量 x 的不同坐标表示,取决于基的选择。 x = 2e₁ + 3e₂ x = -1/2 b₁ + 5/2 b₂

备注. 对于 n 维向量空间 V 和 V 的有序基 B,映射 Φ : Rⁿ → V, Φ(eᵢ) = bᵢ, i = 1, . . . , n 是线性的(并且由于定理 2.17 是一个同构映射),其中 (e₁, . . . , eₙ) 是 Rⁿ 的标准基。♢

现在我们准备好在矩阵和有限维向量空间之间的线性映射之间建立明确的联系。

定义 2.19(变换矩阵). 考虑向量空间 V, W 及其对应的(有序)基 B = (b₁, . . . , bₙ) 和 C = (c₁, . . . , cₘ)。此外,我们考虑线性映射 Φ : V → W。对于 j ∈ {1, . . . , n},

Φ(bⱼ) = α₁ⱼc₁ + · · · + αₘⱼcₘ = ∑ᵢ₌₁ᵐ αᵢⱼcᵢ (2.92)

是 Φ(bⱼ) 关于 C 的唯一表示。那么,我们称 m × n 矩阵 A_Φ 为 Φ 的变换矩阵(关于 V 的有序基 B 和 W 的有序基 C),其元素由下式给出:

A_Φ(i, j) = αᵢⱼ, (2.93)

Φ(bⱼ) 关于 W 的有序基 C 的坐标是 A_Φ 的第 j 列。考虑(有限维)向量空间 V, W 及其有序基 B, C 和线性映射 Φ : V → W,其

[©2023 M. P. Deisenroth, A. A. Faisal, C. S. Ong. Published by Cambridge University Press (2020).]

[52] [[Linear Algebra]]

变换矩阵为 A_Φ。如果 x̂ 是 x ∈ V 关于 B 的坐标向量,ŷ 是 y = Φ(x) ∈ W 关于 C 的坐标向量,那么

ŷ = A_Φx̂. (2.94)

这意味着变换矩阵可以用来将关于 V 中有序基的坐标映射到关于 W 中有序基的坐标。

例 2.21(变换矩阵)

考虑同态 Φ : V → W 以及 V 的有序基 B = (b₁, . . . , b₃) 和 W 的有序基 C = (c₁, . . . , c₄)。给定

Φ(b₁) = c₁ − c₂ + 3c₃ − c₄ Φ(b₂) = 2c₁ + c₂ + 7c₃ + 2c₄ (2.95) Φ(b₃) = 3c₂ + c₃ + 4c₄

关于 B 和 C 的变换矩阵 A_Φ 满足 Φ(bₖ) = ∑ᵢ₌₁⁴ αᵢₖcᵢ,k = 1, . . . , 3,并给出为

A_Φ = [α₁, α₂, α₃] = [1 2 0; -1 1 3; 3 7 1; -1 2 4], (2.96)

其中 α[j], j = 1, 2, 3, 是 Φ(b[j]) 相对于基 C 的坐标向量。

例 2.22 (向量的线性变换)

图 2.10 线性变换的三个例子,向量以点的形式显示:(a) 原始数据;(b) 旋转 45°;(c) 沿水平轴拉伸;(d) 一般线性映射。

我们考虑 R² 中一组向量的三种线性变换,变换矩阵为:

A₁ = [cos(π/4) -sin(π/4); sin(π/4) cos(π/4)], A₂ = [2 0; 0 1], A₃ = [1 3; 2 -1] (2.97)

图 2.10 给出了向量集合线性变换的三个例子。图 2.10(a) 显示了 R² 中的 400 个向量,每个向量由对应 (x₁, x₂) 坐标处的点表示。这些向量排列成正方形。当我们使用 (2.97) 中的矩阵 A₁ 对每个向量进行线性变换时,得到图 2.10(b) 中的旋转正方形。如果我们应用矩阵 A₂ 表示的线性映射,我们得到图 2.10(c) 中的矩形,其中每个 x₁ 坐标被拉伸 2 倍。图 2.10(d) 显示了图 2.10(a) 中的原始正方形使用 A₃ 进行线性变换后的结果,这是反射、旋转和拉伸的组合。

在下面的内容中,我们将仔细研究当我们改变 V 和 W 中的基时,线性映射 Φ : V → W 的变换矩阵如何变化。考虑两个有序基:

B = (b₁, …, bₙ), B̃ = (b̃₁, …, b̃ₙ) (2.98)

作为 V 的基,以及两个有序基:

C = (c₁, …, cₘ), C̃ = (c̃₁, …, c̃ₘ) (2.99)

作为 W 的基。此外,A_Φ ∈ Rᵐ×ⁿ 是线性映射 Φ : V → W 相对于基 B 和 C 的变换矩阵,Ã_Φ ∈ Rᵐ×ⁿ 是相对于基 B̃ 和 C̃ 的对应变换映射。

在下面的内容中,我们将研究 Ã 和 A 如何相关,即当我们选择从 B̃, C̃ 到 B, C 进行基变换时,我们如何/是否可以将 Ã_Φ 转换为 A_Φ。

备注. 我们有效地得到了恒等映射 id_V 的不同坐标表示。在图 2.9 的上下文中,这意味着将相对于 (e₁, e₂) 的坐标映射到相对于 (b₁, b₂) 的坐标,而不改变向量 x。通过改变基并相应地改变向量的表示,相对于这个新基的变换矩阵可以具有特别简单的形式,从而允许直接的计算。♢

例 2.23 (基变换)

考虑变换矩阵:

A = [2 1; 1 2] (2.100)

相对于 R² 中的标准基。如果我们定义新基:

B = ([1; 1], [1; -1]) (2.101)

我们得到对角变换矩阵:

à = [3 0; 0 1] (2.102)

相对于基 B,这比 A 更容易处理。

在下面的内容中,我们将研究将相对于一个基的坐标向量转换为相对于不同基的坐标向量的映射。我们将首先陈述主要结果,然后提供解释。

定理 2.20 (基变换). 对于线性映射 Φ : V → W,有序基

B = (b₁, …, bₙ), B̃ = (b̃₁, …, b̃ₙ) (2.103)

属于 V,以及

C = (c₁, …, cₘ), C̃ = (c̃₁, …, c̃ₘ) (2.104)

属于 W,以及 Φ 相对于 B 和 C 的变换矩阵 A_Φ,则相对于基 B̃ 和 C̃ 的对应变换矩阵 Ã_Φ 由下式给出:

Ã_Φ = T⁻¹A_Φ S (2.105)

这里, S ∈ Rⁿ×ⁿ 是 id_V 的变换矩阵,将相对于 B̃ 的坐标映射到相对于 B 的坐标, T ∈ Rᵐ×ᵐ 是 id_W 的变换矩阵,将相对于 C̃ 的坐标映射到相对于 C 的坐标。

证明 根据 Drumm and Weil (2001),我们可以将 V 的新基 B̃ 的向量写成基 B 的基向量的线性组合,使得:

b̃ⱼ = s₁ⱼb₁ + ··· + sₙⱼbₙ = Σᵢ₌₁ⁿ sᵢⱼbᵢ, j = 1, …, n (2.106)

类似地,我们将 W 的新基向量 C̃ 写成基 C 的基向量的线性组合,得到:

c̃ₖ = t₁ₖc₁ + ··· + tₘₖcₘ = Σₗ₌₁ᵐ tₗₖcₗ, k = 1, …, m (2.107)

我们定义 S = ((sᵢⱼ)) ∈ Rⁿ×ⁿ 为将相对于 B̃ 的坐标映射到相对于 B 的坐标的变换矩阵,T = ((tₗₖ)) ∈ Rᵐ×ᵐ 为将相对于 C̃ 的坐标映射到相对于 C 的坐标的变换矩阵。特别地,S 的第 j 列是 b̃ⱼ 相对于 B 的坐标表示,T 的第 k 列是 c̃ₖ 相对于 C 的坐标表示。注意 S 和 T 都是可逆的。

我们将从两个角度来看 Φ(b̃ⱼ)。首先,应用映射 Φ,对于所有 j = 1, …, n,我们得到:

Φ(b̃ⱼ) = Σₖ₌₁ᵐ ãₖⱼc̃ₖ = Σₖ₌₁ᵐ ãₖⱼ Σₗ₌₁ᵐ tₗₖcₗ = Σₗ₌₁ᵐ (Σₖ₌₁ᵐ tₗₖãₖⱼ)cₗ (2.108)

其中我们首先将新的基向量 ˜c[k] ∈ W 表示为基向量 c[l] ∈ W 的线性组合,然后交换求和顺序。

或者,当我们将 ˜b[j] ∈ V 表示为 b[j] ∈ V 的线性组合时,我们得到

[n] ! [n] [n] [m]

Φ(˜ [[(2.106)]] X X X X b ) = Φ s b = s Φ( b ) = s a c (2.109a) [j] [ij] [i] [ij] [i] [ij] [li] [l]

[i][=1] [i][=1] [i][=1] [l][=1]

[m] ! [n]

= X X a s c , j = 1, . . . , n , [(2.109b)]

[li] [ij] [l]

[l][=1] [i][=1]

其中我们利用了 Φ 的线性性。比较 [(2.108)] 和 [(2.109b),] 对于所有 j = 1, . . . , n 和 l = 1, . . . , m,可得

[m] [n]

X X t ˜ a = a s (2.110) [lk] [kj] [li] [ij]

[k][=1] [i][=1]

因此,

T ˜ [m][×][n] A [Φ] = A [Φ] S ∈ R , (2.111)

使得

A ˜ − [Φ] = TA[Φ]S , (2.112)

这证明了定理 [2.20.]

定理 [2.20] 告诉我们,当 V 中的基改变(B 被替换为 B ˜) 和 W 中的基改变 ( C 被替换为 C ˜) 时,线性映射 Φ : V → W 的变换矩阵 A[Φ] 被等价矩阵 A ˜[Φ] 替换,其中

A ˜ − [Φ] = TA[Φ]S. (2.113)

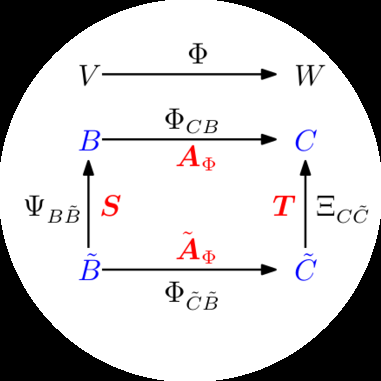

图 [2.11] 说明了这种关系:考虑同态 Φ : V → W 以及 V 的有序基 B, B ˜ 和 W 的有序基 C, C ˜。映射 Φ[CB] 是 Φ 的一个实例,将 B 的基向量映射到 C 的基向量的线性组合上。假设我们知道关于有序基 B, C 的 Φ[CB] 的变换矩阵 A[Φ]。当我们在 V 中执行从 B 到 B ˜ 的基变换,在 W 中执行从 C 到 C ˜ 的基变换时,我们可以确定

[©2023 M. P. Deisenroth, A. A. Faisal, C. S. Ong. 由 Cambridge University Press 出版 (2020).]

[56] [[Linear Algebra]]

图 2.11 对于同态 Φ : V → W 和有序基 B, B ˜ 的 V 以及 C, C ˜ 的 W(标记为蓝色),我们可以等价地将关于基 B ˜, C ˜ 的映射 Φ[C] [˜][B] [˜] 表示为同态的组合,下标中的基对应的变换矩阵用红色标出。

相应的变换矩阵 A ˜[Φ] 如下:首先,我们找到线性映射 Ψ [B] [B] [˜] : V → V 的矩阵表示,该映射将关于新基 B ˜ 的坐标映射到关于”旧”基 B(在 V 中)的(唯一)坐标。然后,我们使用 Φ[CB] : V → W 的变换矩阵 A[Φ] 将这些坐标映射到关于 W 中 C 的坐标。最后,我们使用线性映射 Ξ [˜] [CC] : W → W 将关于 C 的坐标映射到关于 C ˜ 的坐标。因此,我们可以将线性映射 Φ [C] [˜] [˜] [B] 表示为涉及”旧”基的线性映射的组合:

Φ − [C] [˜] [˜] [˜] [B] [CC] [CB] [˜] [B] [B] [˜] [CB] [C] = Ξ ◦ Φ ◦ Ψ = Ξ Φ Ψ [C] [(2.114) ◦ ◦ [B] [˜] . [B]]

具体地,我们使用 Ψ [˜] 和 [B] [B] = id [V] Ξ [˜] ,即恒等映射,将向量映射到自身,但使用不同的基。 [C] [C] = id [W]

定义 2.21 (等价) 。 两个矩阵 A , A ˜ ∈ R [m][×][n] 是等价的,如果存在正则矩阵 S ∈ R [n] [×][n] 和 T ∈ R [m][×][m],使得

A ˜ − = TAS.

定义 2.22 (相似) 。 两个矩阵 A , A ˜ ∈ R [n][×][n] 是相似的,如果存在正则矩阵 S ∈ R [n] [×][n] 使得 A ˜ = SAS −

备注。 相似矩阵总是等价的。然而,等价矩阵不一定相似。♢

备注。 考虑向量空间 V, W, X。从定理 [2.17] 后面的备注,我们已经知道对于线性映射 Φ : V → W 和 Ψ : W → X,映射 Ψ ◦ Φ : V → X 也是线性的。有了相应映射的变换矩阵 A[Φ] 和 A[Ψ],整体变换矩阵是 A[Ψ][◦][Φ] = A[Ψ]A[Φ]。♢

根据这个备注,我们可以从组合线性映射的角度来看基变换:

A[Φ] 是关于基 B, C 的线性映射 Φ[CB] : V → W 的变换矩阵。A ˜[Φ] 是关于基 B ˜, C ˜ 的线性映射 Φ[C] [˜][B] [˜] : V → W 的变换矩阵。S 是线性映射 Ψ[B][B] [˜] : V → V(自同态)的变换矩阵,用 B 来表示 B ˜。通常,Ψ = id[V] 是 V 中的恒等映射。

[Draft (2023-10-18) of “Mathematics for Machine Learning”. Feedback:] [https://mml-book.com][.] [2.7 Linear Mappings] [[57]]

T 是线性映射 Ξ[C][C] [˜] : W → W(自同态)的变换矩阵,用 C 来表示 C ˜。通常,Ξ = id[W] 是 W 中的恒等映射。

如果我们(非正式地)仅用基来写下变换,

那么 A [Φ] : B → C ˜, A ˜ [Φ] : B ˜ → C ˜, S : B ˜ → B, T : C ˜ → C 和 T [−] 1 : C → C ˜,以及

B ˜ → C ˜ = B ˜ → B → C → C ˜ (2.115)

A ˜ − [Φ] = TA[Φ]S . (2.116)

注意 [(2.116)] 中的执行顺序是从右到左,因为向量在右侧相乘,所以 x 7→ Sx 7→ AΦ 7→ T − A ( Sx ) = A ˜ x。 [Φ] [Φ]

例 2.24 (基变换)

考虑线性映射 Φ : R 3 → R [4],其变换矩阵是

1 2 0 − 1 1 3

A[Φ] = (2.117)

3 7 1

−1 2 4

关于标准基

0 0 0 1

1 0 0

0 1 0 0B = (0 , 1 , 0) , C = ( , , , ). (2.118)

0 0 1 00 0 1

0 0 0 1

我们寻求 Φ 在新基下的变换矩阵 ˜ A[Φ]:

1 0 1 1˜ 1 1 0 1

B = (1 , 1 , 0) ∈ R³, C = ( , , , ) . (2.119) 0 3 ˜ 0 1 0 1 1 0

0 1 1

0 0 0 1

那么,

1 1 0 1

1 0 1

1 0 1 0

S = 1 1 0 , T = , (2.120)

0 1 1 0

0 1 1

0 0 0 1

其中 S 的第 ˜ i 列是 b[i] 用 B 的基向量表示的坐标表示。由于 B 是标准基,坐标表示很容易找到。对于一般的基 B,我们需要求解线性方程组来找到 λ[i],使得

[©2023 M. P. Deisenroth, A. A. Faisal, C. S. Ong. Published by Cambridge University Press (2020).]

[58] [[Linear Algebra]]

P 3 λ b , j , . . . , . 类似地,T 的第 j 列是 ˜ c[j] 用 C 的基向量表示的坐标表示。= ˜ b = 1 3 j T

[i][=1] [i] [i] [j]

因此,我们得到

1 1 − 1 − 1 3 2 1

A ˜ − 1 1 −1 1 −1 0 4 2 [Φ] = T A [Φ] S = (2.121a) 2 − 1 1 1 1 10 8 4

0 0 0 2 1 6 3

− 4 − 4 − 2

6 0 0

= . (2.121b)

4 8 4

1 6 3

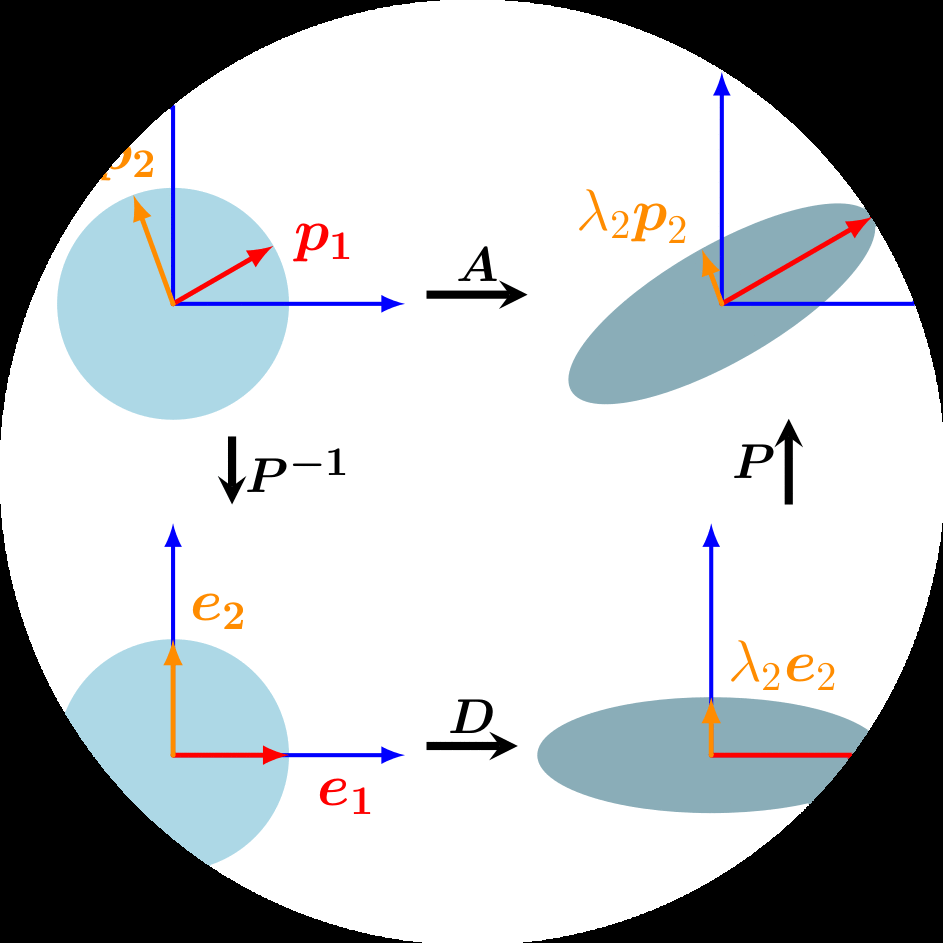

在第 4 章中,我们将能够利用基变换的概念找到一个基,在该基下自同态的变换矩阵具有特别简单的(对角)形式。在第 10 章中,我们将研究数据压缩问题,并找到一个方便的基,我们可以将数据投影到该基上,同时最小化压缩损失。

2.7.3 像和核

线性映射的像和核是具有某些重要性质的向量子空间。接下来,我们将更仔细地描述它们的特征。

定义 2.23(像和核)。 对于 Φ : V → W,我们定义核/零空间

[零空间] − 0 ker(Φ) := Φ ([W] ) = {v ∈ V : Φ(v) = 0[W] } (2.122)

[像] 和像/值域

[值域]

Im(Φ) := Φ(V ) = {w ∈ W |∃v ∈ V : Φ(v) = w} . [(2.123)]

[定义域] 我们也称 V 和 W 分别为 Φ 的定义域和余定义域。 [余定义域]

直观上,核是 Φ 映射到中性元 0[W] ∈ W 的向量 v ∈ V 的集合。像是可以从 V 中的任何向量通过 Φ “到达”的向量 w ∈ W 的集合。图 2.12 给出了示意图。

注记。 考虑线性映射 Φ : V → W,其中 V、W 是向量空间。

总是有 Φ(0[V] ) = 0[W],因此 0[V] ∈ ker(Φ)。特别地,零空间永远不为空。

Im(Φ) ⊆ W 是 W 的子空间,ker(Φ) ⊆ V 是 V 的子空间。

[Draft (2023-10-18) of “Mathematics for Machine Learning”. Feedback:] [https://mml-book.com][.] [2.7 Linear Mappings] [59]

V [Φ : V → W 图 2.12 线性映射] W [Φ : V → W 的核和像。]

[ker(Φ)] [Im(Φ)]

[0][V] [0][W]

Φ 是单射的(一对一的)当且仅当 ker(Φ) = {0}。

♢

注记(零空间和列空间)。 设 A ∈ R^(m×n),考虑线性映射 Φ : R^n → R^m, x 7→ Ax。

对于 A = [a1, . . . , a[n]],其中 a[i] 是 A 的列,我们得到

( n )

Im(Φ) = { Ax : x ∈ R^n } = { Σ x[i] a[i] : x1, . . . , x[n] ∈ R } (2.124a)

[i=1]

= span[a1, . . . , a[n]] ⊆ R^m, (2.124b)

即,像是 A 的列的生成空间,也称为列空间。因此,列空间(像)是 R^m 的一个子空间,其中 m 是矩阵的”高度”。

rk(A) = dim(Im(Φ))。

核/零空间 ker(Φ) 是齐次线性方程组 Ax = 0 的通解,它捕获了 R^n 中产生 0 ∈ R^m 的元素的所有可能线性组合。

核是 R^n 的一个子空间,其中 n 是矩阵的”宽度”。

核关注列之间的关系,我们可以用它来确定是否/如何将一列表示为其他列的线性组合。

♢

例 2.25(线性映射的像和核)

映射

x[1] x[1]x[2] x[2]

Φ : R⁴ → R², [x3] 7→ [x1 + 2x[2] - x3] = [1 2 -1 0] [x3] (2.125a)

x[4] x1 + x[4] [1 0 0 1] [x[4]]

1 2 − 1 0

= x1 + x[2] + x3 + x[4] (2.125b)

1 0 0 1

是线性的。为了确定 Im(Φ),我们可以取变换矩阵的列的生成空间,得到

1 2 − 1 0

Im(Φ) = span[ , , , ] . (2.126)

1 0 0 1

为了计算 Φ 的核(零空间),我们需要求解 Ax = 0,即我们需要求解齐次方程组。为此,我们使用 Gaussian 消元将 A 变换为简化行阶梯形式:

1 2 − 1 0 1 0 0 1

⇝ · · · ⇝ . (2.127)

1 0 0 1 0 1 − 2 − 1

这个矩阵是简化行阶梯形式,我们可以使用 Minus-1 技巧来计算核的基(见第 2.3.3 节)。或者,我们可以将非主元列(第 3 列和第 4 列)表示为主元列(第 1 列和第 2 列)的线性组合。第三列 a3 等于第二列 a[2] 的 -1/2 倍。因此,0 = a3 + (1/2)a[2]。同样地,我们看到 a[4] = a1 - a[2],因此 0 = a1 - a[2] - a[4]。

总的来说,这给出了核(零空间):

0 − 11/2 1

ker(Φ) = span[ , ] . (2.128)

1 0 0 1

定理 2.24(秩-零化度定理)。 对于向量空间 V、W 和线性映射 Φ : V → W,有

dim(ker(Φ)) + dim(Im(Φ)) = dim(V ) . (2.129)

秩-零化度定理也被称为基本定理

线性映射定理(Axler, 2015,定理3.22)。以下是定理2.24的直接推论:

如果 dim(Im(Φ)) < dim(V),那么 ker(Φ)

是非平凡的,即kernel包含的不仅仅是 0_V,并且 dim(ker(Φ)) ≥ 1。如果 A_Φ

是 Φ 相对于有序基的变换矩阵,且 dim(Im(Φ)) < dim(V),那么线性方程组

A_Φx = 0 有无穷多个解。如果 dim(V) = dim(W),那么以下三向等价关系成立:

- Φ 是单射的 - Φ 是满射的

- Φ 是双射的

因为 Im(Φ) ⊆ W。

接下来,我们将仔细研究从原点偏移的空间,即不再是向量子空间的空间。此外,我们将简要讨论这些仿射空间之间映射的性质,这些映射类似于线性映射。

备注。 在机器学习文献中,线性和仿射之间的区别有时不够清晰,因此我们可以找到将仿射空间/映射称为线性空间/映射的参考文献。♢

定义2.25(仿射子空间)。设 V 是向量空间,x_0 ∈ V,U ⊆ V 是子空间。那么子集

L = x_0 + U := {x_0 + u : u ∈ U } (2.130a) = {v ∈ V |∃u ∈ U : v = x_0 + u} ⊆ V (2.130b)

称为 V 的仿射子空间或线性流形。U 称为方向或方向空间,x_0 称为支撑点。在第12章中,我们将这样的子空间称为超平面。

注意,仿射子空间的定义在 x_0 ∉ U 时排除了 0。因此,对于 x_0 ∉ U,仿射子空间不是 V 的(线性)子空间(向量子空间)。

仿射子空间的例子是 R³ 中的点、直线和平面,它们不(必须)通过原点。

备注。 考虑向量空间 V 的两个仿射子空间 L = x_0 + U 和 L̃ = x̃_0 + Ũ。那么,L ⊆ L̃ 当且仅当 U ⊆ Ũ 且 x_0 - x̃_0 ∈ Ũ。

仿射子空间通常用参数来描述:考虑 V 的 k 维仿射空间 L = x_0 + U。如果 (b₁, …, bₖ) 是 U 的有序基,那么 L 中的每个元素 x 都可以唯一地表示为

x = x_0 + λ₁b₁ + … + λₖbₖ , (2.131)

其中 λ₁, …, λₖ ∈ R。这种表示称为 L 的参数方程,具有方向向量 b₁, …, bₖ 和参数 λ₁, …, λₖ。♢

例2.26(仿射子空间)

一维仿射子空间称为直线,可以写成 y = x_0 + λ₁b₁,其中 λ ∈ R,U = span[b₁] ⊆ Rⁿ 是 Rⁿ 的一维子空间。这意味着直线由支撑点 x_0 和定义方向的向量 b₁ 确定。参见图2.13的说明。

Rⁿ 的二维仿射子空间称为平面。平面的参数方程是 y = x_0 + λ₁b₁ + λ₂b₂,其中 λ₁, λ₂ ∈ R,U = span[b₁, b₂] ⊆ Rⁿ。这意味着平面由支撑点 x_0 和两个线性无关的向量 b₁, b₂ 确定,它们张成方向空间。

在 Rⁿ 中,(n-1) 维仿射子空间称为超平面,相应的参数方程是 y = x_0 + Σᵢ₌₁ⁿ⁻¹ λᵢbᵢ,其中 b₁, …, bₙ₋₁ 构成 Rⁿ 的 (n-1) 维子空间 U 的基。这意味着超平面由支撑点 x_0 和 (n-1) 个线性无关的向量 b₁, …, bₙ₋₁ 确定,它们张成方向空间。在 R² 中,直线也是超平面。在 R³ 中,平面也是超平面。

直线是仿射子空间。直线上的向量 y = x_0 + λb₁ 位于具有支撑点 x_0 和方向

b₁ 的仿射子空间 L 中。

直线是仿射子空间。直线上的向量 y = x_0 + λb₁ 位于具有支撑点 x_0 和方向

b₁ 的仿射子空间 L 中。

备注(非齐次线性方程组和仿射子空间)。对于 A ∈ R^(m×n) 和 x ∈ R^m,线性方程组 Aλ = x 的解要么是空集,要么是 R^n 的维数为 n - rk(A) 的仿射子空间。特别地,线性方程 λ₁b₁ + … + λₙbₙ = x 的解,其中 (λ₁, …, λₙ) ≠ (0, …, 0),是 R^n 中的超平面。

在 R^n 中,每个 k 维仿射子空间都是非齐次线性方程组 Ax = b 的解,其中 A ∈ R^(m×n),b ∈ R^m,且 rk(A) = n - k。回忆一下,对于齐次方程组 Ax = 0,解是向量子空间,我们也可以将其视为支撑点 x_0 = 0 的特殊仿射空间。♢

类似于向量空间之间的线性映射(我们在第2.7节中讨论过),我们可以定义两个仿射空间之间的仿射映射。线性映射和仿射映射密切相关。因此,我们已经从线性映射中了解的许多性质,例如线性映射的复合是线性映射,也适用于仿射映射。

定义2.26(仿射映射)。对于两个向量空间 V, W,线性映射 Φ : V → W,以及 a ∈ W,映射

ϕ : V → W (2.132) x ↦ a + Φ(x) (2.133)

是从 V 到 W 的仿射映射。向量 a 称为 ϕ 的平移向量。

每个仿射映射 ϕ : V → W 也是线性映射 Φ : V → W 和 W 中的平移 τ : W → W 的组合,使得

ϕ = τ ◦ Φ。映射 Φ 和 τ 是唯一确定的。

仿射映射 ϕ : V → W,ϕ′ : W → X 的组合 ϕ′ ◦ ϕ 是仿射的。

仿射映射保持几何结构不变。它们也保持维度和平行性。

2.9 延伸阅读

学习线性代数有很多资源,包括 [Strang (2003),] [Golan (2007),] [Axler (2015),] 和 [Liesen and Mehrmann (2015)] 的教科书。还有几个在线资源,我们在本章的介绍中提到过。我们这里只涵盖了高斯消元法,但有许多其他方法可以求解线性方程组,我们推荐 [Stoer and Burlirsch (2002),] [Golub and Van Loan (2012),] 和 [Horn and Johnson (2013)] 的数值线性代数教科书进行深入讨论。

在本书中,我们区分线性代数的主题(如向量、矩阵、线性无关、基)和与向量空间几何相关的主题。在第 3 章中,我们将介绍内积,它诱发一个范数。这些概念允许我们定义角度、长度和距离,我们将用于正交投影。投影在许多机器学习算法中起关键作用,如线性回归和主成分分析,我们将分别在第 9 章和第 [10] 章中涵盖。

[©2023 M. P. Deisenroth, A. A. Faisal, C. S. Ong. Published by Cambridge University Press (2020).]

[64] [[Linear Algebra]]

练习

[2.1] [我们考虑] [(] [R{−1}, ⋆][)][,其中]

[a ⋆ b] [:=] [ab] [+] [a] [+] [b,] [a, b] [∈] [R{−1}] [(2.134)]

[a. 证明] [(] [R{−1}] [, ⋆][)] [是一个阿贝尔群。] [b. 求解]

3 [⋆ x ⋆ x] [= 15]

[在阿贝尔群] [(] [R{−1}][, ⋆][)] [中,其中] [⋆] [定义在 (2.134) 中。]

[2.2] [设] [n] [属于] [N] [{] [0] [}] [。设] [k, x] [属于] [Z] [。我们定义整数] [k] [的同余类] [k] [为集合]

[k] [=] { [∈] [Z | x] [−] [k] [= 0 (mod][n][)][}] [=] { [∈] [Z] [| ∃][a] [∈] [Z] : ( [−] [k] [=] [n] [·] [a][)][}] [.]

[我们现在定义] [Z/nZ] [(有时写作] [Z][n][) 为所有模] [n] [的同余类的集合。欧几里得除法意味着这个集合是包含] [n] [个元素的有限集合:]

[Z][n] [=] [{][0][,] [1][, . . . , n] [−] [1][}]

[对于所有] [a, b] [∈] [Z][n] [,我们定义] [a] [⊕] [b] [:=] [a] [+] [b]

[a. 证明] [(][Z][n][,] [⊕][)] [是一个群。它是阿贝尔的吗?] [b. 我们现在为] [Z][n] [中的所有] [a] [和] [b] [定义另一个运算] [⊗] [:]

[a] [⊗] [b] [=] [a] [×] [b ,] [[(2.135)]]

[其中] [a] [×] [b] [表示] [Z] [中的通常乘法。] [设] [n] [= 5] [。绘制] [Z][5]{0}] [在] [⊗] [下的乘法表,即计算] [Z][5]{0}] [中所有] [a] [和] [b] [的乘积] [a] [⊗] [b] [。] [因此,证明] [Z][5]{0}] [在] [⊗] [下封闭并且对于] [⊗] [拥有中性元素。显示] [Z][5]{0}] [中所有元素在] [⊗] [下的逆。] [得出结论] [(] [Z][5]{0}][,] [⊗][)] [是一个阿贝尔群。]

[c. 证明] [(][Z][8]{0}][,] [⊗][)] [不是一个群。] [d. 我们回顾贝祖定理(Bézout theorem)陈述两个整数] [a] [和] [b] [互质(即] [gcd][(][a, b][) = 1][) 当且仅当存在两个整数] [u] [和] [v] [使得] [au] [+] [bv] [= 1] [。证明] [(] [Z][n]{0}][,] [⊗][)] [是一个群当且仅当] [n] [∈] [N{0}] [是质数。]

[2.3] [考虑如下定义的] 3 [×] 3 [矩阵集合] [G] [:]

G = {[[1 x z], [0 1 y], [0 0 1]] | x, y, z ∈ R}

[我们定义] [·] [为标准矩阵乘法。] [(][G][,] [·][)] [是一个群吗?如果是,它是阿贝尔的吗?证明你的答案。]

[2.4] [如果可能,计算以下矩阵乘积:]

[Draft (2023-10-18) of “Mathematics for Machine Learning”. Feedback:] [https://mml-book.com.] [Exercises] [[65]]

[a.] [[1 2], [7 8]] [[1 1 0], [4 5 0], [1 1 1]]

[b.] [[1 2 3], [4 5 6], [7 8 9]] [[1 1 0], [0 1 1], [1 0 1]]

[c.] [[1 1 0], [0 1 1], [1 0 1]] [[1 2 3], [4 5 6], [7 8 9]]

[d.] [[1 2 1], [4 1 −1]] [[0 3], [1 −1], [−4 2]]

[e.] [[0 3], [1 −1], [−4 2]] [[1 2 1], [4 1 −1]]

[2.5] [求下列非齐次线性系统] [Ax] [=] [b] [中] x [的所有解的集合] [S] [,其中] [A] [和] [b] [定义如下:]

[a.] A = [[1 1 −1 −1], [2 5 −7 −5], [2 −1 1 3], [5 2 −4 2]], b = [1, [−2], [4], 6]

[b.] A = [[1 −1 0 0 1], [1 1 0 −3 0], [2 −1 0 1 −1], [−1 2 0 −2 −1]], b = [3, 6, [5], [−1]]

[2.6] [使用高斯消元法,求非齐次方程组] [Ax] [=] [b] [的所有解,其中]

A = [[0 1 0 0 1], [0 0 0 1 1], [0 1 0 0 0]], b = [[0], [2], [−1], 1]

[©2023 M. P. Deisenroth, A. A. Faisal, C. S. Ong. Published by Cambridge University Press (2020).]

[66] [[Linear Algebra]]

x₁

2.7 求解方程组在 x ∈ R 中的所有解:

2Ax = 12x

其中

A = [6 4 3] [6 0 9] [0 8 0]

且 ∑(i=1 to 3) P_i x_i = 1。

2.8 如果可能,求以下矩阵的逆矩阵:

A = [2 3 4] [3 4 5] [4 5 6]

A = [1 0 1 0] [0 1 1 0] [1 1 0 1] [1 1 1 0]

2.9 以下哪些集合是 R³ 的子空间?

2.10 以下向量集合是否线性无关?

2.11 将 y = 1 [-2] [5]

写成以下向量的线性组合:

x₁ = 1 x₂ = 1 x₃ = [2] 1 [2] [-1] 1 3 1

草稿(2023-10-18)《机器学习数学》。反馈:https://mml-book.com。练习 [67]

2.12 考虑 R⁴ 的两个子空间:

U₁ = span{1, [2], [-1]} U₂ = span{[-1], [2], [-3]} [2] [-1] [-1] 1 [-2] 6 [-3] [0] [-1] [-2] [2] [-2] 1 [-1] 1 1 [0] [-1]

求 U₁ ∩ U₂ 的基。

2.13 考虑两个子空间 U₁ 和 U₂,其中 U₁ 是齐次方程组 A₁x = 0 的解空间,U₂ 是齐次方程组 A₂x = 0 的解空间,其中:

A₁ = [1 0 1 3 -3 0] A₂ = [1 -2 -1 1 2 3] [2 1 3 7 -5 2] [1 0 1 3 -1 2]

2.14 考虑两个子空间 U₁ 和 U₂,其中 U₁ 由 A₁ 的列张成,U₂ 由 A₂ 的列张成,其中:

A₁ = [1 0 1 3 -3 0] A₂ = [1 -2 -1 1 2 3] [2 1 3 7 -5 2] [1 0 1 3 -1 2]

2.15 设 F = {(x, y, z) ∈ R³ | x + y - z = 0} 和 G = {(a - b, a + b, a - 3b) | a, b ∈ R}。

2.16 以下映射是否为线性映射?

Φ : L¹([a, b]) → R f ↦ Φ(f) = ∫ᵇₐ f(x)dx

其中 L¹([a, b]) 表示在 [a, b] 上可积函数的集合。

其中对于 k ≥ 1,Cᵏ 表示 k 次连续可微函数的集合,C⁰ 表示连续函数的集合。

©2023 M. P. Deisenroth, A. A. Faisal, C. S. Ong. 由 Cambridge University Press 出版 (2020)。

68 [线性代数]

Φ : R → R x ↦ Φ(x) = cos(x)

Φ : R³ → R² x ↦ [1 2 3] x [1 4 3]

设 θ ∈ [0, 2π] 且

Φ : R² → R² x ↦ [cos(θ) sin(θ) ] x [-sin(θ) cos(θ)]

2.17 考虑线性映射

Φ : R³ → R⁴

Φ([x₁]) = [3x₁ + 2x₂ + x₃] [x₂] [x₁ + x₂ + x₃] [x₃] [x₁ + 3x₂ - x₃] [2x₁ + 3x₂ + x₃]

求变换矩阵 A_Φ。求 rk(A_Φ)。计算 Φ 的核(kernel)和像(image)。dim(ker(Φ)) 和 dim(Im(Φ)) 是什么?

2.18 设 E 是向量空间。设 f 和 g 是 E 上的两个自同构(automorphism),使得 f ∘ g = id_E(即,f ∘ g 是恒等映射 id_E)。证明 ker(f) = ker(g ∘ f),Im(g) = Im(g ∘ f) 且 ker(f) ∩ Im(g) = {0_E}。

2.19 考虑自同态 Φ : R³ → R³,其变换矩阵(相对于 R³ 中的标准基)是

A_Φ = [1 1 0] [1 -1 0] [1 1 1]

的变换矩阵 Ã_Φ。

即执行向基变换向新基[B]。

2.20 让我们考虑R²的向量b₁’, b₂’, b₁, b₂,在R²的标准基中表示为:

b₁’ = [2, 1]ᵀ, b₂’ = [-1, 2]ᵀ, b₁ = [2, -1]ᵀ, b₂ = [1, 1]ᵀ

并且让我们定义两个有序基B’ = (b₁’, b₂’)和B = (b₁, b₂),它们都是R²的基。

c₁ = [1, 2, -1]ᵀ, c₂ = [0, -1, 2]ᵀ, c₃ = [1, 0, -1]ᵀ

并且我们定义C = (c₁, c₂, c₃)。

证明C是R³的基,例如通过使用行列式(见第4.1节)。

让我们称C’ = (c₁’, c₂’, c₃’)为R³的标准基。确定矩阵P₂C’,该矩阵执行从C’到C的基变换。

Φ(b₁ + b₂) = c₂ + c₃ Φ(b₁ - b₂) = 2c₁ - c₂ + 3c₃

其中B = (b₁, b₂)和C = (c₁, c₂, c₃)分别是R²和R³的有序基。

确定Φ关于有序基B和C的变换矩阵AΦ。

确定A’,即Φ关于基B’和C’的变换矩阵。

让我们考虑向量x ∈ R²,其在B’中的坐标为[2, 3]ᵀ。

换句话说,x = 2b₁’ + 3b₂’。

计算x在B中的坐标。

基于此,计算Φ(x)在C中表示的坐标。

然后,用c₁’, c₂’, c₃’表示Φ(x)。

使用x在B’中的表示和矩阵A’直接找到这个结果。

在第2章中,我们在一般但抽象的层面研究了向量、向量空间和线性映射。在本章中,我们将为所有这些概念添加一些几何解释和直觉。特别地,我们将研究几何向量并计算它们的长度和距离,或两个向量之间的角度。为了能够做到这一点,我们为向量空间配备一个内积(inner product),该内积诱导向量空间的几何结构。内积及其对应的范数(norms)和度量(metrics)捕获了相似性和距离的直观概念,我们在第12章中使用这些概念来开发支持向量机(support vector machine)。然后,我们将使用向量长度和向量间角度的概念来讨论正交投影(orthogonal projections),这在我们讨论第10章的主成分分析(principal component analysis)和第9章通过最大似然估计的回归时将起核心作用。图3.1概述了本章概念之间的关系以及它们与本书其他章节的联系。

图3.1 本章介绍的概念的思维导图,以及它们在本书其他部分中的使用时机。

内积(Inner product)

诱导

范数(Norm) → 分类(Classification) → 第12章

长度(Lengths) → 正交投影(Orthogonal projection) → 角度(Angles) → 旋转(Rotations)

第9章 → 第4章 → 第10章回归(Regression) → 矩阵分解(Matrix decomposition) → 降维(Dimensionality reduction)

当我们考虑几何向量,即从原点开始的有向线段时,直觉上向量的长度就是这个有向线段的”端点”到原点的距离。在下面的内容中,我们将使用范数(norm)的概念来讨论向量长度的概念。

定义3.1(范数)。向量空间V上的范数是一个函数

∥ · ∥ : V → ℝ, (3.1) x ↦ ∥x∥, (3.2)

它为每个向量x分配其长度 ∥x∥ ∈ ℝ,使得对于所有λ ∈ ℝ和x, y ∈ V,以下条件成立:

绝对齐次性:∥λx∥ = |λ|∥x∥

三角不等式:∥x + y∥ ⩽ ∥x∥ + ∥y∥

正定性:∥x∥ ⩾ 0且∥x∥ = 0 ⇔ x = 0

在几何术语中,三角不等式表明对于任何三角形,任意两边长度之和必须大于或等于

图3.2 三角不等式。

图3.3 对于不同的范数,红线表示范数为1的向量集合。左:Manhattan范数;右:欧几里得距离。

∥x∥₁ = 1 ∥x∥₂ = 1

到剩余边的长度;参见图[3.2]的说明。

定义[3.1]是基于一般向量空间V(第[2.4]节),但在本书中我们只考虑n维向量空间R^n。回忆对于向量x ∈ R^n,我们使用下标表示向量的元素,即x_i是向量x的第i个元素。

例3.1(曼哈顿范数)

R^n上的曼哈顿范数定义为对于x ∈ R^n:

‖x‖₁ := Σ|x_i|, (3.3)

其中|·|是绝对值。图[3.3]的左面板显示了所有满足‖x‖₁ = 1的向量x ∈ R²。曼哈顿范数也称为ℓ₁范数。

例3.2(欧几里得范数)

x ∈ R^n的欧几里得范数定义为:

‖x‖₂ := √(Σx_i²) = √(x^T x) (3.4)

并计算x到原点的欧几里得距离。图[3.3]的右面板显示了所有满足‖x‖₂ = 1的向量x ∈ R²。欧几里得范数也称为ℓ₂范数。

注意。 在本书中,如果没有特别说明,我们将默认使用欧几里得范数[(3.4)]。 ♢

内积允许引入直观的几何概念,如向量的长度以及两个向量之间的角度或距离。内积的主要目的是确定向量之间是否正交。

我们可能已经熟悉一种特殊类型的内积,即R^n中的标量积/点积,其定义为:

x^T y = Σx_i y_i. (3.5)

在本书中我们将此特定内积称为点积。然而,内积是具有特定性质的更一般概念,我们现在将介绍这些概念。

回忆第[2.7]节的线性映射,我们可以重新安排关于加法和标量乘法的映射。双线性映射Ω是具有两个参数的映射,并且在每个参数中都是线性的,即当我们考虑向量空间V时,对于所有x, y, z ∈ V, λ, ψ ∈ R成立:

Ω(λx + ψy, z) = λΩ(x, z) + ψΩ(y, z) [(3.6)] Ω(x, λy + ψz) = λΩ(x, y) + ψΩ(x, z). [(3.7)]

这里,[(3.6)]断言Ω在第一个参数中是线性的,[(3.7)]断言Ω在第二个参数中是线性的(另见[(2.87)])。

定义3.2. 设V是向量空间,Ω : V × V → R是将两个向量映射到实数的双线性映射。那么

Ω称为对称的,如果对于所有x, y ∈ V,Ω(x, y) = Ω(y, x),即参数的顺序无关紧要。

Ω称为正定的,如果

∀x ∈ V {0} : Ω(x, x) > 0, Ω(0, 0) = 0. (3.8)

定义3.3. 设V是向量空间,Ω : V × V → R是将两个向量映射到实数的双线性映射。那么

正定的对称双线性映射Ω : V × V → R称为V上的内积。我们通常写作⟨x, y⟩而不是Ω(x, y)。

对(V, ⟨·, ·⟩)称为内积空间或(实)带内积的向量空间。如果我们使用[(3.5)]中定义的点积,我们称(V, ⟨·, ·⟩)为欧几里得向量空间。

在本书中我们将这些空间称为内积空间。

例3.3(非点积的内积) 考虑V = R²。如果我们定义

⟨x, y⟩ := x₁y₁ - (x₁y₂ + x₂y₁) + 2x₂y₂ (3.9)

那么⟨·, ·⟩是内积但不同于点积。证明将作为练习。

对称正定矩阵在机器学习中起重要作用,它们通过内积定义。在第[4.3]节中,我们将在矩阵分解的背景下回到对称正定矩阵。对称正半定矩阵的概念是核函数定义的关键(第[12.4]节)。

考虑具有内积⟨·, ·⟩ : V × V → R(见定义[3.3])的n维向量空间V和V的有序基B = (b₁, …, bₙ)。回忆第[2.6.1]节,任何向量x, y ∈ V都可以写成基向量的线性组合,使得x = Σψᵢbᵢ ∈ V和y = Σλⱼbⱼ ∈ V,其中ψᵢ, λⱼ ∈ R为合适的参数。由于内积的双线性性,对于所有x, y ∈ V成立:

⟨x, y⟩ = ⟨Σψᵢbᵢ, Σλⱼbⱼ⟩ = ΣΣψᵢ⟨bᵢ, bⱼ⟩λⱼ = x̂ᵀAŷ, (3.10)

其中Aᵢⱼ := ⟨bᵢ, bⱼ⟩,x̂, ŷ是x和y相对于基B的坐标。这意味着内积⟨·, ·⟩通过A唯一确定。内积的对称性也意味着A是对称的。此外,内积的正定性意味着

∀x ∈ V {0} : x̂ᵀAx̂ > 0. (3.11)

定义3.4(对称正定矩阵)。 满足[(3.11)]的对称矩阵A ∈ R^(n×n)称为对称正定,或

[正定] 只是正定的。如果在 [(3.11)] 中只有 ⩾ 成立,那么 A 被称为对称,[正定] 正半定。

[对称,正]

[半定]

例 3.4 (对称正定矩阵)

考虑矩阵

9 6 9 6 A₁ = , A₂ = . (3.12) 6 5 6 3

A₁ 是正定的,因为它是对称的且

9 6 x₁ x⊤A₁x = [x₁ x₂] (3.13a) 6 5 x₂

= 9x₁² + 12x₁x₂ + 5x₂² = (3x₁ + 2x₂)² + x₂² > 0 (3.13b)

对于所有 x ∈ V {0}。相比之下,A₂ 是对称的但不是正定的,因为 x⊤A₂x = 9x₁² + 12x₁x₂ + 3x₂² = (3x₁ + 2x₂)² - x₂²,可能小于 0,例如,对于 x = [2, -3]⊤。

如果 A ∈ R^(n×n) 是对称正定的,那么

⟨x, y⟩ = x̂⊤Aŷ (3.14)

定义了关于有序基 B 的内积,其中 x̂ 和 ŷ 是 x, y ∈ V 关于 B 的坐标表示。

定理 3.5. 对于实值有限维向量空间 V 和 V 的有序基 B,⟨·, ·⟩ : V × V → R 是内积当且仅当存在对称正定矩阵 A ∈ R^(n×n) 使得

⟨x, y⟩ = x̂⊤Aŷ . (3.15)

如果 A ∈ R^(n×n) 是对称正定的,则有以下性质:

A 的零空间(kernel)只包含 0,因为对所有 x ≠ 0 有 x⊤Ax > 0。这意味着如果 x ≠ 0 则 Ax ≠ 0。A 的对角元素 aᵢᵢ 都是正的,因为 aᵢᵢ = eᵢ⊤Aeᵢ > 0,其中 eᵢ 是 Rⁿ 中标准基的第 i 个向量。

[Draft (2023-10-18) of “Mathematics for Machine Learning”. Feedback: https://mml-book.com.] 3.3 长度和距离 75

在第 3.1 节中,我们已经讨论了可以用来计算向量长度的范数。内积和范数密切相关,任何内积都自然地诱导出一个范数 [内积诱导范数。]

∥x∥ := √⟨x, x⟩ (3.16)

这样我们可以使用内积来计算向量的长度。然而,并非每个范数都由内积诱导。Manhattan 范数 [(3.3)] 是一个没有对应内积的范数的例子。在下面,我们将重点关注由内积诱导的范数,并引入几何概念,如长度、距离和角度。

备注 (Cauchy-Schwarz 不等式)。对于内积向量空间 (V, ⟨·, ·⟩),诱导范数 ∥ · ∥ 满足 Cauchy-Schwarz 不等式 [Cauchy-Schwarz 不等式]

|⟨x, y⟩| ⩽ ∥x∥∥y∥ . (3.17)

♢

例 3.5 (使用内积计算向量长度)

在几何学中,我们经常关心向量的长度。现在我们可以使用内积通过 [(3.16)] 来计算它们。让我们取 x = [1, 1]⊤ ∈ R²。如果我们使用点积作为内积,通过 [(3.16)] 我们得到

∥x∥ = √(x⊤x) = √(1² + 1²) = √2 (3.18)

作为 x 的长度。现在让我们选择一个不同的内积:

⟨x, y⟩ := x⊤[2 -1; -1 1]y = 2x₁y₁ - (x₁y₂ + x₂y₁) + x₂y₂ . (3.19)

如果我们计算向量的范数,那么当 x₁ 和 x₂ 符号相同(且 x₁x₂ > 0)时,这个内积返回比点积更小的值;否则,它返回比点积更大的值。使用这个内积,我们得到

⟨x, x⟩ = 2x₁² - 2x₁x₂ + x₂² = 2·1 - 2·1·1 + 1 = 1 ⇒ ∥x∥ = 1 (3.20)

所以使用这个内积时 x 比使用点积时更”短”。

定义 3.6 (距离和度量)。考虑内积空间 (V, ⟨·, ·⟩)。那么

d(x, y) := ∥x - y∥ = √⟨x - y, x - y⟩ (3.21)

称为 x, y ∈ V 之间的距离。如果我们使用点积作为内积,那么距离称为欧几里得距离。[距离] [欧几里得距离]

[©2023 M. P. Deisenroth, A. A. Faisal, C. S. Ong. Published by Cambridge University Press (2020).] 76 [解析几何]

映射

d : V × V → R (3.22) (x, y) ↦ d(x, y) (3.23)

称为度量。[度量]

备注。 与向量的长度类似,向量之间的距离不需要内积:范数就足够了。如果我们有一个由内积诱导的范数,距离可能会根据内积的选择而变化。♢

度量 d 满足以下性质:

备注。 乍一看,内积和度量的性质列表非常相似。然而,通过比较定义 3.3 和定义 3.6,我们观察到 ⟨x, y⟩ 和 d(x, y) 的行为方向相反。非常相似的 x 和 y 会导致内积的大值和度量的小值。♢

图 3.4 [当限制到 [0, π] 时,f(ω) = cos(ω) 返回区间 [-1, 1] 中的唯一数。] 除了能够定义向量的长度以及两个向量之间的距离外,内积还通过定义两个向量之间的角度 ω 来捕获向量空间的几何性质。我们使用 Cauchy-Schwarz 不等式 [(3.17)] 在内积空间中定义向量 x, y 之间的角度 ω,这个概念与我们在 R¹、R² 和 R³ 中的直觉一致。假设 x ≠ 0, y ≠ 0。那么

-1 ⩽ ⟨x, y⟩/(∥x∥∥y∥) ⩽ 1 . (3.24)

[cos(ω)]

[-1] [0] [π/2] [π] [0] 1

因此,存在唯一的 ω ∈ [0, π],如图3.4所示,其中

cos ω = ⟨x, y⟩ / (∥x∥ ∥y∥) (3.25)

数值ω是向量x和y之间的角度。直观地说,两个向量之间的角度告诉我们它们的方向有多相似。例如,使用点积,x和y = 4x之间的角度(即y是x的缩放版本)为0:它们的方向相同。

例3.6(向量间的角度)

让我们计算x = [1, 1]⊤ ∈ R²和y = [1, 2]⊤ ∈ R²之间的角度;参见图3.5,其中我们使用点积作为内积。然后我们得到

cos ω = ⟨x, y⟩ / √(⟨x, x⟩⟨y, y⟩) = (x⊤y) / √(x⊤x y⊤y) = 3/√10 (3.26)

两个向量之间的角度是arccos(3/√10) ≈ 0.32 rad,对应约18°。

内积的一个关键特征是它还允许我们描述正交向量的特征。

定义3.7(正交性)。如果且仅当⟨x, y⟩ = 0时,两个向量x和y是正交的,我们记作x ⊥ y。如果另外∥x∥ = 1 = ∥y∥,即这些向量是单位向量,那么x和y是标准正交的。

这个定义的一个含义是零向量与向量空间中的每个向量都正交。

备注。 正交性是垂直概念对不一定是点积的双线性形式的推广。在我们的上下文中,从几何角度来看,我们可以将正交向量视为相对于特定内积成直角。♢

例3.7(正交向量)

考虑两个向量x = [1, 1]⊤,y = [-1, 1]⊤ ∈ R²;参见图3.6。我们有兴趣使用两种不同的内积确定它们之间的角度ω。使用点积作为内积得到x和y之间的角度ω为90°,使得x ⊥ y。但是,如果我们选择内积

⟨x, y⟩ = x⊤[2 0; 0 1]y (3.27)

我们得到x和y之间的角度ω由下式给出

cos ω = ⟨x, y⟩ / (∥x∥∥y∥) = -1/3 ⇒ ω ≈ 1.91 rad ≈ 109.5° (3.28)

并且x和y不正交。因此,相对于一个内积正交的向量不一定相对于不同的内积正交。

定义3.8(正交矩阵)。方阵A ∈ Rⁿˣⁿ是正交矩阵当且仅当其列是标准正交的,使得

AA⊤ = I = A⊤A (3.29)

这意味着

A⁻¹ = A⊤ (3.30)

即逆矩阵通过简单地转置矩阵获得。

正交矩阵的变换是特殊的,因为当使用正交矩阵A变换向量x时,向量x的长度不会改变。对于点积,我们得到

∥Ax∥² = (Ax)⊤(Ax) = x⊤A⊤Ax = x⊤Ix = x⊤x = ∥x∥² (3.31)

此外,任意两个向量x、y之间的角度(由它们的内积测量)在使用正交矩阵A变换它们时也保持不变。假设点积作为内积,图像Ax和Ay的角度由下式给出

cos ω = (Ax)⊤(Ay) / (∥Ax∥∥Ay∥) = (x⊤A⊤Ay) / √((x⊤A⊤Ax)(y⊤A⊤Ay)) = (x⊤y) / (∥x∥∥y∥) (3.32)

这给出了x和y之间的确切角度。这意味着具有A⊤ = A⁻¹的正交矩阵保持角度和距离。事实上,正交矩阵定义了旋转变换(可能带有翻转)。在第3.9节中,我们将讨论关于旋转的更多细节。

在第2.6.1节中,我们描述了基向量的性质,发现在n维向量空间中,我们需要n个基向量,即n个线性无关的向量。在第3.3节和第3.4节中,我们使用内积计算向量的长度和向量之间的角度。在下面,我们将讨论基向量彼此正交且每个基向量的长度为1的特殊情况。我们将这样的基称为标准正交基。

让我们更正式地介绍这一点。

定义3.9(标准正交基)。考虑n维向量空间V和V的基{b₁, …, bₙ}。如果

⟨bᵢ, bⱼ⟩ = 0 对于 i ≠ j (3.33) ⟨bᵢ, bᵢ⟩ = 1 (3.34)

对于所有i, j = 1, …, n成立,那么该基被称为标准正交基(ONB)。

如果只满足(3.33),那么该基被称为正交基。注意(3.34)意味着每个基向量的长度/范数为1。

回顾第[2.6.1]节,我们可以使用高斯消元法来找到由一组向量张成的向量空间的基。假设我们给定一组非正交且未规范化的基向量{˜b1, . . . , ˜b[n]}。我们将它们连接成矩阵˜B = [˜b1, . . . , ˜b[n]],并对增广矩阵(第[2.3.2]节)[˜B⊤ ˜B | ˜B]应用高斯消元法来获得标准正交基。这种迭代构建标准正交基{b1, . . . , b[n]}的构造性方法称为Gram-Schmidt过程 [(Strang, 2003).]

欧几里得向量空间R^n的标准基是一个标准正交基,其中内积是向量的点积。

在R^2中,向量

b1 = √(1/2)[1, 1]⊤, b[2] = √(1/2)[1, -1]⊤ (3.35)

构成标准正交基,因为b1⊤b[2] = 0且∥b1∥ = 1 = ∥b[2]∥。

我们将在第[12]章和第[10]章中利用标准正交基的概念,当我们讨论支持向量机和主成分分析时。{#calibre_link-531 .calibre3}

定义了正交性之后,我们现在来看彼此正交的向量空间。这在第[10]章中将起到重要作用,当我们从几何角度讨论线性降维时。

考虑一个D维向量空间V和一个M维子空间U ⊆ V。那么它的正交补U⊥是V的一个(D−M)维子空间,包含V中与U中每个向量都正交的所有向量。此外,U ∩ U⊥ = {0},因此V中的任何向量x都可以

[©2023 M. P. Deisenroth, A. A. Faisal, C. S. Ong. Published by Cambridge University Press (2020).]

[图3.7] [三维向量空间中的平面U可以用其法向量来描述,该法向量张成其正交补U⊥。]

被唯一分解为

x = Σ(m=1 to M) λm bm + Σ(j=1 to D-M) ψj b⊥j, λm, ψj ∈ R, (3.36)

其中(b1, . . . , bM)是U的基,(b⊥1, . . . , b⊥D-M)是U⊥的基。

因此,正交补也可以用来描述三维向量空间中的平面U(二维子空间)。更具体地说,与平面U正交且∥w∥ = 1的向量w是U⊥的基向量。图[3.7]说明了这种设置。所有与w正交的向量必须(根据构造)位于平面U中。向量w称为U的法向量。

一般来说,正交补可以用来描述n维向量空间和仿射空间中的超平面。

到目前为止,我们研究了内积的性质来计算长度、角度和距离。我们专注于有限维向量的内积。接下来,我们将看一个不同类型向量内积的例子:函数的内积。

我们迄今讨论的内积是为具有有限条目数的向量定义的。我们可以将向量x ∈ R^n看作具有n个函数值的函数。内积的概念可以推广到具有无限条目数的向量(可数无限)以及连续值函数(不可数无限)。然后,对向量各个分量的求和(例如见方程[(3.5)])转变为积分。

两个函数u : R → R和v : R → R的内积可以定义为定积分

⟨u, v⟩ := ∫[a to b] u(x)v(x)dx (3.37)

对于下限和上限分别为a, b < ∞。与我们通常的内积一样,我们可以通过内积来定义范数和正交性。如果[(3.37)]计算结果为0,则函数u和v是正交的。为了使前述内积在数学上精确,我们需要处理测度和积分的定义,这导致Hilbert空间的定义。此外,与有限维向量上的内积不同,函数上的内积可能发散(具有无限值)。所有这些都需要深入实分析和函数分析的一些更复杂的细节,这些我们在本书中不涉及。

如果我们选择u = sin(x)和v = cos(x),则[(3.37)]的被积函数f(x) = u(x)v(x)如图[3.8]所示。我们看到这个函数是奇函数,即f(−x) = −f(x)。因此,在限制a = −π, b = π下该乘积的积分计算结果为0。因此,sin和cos是正交函数。

[图3.8] [f(x) = sin(x)cos(x).]

注释。 还成立的是函数集合

{1, cos(x), cos(2x), cos(3x), . . .} (3.38)

如果我们从−π积分到π,是正交的,即任何一对函数彼此正交。[(3.38)]中的函数集合张成在[−π, π)上偶函数和周期函数的一个大子空间,将函数投影到这个子空间是Fourier级数背后的基本思想。 ♢

在第[6.4.6]节中,我们将看一个第二种非常规内积类型:随机变量的内积。

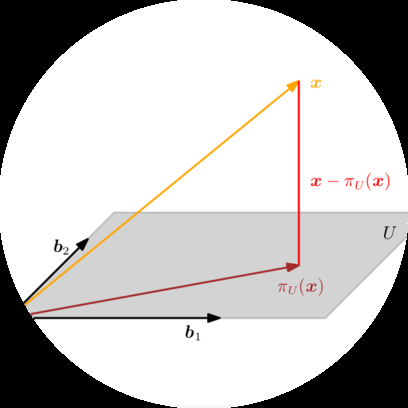

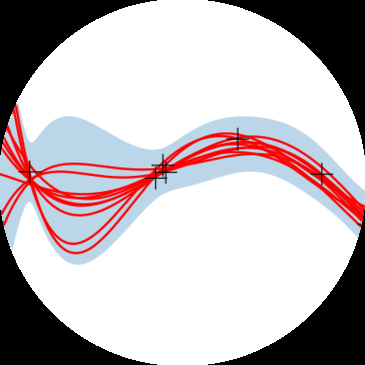

投影是线性变换的一个重要类别(除了旋转和反射),在图形学、编码理论、统计学和机器学习中发挥重要作用。在机器学习中,我们经常处理高维数据。高维数据通常很难分析或可视化。然而,高维数据经常具有这样的性质:只有少数几个维度包含大部分信息,而大多数其他维度对于描述数据的关键属性并不重要。当我们压缩或可视化高维数据时,我们将丢失信息。为了最小化这种压缩损失,我们理想情况下要找到数据中最具信息性的维度。正如第1章中讨论的,数据可以表示为向量,在本章中,我们将讨论数据压缩的一些基本工具。更具体地说,我们可以将原始高维数据投影到低维特征空间,并在这个低维空间中工作,以更多地了解数据集并提取相关模式。例如,机器学习算法,如Pearson (1901)和Hotelling (1933)的主成分分析(PCA)以及深度神经网络(例如,深度自编码器(Deng et al., 2010)),大量利用了降维的思想。在接下来的内容中,我们将专注于正交投影,我们将在第10章中用于线性降维,在第12章中用于分类。甚至我们在第9章中讨论的线性回归,也可以使用正交投影来解释。对于给定的低维子空间,高维数据的正交投影保留尽可能多的信息,并最小化原始数据与相应投影之间的差异/误差。图3.9给出了这种正交投影的示例。在我们详细说明如何获得这些投影之前,让我们定义什么是投影。

定义3.10(投影)。设V是一个向量空间,U ⊆ V是V的子空间。线性映射π : V → U被称为投影,如果 π² = π ◦ π = π。

由于线性映射可以用变换矩阵表示(参见第2.7节),前面的定义同样适用于一种特殊的变换矩阵,即投影矩阵P_π,它具有P²_π = P_π的性质。

接下来,我们将推导内积空间(R^n, ⟨·, ·⟩)中向量到子空间的正交投影。我们将从一维子空间开始,这也被称为直线。如果没有另外提及,我们假设点积⟨x, y⟩ = x^T y作为内积。

假设我们给定一条通过原点的直线(一维子空间),其基向量为b ∈ R^n。直线是由b张成的一维子空间U ⊆ R^n。当我们将x ∈ R^n投影到U时,我们寻找最接近x的向量π_U(x) ∈ U。使用几何论证,让我们描述投影π_U(x)的一些性质(图3.10(a)作为说明):

投影π_U(x)最接近x,其中”最接近”意味着距离∥x − π_U(x)∥是最小的。由此可知,从π_U(x)到x的线段π_U(x) − x垂直于U,因此也垂直于U的基向量b。正交性条件产生⟨π_U(x) − x, b⟩ = 0,因为向量之间的角度通过内积定义。

x到U的投影π_U(x)必须是U的元素,因此必须是张成U的基向量b的倍数。因此,π_U(x) = λb,对于某个λ ∈ R。

在接下来的三个步骤中,我们确定坐标λ、投影π_U(x) ∈ U,以及将任何x ∈ R^n映射到U的投影矩阵P_π:

寻找坐标λ。正交性条件产生 ⟨x − π_U(x), b⟩ = 0 ⇐⇒ ⟨x − λb, b⟩ = 0 (3.39)

我们现在可以利用内积的双线性性,得到 ⟨x, b⟩ − λ⟨b, b⟩ = 0 ⇐⇒ λ = ⟨x, b⟩/⟨b, b⟩ = ⟨b, x⟩/∥b∥² (3.40)

在最后一步中,我们利用了内积是对称的这一事实。如果我们选择⟨·, ·⟩为点积,我们得到 λ = b^T x/b^T b = b^T x/∥b∥² (3.41)

如果∥b∥ = 1,那么投影的坐标λ由b^T x给出。

π[U] (x) = λb = b = b , (3.42) ∥ b ∥ ∥ b ∥

其中最后的等式仅对点积成立。我们也可以通过定义3.1计算π[U] (x)的长度:

∥π[U] (x)∥ = ∥λb∥ = |λ| ∥b∥ . (3.43)

因此,我们的投影长度是|λ|倍的b的长度。这也提供了直观理解:λ是π[U] (x)相对于张成一维子空间U的基向量b的坐标。

如果我们使用点积作为内积,得到

∥π[U] (x)∥ = ∥b∥ = |cos ω| ∥x∥ ∥b∥ = |cos ω| ∥x∥ . b ∥b∥

这里,ω是x和b之间的夹角。这个方程在三角学中应该很熟悉:如果∥x∥ = 1,那么x位于单位圆上。水平轴是一维子空间,因此投影到由b张成的水平轴上正好是cos ω,对应向量π[U] (x) = |cos ω|的长度。图3.10(b)给出了说明。

π[U] (x) = λb = bλ = b = x , (3.45) ∥ b ∥² ∥b∥²

我们立即看到

P[π] = bb^⊤/∥b∥² . (3.46)

投影矩阵总是对称的。注意bb^⊤(因此P[π])是对称矩阵(秩为1),而∥b∥² = ⟨b, b⟩是标量。

投影矩阵P[π]将任何向量x ∈ R^n投影到通过原点且方向为b的直线上(等价地,由b张成的子空间U)。

备注。 投影πU ∈ R^n仍然是n维向量而不是标量。然而,如果我们想用张成子空间U的基向量b来表示投影,我们不再需要n个坐标来表示投影,只需要一个:λ。♢

图3.11 投影到二维子空间U,基为b₁,b₂。x ∈ R³到U的投影πU可以表示为b₁,b₂的线性组合,位移向量x - πU与b₁和b₂都正交。

例3.10 (投影到直线)

找到投影矩阵P[π],投影到通过原点由b = [1 2 2]^⊤张成的直线。b是一维子空间(通过原点的直线)的方向和基。

利用(3.46),我们得到

P[π] = bb⊤/b⊤b = (1/9)[1 2 2][1 2 2] = (1/9)[1 2 2; 2 4 4; 2 4 4] (3.47)

现在选择特定的x,看它是否位于由b张成的子空间中。对于x = [1 1 1]^⊤,投影是

πU = P[π]x = (1/9)[1 2 2; 2 4 4; 2 4 4][1; 1; 1] = (1/9)[5; 10; 10] ∈ span[2] . (3.48)

注意P[π]应用于πU不会改变任何东西,即P[π]πU = πU。这是预期的,因为根据定义3.10,我们知道投影矩阵P[π]满足P²[π]x = P[π]x对所有x成立。

备注。 利用第4章的结果,我们可以证明πU是P[π]的特征向量,对应的特征值是1。♢

如果U由一组张成向量给出,在不是基的情况下,确保在继续之前确定基b₁,…,b[m]。

接下来,我们考虑向量x ∈ R^n到低维子空间U ⊆ R^n的正交投影,其中dim(U) = m ≥ 1。图3.11给出了说明。

假设(b₁,…,b[m])是U的有序基。任何到U的投影πU必然是U的元素。因此,它们可以表示为U的基向量b₁,…,b[m]的线性组合,使得πU = Σᵢ₌₁ᵐ λᵢbᵢ。

基向量构成B ∈ R^(n×m)的列,其中B = [b₁,…,b[m]]。

如同1D情况,我们遵循三步程序来找到投影πU和投影矩阵P[π]:

πU = Σᵢ₌₁ᵐ λᵢbᵢ = Bλ , (3.49)

B = [b₁,…,b[m]] ∈ R^(n×m) , λ = [λ₁,…,λ[m]]^⊤ ∈ R^m , (3.50)

最接近x ∈ R^n。如同1D情况,“最接近”意味着”最小距离”,这意味着连接πU ∈ U和x ∈ R^n的向量必须与U的所有基向量正交。因此,我们得到m个同时条件(假设点积作为内积)

⟨b₁, x - πU⟩ = b₁^⊤(x - πU) = 0 (3.51)

…

⟨b[m], x - πU⟩ = b[m]^⊤(x - πU) = 0 (3.52)

利用πU = Bλ,可写成

b₁^⊤(x - Bλ) = 0 (3.53)

…

b[m]^⊤(x - Bλ) = 0 (3.54)

从而得到齐次线性方程组

b₁^⊤; …; b[m]^⊤ = B^⊤(x - Bλ) = 0 (3.55)

⇐⇒ B^⊤Bλ = B^⊤x . (3.56)

最后的表达式称为正规方程(normal equation)。由于b₁,…,b[m]是U的基,因此线性无关,B^⊤B ∈ R^(m×m)是正则的且可逆。这允许我们求解系数/坐标

λ = (B⊤B){-1}B^⊤x. (3.57)

伪逆矩阵 矩阵(B⊤B){-1}B⊤也被称为B的伪逆矩阵(pseudo-inverse),它可以为非方形矩阵B计算。它只要求B⊤B是正定的,当B是满秩的时候就是这种情况。在实际应用中(例如,线性回归),我们经常向B^⊤B添加一个”扰动项”εI来保证增强的数值稳定性和正定性。这个”岭”可以通过贝叶斯推理严格推导得出。详见第9章。

π_U(x) = B(B⊤B){-1}B^⊤x. (3.58)

P_π = B(B⊤B){-1}B^⊤. (3.59)

注释。 投影到一般子空间的解包括1D情况作为特例:如果dim(U) = 1,那么B^⊤B ∈ R是一个标量,我们可以将(3.59)中的投影矩阵P_π = B(B⊤B){-1}B^⊤重写为

P_π = BB⊤/(B⊤B),这正是(3.46)中的投影矩阵。♢

对于子空间U = span[⎡1⎤ ⎡0⎤] ⊆ R³和x = ⎡6⎤ ∈ R³,找出x关于子空间U的坐标λ、投影点π_U(x)和投影矩阵P_π。 ⎢1⎥ ⎢1⎥ ⎢0⎥ ⎣1⎦ ⎣2⎦ ⎣0⎦

首先,我们看到U的生成集是一个基(线性无关)并将U的基向量写入矩阵B = ⎡1 0⎤ ⎢1 1⎥ ⎣1 2⎦

其次,我们计算矩阵B⊤B和向量B⊤x如下

B^⊤B = ⎡1 1 1⎤ ⎡1 0⎤ = ⎡3 3⎤, B^⊤x = ⎡1 1 1⎤ ⎡6⎤ = ⎡6⎤ (3.60) ⎣0 1 2⎦ ⎢1 1⎥ ⎣3 5⎦ ⎣0 1 2⎦ ⎢0⎥ ⎣0⎦ ⎣1 2⎦ ⎣0⎦

第三,我们求解正规方程B^⊤Bλ = B^⊤x来找到λ:

⎡3 3⎤ ⎡λ₁⎤ = ⎡6⎤ ⟺ λ = ⎡ 5⎤ (3.61) ⎣3 5⎦ ⎣λ₂⎦ ⎣0⎦ ⎣-3⎦

第四,x到U的投影π_U(x),也就是到B的列空间的投影,可以直接通过以下方式计算

π_U(x) = Bλ = ⎡ 5⎤ (3.62) ⎢ 2⎥ ⎣-1⎦

投影误差 相应的投影误差(projection error)是原向量与其在U上投影之间差向量的范数,即

‖x - π_U(x)‖ = ‖⎡1⎤ - ⎡2⎤ ⎡1⎤‖ = √6. (3.63) ⎣1⎦ ⎣1⎦ ⎣-1⎦

投影误差也被称为重构误差(reconstruction error)。

第五,投影矩阵(对于任何x ∈ R³)由以下给出

P_π = B(B⊤B){-1}B^⊤ = 1/6 ⎡ 5 2 -1⎤ (3.64) ⎢ 2 2 2⎥ ⎣-1 2 5⎦

为了验证结果,我们可以(a)检查位移向量π_U(x) - x是否与U的所有基向量正交,以及(b)验证P_π² = P_π(见定义3.10)。

注释。 投影π_U(x)仍然是R^n中的向量,尽管它们位于m维子空间U ⊆ R^n中。然而,为了表示一个投影向量,我们只需要关于U的基向量b₁,…,b_m的m个坐标λ₁,…,λ_m。♢

注释。 在带有一般内积的向量空间中,我们在计算角度和距离时必须注意,这些是通过内积定义的。♢