Thomas L. Griffiths, Nick Chater, and Joshua B. Tenenbaum

MIT出版社马萨诸塞州剑桥英国伦敦

© 2024 麻省理工学院

本作品受知识共享CC-BY-NC-ND许可证约束。

此许可证仅适用于完整作品,不适用于经许可包含的任何组件。在此许可证约束下,保留所有权利。未经MIT出版社书面许可,本书的任何部分不得用于训练人工智能系统。

本书的开放获取版本得以实现,得益于MIT图书馆的慷慨资助和支持。

本书由韦斯切斯特出版服务公司采用Times New Roman字体排版。

国会图书馆编目出版数据

姓名:Griffiths, Thomas L., 作者。| Chater, Nick, 作者。| Tenenbaum, Joshua, 作者。书名:认知的贝叶斯模型:心智的逆向工程 / Thomas L. Griffiths, Nick Chater, and Joshua Tenenbaum。描述:马萨诸塞州剑桥:MIT出版社,[2024] | 包含参考文献和索引。标识符:LCCN 2023058931 (印刷版) | LCCN 2023058932 (电子书) |

ISBN 9780262049412 (精装本) | ISBN 9780262381048 (epub) | ISBN 9780262381055 (pdf) 主题:LCSH: 认知科学。| 认知。| 认知心理学。分类:LCC BF311 .G758 2024 (印刷版) | LCC BF311 (电子书) | DDC 153—dc23/eng/20240209 LC记录可在 https://lccn.loc.gov/2023058931 获取 LC电子书记录可在 https://lccn.loc.gov/2023058932 获取

致敬 Roger Shepard (1929–2022)

前言 ix

第一部分 基础知识

第1章 认知科学的贝叶斯方法导论 3 Joshua B. Tenenbaum, Thomas L. Griffiths, and Nick Chater

第2章 认知概率模型的历史背景 37 Nick Chater, Thomas L. Griffiths, and Joshua B. Tenenbaum

第3章 贝叶斯推理 59 Thomas L. Griffiths and Joshua B. Tenenbaum

第4章 图形模型 101 Thomas L. Griffiths and Alan Yuille

第5章 构建复杂生成模型 129 Thomas L. Griffiths and Alan Yuille

第6章 近似概率推理 159 Thomas L. Griffiths and Adam N. Sanborn

第7章 从概率到行动 189 Nick Chater, Thomas L. Griffiths, and Mark K. Ho

第二部分 高级主题

间奏 229

第8章 用层次贝叶斯模型学习归纳偏置 231 Charles Kemp and Joshua B. Tenenbaum

第9章 用非参数贝叶斯模型捕获知识增长 245 Joseph Austerweil, Adam N. Sanborn, Christopher Lucas, and Thomas L. Griffiths

第10章 估计主观概率分布 267 Thomas L. Griffiths, Adam N. Sanborn, Raja Marjieh, Thomas Langlois, Jing Xu, and Nori Jacoby

第11章 采样作为跨分析层次的桥梁 285 Thomas L. Griffiths, Edward Vul, Adam N. Sanborn, and Nick Chater

第12章 贝叶斯模型与神经网络 299 Thomas L. Griffiths, Ishita Dasgupta, and Erin Grant

第13章 资源理性分析 315 Falk Lieder, Fred Callaway, and Thomas L. Griffiths

第14章 心理理论(Theory of Mind)和逆向规划 341 Julian Jara-Ettinger, Chris Baker, Tomer Ullman, and Joshua B. Tenenbaum

第15章 直觉物理作为概率推理 369 Kevin A. Smith, Jessica B. Hamrick, Adam N. Sanborn, Peter W. Battaglia, Tobias Gerstenberg, Tomer D. Ullman, and Joshua B. Tenenbaum

第16章 语言处理和语言学习 395 Nick Chater, Andy Perfors, and Steven T. Piantadosi

第17章 逻辑表示上的贝叶斯推理 423 Charles Kemp, Noah D. Goodman, and Thomas L. Griffiths

第18章 概率程序作为统一的思维语言 437 Noah D. Goodman, Tobias Gerstenberg, and Joshua B. Tenenbaum

第19章 学习作为程序上的贝叶斯推理 473 Steven T. Piantadosi, Joshua S. Rule, and Joshua B. Tenenbaum

第20章 认知发展的贝叶斯模型 499 Elizabeth Bonawitz and Tomer Ullman

第21章 推理的限制和算法概率 517 Nick Chater

第22章 贝叶斯对话 543 Nick Chater, Thomas L. Griffiths, and Joshua B. Tenenbaum

结论 557 致谢 561 参考文献 565 索引 615

这本书讲述人类心智如何理解世界——以及最终,也许讲述我们人类如何理解自己。从神经科学到人类学,许多学科都有这一目标——但我们在这里采用的方法相当具体。我们采用认知科学(cognitive science)的框架,旨在创造这样的

通过逆向工程获得理解:使用创建人工智能(artificial intelligence, AI)系统工程项目中的数学和计算工具来更好地理解人类思维的运作。AI产生了关于人类心智如何工作的丰富且极其多样的假说流。但认知科学不仅仅将AI作为灵感来源。我们对人类认知的数学和计算基础的了解也有助于在机器中构建更像人类的智能。

AI和认知科学领域诞生于1950年代末,并在最初几十年中共同成长。从一开始,这些领域工程和逆向工程人类智能的双重目标就被理解为不同但通过计算视角深度相关。数字计算机的兴起和计算机编程的可能性同时使得认为机器至少在原则上可以被编程来产生人类心智的输入输出行为变得合理。因此,自然而然地提出人类心智本身可以被理解为已经被编程,通过进化、发展以及可能甚至其自身反思的某种混合,来产生我们称之为”智能”的行为。在这些早期,AI研究者和认知科学家分享着他们最大的问题:大脑是什么样的计算机,心智可能是什么样的程序?什么样的计算模型可能构成人类智能的基础——既包括其内部运作也包括其外在可观察的效果?

现在,近70年后,这两个领域已经成熟,并且(如兄弟姐妹经常发生的情况)在某种程度上疏远了。认知科学已经成为一个蓬勃发展、偶尔火热但仍然相对较小的跨学科学术研究领域。AI已经成为一种主导社会力量,在智力、文化和经济方面都是如此。毫不夸张地说,我们正生活在第一个”AI时代”,因为我们被真正有用的AI技术包围着。我们拥有看似能够做我们曾经认为只有人类才能做的事情的机器——驾驶汽车、进行对话或玩像围棋或国际象棋这样的游戏——然而我们仍然没有真正的AI,即该领域创始人最初设想的那种意义上的AI。我们没有通用机器智能,它能做人类能做的一切或思考人类能思考的一切,甚至还差得很远。我们今天拥有的AI技术是由大型专门的人类工程师团队以巨大代价构建的。它们不会自己学习如何驾驶、对话或玩游戏,也不会像任何人类那样想要为自己做这些事情。相反,它们在庞大的数据集上进行训练,这些数据远超任何人类遇到的数据量,并且这些数据都经过人类工程师的精心策划。每个系统只做一件事:玩围棋的机器不会也玩国际象棋、井字游戏、桥牌或足球,更不用说知道如何看到围棋棋盘上的棋子或在棋子意外掉到地板上时捡起来。它不会开车去围棋锦标赛,不会进行关于围棋为何如此迷人的对话,不会制定何时以及如何练习来提高棋艺的计划,也不会决定更多练习是否是其时间的最佳利用。当然,人类心智可以做所有这些事情以及更多——独立学习和思考以在极其复杂的物理、社会、技术和智力世界中运作。人类心智自发地学会弄清所有这些,而不需要数据科学家团队来策划其学习数据,而是通过在那个复杂而混乱的世界中成长互动,尽管需要照顾者、教师和教科书的关键帮助。

可以肯定的是,深度学习的最新和显著发展创造了AI模型,这些模型在正确提示下可以用来执行令人惊讶的多样化任务范围,从编写计算机代码、学术论文和诗歌,甚至创建图像。但相比之下,人类自主创造自己的目标和计划,并且会好奇、无聊或受启发去探索、创造、玩耍和以开放式和自主导向的方式合作。AI很聪明;但到目前为止,它只是人类智能的微弱回声。

缺少什么?为什么我们今天称之为AI的东西与第一批计算机科学家和认知心理学家设想的人类智能通用计算模型之间存在如此巨大的差距?AI和认知科学是如何失去,如已变得越来越明显的,它们最初的共同目标感的?来自市场力量和计算领域更大技术发展的压力和机遇,以及学术时尚和趋势的熟悉模式,都肯定发挥了作用。

今天的一些AI技术经常被描述为受到心智或大脑启发,最著名的是那些基于人工神经网络或强化学习(reinforcement learning)的技术,但这些类比,尽管在历史上对启发现代AI方法至关重要,充其量是松散的。大多数认知科学家会说,虽然他们的领域取得了真正的进步,但其最大的问题仍然悬而未决。控制人类心智如何工作的基本原理是什么?如果被迫诚实回答这个问题,许多认知科学家会说要么我们不知道,要么至少该领域还没有科学共识或广泛共享的范式。

与我们的许多合著者一起,我们写这本书是为了试图缩小这些差距:将认知科学和AI领域重新聚集在一起,并建立

人类智能理解的坚实基础和深度共享的数学与计算基础。这些都是雄心勃勃的目标,我们不会假装不是如此。我们确信这次尝试在很多方面都有不足,仍然留下许多问题未得到解答或未被解决。但我们已经在这个项目上工作了二十多年,开发工具、想法和见解,如果只读单篇论文是很难理解的——特别是如果只读最近几年写的论文,就像今天的学生一样,他们被不断涌现的AI发展浪潮所淹没,大多只是这样做。现在是时候分享我们迄今为止共同学到的东西了,尽管还不完整。

我们的目标是为读者提供一些有价值的内容,无论他们的学术背景和兴趣如何。这本书可以从头到尾阅读;但许多人会选择自己的路径来浏览各章节。本书分为两部分。第一部分包括第1-7章,介绍了关键的数学思想,并用心理学文献中的例子进行说明。这些章节提供了具体模型的详细推导和可用于了解更多基本原理的参考文献。第二部分包括其余章节,介绍了更高级的主题,并深入探讨了这些思想应用的领域。该部分以一个想象的对话结束,其中我们考虑并回应一些我们经常听到的关于逆向工程方法理解心智的担忧。

对于来自AI和机器学习领域的读者,本书第一部分的数学思想可能很熟悉,但应用希望是新颖的。通读这些章节对于了解那些可能出现在计算机科学或统计学课程中的模型——如贝叶斯奥卡姆剃刀(Bayesian Occam’s razor)(第3章)或识别因果关系(第4章)——如何与人类心智必须解决的问题相联系是有用的。对于这些读者,本书第二部分提供了关于贝叶斯模型如何与神经网络相关(第12章)的见解;人们如何高效利用他们有限的认知资源(cognitive resources)(第13章);以及AI系统的经典挑战,如推理他人的心理状态(mental states)(第14章);进行关于物理世界的常识推理(common-sense reasoning)(第15章);以及从有限数据中学习语言(第16章)。结构化表示(structured representations)——如逻辑、语法和程序——在贝叶斯认知模型的高级应用中发挥着关键作用,并在第17-19章中详细讨论。第20章讨论发展心理学(developmental psychology),对那些寻求从数据训练智能系统的人特别相关,第21章考虑学习的限制。

对于认知心理学家,贝叶斯方法提供了一种不同于传统专注于将心智分解为不同认知机制的思维方式。正如我们强调的,贝叶斯认知模型明确采用逆向工程方法,试图从人类心智必须解决的抽象计算问题的角度来理解人类行为。一个人的心智模型应该实际解决心智面临的信息处理问题这一约束是强有力的——它从根本上重塑了创建充分心理学理论的含义。这一观点在第1章中介绍,在第2章中情境化,并通过第3-7章中呈现的例子进行说明。第8章和第9章使用贝叶斯统计学的复杂工具处理认知心理学中的经典问题——学习如何学习和形成支持学习的表示(representations)。第10章以新颖的角度呈现一些传统实验方法,展示让一系列人传递信息片段如何揭示学习和记忆中的系统性偏差(systematic biases)。第11-13章开始与心理学中更传统的计算建模方法接触,展示范例模型(exemplar models)、神经网络以及启发式和偏差(heuristics and biases)如何与贝叶斯推理(Bayesian inference)相协调。第14-19章呈现高级认知中重要主题的应用,如语言、概念学习和直觉物理学(intuitive physics)。

对于发展心理学家,贝叶斯方法提供了一种参与关于人类能够通过经验学习什么的基本问题的方式。贝叶斯认知模型对学习者在问题中运用的先验知识(prior knowledge)做出明确假设,因此它们提供了探索学习限制的工具。第20章明确讨论这些思想如何在发展心理学背景下应用,所以在阅读第一部分后可能是构建进一步阅读的好地方。

第9章描述逐渐形成日益复杂表示的模型。第10章展示信息的文化传播(cultural transmission)如何使该信息更容易学习——这一思想已在语言学习背景下应用。第11-13章介绍支持贝叶斯推理并有空间容纳发展变化的机制。第14章考虑心智理论(Theory of Mind),第15章直觉物理学,第16章语言学习,所有这些在发展心理学中都发挥了重要作用。对于更倾向理论的读者,

关于刺激贫乏性和与此相关的论证,这些论证涉及语言习得研究以及整个认知发展中天赋论-经验论的辩论。比较心理学家可能会喜欢通过本书的类似路径。虽然我们没有明确讨论比较研究,但这些主题很适合在不同物种间进行探索,既涉及那些在物种间似乎高度保守的机制(例如,感知、学习和行动的基本原理),也涉及那些通常被认为是人类独有的机制(例如,心理理论和社会认知的各个方面)。

对于神经科学家来说,这里提出的工作主要提供了一个挑战。虽然我们讨论了可以用来实现贝叶斯推理的认知过程(第11章和第13章),并建立了与神经网络的联系(第12章),但可能支撑我们提出的最复杂模型的神经机制仍然是深度神秘的。神经元如何执行计算从而导致对这些模型中使用的结构化表征进行推理,这仍然是一个开放性问题。对于渴望此类挑战的神经科学家,我们推荐第8章作为开胃菜,第14-19章作为主菜。

我们撰写本书的目的是让尽可能广泛的读者群体都能理解,从发现认知科学并对概率论有基本了解的本科生,到希望拓宽视野的资深研究者。在此过程中,我们受益于来自斯坦福大学、麻省理工学院(MIT)、布朗大学、加州大学伯克利分校、普林斯顿大学、牛津大学和华威大学学生的反馈,以及来自各个领域同事的反馈。本书的种子是由我们在加州大学洛杉矶分校纯数学与应用数学研究所举办的暑期学校播下的,而这个暑期学校又建立在我们在认知科学学会年会和神经信息处理系统会议上做的教程基础上。我们感谢在过去二十年中讨论这些想法的所有机会,并期待在未来的岁月里与读者继续这种对话。

[1.] 经验丰富的教授已经注意到本书的章节数量与两周一次的学期课程的授课次数完美匹配。你不需要掌握第3章中介绍的贝叶斯方法就能够认识到这不是巧合。我们认为当前的章节顺序对这样的课程很有效,但第二部分的章节相对独立,可以根据学生的兴趣进行调整。

Joshua B. Tenenbaum, Thomas L. Griffiths, and Nick Chater

我们在第一章的目标是从它让我们能够提出的重大问题以及它提供的独特答案类型的角度来介绍认知科学的贝叶斯方法。从工程学角度来看,人类智能是如何工作的?什么数学原理和计算构建块能够解释我们理解世界和我们在世界中位置的能力?这些是最重大的问题,最初将我们和许多其他人带入认知科学领域。它们可以追溯到将人类思维建模为计算的最早尝试(例如,Newell & Simon, 1956),并与可以追溯到更早的哲学思想有联系(例如,Hume, 1739/1978; Kant, 1781/1964; Mill, 1843)。接下来页面中的一切都可以看作是对它们的回应,我们撰写本书是因为我们认为贝叶斯方法提供了我们所知的解决这些问题最有价值的工具。

但这样的重大问题一开始可能也会让人感到无法面对。可能不清楚什么算作令人满意的答案,或者我们如何知道何时是正确的——或者至少走在正确的道路上。所以让我们从一个容易陈述、也许更容易理解可能答案的问题开始:我们的大脑如何从如此少的信息中获得如此多的内容?

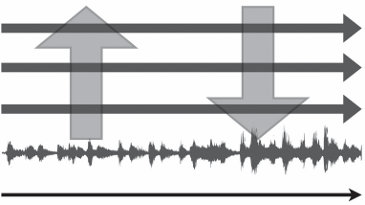

在我们看到大脑工作的每个领域中,我们都看到通过感官传入的信息与认知输出之间的不匹配。我们建立丰富的世界因果模型,做出强有力的泛化,构建强大的抽象,甚至发明全新的世界和理解它们的方式,而输入数据是稀疏的、嘈杂的、不完整的和模糊的——在各个方面都太有限了。我们是如何做到的?

这是激发本书中描述的最早研究的问题,它所呈现的挑战——以及什么算作令人满意的解决方案——可以通过几个熟悉的例子变得具体和精确。首先考虑儿童学习词汇意义的情况。一个典型的两岁儿童可以通过看几个例子学会如何使用一个新词,如”马”或”发刷”——有时甚至一个例子就足够了(Carey & Bartlett, 1978; Bloom, 2000; Smith, 2000; Xu & Tenenbaum, 2007)。我们知道他们掌握了这些词的意义,而不仅仅是声音,因为他们能够泛化:他们能够适当地使用这些词(即使不总是

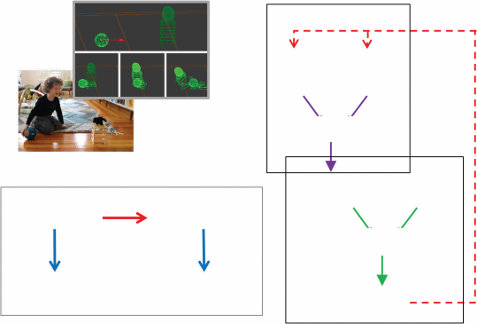

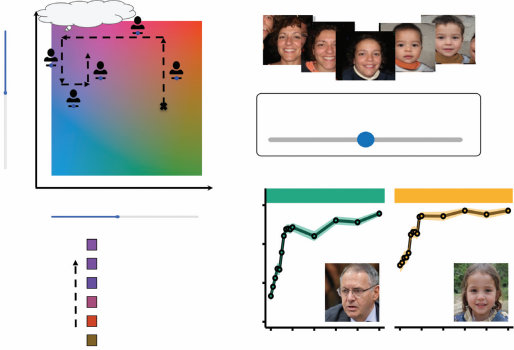

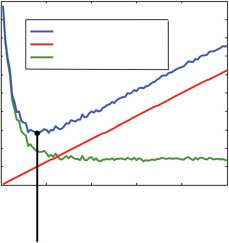

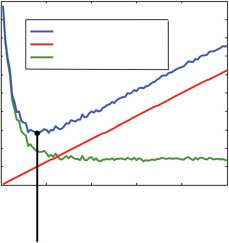

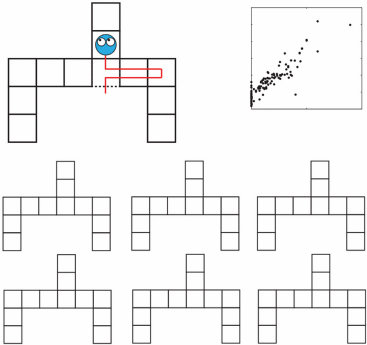

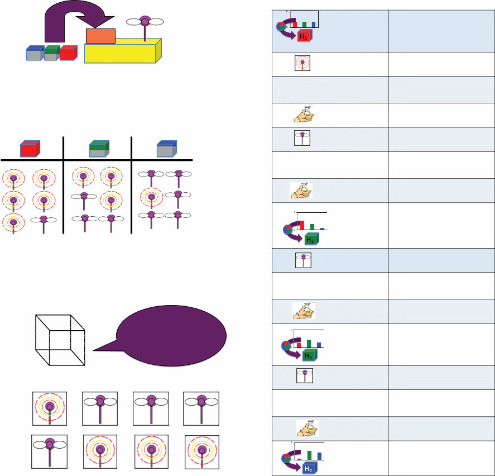

图1.1

人类儿童在学习物体概念的名称时,通常仅从少数几个例子就能做出强有力的归纳。在成人学习计算机生成的新颖物体名称时,也可以研究这种快速归纳的相同过程。(a) 给定这些外星物体,以及三个”tufas”(外星语言中的一个词)的例子(红框标出),哪些其他物体是tufas?(b) 学习类别名称可以建模为在树状领域表示上的贝叶斯推理(Xu & Tenenbaum, 2007)。物体被放置在树的叶子节点上,关于词汇可能标记的类别的假设对应于不同的分支。不同深度的分支选择出不同归纳水平的假设。通过假设更具区分性的假设——那些具有更长分支的假设——更有可能,以及观察到的数据更可能从紧密覆盖例子的假设中生成,贝叶斯推理倾向于在跨越所有观察例子的最低区分性分支上进行归纳(这里用虚线圆圈显示)。图改编自Tenenbaum, Kemp, Griffiths, and Goodman (2011)。

在新情况下(完美地)使用。他们开始分类地使用这些词来指代任何

适当类型的实体。从计算

或统计推理的角度来看,这是一个非凡的成就。在所有可能物体的无限(且可能是无限维)空间内,存在一个无限但更小且高度受限的子集

可以被称为”马”,另一个可以被称为”发刷”。儿童如何仅从看到每种类型的一个或几个例子就掌握

这些子集的边界?机器又如何能学会

做同样的事情?

来自统计学和机器学习的传统算法方法通常

需要数十或数百个标记例子来将物体分类到类别中,而且

归纳得远不如此可靠或稳健。儿童如何做得如此出色?成人

较少面临学习全新物体概念的挑战,但他们在这方面可以同样

出色:通过图1.1中计算机生成的物体亲自体验一下。

在认知领域,根本上相同的挑战出现在各个方面。作为第二个案例,考虑

儿童和成人为自己创造并相互学习的许多谜题和游戏。以任何具有少数几条规则的简单棋盘游戏为例,如井字游戏、四子棋、

跳棋或奥赛罗,想象你第一次遇到它,看到两个人在玩。规则没有向你解释——你只是在观察玩家的

行动。仅仅通过观察他们的游戏,你肯定无法学到所有

你需要知道的东西来熟练地玩这些游戏。但在许多情况下,仅仅看几轮行动

就足以推断出游戏的大部分玩法:允许哪些移动,它们对游戏状态有什么影响,甚至可能知道

这些移动似乎要达到什么目标。你的推断可能只是猜测,带有一定程度的

不确定性,但即使不确定,即使略有偏差,你对

游戏规则的猜测也会比你在完全没有看到任何游戏之前能做出的猜测好得多。你同样可以推断出许多流行的儿童操场游戏背后的规则和目标

## 认知科学贝叶斯方法简介 [5]

游戏,只需观看一分钟的标签游戏、跳房子、红灯绿灯或许多其他游戏。

在每一个这样的案例中,即使我们推断的概念和规则对我们来说显然是正确的,而且确实是正确的,对于任何有限的游戏序列,总是存在无限的替代可能性集合,这些可能性与所有相同的数据都是一致的。

我们在实验室中用更简单的抽象任务研究了这种现象,例如以下数字游戏(Tenenbaum, 1999; Tenenbaum, 2000):想象我们正在思考一个规则,该规则从1到100之间的数字中选出一个子集——原则上可以是任何子集。现在我们给你四个目标子集中数字的例子——60、80、10和30——然后问你还有哪些其他数字在同一个子集中。几乎每个人都会说规则可能选出”10的倍数”,并用该子集中的其他数字(即20、40、50等)来回应。但为什么呢?是什么让你如此确定,而逻辑上有许多其他可能性——数量庞大。给出的例子同样符合选出”偶数”、“5的倍数”或”10到90之间的数字”的规则,更不用说更深奥但逻辑上同样一致的可能性,如”7到97之间的数字”、“除了50之外的10的倍数”或”20的倍数,以及小于40的数字”。为什么在这里超越给定数据的一种特定方式如此更加

比其他规则更具说服力?为什么同样的规则”10的倍数”如果我们只向你展示前一两个例子(60,或60和80)然后要求你在那个点进行概括的话,就不会那么有说服力——即使在这两种情况下,所有相同的可能替代规则都在起作用?

这本质上就是从稀疏数据中概括的问题。这与儿童通过观察他人的行为和言语来学习如何使用词汇或如何玩新的游乐场游戏时面临的问题相同。一旦你知道如何识别这个挑战,你就会看到它在认知的各个方面都有出现。它出现在语言学习的每个方面,不仅仅是词汇的含义,在研究儿童如何习得母语的语法或形态学方面发挥着特别核心的作用(Pinker, 1999; Marcus, Vijayan, Bandi Rao, & Vishton, 1999; Gomez & Gerken, 1999)。它在因果学习中表现得尤为明显:每个统计学课程都教授相关性不意味着因果关系,然而在合适的情况下,即使是幼儿也经常可靠地从少数几个事件中推断出因果联系(Gopnik et al., 2004)——这个样本太小,无法通过传统统计方法计算出可靠的相关性。

也许人类学习中最深层的概括形式出现在认知发展中,在构建更大规模的知识系统时:物理学、心理学或生物学的直觉理论,或社会结构或道德判断的规则系统。构建这些系统可能需要数年时间,比学习一个新词、一个新的因果联系或新游戏规则要长得多,但在这个规模上,学习的最终产品也远远超出了观察到的数据——仅仅是因为这些理论的核心概念,如重量和密度、信念和偏好,或生与死,根本无法观察到(Gopnik & Meltzoff, 1997; Carey, 1985, 2009)。直觉理论也可以在瞬间被改变,仅凭一丝感官证据就被修改以适应新因果律的可能性——如果这是正确的一丝证据。想想一个孩子第一次看到磁铁、遥控器、触摸屏设备或反重力机器。一次演示就足以表明世界可能与他们之前想象的不同;再进行一两次实验,自己摆弄这个新系统,就能证实这种怀疑。当然,人类科学家还没有发明反重力机器,但你可以确信,如果他们发明了,并且任何人都可以购买并在家中把玩,人类儿童很快就会了解其戏剧性的效果——并且从同样最少的数据模式中学会。

试图解决我们如何从如此少的信息中获得如此多知识的问题,绝不是构建心智模型时唯一有趣的起点,但这肯定是最核心的起点之一,许多其他有趣的问题都源于试图以令人信服的方式回答这个问题。它暴露了任何试图将智能理解为一系列数学和计算问题解决方案的尝试所面临的严峻挑战。这是及时的,因为今天的人工智能(AI)技术越来越由机器学习框架驱动,这些框架无止境地渴求数据且无望地依赖数据。超越观察数据的概括是构建具有类似人类智能的机器的核心困难。这也是永恒的。

哲学家已经为这个问题的各种版本困惑了2000年——最著名的是”归纳问题”,正如大卫·休谟的版本所知(Henderson, 2022),但其根源可以追溯到柏拉图和亚里士多德,并贯穿整个西方哲学传统。19世纪哲学家约翰·斯图尔特·密尔在《逻辑体系》中写道,激发了几代人对思维的思考:“为什么在某些情况下,单个实例足以进行完整的归纳,而在其他情况下,无数个一致的实例,没有已知或假定的单个例外,在建立普遍命题方面却进展甚微?谁能回答这个问题,谁就比古代最智慧的人更了解逻辑哲学,并解决了归纳问题。”(Mill, 1843, p. 380)。

密尔写的是科学家观察世界时面临的概括问题,但他同样可以谈论我们在认知科学中的现代概括问题:在人类学习者可能超越给定数据的众多可能方式中,我们如何知道——有时仅从一个例子——这些概括中哪些应该成立,哪些不应该?威廉·惠威尔、威廉·斯坦利·杰文斯、伯特兰·罗素、鲁道夫·卡尔纳普、汉斯·赖辛巴赫、卡尔·亨佩尔、卡尔·波普尔、威拉德·范·奥曼·奎因、纳尔逊·古德曼,以及19世纪和20世纪的许多其他人深化了这些问题,并继续推动当代认识论和科学哲学中关于知识起源的辩论(Godfrey-Smith, 2003):我们如何能够掌握宇宙的定律,或世界的其他持久属性?成为自然定律或持久属性意味着什么?我们相信一个在任何地方和任何时候都成立的定律或普遍概念不会在明天或明年被证伪的真正信心基础是什么?

1959年,当AI和认知科学刚刚开始作为研究领域出现时,波普尔写道,他选择研究科学知识的起源是因为这是基本的——

本质上是日常认识论的问题——常识知识起源的问题——放大版(Popper, 1959/1990)。在波普尔的时代,就像在密尔的时代一样,科学知识或许比常识知识更容易也更令人信服地进行研究。我们现在看到了同样的类比,但方向相反。我们选择研究人类心智对世界的常识理解,以及它如何通过日常的归纳跳跃运作,因为这以最易处理和最紧迫的形式揭示了知识起源和增长的最深层问题。在这个时刻,凭借我们拥有的数学、计算和实验工具,这是经典归纳问题最适合严格科学解释和实际工程进展的形式。

在某种程度上,我们对这些问题的回答必须与哲学家们自柏拉图以来对归纳问题给出的答案是同一类型的答案。如果心智超越了给定的数据,某些其他信息源必须弥补这种差异。在认知的计算或信息处理解释中,不能有免费午餐、魔法或无中生有(这一思想在机器学习的”无免费午餐”定理中得到了形式化;例如,Wolpert & Macready, 1997)。某些更抽象的背景知识必须生成并限定学习者考虑的假设,否则有意义的泛化将是不可能的(例如,McAllester, 1998)。发展心理学家和语言学家谈论”约束条件”(例如,Carey, 2009; Spelke & Kinzler, 2007; Chomsky, 1965);机器学习和人工智能研究者谈论”归纳偏置”(例如,Mitchell, 1997; Russell & Norvig, 2021);统计学家谈论”先验”(例如,Jaynes, 2003; Robert, 2007)。神经科学家在问关于感知如何解释嘈杂感觉输入的类似问题时,谈论大脑的”内部模型”(例如,Wolpert, Miall, & Kawato, 1998)。术语各不相同,但总是描述某种填补经验空白的世界建模,让我们的心智合理地将数据转化为可靠、合理的信念。

当然,这个”答案”实际上不是一个答案,而是一个提出更多问题的邀请和一个关于这些问题应该聚焦何处的指南。对于逆向工程解释,关键问题现在集中在用计算术语解释这种抽象知识的性质、功能和起源:它究竟如何解决归纳问题,它的具体形式和内容是什么,它如何在人类心智和大脑中产生?稍微展开这些问题,我们想要理解:抽象知识如何从贫乏的数据中指导推理,以产生可靠有价值的泛化、预测和决策?这种知识采取什么形式,在各种思维领域中具有什么信息内容?知识如何在一生中增长,平衡强约束的需要与持续学习新领域的灵活性?我们构建的知识如何指导我们在世界中的规划和行动——我们如何使用它?表示、获取和部署人类规模知识所需的算法和数据结构实际上如何在人类心智中实现,或者在人类大脑的物理基质中实现?具有复杂世界模型的学习和推理如何在具有有限——通常相当有限——资源的心智中高效实现?我们关于抽象知识的最深层概念最终如何在认知发展中产生——它们是否都必须在某种意义上是先天的,从出生时就内置在大脑或心智的机制中,或者抽象知识的基本形式和内容本身是否可以被学习或构建,全部或部分?

本书的其余部分代表了我们尝试用逆向工程的术语回答这些问题:用数学和计算的语言开发一个连贯、统一的框架,以综合的方式解决所有这些问题,达到足以构建具有这些相同能力的机器并在定量行为实验中得到严格测试的精确度和解释深度。本章的其余部分提供了对本书整体涵盖内容的更具体概述,以及一些亮点和关键见解。然而,在我们开始之前,我们应该指出关于这种方法以及我们如何写作的几个要点,这将有助于为读者定向。

首先,如果被迫用一个词总结我们对这些问题的方法,我们自然必须说:“贝叶斯”。正如本章后面所解释并在第3章中进一步阐述的,被称为贝叶斯规则的概率论原理为理性代理如何解决归纳问题提供了指导,将先验知识与数据提供的信息整合在一起。如果给一整个句子,我们可能会说:“有效近似分层贝叶斯推理的算法和数据结构,基于丰富且灵活结构化的世界表示。”当然,要恰当回答所有这些问题需要一整本书——这本书——而不是一个词的标签或一句话的口号。但这些标语也有助于为我们定向。我们将在接下来几百页中描述的工作在认知科学内已经公平且毫无疑问地被称为贝叶斯或概率方法。我们自己在演讲和论文标题中突出使用了这些词汇,并自豪地接受我们的逆向工程观点。

工程化心智的研究受到了机器学习和人工智能中贝叶斯和概率方法工程成功的影响 (Pearl, 1988; Thrun, Burgard, & Fox, 2005; Russell & Norvig, 2021; Murphy, 2012)——以及我们自己的工作如何启发了更强大、更类人的贝叶斯机器学习、推理和感知方法 (Griffiths & Steyvers, 2004; Griffiths & Ghahramani, 2006; Kemp, Perfors, & Tenenbaum, 2007; Goodman, Mansinghka et al., 2008a; Shafto, Kemp, Mansinghka, & Tenenbaum, 2011; Kulkarni, Kohli, Tenenbaum, & Mansinghka, 2015; Lake, Salakhutdinov, & Tenenbaum, 2015; Grant, Finn, Levine, Darrell, & Griffiths, 2018; Ellis et al., 2023)。

同时,认知科学中的贝叶斯方法远不止”贝叶斯”这一个词所能概括的。事实上,任何致力于准确逆向工程的心智观点都不可能被单一的思想或原则所囊括。以”连接主义”或”神经网络”范式为例 (Rumelhart & McClelland, 1986)。这些模型确实涉及关于连接的核心主张:例如,知识存储在类神经元处理单元之间的连接网络中,学习包括调整这些连接的强度。但它们通常还涉及其他核心主张,如分布式表征的首要性、错误驱动学习和梯度激活 (O’Reilly & Munakata, 2000)。

因此,“连接主义”一词已经代表了这些模型在几十年中集体体现和发展的一系列思想集群。同样,认知的”贝叶斯”或”概率”模型应该被视为一套相互加强和支持的概念、原则和工具的标签,它们以强大的方式协同工作,解释智能如何在自然心智中运作,以及我们如何构建更智能的人工心智。本书的目标是介绍、调查和解释这一领域。贝叶斯提供了一个起点,但仅仅是开始。

其次,虽然我们迄今为止一直在讨论人类知识作为我们的主题,并将继续这样做,但我们的重点将放在一种抽象知识上——我们可以称之为”世界模型”,或者更准确地说,“概率生成世界模型”。所谓”生成”,我们指的是人类心智对世界中因果过程的模型:使事情发生的机制,产生(或”生成”)我们观察到的事件以及那些我们没有直接观察到但知道存在的、潜在的、幕后的事件。所谓”概率”,我们指的是这些模型必须内在地表征和处理不确定性的所有方式:即使它们假设的生成机制是确定性的,概率建模和推理也是必要的,因为我们对世界潜在因果结构的捕获和了解存在诸多不足。

这些模型跨越了无生命的物理世界和有生命的智能体世界,以及在其他智能体心智内部发生的因果过程,这些过程生成了它们的行为。它们可能往往是无意识的,尽管有些肯定也有意识的方面。它们延伸到远超我们直接经验的领域,我们只能通过他人的证言或我们自己的想象来思考这些领域。它们甚至延伸到(或者,有些人推测,从这里开始)我们心智对自身内部过程的模型,我们自己的主观世界。

在结构上,这些生成世界模型在多个尺度和抽象层次上运作,从我们每个人对眼前事物的非常具体的模型——比如当我们在桌前写这一章时,或者你阅读这些文字时对眼前事物的模型——到我们对世界运作方式的更一般的概念,以及可能一直以来和将来都会如此运作的方式。它们还表征了除了实际世界之外的许多世界:世界可能或可能如何存在的假设空间,支持我们对实际世界可能如何的推理;以及假想和反事实可能性的空间,支持我们对下一步应该做什么来实现目标的推理,或者对过去当事情没有如我们希望的那样展开时,可能发生什么或我们应该做什么的推理。

为什么要将这种特定类型的知识作为我们心智如何从如此少中获得如此多的基础?自认知心理学和人工智能的早期发展以来,人类心智对世界建模的广阔能力一直是每个关于人类智能的严肃解释的核心。它经常被引用为独特人类”常识”的本质,以及科学建立的认知基础,人类与非人类动物智能之间的差异,以及人类智能与数据驱动的人工智能系统之间的差异。我们不会在这里重复大部分这些论证,但我们建议感兴趣的读者参考出现在 Koffka (1925), Craik (1943), Heider (1958), Newell, Shaw, and Simon (1959), McCarthy (1959), Neisser (1967), Minsky (1982), Norman (1972), Gentner and Stevens (1983), Johnson-Laird (1983), Rumelhart, Smolensky, McClelland, and Hinton (1986b), Pearl (1988), Shepard (1994), Gopnik and Meltzoff (1997), Carey (2009), Levesque (2012), Davis (2014), Kohler (2018), and LeCun (2022) 中的许多版本。关于我们自己对人们世界模型中心性的思考,可以在本书的各个部分找到更多内容。

然而,我们要说的是,即使关于人类心智模型的主题已有如此多的先前工作,本书中提出的方法和工具在试图涉及我们人类用世界模型所做的一切的范围和技术深度方面都是全新的:

我们的能力不仅能识别我们看到的事物,还能理解和解释它们;不仅能预测接下来可能发生的事情,还能判断在不同环境或我们采取不同行动的情况下可能会发生什么;想象可能发生但极不可能的事件,或从未存在但可能存在的事物;然后将这些结果设为目标,制定有效且高效的计划来实现它们,并解决途中遇到的问题;最重要但绝非最后一点是,通过构建模型来学习,这些模型不仅来自我们在世界中的个人经验,还通过与他人分享我们的模型来社会性学习,并在个体生命周期和世代间文化性地构建知识。

我们在过去二十年关于认知贝叶斯模型工作的目标是发展一个统一的数学和计算方法,用于解释人类心智如何能够做到所有这些事情,这一方法建立在严格的行为实验基础上,测试这些解释能够达到多远。这种方法,以及与之配套和扩展所需的工具,正是我们希望您从阅读本书中获得的。

最后,由于在整本书中(尤其是在这个引言中)我们在直观地谈论人们的”世界模型”和更一般但哲学意味浓厚的术语如”知识”或”抽象知识”,以及更具体的贝叶斯技术概念如”生成模型”或”概率生成模型”之间自由转换,我们想要向那些关注这些术语之间重要区别的读者说明,我们对这些区别并非不敏感。概率生成模型并不是智能体(agent)可以拥有的唯一一种世界模型——人类肯定还有其他模型。而且,仅仅因为一个人在头脑中有某个世界模型,并不意味着认识论学者应该真正认为他们拥有”知识”——人类模型的许多方面肯定是错误的或以其他方式不符合条件。

然而,我们确实想要为这样的主张进行辩护:我们在此研究的心智世界模型,如果它们确实大致遵循我们在本书中阐述的形式和功能,那么它们确实构成了真正的知识。考虑知识的经典定义”有根据的真实信念”(这一定义本身也不是没有问题的;参见Gettier, 1963)。世界模型是心理表征(mental representations)或信念。我们认为,按照人们构建它们的方式,它们应该是真实的,或足够真实的。它们之所以如此,是因为它们的形式和功能,作为分层概率生成模型(hierarchical probabilistic generative models),通过理性且合理有根据的学习和推理程序应用于事实世界。因此,称这些模型为”知识”似乎是可以的。就像任何现实智能体拥有的任何现实知识一样,它们在许多方面都是不完整和不完美的。特别是,它们是近似的、概率性的,充其量只是可能的、近似真实的。它们被设计为仅支持好的猜测。但它们是我们能做出的最好猜测,而这本书提供了我们目前对它们如何工作的最好猜测。

本书的内容可以围绕一系列关于人类对其世界的抽象知识——其结构、使用和起源——的基础问题来组织。我们在本章前面非正式地介绍了这些问题,但现在我们将更系统地阐述它们。

我们从最初指导我们自己关于日常归纳跳跃工作的三个最基本问题开始,试图解释我们的心智如何从如此少的信息中获得如此多的内容:

Q1 世界的抽象知识如何指导从稀疏数据中进行学习和推理?

Q2 我们的抽象世界知识在不同领域和任务中采取什么形式?

Q3 世界模型本身是如何获得或构建的?

最初,我们接受并发展了贝叶斯学习和推理方法,因为它似乎为以原则性和统一的方式回答这些问题提供了最佳前景,这些答案有望在认知的许多领域中普遍适用。我们专注于为人类建模典型的归纳问题,这些问题也是认知心理学家自该领域诞生以来就以某种形式研究的经典问题:学习概念(或类别)、学习因果关系、归纳推理、做预测等等。我们已经介绍了其中一些问题,接下来我们将预览贝叶斯框架如何发展来解释它们,具体是通过回答问题Q1-Q3。这代表了我们逆向工程心智方法的核心,也是本书第一部分的重点。

本书第二部分代表了更近期的工作,针对一些更高级但同样重要的问题:

Q4 我们如何使用我们的世界模型来做决策并在世界中成功行动?

Q5 在具有有限计算资源(bounded computational resources)的心智中,如何高效地实现复杂世界模型的学习和推理?

Q6 复杂的世界模型如何在物理机器、大脑或计算机中实现?

Q7 我们世界模型在进化和发展中的起源是什么——婴儿的心智中内置了什么,儿童如何在该起点之内和之外学习?

Q8 需要什么来扩大学习规模,以涵盖人类在其一生中获得的所有知识以及人类文化在世代间构建的知识?

贝叶斯框架在解决这些问题方面的扩展是有机地产生的,作为对我们早期专注于Q1-Q3努力的回应。在某些情况下,这些是尝试

回应尖锐的批评或反对意见;在其他情况下,它们来自我们自己对工作中最缺失部分的思考。我们认识到,在Q1-Q3的驱动下取得一些进展后,我们的初步答案也提出了新的问题,或者建议了我们以前没有看到如何着手处理的认知经典问题的新方法。

我们认为这是贝叶斯范式(或任何逆向工程心智的有效方法)的优势,即在回应外部批评和内部反思时,它不会固守一套固定的问题去回答,而是开辟了建立在早期工作基础上并丰富早期工作的新研究方向。在试图理解像人类心智这样深刻而广阔的主题时,在这个相对早期的探索阶段,我们取得最大进展的时候不是当我们的初始问题被最终确定地解决时,而是当我们能够有效提出的问题集合变得更大、更具挑战性和更有趣时。

我们也开始相信,任何计算认知科学(或认知AI)方法在连接特定认知方面的具体、可定量测试模型与关于心智作为整体如何工作以及有时如何失效的更广泛解释时,取得最大进展。我们在Q1-Q3上的早期工作优先考虑了具体性

[1.] 一些读者可能会注意到我们关于世界知识的问题与Noam Chomsky经常用来构建语言研究框架的问题之间的相似性(例如,Chomsky,1986)。这并非巧合:语言涉及结构化表征和具有挑战性的归纳问题,我们认为这些因素是更广泛地理解人类认知的关键。其他工作也从Chomsky的问题中汲取了类似的灵感来研究高级认知的各个方面(例如,Mikhail,2008,关于道德)。12 J. B. Tenenbaum, T. L. Griffiths, and N. Chater

以及优雅、精确、可定量测试模型的价值,但Q4-Q8对我们来说似乎是实现这种更大整合最紧迫需要解决的问题。我们知道我们距离我们都在寻求的心智完整解释还很远,但是,过去十年在这些更高级问题上取得了巨大进展,使得认真考虑这样的解释可能触手可及的想法成为可能。这些发展也代表了当前研究中一些最活跃的领域,是第二部分的焦点。

在第一章的其余部分,我们想通过预览贝叶斯方法如何处理所有这些问题,让您体验一下贝叶斯方法。我们专注于Q1-Q3,作为我们方法的基础,然后更快地通过Q4-Q8。在此过程中,我们还将包括指向具体后续章节的指引,我们在那里详细处理每个问题,作为读者的指南。

我们将用主要来自两个典型归纳问题领域的例子来说明这种方法:关于自然类概念的学习和推理,以及关于因果关系的学习和推理。我们还将把本书中发展的贝叶斯方法与思考人类知识本质和起源的另外两种经典方式进行对比:René Descartes和Immanuel Kant理性主义的现代认知继承者,以及John Locke和David Hume经验主义的现代认知继承者。这些思想及其彼此辩论的历史是哲学的伟大竞争之一。认知科学家和AI研究者有力地加入了这场辩论的双方,包括在理性主义一方,各种版本的语言、概念和进化先天论(nativism)(Pinker,1997;Fodor,1998;Spelke,1990;Leslie,1994;Spelke & Kinzler,2007;Chomsky,2015;Marcus & Davis,2019);在经验主义一方,既有经典联结主义模型中的联想主义倾向(McClelland & Rumelhart,1986;Elman et al.,1996;McClelland et al.,2010),也有当代AI的深度强化学习系统和非常大的序列学习模型(Silver et al.,2016;Silver, Singh, Precup, & Sutton,2021;LeCun,2022;Brown et al.,2020;Alayrac et al.,2022)。认知的贝叶斯模型通过提供这两极的替代方案,以及思考相关基础问题的真正不同的方式,吸引了许多人。我们在第2章讨论这些各种方法的历史,以及它们与贝叶斯方法的关系。

本书中我们呈现的方法的核心,是将世界的丰富结构化、表达性表征与强大的统计推理机制相结合,论证只有知识表征和归纳推理的复杂方法的综合才能解释人类智能。直到最近,人们还不理解这种融合如何在计算上工作。认知建模者被迫在两个选择之间做出选择(Pinker,1997):在最简单、无结构的知识形式上进行强大的统计学习,例如联结主义语义认知解释中的联想权重矩阵(McClelland & Rumelhart,1986;Rogers & McClelland,2004),或者配备只有最简单、非统计学习形式的丰富结构化符号知识,检查假设与观察数据之间的逻辑不一致性,如语言习得的先天论解释(Niyogi & Berwick,1996)。似乎必须接受以下两种情况之一:人们的抽象知识在非平凡的意义上不是从经验中学习或归纳的(因此本质上是先天的),或者它是

并非像看起来那样抽象或结构化——如”知识般”——(因此简单地[介绍][贝叶斯][方法][到][认知][科学][[13]]

关联)。许多发展研究者完全拒绝了这种选择,转而在”建构主义”或”理论理论”的标题下追求不太正式的方法来描述儿童不断成长的心智(Gopnik & Meltzoff, 1997)。解释人们如何能够真正用抽象结构化知识学习的潜力可能是贝叶斯认知模型最显著的特征——在一些发展圈子中它们受欢迎的最大原因(Gopnik & Tenenbaum, 2007; Griffiths, Chater, Kemp, Perfors, & Tenenbaum, 2010; Perfors, Tenenbaum, & Wonnacott, 2010; Griffiths, Sobel, Tenenbaum, & Gopnik, 2011b; Xu, 2019; Spelke, 2022),也是来自传统先天论和经验主义阵营中其他人怀疑的最大目标(Berwick, Pietroski, Yankama, & Chomsky, 2011; McClelland et al., 2010)。

在过去二十年中,高级认知的许多方面都被贝叶斯统计学的数学原理所阐明:我们的相似性感知(Tenenbaum & Griffiths, 2001a)、代表性(Tenenbaum & Griffiths, 2001b)和随机性(Griffiths & Tenenbaum, 2001; Griffiths, Daniels, Austerweil, & Tenenbaum, 2018);巧合作为隐藏原因的线索(Griffiths & Tenenbaum, 2007a)、因果强度判断(Lu, Yuille, Liljeholm, Cheng, & Holyoak, 2008)和证据支持(Griffiths & Tenenbaum, 2005);诊断和条件推理(Krynski & Tenenbaum, 2007; Oaksford & Chater, 2001);以及对日常事件未来的预测(Griffiths & Tenenbaum, 2006)。

人类心智根据贝叶斯原理学习和推理的主张并不意味着心智可以实现任何贝叶斯推理。只有那些心智被设计为能够很好地执行的归纳计算,即生物学有时间和理由设计有效且高效机制的地方,才可能用贝叶斯术语来理解。除了刚才提到的一般认知能力之外,贝叶斯分析还阐明了许多由快速、可靠和无意识处理产生的特定能力,包括感知(Yuille & Kersten, 2006)、语言(Chater & Manning, 2006)、记忆(Shiffrin & Steyvers, 1997; Steyvers, Griffiths, & Dennis, 2006)和感觉运动系统(sensorimotor systems)(Körding & Wolpert, 2004)。相比之下,在需要将概率作为数值量进行明确有意识操作的任务中——这是一个最近的文化发明,很少有人能熟练掌握,而且只有在经过复杂训练后才能做到——判断可能明显偏离贝叶斯规范(Tversky & Kahneman, 1974)。

本质上,贝叶斯法则只是回答Q1的一个工具:抽象知识如何指导从不完整数据中的学习和推理?抽象知识被编码在概率生成模型(probabilistic generative model)中,这是一种心理模型,描述了世界中产生学习者观察的因果过程,以及支持有效预测和行动的未观察到的潜在变量(latent variables)——如果学习者能够推断它们的隐藏状态。生成模型必须是概率性的,以处理学习者对潜在变量真实状态和起作用的真实因果过程的不确定性。生成模型在两个意义上是抽象的:它不仅描述手头的特定情况,还描述学习应该泛化的更广泛情况类别,并且以简洁的形式捕获了导致学习者观察并使泛化成为可能的基本世界结构。

[14] [J.] [B.] [Tenenbaum,] [T.] [L.] [Griffiths,] [and] [N.] [Chater]

贝叶斯推理为在给定观察数据的情况下更新关于生成模型中潜在变量的信念提供了一个理性框架(Jaynes, 2003; Mackay, 2003)。背景知识通过关于潜在变量可能值的受限假设空间[H]进行编码——可以解释观察数据的候选世界结构。更细粒度的知识来自先验概率P[(]h[)],它指定学习者在观察之前(或独立于观察)对每个假设h的信念程度。贝叶斯法则将这些先验概率更新为以观察数据d为条件的后验概率P[(]h[|]d[)]:

[P[(]h[|]d[)] [=] [∑]] P[(]d[|]h[)]P[(]h[)] [] [[∝] P[(]d[|]h[)]P[(]h[)]. [(1.1)] []]

[h][] [(]d[|] [)]P[(] [)] [∈] [H] P h h

后验概率与先验概率和似然性P[(]d[|]h[)]的乘积成正比,似然性测量在假设h下数据的概率,相对于[H]中的所有其他假设[] h。

为了说明贝叶斯法则的作用,假设我们观察到约翰咳嗽(d),我们考虑三个假设作为解释:h1,约翰感冒了;h[2],肺病;或h[3],胃灼热。直觉上,只有h1看起来令人信服。贝叶斯法则解释了原因。似然性倾向于h1和h[2]而非h[3]:只有感冒和肺病会引起咳嗽,因此会将数据概率提高到基线之上。相比之下,先验倾向于h1和h[3]而非h[2]:感冒和胃灼热比肺病常见得多。贝叶斯法则根据先验和似然性的乘积对假设进行加权,因此只产生像h1这样在两个项上都得分很高的解释。我们在第3章中提供了贝叶斯法则的更技术性介绍——以及它可以用来解决的问题范围。

贝叶斯推理可以用来解释人们如何从稀疏数据中学习。在概念

学习中,数据可能对应几个示例对象(如图1.1所示),而假设对应概念的可能延伸。为什么,在给出三个不同种类马匹的例子后,儿童会将”马”这个词泛化到所有且仅仅是马匹(h1)?

为什么不是h[2],“除克莱德斯代尔马外的所有马”,h[3],“所有动物”,或任何其他与数据一致的规则?似然性偏向更具体的模式,h1和h[2];如果这三个随机例子实际上是从更大的h[3]中抽取的,那么它们都落在较小的集合h1或h[2]内将是极其可疑的巧合(Tenenbaum & Griffiths, 2001a)。

先验偏向h1和h[3],因为作为更连贯和独特的类别,它们更可能是语言中常见词汇的指称对象(Bloom, 2000)。只有h1在两个方面都得分很高。同样,在因果学习中,数据可能是事件之间的共现;假设则是连接这些事件的可能因果关系。似然性偏向使共现更可能发生的因果链接,而先验偏向符合我们背景知识的链接,即什么样的事件可能导致哪些其他事件;例如,疾病(如感冒)比症状(如咳嗽)更可能导致症状,而不是相反。

从这些角度来看,贝叶斯定理为回答关于归纳推理的问题提供了一个简单的定量框架。特别是,它指出了先验知识应该如何与数据结合产生新结论。这建立了一个研究程序,我们可以从人们观察到的数据和得出的结论反推出必然指导他们推理的知识。这个表征人们归纳偏见的项目,以先验分布的形式表达,

描述了我们在认知的贝叶斯模型方面的大部分早期工作(例如,Tenenbaum, 2000; Tenenbaum & Griffiths, 2001a; Griffiths & Tenenbaum, 2001, 2006)。在此过程中,我们还开发了复杂的实验方法,基于统计学和计算机科学中使用的算法来揭示人类先验分布(见第10章)。例如,在某些假设下,从人到人传递的信息——如在传话游戏中——将收敛到反映参与者归纳偏见的形式(Griffiths & Kalish, 2007)。这些方法使得量化人们在广泛问题范围内的抽象知识成为可能,为我们形成关于其形式和起源的概括提供了要素。

抽象知识为学习提供了重要约束,但以什么形式?这带我们到下一个问题,Q2:我们的抽象世界知识在不同领域和任务中采取什么形式?对于概念学习或因果推理等复杂认知任务,不可能简单地列出每个逻辑上可能的假设及其先验和似然。必须有更复杂的知识表示形式作为贝叶斯认知所需的概率生成模型的基础。

在传统的联想或连接主义方法中,学习的统计模型定义在大型数值向量上。学习被视为估计联想记忆中的强度、神经网络中的权重或高维非线性函数的参数(McClelland & Rumelhart, 1986; Rogers & McClelland, 2004)。相比之下,贝叶斯认知模型在定义计算机科学和AI中使用的更结构化符号知识表示形式的概率方面最成功,如图、语法、谓词逻辑、关系模式和函数程序。不同的表示形式用于捕捉人们在不同领域和任务中的知识,以及不同抽象层次的知识。

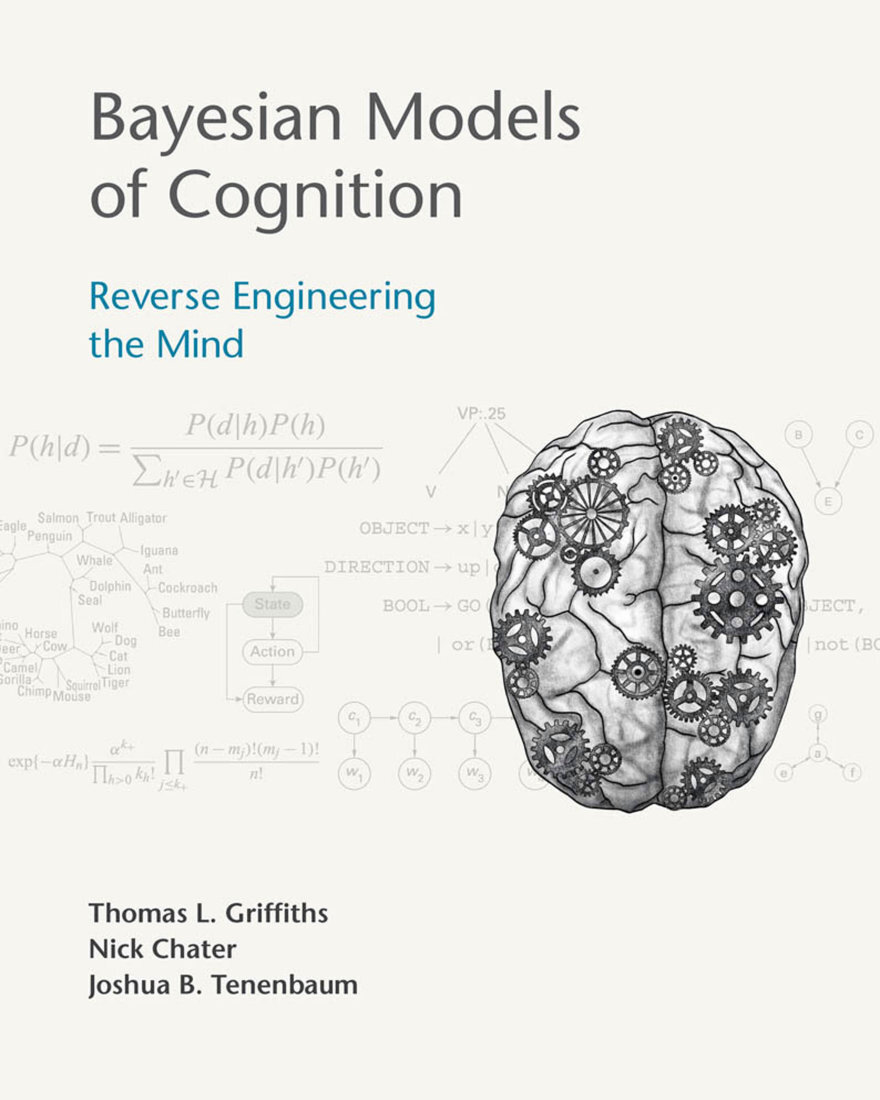

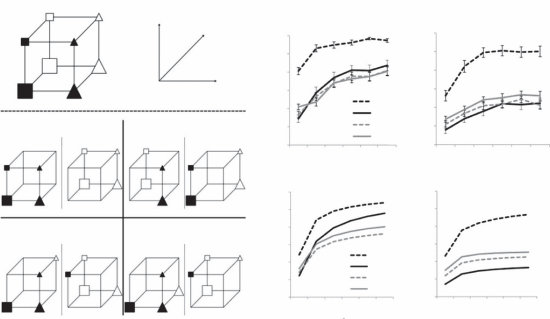

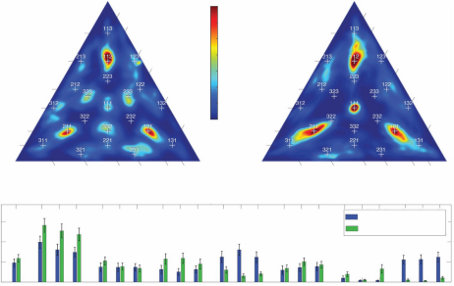

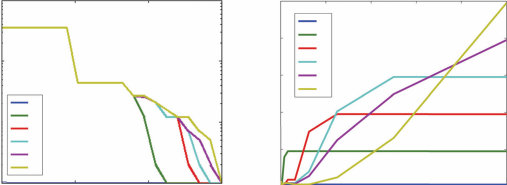

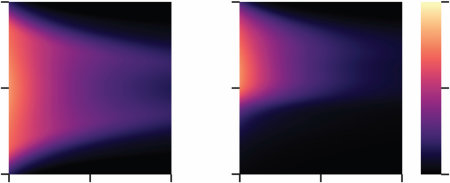

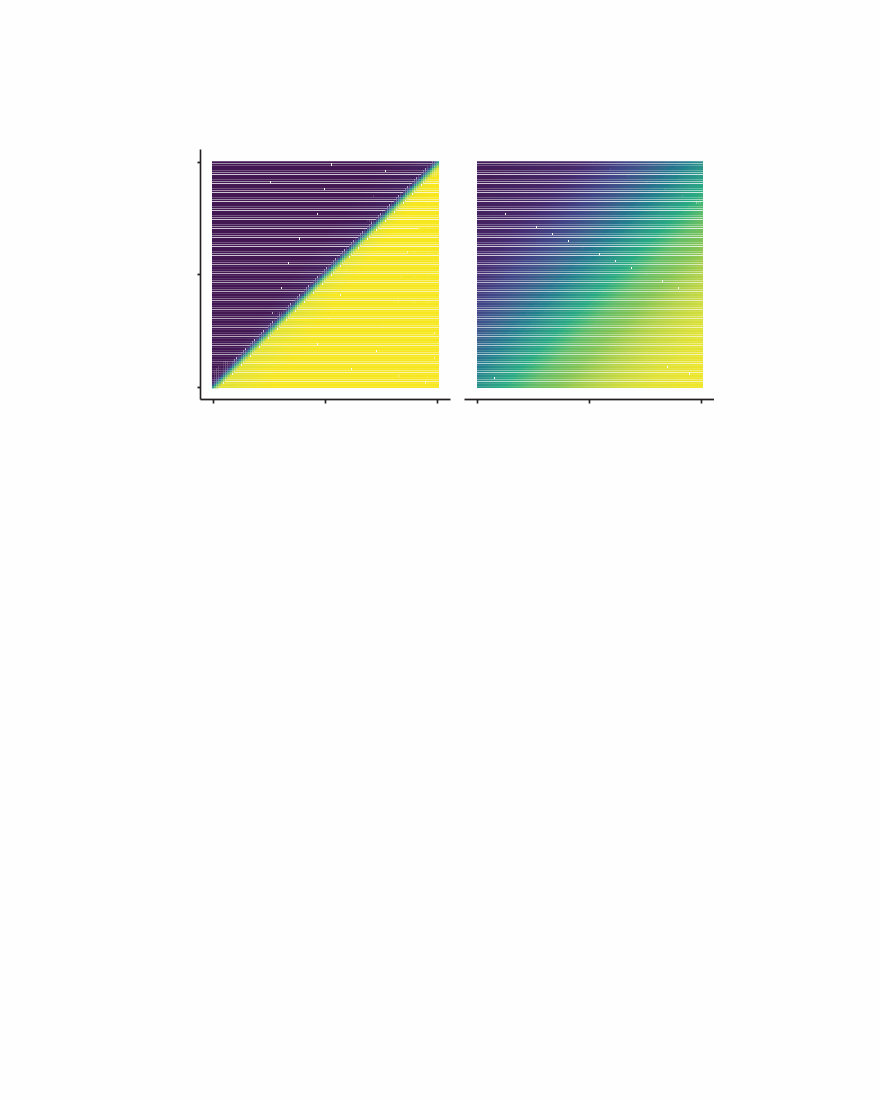

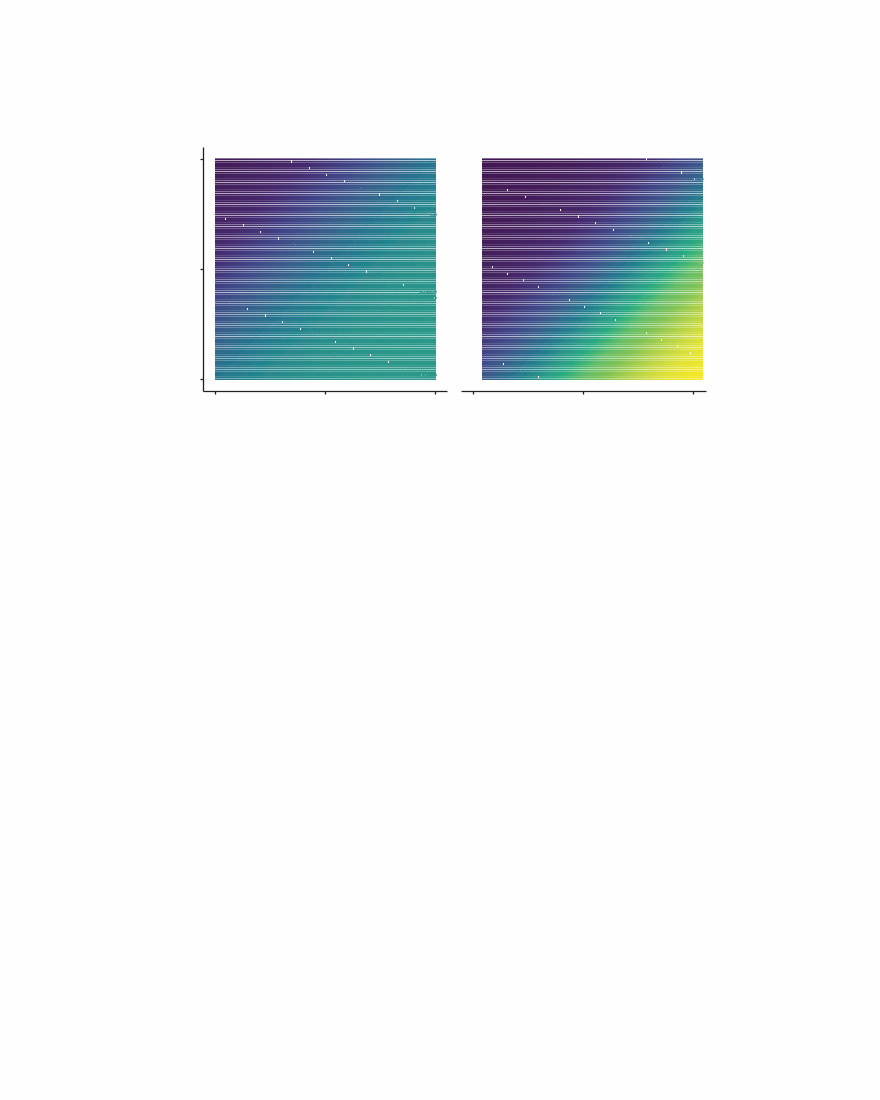

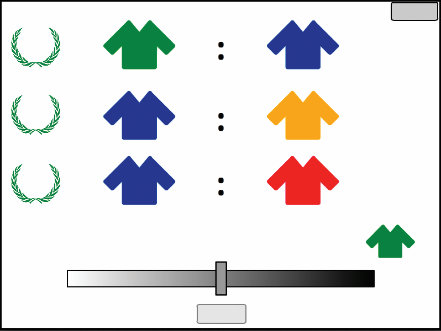

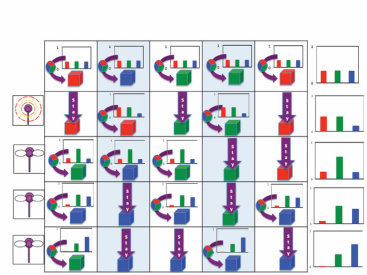

在从例子学习词汇和概念时,指导儿童和成人概括的知识已经通过定义在树状结构表示上的概率模型得到很好的描述(如图1.1b所示)(Xu & Tenenbaum, 2007)。对自然种类的其他生物概念的推理——例如,给定牛和犀牛的肌肉中有蛋白质X,马或松鼠有这种蛋白质的可能性有多大?——也通过假设树中相近对象可能共享属性的贝叶斯模型得到很好的描述(Kemp & Tenenbaum, 2009)。然而,树绝不是通用表示。对其他种类类别或属性的推断最好用不同形式的概率模型来捕捉(图1.2):用于城市地理属性推理的二维(2D)空间或网格,用于价值或能力推理的一维(1D)顺序,或用于物种因果传播属性(如疾病)的有向网络(Kemp & Tenenbaum, 2009)。

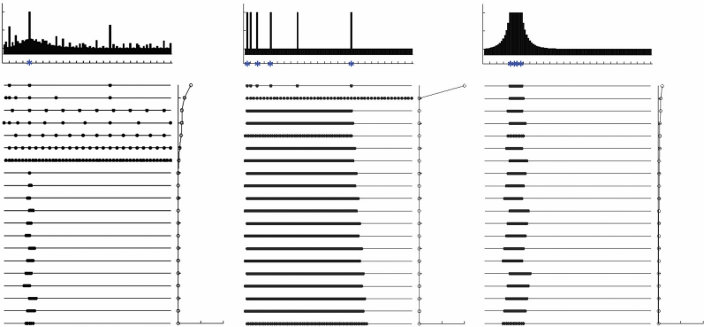

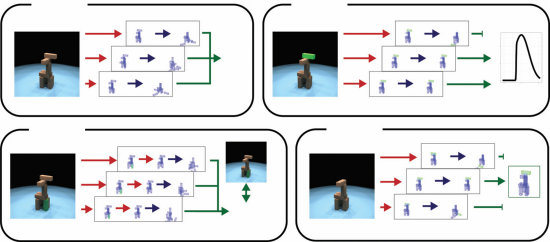

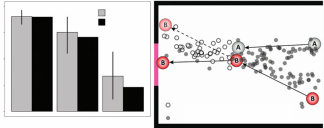

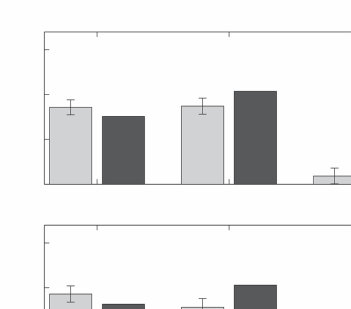

更一般地,关于原因和结果的知识可以用有向图模型表达(Pearl, 1988):一种图结构,其中节点表示变量,节点间的有向边表示概率因果链接(见第4章)。例如,在医疗环境中(见图1.3a),节点可能表示患者是否感冒、咳嗽、发烧或其他症状,边的存在或缺失显示感冒往往导致咳嗽和发烧,但不导致胸痛;肺病往往导致咳嗽和胸痛,但不导致发烧;等等。

鹰、鲑鱼、鳟鱼、鳄鱼

鸡、知更鸟、企鹅、鬣蜥、雀鸟、鲸鱼

安克雷奇

开普敦、金沙萨、金沙萨、马德里、惠灵顿、伦敦、柏林、东京、布达佩斯、悉尼、内罗毕、莫斯科、符拉迪沃斯托克、符拉迪沃斯托克、伊尔库茨克、开罗、开罗、马尼拉、马尼拉、珀斯、德黑兰、德黑兰、上海、上海、雅加达、特征、孟买、曼谷

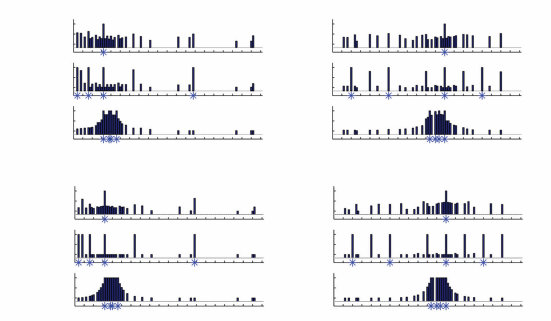

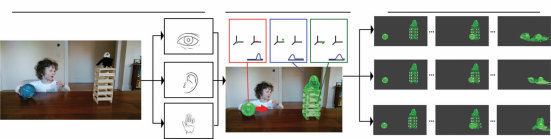

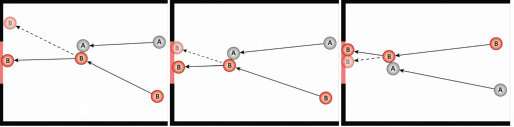

图1.2

Kemp和Tenenbaum(2008)展示了如何使用定义在图语法上的层次贝叶斯模型来发现领域中的结构形式。模型的底层是一个对象及其属性的矩阵,或对象对之间的相似性。矩阵的每个单元格表示给定特征(列)是否在给定对象(行)中被观察到。上一层是描述属性如何在对象上分布的图。直观上,图中相近的对象预期会共享属性。在最高层,语法规则指定了领域中的结构形式——从初始种子节点生成受约束形式图的规则。搜索算法试图找到形式语法和由该语法生成的图的组合,使其共同获得最高概率。(a) 给定动物特征的观察,算法推断树结构最好地解释了数据。找到的最佳树在多个尺度上捕获了直观合理的类别。(b) 同样的算法发现历史美国最高法院大法官的投票模式最好由线性”左右”光谱解释。(c) 颜色之间的主观相似性最好由圆形环解释。(d) 给定地球上城市之间的邻近性,算法发现了类似于纬度和经度的圆柱表示:环与环的交叉乘积。(e) 给定在两个维度(种族和男性化)上变化的逼真合成人脸图像,算法成功恢复了潜在的2D网格结构:两个链的交叉乘积。图改编自Tenenbaum等人(2011)。

这样的”因果图”代表了一种简单的直觉理论(intuitive theory)(Gopnik等人,2004),但从有限数据中学习因果网络依赖于更抽象知识的约束(Griffiths & Tenenbaum,2009)。例如,学习医学状况之间的因果依赖关系需要更高层次的框架理论(framework theory)(Wellman & Gelman,1992)来支持,该理论指定两类变量(或节点)——疾病(D)和症状(S)——以及因果关系(或图边)倾向于从D流向S,而不是在这些类内部,或从S流向D(图1.3a-c)。这种抽象框架可以使用定义在关系数据结构上的概率模型来表示,如图模式(graph schemas)(Kemp,Tenenbaum,Niyogi,& Griffiths,2010b),基于节点类型的图模板,或概率图语法(graph grammars)(Griffiths & Tenenbaum,2007b),在精神上类似于已成为表示语言知识标准的字符串概率语法(Chater & Manning,2006)(见第16章和第17章)。在最抽象的层次上,因果性本身的概念,即支持外部代理干预或操纵的有向关系(Woodward,2003),可以表述为一组逻辑法则,表达对连接行动和可观察事件的有向图结构的约束(图1.3d)。

1 2 3 4 5 6 1 2 3 抽象 7 8 9 10 4 5 6 0.4 11 12 13

7 原则 8 9 10 11 12 13 14 15 16 … c 1 14 15 16 c … … 2

结构 结构

s

数据 数据 tie nt

pa

条件

ts

en

ev

变量

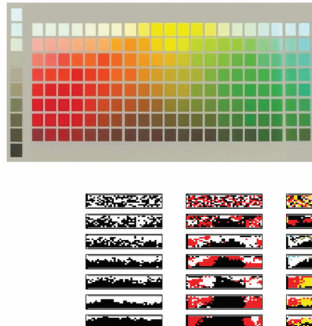

图1.3

在图模式上定义的层次贝叶斯模型(Hierarchical Bayesian models, HBMs)可以解释直觉理论是如何获得的,以及如何用于从有限数据中学习特定的因果关系(Kemp et al., 2010b)。(a) 一个简单的医学推理领域可能由16个变量之间的关系来描述:前6个编码”疾病”的存在或不存在(上排),与接下来10个”症状”(下排)有因果联系。这个网络也可以可视化为一个矩阵(右上,链接用黑色显示)。因果学习任务是基于观察这些变量在一组患者中的状态数据来重构这个网络。(b) 二层HBM形式化了自下而上的因果学习,或使用网络上无信息先验的学习。底层是数据矩阵。第二层(结构)编码假设的因果网络:灰度矩阵可视化了在观察n个患者的条件下,每个成对因果链接存在的后验概率;将此矩阵与(a)中显示的黑白真实矩阵进行比较。当n = 80时,推断出虚假链接(灰色方块),当n = 20时,几乎没有检测到真实结构。(c) 三层非参数HBM(Mansinghka, Kemp, Tenenbaum, & Griffiths, 2006)添加了一层抽象原则,即图模式。模式对下层(因果网络结构)编码先验,约束并因此加速因果学习。模式和网络结构都从(b)中观察到的相同数据中学习。模式通过将变量1-6分配到类C1,变量7-16分配到类C2,以及偏好仅C1 → C2链接的先验,发现了疾病-症状框架理论。这些分配以及有效类别数(这里是两个)都是自动推断的。尽管这个三层模型比(b)中的模型有更多自由度,但学习更快更准确。有n = 80个患者时,因果网络几乎完美识别。甚至n = 20个患者就足以学习高层C1 → C2模式,从而将网络层的不确定性限制在哪些疾病引起哪些症状的问题上。(d) 用于学习抽象因果理论的HBM(Goodman et al., 2011)。最高层是用一阶逻辑表达的定律,代表因果关系的抽象属性、外生干预在定义因果方向中的作用,以及可能将事件标记为外生干预的特征。这些定律对下层可能的有向图模型施加约束,后者又用于解释变量上观察到的事件模式。给定来自几个因果系统的观察事件和最高层可能定律的假设空间,模型快速收敛到基于干预的因果关系的正确理论,并使用该理论约束关于特定因果网络的推断。图改编自Tenenbaum et al. (2011)。

每种知识形式都使不同类型的先验分布自然地定义,因此对归纳施加不同的约束。成功的泛化依赖于正确获得这些约束。虽然归纳约束通常是分级的,但最容易理解的是定性约束的效果,这些约束简单地限制学习者可以考虑的假设(即,将许多逻辑可能假设的先验设为零)。例如,在包含n个对象的领域上学习概念时,有2n个子集,因此有2n个逻辑上可能的新概念扩展假设。假设概念对应于对象上特定二叉树的分支,如图1.1b所示,将此空间限制为仅n - 1个假设。在学习16个变量的因果网络时,大约有1046个逻辑可能的假设(有向无环图),但将假设限制为二分疾病-症状图的框架理论将此减少到大约1023个假设。知道哪些变量属于疾病和症状类别进一步将此限制为大约10^18个网络。假设空间越小,学习者的泛化准确性越高,但只有当要学习的真实结构仍在学习者假设空间内或附近(在概率意义上)时才如此(McAllester, 1998)。因此,我们对人类心理表征的最佳解释通常类似于科学家如何表征相同领域的简化版本,如生物物种的树形结构,这并非巧合。一个近似世界实际运行机制的紧凑描述为归纳学习提供了最有用的约束形式。

1.2.3 抽象知识的起源

对抽象知识的需求——以及正确获得它的需求——将我们带到了Q3:学习者如何学习他们需要知道的东西来使学习成为可能?儿童如何知道哪种树结构是组织词汇学习假设的正确方式?在更深层次上,学习者如何知道给定的实体和概念领域应该使用树结构来表示,而不是低维空间或其他形式?或者在因果学习中,人们如何达到正确的框架理论,比如对抽象的疾病(disease)和症状(symptom)变量类别的知识,以及从疾病到症状的因果联系?

抽象知识或新归纳约束的获得主要属于认知发展的范畴(Gopnik & Meltzoff, 1997; Carey, 2009)。例如,学习词汇的儿童最初假设对象有一个扁平的、相互排斥的分类到可命名的聚类中;只有后来他们才发现类别应该组织成树结构层次(如图1.1所示)(Markman, 1989)。这样的发现在科学进步中也是关键的:德米特里·门捷列夫(Dmitri Mendeleev)通过提出元素的周期结构启动了现代化学,卡尔·林奈(Carl Linnaeus)著名地提出生物物种之间的关系最好用树结构来解释,而不是更简单的线性顺序(前现代欧洲的”存在大链条”)或其他形式。

心理学家和科学哲学家长期以来一直认为这种结构洞察在其机制上是深度神秘的——更像是魔法而不是计算。统计学和机器学习中用于无监督结构发现的传统算法——包括层次聚类、主成分分析、多维尺度分析和团检测——假设单一固定形式的结构(Shepard, 1980)。与人类儿童或科学家不同,它们无法学习多种结构形式或在新数据中发现新形式。认知发展的传统方法都没有完全令人满意的回应:先天论者假设如果认知的不同领域以质量上不同的方式表示,那些形式必须是先天的(Chomsky, 1980; Atran, 1998);另一方面,连接主义者建议这些表示可能是学习的,但在关联权重的通用系统中,最多只能近似 [介绍] [贝叶斯] [认知科学] [方法] [[19]]

图1.4

一个说明迁移学习的思想实验。(a) 单独来看,观察从袋子中抽出的一颗蓝色弹珠几乎无法告诉我们其他可能抽到的弹珠的颜色。但如果我们也观察了同类型的其他几个袋子的几次抽取,就会产生超假设(overhypothesis):袋子在颜色上是同质的,尽管颜色在袋子之间有所不同。(b) 层次贝叶斯模型解释了如何获得这种超假设,并表明仅从一个例子就能对新袋子的分布做出强有力的泛化。

树、因果网络和人们似乎明确知道的其他结构形式(Rogers & McClelland, 2004)。

贝叶斯认知建模者通过将本章描述的结构化知识表示与贝叶斯统计学中被称为层次贝叶斯模型(hierarchical Bayesian models)的先进方法相结合来回应这些挑战(HBMs; Gelman, Carlin, Stern, & Rubin, 1995)。HBMs通过假设不仅有解释数据的单一层次假设,而且有多个层次:假设空间的假设空间,以及先验的先验,来解决假设空间和先验的起源问题。跨所有层次的贝叶斯推理允许特定学习任务所需的假设和先验本身在更大或更长的时间尺度上被学习,同时它们约束较低层次的学习(见第8章)。

在机器学习和AI中,HBMs主要用于迁移学习(transfer learning)或学习如何学习(learning to learn):从先前相关任务的经验中获得归纳约束(Kemp et al., 2007)。这个想法在当代机器学习文献中关于元学习(metalearning)的研究中得到体现(见第12章)。学习如何学习也是人类认知的核心,并且是HBMs在认知建模中的第一个突出应用。图1.4说明了基本数学,而图1.5说明了人类认知发展研究中的一个经典例子,该例子已用这种方法建模,即早期词汇学习中形状偏见(shape bias)的获得。

HBMs对于寻求解释人们如何获得适合不同领域的不同形式抽象知识的认知科学家特别有价值。Kemp和Tenenbaum(2008, 2009)展示了基于图和语法表示定义的HBMs如何发现支配领域中相似性的结构形式。各种形式的结构——树、聚类、空间、环、顺序和其他——都可以表示为图,而每种形式的抽象原理都表达为 [20] [J.] [B.] [Tenenbaum,] [T.] [L.] [Griffiths,] [and] [N.] [Chater]

[摘要] [α = 0.1] [α = 5] [形状] [材质] [是一个dax。] 原则 [ϕ] [形状] [ϕ] [材质]

[哪个是dax?]

[θ] [材质]

[类别结构] i [θ] [形状]

数据 [[“wib”] [“zup”] [“div”] [“lug”] [“dax”]]

[类别] […] i

图1.5

作为用于生成该形式图的简单语法规则。嵌入在层次

贝叶斯框架中,这种方法可以发现许多现实世界领域的正确结构形式(语法),以及适当形式的最佳结构(图),如图1.2所示。特别是,它可以推断出图1.1a中新颖物体的层次组织(如图1.1b所示)比替代表示(如二维空间)更好地拟合了

人们在这些物体中看到的相似性。

层次贝叶斯模型也可以用于学习抽象因果知识,如

疾病和症状的框架理论(图1.3)以及其他简单形式的直觉理论(Kemp et al., 2010b)。Mansinghka等人(2006)展示了如何学习表示两类变量疾病(D)和症状(S)的图模式(graph schema),以及从D到S变量运行的因果链接偏好,这些可以从支持学习特定疾病和症状之间因果链接的相同数据中学习——并且学习得同样快或更快(图1.3b,c)。学习到的模式反过来显著加速了下一层级特定因果关系(有向图结构)的学习。首先获得大局观——在确定任何特定疾病-症状链接之前发现疾病导致症状——然后使用该框架来填补特定知识的空白,这是一种独特的人类学习模式。这种模式在儿童发展和科学进步中占据重要地位,但以前并不适合理性或统计学习模型的框架。

虽然这种HBM对因果网络的假设空间施加了强大而有价值的约束,但它也极其灵活:它可以发现由任意数量的变量类别和变量在这些类别中如何连接的任何成对规律模式定义的框架理论。认知科学贝叶斯方法简介 [21]

甚至变量类别的数量(疾病-症状理论中为两个)也不需要事先知道。这是通过另一个最先进的贝叶斯工具实现的,称为无限模型或非参数贝叶斯模型(见第9章)。这些模型假设无界的结构量,但对于给定的数据集,只有有限多个自由度被积极参与(Rasmussen, 2000)。贝叶斯推理中体现的对简单性的自动偏好平衡模型复杂性和拟合度,确保新结构——在这种情况下是新的变量类别——只有在数据真正需要时才会引入。

图1.3c中节点类别的特定非参数分布是中国餐厅过程(CRP),它在机器学习和认知建模的许多领域都具有更广泛的影响。CRP模型首次提供了人们如何在没有直接监督的情况下形成新类别的原则性解释——包括当类别数量未知时的类别数量(Anderson, 1991a; Sanborn, Griffiths, & Navarro, 2010a; Griffiths, Sanborn, Canini, & Navarro, 2008c)。当观察到每个物体时,CRP模型推断该物体是最好通过同化到现有类别来解释,还是通过假设一个以前未见过的类别来解释,如图1.6所示。这是任何终身学习者在理解未知复杂性世界时面临的基本问题。看到新事物的第一个实例时,你如何知道它真的是一种新类型,还是仅仅是熟悉类型的奇怪实例?例如,第一次看到斑马或骆驼时,你可能试图将其理解为有黑白条纹的马或有两个驼峰的马。CRP捕获的不同概率压力的权衡使得以原则性和计算效率的方式回答这个问题成为可能。

非参数贝叶斯模型背后的基本原则——假设你

看到世界无限复杂性中的一小部分—可以应用到学习的其他方面。贝叶斯模型的优势之一是,底层的生成模型可以组合起来创建新的模型。如果我们假设不仅对象本身,而且对象的属性也形成聚类,我们就得到了一个新模型:CrossCat模型(Shafto, Kemp, Mansinghka, & Tenenbaum, 2011),如图1.7所示。在现实世界中,由于其复杂性,单一的对象分类方式很少是充分的。不同类型属性的产生可能最好通过不同的对象分类方式来解释。早期的分类模型通常忽略了这种复杂性,但CrossCat通过发现捕获这些不同属性子类别的不同视角的聚类来捕获这种复杂性。非参数贝叶斯公式使CrossCat能够自动发现视角的数量和每个视角内类别的数量,还允许当遇到新对象、新属性或两者时,两个层次的结构都能增长。

中国餐厅过程(CRPs)可以嵌入到许多其他情况的概率模型中。例如,在语言方面,它们被用来解释儿童如何在未分割的语音中发现单词(Goldwater, Griffiths, & Johnson, 2009),学习形态学规则(Johnson, Griffiths, & Goldwater, 2007b),以及将词汇意义组织成层次语义网络(Griffiths, Steyvers, & Tenenbaum, 2007; Blei, Griffiths, & Jordan, 2010)(图1.8)。这种树状结构的语义网络长期以来一直被研究人类记忆结构和动态的认知心理学家所假设。然而,只有随着复杂的非参数贝叶斯模型的出现,我们才能够解释人们如何[22] [J.] [B.] [Tenenbaum,] [T.] [L.] [Griffiths,] [and] [N.] [Chater]

短吻鳄

蚂蚁

蝙蝠

蜜蜂

海豚

蜻蜓

鹰

雀

青蛙

蚱蜢

鬣蜥

水母

豹

猴子

章鱼

鸵鸟

猫头鹰

企鹅

蟒蛇

海鸥

海豹

绵羊

蝙蝠

海豚

豹

猴子

海豹

绵羊

短吻鳄

青蛙

鬣蜥

蟒蛇

鹰

雀

鸵鸟

猫头鹰

企鹅

海鸥

蚂蚁

蜜蜂

蜻蜓

蚱蜢

水母

章鱼

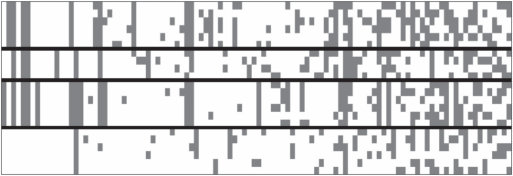

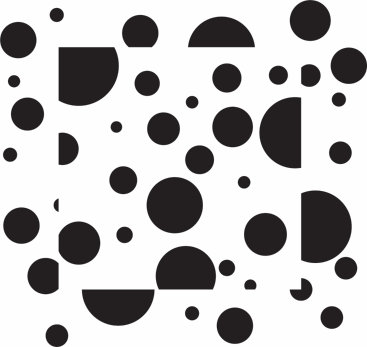

图1.6

使用中餐厅过程(Chinese Restaurant Process, CRP)进行无监督分类的说明图。(a) 数据由动物物种(行)及其解剖学、生理学、行为学和生态学属性(列)的矩阵组成。只有每隔一列才有标签。(b) 使用CRP作为先验的贝叶斯模型推断出动物最好分为四个大的分类学类别,大致对应哺乳动物、爬行动物和两栖动物、鸟类以及昆虫和无脊椎动物。类别数量和动物到类别的具体分配都是自动推断的。相对于(a),行已重新排序以反映这四个类别,列已根据模型解释程度——它们在类别内的”纯净度”重新排序。图改编自Shafto等人(2011)。

能够从无监督的语言经验中发现这样的心理模型。一个相关但新颖的非参数构造,印度自助餐过程(Indian buffet process, IBP)解释了在对象分类过程中如何构建新的感知特征(Griffiths & Ghahramani, 2006; Austerweil & Griffiths, 2011)。

更一般地说,非参数贝叶斯模型解决了人类学习者在一生知识增长过程中面临的主要挑战:平衡约束和灵活性,或者说在任何时刻限制可用于泛化的假设的需要,与扩展假设空间、学习世界可能运作的新方式的能力之间的平衡。

在分层模型的更高层次放置非参数分布产生灵活的 认知科学的贝叶斯方法介绍 [23]

豹子 [[豹子]]

羊 [[鳄鱼]]

海豹 [[蟒蛇]]

海豚 [[海豹]]

猴子 [[海豚]]

蝙蝠 [[青蛙]]

鳄鱼 [[水母]]

鬣蜥 [[章鱼]]

青蛙 [[企鹅]]

蟒蛇 [[雀鸟]]

雀鸟 [[海鸥]]

鸵鸟 [[猫头鹰]]

海鸥 [[鹰]]

猫头鹰 [[蜻蜓]]

企鹅 [[蝙蝠]]

鹰 [[蚱蜢]]

蚱蜢 [[蚂蚁]]

蚂蚁 [[蜜蜂]]

水母 青蛙 蜜蜂 [[羊]]

猴子

章鱼 [[鬣蜥]]

蜻蜓 [[鸵鸟]]

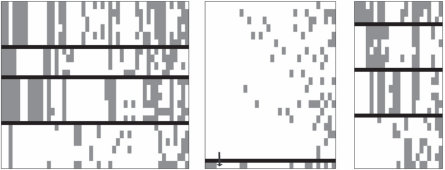

图1.7

使用CrossCat模型进行多分类”视角”的无监督发现的说明图(Shafto等人,2011)。基于图1.6中的动物-属性数据,CrossCat发现了三个视角,显示在这里的三个面板中。左侧视角完全对应于图1.3b中Chinese restaurant process发现的分类学分类。主要的核心生物学属性与此视角相关:解剖学和生理学特征,如”有骨头”、“产卵”、“是温血动物”、“有喙”等等。中间视角由许多特异性属性组成——在这个数据集中,这些特征只有少数物种具有,并且不会与许多其他属性以连贯的方式共变。右侧视角最有趣,因为它捕获了一个直观上令人信服且连贯的结构,这个结构完全被CRP遗漏,但对许多自然推理任务可能很重要。在这里,物种根据生态位和捕食者/猎物角色进行分类:从上到下,各组对应于陆地捕食者、水生物种、空中物种和陆地猎物。相关属性同样主要是生态学相关的——“凶猛”、“是肉食动物”、“生活在水中”、“会飞”、“吃动物”等等——这些不能很好地用该领域的主导分类学类别结构解释,但能很好地适应这种组织物种的替代方式。如图1.6所示,只标注了每隔一列。图表改编自Shafto等人(2011)。

较低层次的归纳偏差,而贝叶斯对简单性的偏好确保了随着知识增长,约束和灵活性的适当平衡。

通过几个抽象知识学习的案例研究——发现结构形式、因果框架理论,以及通过迁移学习获得的其他归纳约束——发现HBM中的抽象化可以学得非常快,与较低层次的学习所需数据相比,需要的数据相对较少。这是因为HBM较高层次的每个自由度都会影响——并汇集来自——下层许多变量的证据。HBM的这一特性被称为抽象化的祝福(blessing of abstraction)(Goodman, Ullman, & Tenenbaum, 2011)。它提供了一条自上而下的知识起源路径,与两种经典方法形成鲜明对比:先天论(nativism)(Chomsky, 1986; Spelke, Breinlinger, Macomber, & Jacobson, 1992),假设抽象概念从出生时就存在;以及经验主义或联想主义(empiricism or associationism)(Rogers & McClelland, 2004),其中抽象化是构建的,但只是近似地,并且只是缓慢地,以自下而上的方式,通过将许多经验层叠在一起并过滤出它们的共同元素。因此,只有HBM似乎适合解释人类抽象知识的两个最显著特征:它可以从经验中学习,并且可以在生命早期就显著地参与,为更具体的学习任务提供约束。

24 J. B. Tenenbaum, T. L. Griffiths, and N. Chater

hiv

重组 聚合酶 复制 dna 类 tcr 病毒 pax 球蛋白 病毒的 肿瘤 fgf prp hla 感染 前列腺 视网膜 抗体 朊病毒 nk ccr 突触的 视杆细胞 抗 hd mhc 受体 光感受器 癌症 gata 谷氨酸 能量 gaba 时间 ca 方法 链 理论 荧光 t cd 视觉 细胞 神经元 抗原 皮层 大脑 任务 il 神经元的 听觉 残基 皮层 刺激 螺旋 记忆 结构 酶 折叠 催化的 app 位点 状态 ps 结构 notch 反应 THE 淀粉样

囊壳 OF 阿尔茨海默

IN AND 肝素 fn A 基因 物种 基因组 进化 序列 酶 遗传的 基因组 植物 生物合成 种群 基因座 植物 酸 种群 拟南芥 大肠杆菌 叶子 合成酶 hsp 过氧化物酶体的 apo 尿素 固定 cho 气候 雄性 纤溶酶原 pex 全球的 雌性 hta 铁 pts 碳 雄性 pu fe 胆固醇 氧气 化石 雌性 宿主 ra 年 性的 o 毒力 rar 血红素 寄生虫 甾醇 疟疾 ldl 寄生虫

图 1.8

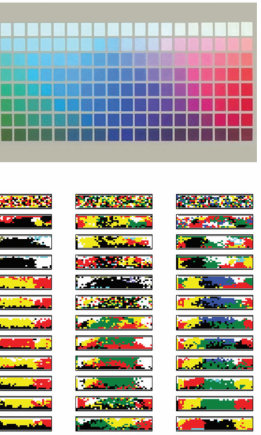

[嵌套][中餐厅][过程]是一个非参数层次模型的基础,该模型能够从文本语料库中自动发现类似人类的语义网络(Blei et al., 2010)。该模型的输入是大量文档集合,以语言中每个词在该文档中出现次数来表示。输出是一个”主题”的根树,以及每个文档指向树中某个叶节点的指针。在这里,文本语料库由来自美国国家科学院院刊的摘要组成。主题是具有共同语义主题的特征词分布,例如这里的”神经科学”或”进化生物学”,或在树的较低层级,更细粒度的主题,如”突触可塑性”或”感知”。显示了每个主题的几个最具特征性的词汇。该模型试图通过将每个文档中观察到的词汇分布与从根到包含该文档的叶节点路径上的主题特征词组合进行拟合来解释语料库数据。图改编自Blei et al. (2010)。

1.2.4 使用知识指导行动

到目前为止,我们一直专注于知识的形式以及如何获得知识。

然而,对于任何有机体来说,知识的真正价值在于它使得采取更明智的行动成为可能。那么我们应该如何选择做什么呢?这将我们带到Q4:我们如何使用我们的世界模型来做决策并在世界中成功行动?

认知贝叶斯模型的一个优点是,它们在贝叶斯统计学中的基础为这个问题提供了直接的答案。近一个世纪以来,统计学家和概率论者一直在探索信念与行动之间的关系,产生了关于统计决策理论的大量文献(见第7章)。如果人们对其行动结果的偏好满足一些简单规则,那么这些偏好可以通过为每个可能结果分配效用(utility)来捕捉(其中更高的效用表示结果更理想)。一个理性智能体,对世界有信念

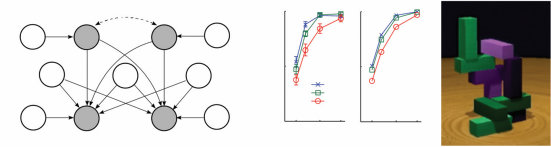

图1.9

一个序列决策问题。(a) 我们如何从起始点(左下角)到达目标(右上角的绿色和黄色方块),在避开蓝色和黑色显示的障碍物的同时尽可能高效?这个问题可以形式化为一个MDP,其中状态对应于智能体的位置,行动是智能体可以移动到的地方,奖励是到达目标的正收益,但路径上的每一步都有小的成本。(b) 人们对这些问题的表征可以用认知资源的有效利用来解释。顶行显示了一个试图在最小化考虑对象数量的同时找到路径的模型所表示的对象。底行显示了人类参与者在解决导航任务后被问及这些对象时对它们的意识程度。图改编自Ho et al. (2022)。

以假设的概率分布表达,寻求最大化其行动结果的期望效用。

统计决策理论的原理超越了个体决策,使得描述智能体应该如何执行一系列相互依赖的行动成为可能。例如,考虑图1.9a所示的问题。目标是到达右上角的黄色方块,从左下角标有圆圈的方块开始。从每个方块,可用的行动是向上、下、左或右移动到相邻方块。然而,蓝色和黑色显示的障碍物无法穿越——试图穿过它们会导致留在同一方块中。你做出的每一步移动都会改变你的位置,从而改变你可用的选择。

这种序列决策问题可以用马尔可夫决策过程(Markov decision process, MDP)来描述,其中智能体的当前位置被编码为系统的状态,行动(概率性地)修改该状态(在第7章中有更详细的描述)。到达目标提供一些奖励,但到达那里的每一步都有成本。目标是最大化期望长期奖励,即智能体采取的所有行动的总和。以这些术语表达,可以使用动态规划等复杂算法来计算每个状态下的最优行动——智能体在这种情况下应该遵循的策略(policy)。

MDP在贝叶斯模型和心理学中的两个经典主题之间提供了联系:问题解决和强化学习。问题解决自Herbert Simon和Allen Newell的开创性工作以来一直是认知心理学的核心主题,他们以在抽象”问题空间”中的搜索来描述它:每个可能的行动

导致一个新状态,该状态具有另一组可能的行动,从而产生决策的分支树结构(Newell & Simon, 1972)。对于确定性任务,这种问题表述精确地映射到马尔可夫决策过程(MDP)的结构上。然而,马尔可夫决策过程通过允许行动仅以概率方式影响状态的可能性来扩展这一想法——例如,尝试的行动有一定失败的可能性。在部分可观察马尔可夫决策过程(POMDPs)中可以引入更多不确定性,这种过程允许智能体实际上不知道自己处于什么状态,而需要从可观察特征中推断这些信息。在图1.9a所示的例子中,智能体可能不是从左下角开始,而是从随机选择的方格开始,必须基于附近障碍物的有限感知信息来识别该方格。这种不确定性是许多现实世界问题解决情况的固有特征,因此解决马尔可夫决策过程和部分可观察马尔可夫决策过程的方法为我们提供了关于人类认知的丰富思想来源。

强化学习引入了另一种不确定性:到目前为止,我们一直假设智能体知道其行动的后果,但如果这也必须学习呢?强化学习问题是在缺乏关于行动如何修改状态或可能产生什么成本或奖励信息的情况下,试图找到马尔可夫决策过程的最优策略。智能体必须通过经验获取这些信息。这可以通过两种截然不同的策略来完成:无模型(model-free)方法专注于简单学习在给定状态下要采取的最佳行动,也许通过估计与每个行动相关的奖励;同时,基于模型(model-based)方法试图估计与每个行动相关的状态和奖励的概率分布,然后通过解决结果马尔可夫决策过程来找到最优策略(Daw, Niv, & Dayan, 2005)。这两种策略映射到人类认知的不同方面。无模型学习类似于人类与许多其他动物共享的联想学习机制,在状态和行动之间形成联想。基于模型的学习更加深思熟虑,为使用本章讨论的获取和表示知识的复杂工具提供了机会。

目前,在人工智能应用中占主导地位的强化学习算法属于无模型类别(广义上)。这些算法基于使用大型神经网络来学习状态与行动相关奖励之间的关系(Mnih et al., 2015)或直接学习策略(Sutton, Precup, & Singh, 1999)。这种方法具有影响力,部分原因是现代机器学习专注于能够生成这些系统学习做出良好决策所需的大量数据的环境。例如,对于电脑游戏、棋类游戏或模拟环境,通过根据需要多次运行游戏或模拟来获得所需的尽可能多的数据是容易的。人类学习者能够从数量级更少的数据中学习新任务,因为他们能够构建其环境的明确模型,从而显著约束学习问题。能够学习结构化表示,如直接从数据中学习简单程序,使得从有限经验中学习复杂策略成为可能(Tsividis et al., 2021)。

到目前为止,我们将贝叶斯推理作为归纳问题的理想解决方案。以这种方式使用,贝叶斯方法让我们能够预测任何智能体应该如何解决这些问题。实际上,我们在认知贝叶斯模型方面的大部分工作都受到Roger Shepard的想法启发,即我们应该能够通过思考所有智能体需要解决的抽象问题的理想解决方案来识别认知的普遍规律(Shepard, 1987)。

然而,这样的理想解决方案不仅在最优意义上是理想的,而且在无法实现的意义上也是理想的。大型概率模型中精确推理的高计算成本意味着人类思维和大脑最多只能近似贝叶斯计算,就像在任何工作的贝叶斯人工智能系统中一样(Russell & Norvig, 2021)。这提出了问题5:在计算资源有限的思维中,如何有效地实现复杂世界模型的学习和推理?

回答这个问题的一种方法是参考计算机科学和统计学中用于近似贝叶斯推理的算法(见第6章)。从这个角度来看,关键研究问题是:思维使用什么近似算法?它们与人工智能中的工程近似有什么关系?它们如何在神经回路中实现?

人们已经追求了这些问题的两种不同答案。一条研究路线专注于蒙特卡罗(Monte Carlo)或基于随机采样的近似,作为理解贝叶斯推理如何在思维、大脑和机器的所有这些层面上实际工作的统一框架(Sanborn, Griffiths, & Navarro, 2006; Brown & Steyvers, 2009; Fiser, Berkes, Orbán, & Lengyel, 2010; Vul, Goodman, Griffiths, & Tenenbaum, 2014)。这种方法在第11章中进行了回顾。在结构丰富的模型中进行蒙特卡罗推理是可能的(例如,Goodman, Mansinghka, et al., 2008a),但非常缓慢;构建更高效的采样器是当前工作的主要焦点。

另一条研究路线专注于通过用更易于处理的概率分布来替代复杂概率计算的近似方法。特别是,在训练人工神经网络方法方面的最新进展使得训练这样的网络来近似任意概率分布成为可能。通过训练神经网络来在给定观察数据的条件下近似假设的后验分布,我们可以创建一个摊销推理(amortized inference)系统,该系统付出显著的前期成本(训练)来降低新观察的推理成本(Dasgupta & Gershman, 2021)。这种方法在第12章中进行了总结。

不同算法近似贝叶斯推理的可用性产生了一个新问题:我们如何知道使用哪种算法?即使我们选定了一种算法——比如从后验分布中采样的算法——我们如何知道要抽取多少样本?考虑这些问题需要思考近似质量与计算所需时间之间的权衡——这些量可能对任何人类决策都至关重要。对这种权衡的早期研究产生了一个也许令人惊讶的结果:在许多情况下,抽取单个样本就能达到正确的平衡(Vul et al., 2014)。这种一次完成(one and done)策略的副作用是解释了一个奇特的观察:当人们执行建模为贝叶斯推理的任务时,他们选择假设的概率往往与这些假设的后验概率密切对应。这种概率匹配(probability matching)正是我们在基于单个样本做出决策时所期望的。

考虑这种权衡为另一个关于我们如何从如此少的信息中获得如此多内容的问题提供了答案:我们如何在有限的计算资源下实时解决如此广泛的归纳问题?答案必须是我们很好地利用了这些有限的资源,对如何以及何时进行近似做出了明智的决策。这个想法引发了一波研究浪潮,探索我们能在多大程度上用认知资源的合理使用来解释人类行为(概述见Lieder & Griffiths, 2020,以及本书第13章)。当应用于决策制定时,这种观点提供了一种方法来调和卡尼曼和特沃斯基的启发式和偏见(heuristics and biases)研究项目(例如,Tversky & Kahneman, 1974)与认知的贝叶斯模型,将好的启发式定义为在近似质量和计算成本之间取得正确平衡的方法。

明智地使用我们的认知资源不仅意味着使用高效的算法——我们在做决策时遵循的启发式和策略。这也意味着使用高效的表征。我们可以将相同的视角应用于问题解决文献中的另一组经典问题:人们如何选择问题的哪些方面进行表征?他们如何选择有意义的子目标?这些问题可以根据特定表征对规划的支持程度来分析。例如,当人们解决像图1.9a所示的序列决策问题时,他们似乎会最小化在问题表征中包含的对象数量。图1.9b显示了假设每个对象都与表征成本相关的模型的预测,人们在这种成本与他们能够形成的计划质量之间进行权衡(Ho et al., 2022)。

像采样和摊销推理这样的方法为我们提供了一种方式来了解人类思维和大脑如何能够执行贝叶斯推理中涉及的挑战性计算。然而,当我们考虑涉及人们世界模型的全部复杂性的问题时,即使这些算法也会遇到困难。这一挑战是Q6的核心:世界模型如何在物理机器、大脑或计算机中实现?

这一挑战部分源于我们的发现,即形式化直观理论的完整内容似乎需要图灵完备的组合表征,甚至超越了概率一阶逻辑(Milch, Marthi, & Russell, 2004; Kemp, Goodman, & Tenenbaum, 2008b),正如我们在第17章中发展的,到通用概率编程语言(universal probabilistic programming languages)(Goodman, Mansinghka, Roy, Bonawitz, & Tenenbaum, 2012)(第18章)。

值得注意的是,所有可计算概率模型和条件分布的类别在这些语言中很容易定义,使用一种称为随机λ演算(stochastic λ-calculus)的形式化方法。原则上它涵盖了任何计算代理可能执行的任何贝叶斯推理。这包括关于最能解释(最可能生成)观察数据集的程序的贝叶斯推理——换句话说,概率程序的贝叶斯学习(Bayesian learning of probabilistic programs)。有效约束具有如此灵活表征的学习是一个挑战,有效实现或甚至粗略近似在如此表达性语言中的概率推理和学习更是如此。我们在第18章和第19章中探讨这些问题,但对富结构程序类表征的高效和可扩展概率推理的最困难挑战大多仍有待未来工作。这也是一个严肃参与认知的神经计算基础可能有用,甚至必要的领域。

实际上,我们逆向工程思维项目的最大剩余挑战是

可能是理解不仅仅是概率推理,还包括结构化符号知识,以及对符号结构的推理,如何在神经回路中表示。连接主义模型传统上通过否定——或避免讨论如何——大脑实际编码如此丰富的知识这一命题来回避这些挑战。相比之下,贝叶斯方法试图直接参与认知科学和人工智能传统,展示显式符号表示和语言对思维的各种价值,但随后神经实现这些结构的挑战就变得突出。揭示它们的神经基础可以说是认知神经科学中最大的计算挑战——我们现代的心身问题。

本章目前的焦点一直是如何构建心智——识别各个组成部分,如分层和非参数贝叶斯推理、结构化表示,以及用于行动和思考的智能策略,我们认为这些解释了人类认知的不同方面。但心智不仅仅是被构建的——它们还会成长。如何可能培养一个心智?这一切是如何开始的?这就是Q7:我们世界模型在进化和发展中的起源是什么——婴儿大脑中内置了什么,孩子们如何在起点内外进行学习?

如前所述,哲学对这些问题提供了两种观点:强调先天知识的先天论观点,以及强调学习的经验论观点。现代发展心理学提供了这些立场的更细致版本。核心知识传统的发展心理学家认为,学习只有在一些先天的抽象概念库存(如agent(代理)、object(对象)和cause(因果))的基础上才能起步,以提供分割经验的基本本体论(Carey, 2009; Spelke, 2022)。当然,心理表征的某些方面是先天的,但在不争议这一点的情况下,贝叶斯建模者最近论证,即使是最抽象的概念原则上也可能被学习。例如,表达为有向图结构逻辑约束的抽象因果概念可以从HBM中的经验中学习,该模型在许多特定因果系统的网络结构中进行泛化,如图1.3d所示。遵循”抽象的祝福”,这些约束可以仅从每个网络行为的小样本中诱导出来,并反过来为新系统实现更高效的因果学习(Goodman et al., 2011)。这种分析如何扩展到其他抽象概念(如agent或object),以及儿童是否实际以这种方式获得他们最深层的抽象概念,仍然是基本开放的问题。

虽然HBM已经解决了简单形式抽象知识的获得问题,但它们只涉及认知发展中最困难的主题:核心常识领域的框架理论,如直觉物理学、心理学和生物学(Carey, 1985, 2009; Gopnik & Meltzoff, 1997)。已经采取了第一步来解释发展中的心理理论——儿童如何理解明确的错误信念(Goodman et al., 2006)和偏好的个体差异(Lucas, Griffiths et al., 2014)——以及直觉生物学中本质主义理论的起源,以及在直觉物理学中形成关于磁力和其他新力量的信念(Griffiths & Tenenbaum, 2007b; Kemp et al., 2010b; Bonawitz, Ullman, Bridgers, Gopnik, & Tenenbaum, 2019; Ullman, Stuhlmüller, Goodman, & Tenenbaum, 2018)。

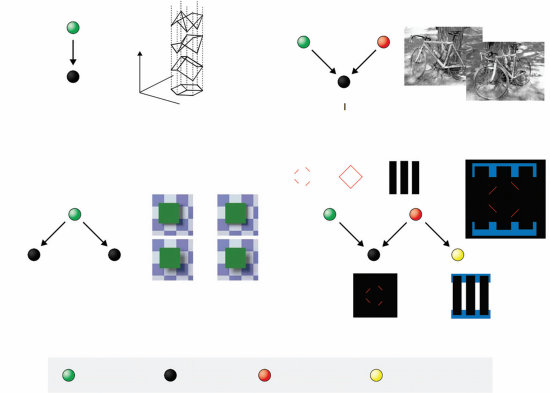

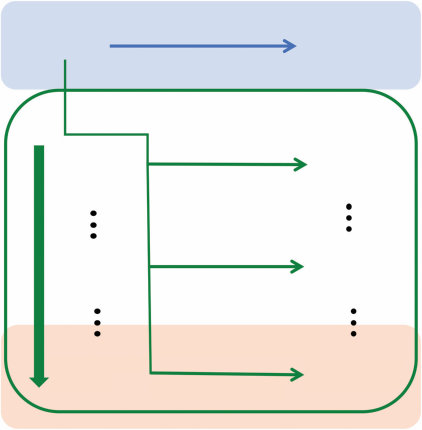

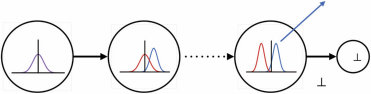

我们将在第20章中概述其中一些发展模型,以及旨在从对象系统、场所系统和代理系统的角度捕捉幼儿一些最早核心知识能力的最新工作(图1.10)。总的来说,这些可以通过对概率生成模拟器的贝叶斯推理进行建模,表示围绕一套近似和

世界状态 代理状态

感知

图像(t) 图像(t+1) 对象 行动代理

图1.10

受Spelke和Kinzler (2007)以及Spelke (2022)启发,幼儿在直觉物理学和直觉心理学方面的核心常识能力,可以通过对世界结构化生成模型的概率推理来建模,这在某些方面类似于视频游戏引擎的简化和近似——因此这些模型通常被称为”头脑中的游戏引擎”(Ullman, Spelke, Battaglia, & Tenenbaum, 2017)。这些模型捕捉了儿童在短时间和空间尺度内,在一系列可能行动下概率性地模拟可能或潜在未来结果的能力——从而选择能够产生期望结果的行动(a)。以这种方式建模的核心系统包括(b)用于预测动态物理事件的对象系统,例如球的滚动及其与积木堆的碰撞(如(a)中所示),以及(c)用于在空间中导航和定向的位置系统,与用于推理他人信念如何通过目标导向规划产生行动并通过感知推理和推理过程更新其信息内容的代理系统相集成。

我们称之为”头脑中的游戏引擎”的简化(Ullman et al., 2017; Lake, Ullman, Tenenbaum, & Gershman, 2017)。由此产生的架构作为认知发展中先天能力的候选假设,以及早期学习的计算基础(Ullman & Tenenbaum, 2020)。在第14章和第15章中,我们介绍了这些模型以及它们作为成人直觉物理学和直觉心理学模型被严格和定量测试的一些方法。我们还概述了这些模型如何整合到统一的”概率思维语言(PLoT)“认知架构观点中,利用概率编程语言中知识表示和推理的基本基于仿真的性质(第18章),并介绍程序归纳方法,通过这些方法,这些模拟器可能在学习和发展过程中扩展超越其初始核心能力(第19章)。

贝叶斯定理的标准表述,如方程(1.1),设想学习者从数据中进行推理。但这些数据从何而来?在我们到目前为止讨论的许多模型中,这些数据由世界生成,从学习者试图构建世界模型来捕捉的过程中采样。但实际上,人类学习很大程度上依赖于不同类型的数据:由人产生的数据。我们不可能直接体验足够多的世界来构建所有与指导智能行动相关的世界方面的丰富模型。因此,我们依赖他人告诉我们他们的经历,为我们提供以支持学习的方式结构化的数据,并有效地积累和提炼他们反过来学习的人的见解。理解这些数据来源是回答我们最后一个问题Q8的关键:扩大学习规模以涵盖人类在其一生中获得的所有知识以及人类文化在几代人中构建的知识需要什么?

与其他学习范式(如人工神经网络)相比,认知贝叶斯模型的一个独特方面是它们需要精确指定关于数据如何生成的假设。贝叶斯定理中的P(d|h)项需要纳入数据生成过程的模型,以便能够为我们可能观察到的每个d分配概率。这种对数据采样方式的敏感性甚至在早期的概念学习贝叶斯模型(Tenenbaum, 2000)和词汇学习模型(Xu & Tenenbaum, 2007)中就得到了探索。

关于采样假设的早期工作发展成为使用贝叶斯模型理解教学法和交流原则的丰富文献。通过分析教师考虑什么数据对学习者最有益的教学思维,以及学习者假设教师正在进行这样的思考过程,产生的模型显示了如何用非常少量的数据传达复杂概念(Shafto, Goodman, & Griffiths, 2014)。

语言更广泛地为应用认知贝叶斯模型提供了丰富的机会,不仅在理解语言的各个方面是如何学习的,而且在了解人们如何从他人所说的话中学习和推理。实际上,在有影响力的语用语言推理理性言语行为(Rational Speech Act)框架中起作用的是相同的原则(Goodman & Frank, 2016),该框架提供了一种理解经典发现的方法,即人们话语的解释既取决于他们说了什么,也取决于他们没有说什么(见第16章)。这里的技巧是,听者不局限于阅读所说内容的字面意思——听者也知道说话者选择使用那个特定的话语(而不是各种各样的其他可能性)——因此,假设说话者试图尽可能提供信息,这允许听者推断出超出实际所说内容的信息。例如,听到”这部戏有许多好的”

特质”时,听者很可能会推断说话者认为这部戏至少有同样多的不良特质,而且说话者总体上很可能不喜欢这部戏,否则他们会更加积极正面。推理图景还更加复杂,因为说话者在选择用词时知道听者会做出这样的推断(即说话者会使用贝叶斯推理来推断听者的理解)。听者也可能会考虑到这一事实,从而上升到更高层次的推理;这个过程可以无限制地继续下去,除非受到我们计算能力的限制。

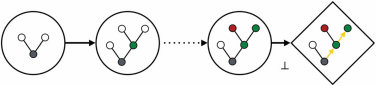

语言中的贝叶斯语用学也可以看作是更一般的贝叶斯”心理理论”或”心智化”(mentalizing)处理的特例:这是人类观察其他主体行为并推断产生这些行为的信念、欲望和意图的核心能力,假设这些行为是主体大脑中近似理性的目标导向规划和决策过程的结果。第14章发展了建模心理理论的贝叶斯方法,重点是理解在我们周围和我们本地环境中移动的主体的行为,在相对较短的空间和时间尺度上,正如Baker、Saxe和Tenenbaum (2009)、Lucas、Griffiths等(2014)、Jern、Lucas和Kemp (2017)、Jara-Ettinger、Gweon、Schulz和Tenenbaum (2016)、Baker、Jara-Ettinger、Saxe和Tenenbaum (2017)以及Ullman等(2009)的开创性工作所发展的。该框架的核心观点是,个体通过观察他人的行为来推断他们的意图和信念,然后”反转”主体的规划过程。贝叶斯逆向规划不是基于给定意图预测未来行为(如前向规划和理性决策;见第7章),而是从观察到的行为开始,反向推导出最有可能产生这些行为的意图和信念。为了实现这一点,该模型使用贝叶斯规则,将关于行为者偏好和意图的先验信念与观察到的行为的可能性相结合(假设这些意图假设了一个近似理性的规划者),从而产生可能意图的后验分布。这种方法提供了一种结构化的方式来根据潜在心理状态解释他人的行为,不仅为我们提供了人类理解和预测他人行为能力背后的候选机制,而且为人类社会认知和更广泛的认知文化基础开辟了广阔的洞察和建模机会景观。

最后,贝叶斯方法可以用来阐明文化学习的某些方面。通过考虑信息在一系列贝叶斯学习者中传递时如何变化,我们可以探索这些学习者的归纳偏见如何影响文化传播过程的结果(见第10章)。这种迭代学习过程可以改变正在传播的信息,使其与学习者的先验更加一致,从而使后续学习者更容易学习(Griffiths & Kalish, 2007)。这提供了一种理解代代相传的文化对象如何被人类大脑塑造的方式。在这种观点下,语言——从一个说话者传递到另一个说话者——应该会改变以采取更容易学习的形式,这为理解人类学习者如何能够从有限数据中习得这些语言提供了另一种方式。

在本书中介绍贝叶斯方法时,我们选择强调其根本哲学是逆向工程的事实。要创建认知的贝叶斯模型,我们首先要思考大脑正在解决的计算问题。这涉及识别可用于学习的数据,指定关于这些数据是如何生成的假设,并为这些假设分配先验概率。然后贝叶斯规则表明该问题的理想解决方案,生成可以与人类行为进行比较的预测。如果我们看到模型和行为之间的对应关系——特别是如果我们进行进一步的实验来测试模型的预测时这种对应关系仍然成立——那么我们就有了一种理解人们为什么可能在做他们正在做的事情的方式,以及一个我们可以用来制造执行类似任务的机器的模型。

这种逆向工程方法体现了David Marr首次阐述的在认知科学中取得进展的观点——分析层次的概念。Marr (1982)认为信息处理系统可以在三个层次上进行分析:计算层次描述系统解决的问题以及在自然环境中从可用输入计算其解决方案的原则;算法层次分析描述执行以产生这种解决方案的程序以及算法操作的表征或数据结构;实现层次指定这些算法和数据结构如何在大脑或机器的电路中实例化。逆向工程意味着从计算层次开始,在深入算法和实现之前试图理解系统的功能。因此,我们将其称为自上而下或功能优先方法(Griffiths等,2010)。这个想法在Anderson (1990)的理性

分析,专注于根据环境所带来问题的适应性解决方案来分析认知,并产生了一些开创性的贝叶斯认知模型。

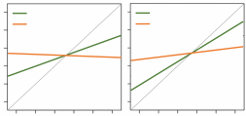

许多早期的贝叶斯模型只处理计算层面,将认知纯粹以功能性术语描述为给定环境中近似最优的统计推理,而不涉及如何执行计算(Oaksford & Chater, 2001; Tenenbaum & Griffiths, 2001b; Griffiths & Tenenbaum, 2007b)。后续工作,如我们在Q5回答中总结的那些,已经开始探索如何使用相同的优化原理来指导较低层面的研究。资源理性分析(resource-rational analysis)(Griffiths, Lieder, & Goodman, 2015)明确旨在理解人们的认知过程——一个算法层面的问题——将其视为解决方案质量与计算成本之间权衡的最优解决方案。

对最优解决方案作为理解人类认知洞察来源的关注,是将认知科学中的贝叶斯模型与统计学、机器学习和人工智能研究连接起来的部分原因。这些学科专注于解决推理和优化问题,提供了可以应用于理解人类认知的丰富解决方案来源。在机器面临与人类相似的计算问题的程度上,我们也可以希望将人类的解决方案反向输出到这些不同的学科中。

这种逆向工程视角将认知的贝叶斯模型置于与心理学传统计算建模努力略有不同的类别中。虽然认知心理学家通常可能希望阐明人类行为背后的机制,但我们在本书中提出的模型在另一个抽象层面上运作。

将这些模型作为认知过程的声明是混淆的潜在来源(这一点在第22章中进一步讨论)。例如,用贝叶斯推理来解释概念学习并不意味着我们期望人们在头脑中明确计算贝叶斯法则。这意味着该模型的假设——特别是关于归纳偏差(inductive biases)的假设——与人们的行为相一致,帮助我们根据对概念学习任务抽象表述的理想反应来理解该行为。

当我们发现贝叶斯模型捕捉到人们的行为时,对于他们头脑中发生的事情有几种可能性。在罕见情况下,他们可能实际上明确执行贝叶斯推理。更典型的是,他们遵循一种策略,隐式地允许他们近似贝叶斯法则指示的理想解决方案。

这使我们能够预测他们在其他情况下的行为方式,并为我们提供关于可能在起作用的表征和算法类型的线索。它还突出了人们行为背后的隐含假设,这些假设可以提供更深入的洞察,或者允许我们构建做出类似假设的机器。

这可能引起的一个担忧是它是否会产生一个可证伪的理论。许多科学家使用波普尔(1959/1990)强调的标准来评估理论,认为理论只有在做出可以测试并可能被证明为假的预测时才有价值。我们概述的方法——其中我们需要假设人们产生接近问题最优解决方案的东西,以使逆向工程有效——听起来并不特别可证伪,因为我们可以在如何定义问题及其解决方案方面做出很多选择。我们同意这一点——最优性的基本假设是不可证伪的。但它也不是作为理论声明而意图的。我们并不是在断言人们是最优的、理性的,或者符合某些特定的理想。相反,我们建议这个假设可以作为生成人类认知解释的手段而有用——一个方法论框架,而不是一个意图被证伪的理论。在这个理论内生成的个别理论可以被测试并被证明是错误的,但通过考虑计算问题的理想解决方案来理解人类认知的更广泛想法是一个应该基于其在产生有意义解释方面的效用来评估的框架。这种观点与更近期的科学哲学家(例如,Lakatos, 1970; Godfrey-Smith, 2003)所采取的立场一致,为波普尔倡导的对证伪的狭隘关注提供了更新。

我们概述了一种根据对丰富结构化、分层生成模型的贝叶斯推理来理解认知及其起源的方法。虽然我们远未完全理解人类思维如何工作和发展,但贝叶斯方法在几个方面使我们更接近这一目标。首先是统一数学语言的前景,用于将认知框架为归纳问题的解决方案,并以最少的自由参数和临时假设构建原则性的思维定量模型。另一个更深层的贡献是一个理解思维为什么以这种方式工作的框架,即根据适应现实世界环境结构的理性推理,以及思维对世界的了解——抽象模式(abstract schemas)和直觉理论(intuitive theories),这些只能通过它们如何约束泛化来间接揭示。

最重要的是,贝叶斯方法让我们超越了长期塑造和限制认知科学辩论的经典”非此即彼”二分法:“经验主义对

nativism,” “domain-general versus domain-specific,” “logic versus probability,” 以及 “symbols versus statistics。” 相反,我们可以提出更难的逆向工程问题,并获得足够丰富的答案来帮助我们构建更像人类的AI。领域通用的学习和表征机制如何构建领域特定的知识系统?结构化符号知识如何通过统计学习获得?正在出现的答案提出了思考认知系统发展的新方式。强大的抽象可以令人惊讶地快速学习,与更具体的知识一起学习或在学习之前就被获得。结构化符号表征不必是僵化的、静态的、硬连线的或脆弱的。嵌入在概率框架中,它们可以动态且稳健地响应经验中稀疏、嘈杂的数据而增长。

总的来说,我们在本书中提出的方法提供了一种统一的数学语言,可以在所有认知科学领域中使用。归纳问题出现在认知科学家传统研究的所有领域中:不仅仅是学习和推理,还有视觉、语言、社会互动,甚至基本的认知过程如记忆和注意力。它还在AI和认知科学之间、工程和逆向工程之间架起了桥梁。即使人工神经网络目前主导着AI中使用的方法,我们相信这里阐述的原理对于理解任何类型的智能系统都是必不可少的。它们还可以帮助我们理解人们如何从少量数据中学习并充分利用他们有限的认知资源——这两种能力与训练AI系统时使用的大量数据和计算的增加形成了鲜明对比。因此,当这些AI系统开始达到数据和计算规模化的极限时,它们可以为下一步发展提供指导,如果我们想要构建更像人类学习和思考的AI系统,它们也可以为现在的发展提供指导。

Nick Chater, Thomas L. Griffiths, and Joshua B. Tenenbaum

认知科学的创立目标是以计算术语理解心智和大脑。如果大脑要被理解为一种生物计算机,那么关于计算原理上如何工作的想法将是创建心智/大脑工作假设时的重要灵感源泉。因此,为了逆向工程心智,我们应该从致力于构建智能机器的工程学科中寻找灵感。因此,正如我们在第1章中描述的,认知科学的起点是其孪生学科人工智能(AI)和更广泛的计算机科学。

不过,这种描述在各种方式上都过于简化了。首先,即使心智是一种生物计算机,我们也应该期待它看起来和运作起来都与我们实际构建的任何计算机或编写的计算机程序非常不同。当然,这在逆向工程中普遍如此——心脏可能是一个泵,但它与任何人类设计的泵都非常不同,且远更复杂。大脑看起来当然不像硅芯片,所以如果大脑是生物计算机,与真实计算机的任何关系都可能是相当抽象的,绝不明显。其次,逆向工程不仅需要被动地从计算机科学家碰巧为其他目的创造的工具中进行选择(如进行算术运算或构建数据库)。实际上,通过解决人类智能如何工作的问题,认知科学本身有助于启发新的计算思想和方法。正如在科学的其他领域一样,自然可以为新的工程解决方案提供灵感。因此,洞察在支撑AI的工程学科和认知科学的逆向工程项目之间双向流动。

然而,不可避免地,如果我们通过逆向工程的视角来看待认知科学项目,我们应该期待该领域的发展受到可用的工程、计算和数学工具和技术库存的强烈影响。在本章中,我们描述了认知科学中建立在不同工程思想风格基础上的三个有影响力的传统:符号AI、连接主义(connectionism)和认知的理性方法。本书探索的观点可以被视为这些方法中每种关键洞察的综合。这种综合的可能性本身依赖于新的工程发展,特别是使用和学习复杂概率模型的技术,即在结构化表征(如图、语法或程序)上定义的概率模型。探索这些模型及其在帮助理解人类认知多样化领域中的应用,是本书的核心主题。

本章从这个角度概述了认知科学的一些历史,以及它与其孪生学科AI的相互作用。前三节依次描述了符号、连接主义和理性研究传统。基于第1章,我们然后注意到来自机器学习、计算语言学等领域的工程发展如何

学、语言学和计算视觉学等领域的发展使得这些方法的综合成为可能,通过在复杂的符号表征上开发复杂概率模型的推理方法,这些表征最终可能在连接主义网络中实现并具有理性的理论依据。这种整合的观点为本书其余部分的叙述提供了起点,本书将介绍和解释复杂性逐步递增的认知概率模型。我们还将强调,逆向工程方法建议对心智采用自上而下的方法,专注于理解心智解决的计算问题,然后再转向实现其计算的神经硬件。尽管采用这种自上而下的焦点,如何将复杂的概率模型有效地嵌入到大脑的生物机制中仍然是未来研究的一个重大而关键的挑战。

我们已经注意到,认知科学的目标是从计算角度理解心智。因此,从1950年代末该学科开始时起,认知科学家很自然地以前十年左右出现的计算理论和实践为起点。这是非常有意识和自觉地进行的:因此,早期数字计算的核心特征被早期认知科学作为关于心智运作的假设而采纳。

实际上,早期认知科学和人工智能的两位先驱Allen Newell和Herbert Simon提出了物理符号系统假设:人类智能是一个符号操作系统,在大脑硬件中物理实例化,就像数字计算机通过在硅芯片中操作符号来运作一样(Newell & Simon, 1976)。

这在实践中意味着什么?让我们从一个简单的信息处理挑战开始,比如将单词列表按字母顺序排序。首先,我们需要某种表示单个单词的方法;我们需要某种数据结构来表示它们当前的顺序——通常是一种称为列表的数据结构。列表由可以对其执行的信息处理操作来定义。例如,给定一个列表,我们可以在开头添加一个新项目,这样pear可以添加到列表[banana, orange, blueberry]中,创建一个新列表:[pear, banana, orange, blueberry]。相比之下,在这种技术意义上的列表(不同于日常的”购物清单”意义),一个项目不能直接添加到列表的末端。我们还可以直接移除列表的第一个项目(或”头部”)(剥离pear)留下[banana, orange, blueberry](但同样,对于列表,我们不能直接剥离最后一个项目,blueberry)。

因此,将列表按字母顺序排列将涉及复杂的符号操作过程,其中项目被从列表中剥离出来,相互比较以查看哪个在字母表中更早,并最终重新组装成最终列表。这种符号操作过程

图2.1

图灵机:最简单的物理符号系统。图灵机由一个无限长的磁带组成,在磁带上可以写入和读取有限的符号集合(这个集合可以只有两个基本符号,我们可以标记为”0”和”1”,其他符号可以编码为0和1的字符串)。一个非常简单的”控制器”系统在磁带上一次移动一步。在每一步中,它只能读取其在磁带上当前位置的符号,根据该符号和控制器的当前状态(有限数量的可能状态之一),它可能重写磁带上的当前符号,和/或沿磁带向左或向右移动一步。随着时间的推移,磁带上的符号字符串将逐渐改变,表示计算的步骤,并在机器停止时最终给出计算的输出。一个简单但关键的进一步步骤是将磁带的符号视为分为两个块,其中一个块被视为应该在另一个块编码的数据上执行的算法。值得注意的是,这个极其简单的”可编程”计算机能够执行任何计算,尽管速度非常慢。体现在今天的数字计算机中,以及在Newell和Simon关于人类机器操作的提议中的物理符号系统,可以被视为图灵机的极其复杂和高效的精化。

受算法控制——一个程序,该程序详细说明了将我们从原始列表逐步带到排序列表[banana, blueberry, orange, pear]的步骤。

实际上,使用列表来排序项目是相当笨拙的,因为列表末尾的项目不能在不分解列表其余部分的情况下快速访问。所以我们

可能会选择不同的数据结构,比如一维数组,其中的项目可以通过数字(0, 1, 2…)直接访问,这些数字对应数组中的位置。

但即便如此,排序仍然出奇地缓慢和耗时,特别是当有很多项目时(例如,如果我们要将整本词典按字母顺序排列)。例如,一种策略是首先在数组中选择一个项目(通过任何方法),然后将原数组中的所有项目依次重新定位——如果它们在字母表中位于这个”pivot”项目之前,就放在一边;如果在字母表中位于其后,就放在另一边。然后我们对数组的左侧部分应用相同的方法(在该数组中找到一个pivot项目并根据该项目进行排序);接下来我们对数组的右侧部分做同样的操作。我们可以递归地继续这样做,直到每个子数组只包含一个项目(因此没有什么需要排序的)。这个过程被称为快速排序,但还有许多其他方法来排序列表。尽管看起来显而易见,但排序问题在计算机科学中是一个永恒的问题,一直是大量理论和实践研究的主题。

这就是顺序访问和随机访问内存之间的区别。

我们如何说服计算机遵循我们预期的符号操作的特定舞蹈?答案是我们需要指定一个算法,详细说明所需的符号操作序列。当然,算法将取决于正在操作的数据结构;它通常本身以符号形式编码,用计算机编程语言编写。因此,我们可能在Python、C++或任何其他编程语言中编写一个快速排序算法来将单词按字母顺序排列。

尽管如此——这只是排序:对认知科学来说不是一个非常丰富或有趣的任务。

如果我们想要表示视觉图像、对象、类别和自然语言句子的复杂性,更不用说科学和数学的抽象领域,我们将需要一系列丰富的表示,不仅包括列表和数组,还包括图、语法、逻辑形式等等。但是,从认知科学的符号处理视角来看,这最终只是更多相同的东西。符号计算涉及协调对任何类型数据结构内容的复杂操作的算法。

这种对复杂符号表示操作的强调,与前几十年心理学理论中行为主义学说占主导地位(例如,Skinner, 1953)形成了戏剧性的理论突破。行为主义者希望纯粹基于外部可测量的刺激和可观察的反应来建立心理学理论。心理或大脑内部表示的想法被拒绝为完全不科学的。关于心理的计算革命摆脱了这些担忧。数字计算机的例子显示了信息处理如何通过对数据结构的符号操作来执行,捕获任意丰富和复杂的信息,并在物理系统中实现它。特别是,虽然行为主义者将自己限制在将心理视为由各种刺激之间的关联(例如,铃声可能唤起通常随之而来的食物的想法)或反应与后续刺激之间的关联(例如,当一致地用食物奖励时,按压杠杆可能以某种方式得到强化)组成的观点,符号认知科学将心理的可观察输入和输出视为仅仅是极其复杂的信息处理系统表面的外围扰动。

语言为心理作为符号处理系统的观点所代表的思维根本转变提供了特别有力的说明。行为主义的语言观将单词视为与环境的各个方面相关联(例如,实际的狗与狗这个词相关联),并在彼此之间形成关联链,据说导致语言的顺序结构(Skinner, 1957)。但这个故事从未真正奏效,因为除其他原因外,语言依赖于不同大小的语言单位(词素、完整单词、名词和动词短语等)之间的复杂结构关系,而不是连续单词之间的关联(Chomsky, 1959)。语言以高度复杂和间接的方式指向世界(以及对世界的猜测、对世界可能如何的思考,或完全虚构的领域)。实际上,很难想象我们如何能够基于quick、brown和fox这些词的出现与实际快速的事物、棕色斑块和狐狸的呈现之间的关联来开始解释the quick brown fox的含义。单词之间的特定关系(狐狸既快速又棕色)和the这个词的功能(它告诉我们在我们碰巧谈论的任何语境中,有且仅有一只既快速又棕色的狐狸)在行为主义解释中同样令人困惑。

语言学家诺姆·乔姆斯基(Noam Chomsky),计算革命的关键人物之一

在思考心智时,乔姆斯基论证说句子具有树状的语法结构(Chomsky, 1957)。他直接借鉴并扩展了理论计算机科学的一个分支——自动机理论,论证说生成人类语言中所有且仅有的句子所需的底层机制必须相当复杂,肯定比单纯的词汇间联想或任何简单的联想泛化要复杂得多(我们将在第16章遇到其中一些问题,特别是乔姆斯基语言层次结构)。

乔姆斯基还与符号传统中的许多其他认知科学家一起提出,心智在自然语言(中文、豪萨语、芬兰语等)和单一内部逻辑表征之间进行转换。这种内部表征被认为能够捕获句子的逻辑形式——例如,明确表示存在一只既敏捷又棕色的独特狐狸,并允许进行诸如狐狸是棕色的、至少存在一样既棕色又敏捷的东西等推理。理解自然语言句子的逻辑形式是二十世纪前半期哲学分析传统的核心目标。然而,新颖的认知科学视角是将逻辑形式——以及构建它的逻辑表征系统——放入说话者和听话者的头脑中。也就是说,该提议认为心智表征并推理一种逻辑思维语言(Fodor, 1975)。实际上,这种思维语言可以被视为一个丰富、抽象且高度灵活的世界表征系统。此外,它不仅可以被视为提供了一个惰性的知识储存库,还提供了一种高级编程语言,允许通过对这些表征进行引导性逻辑推理链来定义算法(对应于计算机科学中的逻辑编程范式[Kowalski, 1974],最著名的体现是编程语言Prolog[Clocksin & Mellish, 2003])。

所提出的思维语言不仅被假定支撑句子的意义,还被认为是各种知识在记忆中编码并用作思维基础的格式。这是一个我们将在第18章关于概率思维语言假设中以贝叶斯视角重新审视的观点。

回到我们在第1章开头提出的问题,乔姆斯基还考虑了语言如何习得:儿童如何能够从如此少的材料(周围人们零散且不完整的话语语料库)中学到如此多的东西(即获得创造和表达无限数量潜在新颖思想的能力)。乔姆斯基的结论令人震惊:他论证说人类语言的复杂性实际上根本无法学习(Chomsky, 1980)。相反,他论证说所有人类语言所谓共同核心的蓝图必须以普遍语法的形式先天表征——儿童在接触实际言语时只能对这种普遍语法进行微调,使他们能够专注于周围的特定语言(无论是中文、豪萨语还是芬兰语)。在这一传统中,将普遍语法调整为要习得的特定语言的假定过程本身也被视为本质上是符号计算的问题,可以为其指定算法(Pinker, 1979; Gibson & Wexler, 1994)。

[42] [N.] [Chater,] [T.] [L.] [Griffiths,] [and] [J.] [B.] [Tenenbaum]

符号计算方法最初与更普遍的先天主义转向相关:该提议认为许多种类的知识主要不是从经验中学习的。相反,假定儿童拥有语言、道德、数学、对物理学或心理学的日常理解,甚至可能对范畴本身的先天知识(Fodor, 1975)。对于儿童如何能够显然从如此少的材料中获得如此多知识这一问题的答案,总体而言是大量知识是内置的,而不是通过经验学习的。虽然行为主义者曾假定心智是一块空白石板,可以在其上叠加任何种类的联想,但心智现在被视为包含丰富的预包装信息和算法,这些可能是通过数百万年的生物进化逐渐积累的(Fodor, 1983; Pinker, 2003)。正如在许多章节中(特别是第20章关于认知发展)将变得清晰的那样,本书的主要主题之一是贝叶斯逆向工程观点使我们能够对先天主义观点及其对立面——经验主义之间这场持久辩论提供更细致的视角。我们将看到,在计算模型中放入相当具体但有限的先天结构,在某些情况下至少可以使得从令人惊讶地少的经验中学习到极其丰富和强大的理解。但这超前了我们的讨论。

从具体辩论中退一步,值得反思符号方法理解认知的独特之处。符号到底是什么?用符号进行计算意味着什么?根据迄今为止的讨论,对于纽厄尔和西蒙来说,物理符号系统由符号表征的表达式(例如,列表、图表、数学和逻辑公式以及词汇)以及操作这些表征的一组过程(例如,添加、组合、复制或删除符号;将符号链接在列表或矩阵中;等等)组成。关键的是,符号和过程都以物理形式体现,最终以二进制0/1的形式体现。

硅芯片中的开关的情况(在传统数字计算机中)(实际上,正是这种离散的二进制基底,而不是处理连续值,使得传统计算机成为数字计算机)。正如我们所看到的,这些符号不仅仅是因果惰性的,就像纸上的墨水印记一样。相反,它们(以及最终编码它们的二进制开关)塑造并参与了作为计算过程的复杂编排。

当然,这些符号不仅仅是无意义的物理模式。至关重要的是,它们可以被视为具有解释,要么作为世界各个方面的表示(因此符号结构可以被视为编码知识),要么作为指定符号操作序列(因此它们可以被视为表示程序)。

Newell和Simon(1976)注意到数字计算机是物理符号系统假设的工作典型:数字计算机展示了如何通过符号的物理操作来解决问题、证明定理或进行简单的语言行为。因此,采用逆向工程的观点,他们提出人类思维具有相同的基础。认知即计算的想法被认为是计算应该被理解为符号操作的提议。

这些和相关的想法体现在早期人工智能和认知科学的研究项目中。例如,生成语言学方法(例如,Chomsky,1957)旨在用形式语法的术语来指定自然语言语法的知识,概率认知模型历史背景 [[43]]

指定为一组符号和符号操作过程(例如,重写规则,转换),可以生成每种语言的所有且仅有的可接受句子。从这个角度来看,解析句子的任务变成了将单词字符串的符号表示映射到分层树结构的问题,指示根据相关语言语法的该单词序列的句法推导。

类似地,语言产生问题除其他事项外,涉及创建这样的树并读取该树中单词的线性顺序以产生句子。学习语言涉及推断语言的形式语法规则,给定一组示例句子,可能与其他约束一起,如先天先验知识(见第16章)。

日常知识同样被假设编码在符号表示形式主义中,如情境演算(situation calculus)(McCarthy & Hayes,1969),语义网络(semantic networks)(Collins & Quillian,1969),框架(frames)(Minsky,1977)和脚本(scripts)(Schank & Abelson,1977)。然后推理被建模为对这种表示的逻辑推理(或对严格逻辑推理的轻微偏离)。在这个框架中,感知表示和过程也被视为本质上具有符号特征(例如,Marr,1982)。

此外,认知的这种符号方法的某些方面已经受到进一步工程发展的影响,如为计算机科学和人工智能的各个方面构建逻辑基础的项目(例如,Genesereth & Nilsson,1987)。因此,符号计算的许多方面已经被有效地解释为逻辑推理——并且有一个重要的研究方向来重构特定的编程语言,以及扩展的特定程序,以逻辑术语。根据这个观点,符号操作可以被视为正确或不正确,这取决于它们是否对应于某种逻辑解释下的有效推理。

此外,计算机编程中声明式方法的发展使这种逻辑观点变得具体(即,与程序员相关,而不仅仅是理论计算机科学家)。至少可以近似地将声明式计算机程序视为涉及各种事实、约束或关系的陈述,而不是概述指定符号操作序列的过程(如用C、BASIC或Pascal编写的计算机程序)。符号操作的模式通过自动推导这些事实、约束或关系的逻辑结果而间接产生。

计算机科学中逻辑方法的日益扩大范围与人工智能内部的情况并行,在那里,为了整理和扩展早期人工智能中体现的相当临时的程序,有越来越激烈的尝试来构建表示和推理的逻辑框架。类似地,认知科学的哲学开始从认知是符号操作的核心思想转向更具体的概念,即认知是对思维逻辑语言的机械化逻辑推理(Fodor & Pylyshyn,1988),这是我们很快将涉及的主题。

认知科学的符号方法在许多方面都取得了巨大成功。实际上,人工智能中广泛问题的现代工程方法基于这样的思想:知识可以使用复杂的符号表示来制定和操作,其中许多可以有效地用逻辑术语来理解。尽管如此,认知科学的符号方法对许多人来说似乎不足以解释 [44] [N.] [Chater,] [T.] [L.] [Griffiths,] [and] [J.] [B.] [Tenenbaum]

[S ]

[VP ]

[PP ]

[NP ]

[NP ]

[N ] [V ] [Prep ] [det ] [N ]

[Time ] [flies ] [like ] [an ] [arrow. ]

[Fnit ] [flies ] [like ] [a ] [banana. ]

[N ] [N ] [V ] [det ] [N ]

[NP ]

[NP ]

[VP ]

[S ]

图2.2

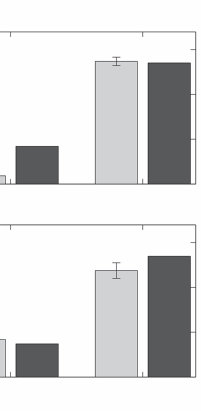

看似相似的词串可能具有非常不同的语法结构。“Fruit flies”可能指水果在空中投射的方式;“time flies”可能是一种罕见的苍蝇类型;但这些都不太可能。同样,“like a banana”似乎更自然地被解释为表达对香蕉的偏好,而不是与香蕉的比较。当然,将这些片段组合在一起并不能完全解决歧义性(那些神秘的”time flies”可能偏爱箭头),但会使一种解释变得压倒性地可能。

早期解释人们如何处理句子的符号方法通常避免使用概率信息,并试图仅通过分析的结构特征来指导”解析”过程(粗略地说,偏好某些树形结构而非其他结构,例如,Frazier & Fodor, 1978)。局部语言歧义性的普遍存在产生了可能分析的令人生畏的组合爆炸——概率约束可以帮助控制这种爆炸。

许多核心认知现象;研究者开始寻找替代的,或者可能是互补的工程方法,为理解认知提供起点。

人们认为符号认知方法存在局限性的原因是复杂而众多的。从本书概述的观点来看,最重要的缺失成分是概率:认知系统面临的几乎所有问题都涉及不确定性;而概率,即处理不确定性的演算法,对于理解如何解决这些问题至关重要(参见本章后面的讨论,当然,贯穿整本书)。例如,正如我们所注意到的,根据传统的语言理解符号观点,解析句子的关键目标是恢复表达其语法派生的潜在树结构。找到这种结构涉及分析句子的各个部分(然后尝试将这些部分的可能分析联系起来,以产生全局一致的分析,就像我们可能尝试拼接拼图的碎片一样)。然而,执行这个程序的尝试很快遇到了自然语言在局部上极其模糊的问题——句子的每个部分都可以用多种方式解析,导致需要考虑的可能全局分析出现组合爆炸。但是,至关重要的是,并非所有可能的局部分析都是等概率的:专注于少数概率高的分析可能对缩小搜索空间至关重要(我们将在第16章中更详细地回到这些问题)。如果这是正确的,那么一个关键问题是如何确定,在给定当前语言上下文和/或背景知识的情况下,哪些局部分析是最可能的;同样至关重要的是,当拼图拼接在一起时,每个局部分析的概率如何被其他分析的概率所修改。

历史背景下的认知概率模型 [45]

同样的观点不仅适用于解析,也适用于整个感知过程。例如,视觉输入在局部上是极其模糊的——图像的任何部分或方面通常都可以用无数种方式解释,因此可能探索的局部解释组合数量是爆炸性的。但是,同样,一些局部解释比其他解释更可能,而且,随着图像解释拼图的逐渐组装,每个局部解释的概率将实质性地约束彼此。但是因为它们忽略了概率推理,早期的语言和视觉符号方法不允许利用这些强大的约束。

虽然从现在的立场来看,概率的缺失可能是认知科学符号方法中最关键的空白,但探索替代计算模型的动力在历史上有所不同。对符号范式的不满,至少部分源于这样的直觉:生物计算是渐进的、容忍噪声的,能够从经验中逐渐学习并整合许多”软”约束——而符号方法被视为过于僵化、全有或全无,不太适合建模学习和在损伤下的退化(例如,Hinton & Anderson, 1981; Rumelhart, Smolensky, McClelland, & Hinton, 1986b)。此外,理论家开始怀疑符号方法(通常在非常快速的串行计算机中实现)如何能在大脑缓慢且高度并行的机制中实现(Feldman & Ballard, 1982)。这提出了这样的可能性:心智是符号处理系统的观点要么根本有缺陷,要么至少需要重构。这种观点的倡导者试图创建一个似乎与大脑操作更兼容的计算范式:联结主义(connectionism)。

符号计算作为计算机行业的基础被证明是惊人成功的。但其他工程计算方法同样有着悠久的历史——也许可以为心智建模提供同样或甚至更富有成果的起点。替代方法族在其核心基于微积分的连续数学,而不是0和1的离散数学,

符号操作和逻辑。这种方法的一个分支是模拟计算——尝试使用体现相关数学关系的电路或液压回路来解决微分方程或建模特定的物理或经济系统。另一个比喻来源来自模拟电信:遍布世界的铜线网络提供了与穿过身体并构成大脑的神经纤维网络的自然平行。

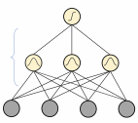

那么,从底层开始构建大脑功能模型能走多远呢——也就是说,通过直接建模神经回路的特性?麦卡洛克和皮茨(McCulloch and Pitts, 1943)有影响力地建议,神经回路应该被视为计算逻辑函数,如AND或OR——正是构成数字符号计算基础的计算组件类型。然而,后来的模型关注神经元计算其输入加权函数的能力,其中权重可能被视为类似于神经元之间的突触强度。一个著名的模型,感知机(perceptron)(Rosenblatt, 1958),计算其输入的线性加权函数,如果该函数超过阈值则产生输出1,否则产生输出0。使用加权和而不是逻辑函数提供了许多约束”软”整合的简单模型。此外,感知机的直观吸引力因为网络不需要由设计者指定,而是可以从接触先前数据中学习这一事实而得到增强。具体来说,感知机可以学习基于接触先前输入示例(标记为类别成员和非成员)将一组新输入分类为两种类型。

实际上,这种学习也可以局部实现。例如,网络中的每个连接只需观察它连接的输入和输出,并可以相应地更新其权重。因此,原则上,学习可以通过网络组件的局部调整并行进行。这个特征——处理和学习都从底层发生且不需要外部干预——是大多数连接主义模型的典型特征。

图2.3 感知机(Rosenblatt, 1958)——最简单的连接主义网络,其中输入xi乘以权重wi,结果被求和(同时加入偏置项θ)。如果总和超过阈值,输出为1;否则为0。我们可以将输出1视为表示输入模式是类别成员,输出0表示它不是。网络通过重复接触输入和输出对(训练集)进行学习,并逐渐调整其权重以最小化在该训练集上的分类错误。单层感知机,如这里所示,具有严格的表示限制——例如,它只能学习通过超平面分割输入空间,一边是类别成员,另一边是类别非成员。通过发现如何训练多层感知机,使用软阈值而不是硬阈值(如这里),最著名的是使用反向传播算法(Rumelhart et al., 1985),连接主义研究者能够证明可以学习更复杂的概念和映射。

具有单层可训练连接的感知机分类能力非常有限。因为它依赖于线性和,它只能通过平面(或在多维中,超平面)划分输入项,其中两个类别对应平面的不同侧。然而,可以通过在输入和输出之间添加多层节点和权重来构建更复杂的神经网络。这些节点中的每一个仍然以类似于感知机的方式计算其输入的加权和(有关神经网络的更详细介绍,请参见第12章)。多层网络可以表示更一般的函数;但最初,不清楚如何训练这样的网络。一种方法(Rosenblatt, 1958)是只训练一层权重,随机设置其他权重。然而,这种方法的表示限制被符号计算的支持者视为严重的(Minsky & Papert, 1969)。

对日益复杂的连接主义网络的兴趣仍在继续(例如,Grossberg, 1987; Hinton & Anderson, 1981);能够训练多层网络的学习方法的发明(例如,Ackley, Hinton, & Sejnowski, 1985; Rumelhart, Hinton, & Wilson, 1986a)为连接主义方法注入了新的动力,并导致了记忆、阅读、语言处理和习得等方面令人印象深刻的认知模型范围。许多连接主义网络专注于表面上基本但强大的认知过程,如模式完成(pattern completion)。其他网络关注从一个领域到另一个领域的映射,其中一些传统上被视为需要显式符号操作(例如,词干和过去时形式之间;Rumel-

hart & McClelland, 1986), 根据语言学中的符号模型(symbolic models)(Pinker & Prince, 1988)。此外,在单向前馈网络中引入反馈循环(feedback loop)(Elman, 1990)似乎为在语言输入中寻找序列结构提供了一条有前景的途径。这一发展提出了这样的可能性:至少一些明显的句法符号方面可能有效地通过学习系统来近似,而无需明确表示句法类别或规律性,至少对于非常简单的语言是如此(Christiansen & Chater, 1999; Elman, 1990)。

在开发语言神经网络模型方面已经取得了重大进展,包括对神经网络架构的新见解以及用于大规模训练这些系统的新数据集和技术。今天的大型语言模型表明,这样的神经网络可以学会流畅地处理人类语言的大部分复杂性。这些方法最近在机器学习的各种应用中被广泛采用,取得了令人瞩目的结果(Bubeck et al., 2023; Wei et al., 2022; Ramesh, Dhariwal, Nichol, Chu, & Chen, 2022)。这些模型与本书主要关注的复杂概率认知模型之间的关系是一个积极辩论的领域——也是我们在后续章节中重新讨论的话题。

但这是否意味着认知科学可以完全摒弃符号表示呢?别那么快!首先,请注意,作为纯粹的工程问题,连接主义网络当然建立在符号计算的基础上:它们运行在数字计算机上,这些计算机不仅编码网络的复杂结构、通过网络传播活动、运行学习算法等(这些最终可能在专门的类神经元硬件中实现),而且还依赖于以符号形式组装和编码的训练数据。因此,大型语言模型的输入是一系列离散的词,每个词映射到网络的一个节点,从网络上语言的符号表示中收集,而不是作为原始感官刺激(例如,原始声波的表示,就像内耳毛细胞附着的神经元可能记录的那样)。同样,训练网络将图像与描述关联需要这些描述的符号编码,而且显然至少需要某种表示哪些图像与哪些描述配对的方法。可以想象,这种符号”机制”可以说只是一个梯子,可以在后来更纯粹的神经网络模型中丢弃——但这绝不清楚。但是,正如我们在

对许多人来说,这当然是从认知科学中连接主义运动的早期阶段得出的教训,该运动从1980年代开始,提供了一系列丰富的认知模型。然而,像符号范式一样,它很快遇到了当时看起来是根本性限制的问题(尽管其中许多限制后来被最新一代的连接主义模型克服了)。最显著和最受讨论的限制涉及表示能力的缺乏。正如我们所看到的,符号计算可以定义高度结构化的语言,根据这些语言可以编码任意数量的消息,每个消息都有明确可指定的解释。因此,符号模型可以体现丰富的表示,如图、语法或逻辑公式——它们可以体现思维语言(language of thought),能够优雅而简洁地捕获抽象信息。符号操作通常遵循这样一个类逻辑系统的规则,可以允许对编码在这些表示中的信息所遵循的含义进行灵活而强大的推理。

对于解释人类语言、推理、规划、分类等明显需要丰富符号表示的问题,有两种相当不同的连接主义回应。一种方法是问题可以被回避——要么因为足够强大的连接主义模型将能够学会在没有这种表示的情况下模仿认知,要么可能通过连接主义网络在学习过程中以临时方式构建这种表示。第二种方法接受符号计算在认知科学中的中心地位,并探索符号计算如何在连接主义单元中实现(Rumelhart et al., 1986b; Smolensky, 1990; Shastri & Ajjanagadde, 1993)。这两种处理连接主义和符号表示之间关系的方法可以被视为连接主义项目的两种更广泛解释的例证:连接主义作为认知科学:即作为符号方法的替代,或至少是对符号方法的实质性补充;或连接主义作为计算神经科学(例如,Dayan & Abbott, 2001):即解释大脑中神经结构计算特性的项目,认知过程就是在这些神经结构中实现的。

连接主义作为认知科学的观点,即自底向上的连接主义学习可以执行符号操作被认为是必需的那种丰富计算,在最近之前似乎主要是推测性的。但连接主义AI的显著进展不仅表明连接主义网络能够执行

外部定义的符号表示(例如,参与复杂的语言交互、写故事或编写计算机程序)的计算,但它们可能通过学习在某种有限程度上创建和操作内部符号表示来做到这一点——尽管理解庞大的连接主义网络的内部工作机制仍然极其困难(Pavlick, 2023)。

这里采用的观点,正如将变得清楚的那样,是丰富的符号表示对于解释认知过程的复杂性和多样性是必不可少的,从感知到规划,从语言理解到推理。从工程角度来看,符号表示对于解决这些问题似乎是不可或缺的;而好的逆向工程至少必须是好的工程。因此,我们将假设符号表示对于逆向工程大脑也是必需的。

尽管如此,连接主义方法在几个关键方面推进了认知科学:强调了学习的中心地位以及学习与概率推理之间的关系(Mackay, 2003);强调了理解如何权衡多个软约束的重要性,而不是专注于严格的全有或全无规则;以及关注认知过程如何在真实的神经硬件中实现(Dayan & Abbott, 2001)。

连接主义人工智能的最新进展也对大脑如何从如此少的内容中学到如此多这一关键问题提出了有趣的问题。大规模连接主义系统在大量数据上进行训练(例如,文本语料库几乎接近整个互联网的内容),而人类儿童使用的输入量要少得多(例如,数百万个单词的口语输入)。尽管如此,一旦经过训练,大规模连接主义模型在响应新输入时可能会出人意料地灵活。

实际上,它们可以获得少量任务示例(例如,一个英语句子及其法语翻译),然后可以成功推断任务是将另一个英语句子翻译成法语(Brown et al., 2020)。连接主义网络中此类”少样本”学习的扩展在多大程度上能够反映人类在响应新问题时的灵活性,或者是否需要添加内置的符号机制(Zhang et al., 2022),是未来研究的一个重要开放问题。

解释认知的第三个悠久传统根植于经济学、数学和哲学,而不是计算理论。这里的起点是试图通过构建理性的正式理论来理解智能,无论是人类还是人工智能。

从最一般的意义上讲,理性理论通常从某种关于智能体在其思想和/或行为中保持连贯或不连贯意味着什么的概念开始。例如,数学、逻辑、物理或社会推理的理性理论可能从这样的假设开始:没有智能体应该相信任何命题(比如费马大定理)既是真的又是假的——或者确实拥有任何暗示(无论智能体是否已经注意到这一点)费马大定理既是真的又是假的信念集合。正如这个例子所表明的,实现这种一致性可能是任意困难的——在数学家安德鲁·怀尔斯构建了他对该定理极其复杂和微妙的证明之前,没有人知道数论的基本真理是否与该定理兼容。实际上,人们可以将整个数学视为帮助我们理解我们可以连贯地相信什么的正式理性理论。因此,正式的理性理论自动为智能理论提供约束,无论是人类还是人工的。如果智能体在推理数字,其思想应该受到算术规则的约束。如果智能体在推理空间中的物体,其推理可能由几何学和物理学相关方面的原理指导(它们本身可能以某种数学形式被捕获),正如第15章所讨论的。当然,要做到这一点,这些理性原理需要体现在智能体执行的计算中,就像算术原理指导袖珍计算器的操作一样。

同样的思路适用于理解我们如何做决定(见第7章)。我们可能要求智能体不同时选择参与和避免完全相同的行动A;它不同时决定采取两个不兼容的路线或计划;并且它以其他方式避免将导致其陷入僵局的选择组合。这种相当温和的约束迅速产生了丰富的数学理论,这一理论已在经济学、工程学和其他学科中得到发展,涉及成为理性智能体的意义(见第7章)。但是弄清楚如何决定和规划,特别是在处理可能包含其他智能体的复杂世界时,可能需要复杂的理性理论,但也需要非常微妙的计算来考虑该理论(例如,想想在像国际象棋或围棋这样的竞争性游戏中决定最佳计划的本质上无限的复杂性)。

逆向工程大脑的一个特别核心的方面是处理不确定性。正如我们在第1章中所看到的,这里的目标是用概率捕获信念程度——信念程度之间的连贯性通过遵循概率定律来维持

理论,其中贝叶斯定理是一个特别重要的结果(我们在第3章会详细讨论)。

各种理性理论都可以主要视为一致性问题(Chater & Oaksford, 2012; Nau & McCardle, 1991)。但在实践中,理解认知的理性方法通常不会简单地试图确保智能体具有一致的信念、信念程度或决策。相反,它们试图以最优方式解决特定的计算问题。实际上,这种方法通常确定某个目标(从感觉输入中找到环境布局的最佳解释,选择能最大化预期奖励的行动等),并询问如何最好地实现这个目标。

理性理论在为合理推理类型提供约束方面发挥着关键作用(例如,当代理在给定某些感觉或语言输入时进行贝叶斯更新时,应遵循概率论规则)。

确实,按照逆向工程的精神,目标是找出大脑正在解决哪些工程问题;并在理性约束的框架内,找出解决问题的最优方式。因此,在认知科学中,认知的理性方法通常抽象出大脑执行什么计算的问题,而是专注于所解决认知问题的本质。感兴趣的问题是:对于指定的认知问题,最优解决方案是什么?然后假设认知系统将在更大或有时更小的程度上符合该解决方案。通常(尽管不是普遍地)假设找到最优解决方案需要遵循理性原则,尽管可能是隐含的。特别是,最优地处理不确定性可能涉及按照概率论规则行事——因此本书始终关注贝叶斯概率方法。

找出认知问题的最优解决方案本身当然可能需要大量计算。但这并不意味着代理必须执行这样的计算——仅仅是它采用了至少某种近似的结果解决方案。借用Marr(1982)的一个例子,需要复杂的空气动力学计算

[2.] 在行为经济学、金融学和心理学中,不确定性有时用来描述无法量化的未知事物,风险用来描述可以分配概率的情况(例如,从某种统计模型中得出)。在贝叶斯框架中,这种区别不那么绝对,因为概率模型的范围被大大扩展。无论如何,我们在这里以非正式的意义使用不确定性,所以在我们的用法中,概率论对建模不确定性是潜在有用的,而不是不确定性根据定义”超出范围”。

[3.] 理性与最优性之间的联系并非毫无争议(Chater et al., 2018)。这里采用的方法是,理性约束提供了一个框架,在其中最优或近似最优的解决方案可以最容易地被制定。

认知概率模型的历史背景 [51]

来确定鸟类翅膀的最优形状或导致高效飞行的翅膀最优运动。当然,鸟类不需要进行这样的计算——其翅膀形状或运动模式相反可能是自然选择的产物。实际上,这种对生物结构和行为基础的适应性解释(例如,最优觅食理论;见Stephens & Krebs, 1986)在生物科学中无处不在。

或者考虑根据比较优势原理对各国生产和贸易模式分布的经济解释,这一原理由大卫·里卡多(David Ricardo, 1817)推广。这个原理大致是,每个国家将专门生产相对于其他国家具有比较效率的商品或服务,即使它在生产所有商品方面绝对效率高于或低于其他国家。经济理论计算出的最优均衡生产分布不需要由农民和工厂主计算。相反,在自由贸易条件下,如果这些农民或工厂主能通过转向生产其他商品获得更多利润,这种解决方案将自然产生。更一般地,解释经济现象需要计算均衡,这种计算通常可能很复杂;但不需要假设经济代理通过执行任何这样的计算来找到这些均衡。

从逆向工程的角度来看,理性方法通过指定必须找到的解决方案性质的各个方面来运作——而不指定如何实现解决方案的细节。因此,鸟类翅膀的形状和重量可能根据问题的性质被指定——而不精确指定这样的结构可能由什么制成或如何生长。

Marr(1982)的计算层次解释(我们在第1章介绍过)也许是认知科学中理性解释的典范。这种解释关注信息处理系统面临的问题性质,考虑问题原则上如何最优解决,并假设系统采用

接近这个最优解的解决方案。关键在于,对于认知科学中许多有趣的问题,这需要对环境进行仔细分析。在Marr关注的视觉领域,理解视觉环境需要理解自然世界与其产生的图像之间的关系。只有这样,从这些图像重建世界结构的推理问题才能得到适当的表征(Richards, 1988)。

Marr将注意力转向Gibson(1979)对视觉感知的生态分析,从中找到了一些计算层面解释的优雅例子。例如,视觉阵列的扩张速率可能表明与阵列中物体的接触时间(比如,行走的观察者如果以恒定速度继续前进,何时会撞到前方的墙,或者移动物体何时会到达静止的观察者,因此如何安排抓住或避开该物体的动作时机)。同样,对于向前运动的主体,视觉流辐射的起点表明主体前进的方向(Gibson, 1950)。如果人类和动物对这类信息敏感,那么可能可以解释他们感知-运动行为的某些方面,而无需参考估计视觉流所涉及的具体计算或神经回路知识。尽管如此,对Marr来说,处理图像本身的任务(例如,从原始像素级输入中找到边缘、表面和物体)也是一个需要计算层面分析的问题,因此需要理解世界生成图像的潜在自然约束。这是Gibson的生态方法忽视的问题;也是AI中符号视觉方法(例如,Winston, Horn, Minsky, Shirai, & Waltz, 1975)通常假设已经解决的问题。

基于同样的精神,Shepard(1987, 1994)提供了许多重要的理性解释,而没有直接参考计算机制。例如,Shepard(1987)著名地论证,在归纳推理中应该适用物体对之间泛化的普遍法则——这个法则旨在关联这些物体在内部心理空间中的接近程度和它们共享任意属性的概率。这个普遍法则的范围和证明已经得到广泛分析(例如,Tenenbaum & Griffiths, 2001a; Myung & Shepard, 1996; Chater & Vitányi, 2003a; Chater & Brown, 2008)——除了一些例外(Ennis, 1988),论证过程没有直接参考这种泛化所涉及的计算。

Anderson(1990, 1991b)将这种观点扩展到高级认知的广泛现象。他的理性分析(rational analysis)方法论对认知环境、要完成的任务以及(必要时)相关的认知约束(例如,关于记忆或处理限制)做出了一般性假设。目标是将详细的实证数据解释为在具有特定结构的环境中,受到相关认知限制的任务的最优(或接近最优)解决方案。

Anderson(1991b)对分类的描述优雅地捕捉了随着新项目流的到来而潜在无限扩展类别集合的过程(这里,环境的一个方面是它可以包含无限多种不同类型的物体,而不是限于某个有限数量的类别);他试图根据自然类别的结构来解释人类分类的数据。我们将在第9章中考虑Anderson的分类模型,作为非参数贝叶斯混合模型的早期重要例子。

Anderson(1990)及其同事关于记忆理性模型的工作为理性方法的力量提供了一个优雅的例证。认知心理学中的传统记忆理论通常将记忆表现的限制视为特定认知机制运作的结果;但Anderson论证记忆可能经过仔细适应以满足自然环境中信息检索的需求。项目应该按照认知系统需要它们的概率比例来易于检索。他指出,这个概率取决于信息环境的结构。因此,在同一主题在短期内重复出现的世界中,最近遇到的信息比在遥远过去遇到的信息更可能在当前语境中被需要。因此,最近信息的更强记忆性可能不是源于记忆的某些机制方面(例如,记忆痕迹随时间不可避免的衰减过程),而是因为这类信息在当前语境中更可能被需要。Anderson和Milson(1989)研究了特定书籍的图书馆借阅模型和对计算机文件的重复访问,表明了这些领域中信息检索的时间”聚集”。他们论证,关于需要一条信息的概率如何随时间减少的估计准确反映了信息在人类记忆中保持可用的程度。Anderson和Schooler(1991)直接收集了关于报纸标题中主题随时间重现的信息,并用此来建模各种实验记忆数据。Schooler和Anderson(1997)进一步扩展了这项工作,以捕捉这样的观察:一个项目将重现的概率不仅取决于其过去出现的历史,还取决于

相关项目的出现——并提供了这两个因素在人类记忆中运作的综合模型。这意味着通过呈现相关词汇来”启动”一个词汇可能具有合理的基础,这与认知心理学传统理论的观点形成鲜明对比,传统理论通常假设启动只不过是处理机制(如扩散激活)的副作用。最近,贝叶斯主题模型形式的更一般的词汇联想效应合理性解释已经得到发展(Griffiths, Canini, Sanborn, & Navarro, 2007),这将在第5章中讨论。

认知的合理性方法不一定需要应用概率思想。但当所考虑的问题是不确定推理问题时,概率的应用往往是非常自然的。因此,虽然马尔和吉布森专注于自然环境的结构以及该环境产生的视觉输入结构,但从模糊视觉图像推断多种可能结构之一的过程自然被解释为贝叶斯推理问题。事实上,贝叶斯观点在计算机视觉工程领域具有高度影响力(例如,Geman & Geman, 1984; Weiss, 1996),同时在人类感知理论中也迅速获得认可(Feldman, 2001; Feldman & Singh, 2005; Yuille & Kersten, 2006; Knill & Richards, 1996)。这一最新工作可以被视为与亥姆霍兹(1866/1962)的似然原理(likelihood principle)陈述的延续——即感知系统寻求在给定输入数据下最可能的解释。

类似的概率革命在语言领域也在进行中。解析句子(即构建句子句法结构的表示)在符号传统中可以被视为类似于逻辑推理。采用最简单的方法,我们可以将目标设定为从词汇串联(例如,the dog barked)连同语法一起推断S(表示完整句子)。该语法指定规则,如S [→] NP VP、NP [→] Det N或N [→] dog,这些规则可以解释为序列NP VP允许推断S;序列Det N允许推断NP;或单词dog允许推断N(关于符号语法作为逻辑观点的最新例子,见Morrill, 2019)。但自然语言的明显局部性,有时是全局性的歧义性意味着通常有大量的解析必须进行,这造成了计算复杂性的严重问题。概率替代方案是将概率与语法规则关联,使语法可以被视为概率句子生成器。从这个观点来看,解析是一个逆问题,即推断可能生成该句子的最可能解析(即语法规则的应用)。通过研究真实语言语料库的统计结构,可以”调整”这样的解析器,使其在解决局部句法歧义时具有概率”偏向”,这些偏向最有可能导致成功解析。心理语言学的一系列工作表明,这种模型解释了大量经验数据(例如,Chater & Manning, 2006; Jurafsky, 2003)。有趣的是,其他领域的类似贝叶斯模型,如口语词汇识别和阅读(例如,Feldman, Griffiths, & Morgan, 2009; Norris, 2006),已经能够捕捉到这些领域中连接主义模型解释的许多现象,但更加简单和透明。

[54] [N.] [Chater,] [T.] [L.] [Griffiths,] [and] [J.] [B.] [Tenenbaum]

将合理性方法应用到其核心领域——人类推理——在多大程度上是可能的?推理实验任务通常涉及呈现一组口头陈述的前提,并要求参与者得出口头陈述的结论。评估表现的一个流行标准是演绎逻辑,根据该标准,如果前提为真,结论必须确定地跟随。根据这一标准,人类推理表现一直被判断为显著且系统性地容易出错(例如,Evans, Newstead, & Byrne, 1993)。

但逻辑一定是正确的标准吗?认知中不确定性的普遍存在同样适用于推理和论证,就像它适用于视觉或语言处理一样。因此,大多数日常推理,实际上也许几乎所有数学之外的推理,都是可撤销的(defeasible):结论只是暂时地从给定前提中得出,并且可以在新信息的光照下被推翻。这甚至适用于明显规范的逻辑推理,如肯定前件(modus ponens),例如从如果天气好,那么我将打网球和天气好推断出我将打网球,这可以被任何数量的额外前提推翻,如我的网球伙伴生病了、我的车发动不了或球场意外关闭。在符号人工智能中,处理可撤销性的一种方法是扩展逻辑方法来创建所谓的非单调逻辑(nonmonotonic logics)(McCarthy, 1980; Reiter, 1980),这一项目遇到了相当大的技术困难。但另一种方法是假设知识和推理从头到尾都是概率性的,这一方法在人工智能中由Pearl(1988, 2000)开创。

将这一观点应用于推理心理学,人类推理不应该被视为从已知信息中推导出逻辑上必然跟随的新信息的问题。相反,推理的作用是对

给定当前知识,这种推理是可能的。从这个角度来看,人们所犯的许多逻辑错误和谬误可以重新解释为良好的概率论证。

例如,假设我们知道如果刀疤麦克是凶手,那么他的DNA将出现在犯罪现场;麦克的DNA确实被发现了,因此我们得知麦克的DNA出现在犯罪现场。然后我们可能自然地得出结论,麦克确实是凶手。但请注意,从逻辑角度来看,这种论证路线对应于一个基本的逻辑谬误,有时被称为愚人肯定式:从如果p,那么q和q形式的陈述推断出p。这种推理确实在逻辑上是无效的。麦克是凶手在逻辑上并非必然;例如,他的DNA可能出现在犯罪现场是因为他在谋杀发生之前(或确实之后)无辜地在场;或者也许警察在犯罪现场栽赃了麦克的一些物品来陷害他。但是,根据我们的背景知识(也许包括我们对麦克恶劣品格和恶行记录的了解),我们可能合理地假设,在没有相反进一步信息的情况下,DNA的最可能解释绝大多数是麦克的罪行。实际上,这种被称为最佳解释推理的推理风格似乎是日常和科学思维的核心(例如,Harman, 1965)。

因此,从贝叶斯观点来看,我们认为DNA证据的发现不利于麦克无罪的自然推理是完全合理的。然而从严格的逻辑角度来看,这样的论证是谬误的。因此,从逻辑标准转换到概率标准有助于理解人类推理并恢复我们对人类理性的信心 [概率] [认知] [模型] [的] [历史] [背景] [[55]]

此外,事实证明,人类推理的概率方法也为解释人类推理和论证模式的详细经验数据提供了一个富有成效的程序基础(例如,Chater & Oaksford, 1999; Evans & Over, 2004; Hahn & Oaksford, 2007; Oaksford & Chater, 1994),这与以逻辑有效性为起点的推理解释形成对比(例如,Johnson-Laird, 1983; Rips, 1994)。

我们简要概述了认知科学的三种重要方法:强调结构化表征重要性的符号方法;专注于学习和神经实现的连接主义方法;以及旨在解释视觉、语言处理和推理中涉及的认知过程为什么为思维和行为提供可靠指导的理性方法。

本书概述的方法试图综合所有三种方法的关键见解。我们将始终强调结构化表征的重要性,从相对受限但功能强大的结构(如图)到语法、关系、逻辑和程序。然而,在这些结构化表征上定义的推理模式将不仅限于标准逻辑运算,而是遵循概率演算。我们将在一系列复杂的结构化表征上定义贝叶斯推理。连接主义对学习的强调可以通过将学习视为贝叶斯推理的特殊情况来捕获,这种观点长期以来一直是连接主义基础的主流,实际上一直是许多连接主义学习方法发展的灵感来源(Ackley, Hinton, & Sejnowski, 1985; Hinton & Sejnowski, 1986; Hinton & Salakhutdinov, 2006; Hinton & Sejnowski, 1983; MacKay, 1992a)。此外,连接主义对不需要中央控制器、可以分布在大量简单处理单元上、协作并行操作的计算的强调,也与许多贝叶斯方法自然对齐,特别是使用图模型的方法(见第4章)。

因此,我们的目标是结合认知科学中符号、连接主义和理性传统的互补见解,而不是概述一种竞争方法。我们相信,每种传统的贡献都是必不可少的;每种传统单独都是不完整的。鉴于逆向工程心智只能依赖于迄今为止开发的用于创建智能系统的工程技术范围,现代计算机科学主要依赖于符号表征及其操作这一事实,为将这种表征归因于认知系统提供了强有力的表面论证。要理解这种论证风格的力量,请考虑以下内容:假设我们想要构建一个用于处理语言、识别图像、控制机器人手臂或推理日常世界的工程系统;但假设我们不允许自己使用任何符号表征(即,没有列表、图、树、关系、语法等)。我们甚至不知道如何开始——实际上,不存在这样的工程方法。当然,这些问题的某些元素可能以非符号方式分析。例如,也许形态学的某些方面可以用连接主义术语来分析(考虑英语过去时的争议案例;例如,Rumelhart & McClelland, 1986);但即使这是正确的,这样的连接主义模型 [56] [N.] [Chater,] [T.] [L.] [Griffiths,] [and] [J.] [B.] [Tenenbaum]

也预设了基于音素或至少音素束的语音符号表征

音位特征的——连接主义系统的输入和输出不是原始的声学波形,而是语言的符号表征。实际上,创建这样的表征需要将语音从声学输入中的非语音中分离出来;并且需要将语音编码为高度抽象的符号形式(例如,从声音的细节、语调、说话者的距离、听者的头部角度、声学环境中回声的数量和性质等方面抽象出来)。此外,要应用连接主义模型来映射英语动词的现在时和过去时,首先需要将一些输入表征为动词,并表征哪些动词是现在时或过去时。而且,学习者需要能够存储和检索这些表征来尝试学习它们之间的映射(即,学习者需要能够识别出相应的形式,如pass和passed、go和went,或sing和sang,并将现在时形式的符号表征输入到连接主义网络的”输入”缓冲区中,并将相应过去时形式的符号表征输入到”输出”缓冲区)。只有这样,连接主义系统才能开始学习现在时和过去时之间的映射。因此,即使是设置一个学习问题让连接主义系统能够开始学习,似乎也需要大量的预处理。而这种预处理似乎需要大量使用符号表征。

纯连接主义认知方法的倡导者可能会回应说,最终,所有这些预处理本身都可能以某种非符号的、连接主义的方式实现。确实,连接主义工程可能有一天会发展到显示如何做到这一点,而不仅仅是在连接主义机制中重新实现符号操作(这本身就是一个巨大的重要成就)。但目前,这仍然只是一个理论可能性;现在,我们根本不知道如何在不利用结构化符号表征的巨大力量的情况下对心智进行逆向工程。

因此,我们暂时假设结构化符号表征对逆向工程认知至关重要。本章概述的考虑,在理性解释的层面上,要求必须能够对这种结构化表征进行概率计算。连接主义的驱动动机,即对学习的强调和在简单处理单元上定义的并行、协作计算硬件中的实现,进一步要求这样的表征可以被学习;推理和学习本身可以在简单处理单元上并行实现。本书旨在勾勒这样的贝叶斯综合如何发展;我们建议这是目前可用于逆向工程心智的最有希望和最强大的方法。

心理现象可以在多个解释层面上得到解释,从现象学到神经化学。如第1章所述,Marr(1982)强调了三个关键层面:计算层面(前面提到过),它捕捉智能体面临的问题以及该问题的解决方案;算法层面,描述操作这些表征的表征和计算过程,这些表征和过程允许成功解决计算层面面临的问题;[认知概率模型] [在历史背景下] [[57]]

以及实现层面(即,算法层面计算如何在神经活动中物理实例化的规范)。

试图对心智进行逆向工程的项目本身表明了在每个层面生成解释的特定优先顺序,正如我们在第1章中指出的。在逆向工程中,就像在传统工程中一样,主要问题是:要解决什么问题?什么算作解决方案?这些是计算层面的问题。只有这样,才能问什么表征和过程可能体现解决方案(即,在算法层面制定可能的解释)。只有一旦这些表征和过程被指定,我们才能确定如何将这些表征和过程构建到物理机器中。因此,在逆向工程与传统工程相似的程度上,我们期望构建认知模型的”自上而下”方法可能是最有成效的(Griffiths, Chater, Kemp, Perfors, & Tenenbaum, 2010)。

我们强调这种自上而下的关注只不过是一个方法论建议。最终,每个层面的解释必须相互兼容,因此关于任何层面的见解都可以帮助约束其他层面的理论构建。例如,关于神经架构的见解可能导致算法层面的强大约束——能够在缓慢、高度互连和非常简单的神经单元上快速运行的算法类别——可能很小。或者观察到支撑行为某些方面的明显不同的神经系统可能合理地强化这样的建议,即大脑可能正在实现不同的算法,也许解决不同的计算问题(见Dayan & Daw, 2008)。

然而,逆向工程方法表明最有成效的研究策略是工程师的策略:从功能开始;找到一个能够实现该功能的设计;并弄清楚如何在物理(或在逆向工程情况下的生物)机器中实例化该设计。

因此,本书的方法首先是勾勒认知系统面临的概率推理(probabilistic inference)问题的类别;然后我们考虑如何使用最初在优化和机器学习中开发的方法,通过特定的表示和算法来解决(或更典型地,近似)这些问题。这些方法中的许多都可以在简单处理单元上自然地并行硬件实现。这为我们提供了一些乐观的空间,即这些算法最终可能在神经硬件中实现。在理解有趣的计算(包括贝叶斯计算)如何在神经层面实现方面,已经有了一些有希望的进展(例如,Dayan & Abbott, 2001; Ma, Beck, Latham, & Pouget, 2006);但这些问题超出了本书的范围。

在本章中,我们概述了认知科学中的三个重要传统:符号方法、连接主义(connectionism)和理性解释(rational explanation)。我们论证了成功逆向工程心智可能需要综合所有三者的关键洞察,并以自顶向下的方式进行:首先关注认知系统面临问题的性质,然后转向表示和算法问题,最后以神经实现结束。

本书的其余部分专注于阐述这一研究计划在实践中的具体内容;我们希望能激励其他人在未来几十年中帮助推进这一方法。我们将在后续章节中重述这一研究计划的一些历史,从基本概念和认知贝叶斯模型早期工作的一些例子开始,逐步发展到高级思想和更多当代成果。

Thomas L. Griffiths and Joshua B. Tenenbaum

人们解决着大量具有挑战性的归纳问题,从有限的数据中学习词汇、类别、规则、因果关系等等。解决这些问题需要处理不确定性。归纳推理超越了给定的信息,寻求合理的答案,即使我们知道永远不能绝对确定答案是正确的。在本章中,我们对贝叶斯推理背后的思想提供了更正式的介绍,这为我们提供了解决这些问题的强大工具集。

贝叶斯推理从这样的想法开始:我们需要一个数学系统来让我们表示不确定性——我们对世界状态有不同的假设,这些假设被分配了不同的信念程度(degrees of belief)。这些信念程度量化了我们对每个假设的支持强度,表明我们认为它为真的可能性以及我们愿意为此下注的类型。认知贝叶斯模型背后的核心假设是,表示这种不确定性的适当方式是通过概率论,这立即为我们提供了一套原则,用于回答我们应该如何根据证据改变信念的问题。

我们在下一节详细阐述这个想法,然后从考虑贝叶斯定理的含义转向演示它如何在广泛的情境中应用。在介绍新的数学概念时,我们提供了这些概念如何用于理解人类认知各个方面的例子,借鉴了认知贝叶斯模型的现有文献。我们在这里的重点是介绍贝叶斯统计学的关键思想——更深入和更数学化的处理可以在Berger (1993)、Bernardo and Smith (1994)和Robert (2007)中找到。

成为贝叶斯主义者需要信念的飞跃。你需要愿意假设人们的信念程度可以用概率分布来表示。这意味着对于你关于世界状态的每个假设h,存在h为真的某种概率P(h),它遵循概率论的定律。更准确地说,如果我们用H表示所有假设的集合,P(h)应该遵循以下公理,这些公理定义了概率这一数学对象:

• 对于所有h ∈ H,P(h) ≥ 0。

• P(某个h ∈ H为真) = 1。

• 对于任何可数的互斥假设集合Hₙ = {h₁, …, hₙ},P(某个h ∈ Hₙ为真) = ∑ᵢ₌₁ⁿ P(hᵢ)。

从这些公理出发,可以推导出我们与概率相关联的所有性质,比如P(某个不是h的h ∈ H为真) = 1 - P(h)。

用概率表示信念程度的一个重要后果是,更相信一个假设意味着更少相信另一个假设(假设这些假设是互斥的)。在物理学中,谈论物理定律是常见的,比如动量守恒定律。这个定律断言封闭系统的总动量保持不变。例如,两个相互碰撞的物体的总动量在碰撞后保持不变,即使它们的速度发生了变化。由于某个假设为真的总概率是1(通过本章给出的第二个公理),我们只有一个概率单位可以在所有假设之间分配。因此,

增加一个假设的概率必须伴随着另一个假设概率的降低。这可以被认为是信念守恒定律——无论发生什么,我们只有有限的信念可以分配给我们的假设。

认为信念程度可以用概率来表示(这个概念被称为主观概率)在建立认知的概率模型的背景下特别重要。如果我们只是想建立行为的概率模型,我们就不需要讨论内部状态或信念程度,我们可以使用概率的另一种解释(如频率主义,即概率被认为反映了如果事件发生的环境重复多次时,事件发生的长期相对频率)。如果你接受主观概率,那么贝叶斯法则(我们马上会讲到)就是你应该更新信念的方式,因为贝叶斯法则只是概率论公理的简单结果。所以我们将从考虑支持主观概率的一些论证开始,然后转向做出这种假设的后果。Hacking (1975)、Stigler (1986)和Gigerenzer等人(1989)给出了这些不同概率观点的历史视角,Jaynes (2003)详细论述了支持主观概率的论证。

有两种传统形式的论证认为信念程度可以用概率来表示。一种形式表明,对于遵循一些常识简单规则的任何主体来说,这是不可避免的。另一种论证认为,不遵循概率公理将导致可以被利用(因此不具有适应性)。

经典的”不可避免性”论证是Cox定理。Richard Cox (1946, 1961)表明,如果你接受关于信念程度的一些简单公理——他称这些信念程度为”可信度”——你会发现这些信念程度最终等同于概率。Cox希望可信度是以每个人都同意看起来像常识的方式行为的实数。他证明了,对于一组简单的公理,遵循这些公理的可信度将等同于概率。

这样一个公理的例子是命题及其否定的可信度是反向相关的。由于双重否定是肯定,将陈述的可信度映射到其否定的可信度的函数必须是其自身的逆函数。这被概率论满足。如果我们使用¬h(“非h”)来表示除了h之外的某个假设为真,那么P(¬h) = 1 − P(h)。由于h与¬¬h相同,因此P(h) = 1 − P(¬h) = 1 − (1 − P(h))。从沿着这些路线的更广泛的公理集开始,Cox证明了描述概率的标准定律可以从他的公理中推导出来。在这种观点下,概率论只是适当形式化的常识。

荷兰赌书论证(Ramsey, 1926/1931; de Finetti, 1937)表明违反概率定律会让你赔钱。论证的基本形式依赖于购买和出售彩票的机制。你可以设定一张彩票的价格,如果特定事件发生,彩票就向持有者支付1美元,然后另一个玩家可以选择是从你那里购买该彩票,还是向你出售(你必须购买他们向你出售的彩票)。

可以证明彩票的价格应该对应于事件的概率,因此,在设定这些彩票时违反概率论原则会让你赔钱。例如,如果只有两个可能为真的假设h₁和h₂,那么为这些假设的真实性支付的彩票价格总和应该为1美元。如果总和少于1美元,那么你的对手可以购买两张彩票并保证赚取总价格与1美元之间的差额。如果总和大于1美元,那么你的对手可以向你出售这些彩票并再次赚取总价格与1美元之间的差额。类似的技巧适用于所有概率公理,证明了不按照这些公理行事的主体在任何类似于这种赌博游戏的情况下都会赔钱。实际上,我们不仅用金钱而且用生命下注,因为我们根据信念选择行动,所以维持信念

符合概率论公理的方式]可能被期望为适应性]

行为。]

更实用的贝叶斯主义 本节给出的另外两个论证是关于为什么人们应该是贝叶斯的。然而,为了建立认知的概率模型,我们只需要说服自己,假设人们是贝叶斯的是合理的。如果他们真的是(或真的应该是),那么这个假设似乎是合理的。这是安德森(1990)理性分析方法背后论证的本质——试图从人们面临问题的适应性解决方案角度来解释人们的行为,这自然导致贝叶斯模型。但也可能有其他原因假设人们是贝叶斯的。

假设人们是贝叶斯的一个好理由是这样做是有用的。在贝叶斯认知模型能够预测和解释行为的程度上,这似乎可能是一个有价值的工作假设。如第2章所述,理性分析有一些优势,比如与其他学科形成联系,以及拥有一种描述人类学习的语言,这种语言用问题来表达,并自然地转化为机器实现。这些都是贝叶斯主义在分析认知中可以成为有用假设的方式:如果它被证明是人类行为模型的有效来源,回报是显著的。

假设人们是贝叶斯的另一个可能更糟的理由是我们希望它是真的。如果人们真的是贝叶斯的,我们作为认知科学家的生活将会轻松得多。我们将有一个完整的学习理论——贝叶斯推理——我们只需要弄清楚人们使用的假设和表征,这个框架为使用特定假设和表征所产生的行为预测提供指导。由于这将是有价值的,可能值得看看这个框架能带我们走多远。

贝叶斯推理源于被称为贝叶斯定理的简单公式。当以抽象随机变量的形式表述时,贝叶斯定理不过是概率论的一个基本结果。在本节中,我们简要介绍概率论背后的关键思想以及我们将用来讨论它们的一些语言。关于概率论的更详细介绍,请参见皮特曼(1993)。

之前,我们将概率论的公理应用于假设。更一般地说,我们可以将这些公理应用于世界中可能发生的互斥事件。例如,如果我们抛硬币两次,有四个可能发生的事件,对应于正面[H]和反面[T]的所有可能序列:[TT]、[TH]、[HT]和[HH]。这些事件中的每一个都被分配一个大于或等于0的概率,使得所有事件的概率之和为1。

通常,我们不是谈论这些原子事件,而是想谈论描述事件集合的变量。例如,我们可以定义随机变量A对应于第一次抛硬币的结果。A取值[H]的概率是第一次抛硬币出现正面的所有序列的概率之和(即P(HT) + P(HH))。A取值[T]的概率是第一次抛硬币出现反面的所有序列的概率之和(即P(TT) + P(TH)),或者等价地,P(A = T) = 1 − P(A = H)。我们将使用大写字母来表示随机变量,使用匹配的小写变量来表示这些变量在值未指定时所取的值,如P(A = a)。当我们写概率时,随机变量通常是隐含的。例如,P(a)指的是变量A取值a的概率。

当我们在同一组事件上定义多个随机变量时,我们可以询问它们的联合概率。例如,我们可以使用随机变量B来描述第二次抛硬币的结果。我们现在可以询问联合概率分布P(A = a, B = b),我们也可以写作P(a, b)。联合概率的其他记号包括P(a&b)和P(a ∩ b),但我们在本书中不会使用这些。

当我们有多个随机变量时,通常将一个变量单独的概率,如P(A = a)或P(a),称为边际概率。这些边际概率可以通过对其他变量的所有值求和从联合概率中获得(例如,P(A = a) = ∑P(A = a, B = b))。与本节介绍的概率论的所有性质一样,这可以从公理中推导出来——在这种情况下,通过确认这个和正确地识别了对应于随机变量A取值a的原子事件集合。在我们的抛硬币例子中,我们已经展示了

其中P(A = H)* = P(HT) + P(HH),对应于对P(A = H, B = b)中所有b值的求和。这种”求和消除”变量的过程称为边际化(marginalization)。

对于两个或更多随机变量,我们还可以询问关于条件概率(conditional probability)的问题。例如,我们可能想问在第一次抛硬币正面朝上之后,第二次抛硬币正面朝上的概率是多少。直觉上,看到一次正面可能会让你认为再次看到正面的可能性更大,特别是如果你在抛硬币之前没有仔细观察硬币的话。我们可以将这种条件概率写成P(B = b|A = a)或P(b|a),其中|读作”给定”。所以P(b|a)是给定a的b的概率,告诉我们如果已知a发生了,b发生的概率。我们也可以说P(b|a)是b”以a为条件”的概率。

条件概率的计算是通过将我们的世界限制在与a发生一致的原子事件上,并在这些事件之间重新分配概率。第一次抛硬币正面朝上后,只有两个可能的事件:HT和HH。然而,这些事件的概率不再相加为1。为了纠正这一点,我们取每个事件的新概率与其原始概率成正比,但乘以一个数字,使概率相加为1。在计算P(b|a)的情况下,这对应于将每个概率乘以1/P(a),因为P(a)是仍然可能的所有事件概率的总和。最后,我们计算在这个世界中b发生的概率。这与P(a, b)成正比,因此变成

P(b|a) = P(a, b)/P(a) (3.1)

这等价于相关原子事件集合在以a发生为条件后以其新概率的总和。

条件概率为我们提供了一种讨论随机变量之间关系的方法。例如,如果我们绝对确信被抛的硬币是公平的,我们可能认为第二次抛硬币看到正面的概率只是0.5,无论第一次抛硬币的结果如何。在这种情况下,第二次抛硬币得到正面的条件概率与边际概率相同。我们可以通过说两个随机变量A和B相互独立来捕捉这一点。独立性(Independence)意味着随机变量的条件概率不受彼此值的影响,因此P(b|a) = P(b)且P(a|b) = P(a)。

我们可以重新排列方程(3.1)来推导概率论的一个重要原理——联合分布的因式分解,有时称为链式法则(chain rule)。这允许我们将两个随机变量A和B取特定值a和b的联合概率P(a, b)写成给定A取值a时B取值b的条件概率P(b|a)与A取值a的边际概率P(a)的乘积:

P(a, b) = P(b|a)P(a) (3.2)

直觉上,我们通过将a发生的概率乘以在a发生的情况下b发生的概率来得到a发生且b发生的概率。在我们的硬币例子中,我们通过将第一个硬币正面朝上的概率乘以在第一个硬币正面朝上的情况下第二个硬币反面朝上的概率来得到第一个硬币正面朝上且第二个硬币反面朝上的概率。

T. L. Griffiths和J. B. Tenenbaum

我们现在可以推导贝叶斯定律。在方程(3.2)中因式分解联合概率时,选择B而不是A没有什么特别之处,所以我们也可以写成

P(a, b) = P(a|b)P(b) (3.3)

从方程(3.2)和(3.3)可以得出P(a|b)P(b) = P(b|a)P(a),可以重新排列为

P(b|a) = P(a|b)P(b)/P(a) (3.4)

这个表达式就是贝叶斯定律,它表明我们如何从a给定b的条件概率计算b给定a的条件概率。

在一个我们关心的事件只是硬币抛掷的世界中,贝叶斯定律并不像一个非常戏剧性的结果。它为我们提供了一种从其他概率量(条件概率和边际概率)计算一些概率量(条件概率)的简单方法。但是,如果我们现在考虑一个更丰富的世界,其中我们推理的事件对应于假设的真假和可能为此类推理提供信息的数据,那么信念度应该表示为主观概率的假设将贝叶斯定律从概率演算的简单重言式转变为对这些信念度应该如何通过经验改变的有力描述(即学习的数学理论)。

假设学习者为属于集合H的假设h分配概率P(h)。我们将这些称为先验概率(prior probabilities),因为它们是在观察数据之前分配的概率。然后学习者观察数据d并寻求计算在这些数据的光照下应该分配给假设的信念度P(h|d)。如果信念度遵循概率公理,那么这些后验概率(posterior probabilities)应该通过应用条件概率公式来计算,在方程(3.4)中用d替换a,用h替换b得到

P(d|h)P(h)

P(h|d) = , (3.5)

P(d)

其中 P(d|h) 被称为似然(likelihood),指定了如果假设 h 为真时观察到数据 d 的概率。

如果我们展开分母,贝叶斯法则更容易理解:

P(h|d) = P(d|h)P(h) / ∑P(d|h)P(h) , (3.6) h∈H

其中分母 P(d) = ∑P(d, h) 根据边际化原理,而 P(d, h) = P(d|h)P(h) 根据链式法则。这清楚地表明分母的主要作用是作为归一化常数(normalizing constant),确保结果概率和为1。因此,贝叶斯法则也常写成:

P(h|d) ∝ P(d|h)P(h), (3.7)

其中归一化常数被吸收到比例关系中。这非常清楚地表明,后验概率实际上只是先验概率被每个假设预测观察数据的程度所修正。

决定后验概率的两个项——似然和先验——在许多问题中都有很自然的解释。似然反映假设与数据之间的拟合度,先验表示假设的先验合理性(plausibility)(对于频率低、复杂或看起来不太可能的假设,先验合理性可能会降低)。这两个因素对我们应该得出的结论的贡献是相当自然的,在各种情境中都有直观意义。回到第1章介绍的例子,如果你看到约翰在咳嗽(你的数据 d),你可能考虑关于咳嗽原因的三个假设:感冒(h₁)、肺部疾病(h₂)或胃灼热(h₃)。你可能基于拟合度排除胃灼热,因为它只会轻微增加咳嗽的机会。感冒和肺部疾病都与咳嗽拟合良好——它们增加咳嗽的概率——但它们在合理性上有所不同。通常,感冒比肺部疾病常见得多,因此可能是你选择来解释咳嗽的假设。然而,如果你路过医院时看到约翰在里面咳嗽,这两个假设的合理性可能会改变。所有归纳推理(inductive inferences)都需要考虑拟合度和合理性。贝叶斯法则只是告诉你应该如何将它们结合起来得出结论,使用概率论的通用语言来确定每个因素的影响。

在认知科学的语境中,先验成为描述学习者归纳偏置(inductive biases)的有用方式——那些使他们在两个假设都与数据同样一致时选择一个假设而非另一个的因素(Mitchell, 1997)。从方程(3.7)应该清楚,如果两个假设的 P(d|h) 相同,那么获得更大后验概率的假设是具有最高先验概率的那个。认知科学中的许多问题都归结为关于归纳偏置的问题,包括以下几个:

• 儿童习得语言需要什么样的学习约束? • 什么样的类别结构容易或难以学习? • 人们是否偏好更简单的假设? • 人们对因果关系强度有什么期望? • 人们倾向于在随机数据中识别什么样的结构?

因此,认知的贝叶斯模型在回答这些问题方面特别有效。理性假设在这里也很有用,因为我们可以说”给定这些数据和关于数据解释的这些假设(即似然,P(d|h)),理想学习者只有在具有这些特性的归纳偏置时才能得出这个结论。”

在认知科学中谈论先验时,很容易将先验等同于学习的先天约束。这确实是使用贝叶斯模型的一种方式,但不是思考先验的唯一方式。实际上,假设的先验概率反映学习者知道的一切,除了当前的数据 d。因此先验可以通过经验学习,可以捕捉学习者可能拥有的知识的影响

在其他领域获得的知识。一个简单的演示是这样的概念:今天的先验

是昨天的后验。 假设您想要评估假设 h,并且您看到了两

段数据,d1 和 d[2]。如果这两段数据在给定 h 的条件下是独立的,那么我们可以写出

P[(]h[|]d 1, d[2][)] [∝] P[(]d[1][|]h[)]P[(]d[2] [|]h[)]P[(]h[)] [(3.8)]

因为 P[(]d1, d[2] [|]h[)] [=] P[(]d[1][|]d[2] , h[)]P[(]d[2][|]h[)] 通过因式分解,独立性假设

意味着 d1 的条件概率不会基于 d[2] 的值而改变,所以 P[(]d[1][|]d[2], h[)] [=] P[(]d[1][|]h[)]。由于我们也知道 P[(]h[|]d[1][)] [∝] P[(]d[1][|]h[)]P[(]h[)],我们可以将其重写为

P[(]h[|]d1, d[2][)] [∝] P[(]d[2][|]h[)]P[(]h[|]d1 [)], [(3.9)]

其中我们只是改变了比例常数。所以如果您昨天看到了 d1

并将您对假设的分布从 P[(]h[)] 更新为 P[(]h[|]d[1][)],然后今天您看到了 d[2],您可以直接使用 P[(]h[|]d[1][)] 作为您的先验并计算

新的后验 P[(]h[|]d 1, d[2][)]。因此,任何先验分布都假设有一组隐含被条件化的背景知识——在我们所有昨天中积累的数据。

贝叶斯规则适用于任何形式的数据 d 和假设 h。然而,在假设形成离散集的情况下最容易理解。接下来我们将详细探讨这种情况,然后再考虑连续假设的贝叶斯推断。我们将从两个假设开始,然后考虑如何推广到多个假设。

在比较两个假设的背景下,贝叶斯推断的数学最容易介绍。例如,想象您被告知一个盒子包含两枚

硬币:一枚50%的时间产生正面,另一枚90%的时间产生正面。您选择一枚硬币,然后抛掷十次,产生序列

[HHHHHHHHHH]。您选择了哪枚硬币?如果您得到的是[HHTHTHTTHT],您的答案会如何改变?

要用贝叶斯术语形式化这个问题,我们需要识别假设空间 [H]、每个假设的先验概率 P[(]h[)],以及每个假设下数据的概率 P[(]d[|]h[)]。我们有两枚硬币,因此有两个假设。如果我们用 [θ] 表示硬币产生正面的概率,那么 h[0] 是 [θ] [=] 0.5 的假设,h1 是 [θ] [=] 0.9 的假设。由于我们没有理由相信选择一枚硬币比另一枚更可能,假设相等的先验概率是合理的:P[(]h[0][)] [=] P[(]h[1][)] [=] 0.5。包含 n[H] 个正面和 n[T] 个反面的特定硬币翻转序列由产生正面概率为 [θ] 的硬币生成的概率是 贝叶斯推断 [[67]]

P [n] [n] [H] [(] d [|] [θ)] [=] [θ] [(] 1 [−] [θ)][T] . (3.10)

正式地,这个表达式来自假设每次翻转都是从参数为 [θ] 的伯努利分布(Bernoulli distribution)中独立抽取;用较不正式的说法,正面以概率 [θ] 出现,反面以概率 1 [−] [θ] 在每次翻转中出现。因此,与 h[0] 和 h1 相关的似然可以通过将适当的 [θ] 值代入方程(3.10)获得。

我们可以取前一段中定义的先验和似然,直接将它们代入方程(3.6)来计算两个假设的后验概率,P[(]h[0][|]d[)] 和 P[(]h1 [|]d[)]。然而,当我们只有两个假设时,使用后验几率(posterior odds)或这两个后验概率的比值通常更容易。支持 h1 的后验几率是

P[(]h[1][|]d[)] P[(]d[|]h[1][)] P[(]h[1][)] [=]

, [(3.11)]

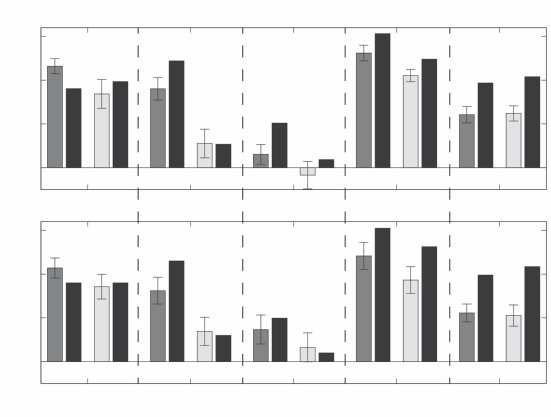

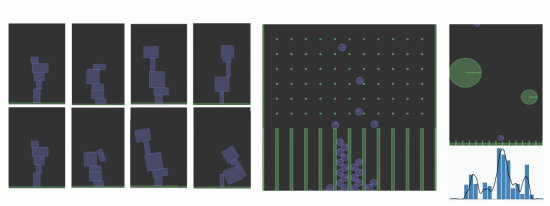

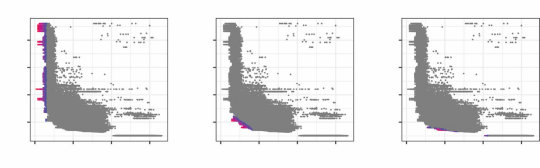

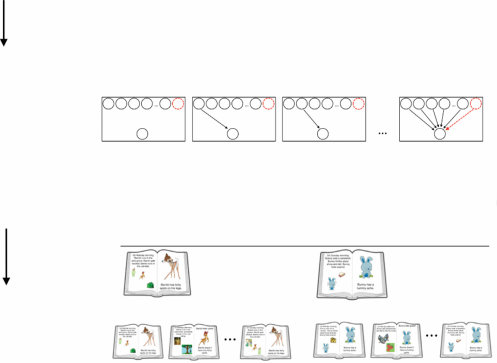

P[(]h[0][|]d[)] P[(]d[|]h[0][)] P[(]h[0][)]