生产高质量软件更快速度的经验实践

Nick Durkin, Eric Minick

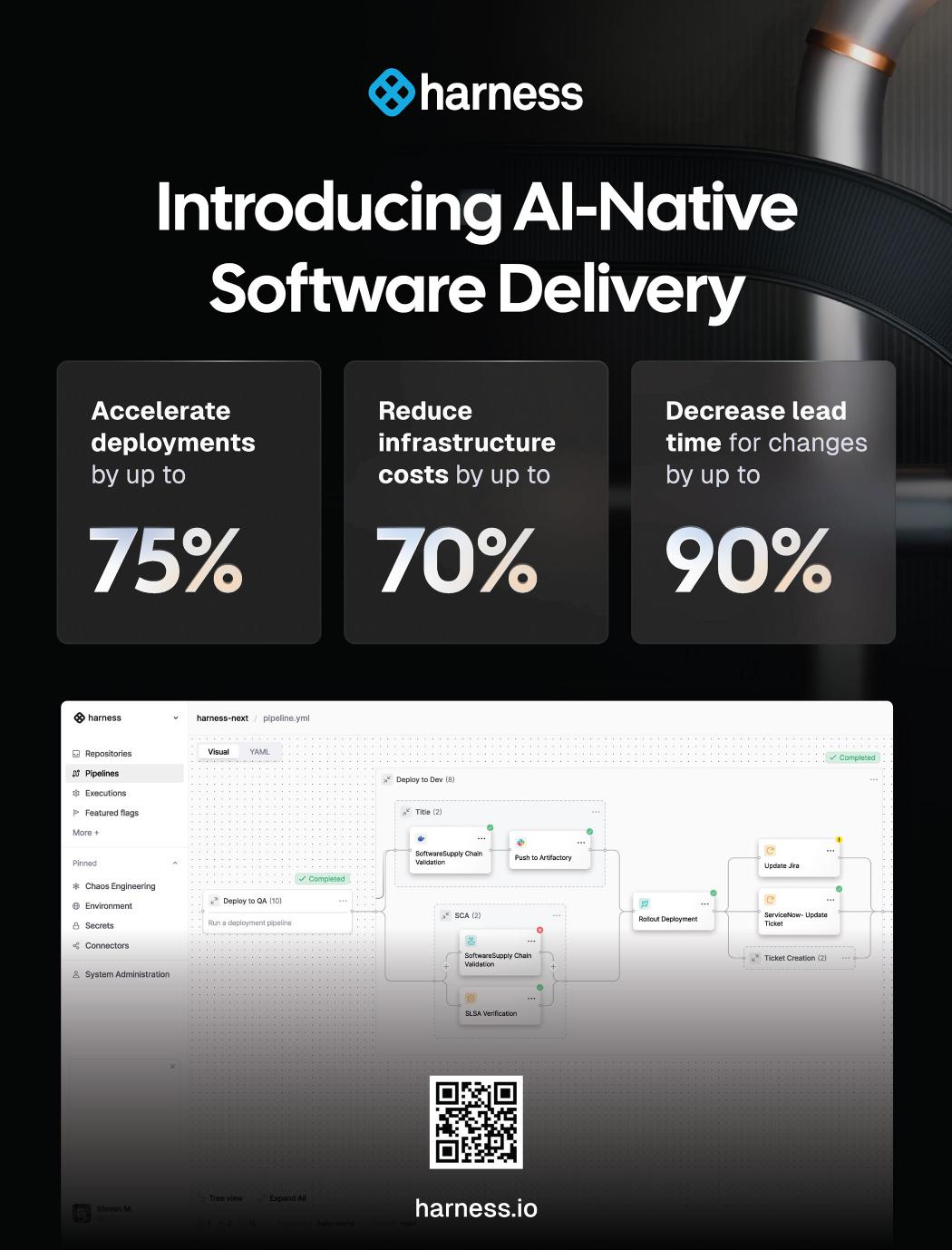

& Chinmay Gaikwad AI-Native软件交付

AI编码助手正在帮助团队比以往更快地创建软件。但要将这种速度转化为真正的创新,组织必须超越编写代码,快速、安全、可靠地交付软件。

虽然AI辅助编码现在已经成为主流,但代码编写完成之后发生的事情仍在追赶中。AI-Native软件交付是您将AI应用于整个交付生命周期的实用指南,从提交到生产及之后。

本书专为软件工程师、DevOps领导者和技术高管而写,探讨了领先团队如何使用AI来简化CI/CD、管理云成本、加强安全性并消除运营负担。本书还揭示了脆弱自动化的风险,并向您展示如何避免构建不可扩展的系统。

Nick Durkin 是Harness的现场CTO,负责组织的全球现场工程团队、售后工程团队和部分平台。

Eric Minick 是Harness的DevOps解决方案高级总监,专注于开发者体验和启用AI-native管道。

Chinmay Gaikwad 结合了深厚的AI-native DevOps和AppSec专业知识与战略营销领导力,担任Harness的产品营销总监。

您将学习如何:

• 在交付工作流程中集成AI以加速价值实现时间

• 避免分片自动化策略的常见陷阱

• 采用可随团队扩展的DevSecOps原则

• 在AIOps、混沌工程和SRE中应用实际做法

• 通过智能管道和反馈循环为您的交付做好未来准备

无论您是在演进传统交付流程还是设计新平台,本指南都将帮助您引领组织进入软件交付的AI-native未来。

软件架构

ISBN: 978-1-098-17200-8

生产高质量软件更快速度的经验实践

Nick Durkin, Eric Minick, and Chinmay Gaikwad

AI-Native软件交付 Nick Durkin, Eric Minick, and Chinmay Gaikwad 著

版权所有 © 2025 O’Reilly Media, Inc. 保留所有权利。

由O’Reilly Media, Inc.出版,141 Stony Circle, Suite 195, Santa Rosa, CA 95401.

O’Reilly图书可用于教育、商业或销售推广用途。大多数标题也有在线版本(http://oreilly.com)。如需更多信息,请联系我们的企业/机构销售部门:800-998-9938 或 corporate@oreilly.com。

采购编辑: Louise Corrigan 开发编辑: Jeff Bleiel 制作编辑: Elizabeth Faerm 复制编辑: J.M. Olejarz 校对: Krsta Technology Solutions

索引制作: Potomac Indexing, LLC 封面设计师: Karen Montgomery 封面插画师: José Marzan Jr. 内页设计师: David Futato 内页插画师: Kate Dullea

2025年8月:首版

首版修订历史

2025-07-25:首次发布

发布详情请参见 http://oreilly.com/catalog/errata.csp?isbn=9781098171995。

O’Reilly标志是O’Reilly Media, Inc.的注册商标。AI-Native软件交付、封面图像和相关商业外观是O’Reilly Media, Inc.的商标。

本作品中表达的观点是作者的观点,不代表出版商的观点。虽然出版商和作者已善意努力确保本作品中包含的信息和说明准确,但出版商和作者不承担任何错误或遗漏的责任,包括但不限于因使用或依赖本作品而导致损害的责任。使用本作品中包含的信息和说明的风险由您自行承担。如果本作品包含或描述的任何代码示例或其他技术受开源许可证或他人的知识产权约束,您有责任确保您的使用符合此类许可证和/或权利。

本作品是O’Reilly和Harness之间合作的一部分。请参见我们的编辑独立声明。

978-1-098-17200-8

软件行业正站在一个关键时刻。系统日趋复杂,用户需求呈指数级增长,而失败的代价——无论是财务、声誉还是运营方面——都达到了前所未有的高度。然而,尽管经过几十年的进步,许多团队仍然被过时的实践所束缚:手动部署、被动救火,以及在自身复杂性下崩溃的工具链。本书的存在就是为了弥合我们现在所处位置与我们需要到达位置之间的差距。它是引导我们从脆弱、高风险的交付转向AI驱动自治的路线图——一个软件自我部署、系统自我修复、创新速度超越风险的未来。

本书面向以下读者:

• 工程师和DevOps实践者,寻求用智能自动化取代繁重工作

• 技术领导者,负责将DevOps成熟度与业务成果(如速度、韧性和成本控制)对齐

• 产品经理和创新者,希望了解AI原生交付如何加速价值实现时间

• 任何投资于软件未来的人,从CTO到学生,准备重新思考部署、测试和可观测性的可能性

作为受过训练的软件工程师,我们花了多年时间研究软件开发和交付的演进。但OpenAI在2022年底推出ChatGPT标志着我们的一个关键时刻。像该领域的许多人一样,我们将生成式AI不仅视为编码助手,而是重新构想整个交付流水线的催化剂。

这本书不是关于追逐趋势。它是关于构建在复杂性中茁壮成长的系统。每一章都将理论与现实世界的例子相结合,从《凤凰项目》的DevOps寓言到AI驱动的部署。无论你是从头到尾阅读还是深入特定章节,你都将具备改变交付流程和团队影响力的能力。

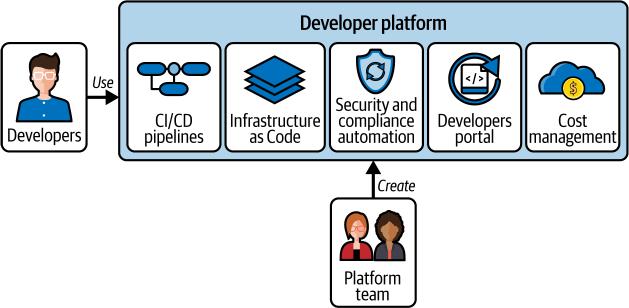

前言 | xi,将平台视为以开发者为客户的产品——所有这些都通过一个实际案例研究加以说明,该案例展示了一家金融服务组织如何仅用6名平台工程师服务1,400名开发者就转变了其交付能力。

本书使用的约定

本书使用以下排版约定:

斜体

表示新术语、URL、电子邮件地址、文件名和文件扩展名。

此元素表示一般注意事项。

O’Reilly在线学习

40多年来,O’Reilly Media为公司成功提供技术和商业培训、知识和见解。

我们独特的专家和创新者网络通过书籍、文章和我们的在线学习平台分享他们的知识和专业技能。O’Reilly的在线学习平台为您提供按需访问的实时培训课程、深入学习路径、交互式编码环境,以及来自O’Reilly和其他200多家出版商的大量文本和视频集合。更多信息请访问https://oreilly.com。

如何联系我们

请将有关本书的评论和问题发送给出版商:

O’Reilly Media, Inc. 141 Stony Circle, Suite 195 Santa Rosa, CA 95401 800-889-8969(美国或加拿大) 707-827-7019(国际或本地) 707-829-0104(传真) support@oreilly.com https://oreilly.com/about/contact.html

xii | 前言 我们为本书建立了一个网页,其中列出了勘误、示例和任何附加信息。您可以在https://oreil.ly/ai-native-software-delivery访问此页面。

有关我们书籍和课程的新闻和信息,请访问https://oreilly.com。

在LinkedIn上找到我们:https://linkedin.com/company/oreilly-media。

在YouTube上关注我们:https://youtube.com/oreillymedia。

致谢

我们对许多人的专业知识、鼓励和坚定不移的支持表示深深的感谢,是他们将这本书从一个大胆的想法转化为现实。

特别感谢我们优秀的同事提供的主题专业知识:Matthew Schillerstrom、David Karow、Mridhula Venkat、Dan Gordan、Sean Roth、Harold Bell和Patrick Wolf。

我们还要感谢本书的技术审稿人——Charles Humble、Julian Setiawan、Sagar Gandhi和Laura Uzcategui——他们对本书技术方面提供的宝贵反馈。

同时感谢O’Reilly团队在这个有意义的过程中与我们合作:收购编辑Louise Corrigan、开发编辑Jeff Bleiel、制作编辑Elizabeth Faerm和总编辑Lisa LaRew。还要感谢Kristy Saunders。

前言 | xiii

通往AI原生DevOps之路

大多数软件开发团队都能讲述部署失败的惨痛故事。正是这些故事让我们踏上了现代化交付实践的道路。这里有一个例子:经过数周或数月的功能开发、大量重构以及漫长的测试和稳定阶段后,团队准备部署了。开发人员、运维团队成员、一群经理,甚至可能是一些高管聚集在”作战室”里。到目前为止,开发和运维之间的协作微乎其微。然而,现在这两个团队正作为一个整体共同工作。他们开始逐一检查长长的清单或手册中的手动步骤。然而,即使是详尽的清单也不能保证部署过程没有问题。鉴于发布中的变更数量,部署很可能既复杂又有风险。正如我们将在后续章节中看到的,依赖管理是具有挑战性的,“依赖地狱”可能是非常真实的。因此,团队可能会发现生产环境中缺少关键依赖。团队可能发现安装了不兼容的库版本,或者关键设置配置错误,或者迁移步骤失败或被遗忘,或者变更导致对合作伙伴服务的请求失败。

任何数量的失误都可能使已经复杂的部署偏离轨道。紧张情绪会加剧,救火会随之而来,时间会不断延长。团队希望在部署窗口内完成部署和任何后续的手动冒烟测试。如果部署无法挽回地失败且无法挽救,团队会希望回滚到之前版本不会导致意外困难,从而延长停机时间和复杂性。当部署最终完成时,疲惫不堪的团队撤退了。通常,在”重症监护期”内,团队需要在流量恢复时保持警惕。可能会有几天或几周的稳定期,在此期间开发团队可能会暂停所有功能工作,专注于热修复或补丁。

[1]

如这个故事所示,高负荷、高风险的部署对开发和运维团队来说都是令人疲惫的。这些大规模生产部署,伴随着稳定化工作周期,分散了团队继续构建增加业务价值功能的注意力。

相比之下,现代软件交付简化并加速了从开发者计算机到最终用户获取软件的整个过程。部署频繁、低调、低风险且高度自动化。但我们正进入一个新时代——一个超越自动化的时代。下一个前沿是AI原生(AI-native)软件交付。AI原生交付将AI编织到软件交付生命周期的每一层,使智能代理能够做出决策、优化工作流程并实时适应。这些代理——从代码和DevOps到安全和测试——自主协作,强制合规性,自愈基础设施,并使用强化学习持续优化软件交付管道。这一转变标志着从被动治理到主动治理,从孤立工具到统一生态系统,从静态自动化到动态自治的转变。

随着AI生成代码、编排管道并减少手动工作,开发速度得到加快。系统变得更加有弹性和安全,AI能够主动识别问题并自主解决它们。同时,通过智能优化降低云成本,随着AI驱动的代理以机器速度处理跨团队协调和决策制定,协作规模得到扩展。在本章中,我们将描述软件交付在过去25年中是如何演变的。我们将定义DevOps并描述DevOps实践如何实现现代软件交付。我们将研究当前DevOps状态面临的众多挑战。最后,本章将概述现代软件交付、DevOps实践和AI原生方法如何演变以应对这些挑战。

“DevOps”一词通常归功于Patrick Debois,他在2009年将”development”和”operations”两词结合起来,为他组织的一次会议命名,该会议旨在探索打破开发和运维团队之间传统壁垒以更快地交付软件。两个主要因素造成了这些壁垒:

沟通和协作不良

开发人员通常专注于编写代码和功能,然后基本上将完成的产品扔过隐喻的墙给运维团队。然后运维承担在生产环境中部署、维护和排除代码故障的责任。

[2 | 第1章:AI原生DevOps之路]

优先级冲突

开发团队优先考虑快速开发和新功能的快速发布,而运维团队专注于系统稳定性、安全性和防止停机。尽管优先级不同,这些团队本质上是相互连接和相互依赖的。无论您的代码或基础设施多么令人印象深刻,在部署并在生产环境中运行以服务于您的业务目标之前,它没有真正的价值。

这种目标不匹配,有时被称为”核心慢性冲突”,可能会在问题出现时导致摩擦和相互指责。

作为回应,DevOps原则鼓励在每个阶段进行沟通。它们鼓励运维在开发早期参与,并在代码部署后与开发人员建立持续的合作伙伴关系来支持代码。

越来越复杂的软件团队、新的软件方法论和新工具帮助为DevOps铺平了道路。在本节中,我们将研究这些因素。

在2000年代初期,组织对如何提高软件交付效率的新想法变得非常感兴趣和接受。基于精益制造理念的新”敏捷”方法论变得流行起来。这些方法论反对强调大量前期规划和严格线性序列不同阶段的”瀑布”软件交付模式。相反,敏捷提倡短开发周期和频繁发布,对变化高度响应。许多并行努力将新的敏捷实践正式化。1995年的一篇论文正式化了Scrum实践。Kent Beck在他1999年的著作《极限编程解释》(Addison-Wesley)中描述了一套软件开发的敏捷实践。2001年,Beck和其他敏捷流程的有影响力的倡导者在敏捷宣言中谈到了类似的主题,该宣言提倡适应性和响应性而非严格遵守计划。[1] DevOps从宣言的第一个原则借用了”持续交付”这个名称:“我们的最高优先级是通过早期和持续交付有价值的软件来满足客户。”

Jeffrey Fredrick观察到,Ken Schwaber的Scrum书籍从2001年到2007年的发展历程,可以作为敏捷日益成熟和组织影响力扩大的一种晴雨表。在这段时间里,由于其清晰的结构、规范性的角色和跨团队的适应性,Scrum正在迅速成为主导的敏捷实践。2001年,《使用Scrum进行敏捷软件开发》(Pearson)向刚开始探索敏捷方法的开发人员和小团队介绍了

[1] [Kent Beck等人,][“敏捷软件开发宣言”](https://agilemanifesto.org),2001年,敏捷联盟。2010年6月14日检索。]

DevOps简史 | 3

这个框架。到2004年,《使用Scrum进行敏捷项目管理》(Addison-Wesley)解决了实际实施挑战,标志着在IT更广泛范围内的采用日益增长。到2007年,《企业与Scrum》(Microsoft Press)承认了将敏捷实践从单个团队扩展到整个组织的日益增长的需求。这些书籍反映了——并帮助塑造了——敏捷从边缘想法到企业必需品的旅程。

在接下来的十年里,技术组织越来越受到敏捷思维的影响。其中一个结果是采用了持续集成和持续交付(CI/CD)实践。

《敏捷软件开发宣言》产生了持续集成的实践,这使得敏捷的一个关键原则——频繁交付可工作软件成为可能。开发人员将他们的代码更改合并到共享代码库中。通过持续集成,每次合并都会触发自动化构建和测试过程。这个自动化系统能够快速捕获错误和冲突,使团队能够在开发周期的早期修复它们。持续集成鼓励更小、更频繁的更新,从而实现更快的交付、减少集成问题和更健康的代码库。

持续交付是持续集成的自然延伸。CD自动化了获取已通过集成构建和测试的代码并为发布到生产环境做准备的过程。这包括打包、配置和将软件部署到预发布环境等步骤。CD使团队能够快速可靠地推送新功能、错误修复和更新,确保可部署的软件始终可用。

在每个开发周期结束时交付”可能可发货的产品”是另一个关键的敏捷实践。可能可发货简单意味着可靠、经过测试、打包好的可以部署到生产环境的软件。(实际上,许多采用CD的组织只在内部交付,并继续不频繁地部署到生产环境。持续交付并不等同于持续部署。)

虽然敏捷方法论倾向于关注软件交付生命周期的规划和执行部分,早期的DevOps专注于交付和运维。在DevOps出现后的几年里,该运动获得了显著的发展动力。一个关键的里程碑发生在2009年,首届DevOpsDays会议举行。这个活动汇聚了专业人士分享他们在DevOps实践方面的经验和见解。

第1章:AI原生DevOps之路 | 4

另一个重要的发展是2010年Gene Kim、Kevin Behr和George Spafford出版的《凤凰项目》(IT Revolution Press)一书。这个叙述说明了一个虚构的IT组织面临的挑战,以及采用DevOps原则和实践如何导致其性能的戏剧性好转。它以一种技术和非技术受众都能产生共鸣的方式为DevOps论证了理由。第二年发布了另一本有影响力的出版物,Gene Kim、Jez Humble、Patrick Debois和John Willis合著的《DevOps手册》。这本实用指南通过提供实施DevOps的综合框架,帮助许多组织开始了他们的DevOps之旅。

2013年,Kim和Humble最初的Puppet Labs(现在的Puppet)“DevOps状态”报告引起了关注。该报告不仅关注技术指标;它强调了采用DevOps的商业效益,证明实施该方法的组织可以比同行快30倍地发布代码,故障减少50%。这将DevOps实践直接与领导者关心的商业成果联系起来。Nicole Forsgren、Jez Humble和Gene Kim合著的《加速:精益软件和DevOps的科学》(IT Revolution)一书更详细地探讨了这个主题。

Platform-as-a-Service (PaaS)和Docker在2013年的推出标志着另一个关键时刻,这些技术简化了应用程序的部署和管理,使DevOps实践在更大规模上变得可行。在此之前,管理基础设施和应用程序的复杂性使得DevOps的广泛采用变得困难。AWS Lambda在2014年的推出进一步改变了格局,它开创了大规模事件驱动函数执行的先河,使开发人员能够专注于编写代码而无需担心底层基础设施。与此同时,同样在2014年推出的Kubernetes为大规模编排容器化应用程序提供了强大的框架,确保部署可靠、高效且可扩展。

到2010年代后半期,机器学习(ML)技术开始渗透到DevOps工具链中,特别是在应用程序性能监控(APM)和测试领域。测试工具使用ML来优化测试执行并检测用户界面中的变化。与此同时,Datadog和New Relic等APM工具较早地将自己标记为”AI Ops”,因为它们使用ML来识别有问题的信号。到2018年,Harness将ML应用于持续交付来检测有问题的信号,使系统能够识别部署何时引起问题并触发必要的回滚。这些技术共同为现代DevOps奠定了基础,提供了高效管理复杂软件系统所需的工具和框架,为AI原生DevOps铺平了道路。

DevOps已经从一个松散的小众概念发展成一套完善的理念,我们可以称之为”DevOps 1.0”。其特征包括:

文化转型

认识到文化转变对于协调软件开发和运维团队的重要性

自动化实践

实施诸如持续集成和持续交付等实践来简化软件交付

自动化工具

利用特定工具来自动化软件交付管道的各个阶段,包括代码提交、测试、部署、配置和生产监控

DevOps 1.0实践的早期采用者获得了立竿见影的成果。在2010年代初期,许多工程团队按季度发布软件,需要数周的手动测试、协调和生产部署工作。这些发布流程缓慢、容易出错,并且需要在非工作时间进行调度以降低风险。当组织开始采用早期DevOps原则——让开发和运维团队更紧密地合作并自动化交付管道的关键部分——他们实现了更快的发布周期、更高的可靠性和更少的手动工作。对许多组织来说,这种转变使他们能够从季度发布转向双周甚至周发布,为更迭代的开发和更快的价值实现时间奠定了基础。

DevOps 1.0提供了有价值的概念、实践和工具。然而,如今的公司在充分实现DevOps收益方面面临新的挑战,原因包括:

• 引入复杂性并要求DevOps适应的软件趋势

• DevOps 1.0工具集要么功能不足,要么对许多组织来说过于复杂

以下章节将详细探讨这些挑战。

云原生和微服务架构的采用。新的架构模式涉及数十个离散的微服务,部署到单独的容器中。DevOps 1.0管道无法满足这些新架构的要求。

在过去十年中,微服务和云原生架构已成为现代软件开发的事实标准,这是由于对软件系统更大可扩展性、灵活性和敏捷性需求的驱动。这些架构为DevOps团队引入了重大的新要求。微服务的采用导致需要部署的服务激增,每个服务都有自己的依赖项和配置。在这些分布式服务中编排部署和维护一致性变得越来越具有挑战性。

容器(云原生系统的关键特性)和无服务器架构的使用需要部署和管理的新策略,并增加了另一层复杂性。DevOps团队现在必须处理跨数十甚至数百个短暂容器或无服务器函数的部署,这需要强大的编排工具、用于构建和管理容器生命周期的自动化流程,以及对这些新兴技术的深入理解。自动化容器的整个生命周期——从构建镜像到将其推送到注册表,再到以最小停机时间推出更新——对于高效的容器管理至关重要。

开源软件的兴起。开源软件(OSS)已成为现代软件开发中无处不在的一部分。虽然OSS提供了众多好处,但它为DevOps团队引入了新的挑战。管理依赖项、确保与不同版本的兼容性,以及在多个OSS组件中维护安全补丁可能是一项艰巨的任务。此外,团队必须仔细审查代码并确保其符合组织的安全和合规标准。

数字化体验和企业消费化的重要性。 在这个数字化颠覆的时代,Marc Andreessen的预言”软件正在吞噬世界”变得越来越准确。一家公司提供的数字化体验正在成为客户的主要接触点,塑造着他们体验品牌的方式。此外,企业技术的消费化意味着员工期待与面向消费者的应用程序相同的无缝体验和持续更新。这些期望给DevOps团队带来压力,要求他们提供更频繁的发布、维持高可用性,并支持实验以推动快速创新。

超越DevOps 1.0工具集

自2009年首届DevOpsDays以来的这些年里,我们对工具的需求已经发生了变化。交付节奏加快了,同时监管负担也增加了。以artifact registries为例:最初作为本地缓存来加速构建,现在它们对于确保跨多种语言的软件供应链安全至关重要。为了简化部署,我们进行了容器化,但我们的构建变得更长,使得我们的持续集成构建不再持续。我们从一套配置管理工具转向更新的、云原生的声明式工具。

DevOps简史 | 7

但我们仍然需要测试、保护和治理这些基础设施变更。与此同时,新工具不断出现——每个都承诺改进,但也需要与其他所有工具进行连接。对于许多团队来说,当前的技术栈正在崩溃。管道很快变得非常复杂。组织平均管理10个或更多不同的工具来部署软件。例如,一个部署Rails、Sidekiq和NodeJS应用的自动化管道可能包括以下工具:

• GitHub actions用于运行CI

• 用于监测Sidekiq、Rails和Puma并将应用指标推送到Prometheus的库

• Docker镜像构建和Kubernetes

• Artifactory用于存储镜像和Helm charts

• ArgoCD用于Kubernetes上的GitOps部署

• Helm用于管理部署和升级

• Terraform用于管理Amazon Web Services (AWS)基础设施、角色、权限等

• New Relic用于异常捕获和监控

• Kube-state-metrics用于收集容器指标

• Prometheus用于存储指标

• Grafana用于使Prometheus指标可消费

这个工具集的集成和管理可能对资源有限的团队构成相当大的挑战。让我们看看DIY方法的一些挑战。

广泛使用的开源工具往往不是最优的。 DevOps的DIY方法通常导致效率较低的管道。一些开源工具缺乏能够减少开发人员工作量和缩短生产时间的功能。例如,在Jenkins中维护正常运行时间和扩展需要大量资源。长时间的测试可能导致缓慢的构建。最后,重用管道的模型是复制/粘贴,导致”管道蔓延”,这可能难以维护且成本高昂。第3章将详细介绍这些问题。

DIY管道导致冗余和浪费的努力。 团队通常必须实现管道来将工具和系统整合在一起。这导致大量的重复造轮子。例如,Jenkins和ArgoCD是用于CI/CD的常用工具。这些工具为自动化软件开发和部署过程提供了强大的功能,但它们要求团队从头构建基本架构,如基于角色的访问控制(RBAC)、审计日志和通知。

第1章:AI原生DevOps之路 | 8

实施和维护这些功能的努力本可以用于为客户提供价值。

自动化往往不完整,需要手动步骤。 一个团队在大部分部署中使用自动化脚本,但需要手动干预来配置环境变量,如果不是所有团队成员都遵循相同的程序,这可能导致不一致的部署。不完整的自动化可能导致监控和反馈循环中的空白,因为手动步骤可能不会触发自动警报或指标收集。手动步骤引入了人为错误的风险,这可能导致停机或安全漏洞。因此,DevOps中不完整的自动化可能导致效率低下、错误和可扩展性问题。

治理是事后考虑。 没有前期治理,团队可能忽视合规要求(如满足通用数据保护条例[GDPR]标准),导致在后期发现问题时需要昂贵的返工或面临罚款。如果安全措施应用不一致或作为事后考虑,应用程序就容易受到攻击。没有明确的治理政策,云服务或基础设施等资源可能被过度配置或未充分利用,导致成本浪费(我们将在第9章中讨论这个话题)。没有监督,团队可能使用不同的工具、流程和标准,导致集成挑战和效率低下。

DevOps 2.0

DevOps 1.0已经显著加速了许多公司的软件交付过程。然而,其复杂性、留下的空白以及所需的投资为改进创造了空间。进入我们称之为DevOps 2.0的阶段——一个由更简单的开发者体验、端到端自动化以及易于管理所有移动部件的视图,以及增强整个管道的AI能力所定义的愿景。这种演进将焦点从工具和流程转向它们所服务的人员和结果。

DevOps 2.0 流程和工具通过强大的新功能增强了开发者体验。开发者可以在几分钟内启动新项目和服务,通过自动化开发和交付工具链的设置来实现。开箱即用的集成使团队能够轻松创建和连接代码库、敏捷项目和管道。为了进一步简化流程,模板封装了组织的最佳实践,确保了一致性,并在创建新服务时消除了工作管理开销。团队专注于构建他们的应用程序,而不是繁琐的基础设施设置。AI 代理执行越来越复杂的 DevOps 任务,例如自动诊断和解决基础设施和管道问题,优化资源分配,以及基于观察到的性能模式提出架构改进建议。

[DevOps 简史 | 9]

DevOps 2.0 工具通过更具凝聚力、紧密集成的工具集来理清 DevOps 1.0 解决方案的复杂性。基本构件(RBAC、审计日志)已经集成。对各种部署策略和实验方法的支持已内置,使团队能够进行频繁发布和快速迭代。新工具能够扩展以支持跨多个环境的大规模部署,包括本地、云和混合设置。DevOps 2.0 工具将提供安全管道和策略执行,以最小化开源采用和 AI 编写代码的固有风险。

最后,AI 正在被融入到整个软件交付管道的 DevOps 2.0 工具和流程中。新兴协议如 Agent Control Protocol (ACP)、Model Context Protocol (MCP) 和 Agent-to-Agent Protocol 正在帮助实现 AI 模型与工具、系统和数据的更广泛生态系统之间的无缝交互。这些协议定义了 AI 代理与工具交互、安全访问数据以及在护栏内执行任务的标准化方式——使工作流程更加动态和自主。

在现代 DevOps 环境中,这些协议充当 AI 能力和运营基础设施之间的桥梁,让 AI 不仅仅是观察和建议;它们使 AI 能够采取有意义的行动,同时保持可审计性和合规性。随着 DevOps 2.0 拥抱越来越智能的自动化,这些协议为安全、可扩展和有效的 AI 驱动运营提供了基础,从而增强开发者工作流程。想象一下能够生成代码、注释、测试和基础设施脚本,或使用自然语言搜索提取相关代码片段的工具。此外,机器学习通过仅执行相关测试来加速测试周期。

利用 AI,这些工具在入职期间提供个性化指导,检测漏洞并提供修复建议或启动修复,甚至帮助编写和理解策略。通过分析可观察性遥测来识别何时需要回滚,从而提高部署的可靠性。AI 分析功能实验以了解变更的影响。这种贯穿软件开发生命周期(SDLC)的 AI 驱动转型正在提高生产力、改善质量、降低风险并增强整体开发者体验。随着开发者可以通过 AI 编码助手越来越快地编写代码,企业快速安全地将变更交付到生产环境并了解这些变更是否有益的能力将成为创新的限制因素。要做好这一点,需要既要做好 DevOps 的基础工作,又要在交付的每个阶段都注入前沿的 AI。

[第1章:通往 AI 原生 DevOps 之路 | 10]

现代软件交付强调快速发布、无缝体验和持续创新,推动了对传统 DevOps 实践的变革需求。虽然 DevOps 1.0 通过 CI/CD 和初步的跨团队协作奠定了基础,但它依赖于由不同解决方案构建的复杂工具链,这产生了障碍。这些挑战源于应用程序架构复杂性的增长(微服务、容器)、开源组件的激增,以及管理日益多样化工具集的需求。DevOps 2.0 旨在通过简化开发者体验、提供更加集成和智能的工具集,以及在整个管道中原生地注入 AI 来解决这些问题。这种演进承诺更高的效率、增强的质量,以及专注于交付价值而不仅仅是管理工具。

此外,AI 原生软件交付用自主代理(例如,代码、DevOps、安全)替代静态自动化,以实现自我优化系统和主动统一的生态系统。它通过自主代码生成、上下文管道创建、预测性故障解决和实时决策制定来加速开发速度、增强可靠性、确保合规性、降低成本并促进可扩展协作。虽然这是变革性的,但组织必须解决 AI 治理、数据隐私和技能差距问题,才能充分利用其优势。

在第2、3和4章中,我们将介绍 DevOps 自动化的骨干。这包括用于有效版本控制的源码控制管理,使用持续集成进行高效开发的构建和测试,以及使用持续交付系统进行无缝软件发布的内部部署。我们将探索 DevOps 1.0 的方法和 DevOps 2.0 带来的机会。

[总结 | 11]

想象一个场景,你和你的团队正在协作一个复杂的软件项目。多个人在贡献,进行修订和改进。如果没有清晰的变更管理系统,你们会面临覆盖彼此工作的风险,并且无法追踪谁更新了什么以及他们为什么进行这些更改。如果没有清晰的系统来标记变更集,当问题出现时,你们将无法导航回到团队代码的前一个稳定版本。如果没有定义的工作流程和结构化访问控制,任何人都可以在任何时候更改任何内容,而没有监督。如果没有控制,你的团队无法确定在需要重新创建特定发布版本时使用了哪些代码文件。接下来,想象几个团队已经在一个新应用程序上工作了几个月,现在接近部署到生产环境的时间。各种开发和QA环境都进行了临时修复和调整,但这些修改并没有可靠地反映在生产环境中。重要的生产设置没有在QA环境中重复,开发环境差异很大。鉴于所需环境日益复杂,启动新环境已经成为一个耗时且容易出错的瓶颈,造成挫折和延迟。

这些情况是功能失调和浪费努力的根源。源代码控制管理(SCM)实践正是为了解决这些问题而创建的。其核心是跟踪和管理随时间对代码和其他关键资源(如配置)所做的更改。

如今,人工智能正在改变我们处理SCM的方式。AI可以自动检测有风险的更改,建议对代码或配置的改进,甚至通过理解修改背后的意图来帮助解决合并冲突。它可以识别环境间的不一致性,推荐修正措施,并优化部署工作流程。AI驱动的工具不仅仅是帮助团队管理复杂性——它们正在实现更快、更安全、更有韧性的开发周期。随着软件交付变得更加分布式和动态,AI正在成为使SCM更加智能、主动和高效的重要合作伙伴。

跨团队协调更改的问题可以追溯到编程的早期,SCM实践的历史与计算机编程的演进密切相关。在本节中,我们将探讨SCM是如何演变的,以及AI工具在现代SCM中发挥的关键作用。

在编程的早期,程序相对简单;它们受到有限硬件的约束,代码管理也很初级。随着CPU变得强大和复杂,计算和代码变得更加复杂。代码存储库(提供基本SCM功能的中央存储)最初出现在1970年代,与高级语言和结构化编程方法学的兴起同时出现。像源代码控制系统(SCCS)这样的工具提供了基本的版本跟踪功能,允许开发者回滚到以前的版本并查看更改历史。这些早期系统反映了向更有组织的程序开发的转变。

SCM在1970年代随着更结构化的软件工程团队的出现而进一步发展。像1982年引入的修订控制系统(RCS)和1986年引入的并发版本系统(CVS)这样的工具添加了对协作至关重要的功能,包括分支。这使得更复杂的项目管理和协作文化成为可能。

在1990年代早期,IBM Rational ClearCase作为SCM的商业解决方案出现。它强调强大的配置管理和流程定制,使其适合复杂的软件开发环境。Subversion(SVN)是由CollabNet开发的另一个集中式代码存储库,获得了广泛认可。SVN 1.0于2004年发布,以解决CVS的不足并提供缺失的功能。

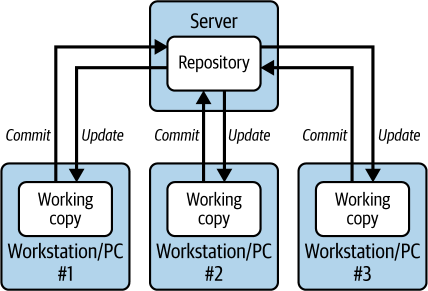

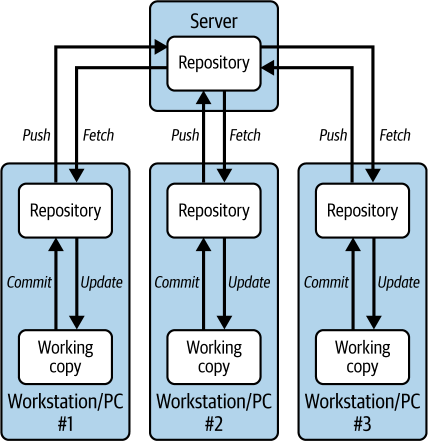

2000年代初期敏捷方法学和开源的兴起对软件开发提出了新的要求。快速发布意味着团队需要对日益复杂的代码库有更多的灵活性和控制。团队本身也发生了变化,变得更大且往往地理分散。Git由Linus Torvalds(Linux内核的创建者)于2005年创建。他需要一个强大而高效的系统来管理Linux项目的庞大代码库,而现有选项都不够用。版本控制系统(VCS)是跟踪文件随时间变化的核心技术,构成任何SCM方法的基础。与大多数早期代码存储库不同,Git是分布式VCS。在集中式VCS中,每个人都从存储在中央服务器(存储库)中的代码库的单一副本工作。每个开发者都有他们自己的本地副本(工作副本)可以修改。当开发者进行更改并提交时,这些更改立即上传到中央存储库,使其他所有人都能看到。要查看其他人的最新更改,开发者只需从中央存储库更新他们的本地副本。

图2-1显示了集中式VCS。

分布式系统采用了不同的方法。在这里,每个开发者在本地机器上都有完整的代码库副本(包括仓库和工作副本)。开发者所做的更改在本地副本中是私有的,直到他们明确地与团队共享这些更改。这是通过将更改”推送”到中央仓库来完成的。同样,要查看其他开发者所做的更新,用户需要从中央仓库”获取”这些更改到本地副本。

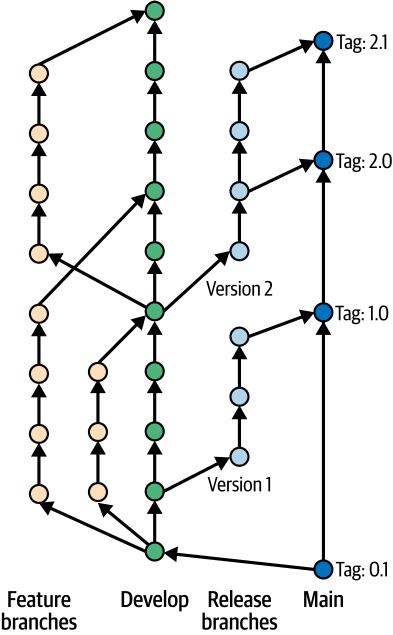

[图 2-2] 展示了 Git 分布式版本控制系统。

[源代码控制管理介绍 | 15]

图 2-2. 使用 Git 的分布式版本控制

Git 对速度的关注、其分布式特性和强大的分支功能使其在许多方面都成为了游戏规则的改变者:

分布式促进离线工作

Git 的去中心化方法促进了高效和独立的工作,因为开发者可以在没有中央服务器的情况下在本地进行更改。这也使开发者能够离线工作。

灵活的分支和合并

Git 的分支系统极其灵活。开发者可以创建独立的分支来开发新功能或修复错误,而不影响主代码库。将这些分支合并回主代码库是一个顺畅且高效的过程。这使开发者能够更自由地进行实验和迭代。

对大型代码库轻量且高效

Git 在高效处理大型代码库方面表现出色。它只存储代码版本之间的差异,使其比传统的 SCM 系统更快且需要更少的存储空间。

非线性历史有助于组织

与一些强制线性历史的 SCM 系统不同,Git 允许开发者通过变基等功能重写历史。这种灵活性有助于维护干净有序的代码库。

[16 | 第 2 章:源代码控制管理] 第一个广泛使用的托管 Git 仓库几年后才出现。GitHub,现在最受欢迎的平台,于 2008 年推出。这些平台建立在 Git 的强大基础上,提供了用户友好的 web 界面、代码库的云存储和协作功能。这种组合将 Git 从一个强大但技术性的工具转变为一个可访问的社交软件开发平台,使其成为现代软件开发工作流程的基石。虽然传统的集中式仓库仍有历史遗留足迹,并在有特殊需求的环境中使用,但 Git 现在是主要选择。2022 年 Stack Overflow 调查发现,94% 的受访者使用 Git,98% 使用任何源代码控制的人都使用 Git。因此,我们将重点关注 Git 仓库的变体。

2010 年,Gitflow 分支约定出现,使用分支在开发、功能创建和发布准备之间提供清晰的分离。

[图 2-3] 显示了 Gitflow 工作流程。在 Gitflow 工作流程中:

主代码库位于名为”main”的分支上。这个分支通常被认为是稳定的,应该只包含生产就绪的代码。

创建一个新的”develop”分支,作为所有开发工作的持续集成分支。

功能开发发生在从 develop 分支分出的独立分支(feature/release 分支)上。开发者在这些功能分支上开发新功能和修复错误。一旦功能完成并经过彻底测试,就会合并回 develop 分支。

develop 分支充当所有完成功能的集成点。它代表即将发布的版本,并通过合并功能分支持续更新。

当需要发布时,从”develop”创建发布分支。可以在此分支上进行错误修复和小幅调整。一旦确定,发布分支将合并回”main”以创建官方发布。在”main”中创建相应的标签来标记发布版本。

[源代码控制管理介绍 | 17]

Pull request,有时缩写为 PR,是 Git 版本控制中用于代码审查和集成的核心协作功能,广泛用于 Gitflow 和其他分支模型。Pull request 为开发者提供了一种结构化的方式来提议对代码库的更改,并在将更改合并到主分支之前让其他人审查。

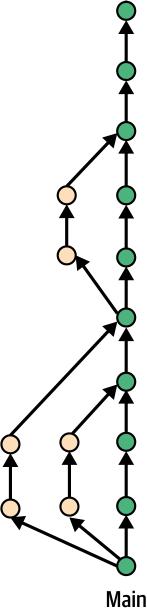

Gitflow 对计划发布和独立发布分支的强调受到了更新的 Git 分支模型的挑战。在持续集成和持续交付日益普及的推动下,这些模型优先考虑更快的部署和更频繁的更新。基于主干的开发完全摒弃了专用开发分支的想法。相反,功能在经过严格测试后持续集成直接到主分支(通常称为”trunk”或”main”)。

[图 2-4] 显示了这种模式。

[18 | 第 2 章:源代码控制管理]

图 2-4. 基于主干的开发

这种简化的方法允许更快的反馈循环和更快的部署,与现代 DevOps 实践保持一致。Pull request 在这些工作流程中仍然至关重要,确保在将更改合并到主分支之前通过代码审查来保证代码质量。

我们已经了解了代码仓库如何与编程和软件开发实践一起发展,以解决我们想象中的问题,使团队能够在源代码中有效协作。但是部署问题呢?我们如何高效系统地构建所需的环境,如何简化代码部署到生产环境的过程?这就是GitOps发挥作用的地方。在将Dev和Ops结合起来时,DevOps强调自动化在消除手动错误方面的重要性,并有助于确保跨环境的一致性。这转化为更快的部署、改进的可靠性和降低的风险。GitOps是指自动化基础设施配置的过程,特别是在现代容器优先的云基础设施中。GitOps强调使用代码仓库(通常是Git)作为系统所需状态的单一真实来源,并利用自动化来持续调和实际状态与所需状态。存储在我们仓库中的资源可以包括:

基础设施配置

定义环境所需组件的文件,虚拟机(VM)的类型和数量、存储配置、网络设置和安全策略。这可以包括声明式和命令式配置以及部署脚本。

环境变量

这些对于存储敏感信息(如密码或API密钥)至关重要,这些信息不应直接嵌入在代码中。基础设施即代码(IaC)工具通常具有安全管理和引用环境变量的机制。

其他资源

根据环境的复杂性,仓库可能还存储其他资源,如用于应用程序部署的容器镜像(通过git-lfs)。

使用我们的仓库作为单一真实来源,我们可以利用其强大的功能。我们获得详细的版本跟踪和变更历史,并且可以通过Git工作流管理基础设施更新,这些工作流通过拉取请求的代码审查等方式促进协作和监督。管理良好的基础设施自动化转化为更快的部署、更少的错误,以及每次需要创建新环境时的可靠环境。我们将在第4章中学习更多关于使用GitOps进行部署的内容。

我们在第1章中提到了微服务的重要性。在基于微服务的系统中,提高生产力的两个关键实践是使用monorepo和远程缓存。

Monorepo(单体仓库)是存储多个项目或服务代码的单一版本控制代码仓库。在微服务环境中,这种方法简化了协作,简化了依赖管理,实现了跨服务的原子更新,并减少了版本冲突。远程缓存是指在远程服务器上存储构建产物——如编译后的代码或测试结果。像Nx这样的工具使用这种技术显著加速开发工作流,通过允许团队重用以前生成的输出而不是从头重建,减少冗余计算。

monorepo和远程缓存一起支持更快、更高效的CI/CD管道,并有助于改善整体系统性能。然而,随着项目规模的扩大,monorepo可能会引入复杂性,如果没有周到的实施,远程缓存可能会引发供应商锁定的担忧。

AI工具已经彻底改变了开发人员处理编码的方式。GitHub Copilot、Cursor、Harness AI Code Agent和类似的编码助手/代理充当智能结对程序员,基于项目上下文提供实时代码建议。这些工具可以预测和建议整行或整块代码,显著加快开发过程。

除了代码补全外,AI助手还可以:

• 自动生成样板代码结构 • 建议不同的实现方法 • 提供代码解释和文档 • 协助调试和优化

AI原生软件交付始于AI原生SCM。AI与SCM的集成超出了代码补全的范围。在SCM内,AI可以分析仓库模式,在错误到达生产环境之前识别潜在bug,并基于在类似项目中观察到的最佳实践建议架构改进。这种主动方法显著减少技术债务,从开发的最早阶段就改善代码质量。我们将在本章后面探讨其中一些主题。

在接下来的部分中,我们将介绍SCM系统如何融入交付管道。在理解了这一点后,我们将讨论选择适合您团队的SCM时需要考虑的因素。最后,我们将查看现代代码仓库的特征,包括AI的作用,这些可以简化您的整个软件开发管道。

核心仓库是交付管道的关键组件,锚定整个管道流程。它作为代码的单一真实来源,确保一致性和可靠性,是开发人员持续交互的实体,启动集成和交付活动。

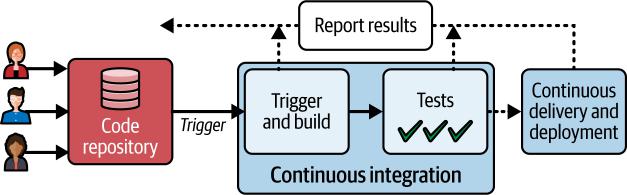

图2-5描述了代码仓库与持续集成和交付的关系。

让我们了解典型管道的三个主要部分:

代码仓库

开发人员对代码仓库进行操作,提交更改并打开和关闭拉取请求。

持续集成

持续集成由代码仓库中的特定动作触发。

这些触发器可以定制,包括代码提交、pull request的开启或关闭,或团队根据特定需求和实践确定的其他相关动作等事件。CI为开发者提供代码变更的快速反馈。通过自动化构建和测试,CI充当早期警报系统,提醒开发者注意潜在的错误、集成问题,甚至是代码风格违规。这种即时反馈使开发者能够快速解决问题,防止问题发展成更大、成本更高的问题。

通过CI,您的代码库保持在一致的可部署状态,为交付管道中的下一步做好准备。

持续交付和部署

持续交付和部署步骤自动化基础设施的配置以及新代码版本到一个或多个预生产环境的部署。通常会针对在预生产环境中运行的应用程序执行各种类型的测试。我们将在第4章中查看这些步骤。最后,自动或手动决策控制软件到生产环境的最终部署。我们将在第8章中详细讨论这些步骤。通过频繁部署较小的变更,CD简化了交付流程,降低了发布风险,并增强了快速响应用户反馈的能力。

22 | 第2章:源码控制管理 许多代码仓库内置了密钥检测功能。密钥可以包括以下内容:

API密钥

用于认证和授权访问各种Web服务和API的唯一标识符

访问令牌

授予应用程序或资源特定访问权限的临时凭据

OAuth令牌

用于委托授权的令牌,允许一个应用程序代表用户访问资源

私钥

在非对称加密中用于解密消息或验证数字签名的密钥

用户名和密码

用于系统和服务基本认证的凭据

数据库连接字符串

建立数据库连接所需的详细信息,通常包括主机名、用户名和密码等敏感信息

云服务连接字符串

用于连接云服务(如Azure存储或AWS S3)的字符串,可能包含访问密钥和其他密钥

一些代码仓库会在开发者尝试提交或合并包含检测到的密钥的代码时阻止或警告开发者。CI流程可以在密钥检测中发挥作用,防止它们到达生产环境。理想的方法是利用两者来实现全面的安全性。

鉴于SCM对软件开发的重要性,选择代码仓库是团队要做的首要决策之一。我们将把源代码放在哪里?是团队需要回答的问题,甚至在启动项目时就需要回答。首先,仓库必须支持对您团队至关重要的基本操作和开发者工作流:

代码仓库考虑因素 | 23

• 创建、导入和克隆仓库,支持分布式离线工作

• 分支、合并和定义分支规则以满足您特定团队的需求(例如,限制特定用户的分支创建/删除)

• 创建、审查和合并pull request,以及定义符合您团队所需治理的pull request策略(例如,要求所有变更都与pull request关联,禁止直接提交,或设置所需审查者批准的最小数量)

• 创建和修改标签,并定义标签策略(例如,强制标签名称遵循特定模式,如语义化版本控制)

虽然在实现细节上可能有差异,但这些都是预期的仓库功能。

在创建交付管道时,团队通常首先从仓库选择开始;因为这是一个对实现有深远影响的选择,确保您的代码仓库能够在更广泛的生态系统中支持无缝集成至关重要。您的代码仓库应该在一个增强团队生产力而不是增加工作负担的生态系统中运行。此外,解决方案应该具有成本效益,并提供您的组织所需的透明度。

设计良好的DevOps生态系统的特点是易于使用的工具和与交付管道所需的功能和服务的全面集成。这与零散的方法形成对比,在零散的方法中,开发者需要手动集成许多不同的工具,这可能导致难以排除故障的问题和安全风险。这也与过于复杂的单平台解决方案形成对比,后者通常存在功能臃肿的问题,难以配置。

流线化集成的一个例子是配置即代码。这种实践允许交付管道的更新像项目代码一样直接在仓库中进行版本化和跟踪。您可以通过强制要求通过pull request和审批进行变更的工作流来进一步加强协作和治理,这反映了标准的开发实践。

另一个功能示例涉及安全/漏洞扫描。在pull request上下文中显示检测到的漏洞和建议的修复方法有助于开发者快速理解和解决任何检测到的问题。

24 | 第2章:源码控制管理

过去几年里,使用大型语言模型来提高开发人员效率的编程助手或代理出现了爆炸式增长。这些编程助手可以帮助自动完成代码、生成代码建议、理解代码功能,以及许多其他用例。当AI助手与代码仓库集成以获得完整代码库上下文时——而不仅仅是孤立的代码片段——它们可以生成更准确和相关的建议。MCP在这里发挥关键作用,提供通用的标准化方式来连接AI模型和编程助手与各种数据源,包括Harness Code Repository、GitHub和Git等仓库。这消除了对自定义集成的需求,减少了开发工作量并提高了效率。生成式AI (GenAI)在代码仓库中的另一个强大应用是语义搜索——使用自然语言搜索整个代码库的能力。像Sourcegraph的Cody和Harness Code Repository这样的工具使开发人员能够询问”身份验证是如何实现的,这些代码在哪里?“等问题,而不是依赖于基于关键词的搜索,如”登录”或”身份验证”。这种能力对于新团队成员的入职特别有价值,帮助他们快速理解复杂的代码库,而无需深入熟悉项目特定的术语。

关于代码审查,像DeepCode和Codacy这样的工具使用ML算法来审查代码变更,自动检测潜在的错误、代码异味和编码标准遵循情况,比手动审查更加高效。AI在SCM中的其他用例包括:通过在代码提交前自动扫描漏洞和合规性问题来增强安全性,并为这些问题推荐修复方案,总结pull request,以及使用SCM作为数据源之一生成软件交付流水线。

需要注意的是,对于AI系统,结果很大程度上取决于用于训练AI模型的数据。因此,例如,“好”的代码会产生好的代码建议和审查,而”坏”的代码会产生坏的代码建议和审查。

衡量AI的影响在验证使用AI是否真正对开发人员产生积极影响方面同样重要。Harness Software Engineering Insights等工具可以帮助衡量使用不同编程助手的开发人员的生产力,并将其与不使用任何编程助手的开发人员进行比较。

AI驱动的SCM通过生成快速可靠的代码(特别是在训练良好的情况下)加速上市时间,通过从源头识别问题——包括安全漏洞——提高代码质量,并通过提升代码审查的质量和效率来增强团队协作。

您的DevOps工具是否开源是一个重要考虑因素。开源解决方案对于预算有限的组织来说可能具有成本效益,它们提供的透明性也有优势。专有解决方案通常声称能提供可靠的运行时间和专门的客户支持团队来解决您遇到的任何技术问题。但是,企业用户通常需要支付订阅费用,这对小团队来说可能是一个重要的成本因素。开源代码库免费使用,非常适合预算有限的团队。开源特性允许透明性和社区驱动的开发。开发人员可以访问源代码,能够根据特定需求自定义平台。但是,他们通常必须依赖社区进行故障排除和支持。虽然有价值,但开源可能无法提供与商业提供商相同级别的保证援助。此外,虽然开源促进透明性,但这也意味着潜在的漏洞是公开可见的。

像Harness.io和GitLab这样的开放核心解决方案提供了中间选择。它们提供免费的、功能受限的版本,类似于开源。

最后,如果监管要求需要或为了确保业务连续性,OSS可以托管。这提供了保证,即使工具提供商倒闭,您仍然可以访问构建、测试和监控应用程序以及重新创建开发、测试和生产环境所需的工具。

传统的、零散的DevOps工具链通常会创建数据孤岛,阻碍对整个SDLC的可见性。然而,单一的DevOps平台通过提供端到端的可见性提供了令人信服的解决方案。例如,它能够跟踪每一个变更,从代码仓库中的初始提交到生产服务器上的最终部署。这种整体视图帮助您识别瓶颈,在开发周期早期发现潜在问题,并衡量DevOps实践的整体效果。此外,全面的审计跟踪提供所有活动的清晰记录,简化故障排除并确保符合安全法规。

统一平台还简化了治理并释放了智能自动化的潜力。在不同工具间管理治理策略可能既繁琐又容易出错。单一平台允许您在整个开发流水线中一致地定义和执行策略。这确保代码遵循编码标准、安全最佳实践和内部指导原则。例如,您可以通过实施诸如”使用(您组织的)批准的安全扫描器在提交前、CI过程中和CD过程中扫描代码”的策略来简化治理。使用统一平台,这可以很容易地实现为可重用的模板。

此外,通过对部署环境的全面理解,包括基础设施和配置详细信息,该平台可以提供智能代码建议来优化性能和效率。想象一个由AI驱动的助手,它会根据服务的部署方式推荐代码调整,从而节省开发时间并提高代码质量。

当团队组装交付工具链时,通常会从单独的点解决方案开始。然而,这种零散的方法可能导致显著的运营开销。在这一节中,我们将以RBAC为例,看看一个统一的交付流水线如何简化操作并赋能开发团队。大多数协作工具都以某种形式使用基于角色的功能访问。代码仓库将支持内置角色,或者包含内置角色并允许用户定义自定义角色。例如,GitHub定义了Read、Triage、Write、Maintain和Admin等角色。这些角色对应不同的访问级别;Read角色推荐给非代码贡献者,而Admin角色则为需要对项目进行完全访问的用户设计,包括敏感和破坏性操作。

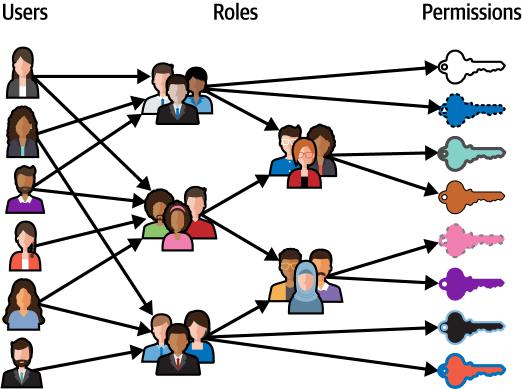

这些系统使用RBAC,这是一种管理系统内资源访问的方法,围绕三个核心要素,即用户、角色和权限:

• 用户代表需要访问权限的个人或账户。

• 角色是定义好的权限集合,授予对系统内特定资源或操作的访问权限。

• 权限是控制的基本单位,定义用户可以执行什么操作(如读取、编辑或删除数据)。

用户不会直接分配权限。相反,他们被分配一个或多个角色。一旦用户被分配一个角色,他们就会继承与该角色相关的所有权限。这种方法通过消除为每个用户单独分配权限的需要来简化访问管理。相反,权限在角色级别定义,用户根据分配给他们的角色获得访问权限。

图2-6展示了分配给角色的用户以及与角色关联的权限集合。

图2-6. 用户被分配给角色;权限与角色关联

使用基于角色的访问是一种常见模式,通过执行最小权限原则来减少管理负担并增强安全性—用户只被授予其工作职能所必需的权限。基于角色的访问还有助于合规性,因为它提供了谁在系统内访问什么的清晰文档。

想象一个由Git仓库、Jenkins、用于管理AWS基础设施的Terraform、用于配置管理的Ansible以及用于捕获性能指标的Datadog组成的DevOps生态系统。在这样一个由几个不同工具构成的系统中,你可能会发现需要在每个系统中定义类似的角色,并重复添加相同的内容。为新开发人员配置可能需要几个耗时的步骤。让我们看看一体化平台如何使用平台方法处理RBAC。例如,Harness平台具有三级层次结构。这三个级别或范围是Account、Organization(Org)和Project:

• Account是最高级实体。它可以行使控制权并对整个平台具有可见性。

• Organization是一个控制单元,来自同一业务单元的人员和项目可以在独立的层次结构中进行组织。一个组织可以有多个项目。

• Projects代表协作的基本单位,用户在其中组合在一起完成相同的任务。

Resource Groups是RBAC组件,定义用户可以访问的对象。对象是任何Harness资源,包括项目、流水线、连接器、密钥、代理、环境、用户等。当你为用户分配Resource Group时,Resource Group中定义的访问权限就会被授予目标用户。Resource Groups可以在任何范围内定义。

角色同样可以在每个范围内定义。角色与Resource Groups一起应用以创建完整的权限和访问集合。例如,你可以将Pipeline Executor角色分配给只允许访问特定流水线的Resource Group,而不是项目中的所有流水线。

在本章中,我们介绍了SCM,这是现代软件开发的基石。SCM解决了团队协作和随时间管理代码库变更的挑战。它使团队能够有效协作并随时间管理代码变更。

SCM对DevOps和CI/CD工作流程至关重要,随着AI原生SCM系统的出现,其作用正在扩大。这些智能系统可以生成、审查、分析和优化代码,改变了团队编写和管理软件的方式。通过自动化日常任务、提高准确性和洞察发现,AI驱动的SCM系统加速了开发并提高了交付效率。我们还讨论了选择合适代码仓库的重要性以及统一DevOps平台对于统一工作流程和更强治理的好处。有了坚实的SCM基础,第3章深入探讨了持续集成如何自动化构建和单元测试以确保代码质量和开发速度。

简而言之,我们现代的软件交付实践提供了一个结构来帮助我们规划、编写、构建、测试和部署软件。在第2章中,我们探讨了SCM系统如何在我们编写代码时帮助跟踪和管理变更。

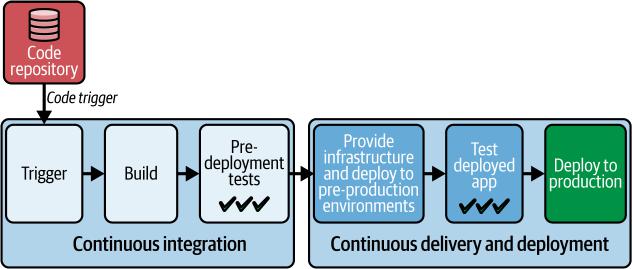

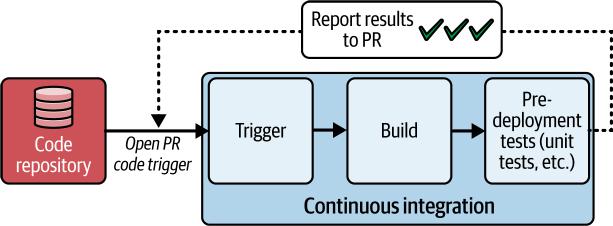

在本章中,我们将把注意力转向持续集成。图3-1展示了一个CI/CD流水线,我们将在稍后详细了解,并在第4章和第8章中再次讨论。

图3-1. CI/CD流水线

我们将探索持续集成流水线,重点关注构建过程和部署前测试(静态扫描、单元测试和集成测试)。我们将演示AI原生方法如何通过GenAI、agentic AI和开放标准(如MCP实现)加速CI。这些技术在构建、缓存和测试阶段实现了自动化流程、预测性优化、标准化上下文管理和智能测试策略。

除了关键的持续集成步骤外,我们还将回顾持续集成工具,并讨论选择工具时需要考虑的因素。您将了解如何提高构建流水线的效率、质量和安全性。

这是一个熟悉的故事。1947年,在哈佛Mark II计算机上工作的一组工程师发现一只飞蛾被困在继电器中,导致机器故障。他们移除了飞蛾并将其贴在日志本上,注明”发现bug的第一个实际案例”,从而巩固了”bug”与软件错误的关联。在机器中发现bug准确地描述了软件开发早期的测试特点。开发人员会独立编写代码并进行集成。测试通常是手动进行的,且相当临时。团队专注于发现bug,当发现错误时从机器中清除”飞蛾”。Bug通常在生产环境中被发现,导致延迟和不可靠的软件。随着软件开发的发展,测试变得更加正规和严格,重点是尝试”破坏”软件以发现缺陷。正式的测试方法和标准开始出现,如IEEE 829软件和系统测试文档标准(1983年)。

瀑布方法论为软件开发引入了结构化方法,其中测试成为一个独立的阶段。在需求收集期间定义的验收标准概述了软件必须满足的条件。然后在开发结束时开发和执行测试用例来验证这些标准。记录缺陷并解决直到软件满足所有要求。然而,这种正式方法通常导致编码和测试之间的相当大的延迟,使得早期问题检测和解决变得困难,最终导致新产品和功能的市场投放时间变慢。

在第1章中,我们讨论了软件开发中敏捷方法论的出现,这是由瀑布开发的低效和局限性所推动的。敏捷方法论更灵活和响应性的开发模型强调频繁的反馈和迭代开发,需要能够跟上快速开发周期步伐的新测试方法。这导致了新测试方法的产生。

极限编程(XP)由Kent Beck、Ward Cunningham和Ron Jeffries开发,是一种由一套最佳实践定义的特定敏捷方法论。一个基本的XP实践是测试驱动开发(TDD)。在TDD中,您在编写相关代码之前先编写测试。Beck的影响力著作《极限编程解析》(Addison-Wesley)于1999年首次出版,向广大读者推广了TDD,而JUnit(用于Java)和NUnit(用于.NET)等早期工具为开发人员提供了在编写相应代码之前轻松编写这些类型测试的框架。

在编写代码之前先编写测试鼓励开发人员深入思考期望的代码行为,从而实现更好的设计和更少的缺陷。虽然这个概念以前就存在,但TDD的特定方法——先编写失败的测试,然后编码使其通过——与敏捷对短周期和频繁交付工作软件的关注很好地对齐。这种实践重新定义了完整性的概念:当代码工作时功能还没有完成,而是当自动化测试完成并通过时才算完成。 TDD期间创建的自动化测试提供了安全网,允许开发人员自信地重构代码,知道任何回归都会被测试快速捕获。这使得更快的迭代和更频繁的发布成为可能,进而允许从客户和利益相关者那里获得更快的反馈。测试本身也作为一种文档形式,清楚地阐述了系统的预期行为。

正如我们在第1章中介绍的,CI是自动化来自多个贡献者的代码更改集成到共享仓库的实践,频繁触发自动化构建和测试以确保软件保持在工作状态。这与TDD相互补充。

CI的起源可以追溯到1990年代。Grady Booch在1991年首次创造了”持续集成”这一术语,但真正将其付诸实践的是Kent Beck和Ron Jeffries,他们在1997年合作一个项目时实现了这一理念。他们的目标是解决由于代码合并不频繁而产生的”集成地狱”问题,在这种情况下冲突和错误会不断累积,变得越来越难以解决。早期的CI系统通常是定制构建的,针对特定项目量身定制。一个值得注意的例子是CruiseControl,由ThoughtWorks在2001年创建。它是首批开源CI服务器之一,允许团队在每次代码提交时自动构建和测试软件。然而,它缺乏用户友好的界面和灵活的作业调度功能,这导致了Kohsuke Kawaguchi在2005年开发Hudson。Hudson因其易用性和强大功能而迅速获得普及。

2011年,与Oracle的争议导致Hudson分叉成Jenkins,此后Jenkins成为不仅在持续集成方面,而且在持续交付和部署方面最广泛使用的工具之一。Jenkins的流行可以

归因于其灵活性、可扩展性和庞大的插件生态系统,使其能够与各种工具集成并适应不同的工作流程。

持续集成已经发展成为现代软件开发中的基础实践,CI/CD系统是任何交付管道的支柱。通过持续集成代码变更,团队已经开始依赖以下优势:

减少集成问题

CI通过确保开发人员频繁合并他们的代码变更来消除可怕的”集成地狱”,最小化冲突并使其更容易解决。

更快的反馈

CI的自动化构建和测试过程为开发人员提供了对其代码变更的快速反馈,使他们能够快速发现和修复错误,从而保持稳定和可部署的代码库。

提高效率和可靠性

通过自动化构建和测试过程,CI消除了人工错误和不一致性,从而产生更可靠和可预测的构建。

改善透明度

CI仪表板和通知提供对构建和测试状态的实时可见性,允许团队中的每个人跟踪进度,识别潜在问题,并更有效地协作。

加速发布

通过简化和自动化构建、测试和集成过程,CI使更快和更频繁的发布成为可能,使企业能够更快速地响应客户反馈和市场变化。

在”CI/CD管道中的持续集成”中,我们将审视CI在交付管道中的功能并探索CI工具的情况。

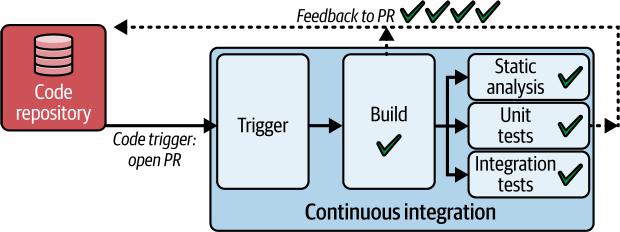

在第2章中,我们介绍了CI/CD管道,重点关注代码仓库和代码集成之间的关系。让我们回到这个管道,专注于持续集成,即构建步骤和执行预部署测试类型的步骤,包括静态分析、单元测试和集成测试。

图3-2中的管道显示了一个典型的CI过程。

图3-2. 由打开Git PR触发的CI管道

这个例子在开发人员打开pull request时触发。该管道的目标是在将变更合并到主分支之前验证PR中提出的变更。让我们逐步了解:

1. 代码触发器

开发人员或AI agent在托管仓库(例如GitHub、GitLab、Bitbucket)上打开pull request,这会触发管道。

2. 检出

管道从PR中指定的分支检出源代码。

3. 构建

代码被编译(如果需要)并构建为可执行文件或可部署的artifact(制品)。

4. 静态分析

诸如linters和代码分析器等工具扫描代码以查找样式违规、潜在错误和安全问题。

5. 单元测试

执行验证单个代码单元功能的自动化测试。

6. 集成测试

可能运行相对快速的测试来验证代码不同组件之间的交互。

7. 反馈

管道向开发人员提供关于PR状态(成功/失败)和发现的任何问题的反馈。这种反馈直接显示在托管仓库的PR中。

该管道检测并通知开发人员代码中的任何问题。构建步骤确定代码变更是否破坏了构建。测试步骤回答以下问题:这段代码是否按预期工作?这段代码是否包含安全漏洞、不安全操作、潜在错误、不良实践、已弃用的特性,甚至不一致的格式?

代码管道通过在打开或更新pull request时检测问题并运行快速测试,为开发人员提供近实时的反馈。它回答关于代码功能、安全性和质量的关键问题。开发人员然后可以快速解决问题,完善PR,或在所有检查通过时自信地合并它,加速开发并确保强大的代码库。

(在第4章中,我们将探索在PR合并时触发的补充CI管道。该管道将新代码部署到测试环境并执行长时间运行的测试套件。)

请注意,虽然我们的示例管道使用代码变更触发器,但CI/CD系统通常提供其他触发选项,如计划触发和手动触发,以获得更大的灵活性。

构建步骤涉及将代码打包成可部署的制品。可部署制品的示例包括容器镜像(用于在Kubernetes/serverless环境中部署)、特定语言包(如JAR、npm、NuGet等)和移动应用程序包(如APK或IPA)等。例如,用编译语言(如C++)编写的代码首先被编译,然后链接以创建机器码。解释型语言通常需要构建步骤将代码打包成中间格式,如Java Archive (JAR)文件,用于运行时编译。其他解释型语言,包括JavaScript,可以被转译或压缩以优化执行。

根据代码类型,此步骤或一系列步骤依赖于构建自动化工具、任务运行器或构建脚本。

构建自动化工具编排整个构建过程。流行的自动化工具示例包括以下几种:

Make和CMake

Make是最古老和最基础的构建工具之一。它使用Makefile来定义文件之间的依赖关系和构建它们所需的命令。

CMake是一个更新的跨平台构建系统生成器,可以生成Makefile、Visual Studio项目和其他构建脚本。它被广泛用于C和C++项目。

Ant

一个早期基于Java的构建工具,使用XML描述构建过程。它以灵活性和跨平台兼容性而闻名。

Maven

另一个流行的Java构建工具,不仅仅是编译。它管理依赖、构建、测试和打包项目。

Gradle

一个较新的构建工具,结合了Ant和Maven的优点。它使用基于Groovy的DSL来定义构建,提供更灵活和简洁的语法。

Bazel

由Google开发,Bazel是为大规模项目设计的强大构建系统。它以速度、可扩展性和对多种语言的支持而闻名。

MSBuild

一个通常与.NET框架和语言(如C#、Visual Basic .NET和F#)一起使用的构建自动化平台。

Cargo

Cargo是Rust编程语言的包管理器,用于构建、编译和管理Rust项目。

任务运行器自动化开发工作流程中的重复性任务,如压缩、连接和转译。JavaScript广泛使用的任务运行器包括以下几种:

npm scripts

Node Package Manager (npm)的一部分,npm scripts是在package.json文件中定义的简单脚本,可以自动化常见任务,如启动开发服务器、运行测试和为生产环境构建。

Gulp

一个使用JavaScript代码定义任务的流式构建系统。它以处理文件的速度和效率而闻名。

Grunt

JavaScript项目的另一个任务运行器,Grunt使用配置文件定义任务。它以其庞大的插件生态系统而闻名。

Webpack

主要用于JavaScript应用程序的模块打包器。它可以将JavaScript、CSS和其他资源打包成优化的生产文件。

Rollup

另一个模块打包器,以专注于生成比Webpack更小、更高效的包而闻名。

最后,构建脚本是自定义脚本(通常用Bash、Python或其他脚本语言编写),定义构建项目所需的具体步骤和命令。这些可以与构建自动化工具或任务运行器结合使用。

在构建代码之后,我们立即运行静态分析工具,其中可能包括linter。Linter是一种特定类型的静态分析工具,用于检查编码风格(例如,确保一致的格式和命名模式);对于JavaScript等解释型语言,linter检查拼写错误、缺少分号或不正确的语言使用。这些工具在不执行源代码的情况下检查源代码,类似于在发布文档之前校对文档。它们有助于在开发过程的早期识别潜在问题。静态代码分析包含一系列技术来评估代码的:

潜在bug

识别常见的编程错误,如空指针解引用、资源泄漏或逻辑缺陷

安全漏洞

检测可能导致SQL注入、跨站脚本(XSS)或其他漏洞的不安全编码实践

代码异味

标记可维护性问题,如重复代码、过度复杂性或未使用的变量,建议需要重构的区域

遵循标准

强制执行编码指南,有时还包括特定语言或项目的最佳实践,确保一致性和可读性

通过将这些静态分析工具集成到开发过程的早期阶段,我们不仅确保了代码质量,还实现了一个被称为左移安全的最佳实践。左移安全是指在开发的最早阶段实施安全实践的策略。我们将在第5章深入探讨左移安全,并探索AI如何帮助快速修复安全问题。

自动化测试是CI/CD pipeline的基础。在我们的示例pipeline运行静态分析检查后,它对新代码执行单元测试和集成测试。让我们看看这些测试类型:

单元测试

这些测试验证最小的独立代码片段(单元),如函数或方法,以验证它们在隔离状态下按预期运行。想象一个简单的天气应用程序,它从外部API获取天气数据,处理数据,并向用户显示。单元测试可能测试处理原始数据的函数

天气数据,验证它们正确地将数据转换为所需的

格式。这些测试仅验证转换逻辑。

集成测试

这些测试专注于验证软件模块之间的交互,确保

正确的通信和数据交换。集成测试相对较快,通常在单元测试之后进行,并且与单元测试一样,有助于及早识别问题。同一天气应用的集成测试可能专注于数据获取和处理模块如何交互。这些测试可以验证应用程序是否正确从API检索和处理天气数据,包括错误场景,使用部分模拟来模拟真实世界的API响应。与隔离组件的单元测试不同,集成测试评估多个组件如何协同工作。在管道中早期使用的集成测试,如我们示例管道中的测试,应避免访问数据库、文件系统或其他外部系统等缓慢操作。

单元和集成测试框架数量众多,因语言而异,例如:

Java

JUnit 5和TestNG是单元测试框架。Mockito和Spring用于Java集成测试。

JavaScript

Jest和Mocha for JavaScript广泛用于单元测试。Jest还支持集成测试。

Python

pyTest和pyUnit (UnitTest)是单元和集成测试的选择。

.NET

NUnit和xUnit for .NET是单元测试的选择,而Moq和NSubstitute通常用于集成测试。

Ruby

RSpec支持Ruby的单元和集成测试。

移动端 (iOS/Android)

XCTest for iOS和Espresso for Android是移动端单元和集成测试的标准。

单元和集成测试作为第一道防线,提醒开发人员他们代码中的潜在错误或回归。这些快速的自动化检查只是我们测试策略的开始。在第4章中,我们将研究在PR关闭和合并时触发的后续管道。

对每个代码单元的彻底测试,包括所有可能的场景,会产生大量但至关重要的测试套件——即使对于看似简单的代码也是如此。然而,由于单元测试是隔离的且不依赖外部资源,它们执行迅速。我们的管道将这些快速的单元测试作为基础,然后是验证不同组件如何协同工作的集成测试,最后是模拟真实世界使用的少量综合端到端测试。

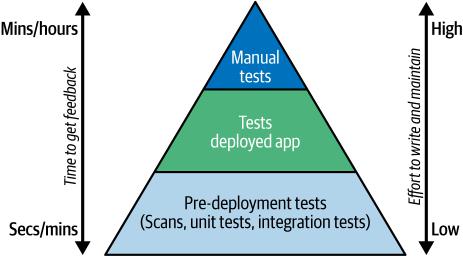

在”测试金字塔”中,我们将研究测试金字塔框架,它说明了如何平衡不同的测试类型以获得最佳的软件质量。

测试金字塔为我们提供了一个战略性构建测试的模型,根据测试的范围和速度确定不同类型的优先级。虽然测试金字塔有时被描述为每层都有特定的测试类型,但我们更愿意将层次概念化为包含广泛测试类别的层次,如图3-3所示。

在我们金字塔的底部是部署前测试,包括单元测试、集成测试和静态扫描等类型。这些测试规模小且执行快速。

集成测试可以指一系列测试策略。不与数据库和网络服务等外部系统交互的集成测试是快速的,包含在这个级别中。宽阔的金字塔底部反映了这些类型的测试套件应该很大,理想情况下覆盖完整的代码库。测试应该设计为向开发人员提供快速反馈。

向上移动金字塔,我们将中间层描述为包括我们在预生产测试环境中对已部署代码执行的任何类型的测试。通常,这些测试比上述测试慢,但提供了关于系统整体功能的宝贵见解。

在金字塔的顶峰,我们发现了手动测试。这些测试缓慢且劳动密集,在代码经过多层自动化测试审核后进行。采用金字塔方法允许团队在测试工作中平衡速度、成本和有效性。通过专注于小型和快速测试的坚实基础,并通过对已部署代码的战略测试进行补充,我们可以实现全面的测试覆盖,同时最小化所需的时间和资源。强大的测试策略是简化管道的关键,加速高质量版本的交付。在”持续集成工具”中,我们将考虑CI工具选择如何优先考虑该因素。

有效的CI流程对现代开发团队至关重要。在本节中,我们将研究传统CI工具以及表征现代工具的功能。一家大型全国零售商——我们的客户——预期数字需求激增,发现自己处于十字路口。其传统CI/CD工具,包括Jenkins,在客户web、移动和后端服务团队中分散,导致长时间构建,每年因开发人员闲置时间成本高达500,000美元。这些工具不仅抑制了创新,还构成了重大安全风险,每年花费800,000美元在维护和自定义脚本上进一步加剧了问题。这笔巨额投资将资源从增强客户体验中转移出来。面对日益严峻的挑战和不断攀升的成本,这家零售商寻求统一的CI/CD平台来简化操作、加速创新并加强安全性。

该公司不断累积的挑战揭示了Jenkins的固有局限性,特别是当组织规模扩大和数字化需求加剧时。让我们来看看这些局限性。

持续集成工具 | 41

Jenkins再思考

Jenkins值得称赞的是将持续集成带入了主流。作为一个开源自动化服务器,Jenkins利用庞大的插件生态系统扩展其功能特性,让用户能够无限定制其流水线。Jenkins插件市场是一个中央仓库,用户可以在这里找到并安装数千个社区开发的插件。Jenkins社区庞大,文档详尽。它是适应多样化开发环境的解决方案。

虽然Jenkins由于其专业插件(例如大型机)对传统系统仍有价值,但现代CI流水线要求更多。当今的开发环境需要能够提供速度、安全性、协作工作流程,以及与多个提供商的云技术、Kubernetes编排和容器化应用程序原生集成的CI工具。以下部分探讨了使Jenkins不太适合这些现代需求的具体挑战。

插件复杂性

Jenkins的灵活性和广泛的插件生态系统往往导致复杂且碎片化的架构,阻碍了可维护性并增加了开发者负担。依赖Groovy脚本进行流水线定制可能使故障排除和更新变得繁重,特别是随着流水线数量及其复杂性的增长。

此外,现代CI/CD解决方案通常采用”流水线即代码”范式,使用YAML等声明式语言来定义流水线。这种方法通常被认为比Jenkins重脚本方法更直接、更易维护。基于YAML的流水线通常比Groovy脚本更易于阅读和维护(可能有例外),而Groovy脚本随着流水线规模和复杂性的增长可能变得复杂且难以调试。将流水线定义为代码允许它们与应用程序代码一起存储在版本控制系统中。这确保流水线更改被跟踪、审查和审计,实现团队成员之间更好的协作。因此,流水线即代码方法允许更好的版本控制、协作和更容易的故障排除。最后,需要管理众多插件,每个都有自己的配置,这引入了维护开销。团队成员发现自己花费宝贵时间在解决插件冲突、更新依赖项和破译神秘错误消息等平凡任务上。这偏离了对创新和核心开发的关注,减缓了创新和功能交付。

42 | 第3章:持续集成的构建和预部署测试步骤

可扩展性挑战

Jenkins的架构主要为单服务器设置而设计,当作业、流水线和用户数量增加时,往往难以高效扩展。这可能导致性能瓶颈、更慢的构建时间和整体系统不稳定。虽然Jenkins提供分布式构建和集群选项,但设置和维护这些解决方案可能复杂且资源密集,需要专业知识和显著开销。因此,水平扩展Jenkins以满足大型组织或高吞吐量CI/CD工作流的需求往往成为重大挑战。

安全顾虑

虽然Jenkins插件提供可扩展性,但它们也引入了潜在漏洞。每个插件都有自己的代码库和依赖项,扩大了Jenkins实例的攻击面。监控这些插件的漏洞并确保及时更新成为管理员的持续开销。此外,配置Jenkins安全性,包括用户权限、访问控制和网络配置,可能很复杂。错误配置可能使系统暴露于未经授权的访问或恶意活动。插件生态系统的动态特性和错误配置的潜在性意味着您必须vigilant地监控风险并主动缓解Jenkins环境中的风险。

资源使用和效率顾虑

Jenkins的资源消耗可能是一个重大缺点,特别是随着作业和插件数量的增加。基于Java的架构(JVM的运行时要求、垃圾收集行为和框架抽象)往往导致高内存使用,管理众多并发构建可能对CPU和磁盘资源造成压力。这可能导致更慢的构建时间、增加的基础设施成本和潜在的性能问题。在大型环境中,水平扩展Jenkins可能变得复杂且资源密集,需要额外硬件和仔细配置。

此外,在CI流水线中构建Docker镜像可能很快变得资源密集且昂贵,特别是在处理大型代码库或频繁提交触发众多并行构建时。每个镜像都需要计算资源、存储空间和网络带宽——成本在各环境和分支中倍增。同样,虽然全面的可观测性提供了有价值的系统洞察,但实施过度日志记录可能创造自己的问题:存储成本激增,信噪比下降,处理开销增加。在全面覆盖和资源效率之间找到正确平衡仍然是关键挑战。

持续集成工具 | 43

超越Jenkins

由于 Jenkins 的局限性,像我们的全国零售商这样的公司往往会超越它的能力范围,并寻求提供以下功能的现代化、完全托管的解决方案:内置、完全支持的构建块

现代 CI/CD 工具提供广泛的内置、完全支持的构建块库,简化了流水线设置。这消除了对社区维护插件的依赖,确保了可靠性和稳定性。然而,认识到定制化的需求,大多数解决方案仍然支持通过自定义插件进行扩展。这使团队能够自动化独特的工作流程,并根据特定需求定制 CI/CD 环境。

声明式定义流水线

现代 CI/CD 工具使用 YAML 等声明式代码简化流水线定义,使其比 Jenkins 的 Groovy 脚本更易于访问和维护。这加速了设置过程,并最大限度地减少了与手动脚本相关的错误。

对容器化和编排的原生支持

Jenkins 早于 Docker 和 Kubernetes 的广泛采用,虽然 Jenkins 流水线可以使用插件来处理和编排容器,但缺乏原生支持往往导致配置繁琐。相比之下,更新的工具无缝集成了容器化和编排功能,简化了容器化环境中应用程序的部署和管理。

在接下来的章节中,我们将探讨比 Jenkins 更新的工具提供的其他现代功能。在我们将注意力转向这些功能之前,让我们考虑在选择 CI/CD 工具时的一个基本问题:是自己托管和管理工具,还是选择完全托管的解决方案。这个决定将影响从开发速度和成本效益到维护需求的一切。考虑到移动端的重要性,选择一个能够处理移动应用程序构建和部署复杂性的 CI/CD 设置至关重要,我们将研究移动应用开发特有的考虑因素。

组织在其 CI/CD 系统方面有三个主要的构建基础设施选择:本地自托管、云端自托管和供应商托管(云端)。每个选项都有独特的优势和缺点,应该仔细考虑:

本地自托管解决方案

在本地自托管 CI/CD 系统给予您对其基础设施和数据的完全控制和所有权。这种方法允许最大程度的定制,能够根据特定的安全协议和组织需求进行定制。此外,一些组织可能更喜欢与本地解决方案相关的一次性付费模式。然而,这种方法有几个缺点。它需要在硬件和软件方面进行大量的前期投资,以及维护和更新所需的时间和精力。持续维护的需求和潜在的可扩展性挑战可能会给资源带来压力,特别是对较小的组织。

云端自托管解决方案

自管理的云托管模式在控制和可扩展性之间取得了平衡。组织在利用云的灵活性和可扩展性的同时保持对其 CI/CD 软件的控制。与本地解决方案相比,这种方法减少了对物理硬件的需求,并简化了扩展。

云托管应用程序在称为 hypervisor(管理程序)的虚拟化环境中运行,在考虑云托管时,您选择的 hypervisor 类型将影响简单性和性能。需要了解的两种 hypervisor 类型是:

Type 1 裸机 hypervisor

这些直接在硬件上运行,提供卓越的性能和隔离,但需要专用硬件。

Type 2 嵌入式 hypervisor

这些在操作系统之上运行,提供更容易的设置和灵活性,但性能可能较低。

裸机可能更适合要求严格的高安全性设置,而嵌入式可能适用于不太密集的需求和预算约束。

任何云托管工具集都需要持续的维护和更新,您的组织仍将负责管理云基础设施。这可能导致与本地解决方案类似的挑战,尽管前期成本可能有所降低。

完全托管的供应商托管解决方案

供应商托管的 CI/CD 解决方案提供完全托管的服务,供应商处理基础设施、维护和更新。您的组织专注于开发而不是基础设施管理。这些解决方案高度可扩展,易于使用,通常遵循按需付费模式,使其具有成本效益。然而,它们可能提供比自托管选项更少的定制化,并可能限制您组织根据特定需求定制系统的能力。此外,这种方法可能会出现对数据安全的担忧和潜在的供应商锁定。

拥有强大且高效的 CI/CD 解决方案对于跟上快速发布周期和移动用户期望的高质量应用至关重要。移动开发带来了独特的挑战:您的流程和 CI/CD 工具必须能够管理设备碎片化和频繁的移动操作系统更新。在选择自托管和完全托管的 CI/CD 解决方案之间进行选择时,请考虑自托管解决方案虽然提供控制和定制化,但可能导致物理硬件约束等挑战。此外,您的团队将负责对构建环境进行持续维护和更新。这些复杂性可能导致意外成本。像 Xcode 这样用于 iOS 开发的工具的频繁发布周期需要定期的硬件更新,这对任何团队来说都可能是重要的时间和资源消耗。

另一方面,完全托管的 CI/CD 解决方案通过提供构建环境的自动更新和可预测的成本来缓解这些痛点。这使您的团队能够专注于构建功能和改进应用程序,而不是管理基础设施。此外,专门为移动开发优化的完全托管 CI/CD 解决方案提供了移动端特定的集成和功能,可以简化开发流程。这些平台中的许多都为您完全管理移动开发的挑战,如设备分片和操作系统更新。

回到我们的零售商例子:它研究了更新的选项,决定摒弃 Jenkins 以及与之配套的插件和工具集合。该公司选择了一个统一平台,简化了工具集,同时提供了所需的可扩展性和成本节约。它能够将服务、客户端 web 和移动团队的 CI/CD 流程整合到这个单一平台上。新平台消除了大量脚本编写的需求,节省了开发人员的时间,使他们能够专注于创新。它还利用 AI/ML 进行测试,进一步节约了成本并实现了更快的构建。此外,统一平台通过在流水线早期支持安全测试来提高安全性,实现了更快的漏洞检测和修复。新平台的效率、安全性和可靠性使零售商能够轻松应对其数字化增长。在接下来的章节中,我们将探讨现代系统中能够实现更快、更具成本效益和更安全流水线的功能。

现代构建环境是临时的,通过提供隔离的、具有成本效益的和可扩展的设置来增强敏捷性,这些设置加速开发周期,同时在 CI/CD 流水线的各个阶段保持一致性。然而,临时环境需要每次从头开始设置整个构建过程,包括

第3章:持续集成的构建和预部署测试步骤 | 46

下载依赖、编译代码和生成构件。这是很耗时的。

缓存是 CI/CD 中使用的一种技术,用于存储和重用构建构件、依赖项、Docker 层和中间结果。这通过避免冗余操作并专注于仅构建已更改的内容来显著减少构建时间,这不仅加快了开发周期,还节约了计算资源和能源。现代 CI/CD 系统智能地管理这个缓存过程,在无需手动干预的情况下优化构建。缓存可以在不同阶段进行——缓存软件依赖、缓存 Docker 层,以及缓存来自 Bazel、Gradle 和 Maven 等工具的构建输出。

原生 AI 的 CI 解决方案将无缝集成 GenAI、智能体 AI 和 MCP 来增强软件构建、缓存所需组件和测试每个构建。让我们更详细地了解这些增强功能。

构建阶段增强。 GenAI 可以自动化重复任务的样板代码创建(例如,Dockerfile 模板、CI 配置文件),减少手动工作。它还可以分析历史构建数据来预测依赖冲突并建议最优版本,最大限度地减少构建失败。GenAI 的另一个有趣用例是根据项目结构生成优化的 CI 流水线 YAML 配置,减少试错设置。

智能体 AI 可以检测构建失败(例如,缺失依赖),然后自动使用修正的配置重试并记录根本原因。它还可以根据工作负载需求动态扩展构建资源(例如,云实例),平衡速度和成本,并可以动态将单体构建拆分为可并行化的任务,减少执行时间。

MCP 可以在分布式团队中标准化环境变量、构建标志和工具链版本,确保一致性并通过 MCP 的集中式缓存在相关项目之间共享预构建构件,避免冗余构建。

缓存阶段增强。 GenAI 可以用来使缓存技术更加智能。它可以根据代码更改预测需要哪些依赖(例如,node_modules、.m2 构件),在构建开始前预缓存它们。ML 模型可以用来通过分析代码差异模式识别过时缓存,确保只保留相关构件。智能体 AI 可以实时标记和清除有毒缓存(例如,损坏的构件),防止构建失败。在可扩展基础设施中使用 MCP 具有许多优势,包括通过标准化 API 在 CI 流水线之间实现安全、低延迟的缓存共享,以及

持续集成工具 | 47

通过在 CI 运行之间缓存中间构建输出(例如,Docker 层)来减少冗余数据传输。MCP 可以通过标准化 API 在并行 CI 作业之间实现安全的缓存共享,消除单体仓库架构中的冗余构建。

测试阶段增强。 考虑这样一个场景:开发人员在大型应用程序中一个很少使用的组件中修改了一行代码。我们通过大型且健壮的单元测试集实现了高代码覆盖率;这些是我们测试策略的基础,是测试金字塔的基座。然而,当代码更改很少时,执行整个测试套件会导致冗长、资源密集且非常低效的测试周期。

现代工具可以通过智能选择并仅执行与修改代码直接相关的测试的 AI 工具来缓解这些问题。这种方法显著减少了测试所需的时间和资源,从而实现更快的反馈循环和更高效的开发过程。

让我们看看 TI 是如何在底层工作的。三个组件共同工作来启用 Harness TI:

该服务使用 AI 并理解您的仓库、Git 提交和单元测试,并使用这些数据动态构建一个图表,映射代码方法与其对应单元测试之间的关系。该图表会持续更新以反映代码库的变化。

该组件与服务通信并执行测试。

这是您添加到 CI 管道中的步骤,用于将 TI 集成到您的工作流程中。

TI 工作流程从开发者发起拉取请求并触发管道时开始。TI 服务分析代码变更并将其与图表进行比较,以识别需要执行的测试。它不仅考虑代码修改,还考虑对测试本身的任何更改或添加。这确保代码库的所有相关方面都得到彻底测试,同时避免冗余的测试运行。

因此,通过专注于受影响的测试,智能测试方法可以显著减少测试时间,特别是在具有大量测试套件的大型项目中。这转化为更快的构建和更快的开发者反馈,使他们能够更快地识别和解决问题。

现代 CI/CD 工具还利用 GenAI 来自动化繁琐的任务,并在出现问题时提供洞察。例如,工具可以自动生成您的管道,分析代码中的潜在问题,并实时排除构建和部署故障。如果 CI 构建失败,GenAI 可以分析日志文件,定位错误,甚至建议潜在的修复方案。这节省了您的时间,减少了停机时间,并加速了软件交付过程。

代理 AI 也可以用来根据您组织的黄金标准提出优化现有管道的建议。这个功能将非常有价值,因为组织通常更多地优化其当前管道而不是创建新管道。

GenAI 的另一个优秀用例是编写基于意图的测试。测试,特别是 UI 测试,如果 UI 发生变化,可能会非常手动化且不稳定。通过使用 GenAI,开发者和 QA 工程师可以简单地陈述测试的意图,让 GenAI 找出步骤。我们将在第 4 章详细讨论基于意图的测试。

最后,AI 还可以用于道德且负责任地为测试生成数据。一些例子包括在使用生产数据进行模型训练时确保符合 GDPR 和其他法规,在整个数据生成过程中保持数据隐私和安全,以及使用适当的算法生成合成数据。

现代 CI/CD 解决方案应该是团队合作伙伴,与您企业生态系统中的其他关键平台协作,特别是您组织依赖的可观察性平台,用于理解系统行为,识别性能瓶颈,并在问题影响用户或业务运营之前主动检测和解决问题。可观察性平台包括带有 Logstash 和 Kibana 的 Elastic(一个流行的开源平台),以及 Datadog 和 Splunk 等知名商业选项。

现代持续集成工具通过实施 OpenTelemetry(一个开源框架)向这些平台提供遥测数据。这引入了 CI/CD 指标,以启用可观察性和仪表板,帮助您了解正在发生的事情并改进构建性能和可靠性。

在管理跨多个仓库的复杂代码库时,版本控制和依赖管理变得非常具有挑战性。Monorepos 是包含项目或组织所有代码的单一仓库,提供了管理复杂代码库的集中化方法。单一仓库通过保留任何共享库或组件的单一副本来简化依赖管理,并简化了不同项目间的代码共享和重用。

虽然 monorepos 增加了合并冲突的风险并需要仔细设计以避免紧密耦合的代码,但许多大公司已经成功地为大规模代码库采用了它们,证明了有效管理的 monorepo 可以提供非常可扩展的方法。

在采用 monorepo 策略时,重要的是要理解 monorepos 对代码仓库和 CI 工具的独特要求。随着可能有数百名开发者为大型 monorepo 做贡献,高效地管理变更和拉取请求变得至关重要。团队必须能够按子目录定义适当的访问权限,部分原因是确保只有相关的审查者收到每次变更的通知。仓库应该支持特定于子目录的所有权。

Monorepos 需要能够选择性构建和测试变更组件的 CI 系统,并支持高级依赖管理、缓存和并行执行。像 Harness CI 这样的工具通过基于路径的触发器等功能支持这些需求,该功能仅在仓库中特定目录发生更改时运行管道(例如,为 serviceA/ 的更改触发服务 A 的管道),以及稀疏检出,它克隆子目录而不是整个仓库。这优化了资源使用并加速了反馈循环,同时保持了依赖完整性。

CI已经成为一项不可或缺的实践,减少了集成问题,提供更快的反馈,并提高了整体效率。在本章中,我们研究了现代全托管CI/CD工具的功能,对比了自托管的成本和挑战中的权衡。我们研究了优先考虑更快、更小的单元测试以获得快速反馈的重要性,然后是较慢的测试类型以获得全面覆盖。我们研究的持续集成pipeline体现了这一实践:在打开PR的上下文中,我们构建、完成静态扫描,然后运行快速测试以确保我们的代码按预期工作且不会引入回归。我们还探讨了AI原生CI工具可以使用GenAI、代理AI(agentic AI)和MCP来增强CI的构建、缓存和测试阶段的各种方式。

在第4章中,我们将继续讨论CI/CD,重点关注部署到测试环境并执行评估系统性能、弹性和端到端行为的较慢测试。

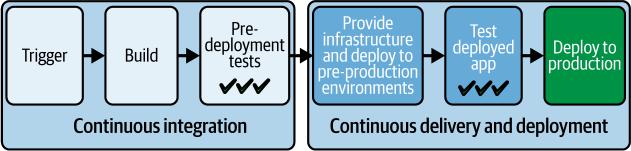

在第3章中,我们探讨了持续集成的基础知识,重点关注CI/CD pipeline中的早期步骤:主要是构建和部署前测试。我们演练了一个当PR打开时触发的示例pipeline,如图4-1所示。

图4-1. CI pipeline

这个pipeline构建并打包代码,进行静态代码分析,并执行早期、快速的测试,包括单元测试和轻量级集成测试,为PR提供构建和测试反馈。这些步骤确保pull request中的代码已准备好合并,提供信心保证合并的代码将按预期运行且不会引入任何回归。假设PR中的代码更改证明已准备就绪,开发人员可以合并PR。

随着我们的新代码合并,下一步是通过部署到测试环境然后运行一系列测试来为生产做好准备。AI和ML工具正在被集成到部署过程中。这些工具帮助团队做出更好的部署决策,主动识别潜在问题,并简化验证过程。实施良好的AI实际上减少了开发人员的认知负荷,同时提高了部署可靠性,而不是增加复杂性。在CI步骤和生产发布之间,我们主要专注于测试。我们想了解发布是否为我们的用户准备好了。如果发布安全,我们希望快速将其交付给用户,以增强用户体验并可能推动更高的客户参与度和忠诚度。如果我们的软件有问题,我们需要快速检测和解决它。这种动态是发布有价值更新的障碍,缺陷引入和将其带回开发团队之间的时间越长,相关开发人员就越不可能记住这些工作。他们将不得不花费更多时间和精力熟悉这些代码部分,使修复变得更加昂贵。如果开发人员已经深入他们的下一个任务,该任务可能会被中断,完成起来也会变得更加昂贵。当发布准备好时,我们将把发布部署到一个或多个环境中,在那里我们可以对运行的代码进行测试。正是在这些预生产环境中,我们弥合了开发和现实使用之间的差距,确保我们的软件不仅功能正确,而且为现实场景做好准备。

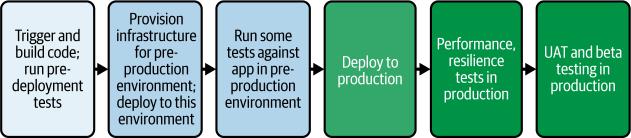

图4-2给出了我们整个交付过程的高层描述。越来越多地,AI被嵌入到整个pipeline中以加强测试和部署决策。

图4-2. 高层交付过程

在本章中,我们将研究配置基础设施、部署到一个或多个预生产环境以及对软件进行测试的步骤。此外,我们将涵盖关键最佳实践,包括:

• 使用IaC创建与生产一致但规模较小的下级环境 • 使用”类生产”部署来一致地移动你的应用程序 • 将测试连接到部署pipeline • 选择在部署中何处应用AI以及何处保持谨慎

这个pipeline阶段是关键的,开发和运维关注点在此交汇。通过理解和实施这些最佳实践,你将能够很好地确定特定项目需求的最佳测试环境数量和类型,无论项目规模或复杂性如何。你将了解如何平衡开发速度和运营稳定性,确保你的软件经过彻底测试并为发布做好准备。

当我们继续沿着交付pipeline导航前往生产时,我们需要考虑必要的部署步骤和部署环境。对于可预测和可靠的交付过程,我们需要可预测和可靠的部署步骤和环境。

在本节中,我们将介绍最佳实践,以获得我们所追求的可预测性和可靠性,从测试到生产。在第8章中,我们将更详细地介绍生产发布和生产环境。

自动化是DevOps的基础,我们交付pipeline的一个关键功能是自动化我们预生产环境的设置和对这些环境的部署。正如我们需要在将软件发布到野外之前验证我们的软件一样,我们需要有措施来验证我们如何部署我们的软件。

我们通过在部署到预生产环境时始终使用与部署到生产环境相同的方法来实现这一点。这种一致性测试了我们的部署方法,并最大限度地降低了在重复这些步骤将软件部署到生产环境时出现意外问题的风险。

以下最佳实践有助于提供我们所追求的可预测性。

开发人员使用简单工具创建自己的轻量级部署流程来部署到测试环境,而运维团队专注于使用企业工具面向生产部署的流程,这种情况并不少见。流程之间的不一致性导致变更在”出错时”进行沟通,开发人员会更新他们的流程,但忘记通知运维,直到出现问题。

应该避免这种方法,因为它限制了在非生产环境中测试的有效性,并导致自动化脚本工作的重复。相反,应该为所有部署采用统一的工具集。

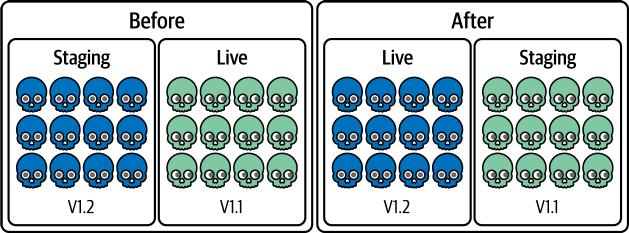

鼓励一致性的一种方法是为开发人员提供简单、预制的模板管道,称为”黄金管道”或”铺好的道路”。我们将在第10章中更详细地研究这一点。至少,您的开发人员和运维团队需要就执行部署的通用工具集达成一致。

无论您使用的是CI/CD工具还是自定义部署脚本,操作序列都应该在各个环境中保持一致。金丝雀部署或蓝绿部署等高级部署策略通常是基于降低生产部署风险而选择的。如果您的生产环境使用这些策略,请在预生产环境中复制它们。同样,如果您要在生产环境中使用功能开关(feature flags)来发布单个功能,请使用功能开关在测试环境中推出功能。这种一致性最大限度地减少了在部署过程中引入差异或疏忽的机会。

我们将在第7章和第8章中更全面地介绍生产部署和这些渐进式部署策略。现在,请注意您使用的步骤和策略应该在每个级别上复制。虽然测试环境可能由于成本或资源限制而较小,但部署时应将其视为生产环境。例如,生产环境中的滚动部署可能一次向10个目标部署两个节点,而在测试环境中,您可以一次向3个目标部署一个节点。这种方法确保您的生产部署步骤和策略在部署到测试环境的每个版本中都得到彻底测试。

在第7章中,我们将深入研究AI技术如何验证部署不会在新环境中造成问题。同样的方法应该在较低的环境中使用,以验证它们是否正常工作,并保护我们的测试不会针对有故障的安装运行。

不可避免地,环境之间会存在差异。目标名称、服务URL和密码可能不同。与其为每个环境创建唯一的部署脚本,不如利用变量来适应这些差异。这允许您维护一个可适应的脚本或管道,可以在运行时针对特定环境进行定制。

通过在部署中保持一致性,您将创建一个强大可靠的交付管道,让团队对无缝高效地发布软件的能力充满信心。

在第3章中,我们讨论了自动管道创建。模板化仍然是一个好的模式——您希望AI利用组织的模板并为您的项目和团队引入正确的调整和变量。无论是您还是AI在创建或维护管道,管道代码需要管理的越少越好。

我们希望有一致和可预测的环境来将发布交付到生产环境。IaC为我们提供了一种不仅实现一致性,还能像控制代码资源一样小心控制配置的方法。在其核心,IaC将基础设施配置视为软件代码。工程师在本地对IaC代码进行更改,并在开发环境中测试它们。然后,这些更改像应用程序代码一样提交到版本控制系统(VCS)。通过管理我们的IaC,我们利用了VCS和CI/CD管道的这些功能。

代码化的特性使IaC成为DevOps领域中快速受益于大型语言模型的一个领域。AI编码助手能够很好地生成和解释IaC代码,为开发人员和基础设施专业人员采用新的IaC语言降低了门槛。对于能够访问环境性能数据或将云成本功能与IaC管理相结合的DevOps平台的主要云提供商,未来的代码生成工具可能会基于实时工作负载包含以下运行时优化:

协作和代码审查

版本控制使多个团队成员能够同时处理文件并管理冲突。我们可以定义和执行策略,要求对我们的基础设施配置更改进行代码审查。

分支和实验

版本控制允许您创建分支来试验不同的配置,而不影响主要的生产环境。

可追溯性和可审计性

VCS提供了对配置设置更改的完整历史记录。提交消息和更改历史帮助您了解系统演进的原因,审计跟踪对于支持符合安全框架的合规性非常重要。

回滚和恢复

如果基础设施配置更改引起问题,您可以快速恢复到之前的工作版本,最大限度地减少停机时间和对系统的影响。此外,在发生灾难性故障的情况下,您可以使用版本控制的配置将系统恢复到已知的工作状态。

自动化测试

交付流水线可以对IaC代码运行自动化测试,包括语法检查、安全扫描和合规性测试。然后将更改应用到预发布环境进行集成测试,最后通过仔细的发布策略推广到生产环境。

安全性

版本控制可以帮助强制执行围绕配置更改的安全策略和控制,确保只有授权人员可以进行修改。考虑一个技术行业中许多人都太熟悉的场景:应用程序在开发中运行完美,在预发布中运行顺利,但部署到生产环境时却陷入混乱。这种差异往往源于跨环境基础设施配置的不一致性。通过IaC配置定义,您可以确保从开发到生产的每个环境都以相同方式配置。

这种系统化的过程确保您的基础设施以受控、可预测的方式发展。它通过消除环境之间的意外差异来解决”在QA中工作”的问题。通过以与应用程序代码相同的尊重和严谨度对待您的基础设施,您获得了一致性、可靠性和敏捷性。

IaC提供了超越控制和一致性的多种优势。通过单个命令,您可以启动与现有基础设施完全相同的新环境。这不仅使您的流程可重复,还作为准确的活文档。由于环境易于创建和销毁,您可以在不使用时拆除它们,节约资源并降低成本,同时确信它们可以毫不费力地重新创建。

要有效实施IaC,您需要正确的工具,有几个流行的选择可用。Terraform及其更开放的分支OpenTofu使用云无关的方法。如果您完全投入特定的云提供商,像AWS CloudFormation或Azure Resource Manager这样的原生工具可能更合适。

GitOps是一种更新且日益流行的软件部署方法,建立在代码存储库的能力基础上。使用GitOps方法,您可以在版本控制的配置中描述基础设施的期望状态。这种描述是声明式的。GitOps工具包括一个代理,定期协调实际环境和Git控制配置中描述的期望状态。您不是运行脚本直接部署软件,而是通过更新代码存储库中的配置来启动软件部署。这种方法和GitOps工具通常在Kubernetes环境中使用,在机器集群中编排容器化应用程序。

使用这种方法,您依赖代码存储库来强制执行安全性、提供治理并实施组织政策,例如通过代码审查和批准要求监督。您的更新是可追踪和可审计的。您可以协作、实验并回滚用于部署软件的配置更新。一旦您进行更新并合并它,GitOps协调代理就会完成其余工作,获取更新并将更改实施到目标环境。

这种方法获得了关注,因为管理描述复杂编排云系统的复杂配置是一个非常适合代码存储库能力的应用程序。此外,GitOps解决了环境漂移的问题;即环境从期望状态中操作性改变。协调代理自动检测和修复,防范环境中的不一致性。

虽然GitOps方法很强大,但在CI/CD交付流水线中使用GitOps方法部署比简单地用脚本推送应用更新更复杂。使用GitOps,您的流水线必须自动化以下步骤:

然后GitOps协调就从那里接手。

您可能还会遇到地理复制到多个集群的应用程序的复杂性。由于许多GitOps协调器针对部署应用程序到单个集群进行了优化,因此跨集群维护一致性和同步可能很困难。您可能需要平衡单一真实来源的需求与某些配置需要针对特定集群定制的现实。商业GitOps工具通常在这些更复杂的场景中提供编排和可见性,扩展了开源提供的功能。尽管有这些挑战,在协作、可追溯性和自动化协调方面的好处使GitOps成为广泛利用Kubernetes的组织的一个令人信服的选择。

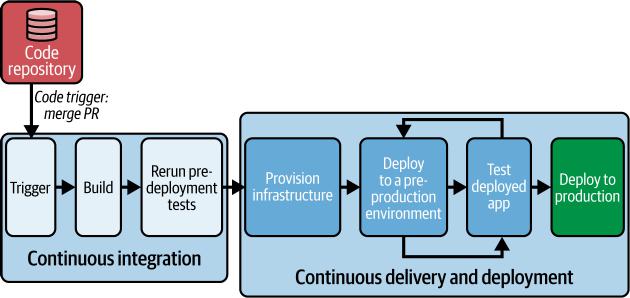

现在我们了解了可预测和可靠的部署步骤和环境的重要性,让我们回到交付流水线。随着新代码的合并,我们现在希望将其部署到一个或多个环境中,在那里我们可以针对运行的代码进行测试。图4-3显示了一个示例流水线。

图 4-3. 在预生产环境中测试我们的代码

在本节中,我们将重点关注管道:

1. 代码触发

拉取请求被审查、批准并合并到主分支。在此管道中,PR 合并触发管道。

2. 持续集成

管道重复我们在上一章中审查的持续集成步骤,检出、构建和执行持续集成测试。

3. 配置基础设施

管道配置测试所需的预生产环境。

4. 部署到一个或多个预生产环境

管道将应用程序部署到一个或多个预生产环境。

5. 针对已部署的应用程序进行测试

管道针对已部署的软件进行测试。可以运行各种类型的测试,具体取决于软件类型和您的组织优先级。我们将在下一节中查看多种不同类型的测试。管道可以配置为并行或顺序运行多种类型的测试。某些测试可以重复使用相同的预生产环境,而其他测试可能需要根据测试要求定制的预生产环境。通常,较快的测试优先于较慢的测试。

6. 部署到生产环境

最后一步是部署或推广到生产环境。根据您的交付流程,部署到生产环境的决策可以是自动化的或需要手动批准。我们将在第7章中查看推广策略和部署到生产环境的步骤。

术语持续交付和持续部署经常互换使用。持续交付通常被宽泛定义为一个将软件发布自动化到生产部署点的流程,在变更上线前需要手动批准。另一方面,持续部署完全自动化整个流程,包括部署到生产环境。

混淆源于管道自动化部署到中间测试环境。一些人使用”持续交付”来涵盖这些自动化的中间部署,而其他人将其保留给不自动部署到任何环境的流程。类似地,“持续部署”有时被广泛用于描述任何自动化部署,包括到测试环境。

为了避免混淆,我们更愿意广义地使用”持续交付”来指代频繁向用户交付软件的流程。减少手动步骤的数量往往会使这个流程更加频繁。当我们讨论特定交付流程中的部署步骤时,我们会包含关于部署环境(中间或生产)和类型(自动化或手动)的详细信息。

测试环境对于运行测试至关重要,但测试的选择很大程度上取决于正在开发的应用程序类型、目标用户、软件架构以及预算和时间限制。例如,一般来说,网站的测试优先级与嵌入式软件或 web API 的测试优先级会有很大不同。高度监管行业中的软件服务与必须对大型零售用户群直观且引人入胜的软件之间的测试优先级会有所不同。您对测试的选择和频率会显著影响应用程序质量、基础设施成本和整体交付速度。

AI 驱动的测试平台越来越多地使用 ML 来优化测试策略。这些平台分析历史测试数据、代码更改、应用程序架构和过去的部署问题,以智能地选择和优先处理测试。例如,AI 驱动的测试选择工具识别针对每个代码更改要执行的最具影响力的测试,显著加快测试周期。Harness、Tricentis SeaLights 和 CloudBees Launchable 等供应商正在使用 AI 和 ML 技术来优化测试选择。

以下是在此阶段发生的常见测试类型:

端到端或功能测试

这些测试是最直接的测试类型,模拟真实世界的用户场景并验证从开始到结束的整个应用程序流程,以确定软件是否按预期工作。这些测试可以是自动化的或手动执行的。现代团队自动化更多。Selenium 是许多商业工具也基于的常用开源测试自动化框架。ML 在这些工具中存在已久,但我们越来越看到向 AI 优先方法的转变,我们很快会深入探讨。

AI 驱动的测试

AI 可以自动生成测试用例,识别边缘情况,并从以前的测试运行中学习,专注于最可能出现问题的区域。AI 测试很可能会补充或成为您的端到端(功能)测试程序的一部分。

API 测试

功能测试的一种形式是 API 测试,它验证 API 是否按预期工作。在分布式系统中,服务通过 API 交互,因此确保 API 性能良好很重要。常见的 API 测试框架包括 SoapUI、Postman、Insomnia 和 Swagger。AI 增强的 API 测试超越了简单验证,能够智能地探索 API 行为和边缘情况。这些系统可以通过分析 API 文档或实际使用模式自动生成 API 测试场景。

用户体验测试

开发人员、测试人员和产品经理可能会评估新功能,以确保它们易于使用且直观。虽然这可能测试与端到端测试相同的系统,但重点是评估可用性。

用户验收测试

这些测试通常作为最终检查来完成,以确保软件满足最终用户的需求,符合要求,并按预期运行。用户验收测试可以包括许多其他类型的测试,从端到端测试到用户体验和性能测试。这些测试从最终用户的角度进行,目的是为软件发布提供最终和正式的验收。

可访问性测试

这些测试确保我们的软件对有视觉、听觉或认知障碍的残疾人可用,以服务我们的用户并符合法律、合同和监管要求。开源可访问性扫描器包括Lighthouse和Pa11Y。包括accessiBe在内的公司也开始提供AI增强的测试和修复工具。

本地化测试

本地化测试对于面向全球受众的软件很重要。它涉及对产品在特定目标地区的语言准确性、文化适宜性和功能正确性的综合评估。这包括验证翻译、根据文化敏感性调整视觉元素,并确保软件在本地格式和法规下正确运行。

性能测试

这些测试模拟工作负载,评估应用程序在不同条件下的速度、响应性和稳定性。这些测试帮助识别性能瓶颈并确保应用程序能够处理预期的流量。这种类型的测试对于有季节性峰值的应用程序至关重要,以确保发布版本能够承受峰值需求。Apache JMeter、Gatling和Grafana k6经常用于性能测试。AI可以利用性能测试的数据来推荐要运行的弹性测试。这些AI驱动的性能测试系统现在可以比传统的基于阈值的方法更准确地检测性能异常。这些系统建立基线性能模式并识别可能表明即将出现问题的细微偏差。更高级的平台甚至可以通过将测试结果与代码更改和架构图相关联来准确定位导致性能下降的具体组件或代码更改。

弹性测试

在现代分布式系统中,生产系统有许多组件。唯一确定的是某个地方总会出现故障。弹性测试,也称为混沌测试,评估当软件所依赖的服务失败时,软件是否能够保持有用。我们将在第6章中回到弹性测试。

安全测试

这些测试识别应用程序中可能被攻击者利用的漏洞和弱点。它们有助于确保应用程序的安全性和完整性。动态应用程序安全测试(DAST)是一种特定类型的安全测试,它自动化渗透测试,检查您正在运行的应用程序的安全缺陷。DAST尝试像恶意用户那样攻击您的应用程序。ZAP是一个常用的免费工具,而Veracode和Checkmarx的商业产品也很受欢迎。我们将在第5章中回到安全测试。

虽然上述概述的测试类型被普遍使用,但重要的是要注意,软件测试没有一种通用的方法,术语在不同组织中可能有所不同。您选择的具体测试以及如何分类它们将取决于您独特的开发流程、应用程序架构和风险承受能力。

传统的自动化功能和端到端测试方法通常严重依赖脚本化测试或简单的录制和回放方法。虽然最初很方便,但这些测试很快就会变得脆弱且难以维护,每当发生轻微的UI更改时就会中断。这种脆弱性造成了高维护负担,减慢了开发速度,并经常导致团队完全放弃自动化测试或限制其范围。

一种新兴的AI优先测试方法,称为基于意图的测试,旨在克服这些挑战。团队不是明确编写脚本或手动记录每个测试步骤,而是表达测试场景的意图,描述他们期望的结果而不是实现它的确切操作序列。然后AI原生测试工具通过与您的应用程序交互来动态生成和执行这些测试,就像人类用户一样。

例如,您可以简单地描述目标:“使用信用卡购买产品”,而不是为电子商务结账流程记录精确的点击和表单输入。AI会自动确定通过您的应用程序的最合适路径,智能地与按钮、表单和工作流程交互。

一个重要的好处是提高了测试的弹性——解决了基于UI的测试脆弱的挑战。如果UI后来发生变化,AI会适应新的布局或修改的交互,显著减少维护开销。测试自动化工具多年来一直试图自动修复测试,使用从跟踪DOM对象到实施ML的技术。转向理解测试背后的意图,并尝试在响应UI改版时重新生成整个脚本,带来了新的恢复水平。

这些工具也可以帮助补偿从专业测试人员向要求开发人员承担这些测试的转变。这些工具可以推荐与现有测试相关的额外测试和断言,这可能有助于乐观的开发人员记住检查边界情况和不良用户行为。AI的高级用例包括将在Selenium和Playwright等传统工具中编写的测试迁移到基于意图的测试工具中,以及生成和运行不仅仅是单个测试,还有整个测试用例。

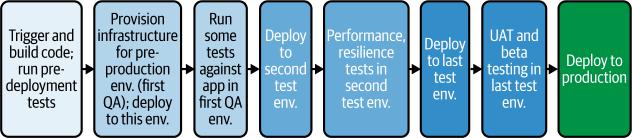

在传统软件开发中,测试通常被分隔在专用的环境中,每种类型都有独立的环境。例如,这确保了手动用户体验测试永远不会受到并发自动化性能测试的影响。然而,这种隔离是有代价的:测试环境的激增是昂贵的,并且管理起来可能很耗时。当单个新版本必须通过众多阶段时,面对加速的发布节奏和不断增长的应用程序复杂性,这种方法变得越来越不可持续。

当你试图加速发布节奏并且应用程序变得更加复杂时,跨多个阶段进行测试变得越来越不可持续,每个阶段都需要一个新的环境。图4-4说明了这种阶段化方法。

图4-4. 通过多个预生产环境的传统测试

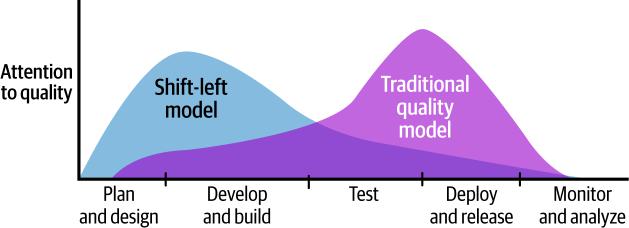

另一方面,更现代的测试方法挑战了这种模式。这种方法有时被称为”中间层空心化”。不是跨多个环境进行多次顺序测试,而是在更少的环境中并发运行测试。这种实践倡导将测试既向左移动又向右移动。

我们在第3章中介绍了左移安全。通过将SAST、SCA、依赖扫描和秘密检测移入预部署步骤,我们的示例流水线体现了左移。我们将这些关键测试早期纳入,使得通过它们成为合并代码的先决条件。作为合并工作流程一部分完成的单元测试和其他早期测试也代表了左移方法。这有助于更早发现问题,减少对广泛下游测试的需求。

右移方法倡导在实时生产环境中对新版本执行某些类型的测试,这些测试传统上是后期测试类型。我们不是配置一个或多个预生产环境并将版本从这些隔离环境中移动和使用这些隔离环境进行测试,而是将应用程序直接部署到生产环境并在那里进行验证。例如,负载测试可能很难很好地执行,环境可能需要很大。部署到生产环境的一部分,对目标基础设施施加负载,并使用生产可观测性工具测量影响,这可能是传统负载测试的可行替代方案。图4-5说明了这种方法。

图4-5. 测试的”中间层空心化”方法

我们可以看到,消除对密切镜像生产环境的预生产环境的需求可以节省成本和维护负担,但是在生产环境中进行广泛测试如何能够安全呢?右移依赖于新工具和生产部署实践。通过先进的流量管理、可观测性工具和容器化,许多组织发现这些测试实际上可以在生产环境中执行,副作用最小。除了显著削减基础设施费用外,这种方法还具有产生更准确结果的优势。我们将在第7章中讨论这些新工具和生产部署实践。

中间层空心化优化了测试,是组织为促进更快交付而采取的一种现代策略。通过重新设计我们在环境之间移动软件的方法,我们同样可以加速我们的交付过程。在”环境之间的推广”中,我们将研究我们应该如何以及为什么在环境之间推广我们的版本。

在前一节中,我们研究了一个典型的交付过程,该过程需要让我们的软件通过多个测试阶段,每个测试阶段都在单独的预生产环境中进行。在这个过程中,我们希望尽可能快速和智能地推广我们的版本,这意味着我们软件的新版本应该毫不拖延地进入下一个环境和阶段。AI开始在这个推广过程中发挥越来越重要的作用,分析测试结果、性能数据和部署历史,以就何时以及如何推广版本做出智能决策。这些系统可以同时评估多个指标,检测可能指示风险的微妙模式,并通过机器学习随着时间的推移变得越来越准确。

理想情况下,我们的推广过程很简单:如果一个阶段的测试通过,我们的版本立即推广到下一个环境,该环境已准备好并可用于下一轮测试。推广决策是自动且即时的,仅基于前一阶段测试是否通过。在实践中,版本推广,即使在测试环境之间,也会成为许多交付过程的瓶颈。这可以归因于几个因素:

推广决策由委员会决定

推广决策不是自动化的,需要小组审查和批准测试结果。

推广依赖于繁琐的手动步骤

触发下一次部署的手动干预会创造瓶颈。

测试环境数量不足

如果下一个环境正被用于测试另一个版本,新版本必须等待。

在本节中,我们将探讨缓解这些问题的方法。我们将介绍的实践帮助我们将发布从一个预生产环境推进到下一个环境,同样也适用于将应用推广到生产环境。然而,最终发布到生产环境有一些特殊考虑,这将在第7章中更深入地讨论。

人工决策制定,无论是委员会讨论还是可信个人的决定,在将发布从一个阶段推进到下一个阶段时都不可避免地会引入延迟。团队成员需要被通知,然后花时间分析测试结果,最后做出决定并采取行动。虽然这可能并不总是劳动密集型的,但无疑会拖慢进度。

虽然传统自动化依赖于简单的通过/失败标准,AI系统提供了更复杂的决策能力。现代AI推广引擎可以同时评估数百个指标,超越简单的测试结果,全面分析系统行为。这些系统可能考虑诸如性能趋势、错误类型、用户影响评估,甚至基于过去部署模式的代码变更风险级别等因素。通过适当权衡这些因素,AI可以做出比传统基于规则的方法更细致的决策。

我们的目标是通过自动化推广发布的决策来简化这个过程。我们将在第7章中详细重新讨论这个话题。

一旦您自动化了决策制定过程,实际推广构建就变得相当容易。关键是确保部署到下一个环境在做出继续决定后立即触发,消除不必要的等待时间。

您如何实现这种自动化取决于您选择的持续交付工具。一些工具提供端到端管道,具有简单的内置触发器,可在各阶段之间无缝推广。其他工具允许您在当前管道中调用另一个管道或作业作为步骤,提供了灵活性但可能需要更多配置。虽然实现的易用性各不相同,但实现这种自动化级别几乎总是可能的。

然而,GitOps风格的部署在这个领域经常呈现出独特的挑战,正如我们在”利用GitOps的Git工作流”中讨论的那样。为了执行部署,我们需要自动化对GitOps配置的Git更改,而不是依赖手动更新。为此,我们通常会在CI/CD管道中直接自动化pull request步骤及其批准。我们维护Git作为GitOps所知的真实来源,同时自动化发布推广的每个步骤。

例如,想象一个场景,您的管道已经确定构建准备好推广到用户验收测试(UAT)环境。当我们的管道被设置为生成必要的pull request、触发任何需要的批准,并且(一旦批准)将更改合并到主分支时,我们的管道无缝地启动到UAT环境的GitOps部署。

在交付过程中自动化各阶段和环境间推广的最后一个挑战是确定您需要的”合适”环境数量。拥有过多环境由于维护其底层基础设施的成本而成为财务负担,而拥有过少环境则在将发布推向交付时创建瓶颈和延迟,因为过程等待资源变得可用。

临时环境(Ephemeral environments)为这个困境提供了常见解决方案。这种方法涉及在需要测试时按需创建环境,并在测试完成后立即拆除它们。在云计算之前的时代,环境创建是一个繁重的过程,通常需要数天时间。现在,由于可编程的云基础设施,环境可以在几分钟内启动和拆除。

基础设施即代码管理(IaCM)工具简化了临时环境。这些专业的CI/CD平台使用代码自动化基础设施资源的配置、配置和部署。与专注于应用程序的传统CI/CD工具不同,IaCM工具管理底层基础设施。使用IaCM工具,您可以使用声明性代码模板定义所需的基础设施状态,使配置更易管理、可维护和版本控制。

理想情况下,为了实现我们”类生产”测试环境的目标,应该使用相同的模板来创建预生产测试环境和生产环境,只对变量进行调整。当您的管道与IaCM工具无缝集成时,部署到”测试”阶段会自动触发相应”测试”环境的创建。一旦这个环境被配置并配置了必要的详细信息,如IP地址、密码和其他特定于环境的变量,部署和测试过程就可以继续进行。完成后,IaCM工具有效地拆除环境,释放资源。

虽然这种策略在一致性、灵活性和成本降低方面提供了显著好处,但重要的是要注意环境创建和拆除过程可能会给整个测试周期增加几分钟时间。因此,对于针对极快交付节奏的管道(如以分钟为单位衡量的管道),临时环境可能不是理想的解决方案。然而,对于以小时、天或周为单位衡量的交付周期,临时环境提供了一种强大的方式来打破瓶颈、提高一致性并优化基础设施成本。

总结

在本章中,我们继续导航交付流程,专注于持续集成之后的持续交付步骤。这些主要是测试步骤,我们回顾了对验证软件所有方面都很重要的测试类型。我们讨论了可靠和可预测的预生产环境对测试的重要性,以及为我们提供这些环境的最佳实践。通过自动化在测试阶段之间推进发布的所有方面,包括推进决策制定,我们可以显著加速软件的交付。

完成测试后,只剩下一步就能将我们的最新软件发布交到用户手中:实际部署到生产环境。我们将在

总结 | 67

保护应用程序

和软件供应链

在本书中,当我们从SCM导航到持续集成和交付的交付流程时,我们已经涉及了安全工具和实践。我们讨论了现代工具中的RBAC和Policy-as-Code (PaC)治理如何帮助保护您的代码仓库和管道,我们还提到了早期安全测试在持续集成中的作用。我们研究了动态测试以发现应用程序中的运行时漏洞。这只是对安全性的轻描淡写。在本章中,我们将把安全性提到前台,在一个网络攻击在频率和复杂性方面都在增长的世界中,给予它应得的关注。备受瞩目的安全漏洞经常成为头条新闻,全球法规正在收紧,客户越来越多地基于安全态势来评估供应商。由于发布周期以天而不是月为单位衡量,传统的将安全作为生产前最后关卡的模式已经变得不可持续。相反,我们已经将负担”左移”到开发者身上,他们现在必须将安全实践集成到他们的日常工作流程中。不是安全专家的开发者现在承担着前所未有的安全责任负担。

人工智能为这种紧张关系带来了一些缓解。AI驱动的安全工具正在提高检测准确性,显著减少浪费开发者时间的误报,甚至自动生成修复代码。AI不是简单地将安全负担左移,而是帮助分担这一负担,为开发者提供专家级的安全指导,而不要求他们成为安全专家。

69

本章将涵盖向AI原生软件交付的演进如何改变了我们处理安全性的方式——不是简单地添加更多工具或流程,而是从根本上改变我们识别、优先级排序和修复安全问题的方式。我们将了解软件供应链安全的重要性,它保护着参与软件构建和交付的工具、流程和人员,从初始代码到最终产品。这是一个关键关注点,因为现代软件严重依赖互连组件,每个组件都可能成为恶意攻击者可以利用的潜在漏洞。理解供应链关注点并学会用安全视角评估您的SDLC将使您能够建立强大的安全措施,更好地保护您的应用程序、数据和组织的声誉。

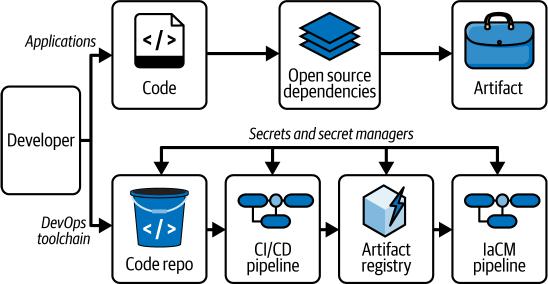

构建和部署现代软件应用程序严重依赖分布式和复杂的软件供应链。这些供应链通常包含一个由代码仓库、开源依赖、第三方组件、构件仓库和CI/CD管道组成的庞大网络。虽然这种互连性促进了创新并加速了我们的开发周期,但它也在整个过程中引入了安全风险。不断扩大的攻击面以及漏洞在整个供应链中传播的潜力使我们的软件供应链成为恶意攻击者的主要目标。

在本节中,我们将研究这些威胁,并了解管理软件供应链的合规性框架如何演进以应对这些威胁。最后,我们将了解新的合规要求如何影响您的组织。

软件供应链包括创建和交付软件所涉及的所有人员、流程和工具。它涵盖软件开发的完整生命周期,从初始代码创建到部署和维护。这是一个复杂的生态系统,其中每个元素在最终产品中都发挥着至关重要的作用。软件供应链由两个主要关注点组成:应用程序和DevOps工具链,如图5-1所示。

70 | 第5章:保护应用程序和软件供应链

图5-1. 软件供应链

这里的”应用程序”是指软件的所有组成部分,包括专有源代码;开源依赖项如库、框架和模块;以及在开发过程中产生的软件工件。根据Synopsys发布的2024年开源安全与风险分析报告,96%的代码库包含开源组件。重要的是要记住,我们的组织有责任保护所使用的开源组件,就像保护内部开发的代码一样。由于开源使用如此广泛,我们不应该对应用程序中发现的80%以上的漏洞来自OSS依赖项感到惊讶。2021年在广泛使用的Java日志库Log4j中发现的漏洞就是开源引入威胁的一个例子。该漏洞允许攻击者仅通过向应用程序日志发送精心制作的字符串就能远程执行受影响系统上的代码。由于Log4j在应用程序和服务中的广泛使用,这个漏洞极其危险,导致大规模的紧急修补和漏洞缓解行动。

在广泛使用的XZ Utils数据压缩工具中发现后门提供了另一个例子。XZ Utils和许多OSS项目一样,由志愿者维护,他们在解决安全问题方面的资源有限。有一个受信任的贡献者被发现实施了后门,这本可以让攻击者获得运行该工具构建软件的系统的管理员权限。该实用程序存在于大多数Linux发行版中,幸运的是在该工具被广泛部署到生产系统之前被发现了。

现代应用程序和网络威胁态势 | 71

应用程序供应链中另一个新兴威胁是利用AI编码助手的幻觉。当AI模型幻觉包名时,推荐不存在的库或错误的包标识符,它们为攻击者创造了机会。恶意行为者可以监控流行的AI编码助手的此类幻觉,然后在公共存储库中注册这些幻觉的包名。当开发人员尝试使用这些不存在但AI推荐的包时,他们无意中安装了恶意代码。这种”幻觉抢注”攻击向量已经在野外被观察到,研究人员发现常见的编码助手经常建议不存在的包。

软件供应链中的DevOps风险

DevOps工具链包括用于自动化软件构建、测试和部署的工具和流程套件。这包括代码存储库、CI/CD工具和管道、工件注册表以及简化开发过程的其他工具,如GitOps和IaCM工具。

SolarWinds黑客攻击是一个鲜明的例子,说明了被入侵的DevOps工具链如何被利用来传播恶意代码。在这次复杂的攻击中,威胁行为者渗透了SolarWinds Orion软件构建系统,将恶意代码注入合法的软件更新中。这些被污染的更新随后分发给了18000个SolarWinds客户,让攻击者广泛访问他们的网络。这一事件突出了攻击者利用DevOps管道中固有的信任和自动化来大规模分发恶意软件的潜力,将常规软件更新转变为毁灭性的网络攻击。

2021年的Codecov供应链黑客攻击是工具链安全漏洞的另一个例子,影响了数千个组织。恶意行为者修改了Codecov Bash Uploader脚本(客户用来上传代码覆盖数据的工具)。这种修改允许攻击者从Codecov客户的持续集成环境中窃取敏感信息,如令牌、密钥和凭据。该漏洞未被发现超过两个月,可能暴露了存储在客户持续集成环境中的敏感数据。

不断增长的威胁

软件供应链攻击不会消失。Gartner Research预测,到2025年,全球45%的组织将遭受对其软件供应链的攻击。代码行、第三方库或管道中工具的安全缺陷可能产生连锁反应,危及整个软件产品。保护软件供应链不仅是保护各个组件,还要确保整个开发和交付过程的完整性和安全性。

第5章:保护应用程序和软件供应链 | 72

鉴于威胁的增加,政府和监管机构已经制定了旨在通过建立最佳实践、促进透明度和要求组织采取主动措施来保护其软件供应链来应对这些挑战的法规。一些最重要的合规和监管框架包括:

美国行政令14028,改善国家网络安全

该行政令于2021年发布,要求联邦机构及其软件提供商加强其软件供应链安全实践。它强调使用安全的软件开发实践、漏洞披露和事件响应。

欧盟网络和信息安全2指令(NIS2指令)

该指令旨在在整个欧盟建立高度通用的网络安全水平。它包括关于软件供应链安全的规定,要求组织评估和管理与软件组件和第三方依赖项相关的风险。

NIST SP 800-218,安全软件开发框架(SSDF)

本美国国家标准与技术研究院出版物提供了将安全集成到SDLC中的指导,包括供应链风险管理。它为安全软件开发实践提供了全面的框架。

ISO/IEC 27036-2:2023

该标准提供了管理与供应商和供应链相关的信息安全风险的指导原则。它涵盖了各个方面,包括供应商选择、合同管理和绩效监控。

支付卡行业数据安全标准 (PCI DSS)

虽然不完全专注于软件供应链,但PCI DSS要求处理支付卡数据的组织实施安全的软件开发实践,其中包括管理供应链风险。

网络弹性法案 (CRA)

这项拟议的欧盟法规旨在增强数字产品和服务的网络安全。它包括对漏洞处理、安全更新、软件物料清单(SBOM)以及在意识到后24小时内报告被主动利用的漏洞的要求。

现代应用程序和网络威胁环境 | 73

此外,质量体系法规(QSR)(21 CFR Part 820)和通用数据保护法规(GDPR)是规范软件实践的框架,间接影响软件供应链问题。QSR要求严格的控制和流程以确保医疗设备的安全性和有效性,包括软件组件。这包括要求制造商验证和控制集成到其设备中的软件。同样,GDPR对保护个人数据的严格要求需要组织实施强有力的技术和组织措施,可能延伸到软件及其供应链的安全性,特别是如果它处理个人数据的话。

这些框架和法规有助于构建更安全、更有弹性的软件生态系统,造福企业和消费者。然而,增加的复杂性可能会影响开发团队。理解这些要求并将其集成到您的流程中对于成功合规至关重要。

通过左移保护现代应用程序

面对高度积极的黑客,我们传统的等到最后才进行安全检查的方法是不够的。这些措施不仅不能提供我们需要的保护,而且传统的安全测试还会减慢我们软件的交付速度。为了保护现代应用程序,组织必须使用专为现代DevOps工作流程设计的工具和实践。在本节中,我们将看看组织在实施安全实践方面面临的挑战。在第3章中,我们谈到了左移安全,即在开发的最早阶段实施安全实践。我们将研究如何使用这种方法来减轻风险,以及实施左移安全和以开发者友好的方式管理漏洞的最佳实践。

开发者友好的左移安全的必要性

与其等到软件开发周期结束时才测试应用程序的安全性,您必须在每个可能的阶段积极解决和测试安全问题。这种方法不仅通过避免后续对软件代码的大量返工来节省时间和精力,还提高了最终产品的整体安全性和效率。图5-2对比了左移安全方法与传统应用程序安全方法。

值得注意的是,有效的左移安全不仅仅意味着在交付过程的早期进行安全测试。虽然这可能有助于让开发者避免在几天或几周后返回代码时的上下文切换成本,但最终并没有节省工作量。真正有效的实现需要选择与您的CI/CD管道无缝集成的安全工具。这些工具不仅应该识别漏洞,还应该根据严重性对其进行优先级排序并提供可操作的洞察。您选择的工具应该标准化和去重复发现,以帮助开发者避免警报疲劳并专注于最关键的风险。这种集成方法确保安全性绝对是开发过程的核心。

图5-2. 左移方法与传统测试方法的对比

应用程序安全扫描器

有许多扫描器和工具可用于进行安全测试和分析,现在许多都增强了AI能力。让我们看看这些扫描器和工具的最常见类别:

软件组成分析 (SCA)

这种类型的扫描器通过分析软件物料清单(SBOM)来检测库和框架中的已知漏洞,从而识别第三方组件和依赖项中的漏洞。我们将在本章后面讨论SBOM。SCA工具在漏洞被访问或利用的可能性方面具有显著的机器学习能力。Snyk是SCA扫描器的一个流行例子。

静态应用程序安全测试 (SAST)

SAST工具在不执行应用程序的情况下分析源代码以查找潜在漏洞,通过扫描代码查找表明漏洞的模式,如SQL注入、XSS和缓冲区溢出。AI正在增强SAST以减少误报的发生率,浪费更少的工程师时间。SonarQube、Checkmarx和Fortify是SAST工具的例子。

容器扫描

这种类型的扫描通过分析容器镜像的内容以查找已知漏洞和配置错误来识别容器镜像及其依赖项中的漏洞。

通过左移保护现代应用程序 | 75

密钥检测扫描

这种类型的扫描可以检测敏感信息,如API密钥、密码和令牌,这些信息存在于代码仓库和配置文件中。借助AI,密钥检测工具在检测混淆密钥和区分实际凭证与测试数据方面变得更加出色,从而减少误报和相关的工作量。

这种测试方法分析运行中的应用程序,通过模拟外部攻击来识别漏洞。它像真实用户一样与应用程序交互,检测诸如注入缺陷、身份验证问题和配置错误等问题,而无需访问源代码。AI增强的DAST工具基于应用程序行为生成测试用例,而不是使用固定模式。它们试图自动验证其发现,以解决误报问题。

这种类型的扫描分析IaC文件,在部署前识别安全漏洞、错误配置和合规性问题。

这些类型的扫描器在软件开发流水线的早期阶段就被集成,符合左移方法。密钥扫描是一种推荐的安全实践,它自动识别并提醒用户代码仓库和其他数据源中的敏感信息。

这可以防止敏感信息从一开始就被纳入代码库。SCA工具通常也在流水线的早期集成,在代码提交之后、构建之前。SAST扫描可以是构建阶段的一部分。容器扫描通常在容器镜像构建完成后、部署前进行集成。

通过在整个开发流水线中集成SCA、SAST、容器扫描、密钥扫描、DAST和IaC扫描,您可以有效地实施左移安全并主动保护您的应用程序免受漏洞影响。

您的测试工具识别的每个问题都必须进行分类。审查问题、确定其是否真实然后进行修复都需要成本。误报(报告但实际不存在的问题)是一个重大问题。它们浪费审查者的时间,消耗本可用于其他安全工作和创新的资源。此外,通过”狼来了”的方式,它们降低了工程师对安全发现的信任,并可能延缓对其他真实问题的响应时间。

考虑到这一点,毫不奇怪减少误报数量是许多扫描工具中AI的关键优先事项。涉及的扫描器数量加剧了分类问题,它们可能以不同方式发现相同的问题。在一些组织中,甚至可能在同一代码库上使用多个SAST工具。在这些环境中,可能使用安全测试编排层来去重并将发现规范化为单个可管理的列表。在AI原生环境中,AI/ML在模式匹配以及减少开发者工作量方面发挥着作用。

将在所有这些类型的扫描器中检测到问题并需要修复。安全工具越来越多地通过专门的AI编程助手提供自动化或半自动化修复,以简化开发人员的这一过程。

在本节中,我们将研究当今软件供应链固有的常见安全风险。我们将审视与代码仓库、CI/CD流水线、工件仓库、开源依赖项以及支撑软件开发过程的基础设施相关的风险。AI正在改变组织检测和响应这些风险的方式,通过识别复杂供应链中的模式和异常,这些在规模化手动监控下是不可能的。我们将了解可用于评估工具链安全性的各种框架和基准。到本节结束时,您将更好地理解潜在威胁以及如何缓解它们。

现代软件供应链的复杂性为人工智能创造了理想的用例。AI系统可以持续监控仓库、构建系统和部署中的可疑模式。例如,ML模型可以检测可能表明开发者账户被攻陷的异常提交模式,识别表明潜在供应链攻击的可疑包行为,或发现可能创建安全漏洞的配置偏移。这些AI能力在互连组件之间提供了前所未有的可见性和保护。

Open Worldwide Application Security Project (OWASP),一个专注于改善软件安全的领先组织,已经识别出前10个CI/CD安全风险。如下面的列表所示,威胁的范围是多样的。理解这些风险并实施推荐的缓解策略将帮助您保护和加强您的CI/CD生态系统:

CI/CD流水线中的流量控制机制不足可能被能够访问您流水线的攻击者利用。通过绕过必要的审查和批准,恶意代码或工件可以通过流水线推送,可能到达生产环境并造成严重后果。

跨各种系统管理众多身份的复杂性,加上过度宽松账户的倾向,可能导致妥协。如果任何用户账户被攻陷,攻击者可能获得广泛访问权限,可能到达生产环境。

依赖链滥用是指利用您的依赖关系管理方式中的漏洞

开发和构建系统获取代码依赖项。当这些系统被欺骗获取并执行恶意包而非合法包时,就会发生这种情况。攻击者通过发布与内部包同名的恶意包(依赖混淆)、劫持维护者账户(依赖劫持)或依靠拼写错误(拼写蹲点)来欺骗开发者下载他们的包来利用这一点。

这是一种网络攻击,恶意代码被注入到CI/CD管道中,通常通过被攻陷的源代码控制系统。中毒的代码随后可以在管道内执行,可能授予攻击者与构建作业相同的访问权限和特权。攻击者可以操纵构建配置文件或管道依赖的其他文件,导致凭证窃取、数据外泄或部署恶意工件等行为。

当管道执行节点对资源和系统拥有过多访问权限时就会产生风险。攻击者可以利用这一点在管道内运行恶意代码,滥用授予管道的权限在CI/CD系统内部或外部横向移动。

凭证卫生不足是在凭证广泛用于不同系统和环境中的环境里的重大风险。例子包括意外推送包含凭证的代码、在构建和部署过程中不安全使用、未轮换的凭证,以及凭证被打印到控制台输出或存储在容器镜像中。

由于典型工具链中存在众多系统和供应商,不安全的系统配置是常见漏洞。错误配置,如过时的软件、过于宽松的访问控制或不安全的默认设置,可以轻易被攻击者利用来获得未经授权的访问、操纵CI/CD流程,甚至攻陷生产环境。

CI/CD管道中的第三方服务,虽然对开发来说便利且有价值,但可以轻易被授予对敏感资源的过多访问权限,有效扩大了组织的攻击面。这种缺乏治理和可见性的情况使得维护适当的访问控制变得困难,如果这些第三方服务中的任何一个被攻陷,就会让组织容易受到攻击。

由于软件交付涉及多个阶段和来源,恶意行为者可能在不引起警报的情况下篡改工件。如果未被检测到,这些被攻陷的工件可能流经管道并最终部署到生产环境中,执行恶意代码并攻陷系统。

没有强大的日志记录,您基本上对开发管道内发生的恶意活动视而不见,使得及时检测和响应攻击变得困难。

理解这些风险并实施推荐的缓解策略是构建安全和有韧性的CI/CD生态系统的关键。

OSS依赖项使用无处不在,因此组织必须应对它带来的安全性和合规性风险。我们之前提到了两个例子。第一个是Log4j威胁,影响了数千个系统。第二个是XZ Utils例子,虽然被及早发现,但说明了恶意行为者通过攻陷OSS组件可能造成的破坏。

常见漏洞和暴露(CVE)是组织可以用来识别已知安全问题以采取措施缓解它们的一种机制。CVE监控工具自动化扫描您的软件并提醒您潜在风险的过程。虽然勤奋监控可以帮助您消除所使用的OSS中的已知威胁,但这并不保证您的OSS组件真正安全。无人维护的组件或过时的依赖项也会产生风险,而且由于OSS包会引入数十个依赖项,这些可能非常复杂难以管理。

虽然CVE管理可以帮助对抗已知威胁,但还有其他类别的威胁需要应对。OWASP基金会创建了以下前10名列表,以捕获您的组织需要防范的更全面的OSS风险:

开源组件可能包含公开披露的安全缺陷,通常通过CVE或其他渠道。如果这些漏洞在您的软件中可被利用,可能会损害您系统的机密性、完整性或可用性。

攻击者可能通过劫持账户或利用漏洞将恶意代码注入现有项目或分发基础设施。这可能导致在最终用户或组织系统上执行代码,使机密性、完整性和可用性面临风险。

名称混淆攻击涉及恶意行为者创建名称与合法组件极其相似的组件,旨在欺骗用户安装它们。这些攻击可能导致在用户和组织系统上执行有害代码,损害机密性、完整性和可用性。

由于无人维护的OSS组件不再被积极开发或支持,新漏洞的补丁可能不可用。这种情况可能导致下游开发者需要创建自己的补丁时增加工作量和更长的解决时间。

在您的项目中使用过时的软件组件可能会产生重大风险。

挑战。这可能使紧急更新变得困难,特别是在您使用的版本中发现漏洞时。旧版本在安全问题方面的测试可能也不如新版本彻底。未跟踪的依赖项

未跟踪的依赖项可能在开发人员不知情的情况下引入漏洞。这些依赖项可能由于不完整的SBOM、有限的SCA工具功能或手动安装方法而被遗漏。许可风险

开源组件可能具有与预期用途不兼容、违反法律要求或完全缺乏许可的许可证。使用没有许可证的组件或未能遵守许可条款可能导致法律后果。

不成熟的软件

不成熟的开源项目缺乏标准版本控制、测试或文档等最佳实践,可能给您的软件带来操作风险。这种不成熟可能导致意外行为和增加的开发工作以及漏洞。

未批准的更改

对软件组件的未批准更改可能导致软件构建的完整性和可重现性受损。

第5章:保护应用程序和软件供应链 | 80 过小/过大的依赖项

开源组件在大小和功能上可能存在显著差异,从而导致安全风险。小型组件提供的功能有限,但由于对上游项目的依赖,仍可能引入重大风险。大型组件虽然可能提供更多功能,但由于未使用的功能和依赖项,可能具有更大的攻击面。

在下一节中,我们将介绍一个框架——SLSA——可以帮助解决这些风险。

显然,OSS的风险众多。在我们在自己的软件中利用OSS或任何第三方组件之前,我们必须问:谁编写了这个软件?它是使用我们可以信任的工具和平台构建和发布的吗?它带来了哪些依赖项?它是否符合对我们重要的监管要求?软件制品供应链级别(SLSA,发音为”salsa”)是一个框架,为回答这些问题提供了结构化方法。SLSA旨在加强整个软件供应链中软件制品的完整性。它增强了软件供应链的安全性,可以帮助解决我们研究过的OSS威胁。

类似于物理证据的监管链,SLSA强调在整个生命周期中跟踪和验证软件制品完整性的重要性。在本节中,我们将深入研究SLSA,并提供如何遵守其要求以保护您的软件免受潜在威胁的指导。

SLSA是由开源安全基金会推动的开源项目。凭借其对实际实施和可衡量的安全改进的关注,SLSA已获得显著关注。

SLSA为OSS和供应商提供的软件的提供者和消费者提供好处。在您的组织内,您可以使用SLSA来帮助保护您的软件开发过程免受内部篡改。这确保您部署到生产环境的代码就是您构建、测试和签署的代码。对于软件消费者,SLSA提供了验证OSS真实性和完整性的机制。包注册表能够使用SLSA来保证上传的OSS包是从合法存储库中的源代码构建的。作为OSS消费者,从受信任的注册表采购确保您下载的包是有效的。此外,您可以要求您的供应商遵守SLSA原则。

使用软件制品供应链级别确保完整性 | 81

验证来自信誉良好的第三方审计师的供应商SLSA认证可以提供额外的信心层。

SLSA定义了一个分层框架,允许组织逐步增强其软件供应链安全性。级别代表对篡改的保证和保护程度不断提高。没有任何保护措施的组织被认为处于级别0。

SLSA级别1是基础。级别1要求生成基本的溯源信息。此信息应详细说明构建过程、描述依赖项并给出源代码位置。级别1是开始软件供应链安全之旅的组织的起点。消费者可以使用此信息来决定与软件相关的风险。级别2在级别1的基础上通过引入更强的构建要求来构建。您的构建环境必须是隔离和受控的。此级别还强制要求制品签名以进行完整性验证,防止篡改。

最后,级别3要求源代码溯源和构建可重现性。溯源必须是可审计的,其完整性必须得到保证。

[表5-1]总结了SLSA 1.0定义的三个级别中每个级别的要求。

表5-1. SLSA级别

| 实施者要求 | 程度 | L1 L2 L3 |

|---|---|---|

| 生产者 | 选择合适的构建平台 | ✓ ✓ ✓ |

| 遵循一致的构建过程 | ✓ ✓ ✓ | |

| 分发溯源 | ✓ ✓ ✓ | |

| 构建平台 | 溯源生成存在 | 存在 |

| 溯源生成确保真实性 | 真实 | |

| 溯源生成不可伪造 | 不可伪造 | |

| 隔离强度 | 托管 | |

| 隔离强度 | 隔离 |

以下原则指导了SLSA框架的设计决策:信任少数平台;专注于制品

将信任扩展到少数核心平台,如构建和打包工具,然后自动验证这些平台生产的制品。例如,

您信任的构建平台为其构建的每个工件生成并签名来源证明。下游平台随后验证由公钥签名的来源,自动确定工件是否满足SLSA级别。

82 | 第5章:保护应用程序和软件供应链

将软件追溯到源代码,而非个人

在最终软件工件与其原始源代码之间建立直接且可验证的链接。这种方法与信任具有包注册表写权限的个人形成对比,转而信任代码本身的不可变性和可分析性。通过建立直接链接,组织可以显著降低恶意代码注入或未授权修改的风险。

优先选择证明而非推论

依赖工件来源的直接证据,而非基于对中介构建系统或其他系统的了解来推论工件的可信度。SLSA不是推论完整性,而是要求对工件来源的明确证明。这需要工件构建过程的具体证据。

在SLSA 1.0中,构建平台是确保工件完整性的核心。构建平台用于指代负责编译、打包和准备软件分发的系统。强大的构建平台对于达到更高的SLSA级别至关重要。您选择的系统应该支持隔离构建,即为每次构建创建新的基础设施,构建运行后删除基础设施。此外,系统应该强制执行非特权的、容器化的持续集成步骤,不使用卷挂载。这防止了访问来源密钥信息,符合SLSA规范。

通过强化的构建系统,您可以确保恶意行为者无法篡改您的构建。除了选择能够保证工件完整性的构建平台外,您的系统应该生成并分发证明(数字签名记录),证明您的软件符合所需的SLSA构建级别。SLSA来源证明是密码学签名,为软件工件的来源和构建过程提供可验证的证据。它们充当数字护照,确保工件的完整性和真实性。

考虑使用CI/CD管道构建的容器镜像。此镜像的SLSA来源证明可能包含以下信息:

构建器

用于构建镜像的CI/CD平台(例如,GitHub Actions、GitLab CI/CD)

调用

用于创建镜像的特定构建配置或脚本

材料

构建过程中使用的源代码存储库、依赖项和其他输入

确保软件工件供应链级别的完整性 | 83

主题

工件本身,由其唯一摘要(哈希)标识

签名

由受信任实体生成的密码学签名,验证证明的真实性和完整性

为了验证SLSA来源证明,组织可以使用SLSA验证器服务等工具。该服务验证证明的真实性,根据受信任签名者的公钥检查签名,并确保证明符合SLSA规范。

为了实现最大安全性,SLSA建议由构建平台而非个别开发者生成来源信息。如果您的组织不使用构建平台,请考虑采用支持SLSA的平台。对于第三方平台,检查其兼容性,如需要可请求SLSA支持。如果您维护自己的构建平台,请添加SLSA来源生成功能。同样,包生态系统应该与软件包一起分发SLSA来源信息,将证明嵌入包中或作为单独的元数据文件提供。如果您的组织使用第三方生态系统,请询问SLSA支持并遵循其指导原则。对于直接分发,在包工件中包含SLSA来源信息。

通过利用SLSA来源证明,您的组织可以对软件工件的真实性和完整性获得信心,并降低供应链攻击的风险。

虽然SLSA为构建完整性提供了优秀的框架,但它主要关注工件来源和构建系统完整性。为了解决OWASP十大CI/CD风险中识别的全部供应链风险,组织需要额外的安全措施。

全面的供应链安全策略应该包括:

持续行为监控

现代交付和安全平台,由AI和ML驱动,正在改进以检测跨存储库、构建系统和部署管道的异常活动。这些系统建立正常行为基线,并标记可能表明妥协的偏差。监控和安全工具如Datadog CI和GitGuardian是今天的热门选择。

84 | 第5章:保护应用程序和软件供应链

高级依赖性分析

除了基本漏洞扫描外,智能分析工具可以评估包行为、代码模式和维护者活动趋势,在公开报告之前识别潜在恶意依赖项。AI驱动的系统可以通过分析代码语义和行为来检测微妙的妥协指标,这是传统扫描器无法做到的,有助于防范复杂的供应链攻击,如依赖混淆或域名抢注。

自动化策略执行

在整个管道中实施自动化策略护栏,强制执行超越构建完整性的安全要求。这些系统防止过度许可

权限访问,阻止危险配置,并确保适当的密钥管理——解决 SLSA 未完全覆盖的 RBAC 不足和凭证卫生等风险。如今,在交付平台上广泛实施策略仍然做得不均匀。展望未来,这是一个强有力的方法,将受益于 AI,既能更好地适应不断变化的威胁,又能在 PaC 场景中通过 AI 代码生成辅助快速创建策略。

供应链风险预测

预测分析和 AI 模型分析历史漏洞趋势和新兴威胁情报,以突出供应链中具有更高潜在风险的组件,帮助团队在漏洞成为关键问题之前主动解决。通过分析数千个项目和依赖项的模式,这些系统在导致安全事件之前识别环境中的风险因素,从而能够主动加强脆弱区域。

通过将这些 AI 增强功能与 SLSA 的构建完整性重点相结合,组织可以创建一个深度防御方法,解决供应链风险的全部范围。这种综合策略不仅保护构建过程,还保护整个软件交付管道,从开发到部署。

解决 AI 生成的依赖风险

随着组织越来越多地采用 AI 编码助手,一种新的供应链风险出现了:AI 幻觉蹲守。这发生在攻击者注册 AI 工具通过幻觉错误建议的包名时,为恶意代码注入创建了一个载体。

虽然核心 SLSA 框架为传统供应链攻击提供了重要保护,但使用 AI 编码工具的组织应该实施额外的保护措施:

通过软件制品供应链级别确保完整性 | 85

已验证的注册表策略

配置包管理器仅从官方审查的注册表和具有已知良好包的私有仓库拉取。这防止开发人员无意中安装来自不受信任来源的包,即使 AI 助手建议它们。

包年龄和流行度检查

实施工具,自动验证推荐包的最小下载计数和已建立的历史指标。使用量极少的新包应触发额外审查。

AI 置信度验证

当使用为其推荐提供置信度分数的 AI 编码助手时,实施流程来标记低置信度包建议,以便根据权威来源进行手动验证。

预安装验证

在开发环境中添加自动检查,在允许将依赖项添加到项目文件之前,验证受信任仓库中的包存在性和来源。

这些额外控制与 SLSA 实践和综合 SBOM 结合时,创建了一种深度防御方法,既保护传统供应链攻击,又防范新兴的 AI 辅助威胁。通过解决 AI 引入依赖选择过程的特定风险,组织可以安全地利用 AI 编码助手,同时保持供应链完整性。除了 AI 置信度验证,这些实践中的每一个都有助于防范其他基于包的攻击,如错字蹲守。

通过软件物料清单解决零日漏洞

在第一节中,我们查看了 Log4j 漏洞,该漏洞允许攻击者通过利用日志消息中的特定模式远程执行任意代码,导致广泛的数据泄露、勒索软件攻击和对关键服务的干扰。这是零日漏洞的一个例子,这是最阴险的威胁类型之一,因为它利用软件供应商未知的漏洞,在任何防御措施到位之前给攻击者巨大优势。在本节中,我们将了解 SBOM 如何作为对抗这种类型漏洞的重要工具。SBOM 提供了软件制品中使用的所有组件和依赖项的详细清单。我们将了解 SBOM 的组成和特征,以及它们在 SDLC 中的管理方式。

第 5 章:保护应用程序和软件供应链 | 86

虽然依赖管理工具和包管理器多年来一直存在于跟踪和管理软件组件中,但 SBOM 自 2018 年以来见证了重大进步。协作努力,包括国家电信和信息管理局 (NTIA) 多利益相关方流程,已经为 SBOM 制定了最佳实践和建议。这一协作努力汇集了行业专家、政府机构和学者,为 SBOM 生成、共享和消费定义标准和指南。

因此,SBOM 已成为关键构建模块。事实上,最近的 Linux 基金会研究发现,78% 的组织在 2022 年生产或消费 SBOM,比前一年增长了 66%。

在为软件创建 SBOM 时,您有两个标准可供选择:

CycloneDX

CycloneDX 项目作为 SBOM 的领先标准出现,为表示软件组件、依赖项及其关系提供了机器可读格式。CycloneDX 已获得各种组织的广泛采用和支持。

SPDX

软件包数据交换 (SPDX) 是 SBOM 的另一个流行标准,由 Linux 基金会赞助,并在 ISO/IEC 5962 国际标准中编纂。它为表示软件组件提供了灵活且可扩展的格式。SPDX 已在开源社区中广泛使用多年。

SPDX是一个更加成熟的格式,涵盖范围更广,不仅包含组件信息,还包含关于SBOM本身的元数据,如其创建者和创建日期。它特别适合管理OSS许可证和共享包信息。

CycloneDX是一个更新的格式,提供了更结构化和机器可读的方法,专注于提供关于软件组件及其关系的详细信息。CycloneDX因其灵活性和适应性而经常受到青睐,使其适用于广泛的使用场景。您的具体使用场景可能决定您采用哪种标准;您为软件供应链安全管理选择的工具和流程应该能够支持这两种标准。无论您选择哪种具体格式,用于评估SBOM质量的因素都是相同的。NTIA已经制定了一套SBOM应包含的最小元素,以提供关于软件组件及其依赖项的基本信息。确保这些元素的存在将有助于在各种工具和平台上有效分析SBOM,以及遵循底层的SPDX或CycloneDX规范。

通过提供组件的全面清单,SBOM提供了透明度和可追溯性,可以帮助确保符合您组织的安全政策和法律要求。PaC框架可以利用SBOM来自动化这种合规性。通过PaC,您可以使用代码定义安全策略,这些策略可以像代码一样进行管理和版本控制。然后可以将这些策略应用于SBOM,确保软件组件符合组织的OSS安全标准。自动化合规性减少了人为错误的风险并提高了效率。

例如,您的组织可能定义一个策略,只允许使用具有宽松许可证(例如MIT、Apache License 2.0)的OSS组件,以确保与组织现有软件组合的兼容性并避免潜在的法律问题。

您可能定义一个策略来自动拒绝具有超过特定严重性阈值的已知漏洞的OSS组件。或者您可以建立评估OSS供应商声誉和可信度的标准。这可以包括供应商规模、安全实践和社区参与等因素。将SBOM与PaC结合创建了一个强大的框架来管理OSS使用,确保合规性并降低安全风险。自动化执行安全策略减轻了安全团队的负担并提高了整体效率。

在具有无数依赖项的复杂代码库中,定位和修复受影响的工件可能是一项艰巨的任务。遵循以下最佳实践可以帮助您的组织准备好快速应对零日漏洞和其他威胁:

确保SBOM作为CI/CD流程的一部分自动生成。这确保您始终拥有关于组织支持的每个工件的软件依赖项的最新信息。

使用自动化工具对照漏洞数据库扫描您的SBOM。这些工具可以及时识别依赖项中的已知漏洞,让您能够优先考虑修复工作并应对潜在的安全威胁。

为修补SBOM中识别的漏洞制定明确的流程。这包括设置补丁优先级、与供应商协调以及在部署前测试补丁。通过维护最新且安全的软件供应链,您可以显著降低零日漏洞被利用的风险。

AI显著增强了这些最佳实践。智能SBOM分析系统可以:

AI模型可以分析您的应用程序架构,以确定有漏洞的组件是否处于可利用的位置,区分理论漏洞和构成即时风险的漏洞。这种上下文分析帮助团队首先专注于最关键的问题。

当识别出漏洞时,AI系统可以自动生成带有适当依赖项更新的拉取请求,测试与您代码库的兼容性,并管理跨多个存储库的更新过程。这种自动化大大减少了从漏洞披露到修复的时间。

ML算法可以检测可能未在包清单中明确捕获的未记录或传递性依赖项,提供实际攻击面的更完整视图。

我们在本章中看到了软件供应链的脆弱性。以安全的方式持续交付软件需要的不仅仅是仔细审查您使用的工具和第三方组件。它需要的不仅仅是选择支持SLSA和生成SBOM与证明的CI/CD工具和技术。为了确保一致的安全交付,您的团队必须维护一个安全的平台,进行彻底的漏洞测试,优先考虑并及时修复问题,防止不安全的代码发布,遵守法规,并保证软件及其所有组件的完整性。

这不能是团队中单一角色或组织内单一团队的工作。它需要一种将安全性集成到整个SDLC的协作方法。这正是DevSecOps方法所倡导的。与在几个地方添加安全性的传统方法不同,DevSecOps促进开发、安全和运维团队之间的持续协作,确保从一开始就考虑安全性。

在本节中,我们将解释DevSecOps原则,并展示采用这些原则如何帮助您更快速地识别和修复漏洞,降低数据泄露风险,并改善软件的整体安全性。

成功实施DevSecOps的第一个也是最重要的步骤是建立具有安全优先思维的协作文化。自然地,这可能是最困难的步骤,需要组织领导团队的全力支持。安全必须成为组织优先事项,并成为开发人员、运维人员、安全团队和其他人员共同承担的责任。

打破孤岛并建立共同所有权意识的一个简单方法是创建跨功能的DevSecOps团队。孤立的团队可能限制沟通和知识共享,这可能导致重复工作和不一致的流程。相比之下,跨功能的DevSecOps团队促进协作和开放沟通。例如,在建立新的安全实践或选择新的安全相关工具时,通过包含开发、运维和安全角色的观点,您可以更容易地获得成功所需的认同和一致性。

此外,跨功能团队可以帮助防止产生瓶颈和影响生产力的选择或建议。这方面的一个例子是单方面强制实施一些新的应用安全检查,而不考虑它们对开发过程的影响。这样做的影响将是增加开发人员的工作量,这不仅影响生产力,还会损害组织内的信任和善意。

除了创建跨功能团队,您还应该在整个组织中识别并支持几个关键的安全冠军,以帮助推广安全倡议并在同事中提高认识。利用您的跨功能团队和安全冠军来分享想法并通过建立开放透明的沟通渠道来传达您的进展,以促进信息和想法的交流。这可以包括定期会议、团队聊天和知识分享会议。

AI工具通过提供共享上下文并在安全和开发关注点之间进行转换,充当安全和开发团队之间的协作桥梁。例如,当AI驱动的安全工具识别出漏洞时,它可以用开发人员友好的术语解释问题,同时也提供安全团队需要的安全上下文。这种共同理解减少了团队之间的摩擦,并有助于建立一种每个人都说同一种语言的安全文化。最后,投资于安全培训。识别技能差距并为所有团队成员提供持续的安全培训,为他们提供识别和缓解安全风险的知识和技能。这不仅提高了整个团队的水平,还表明了您的组织对安全作为优先事项的承诺。

安全编码实践对于防止漏洞至关重要。OWASP Top 10和Common Weakness Enumeration (CWE)为识别和解决常见安全漏洞提供了有用的指导。此外,确保您的方法解决以下常见威胁:

输入验证

始终验证用户输入以防止恶意数据被注入到您的应用程序中。这可以帮助防止SQL注入、XSS和其他注入攻击。

输出编码

正确编码输出以防止XSS攻击。这确保用户生成的内容在页面上安全显示,而不允许恶意代码被执行。

错误处理

实施强大的错误处理以防止信息泄露和潜在漏洞。避免显示可能为攻击者提供有价值信息的敏感错误消息。

会话管理

使用安全的会话管理技术来保护用户数据并防止未经授权的访问。这包括使用强会话标识符和实施超时。

身份验证和授权

实施强身份验证机制并强制执行适当的授权控制以限制对敏感资源的访问。

密码学

使用安全的密码算法和实践来保护敏感数据。避免弱加密方法并确保适当的密钥管理。

依赖管理

保持依赖项最新并安全地管理它们以避免漏洞。使用依赖扫描器等工具来识别和解决第三方库中的已知漏洞。

虽然了解最新威胁和安全编码可以防止许多漏洞,但您的组织的最大努力不会是万无一失的。静态和动态分析工具以及早期阶段的安全测试充当后备,捕获在代码审查中可能被忽略的问题。这就是左移发挥作用的地方。我们已经介绍了左移如何使您能够在早期阶段识别和解决漏洞。早期修复降低了漏洞被发布到生产代码中的风险。

在现代软件开发中,安全不能是事后考虑。它必须是整个开发过程中不可或缺的一部分。正如我们在本章中看到的,AI原生的安全方法改变了:

• 漏洞的发现方式,使用智能分析而不仅仅是静态规则

• 发现结果的优先级排序,基于实际风险而不是通用严重性评级

• 修复措施的实施方式,通过自动化指导和代码生成

• 供应链的安全保障,通过持续监控和异常检测

• 团队协作方式,在安全和开发之间建立共享的上下文和理解

通过将安全嵌入到从设计到部署的每个阶段,并通过培养一种由AI增强的共同责任文化,组织可以构建和交付能够抵御现代威胁的强化应用程序。

在第6章中,我们将把注意力转向通过使用混沌测试来发现可能被忽略的弱点,从而提高应用程序的弹性。

第5章:保护应用程序和软件供应链 | 92

混沌工程和服务可靠性

复杂的现代系统在本质上是脆弱的。即使是看似微小的中断,或者单个薄弱环节,也可能导致问题螺旋上升,产生灾难性后果。考虑这样一个场景:一个知名的电商平台在高峰销售活动(类似于黑色星期五)期间遭受了重大中断。随着流量增加,平台的结账服务变得缓慢,最终完全失效。成千上万的客户无法完成购买,不仅造成直接的收入损失,还损害了声誉,侵蚀了信任和品牌忠诚度。事后分析显示,根本原因是结账服务与关键价格数据缓存之间的网络延迟。当缓存在高流量压力下响应变慢时,系统的重试机制变得不堪重负,导致一连串的失败请求,最终使数据库过载。像这样的场景以及不断增加的故障成本,促成了服务可靠性作为一门学科的兴起,以及混沌工程实践(有时称为故障或故障注入测试)的出现。混沌工程的目标是提供对系统在以不寻常(混沌)方式受到压力时行为表现的理解。这些实践日益普及的推动力来自新工具、技术和实践的发展。

混沌工程这个术语可以追溯到2010年的Netflix。该公司正在将其基础设施迁移到云端,这引入了新的复杂性,数百个微服务以不可预测的方式相互作用。为了测试其系统的弹性,Netflix工程师开发了Chaos Monkey,这是一个设计用于在其生产环境中随机终止VM实例的工具。这模拟了现实世界的故障,迫使工程师构建能够优雅处理意外中断的系统。

93

使用”混沌”一词以及让一只猴子在生产环境中随机终止软件的形象确实让人联想到混乱。考虑到这些先入之见,在组织中引入混沌工程可能会遭到阻力。不止一位老板曾想过:“我们这里的混乱还不够吗?”在本章中,我们将通过将现代混沌工程理解为实施实验的严格方法来反驳这些观念。作为一种方法论,我们使用这种受控中断来测试我们系统的弹性。除了测试我们的当前状态外,混沌工程还为我们提供了系统性提高弹性的强大方法论。

我们进行的实验让我们对软件在压力下的行为有了更深入的理解。这种知识使我们能够设计有针对性的改进措施。然后我们进行测试,验证它们在达成目标方面的有效性。

服务可靠性和服务弹性是相关概念。前者是指服务在指定条件下在特定时间内执行其预期功能而不发生故障的概率。后者是指服务承受并从中断(如硬件故障、软件错误、网络中断,甚至网络攻击)中恢复的能力。它关乎服务从逆境中恢复的能力有多强。

虽然不同,但它们是相互关联的。高度可靠的服务不太可能遇到故障,但即使是最可靠的系统也可能遇到意外问题。这就是弹性的作用所在。它确保即使在故障发生时,服务也能快速恢复并最小化对用户的中断。

我们还将介绍如何使用服务级目标(SLOs)来设定我们的弹性目标。我们将了解如何使用错误预算来允许在该目标内的可接受故障水平。我们将看到混沌工程如何与这些机制配合工作,帮助我们验证我们的系统是否能在其错误预算内运行,并在面临意外中断时仍能达到我们的目标。在本章中,我们还将超越静态混沌实验,了解一种更现代和动态的方法,包括将混沌工程集成到我们的CI/CD管道中,使我们能够作为常规开发工作流程的一部分持续评估和改进系统弹性。

在本章中,我们将探讨高级混沌工程工具如何利用AI/ML驱动的洞察来推荐和指导这些实验的执行,从而在降低风险的同时实现更高效和更有效的弹性测试。我们还将看到智能体AI、生成式AI和MCP如何通过自动化实验设计、启用动态风险检测和提供智能修复来解决混沌工程中的关键可扩展性和精确性挑战。这些技术将混沌工程从被动实践转变为主动的、自优化的系统弹性策略。

虽然许多混沌工程实验采用随机性(例如,选择随机服务器或服务进行停机),但混沌工程的实践与实验室科学一样有条不紊。在本节中,我们将深入探讨混沌工程的核心原则,并了解在进行实验时减少引起服务中断风险的最佳实践。

Netflix定义了一套核心原则,为探索系统在压力下的行为提供了有用的框架。结构化方法确保您的混沌实验不仅仅是破坏性事件,而是结构化的调查,生成有价值的数据,您可以使用这些数据来推动系统弹性的改进。这些原则是:

定义表征正常系统行为的”稳定状态”

可观测性是关键。您必须拥有所需的指标来理解表明系统健康且按预期执行的正常值范围。这可能包括请求延迟、错误率、吞吐量或应用程序特定指标。务必考虑可能影响您指标的外部因素,如时间、星期几或可能导致流量激增的营销活动。

将期望转化为假设

基于您对系统架构和依赖关系的理解,制定关于在引入特定故障时系统应该如何表现的假设。以可以使用您选择的指标客观测试的方式构建您的假设。例如,“如果我们模拟20%的流量增长,平均响应时间应保持在三秒以下,错误率不应超过0.5%。”

通过模拟现实世界事件来执行实验

使用混沌工程工具自动注入故障。模拟服务器崩溃或变得不可用、关键第三方服务中断或用户请求激增。

根据假设评估结果

将实验期间系统的行为与您建立的基线和假设结果进行比较。指标是否保持在可接受的范围内?系统是否按预期恢复?是否观察到任何意外的副作用?如果系统偏离了预期行为,请调查根本原因。根据实验结果,完善您的假设并调整您的系统设计或操作程序以增强弹性。

模拟故障以故意使系统宕机当然会带来风险。我们有意识地以这种受控方式承担风险来验证我们定义的假设。减少风险的重要策略是从小实验开始。为了说明小规模开始和扩展实验,让我们通过一个专注于测试电子商务系统中结账服务的示例来演示。该服务是处理用户购买的关键微服务。预期结果很简单:客户将商品添加到购物车,进行结账,并完成付款。客户期望获得流畅、快速和可靠的体验。在幕后,这个简单的操作依赖于一系列复杂的过程。结账服务依赖多个API和外部服务才能正常运行,包括库存系统、支付网关和缓存层(如Redis)来快速检索重要数据,如产品价格、折扣和可用性。结账服务从缓存中获取定价数据以便快速访问。如果缓存缓慢或失败,结账服务仍应通过故障转移到另一个缓存实例甚至数据库作为备份来提供正确的信息,尽管可能会更慢。

GenAI可以将混沌工程从手动假设测试转变为自适应、自优化的弹性验证系统。这种方法在结账服务等关键电子商务工作流中特别有价值,其中平衡风险缓解与现实故障模拟至关重要。

开发人员通常配置重试逻辑、超时和断路器来处理网络问题或故障。让我们看看每一个:

重试逻辑

这确保如果对缓存的请求失败或遇到网络问题,系统将在放弃之前自动重试几次。这有助于处理瞬态故障。例如,系统可能最多重试三次,每次重试之间延迟100毫秒。

超时

超时设置定义服务在决定尝试失败之前应等待响应多长时间。这防止服务在缓存缓慢或无响应时无限期挂起。系统可能配置为对缓存的每个请求在200毫秒后超时。

断路器

断路器在一定数量的失败尝试后防止进一步尝试调用失败的服务。如果缓存继续失败或太慢,断路器

熔断器”跳闸”并将流量路由到后备系统(例如,另一个缓存或数据库)。熔断器可以在设定的时间段后自动重置,以测试原始服务是否已恢复。例如,熔断器可能配置为在连续五次重试失败后跳闸。

我们将开始测试结账服务,首先引入小延迟以确保重试逻辑和超时设置正常运行,然后再扩大规模引入更严重的问题,最终触发熔断器。如果一切顺利,我们预期系统将故障转移到替代数据源。以下是我们的步骤。

我们从测试重试逻辑开始。我们希望确保如果出现网络问题(如高延迟或临时连接中断),系统具有韧性。我们的稳态是一个响应迅速的服务,在可接受的时间限制内做出响应。我们的假设是,如果网络在尝试访问缓存时经历显著延迟,系统应该使用其重试逻辑和超时设置来优雅地处理问题,最终触发熔断器以防止服务进一步降级。

我们从小处开始,在结账服务和缓存之间注入少量网络延迟(例如200毫秒)。

我们观察重试逻辑是否启动,服务是否在可接受的时间限制内处理延迟而不影响用户。我们继续监控系统是否按预期继续运行,在延迟后从缓存中拉取数据。

一旦我们用小延迟测试了重试逻辑,就可以增加实验的范围和强度来模拟更严重的网络问题。这测试了我们的超时。我们增加网络延迟(例如,从500毫秒到1秒)来观察服务在更重负载或网络拥塞下的行为。我们测试重试逻辑如何处理延长的延迟。服务是否重试对缓存的调用,

并且是否遵循超时设置?如果是的话,我们通过在设定的重试次数后导致缓存API完全失败来增加问题的严重性。

接下来我们设定实验条件使缓存无法访问。重试后,应该触发熔断器机制。当熔断器跳闸时,结账服务故障转移到替代数据源,如不同数据中心的另一个缓存实例(在这种情况下,是我们的Postgres数据库)。虽然Postgres数据库可能比缓存慢,但目标是保持服务可操作,尽管性能略有下降。AI代理可以通过使用强化学习动态调整故障注入参数使这个过程更加简单。例如:

从200毫秒延迟开始,然后基于实时性能遥测自动扩展到500毫秒到1秒。

最初将实验影响限制在0.5%的交易,只有在验证安全机制后才扩大。

通过历史成功模式分析优化跳闸阈值(例如,从五次失败到四次)。

你可以进一步扩展实验,通过在结账服务和Postgres数据库之间引入类似的网络问题来测试故障转移的韧性,观察系统如何在增加的故障条件下继续适应。通过遵循这个过程,我们逐渐增加实验的复杂性来验证系统的韧性机制,而不是立即跳到重大中断。

重要的是要注意,韧性机制的初始设置通常基于有根据的猜测而不是精确的数据。这是通过混沌工程实验进行测试如此重要的另一个原因。

注入网络延迟只是我们可以在混沌实验中扩展的一个条件。我们将在本节后面讨论其他条件。

在混沌工程中最小化风险的另一个重要最佳实践是在转向生产环境之前先在预生产环境中测试实验。这允许我们在不影响真实用户的情况下安全地进行实验。我们可以快速迭代、调整参数并观察结果,不受生产约束的限制。一旦我们在这些设置中确认系统韧性,我们就将实验推广到下一个环境,最终达到生产环境。每次推广都带有风险,所以我们谨慎进行。环境之间的配置偏差可能导致

实验结果的差异。在环境之间移动时保持”从小开始并扩展”的方法对于处理我们可能遇到的问题至关重要。在预生产环境中充分审查我们的实验确保我们的实验设计良好且有洞察力,没有意外后果。

我们广泛研究了在混沌实验中测试网络延迟的示例。还有许多其他类型的条件需要测试。现代工具(如Harness Chaos Engineering、Chaos Monkey和LitmusChaos)可以通过提供广泛的预定义实验目录来帮助解决这个问题。现代工具通常会跨类别和常见故障模式提供混沌工程实验,包括:

强制高CPU利用率来模拟进程消耗过量处理能力。

消耗所有可用内存来测试你的应用程序如何处理内存压力和潜在的内存不足错误。

生成大量磁盘读/写操作来模拟存储瓶颈。

网络带宽耗尽

饱和网络带宽以测试应用程序在网络拥塞情况下的性能表现。

网络中断

网络延迟

在服务之间或与外部依赖项的网络通信中引入延迟。

丢包

模拟网络数据包的丢失,以测试应用程序如何处理不可靠的连接。

网络分区

隔离部分网络以模拟服务之间的连接问题或可用区故障。

DNS故障

模拟DNS解析问题,以测试应用程序如何处理DNS故障或错误响应。

基础设施故障

节点故障

终止或关闭虚拟机或容器以模拟硬件故障。

Pod故障(Kubernetes)

杀死或驱逐pods以测试Kubernetes部署的自愈能力。

可用区故障

模拟整个可用区的故障,以测试灾难恢复计划和多区域部署。

推理层攻击

在ML模型服务期间模拟GPU内存耗尽。

应用层故障

服务故障

停止或崩溃应用程序中的特定服务,以测试容错能力和服务降级。

功能故障

在特定函数或方法中引入错误或异常,以测试错误处理和恢复机制。

数据损坏

损坏数据库或存储系统中的数据,以测试数据完整性和恢复过程。

状态管理

时间旅行

操作系统时钟以模拟时间偏移,测试应用程序如何处理时间敏感的操作或计划任务。

状态注入

向应用程序注入特定数据或状态,以测试其在异常条件下的行为。使用GenAI创建符合模式约束的可信损坏数据条目。

使用AI的动态场景生成

架构建模

使用AI分析服务依赖关系(例如,Redis缓存 → 支付网关 → 数据库),创建镜像生产环境的故障链。

生成对抗网络

通过让AI模型相互对抗来创建新颖的故障模式,发现未探索的漏洞组合。

我们尝试的实验类型越多,就能更多地了解系统中的弱点以及如何加强我们的韧性。

较新的工具不仅提供目录,还可以分析您的系统架构,建议针对性的实验来暴露特定于您设置的潜在弱点。例如,对于采用微服务架构构建的软件,混沌工程工具可能会分析网络流量和依赖关系,识别关键服务并建议专门针对这些服务的实验。现代工具还可能建议在服务之间的API调用中注入延迟或错误,以测试对通信中断的韧性。

对于使用Kubernetes部署的应用程序,该工具可以分析您的Kubernetes部署,并建议针对特定pods、部署或命名空间的实验,以测试副本扩展、资源限制和健康检查。像Red Hat的Krkn这样的工具使用AI分析Kubernetes pods,优先考虑网络密集型服务进行分区测试。在多区域部署的情况下,现代工具可能会分析您的多区域设置,并建议模拟区域故障或网络分区的实验,以测试您的灾难恢复计划以及应用程序故障转移到另一个区域的能力。

密切关注行业范围内的事件,特别是那些影响具有类似技术栈公司的事件,对于主动风险缓解至关重要。例如,2024年12月11日的OpenAI故障事件强烈提醒我们,看似微小的部署如何产生级联后果。在这种情况下,一个新的遥测服务压垮了公司的Kubernetes控制平面,触发了DNS故障,导致其API、ChatGPT和Sora平台宕机数小时。影响广泛且持久:几个小时内,开发人员和用户无法访问他们依赖的服务。工程师在几分钟内识别出根本原因,但面临一个主要障碍——无法访问Kubernetes控制平面,回滚或修复部署变得极其困难。

让我们看看一些有针对性的混沌工程实验,了解这些级联故障如何可能被预防。

首先,我们设计一个实验来测试我们的Kubernetes API服务器韧性。在这个实验中,我们会故意用大量的读/写操作淹没Kubernetes API服务器,模拟新遥测服务在生产中所做的事情。通过在具有生产级规模的预发环境中运行此测试,我们本可以发现API服务器开始失败的确切阈值。这种早期检测将为更好的负载限制、改进的告警以及可能的更安全的分阶段推出策略提供信息。

这个实验将涉及在DNS解析过程中引入延迟或故障——特别是针对负责服务发现的组件。运行此实验有助于确认即使DNS中断,基本服务也能继续运行。我们将发现我们的缓存、回退机制或替代路由策略是否足够。如果不够,我们就知道在真正的故障发生之前要在这些领域进行投资。

这最后一个实验(或演练)涉及模拟工程师在高负载下被锁定在Kubernetes API之外的情况。通过练习紧急访问方法——比如拥有专用的带外通道或专门的工具——团队可以在标准控制平面无法访问时快速回滚或禁用有问题的部署。如果事先进行了这个演练,团队就会确切地知道如何在几分钟内移除故障的遥测服务,从而最大限度地减少停机时间。

我们看到了chaos engineering如何帮助我们发现弱点并构建更有弹性的系统。但是我们如何定义”弹性”?我们如何衡量和跟踪我们的系统是否满足我们的可靠性目标?这就是SLO和service-level indicators (SLI)发挥作用的地方。它们共同为定义和衡量我们服务的可靠性提供了框架,为我们提供了一个明确的目标和跟踪进展的方法。

SLO是我们为服务可靠性设定的目标。SLI是我们用来衡量是否达到这些目标的具体指标。SLO通常表示为必须满足定义的SLI标准的时间百分比或请求数量。例如,99.9%的请求应该具有低于200毫秒的延迟。SLI是反映服务从用户角度性能的具体、可衡量的指标。它们量化了可用性、延迟、错误率、吞吐量和其他相关因素等方面。

本质上,SLI是你测量的内容,SLO是你为这些测量设定的目标。

在建立可靠性目标时,必须将它们与总体业务需求保持一致。监控和可观察性解决方案提供了许多SLI指标,但重要的是要优先考虑那些准确反映客户体验应用程序的指标。目标不是跟踪每个单独的服务,而是专注于那些对客户体验至关重要的服务。常见的SLI包括”四个黄金信号”:

请求延迟

处理用户请求所需的时间

吞吐量

每秒处理的请求数量

错误率

失败请求的百分比

饱和度

系统的利用率百分比

仔细考虑如何在你的系统中实现每一个这些指标。例如,在测量延迟(响应时间)时,你可以选择跟踪所有事务或专注于最关键事务的子集,如登录、付款提交或向购物车添加商品。再次强调,选择一个能够有意义地代表客户体验的指标。

在第1章中,我们将DevOps介绍为结合软件开发(Dev)和IT运营(Ops)关注点的实践。在确保系统可靠性方面,共同所有权和协作是最重要的。SLO是这种共同责任的一个很好的例子。开发、运营和可靠性团队应该共同合作来定义SLO。这种协作建立了对可接受系统性能的理解,并为每个人创造了一个共同的目标。然后SLO作为做出决策的指导,平衡快速开发(速度)的需要和稳定可靠系统的需要。

有了这种共同理解,开发人员可以优先考虑维护可靠性的功能,了解他们的工作如何影响整体系统性能。同时,运营团队获得了有效支持应用程序所需的上下文。如果违反SLO,就会触发活动,鼓励工程团队在发布新功能之前稳定服务。这有助于防止不稳定的循环,并确保可靠性仍然是首要任务。对设计、优先级排序和进行chaos engineering实验本身采用协作方法能够将团队聚集在一起。所有团队都受益于从这些实验中获得的洞察以及共同努力解决发现的故障。

现代工具促进了这种系统可靠性的协作方法。监控平台、事件管理系统和通信工具为系统性能和潜在问题提供了共享的可见性。实时数据和自动化警报使Dev和Ops团队能够快速响应事件。更重要的是,这些工具培养了主动解决问题的文化(如数据驱动的优先级排序、实时协作分诊等),团队可以在问题影响用户之前识别和解决潜在问题。

我们已经了解了chaos engineering如何帮助我们主动发现系统弱点,以及SLO和SLI如何为定义我们的可靠性目标和衡量我们的系统是否达到这些目标提供明确的框架。错误预算的出现为我们提供了安全网。

错误预算代表服务在仍然满足其SLO的同时可以拥有的最大不可靠性或停机时间。通过在追求快速创新的过程中容忍小的故障,错误预算承认完美是不可达到的,而是帮助我们实现平衡这两个竞争优先级的可接受可靠性水平。

让我们通过回到电商示例来看看这是如何工作的。假设我们为网站登录设定了99.9%的SLO,要求响应时间少于300毫秒。在一周时间内,这转化为最大允许的SLO违反时间为10.08分钟。这就是我们的错误预算。这对我们有什么影响?如果错误预算消耗至零,我们将停止或放慢新软件的部署,专注于稳定系统,同时等待错误预算补充。错误预算的状态不仅影响我们的部署优先级,还会影响混沌测试的优先级。

密切关注你的SLI不仅能提醒你注意即时问题——它还能揭示系统中的潜在弱点。例如,如果你注意到系统不断触及延迟限制,消耗错误预算,你的系统可能在高流量场景中难以跟上。这提示了一个专注混沌实验的良好领域。通过模拟这些高流量、高延迟的情况,你可以看到系统在压力下的表现,确保它在峰值使用期间仍能满足SLO。借助现代工具,你可以通过基于这些模式自动触发混沌测试来实现自动化,这样你就可以持续测试和改善系统的韧性,而无需动手。现代平台可以使用AI将SLI趋势与混沌测试建议关联起来,从而显著增加测试覆盖率。

错误预算不仅仅是偶然故障的安全网;它们是管理风险的工具。使用我们的电商网站示例,我们将10.08分钟的错误预算视为需要明智支出的资源。在本节中,我们将探讨如何主动使用这个预算来进行混沌实验。

有效的混沌工程需要考虑你的可用错误预算。当你的错误预算健康时,你的跑道很长。你有更多自由进行激进的实验,模拟大规模故障或将关键系统组件推向极限。这可能涉及测试故障转移机制、注入网络延迟,甚至模拟核心服务的完全中断。随着错误预算的减少,必须将焦点转向携带较少重大中断风险的小规模实验。这些可能涉及隔离测试单个组件、模拟轻微网络问题或验证最近更改的韧性。以这种方式确定实验优先级确保你可以在不危及整体系统稳定性的情况下继续学习和改进。现代自动化工具可以提供帮助。通过实时分析你的错误预算,这些工具可以基于你可用的”故障空间”推荐适当的实验。这允许你在主动测试和服务可靠性之间保持平衡,确保你的混沌工程工作既有洞察力又负责任。

首先模拟是另一种在混沌实验中最小化意外后果风险的策略。这在面对不断减少的错误预算时尤其重要。AI增强的混沌实验”试运行”实践涉及在受控环境中模拟实验,使用系统模型或副本来评估它们在生产中执行之前的潜在影响,并使用AI修复代理在异常检测阈值超过预定义限制时回滚实验。通过事先识别潜在问题和完善实验参数,团队可以降低造成可能耗尽你的错误预算并造成重大中断的显著破坏的可能性。

可靠性问题主要由变更驱动,对我们应用程序的变更或对你基础设施的变更。Google DevOps研究与评估(DORA)定义了变更失败率(CFR)指标,这为我们提供了挑战的另一个视角。CFR描述了我们的变更(如新代码部署或基础设施更新)多久在生产中引入需要热修复或回滚的问题。DORA 2024 DevOps状态报告显示,80%的受调查团队的平均CFR为其发布的20%。事实上,25%的团队的CFR平均达到令人担忧的40%的发布。

此外,我们必须考虑修复每个变更失败的时间和成本。失败部署恢复时间指标(替代类似的平均修复时间[MTTR]指标)专注于组织从故障中恢复的速度。这让我们了解团队在这方面面临的挑战。虽然许多团队能够在不到一天内修复,但25%需要一周到一个月来替换有缺陷的软件。

在前面的章节中,我们探讨了防止缺陷进入生产环境的策略。我们在交付流水线的每个阶段都进行测试,执行各种类型的测试。我们在环境管理方面格外小心。我们通过GitOps结合IaC等实践来防止配置漂移。我们在预生产和生产环境中进行混沌工程测试,帮助我们发现系统中的薄弱环节。然而,尽管我们尽了最大努力,偶尔出现需要快速修复的缺陷仍是不可避免的。这就是持续韧性发挥作用的地方。正如持续集成和持续交付是通过自动化来构建、测试和部署代码,持续韧性就是通过将混沌工程实验添加到CI/CD流水线中来自动化我们的韧性实践。这样做意味着我们不仅仅在测试功能,而是主动且持续地评估变更对系统稳定性的潜在影响。使用AI代理进行DevOps,混沌实验可以智能地集成到CI/CD流水线中。

在”扩展你的混沌工程实践”中,我们将探讨如何通过借助现代工具将混沌工程纳入交付流水线来扩展混沌工程实践。我们将研究如何优先考虑要添加到流水线中的实验,以及在流水线中保护和管理混沌实验的最佳实践。

组织以不同的方式开始其混沌工程之旅。通常,单个团队或两个团队会采用开源工具,并在组织的一个小范围内引入实验。组织可能会举办定期的混沌工程”游戏日”。这些是全员参与的计划性活动,团队故意向系统注入一系列故障,以在受控环境中练习事件响应并识别弱点。这些活动通常不频繁,且响应是对发现问题的被动反应。

在整个组织范围内大规模实施持续韧性的关键可能在于选择合适的工具。虽然开源和专有解决方案都提供了有价值的功能,但组织应该仔细评估其需求。一些企业环境可能需要特定功能,如高级安全控制、全面审计跟踪和RBAC——这些功能在开源解决方案中的可用性和成熟度可能有所不同。一家处理超过十亿日交易的领先金融科技公司深切感受到了这一挑战。面对峰值需求期间交易失败率不断增加的问题,该公司寻求解决方案来提高其支持20多种金融产品的复杂平台的可靠性。

该公司选择现代混沌工程工具在克服扩展混沌工程实践障碍方面发挥了重要作用。它选择的工具(在这种情况下是Harness Chaos Engineering)包含了广泛的预构建实验库,简化了自动化和编排众多混沌实验的工作。此外,全面的分析和报告功能为该公司快速洞察其系统的韧性提供了支持。该公司首先专注于处理九百万日支付请求的单一关键服务。它在复杂的基础设施中确定了容错目标,为韧性测试的受控推广奠定了基础。通过优先考虑在交付流水线和生产环境中自动化混沌实验,它解决了交易失败的根本原因,并为持续韧性建立了基础。

通过其自动化韧性测试平台,该公司能够扩大测试范围,发现服务恢复中的漏洞,优化应用程序设计模式,并微调配置。结果非常显著:失败交易减少了16倍,MTTR降低到10分钟,客户满意度提高了10倍。如果没有提供安全性、模板和自动化以及编排的现代工具,就不可能在整个组织中推广混沌工程,并在如此短的时间内取得这些结果。