献给我的儿子 Bruno,

两岁的你为我的生活带来了新的璀璨光芒。当我探索这些将定义我们明天的系统时,你将继承的世界始终在我心中最重要的位置。

献给我的儿子 Leonardo 和 Lorenzo,以及我的女儿 Aurora,

我为你们成长为如此优秀的人以及你们正在建设的美好世界而感到骄傲。

这本书讲述如何构建智能工具,但它承载着深刻的希望,希望你们这一代能以智慧和同情心引导它们。如果我们学会使用这些强大的技术来服务人类并帮助其进步,未来对你们和我们所有人来说都将无比光明。

满怀我的爱。

人工智能领域正处在一个引人入胜的拐点。我们正在从构建仅能处理信息的模型转向创建能够推理、规划并采取行动来完成复杂目标和模糊任务的智能系统。这些”智能体式”系统,正如本书恰如其分所描述的,代表着人工智能的下一个前沿,它们的发展是一个让我们在谷歌感到兴奋和鼓舞的挑战。

《智能体设计模式:构建智能系统的实用指南》在这个完美的时刻到来,指导我们踏上这段旅程。本书正确地指出,大型语言模型的力量——这些智能体的认知引擎——必须通过结构和深思熟虑的设计来加以利用。正如设计模式通过提供通用语言和可重用的解决方案来革命化软件工程一样,本书中的智能体模式将成为构建强健、可扩展和可靠智能系统的基础。

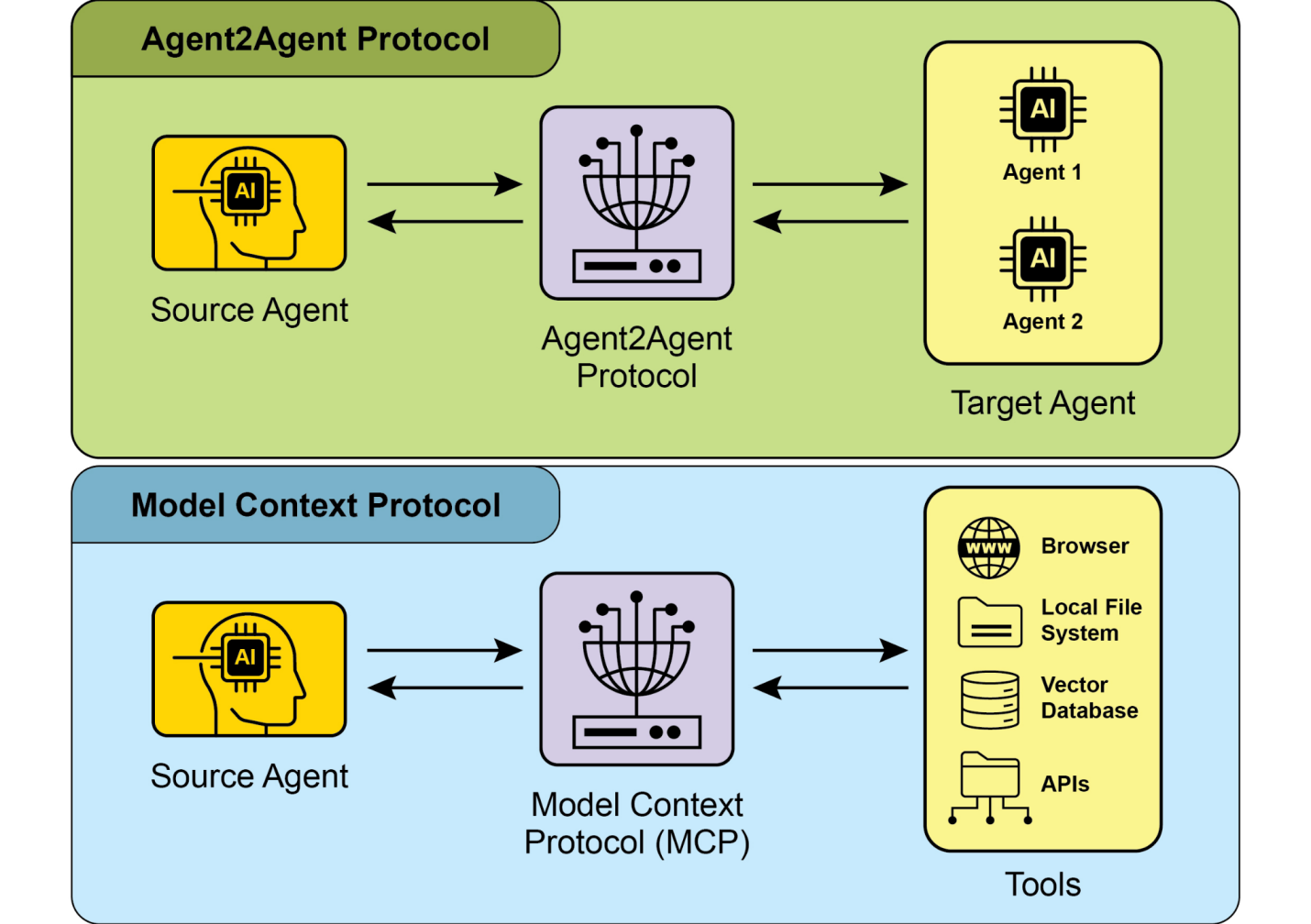

用”画布”来比喻构建智能体系统这一概念与我们在谷歌 Vertex AI 平台上的工作产生了深刻共鸣。我们致力于为开发者提供最强大、最灵活的画布,让他们构建下一代人工智能应用程序。本书提供了实用的、实践性的指导,将使开发者能够充分发挥该画布的潜力。通过探索从提示链接和工具使用到智能体间协作、自我纠正、安全和保护措施的各种模式,本书为任何希望构建复杂人工智能智能体的开发者提供了全面的工具包。

人工智能的未来将由能够构建这些智能系统的开发者的创造力和独创性来定义。《智能体设计模式》是一个不可或缺的资源,将有助于释放这种创造力。它提供了基础知识和实际示例,不仅帮助理解智能体系统的”是什么”和”为什么”,还有”如何实现”。

我很高兴看到这本书出现在开发者社区的手中。这些页面中的模式和原理无疑将加速创新和有影响力的人工智能应用程序的开发,这些应用程序将在未来几年塑造我们的世界。

Saurabh Tiwary 谷歌 CloudAI 副总裁兼总经理

欢迎阅读《智能体设计模式:构建智能系统的实用指南》。当我们观察现代人工智能的格局时,我们看到了从简单的反应式程序到复杂的自主实体的清晰演变,这些实体能够理解上下文、做出决策,并与其环境和其他系统动态交互。这些就是智能智能体以及它们组成的智能体系统。

强大的大型语言模型(LLMs)的出现为理解和生成类似人类的内容(如文本和媒体)提供了前所未有的能力,成为许多这些智能体的认知引擎。然而,将这些能力编排成能够可靠实现复杂目标的系统需要的不仅仅是强大的模型。它需要结构、设计以及对智能体如何感知、规划、行动和交互的深思熟虑的方法。

想象一下,构建智能系统就像在画布上创作复杂的艺术品或工程作品。这个画布不是空白的视觉空间,而是为你的智能体提供存在和运行环境和工具的底层基础设施和框架。它是你构建智能应用程序的基础,管理状态、通信、工具访问和逻辑流程。

在这个智能体画布上有效构建需要的不仅仅是将组件拼凑在一起。它需要理解经过验证的技术——模式——来解决设计和实现智能体行为时面临的常见挑战。正如建筑模式指导建筑物的建造,或设计模式构造软件一样,智能体设计模式为你在所选画布上赋予智能智能体生命时面临的重复问题提供可重用的解决方案。

从本质上讲,智能体系统是一个计算实体,旨在感知其环境(数字环境和潜在的物理环境)、基于这些感知和一组预定义或学习的目标做出明智的决策,并自主执行行动来实现这些目标。与遵循严格的分步指令的传统软件不同,智能体表现出一定程度的灵活性和主动性。

想象你需要一个管理客户询问的系统。传统系统可能会遵循固定的脚本。然而,智能体系统可以感知客户查询的细微差别,访问知识库,与其他内部系统(如订单管理)交互,可能会询问澄清问题,并主动解决问题,甚至可能预测未来需求。这些智能体在你应用程序基础设施的画布上运行,利用可用的服务和数据。

智能体系统(Agentic systems)通常具有自主性(autonomy)等特征,允许它们在没有持续人类监督的情况下行动;主动性(proactiveness),主动启动行动以实现目标;以及反应性(reactiveness),对环境变化做出有效响应。它们本质上是目标导向的(goal-oriented),持续朝着目标努力。一个关键能力是工具使用(tool use),使它们能够与外部API、数据库或服务交互——有效地扩展到直接画布之外。它们具有记忆(memory),在交互中保留信息,并能与用户、其他系统或甚至在相同或连接画布上操作的其他智能体进行通信(communication)。

有效实现这些特征引入了显著的复杂性。智能体如何在其画布上的多个步骤中维护状态?它如何决定何时和如何使用工具?不同智能体之间的通信是如何管理的?您如何在系统中构建韧性以处理意外结果或错误?

这种复杂性正是智能体设计模式不可或缺的原因。它们不是严格的规则,而是经过实战验证的模板或蓝图,为智能体领域的标准设计和实现挑战提供了成熟的方法。通过识别和应用这些设计模式,您获得了增强在画布上构建的智能体的结构、可维护性、可靠性和效率的解决方案。

使用设计模式帮助您避免为管理对话流程、集成外部能力或协调多个智能体动作等任务重新发明基本解决方案。它们提供了一种通用语言和结构,使您的智能体逻辑更清晰,更容易被他人(以及未来的您自己)理解和维护。实施为错误处理或状态管理设计的模式直接有助于构建更强大和可靠的系统。利用这些既定方法加速您的开发过程,使您能够专注于应用程序的独特方面,而不是智能体行为的基础机制。

本书提取了21个关键设计模式,代表了在各种技术画布上构建复杂智能体的基础构建块和技术。理解和应用这些模式将显著提升您有效设计和实现智能系统的能力。

《智能体设计模式(Agentic Design Patterns):构建智能系统的实操指南》旨在成为一个实用且易懂的资源。其主要焦点是清晰地解释每个智能体模式,并提供具体的可运行代码示例来演示其实现。在21个专门章节中,我们将探索各种设计模式,从结构化顺序操作(提示链Prompt Chaining)和外部交互(工具使用Tool Use)等基础概念,到更高级的主题,如协作工作(多智能体协作Multi-Agent Collaboration)和自我改进(自我纠正Self-Correction)。

本书按章节组织,每个章节深入研究一个智能体模式。在每个章节中,您将找到:

● 模式概述,提供模式及其在智能体设计中的作用的清晰解释。

● 实际应用和使用案例部分,说明该模式在现实世界场景中的价值以及它带来的好处。

● 实操代码示例,提供使用著名智能体开发框架演示模式实现的实用、可运行代码。这是您将看到如何在技术画布环境中应用模式的地方。

● 关键要点,总结最重要的要点以供快速回顾。

● 参考文献,供进一步探索,提供该模式和相关概念的深度学习资源。

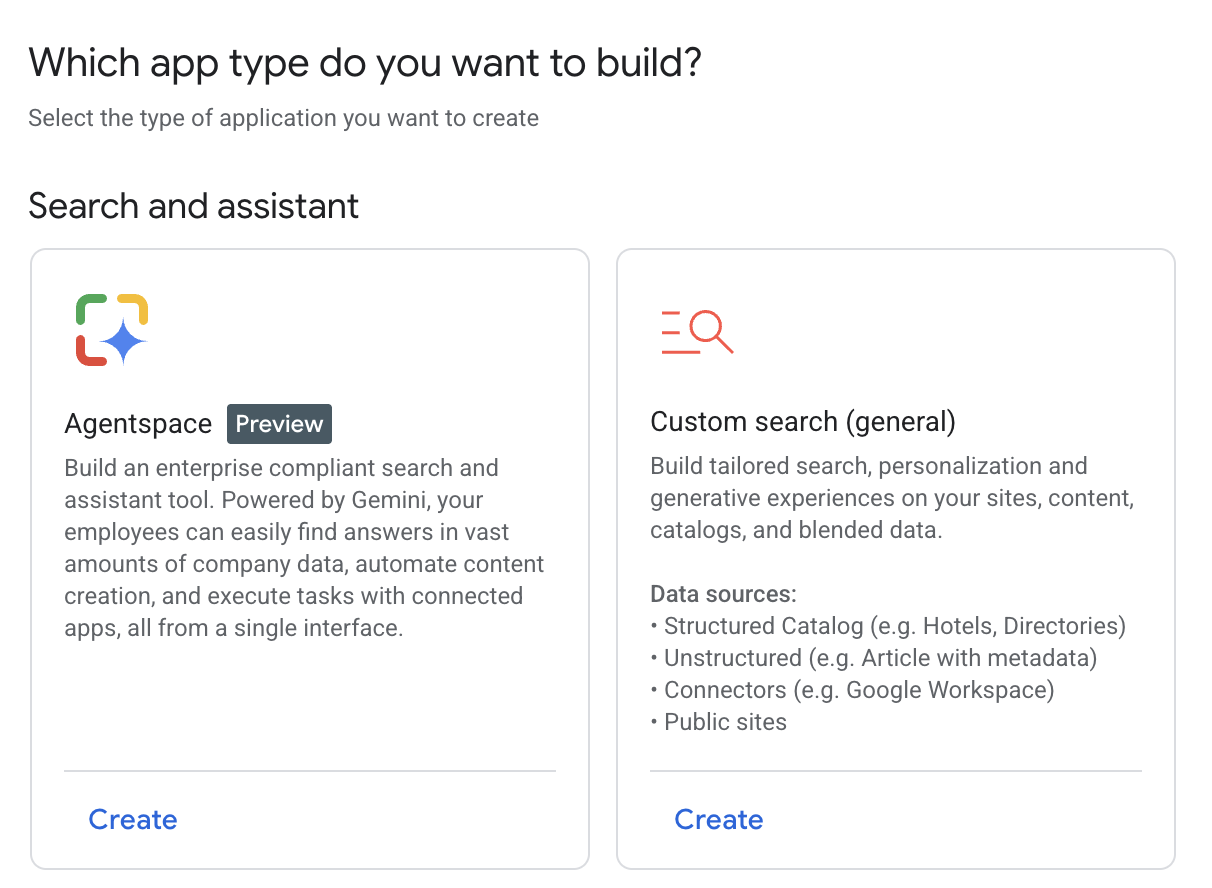

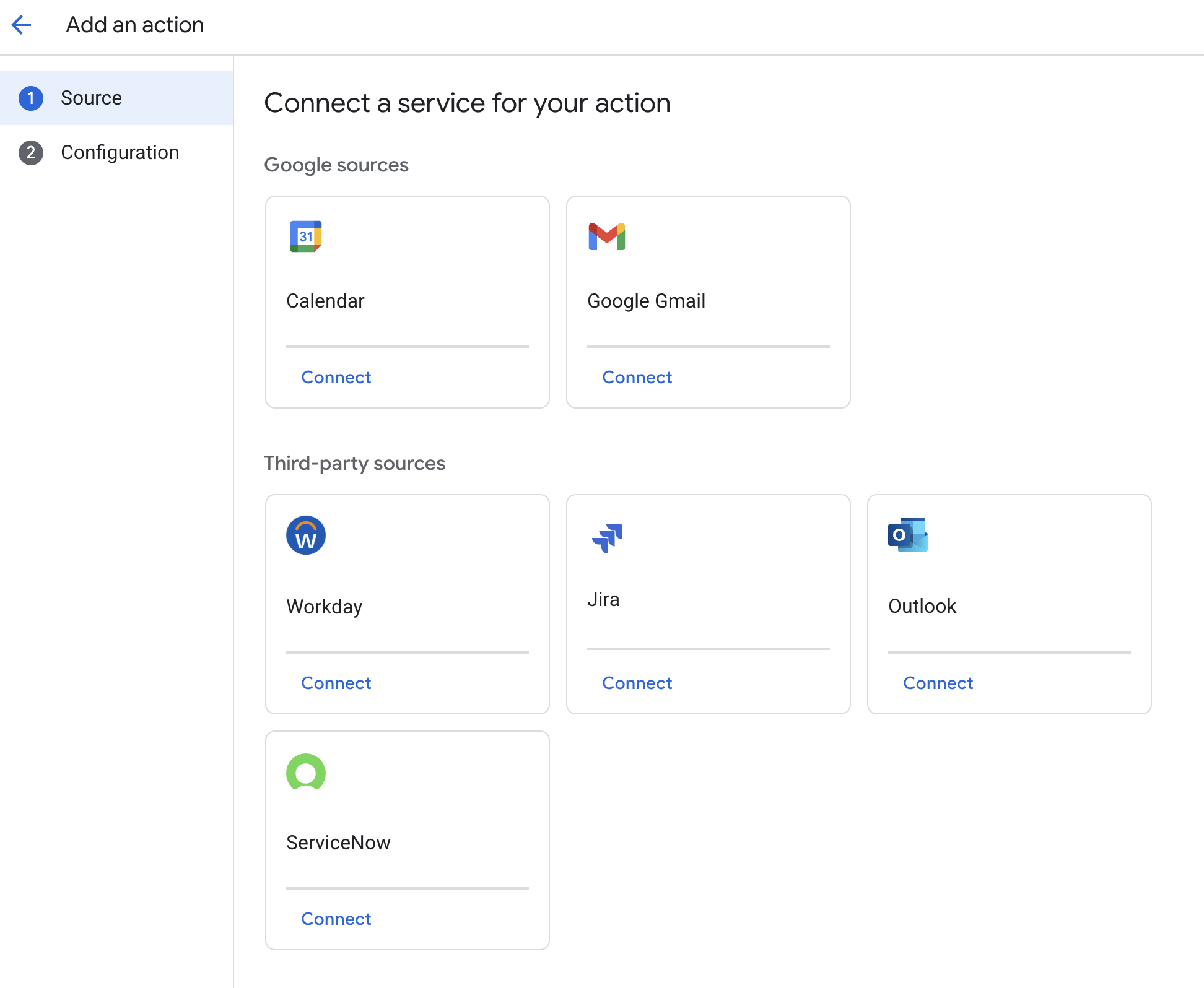

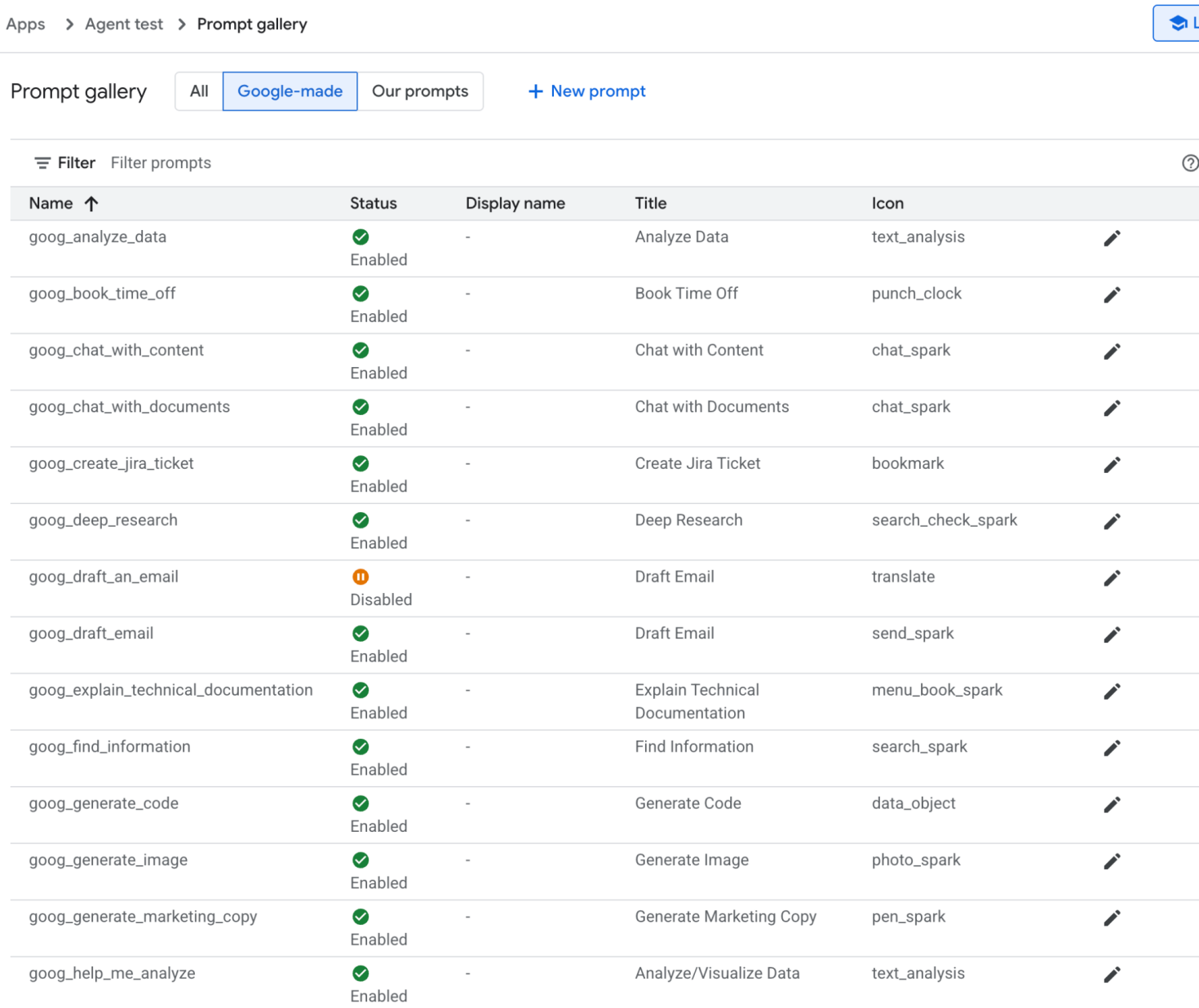

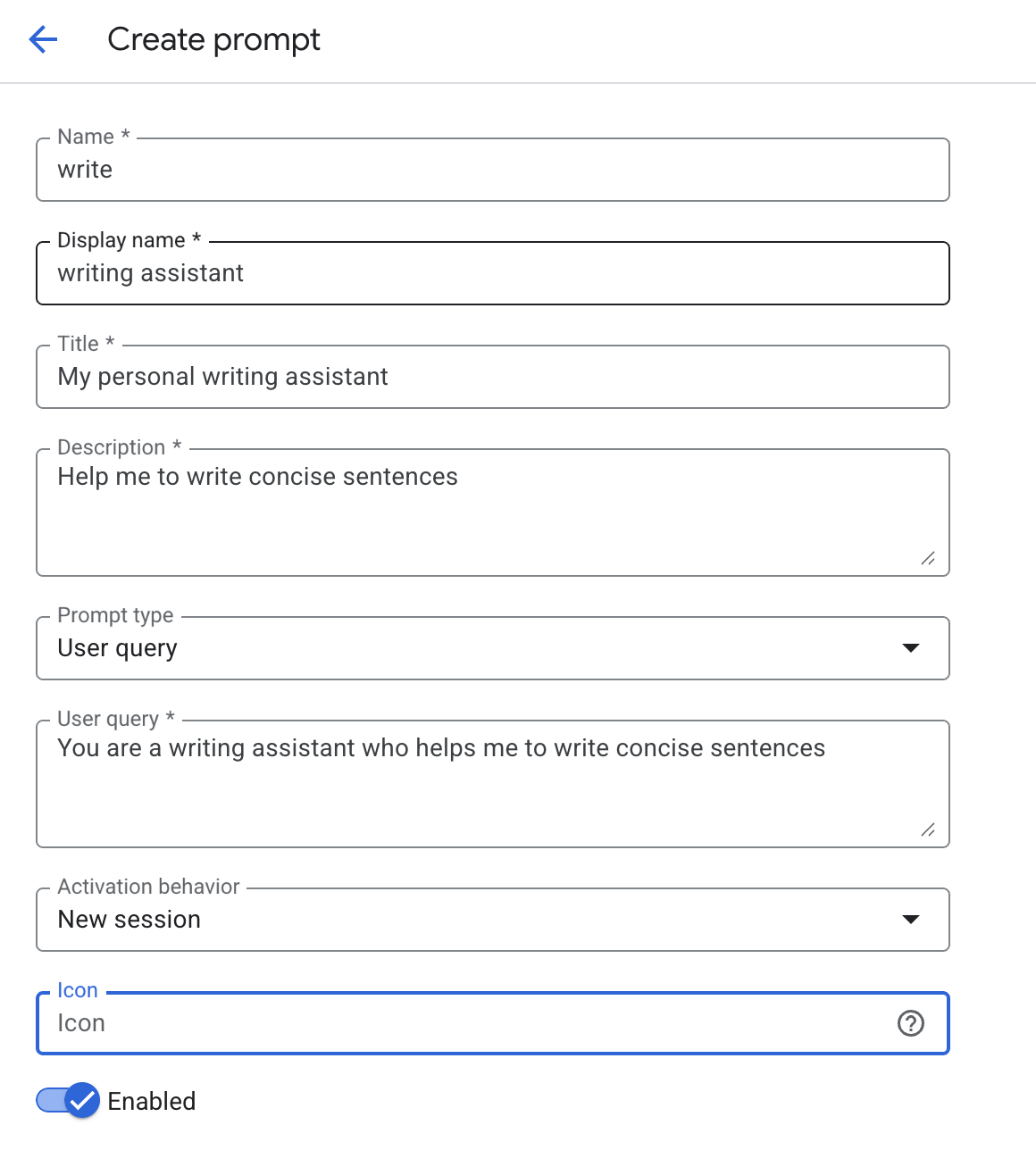

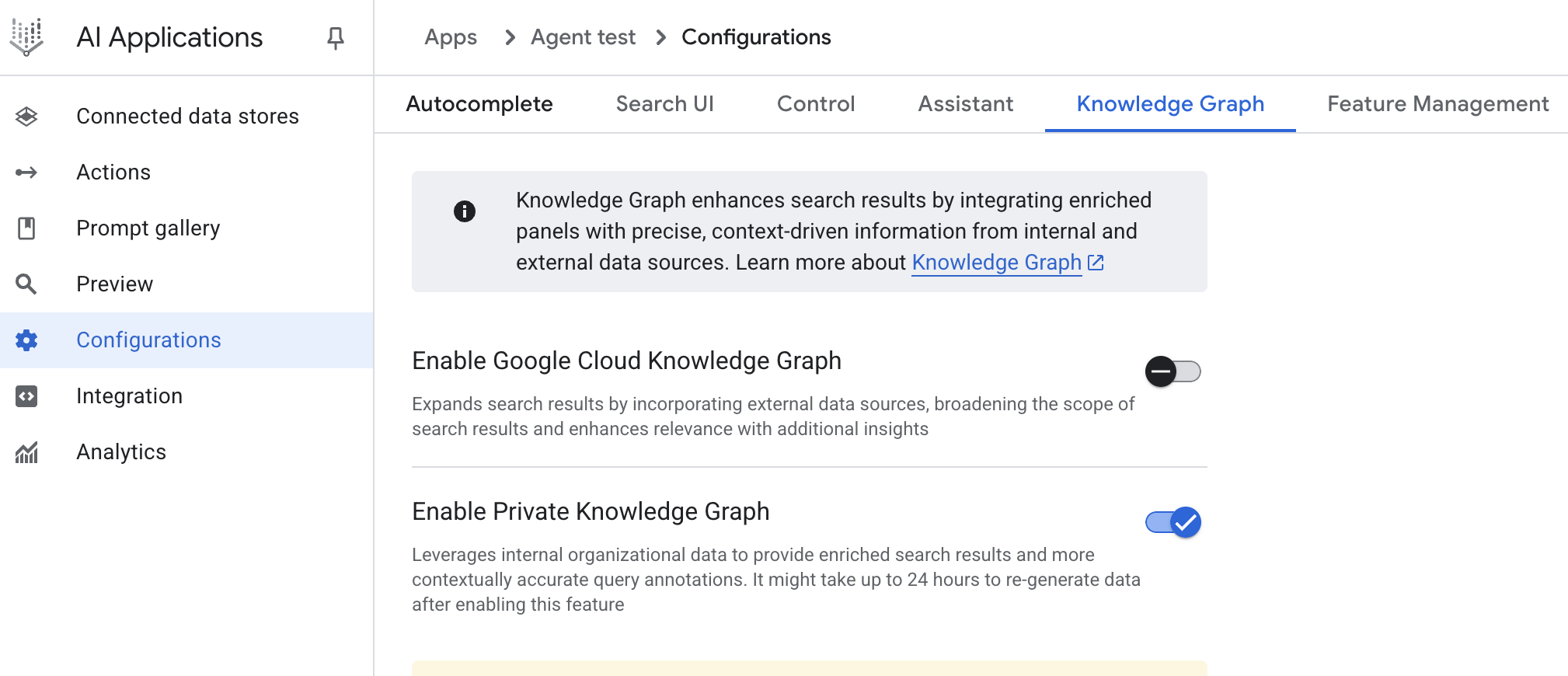

虽然章节按照渐进构建概念的顺序排列,但请随意将本书用作参考,跳转到解决您在自己的智能体开发项目中面临的特定挑战的章节。附录提供了高级提示技术的全面介绍、在现实世界环境中应用AI智能体的原则,以及基本智能体框架的概述。为了补充这些内容,包含了实用的在线教程,提供使用AgentSpace等特定平台以及命令行界面构建智能体的逐步指导。整本书的重点在于实际应用;我们强烈建议您运行代码示例,进行实验,并调整它们以在您选择的画布上构建自己的智能系统。

我听到的一个很好的问题是:“AI变化如此之快,为什么要写一本可能很快就过时的书?”我的动机实际上是相反的。正是因为事情发展得如此迅速,我们需要退一步,识别正在固化的底层原则。像RAG、反思(Reflection)、路由(Routing)、记忆(Memory)和我讨论的其他模式,正在成为基本构建块。这本书是对反思这些核心思想的邀请,它们提供了我们需要构建的基础。人类需要这些关于基础模式的反思时刻。

为了为我们的代码示例提供具体的”画布”(参见附录),我们将主要使用三个著名的智能体开发框架。LangChain及其有状态扩展LangGraph,提供了一种灵活的方式来链接语言模型和其他组件,为构建复杂的操作序列和图形提供强大的画布。Crew AI提供了专门设计用于编排多个AI智能体、角色和任务的结构化框架,作为特别适合协作智能体系统的画布。Google智能体开发工具包(Google ADK)提供了构建、评估和部署智能体的工具和组件,提供了另一个有价值的画布,通常与Google的AI基础设施集成。

这些框架代表了智能体开发画布的不同方面,各有其优势。通过展示这些工具的示例,您将更广泛地了解如何应用这些模式,无论您为智能体系统选择什么具体的技术环境。这些示例旨在清晰地说明模式的核心逻辑及其在框架画布上的实现,重点关注清晰性和实用性。

在本书结束时,您不仅将了解21个基本智能体模式背后的基础概念,还将拥有有效应用这些模式的实用知识和代码示例,使您能够在选择的开发画布上构建更智能、更有能力、更自主的系统。让我们开始这个实践之旅!

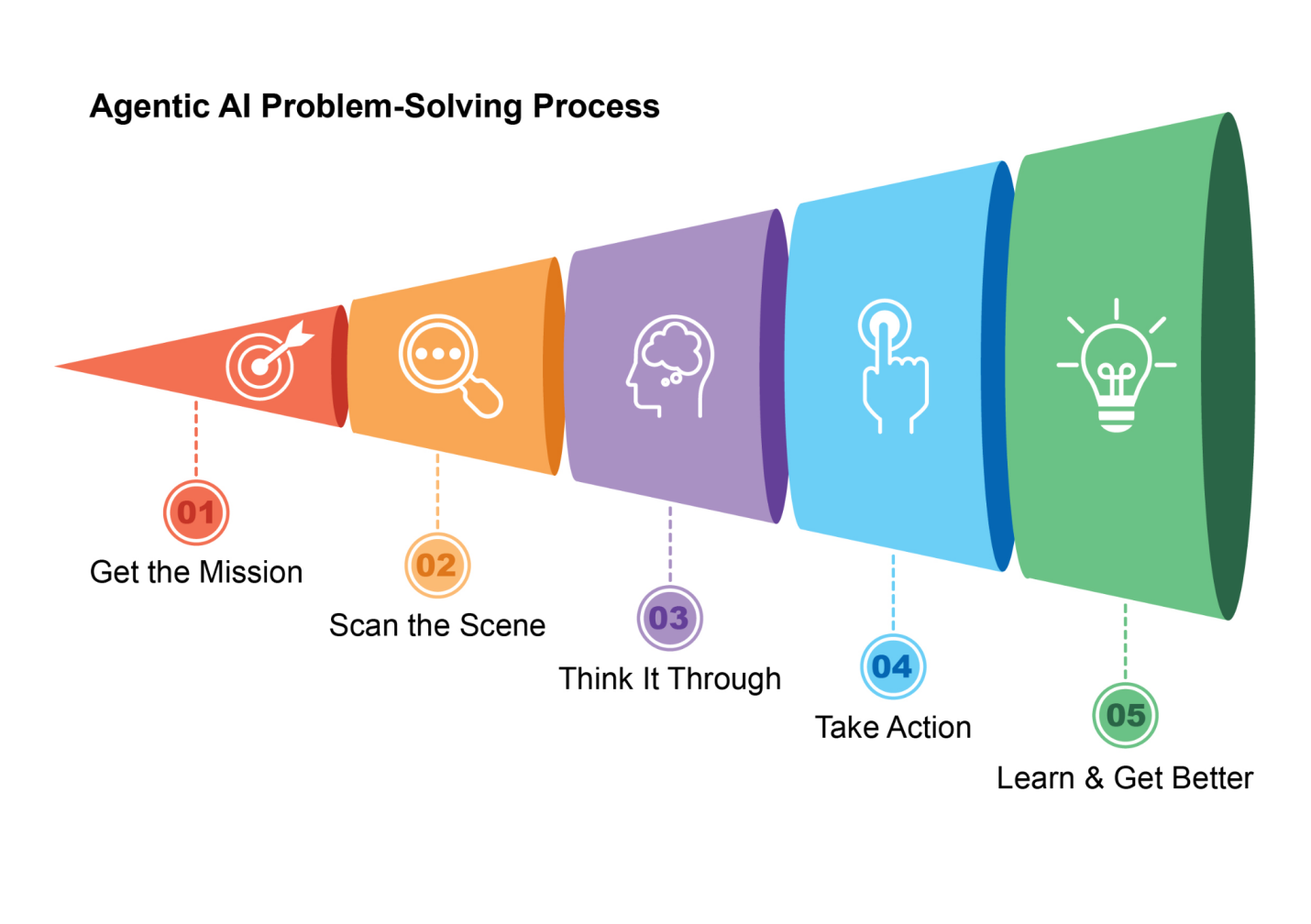

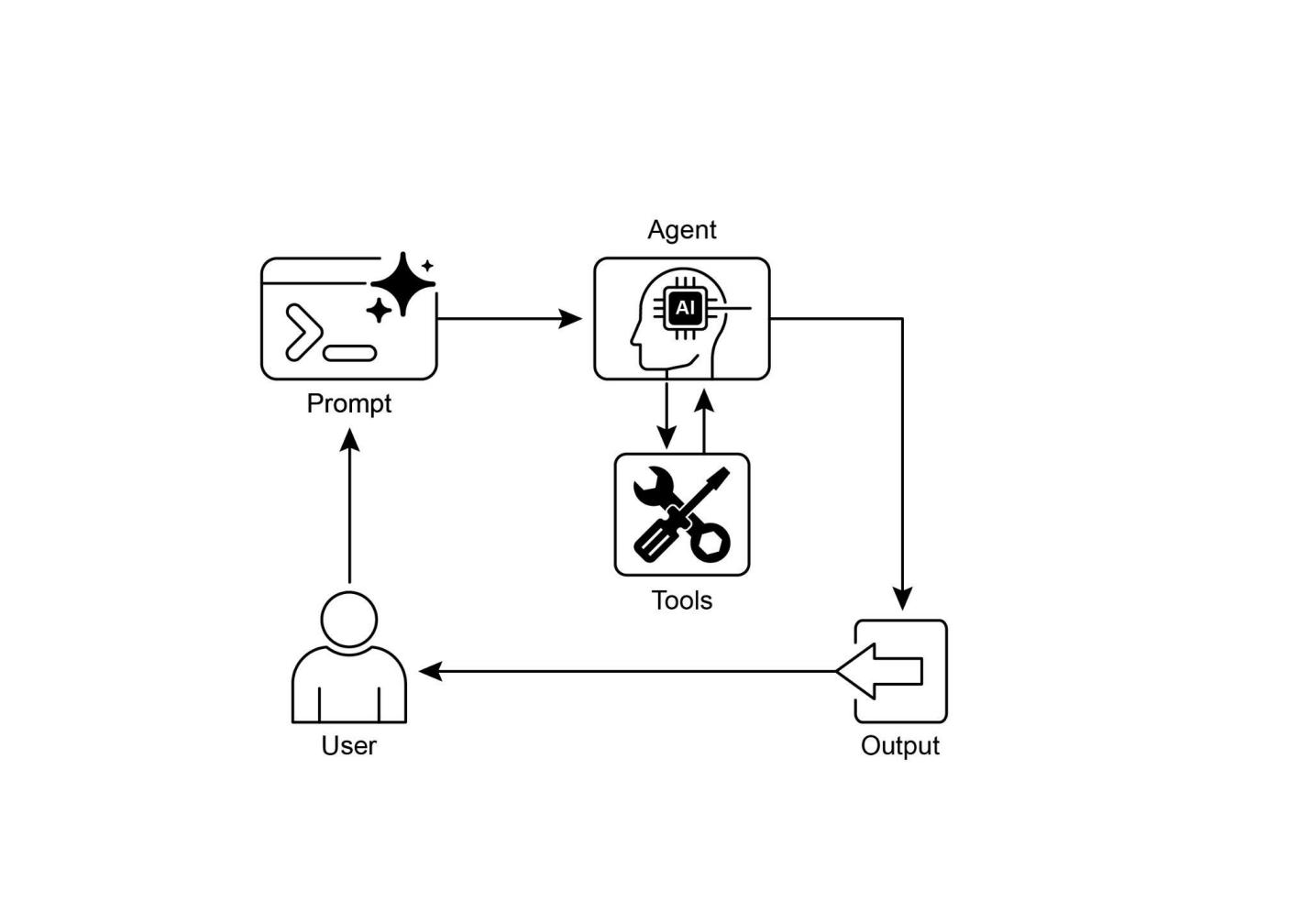

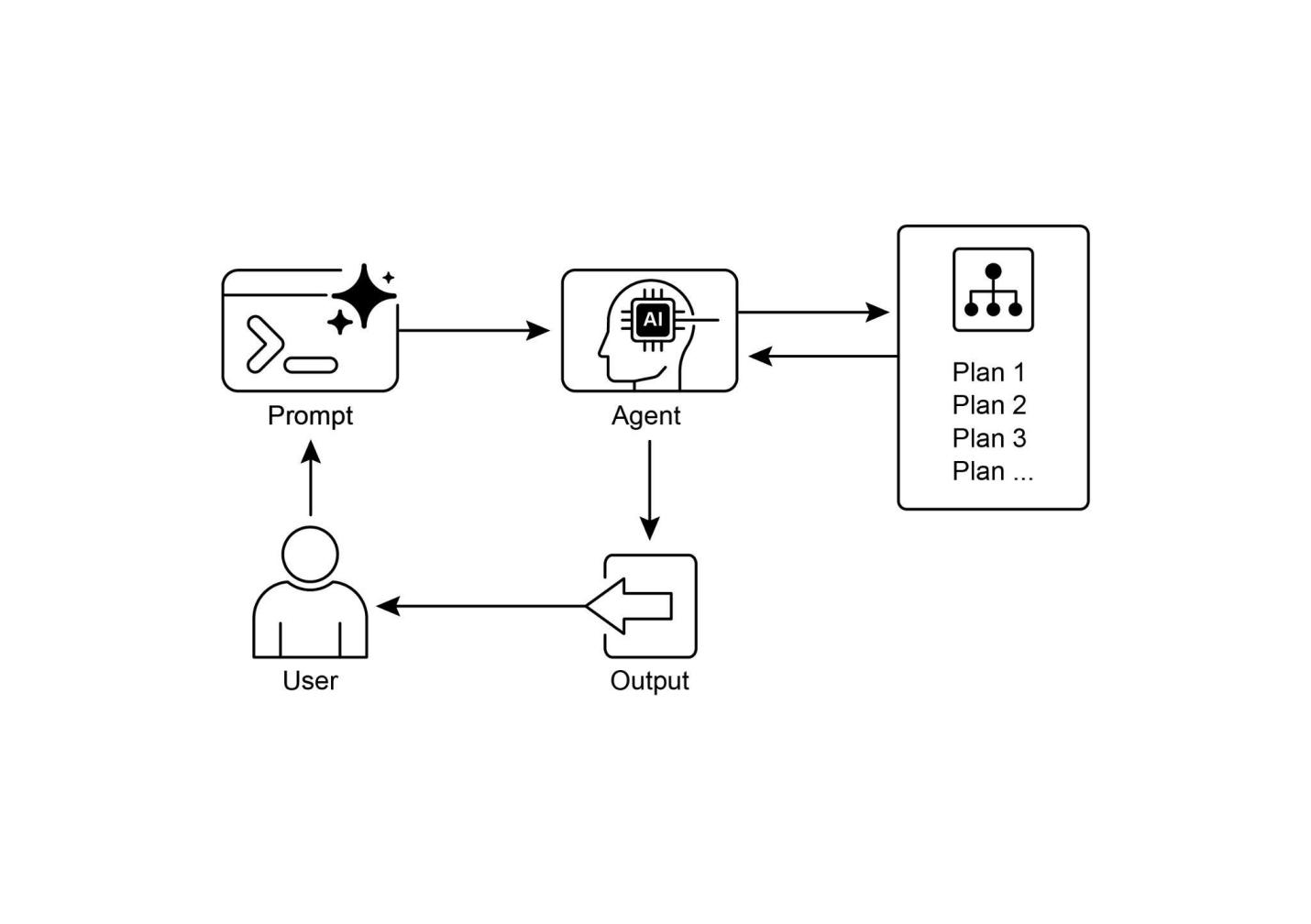

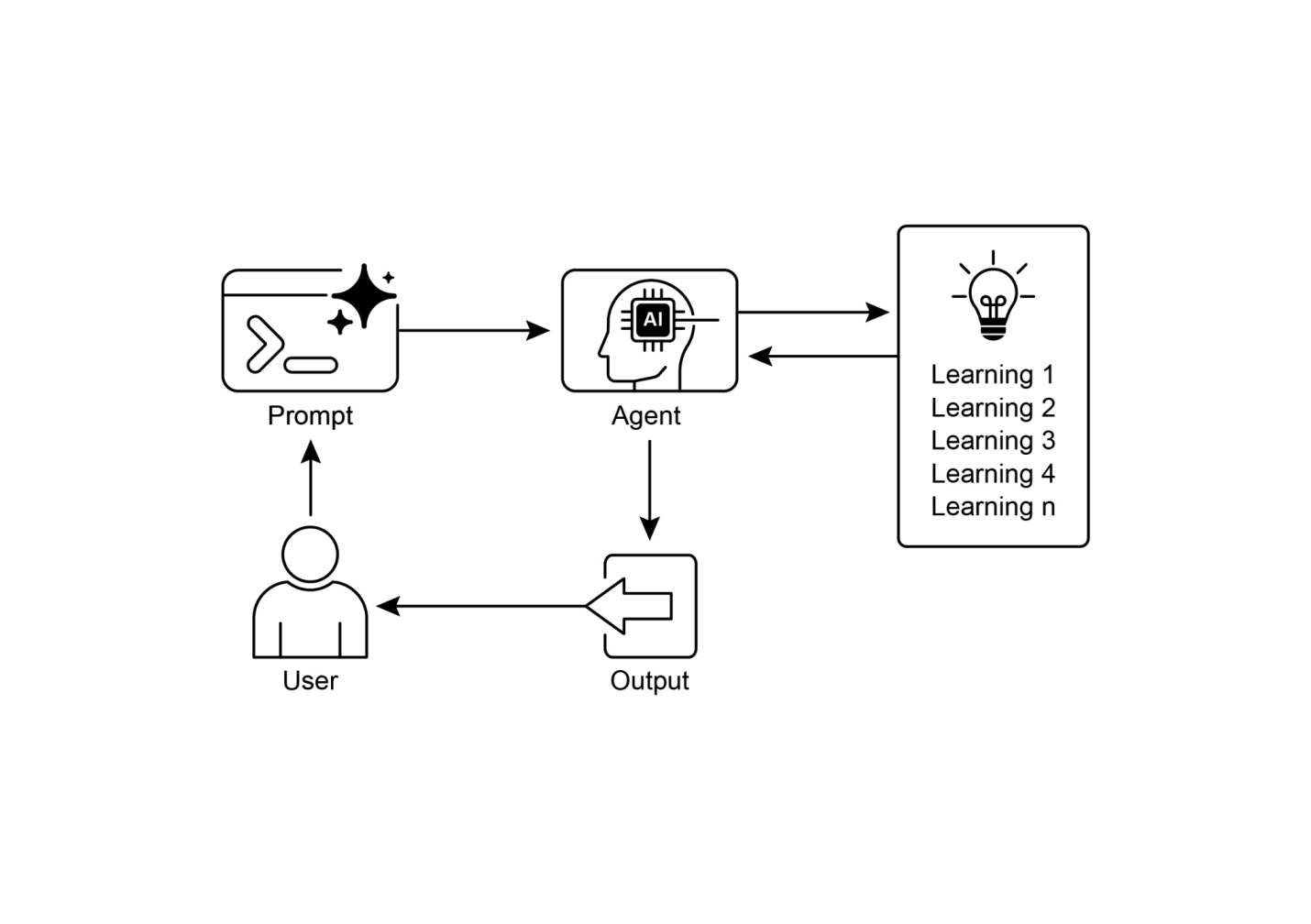

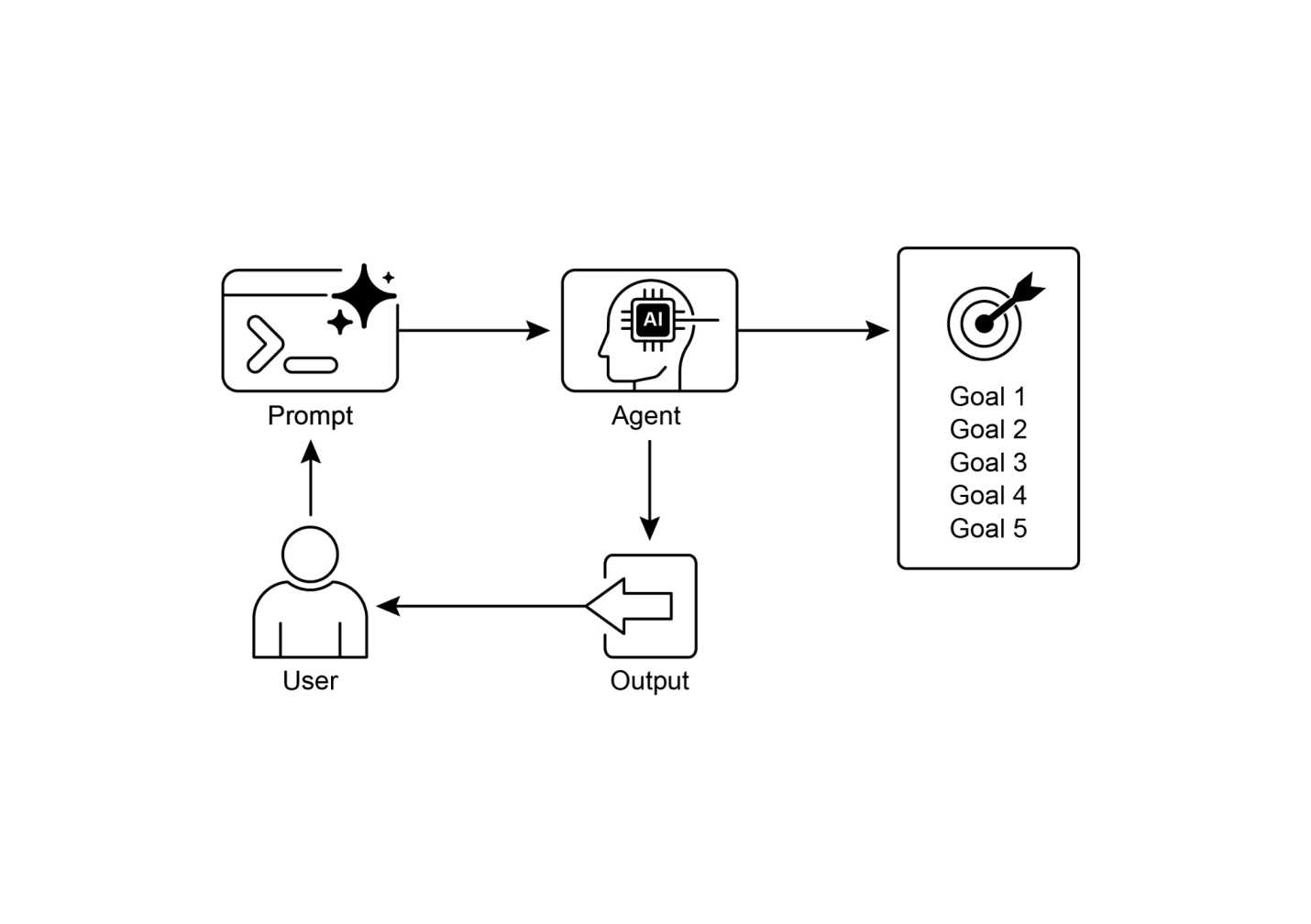

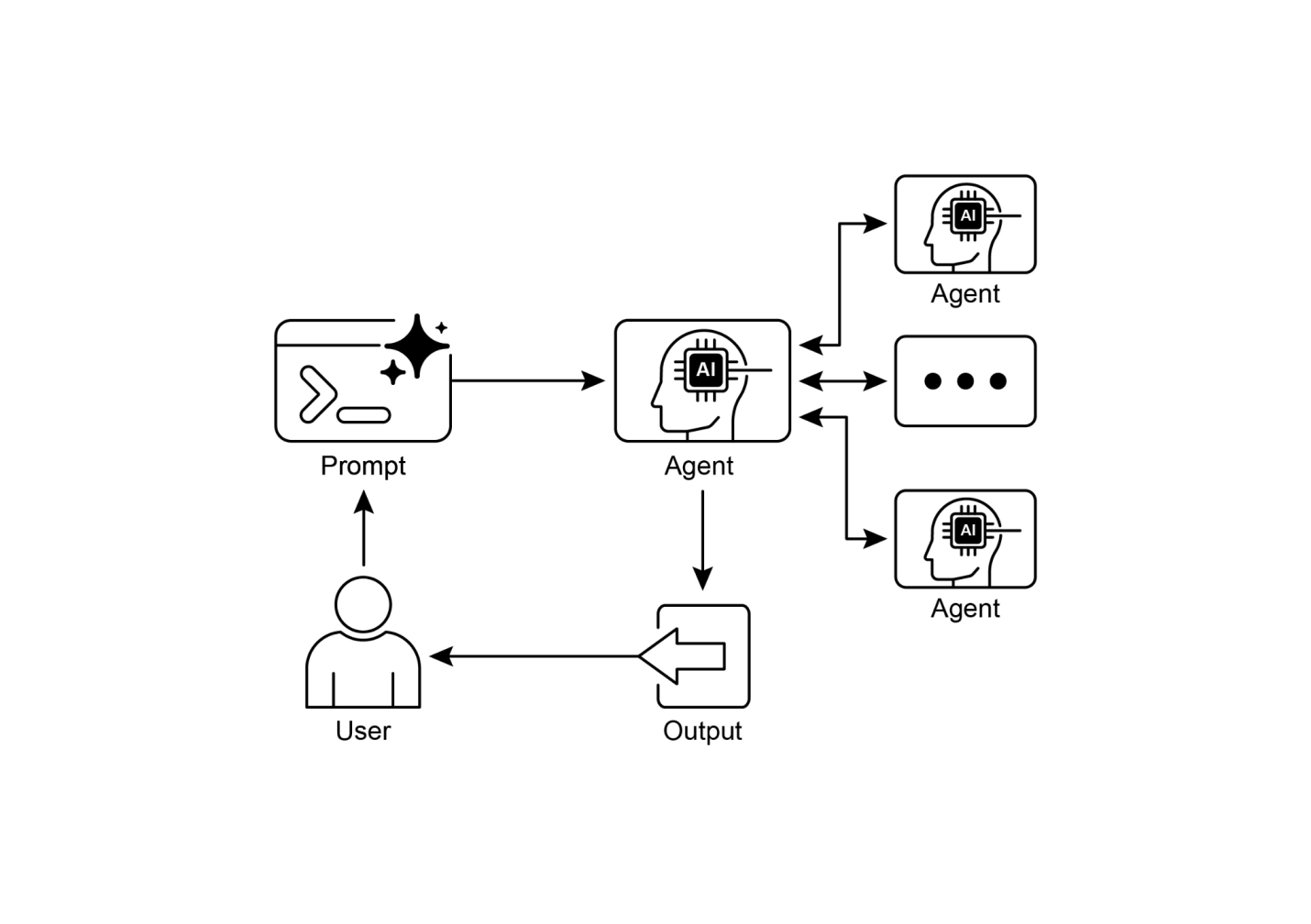

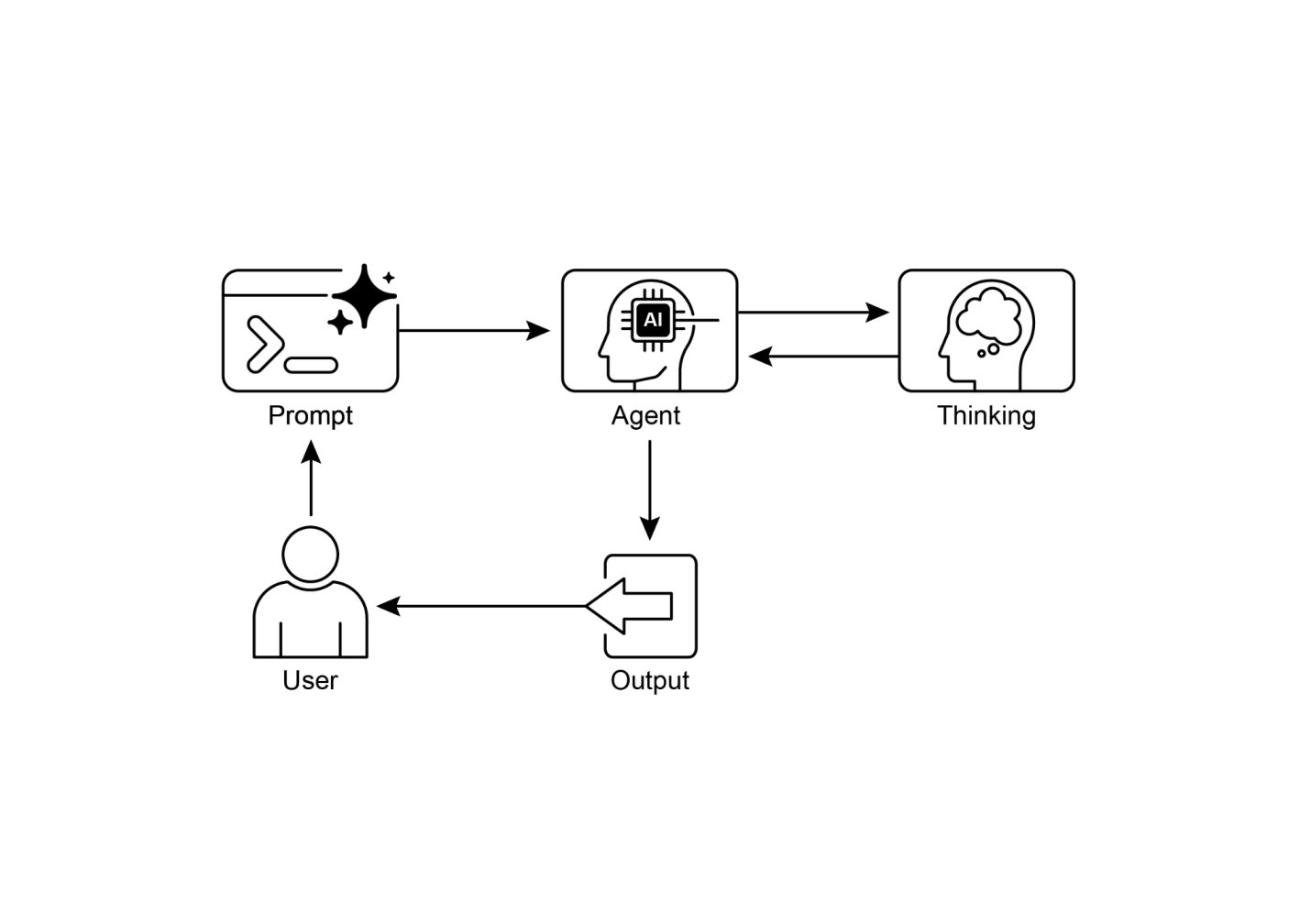

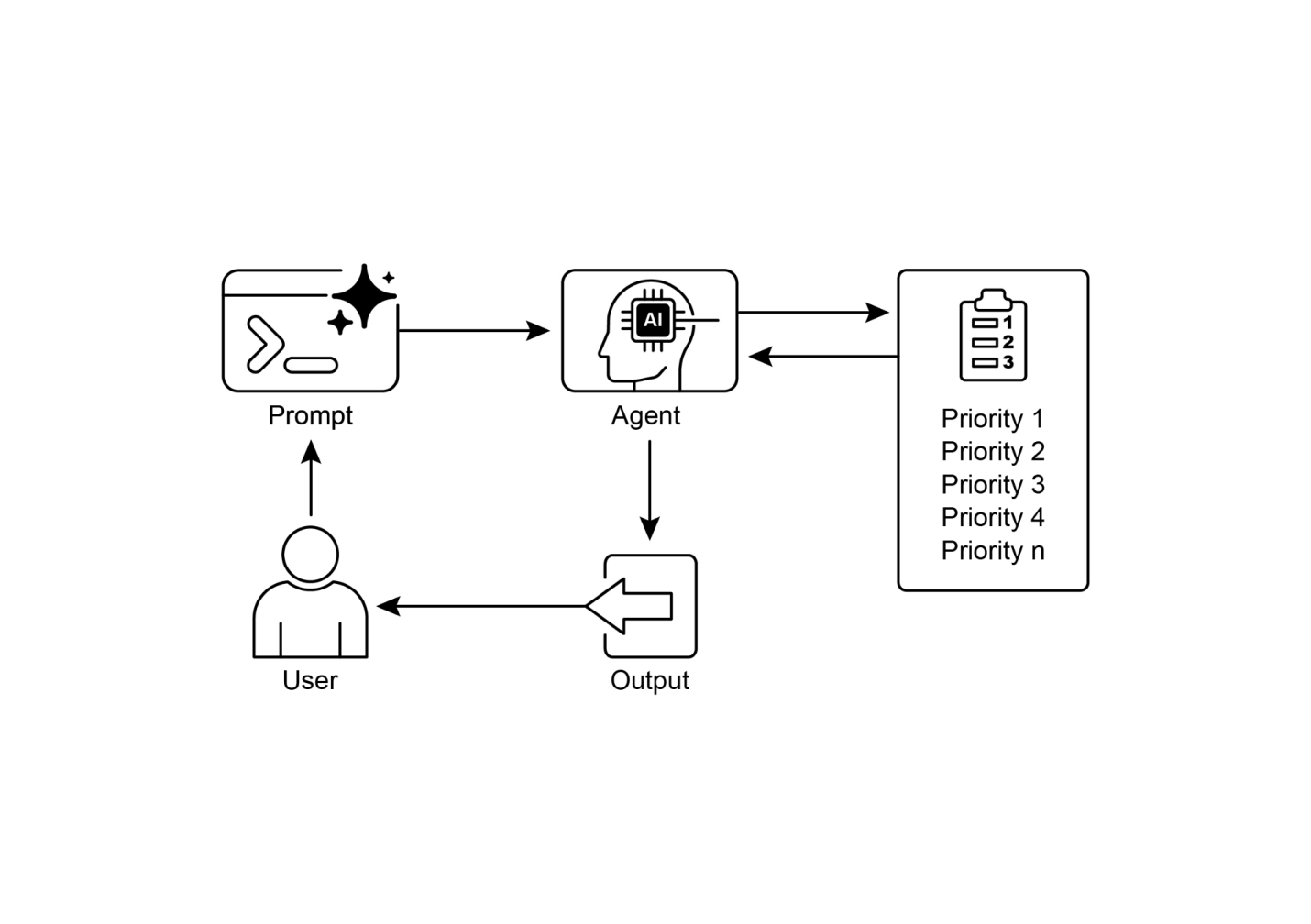

简单来说,AI智能体是一个被设计来感知其环境并采取行动以实现特定目标的系统。它是标准大型语言模型(LLM)的进化,增强了规划、使用工具和与环境交互的能力。将智能体AI看作是一个在工作中学习的智能助手。它遵循一个简单的五步循环来完成工作(见图1):

图1:智能体AI作为智能助手运行,通过经验持续学习。它通过简单的五步循环来完成任务。

智能体正在以惊人的速度变得越来越流行。根据最近的研究,大多数大型IT公司正在积极使用这些智能体,其中五分之一在过去一年内刚刚开始使用。金融市场也在关注。到2024年底,AI智能体初创公司已筹集超过20亿美元,市场估值为52亿美元。预计到2034年将爆发式增长至近2000亿美元的价值。简而言之,所有迹象都表明AI智能体将在我们未来的经济中发挥重要作用。

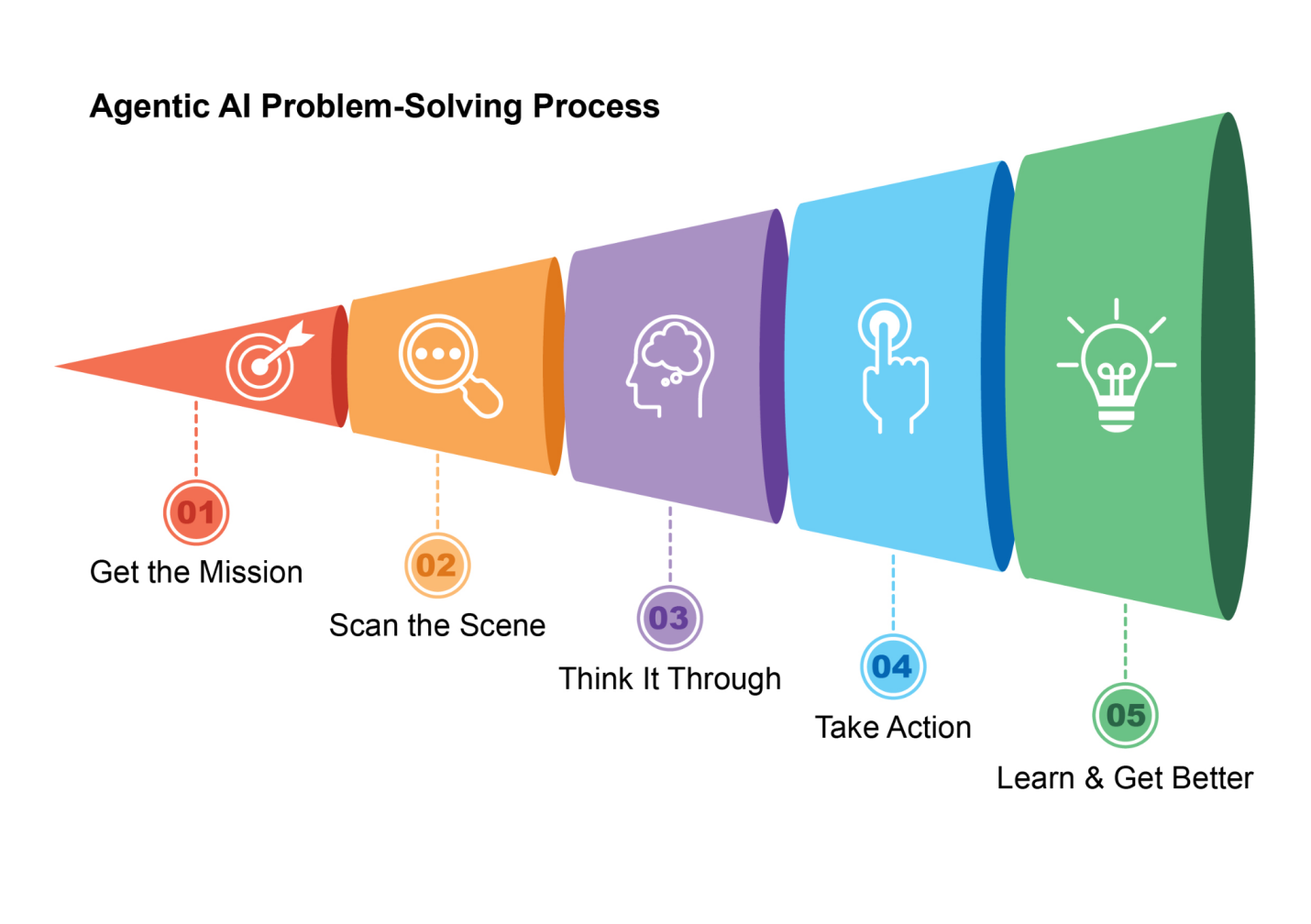

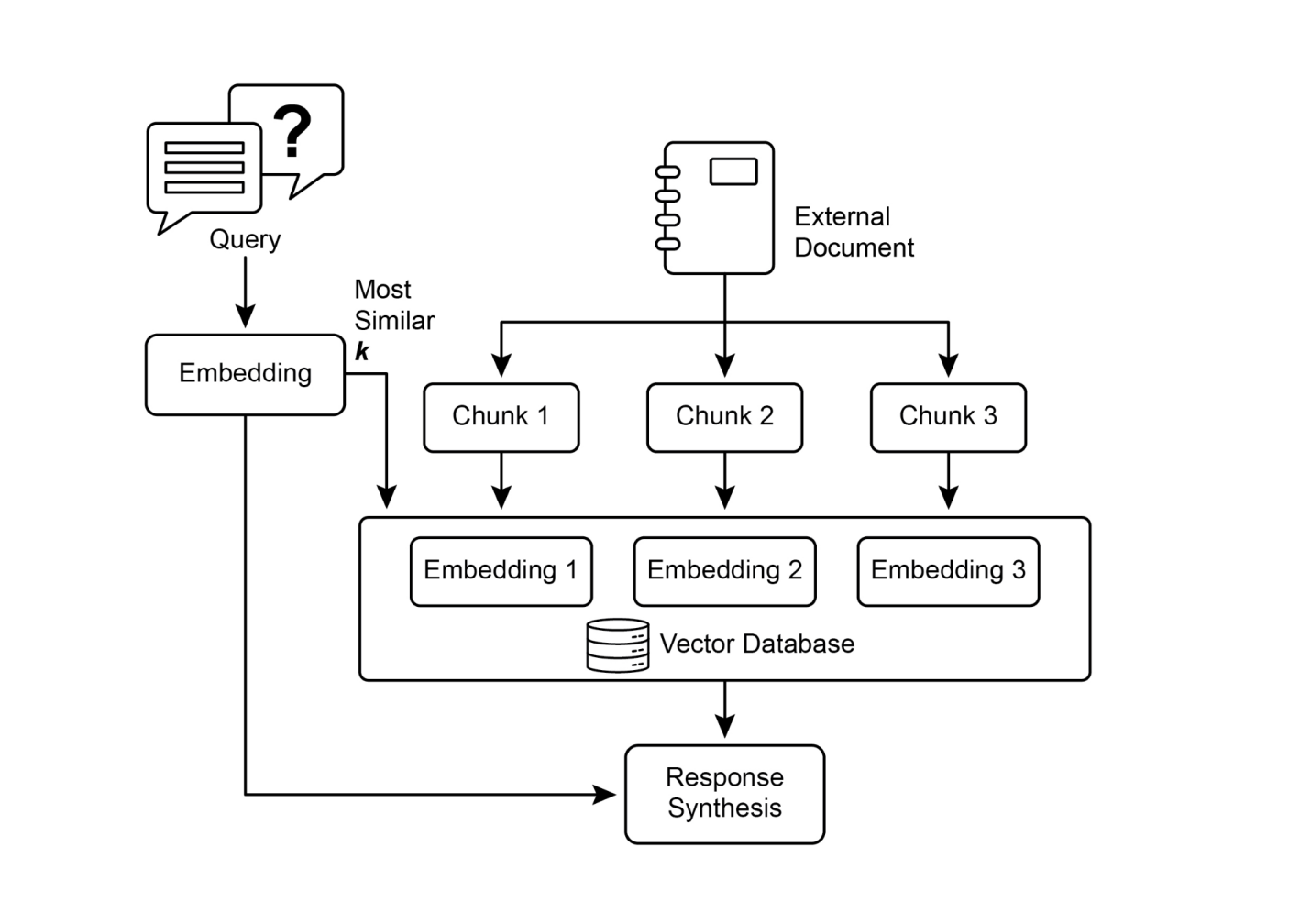

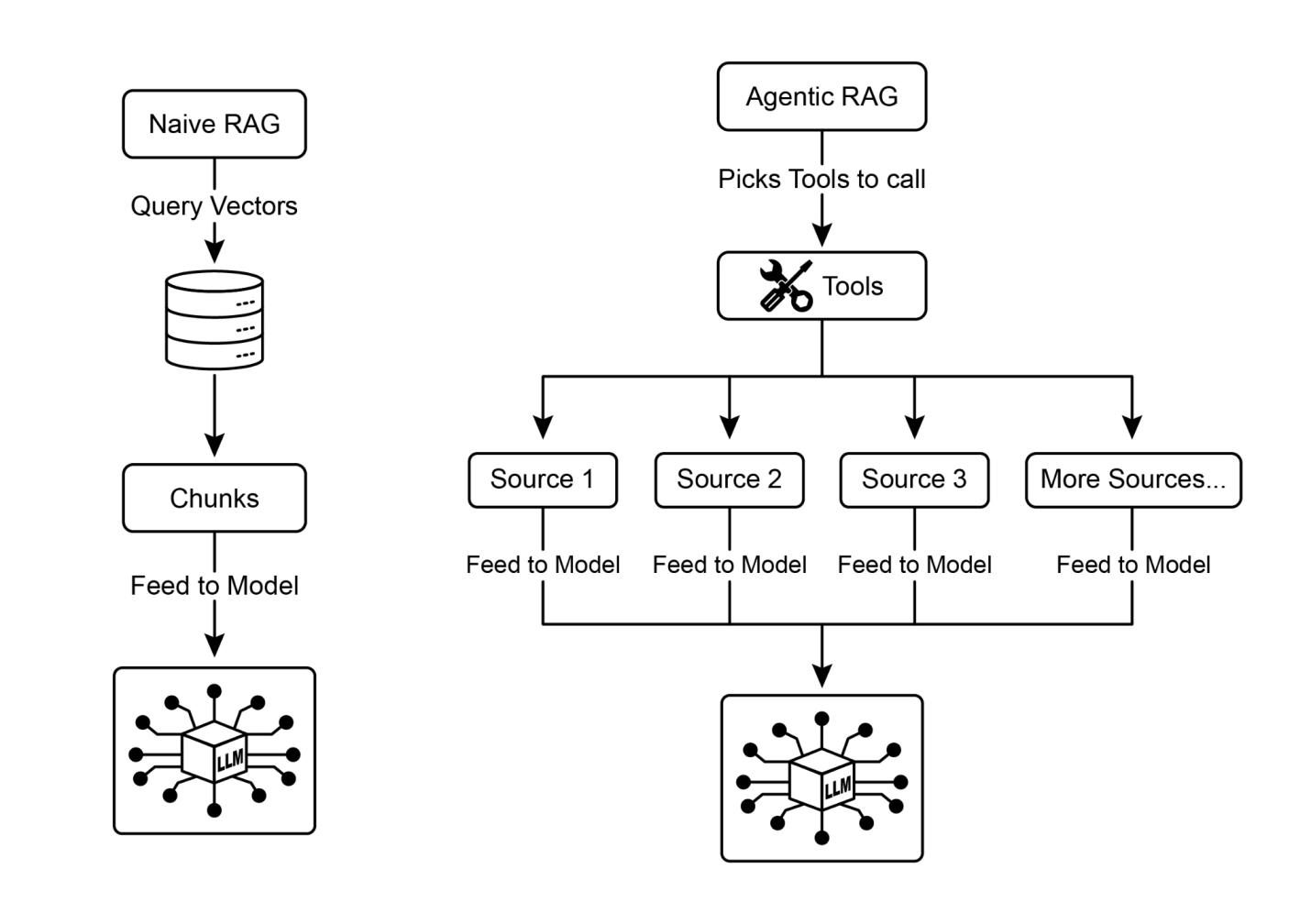

仅仅在两年内,AI范式发生了戏剧性的转变,从简单的自动化发展到复杂的自主系统(见图2)。最初,工作流依赖基本提示和触发器通过LLM处理数据。这通过检索增强生成(RAG)得到了发展,RAG通过在事实信息上建立基础增强了可靠性。然后我们看到了能够使用各种工具的单个AI智能体的发展。今天,我们正在进入智能体AI的时代,其中一个专门智能体团队协同工作以实现复杂目标,标志着AI协作能力的重大飞跃。

图2:从LLM到RAG,然后到智能体RAG,最后到智能体AI的转变。

本书的意图是讨论专门智能体如何协同工作和协作以实现复杂目标的设计模式,您将在每一章中看到一种协作和交互的范式。

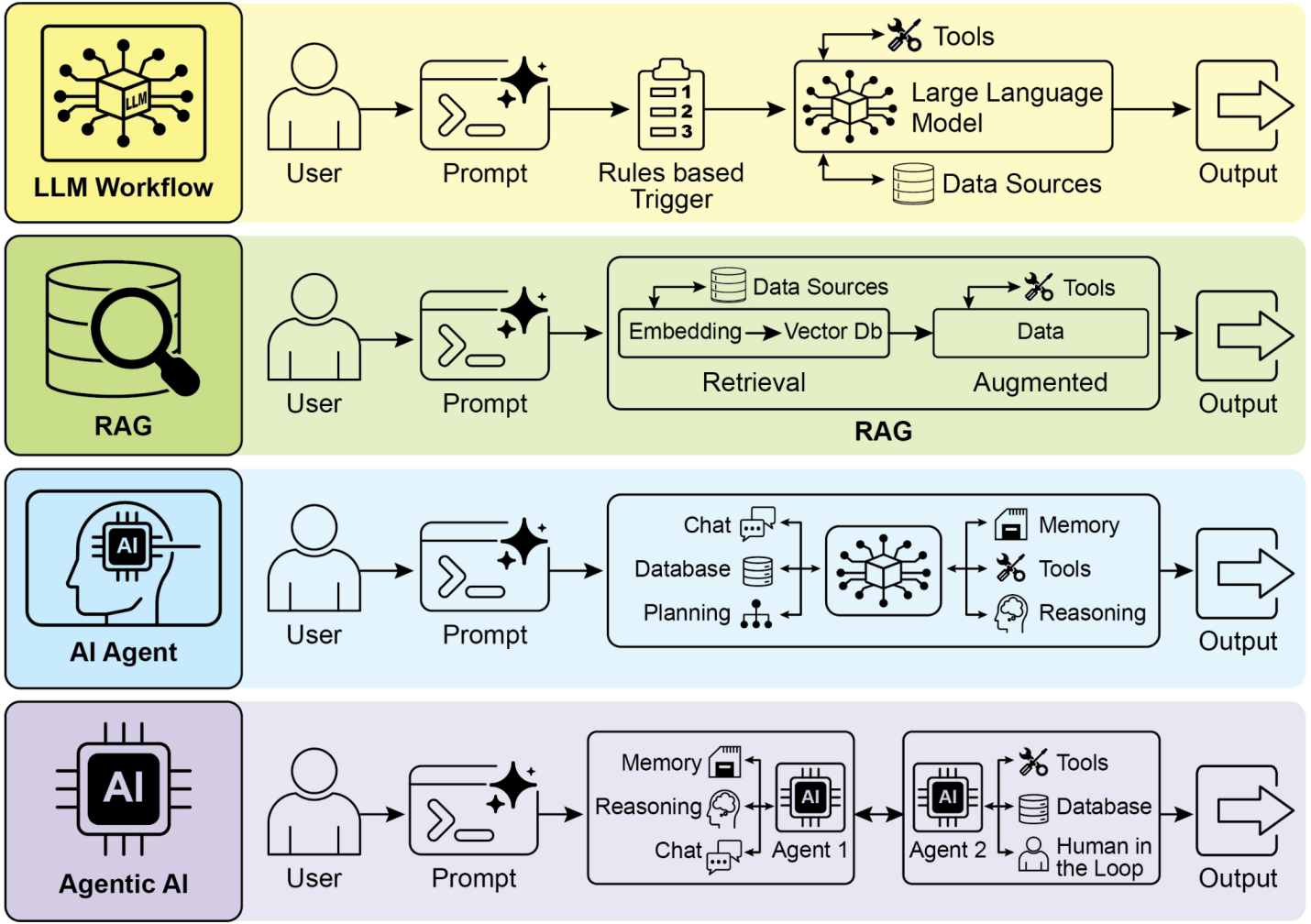

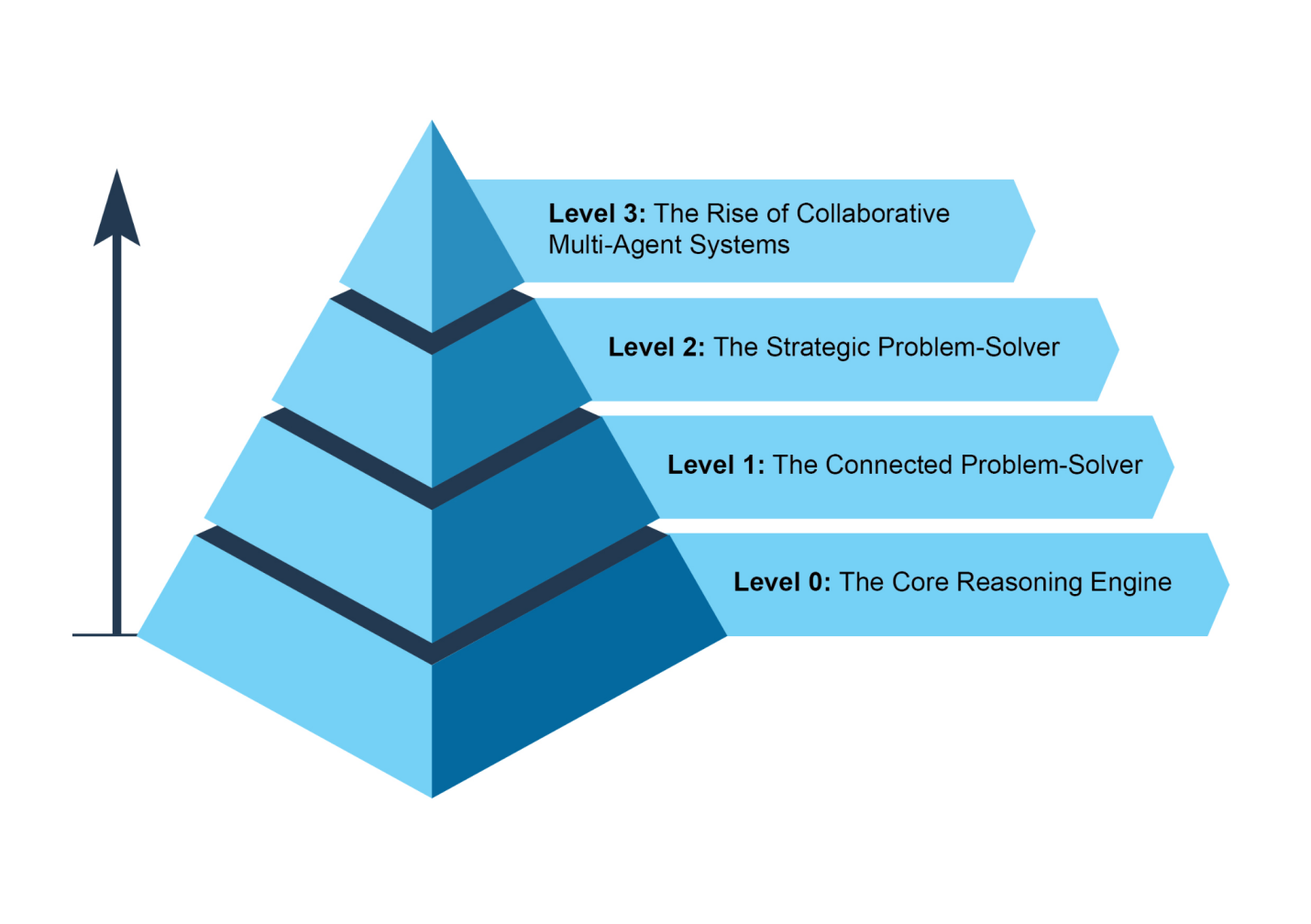

在此之前,让我们检查跨越智能体复杂性范围的示例(见图3)。

虽然LLM本身不是智能体,但它可以作为基本智能体系统的推理核心。在”级别0”配置中,LLM在没有工具、记忆或环境交互的情况下运行,仅基于其预训练知识进行响应。它的优势在于利用其广泛的训练数据来解释既定概念。这种强大内部推理的权衡是完全缺乏时事感知。例如,如果该信息超出其预训练知识范围,它将无法说出2025年奥斯卡”最佳影片”的获奖者。

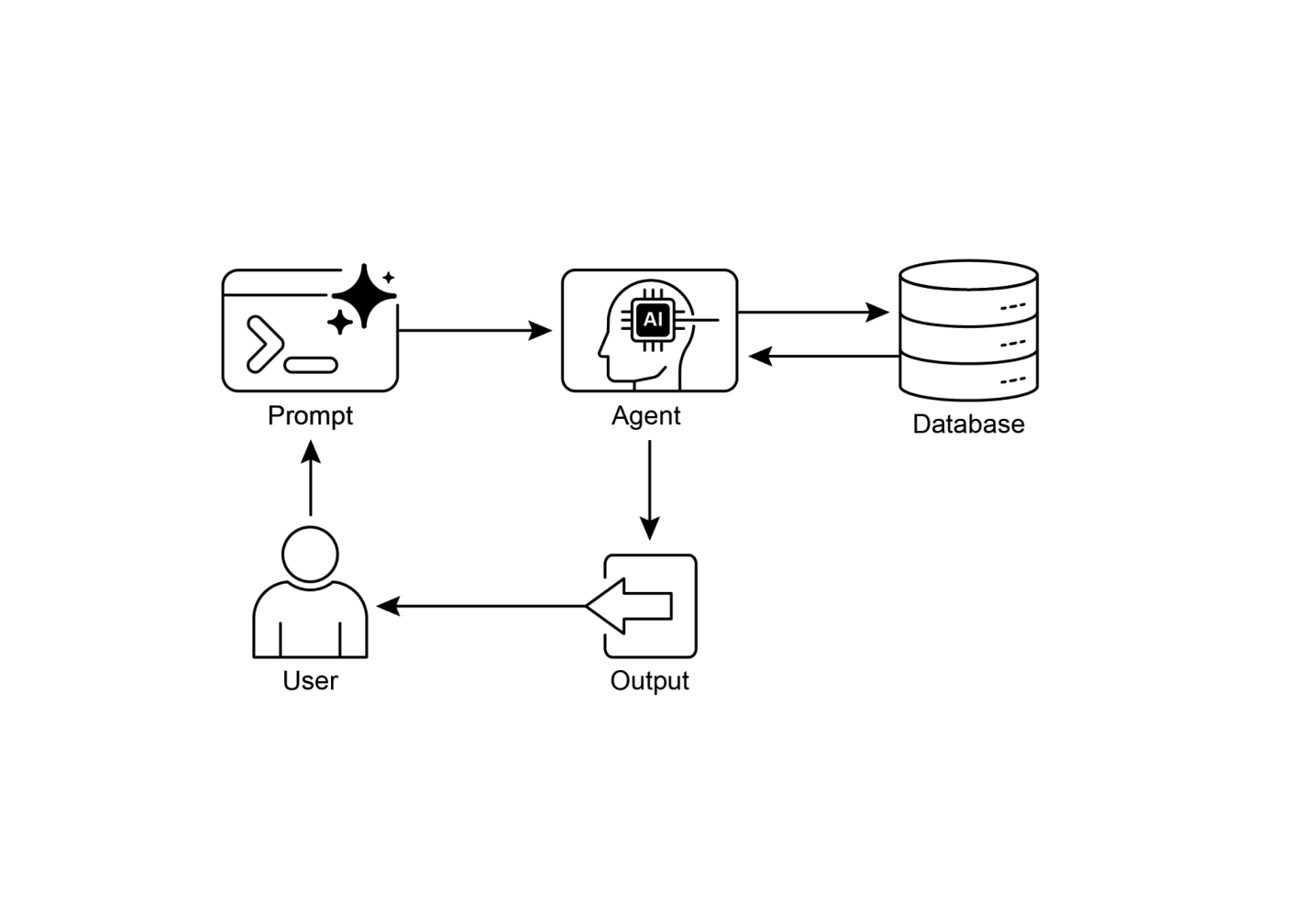

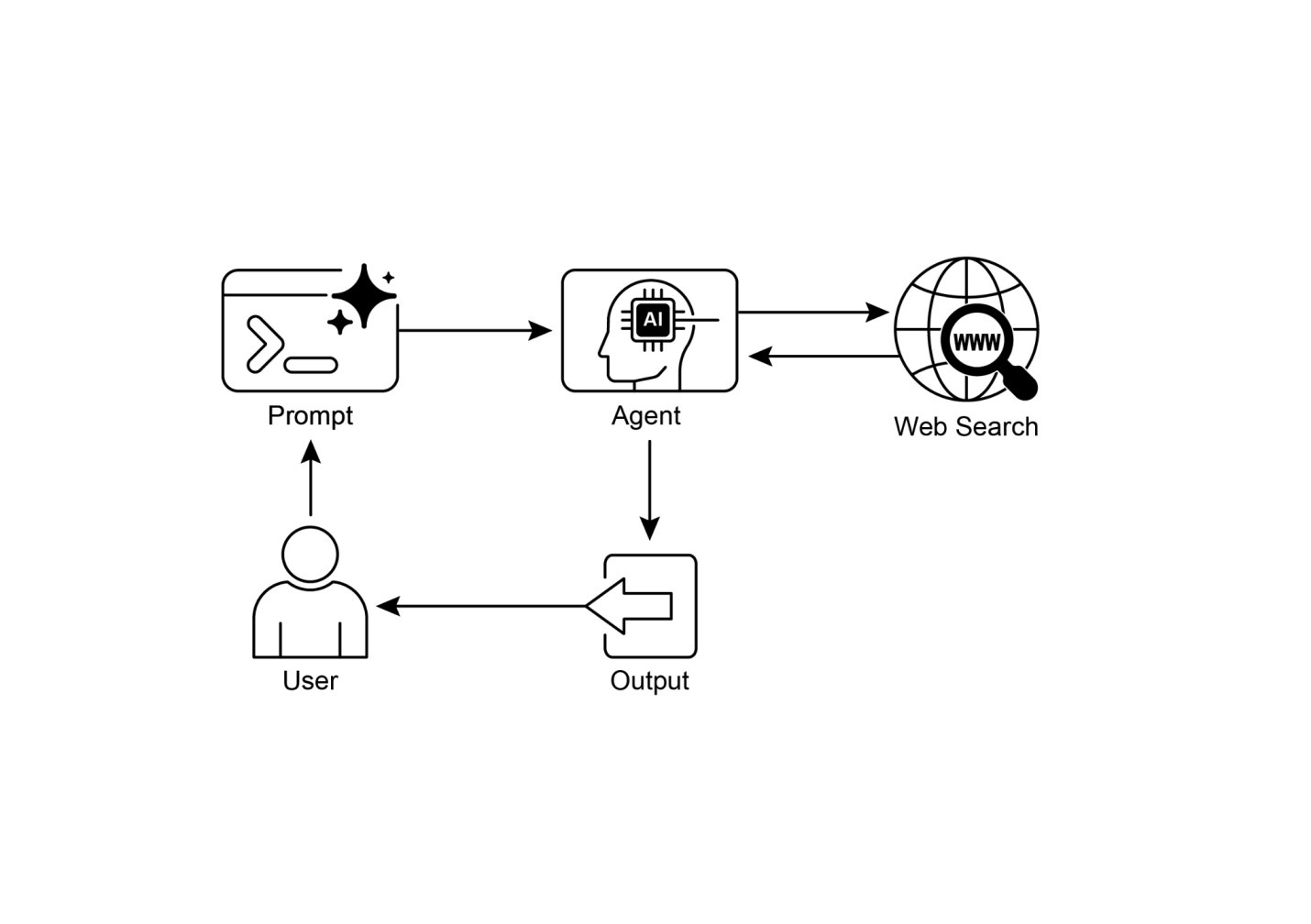

在这个级别,LLM通过连接和使用外部工具成为功能性智能体。它的问题解决不再局限于其预训练知识。相反,它可以执行一系列动作,从互联网(通过搜索)或数据库(通过检索增强生成或RAG)等来源收集和处理信息。详细信息请参考第14章。

例如,为了找到新的电视剧,智能体识别到需要当前信息,使用搜索工具找到信息,然后综合结果。关键的是,它还可以使用专门的工具来提高准确性,比如调用金融API获取AAPL的实时股价。这种在多个步骤中与外部世界交互的能力是1级智能体的核心能力。

在这个级别,智能体的能力显著扩展,包括战略规划、主动协助和自我改进,其中提示工程(prompt engineering)和上下文工程(context engineering)是核心使能技能。

首先,智能体超越单一工具使用,通过战略问题解决来处理复杂的多部分问题。在执行一系列操作时,它主动执行上下文工程:选择、打包和管理每个步骤最相关信息的战略过程。例如,为了在两个位置之间找到咖啡店,它首先使用地图工具。然后它对这个输出进行工程化,策划一个简短、聚焦的上下文——也许只是一个街道名称列表——输入到本地搜索工具中,防止认知过载并确保第二步高效准确。为了从AI获得最大准确性,必须给它一个简短、聚焦和强大的上下文。上下文工程是通过战略性地选择、打包和管理所有可用来源中最关键信息来实现这一目标的学科。它有效地管理模型的有限注意力,防止过载并确保在任何给定任务上的高质量、高效性能。详细信息请参考附录A。

这个级别导致主动和持续操作。连接到您邮箱的旅行助手通过从冗长的航班确认邮件中工程化上下文来展示这一点;它只选择关键细节(航班号、日期、位置)来打包,用于后续调用您的日历和天气API的工具。

在软件工程等专业领域,智能体通过应用这门学科来管理整个工作流程。当分配到错误报告时,它读取报告并访问代码库,然后战略性地将这些大量信息源工程化为一个有力、聚焦的上下文,使其能够高效地编写、测试并提交正确的代码补丁。

最后,智能体通过完善自己的上下文工程过程实现自我改进。当它询问如何改进提示的反馈时,它正在学习如何更好地管理其初始输入。这使它能够自动改进如何为未来任务打包信息,创建一个强大的自动化反馈循环,随着时间的推移提高其准确性和效率。详细信息请参考第17章。

图3:展示智能体复杂性范围的各种实例。

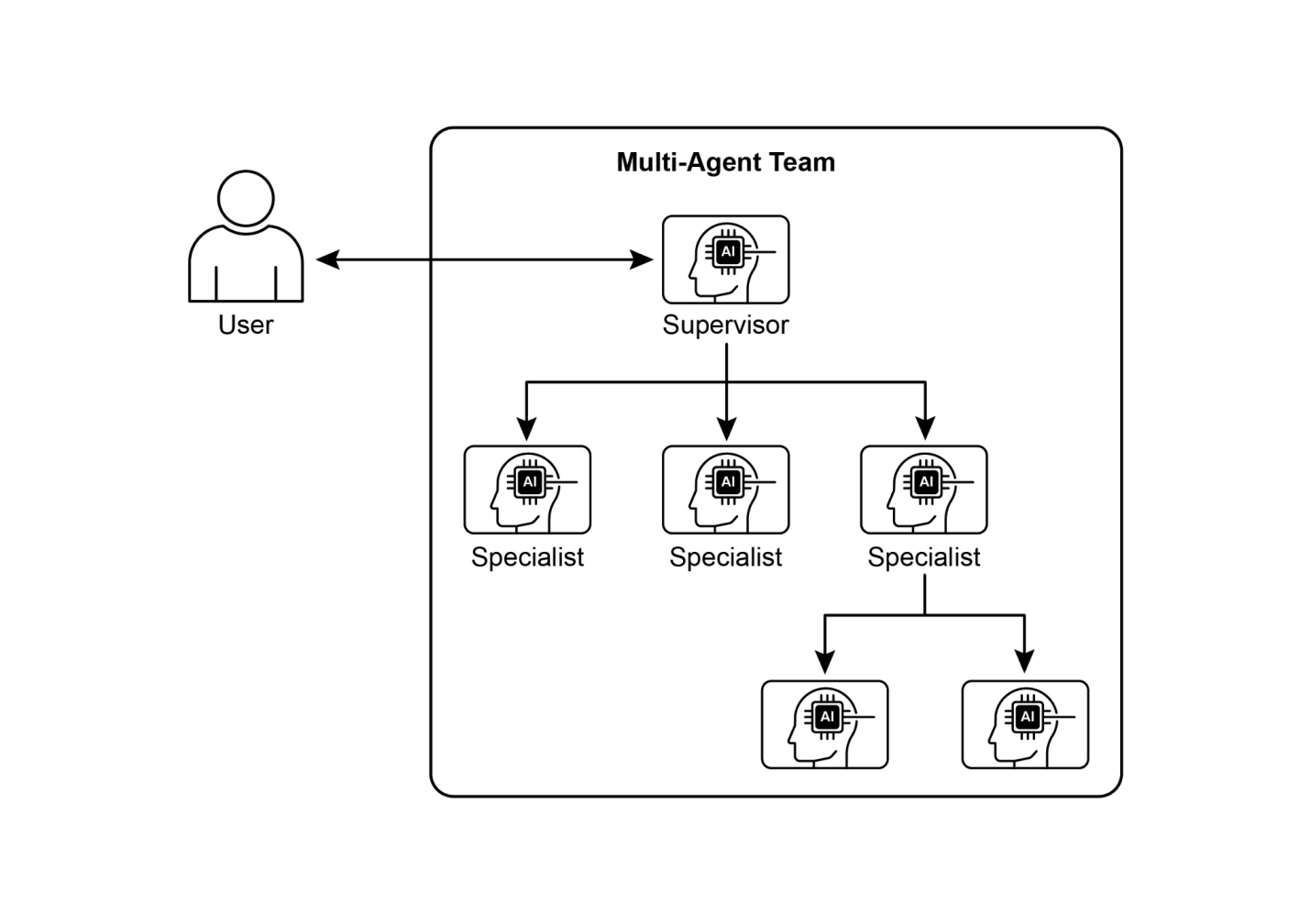

在3级,我们看到AI开发中的重大范式转变,从追求单一的全能超级智能体转向复杂的协作多智能体系统的兴起。本质上,这种方法认识到复杂挑战往往最好不是由单一的通才来解决,而是由协同工作的专家团队来解决。这种模式直接反映了人类组织的结构,其中不同部门被分配特定角色并协作处理多方面的目标。这种系统的集体力量在于这种分工和通过协调努力创造的协同作用。详细信息请参考第7章。

为了使这个概念生动化,考虑推出新产品的复杂工作流程。与其让一个智能体尝试处理每个方面,一个”项目经理”智能体可以作为中央协调者。这个经理将通过委托任务给其他专门的智能体来协调整个过程:一个”市场研究”智能体收集消费者数据,一个”产品设计”智能体开发概念,一个”营销”智能体制作促销材料。它们成功的关键将是它们之间的无缝沟通和信息共享,确保所有个体努力都与实现集体目标保持一致。

虽然这种自主的、基于团队的自动化愿景已经在开发中,但重要的是要承认当前的障碍。这种多智能体系统的有效性目前受到它们所使用的大语言模型(LLM)推理限制的约束。此外,它们真正相互学习并作为一个有凝聚力的单元改进的能力仍处于早期阶段。克服这些技术瓶颈是关键的下一步,这样做将释放这个级别的深远前景:从开始到结束自动化整个业务工作流程的能力。

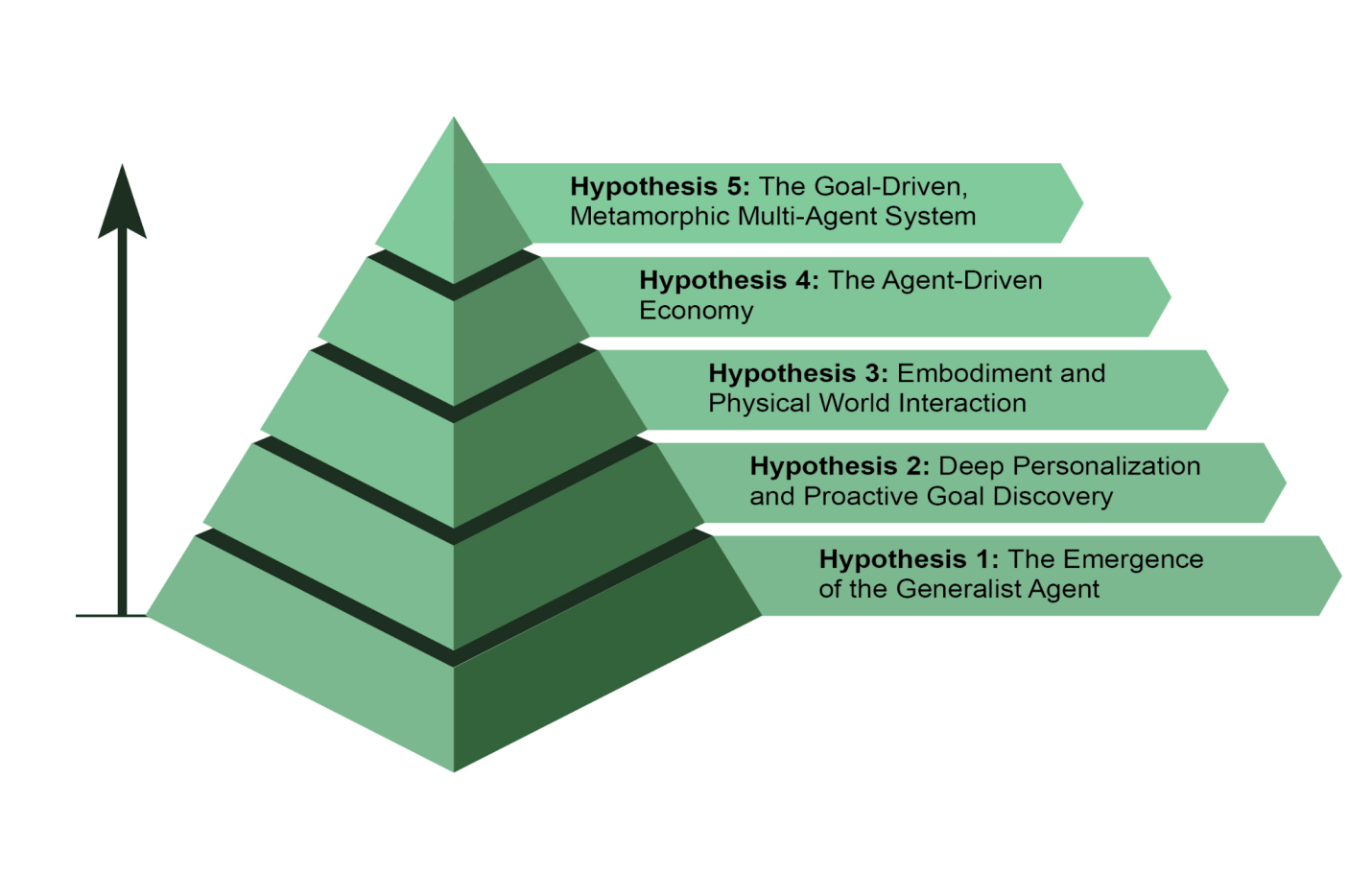

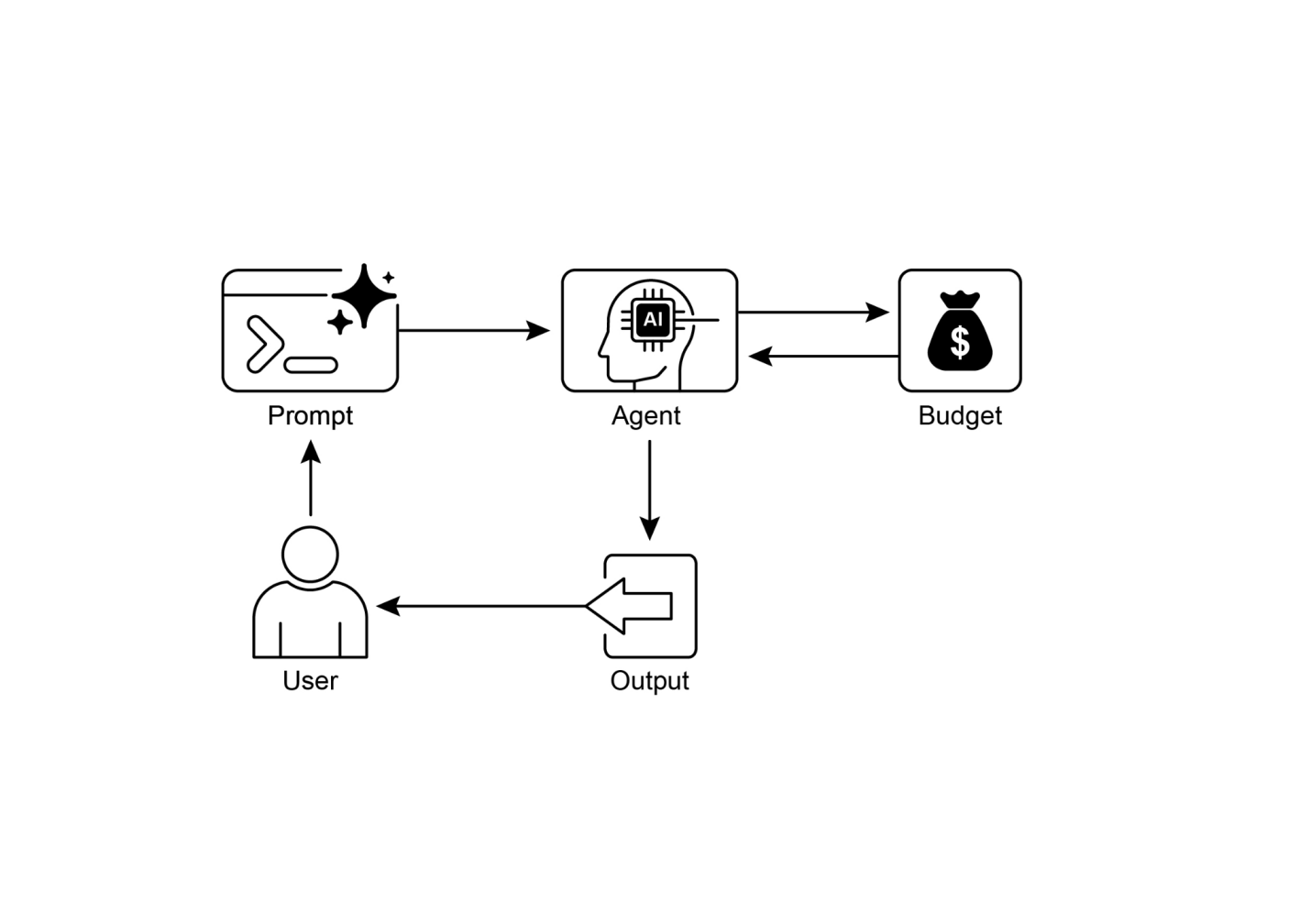

AI智能体开发正在软件自动化、科学研究和客户服务等领域以前所未有的速度发展。虽然当前系统令人印象深刻,但它们只是开始。下一波创新可能会专注于使智能体更可靠、更协作、更深度地融入我们的生活。以下是对下一步发展的五个主要假设(见图4)。

第一个假设是,AI智能体(agents)将从狭窄的专家发展为真正的通才,能够以高可靠性管理复杂、模糊和长期的目标。例如,你可以给智能体一个简单的提示:“为我公司下个季度在里斯本为30人规划异地团建活动。”智能体随后将管理整个项目数周,处理从预算审批和航班谈判到场地选择和根据员工反馈制定详细行程等所有事务,同时提供定期更新。实现这种自主水平将需要在AI推理、记忆和近乎完美的可靠性方面取得根本性突破。另一种不互相排斥的方法是小语言模型(SLMs)的兴起。这种”乐高式”概念涉及从小型专业专家智能体组合系统,而不是扩展单一的整体模型。这种方法承诺系统更便宜、调试更快、部署更容易。最终,大型通用模型的发展和小型专业模型的组合都是可行的前进路径,它们甚至可以相互补充。

第二个假设认为智能体将成为深度个性化和主动的合作伙伴。我们正在见证一类新智能体的出现:主动合作伙伴。通过学习你独特的模式和目标,这些系统开始从仅仅遵循命令转向预测你的需求。AI系统在超越简单回应聊天或指令时作为智能体运行。它们代表用户发起和执行任务,在过程中积极协作。这超越了简单的任务执行,进入了主动目标发现的领域。

例如,如果你正在探索可持续能源,智能体可能会识别你的潜在目标并主动支持,建议课程或总结研究。虽然这些系统仍在发展中,但它们的轨迹是明确的。它们将变得越来越主动,学会在高度确信行动会有帮助时代表你采取主动。最终,智能体成为不可或缺的盟友,帮助你发现和实现尚未完全阐述的抱负。

图4:关于智能体未来的五个假设

这个假设预见智能体将突破纯数字限制,在物理世界中运行。通过将智能体AI与机器人技术集成,我们将看到”具身智能体”的兴起。你可能不是预订水管工,而是要求你的家庭智能体修理漏水的水龙头。智能体将使用其视觉传感器感知问题,访问管道知识库制定计划,然后精确控制其机器人操作器执行维修。这将代表一个巨大的步骤,在数字智能和物理行动之间架起桥梁,改变从制造业和物流到老年护理和家庭维护的一切。

第四个假设是高度自主的智能体将成为经济中的积极参与者,创造新的市场和商业模式。我们可能看到智能体作为独立的经济实体,被赋予最大化特定结果(如利润)的任务。企业家可以启动智能体来运营整个电子商务业务。智能体将通过分析社交媒体识别趋势产品,生成营销文案和视觉效果,通过与其他自动化系统交互管理供应链物流,并根据实时需求动态调整定价。这种转变将创造一个新的、超高效的”智能体经济”,以人类无法直接管理的速度和规模运行。

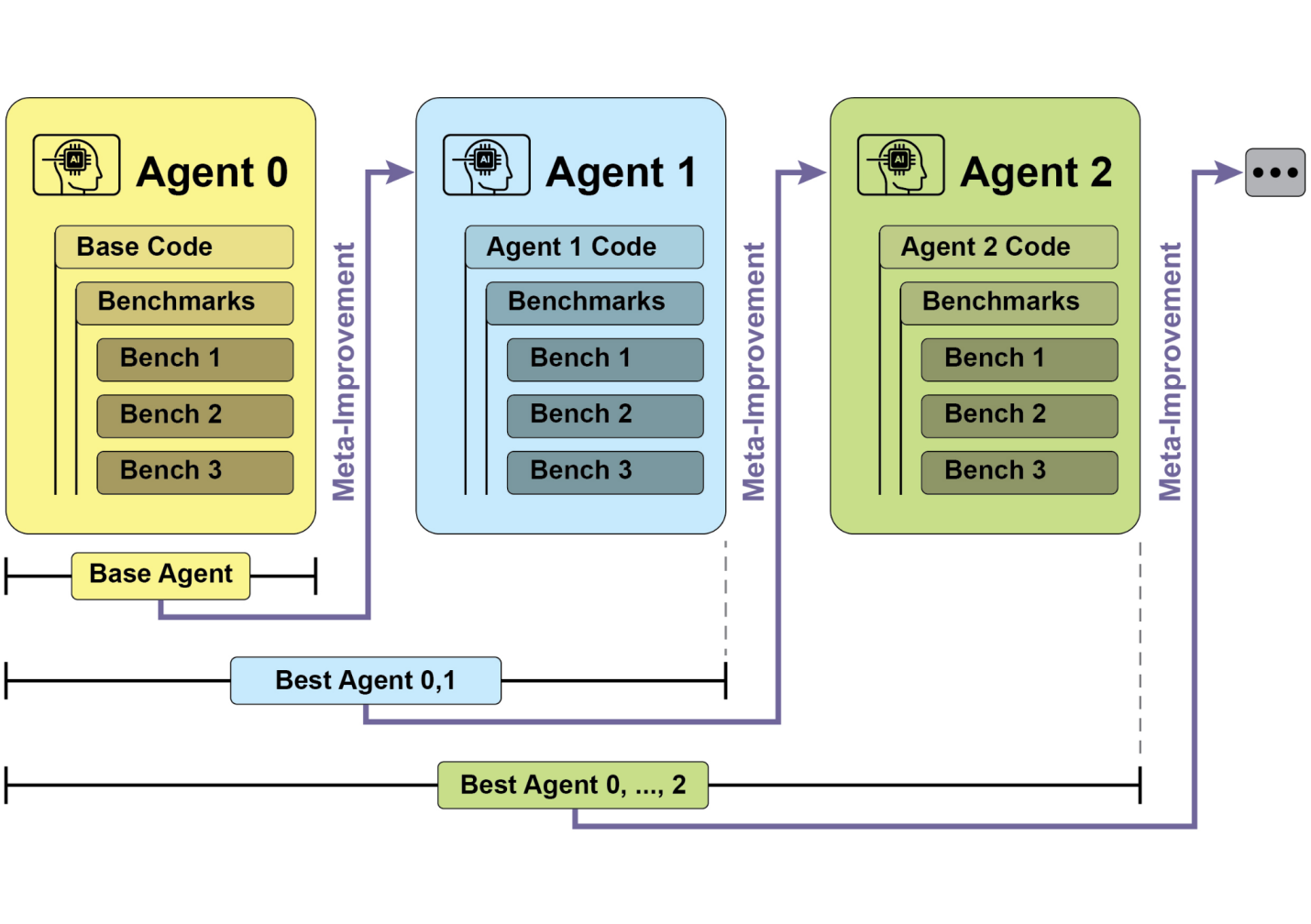

这个假设提出了智能系统的出现,这些系统不是从显式编程运行,而是从声明的目标运行。用户只需说明期望的结果,系统就会自主找出如何实现它。这标志着向具有真正自我改进能力的变形多智能体系统的根本转变,无论是在个体还是集体层面。

这个系统将是一个动态实体,而不是单一智能体。它将具有分析自身性能和修改其多智能体工作队伍拓扑结构的能力,根据需要创建、复制或移除智能体,以形成最有效的团队来完成手头的任务。这种演化发生在多个层面:

● 架构修改:在最深层,个体智能体可以重写自己的源代码并重新构建其内部结构以提高效率,如原始假设所述。

● 指令修改:在更高层面,系统持续执行自动提示工程和上下文工程。它完善给每个智能体的指令和信息,确保它们在没有任何人工干预的情况下以最佳指导运行。

例如,一位企业家只需简单地宣布意图:“启动一个成功的电子商务业务,销售手工精品咖啡。” 系统无需进一步编程即可立即行动。它可能最初生成一个”市场研究”代理和一个”品牌”代理。基于初步发现,它可能决定移除品牌代理并生成三个新的专门化代理:一个”Logo设计”代理、一个”网店平台”代理和一个”供应链”代理。它会不断调整它们的内部提示以提升性能。如果网店代理成为瓶颈,系统可能将其复制为三个并行代理来处理网站的不同部分,有效地实时重新构建其自身结构以最好地实现声明的目标。

本质上,AI代理(AI agent)代表着从传统模型的重大飞跃,作为一个自主系统运作,能够感知、规划并行动以实现特定目标。这项技术的演进正在从单一的、使用工具的代理发展为处理多方面目标的复杂协作多代理系统。未来假说预测将出现通用的、个性化的,甚至物理体现的代理,它们将成为经济中的积极参与者。这种持续发展标志着向自我改进、目标驱动系统的重大范式转变,这些系统准备自动化整个工作流程,并从根本上重新定义我们与技术的关系。

第一章:提示链接

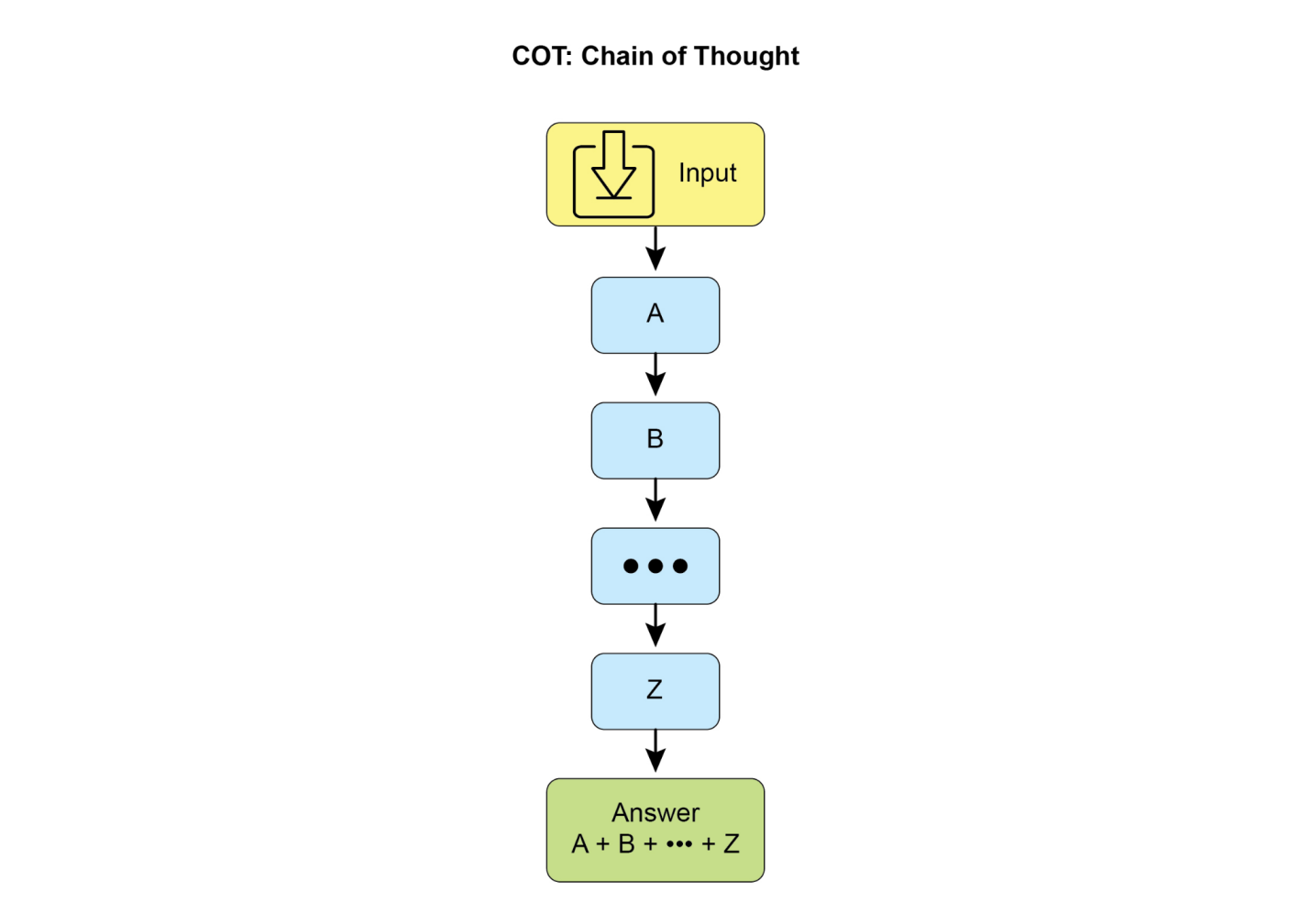

提示链接(Prompt chaining),有时称为流水线模式(Pipeline pattern),代表了在利用大型语言模型(LLMs)处理复杂任务时的一个强大范式。提示链接提倡采用分而治之的策略,而不是期望LLM在一个单一的、整体的步骤中解决复杂问题。核心思想是将原始的、令人生畏的问题分解为一系列更小的、更易管理的子问题。每个子问题通过专门设计的提示单独处理,一个提示生成的输出被策略性地作为输入传递给链中的下一个提示。

这种顺序处理技术内在地为与LLMs的交互引入了模块化和清晰性。通过分解复杂任务,每个单独步骤变得更容易理解和调试,使整个过程更加稳健和可解释。链中的每个步骤都可以被精心制作和优化,专注于较大问题的特定方面,从而产生更准确和集中的输出。

一个步骤的输出作为下一个步骤的输入是至关重要的。这种信息传递建立了依赖链,因此得名,其中先前操作的上下文和结果指导后续处理。这使得LLM能够在其先前工作基础上构建,完善其理解,并逐步接近期望的解决方案。

此外,提示链接不仅仅是分解问题;它还能够整合外部知识和工具。在每个步骤中,LLM可以被指示与外部系统、API或数据库交互,丰富其知识和能力,超越其内部训练数据。这种能力大大扩展了LLMs的潜力,使它们不仅作为孤立模型发挥作用,而且作为更广泛、更智能系统的组成部分。

提示链接的重要性超越了简单的问题解决。它作为构建复杂AI代理的基础技术。这些代理可以利用提示链在动态环境中自主规划、推理和行动。通过策略性地构建提示序列,代理可以参与需要多步推理、规划和决策制定的任务。这样的代理工作流可以更紧密地模拟人类思维过程,允许与复杂领域和系统进行更自然和有效的交互。

单一提示的局限性: 对于多方面的任务,为大语言模型使用单一复杂提示可能效率低下,导致模型在处理约束和指令时出现困难,可能引发指令忽略(prompt的某些部分被忽略)、上下文漂移(模型失去对初始上下文的跟踪)、错误传播(早期错误被放大)、需要更长上下文窗口的提示(模型获得的信息不足以做出响应)以及幻觉(认知负荷增加导致错误信息的可能性增加)。例如,一个要求分析市场研究报告、总结发现、识别趋势及数据点并起草电子邮件的查询存在失败风险,因为模型可能总结得很好,但在提取数据或正确起草电子邮件方面失败。

通过顺序分解增强可靠性: 提示链通过将复杂任务分解为专注的顺序工作流来解决这些挑战,从而显著提高可靠性和控制力。基于上述例子,流水线或链式方法可以描述如下:

这种分解允许对过程进行更精细的控制。每个步骤都更简单且更少歧义,这减少了模型的认知负荷,并导致更准确可靠的最终输出。这种模块化类似于计算流水线,其中每个函数在将结果传递给下一个函数之前执行特定操作。为确保每个具体任务的准确响应,可以在每个阶段为模型分配不同的角色。例如,在给定场景中,初始提示可以指定为”市场分析师”,后续提示为”贸易分析师”,第三个提示为”专业文档撰写者”,等等。

结构化输出的作用: 提示链的可靠性高度依赖于步骤间传递数据的完整性。如果一个提示的输出模糊或格式不当,后续提示可能因输入错误而失败。为缓解这种情况,指定结构化输出格式(如JSON或XML)至关重要。

例如,趋势识别步骤的输出可以格式化为JSON对象:

+—————————————————————————————————————————————————————————-+ | { | | | | "trends": [ | | | | [ {] | | | | [ "trend_name": "AI驱动的个性化",] | | | | [ "supporting_data": "73%的消费者更愿意与使用个人信息使购物体验更相关的品牌合作。"] | | | | [ },] | | | | [ {] | | | | [ "trend_name": "可持续和道德品牌",] | | |

这种结构化格式确保数据是机器可读的,可以被精确解析并插入到下一个提示中而不产生歧义。这种做法最大限度地减少了解释自然语言时可能出现的错误,是构建稳健的、多步骤LLM(大语言模型)系统的关键组成部分。

提示链接(Prompt chaining)是一种多功能的模式,在构建代理系统时适用于广泛的场景。它的核心用途在于将复杂问题分解为顺序的、可管理的步骤。以下是几个实际应用和用例:

1. 信息处理工作流: 许多任务涉及通过多个转换来处理原始信息。例如,总结文档、提取关键实体,然后使用这些实体查询数据库或生成报告。提示链可能如下所示:

●提示1:从给定的URL或文档中提取文本内容。

●提示2:总结清理后的文本。

●提示3:从摘要或原始文本中提取特定实体(例如,姓名、日期、地点)。

●提示4:使用这些实体搜索内部知识库。

●提示5:生成融合摘要、实体和搜索结果的最终报告。

这种方法应用于自动内容分析、AI驱动的研究助手开发和复杂报告生成等领域。

2. 复杂查询回答: 回答需要多步推理或信息检索的复杂问题是一个主要用例。例如,“1929年股市崩盘的主要原因是什么,政府政策是如何回应的?”

●提示1:识别用户查询中的核心子问题(崩盘原因,政府回应)。

●提示2:专门研究或检索关于1929年崩盘原因的信息。

●提示3:专门研究或检索关于政府对1929年股市崩盘政策回应的信息。

●提示4:将步骤2和3的信息综合成对原始查询的连贯答案。

这种顺序处理方法是开发能够进行多步推理和信息综合的AI系统所必需的。当查询无法从单一数据点获得答案,而是需要一系列逻辑步骤或来自不同来源信息的整合时,就需要这样的系统。

例如,设计用于生成特定主题综合报告的自动化研究代理执行混合计算工作流。最初,系统检索众多相关文章。从每篇文章中提取关键信息的后续任务可以对每个来源同时执行。这个阶段很适合并行处理,其中独立的子任务同时运行以最大化效率。

然而,一旦个别提取完成,过程就变得固有地顺序化。系统必须首先整理提取的数据,然后将其综合为连贯的草稿,最后审查和完善这个草稿以产生最终报告。这些后续阶段中的每一个在逻辑上都依赖于前一个阶段的成功完成。这就是应用提示链接的地方:整理的数据作为综合提示的输入,生成的综合文本成为最终审查提示的输入。因此,复杂操作经常将用于独立数据收集的并行处理与用于综合和完善的依赖步骤的提示链接相结合。

3. 数据提取和转换: 将非结构化文本转换为结构化格式通常通过迭代过程实现,需要顺序修改以提高输出的准确性和完整性。

●提示1:尝试从发票文档中提取特定字段(例如,姓名、地址、金额)。

●处理:检查是否提取了所有必需字段以及它们是否符合格式要求。

●提示2(条件性):如果字段缺失或格式错误,制作新的提示要求模型专门查找缺失/格式错误的信息,可能提供失败尝试的上下文。

●处理:再次验证结果。必要时重复。

●[[输出:提供提取的、经过验证的结构化数据。]]

这种序列化处理方法特别适用于从表单、发票或电子邮件等非结构化来源进行数据提取和分析。例如,解决复杂的光学字符识别(OCR)问题,如处理PDF表单,通过分解的多步骤方法更有效地处理。

首先,使用大语言模型从文档图像中执行主要的文本提取。随后,模型处理原始输出以规范化数据,在这一步中,它可能会将数字文本(如”一千零五十”)转换为其数字等价物1050。对LLM来说,执行精确的数学计算是一个重大挑战。因此,在后续步骤中,系统可以将任何所需的算术运算委托给外部计算器工具。LLM识别必要的计算,将规范化的数字输入到工具中,然后整合精确的结果。这种文本提取、数据规范化和外部工具使用的链式序列实现了最终的准确结果,这通常很难从单个LLM查询中可靠地获得。

4. 内容生成工作流:[复杂内容的构成是一个程序化任务,通常分解为不同的阶段,包括初始构思、结构大纲、起草和后续修订]

●[[提示1:基于用户的一般兴趣生成5个主题想法。]]

●[[处理:允许用户选择一个想法或自动选择最好的一个。]]

●[[提示2:基于选定的主题,生成详细的大纲。]]

●[[提示3:基于大纲中的第一个要点写一个草稿段落。]]

●[[提示4:基于大纲中的第二个要点写一个草稿段落,提供前一段落作为上下文。对所有大纲要点继续此过程。]]

●[[提示5:审查和完善完整草稿的连贯性、语调和语法。]]

这种方法被用于一系列自然语言生成任务,包括创意叙事、技术文档和其他形式的结构化文本内容的自动构成。

5. 带状态的对话代理:[尽管全面的状态管理架构采用比序列链接更复杂的方法,提示链接为保持对话连续性提供了基础机制。这种技术通过构建每个对话轮次作为新提示来维持上下文,该提示系统地整合来自对话序列中前面交互的信息或提取实体。]

●[[提示1:处理用户话语1,识别意图和关键实体。]]

●[[处理:用意图和实体更新对话状态。]]

●[[提示2:基于当前状态,生成响应和/或识别下一个所需的信息片段。]]

●[[对后续轮次重复此过程,每个新的用户话语启动一个利用累积对话历史(状态)的链条。]]

这个原则对于开发对话代理至关重要,使它们能够在扩展的多轮对话中保持上下文和连贯性。通过保存对话历史,系统可以理解并适当地回应依赖于先前交换信息的用户输入。

6. 代码生成和优化:[功能代码的生成通常是一个多阶段过程,需要将问题分解为一系列离散的逻辑操作,并逐步执行]

●[[提示1:理解用户对代码函数的请求。生成伪代码或大纲。]]

●[[提示2:基于大纲编写初始代码草稿。]]

●[[提示3:识别代码中的潜在错误或改进区域(可能使用静态分析工具或另一个LLM调用)。]]

●[[提示4:基于识别的问题重写或完善代码。]]

●[[提示5:添加文档或测试用例。]]

在AI辅助软件开发等应用中,提示链接的效用源于其将复杂编码任务分解为一系列可管理子问题的能力。这种模块化结构降低了大语言模型在每个步骤的操作复杂性。关键地,这种方法还允许在模型调用之间插入确定性逻辑,使工作流中的中间数据处理、输出验证和条件分支成为可能。通过这种方法,一个原本可能导致不可靠或不完整结果的单一、多方面请求被转换为由底层执行框架管理的结构化操作序列。

7. 多模态和多步骤推理:分析具有不同模态的数据集需要将问题分解为更小的、基于提示的任务。例如,解释包含图片和嵌入文本、突出显示特定文本段的标签以及解释每个标签的表格数据的图像,需要这样的方法。

●[提示1:从用户的图像请求中提取和理解文本。]

●[提示2:将提取的图像文本与其对应的标签链接。]

●[提示3:使用表格解释收集的信息以确定所需的输出。]

实现提示链(prompt chaining)的方式从脚本中直接的顺序函数调用到利用专门设计来管理控制流、状态和组件集成的专用框架都有。LangChain、LangGraph、Crew AI和Google代理开发工具包(Agent Development Kit, ADK)等框架为构建和执行这些多步骤流程提供了结构化环境,这对于复杂架构特别有利。

为了演示目的,LangChain和LangGraph是合适的选择,因为它们的核心API专门设计用于组合操作链和图。LangChain为线性序列提供基础抽象,而LangGraph扩展了这些功能以支持有状态和循环计算,这对于实现更复杂的代理行为是必要的。此示例将专注于基本的线性序列。

以下代码实现了一个两步提示链,作为数据处理管道运行。初始阶段设计用于解析非结构化文本并提取特定信息。后续阶段然后接收这个提取的输出并将其转换为结构化数据格式。

要复制此过程,必须首先安装所需的库。这可以使用以下命令完成:

pip install langchain langchain-community langchain-openai langgraph注意langchain-openai可以替换为不同模型提供商的相应包。随后,执行环境必须配置所选语言模型提供商(如OpenAI、Google Gemini或Anthropic)的必要API凭据。

import os

from langchain_openai import ChatOpenAI

from langchain_core.prompts import ChatPromptTemplate

from langchain_core.output_parsers import StrOutputParser

# For better security, load environment variables from a .env file

# from dotenv import load_dotenv

# load_dotenv()

# Make sure your OPENAI_API_KEY is set in the .env file

# Initialize the Language Model (using ChatOpenAI is recommended)

llm = ChatOpenAI(temperature=0)这段Python代码演示了如何使用LangChain库处理文本。它使用两个独立的提示:一个用于从输入字符串提取技术规格,另一个用于将这些规格格式化为JSON对象。ChatOpenAI模型用于语言模型交互,StrOutputParser确保输出为可用的字符串格式。LangChain表达式语言(LCEL)用于优雅地将这些提示和语言模型链接在一起。第一个链extraction_chain提取规格。然后full_chain将提取的输出作为转换提示的输入。提供了一个描述笔记本电脑的示例输入文本。使用此文本调用full_chain,通过两个步骤进行处理。最终结果是包含提取和格式化规格的JSON字符串,然后被打印出来。

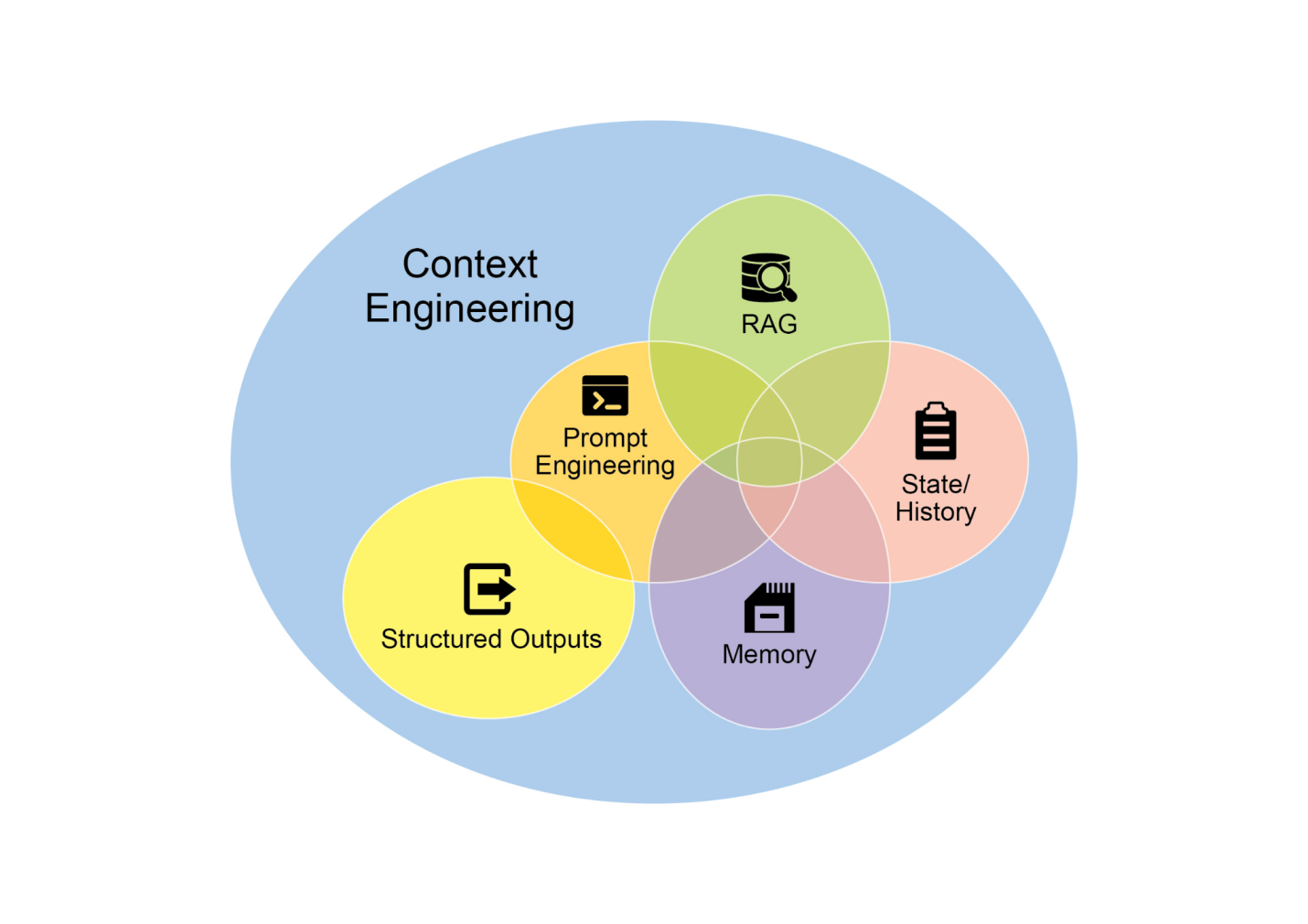

上下文工程(Context Engineering)(见图1)是在token生成之前系统性地设计、构建和提供完整信息环境给AI模型的学科。这种方法论断言,模型输出的质量更少依赖于模型的架构本身,而更多依赖于所提供上下文的丰富程度。

图1:上下文工程是为AI构建丰富、综合信息环境的学科,因为这种上下文的质量是实现高级代理(Agentic)性能的主要因素。

它代表了传统提示工程的重大演进,传统提示工程主要关注优化用户即时查询的表述。上下文工程(Context Engineering)将这一范围扩展到包含多层信息,如系统提示,这是一套定义AI操作参数的基础指令集——例如,“你是一名技术写作者;你的语调必须正式且精确。” 上下文通过外部数据进一步丰富。这包括检索文档,AI主动从知识库获取信息来告知其响应,如为项目提取技术规范。它还结合了工具输出,即AI使用外部API获得实时数据的结果,如查询日历确定用户的可用性。这种显式数据与关键的隐式数据相结合,如用户身份、交互历史和环境状态。核心原则是,即使是先进的模型,在提供有限或构造不良的操作环境视图时也会表现不佳。

因此,这种做法将任务从仅仅回答问题重新定义为为智能体构建全面的操作图景。例如,一个经过上下文工程的智能体不仅会响应查询,还会首先整合用户的日历可用性(工具输出)、与电子邮件接收者的专业关系(隐式数据)以及之前会议的记录(检索文档)。这使模型能够生成高度相关、个性化且实用的输出。“工程”组件涉及创建强大的管道来在运行时获取和转换这些数据,并建立反馈循环以持续改进上下文质量。

为了实施这一点,可以使用专门的调优系统来大规模自动化改进过程。例如,谷歌的Vertex AI提示优化器等工具可以通过系统评估响应与一组样本输入和预定义评估指标的对比来增强模型性能。这种方法对于在不需要大量手动重写的情况下跨不同模型调整提示和系统指令非常有效。通过为这样的优化器提供样本提示、系统指令和模板,它可以程序化地完善上下文输入,为实施复杂上下文工程所需的反馈循环提供结构化方法。

这种结构化方法是区分基础AI工具和更复杂、上下文感知系统的关键。它将上下文本身视为主要组件,对智能体知道什么、何时知道以及如何使用这些信息给予重要性。这种做法确保模型对用户的意图、历史和当前环境有全面的理解。最终,上下文工程是将无状态聊天机器人发展为高度能干、情境感知系统的关键方法论。

什么:复杂任务在单个提示内处理时经常会让LLMs不堪重负,导致严重的性能问题。模型的认知负荷增加了出错的可能性,如忽略指令、丢失上下文和生成错误信息。单一提示难以有效管理多个约束和顺序推理步骤。这导致不可靠和不准确的输出,因为LLM无法解决多方面请求的所有层面。

为什么:提示链(Prompt chaining)通过将复杂问题分解为一系列较小的、相互关联的子任务来提供标准化解决方案。链中的每个步骤使用专注的提示来执行特定操作,显著提高可靠性和控制力。一个提示的输出作为下一个提示的输入传递,创建一个逻辑工作流,逐步构建最终解决方案。这种模块化的分而治之策略使过程更易管理、更容易调试,并允许在步骤之间集成外部工具或结构化数据格式。这种模式是开发复杂、多步骤智能体系统的基础,这些系统能够规划、推理和执行复杂工作流。

经验法则:当任务对于单个提示来说过于复杂、涉及多个不同的处理阶段、需要在步骤之间与外部工具交互,或者在构建需要执行多步推理并维护状态的智能体系统时,使用此模式。

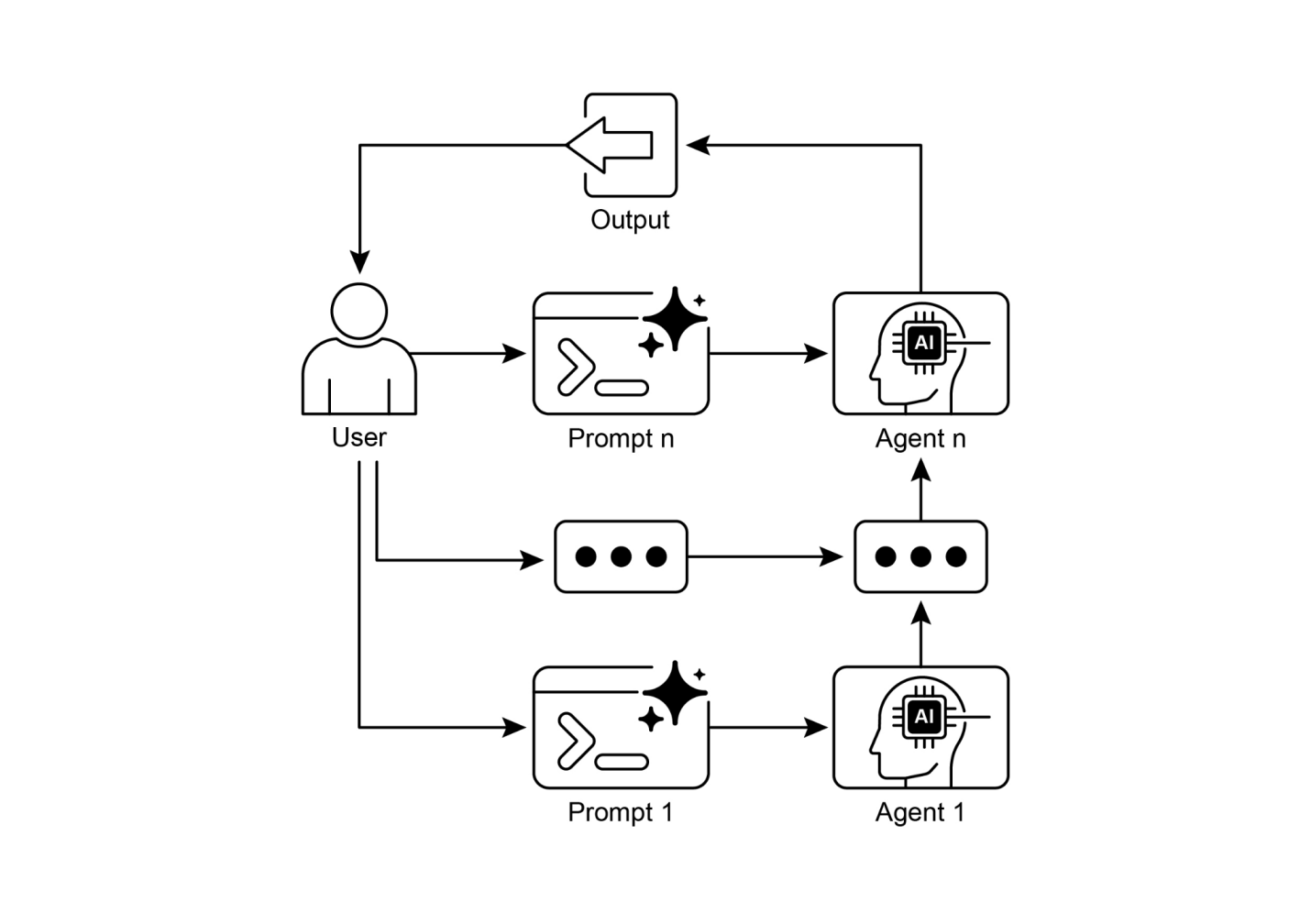

视觉摘要

图2:提示链模式:智能体从用户接收一系列提示,每个智能体的输出作为链中下一个智能体的输入。

以下是一些关键要点:

● 提示链将复杂任务分解为一系列较小的、专注的步骤。这有时也被称为管道模式。

● 链中的每个步骤涉及LLM调用或处理逻辑,使用前一步的输出作为输入。

● 这种模式提高了与语言模型复杂交互的可靠性和可管理性。

● 像LangChain/LangGraph和Google ADK等框架提供了强大的工具来定义、管理和执行这些多步序列。

通过将复杂问题分解为一系列更简单、更易管理的子任务,提示链为指导大语言模型提供了一个强大的框架。这种”分而治之”的策略通过使模型一次专注于一个特定操作,显著增强了输出的可靠性和控制性。作为一种基础模式,它能够开发出具备多步推理、工具集成和状态管理能力的复杂AI智能体(Agent)。最终,掌握提示链对于构建能够执行复杂工作流程的强大、上下文感知系统至关重要,这远超出了单一提示的能力范围。

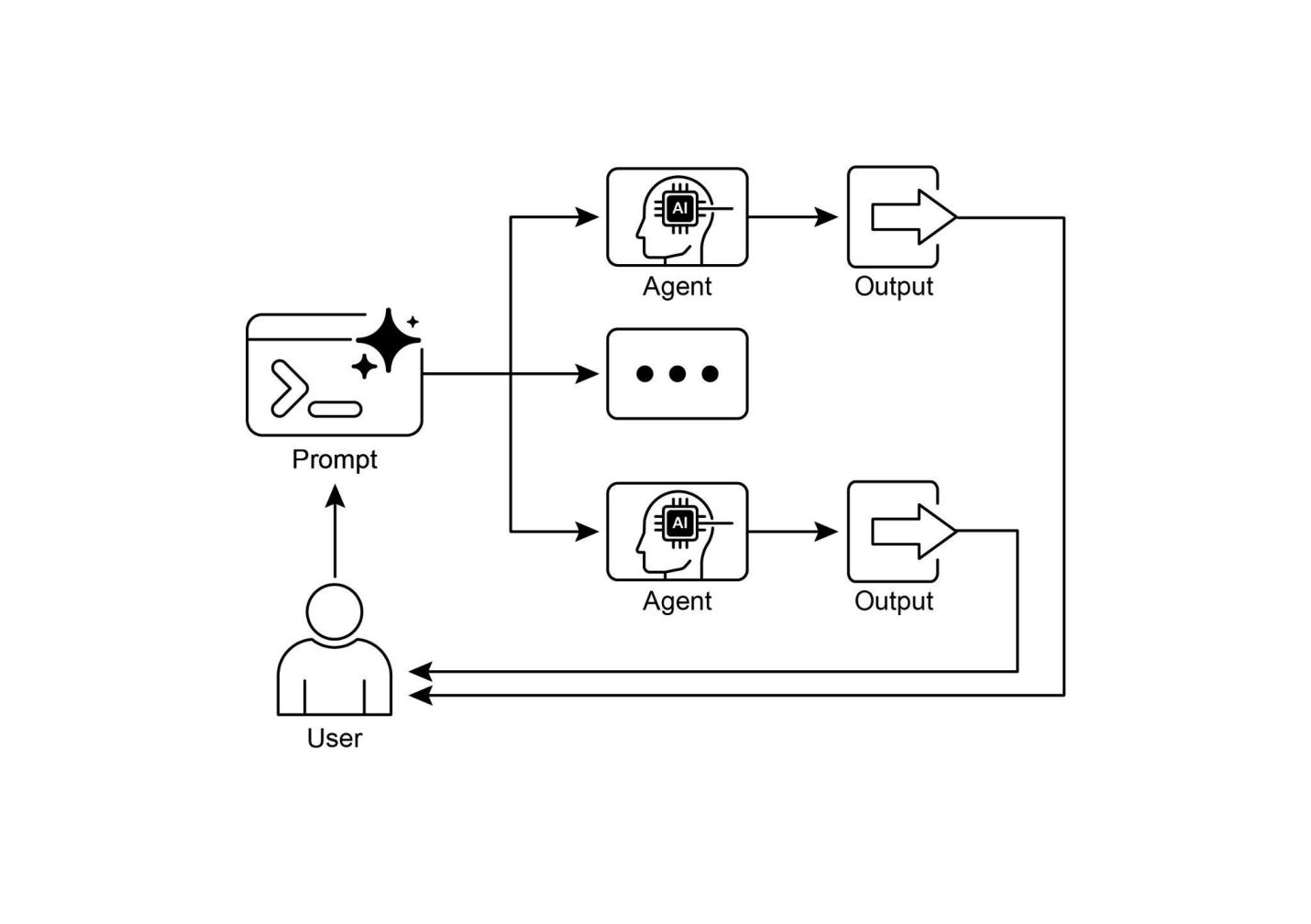

第二章:路由

虽然通过提示链进行顺序处理是执行确定性、线性工作流程的基础技术,但在需要自适应响应的场景中,其适用性有限。现实世界的智能体系统通常必须根据条件因素在多个潜在行动之间进行仲裁,例如环境状态、用户输入或前置操作的结果。这种动态决策能力控制着流程转向不同专门功能、工具或子流程,通过称为路由的机制来实现。

路由将条件逻辑引入智能体的操作框架,使其能够从固定的执行路径转变为模型动态评估特定标准以从一组可能的后续行动中进行选择。这使得系统行为更加灵活和上下文感知。

例如,专为客户查询设计的智能体在配备路由功能时,可以首先对传入查询进行分类以确定用户意图。基于这种分类,它然后可以将查询定向到专门的智能体进行直接问答、用于账户信息的数据库检索工具,或针对复杂问题的升级程序,而不是默认使用单一的、预定的响应路径。因此,使用路由的更复杂智能体可以:

○ 如果意图是”检查订单状态”,路由到与订单数据库交互的子智能体或工具链

○ 如果意图是”产品信息”,路由到搜索产品目录的子智能体或链

○ 如果意图是”技术支持”,路由到访问故障排除指南或升级到人工的不同链

○ 如果意图不明确,路由到澄清子智能体或提示链

路由模式的核心组件是执行评估和指导流程的机制。这种机制可以通过几种方式实现:

● 基于LLM的路由:语言模型本身可以被提示分析输入并输出指示下一步或目标的特定标识符或指令。例如,提示可能要求LLM”分析以下用户查询并仅输出类别:‘订单状态’、‘产品信息’、‘技术支持’或’其他’“。智能体系统然后读取此输出并相应地指导工作流程。

● 基于嵌入的路由:输入查询可以转换为向量嵌入(Embedding)(参见RAG,第14章)。然后将此嵌入与代表不同路由或能力的嵌入进行比较。查询被路由到嵌入最相似的路由。这对于语义路由很有用,其中决策基于输入的含义而不仅仅是关键词。

●[基于规则的路由:[ 这涉及使用基于关键词、模式或从输入中提取的结构化数据的预定义规则或逻辑(例如if-else语句、switch case)。这比基于LLM的路由更快、更具确定性,但在处理细致入微或新颖输入方面灵活性较差。]]

●[基于机器学习模型的路由[:它采用判别模型,如分类器,该模型在小型标记数据语料库上进行了专门训练来执行路由任务。虽然它与基于嵌入的方法在概念上有相似性,但其关键特征是监督微调过程,该过程调整模型参数以创建专门的路由函数。这种技术与基于LLM的路由不同,因为决策组件不是在推理时执行提示的生成模型。相反,路由逻辑编码在微调模型的学习权重中。虽然LLM可能在预处理步骤中用于生成合成数据来增强训练集,但它们不参与实时路由决策本身。]]

路由机制可以在智能体(agent)操作周期内的多个关键点实施。它们可以在开始时应用来分类主要任务,在处理链的中间点确定后续行动,或在子程序期间从给定集合中选择最合适的工具。

LangChain、LangGraph和Google的智能体开发工具包(ADK)等计算框架为定义和管理此类条件逻辑提供了明确的构造。凭借其基于状态的图架构,LangGraph特别适合复杂的路由场景,其中决策取决于整个系统的累积状态。类似地,Google的ADK提供了用于构建智能体能力和交互模型的基础组件,这些组件是实现路由逻辑的基础。在这些框架提供的执行环境中,开发者定义可能的操作路径以及决定计算图中节点间转换的函数或基于模型的评估。

路由的实现使系统能够超越确定性的顺序处理。它促进了更自适应执行流的开发,能够动态且适当地响应更广泛的输入和状态变化。

路由模式是自适应智能体系统设计中的关键控制机制,使它们能够根据可变输入和内部状态动态改变执行路径。通过提供必要的条件逻辑层,其实用性涵盖多个领域。

在人机交互中,如虚拟助手或AI驱动的导师,路由用于解释用户意图。对自然语言查询的初始分析确定最合适的后续行动,无论是调用特定的信息检索工具、升级到人工操作员,还是根据用户表现选择课程中的下一个模块。这使系统能够超越线性对话流并做出上下文响应。

在自动化数据和文档处理管道中,路由充当分类和分发功能。根据内容、元数据或格式分析传入的数据,如电子邮件、支持工单或API有效负载。然后系统将每个项目定向到相应的工作流程,如销售线索摄取过程、JSON或CSV格式的特定数据转换函数,或紧急问题升级路径。

在涉及多个专门工具或智能体的复杂系统中,路由充当高级调度程序。由用于搜索、总结和分析信息的不同智能体组成的研究系统将使用路由器根据当前目标将任务分配给最合适的智能体。类似地,AI编码助手使用路由来识别编程语言和用户意图——调试、解释或翻译——然后将代码片段传递给正确的专门工具。

最终,路由提供了对创建功能多样化和上下文感知系统至关重要的逻辑仲裁能力。它将智能体从预定义序列的静态执行器转变为能够在变化条件下就完成任务的最有效方法做出决策的动态系统。

在代码中实现路由涉及定义可能的路径和决定采取哪条路径的逻辑。LangChain和LangGraph等框架为此提供了特定的组件和结构。LangGraph基于状态的图结构对于可视化和实现路由逻辑特别直观。

此代码演示了使用LangChain和Google生成式AI的简单智能体系统。它建立了一个”协调器”,根据请求的意图(预订、信息或不明确)将用户请求路由到不同的模拟”子智能体”处理程序。系统使用语言模型对请求进行分类,然后将其委托给适当的处理程序函数,模拟多智能体架构中常见的基本委托模式。

首先,确保您已安装必要的库:

| pip install langchain langgraph google-cloud-aiplatform langchain-google-genai google-adk deprecated pydantic |

您还需要使用您选择的语言模型的API密钥来设置环境(例如,OpenAI、Google Gemini、Anthropic)。

# Copyright (c) 2025 Marco Fago

# https://www.linkedin.com/in/marco-fago/

#

# This code is licensed under the MIT License.

# See the LICENSE file in the repository for the full license text.

from langchain_google_genai import ChatGoogleGenerativeAI

from langchain_core.prompts import ChatPromptTemplate

from langchain_core.output_parsers import StrOutputParser

from langchain_core.runnables import RunnablePassthrough, RunnableBranch

# --- 配置 ---

# 确保您的API密钥环境变量已设置(例如,GOOGLE_API_KEY)

try:

llm = ChatGoogleGenerativeAI(model="gemini-2.5-flash", temperature=0)

print(f"语言模型已初始化:{llm.model}")

except Exception as e:

print(f"初始化语言模型时出错:{e}")

llm = None

# --- 定义模拟子代理处理器(Sub-Agent Handlers)(等同于ADK sub_agents)---

def booking_handler(request: str) -> str:# 将路由器链和委托分支合并为单个可运行对象

# 路由器链的输出('decision')与原始输入('request')一起传递

# 给委托分支。

coordinator_agent = {

"decision": coordinator_router_chain,

"request": RunnablePassthrough()

} | delegation_branch | (lambda x: x['output']) # 提取最终输出

# --- 使用示例 ---

def main():

if not llm:

print("\n由于LLM初始化失败,跳过执行。")

return

print("--- 运行预订请求 ---")

request_a = "给我预订一张到伦敦的航班。"

result_a = coordinator_agent.invoke({"request": request_a})

print(f"最终结果 A: {result_a}")

print("\n--- 运行信息请求 ---")

request_b = "意大利的首都是什么?"

result_b = coordinator_agent.invoke({"request": request_b})

print(f"最终结果 B: {result_b}")+—————————————————————————————————————————-+

如前所述,这个Python代码使用LangChain库和Google的Generative AI模型(特别是gemini-2.5-flash)构建了一个简单的智能体系统。详细来说,它定义了三个模拟的子智能体处理器:booking_handler、info_handler和unclear_handler,每个都设计用于处理特定类型的请求。

核心组件是coordinator_router_chain,它使用ChatPromptTemplate指导语言模型将传入的用户请求分类为三种类别之一:‘booker’、‘info’或’unclear’。然后,这个路由链的输出被RunnableBranch用来将原始请求委托给相应的处理器函数。RunnableBranch检查语言模型的决策,并将请求数据引导到booking_handler、info_handler或unclear_handler。coordinator_agent结合了这些组件,首先路由请求以做出决策,然后将请求传递给选定的处理器。最终输出从处理器的响应中提取。

main函数通过三个示例请求演示了系统的使用,展示了不同输入如何被路由和处理的模拟智能体。包含了语言模型初始化的错误处理以确保鲁棒性。代码结构模拟了一个基本的多智能体框架,其中中央协调器根据意图将任务委托给专门的智能体。

智能体开发工具包(Agent Development Kit,ADK)是一个用于设计智能体系统的框架,提供了一个结构化环境来定义智能体的能力和行为。与基于显式计算图的架构相比,ADK范式中的路由通常通过定义一组表示智能体功能的离散”工具”来实现。在响应用户查询时选择合适工具的过程由框架的内部逻辑管理,该逻辑利用底层模型将用户意图与正确的功能处理器匹配。

这个Python代码演示了使用Google的ADK库的智能体开发工具包(ADK)应用程序示例。它设置了一个”协调器”智能体,根据定义的指令将用户请求路由到专门的子智能体(用于预订的”Booker”和用于一般信息的”Info”)。然后子智能体使用特定工具来模拟处理请求,展示了智能体系统中的基本委托模式。

+————————————————————————————————————————————————————–+ | # Copyright (c) 2025 Marco Fago | | | | # | | | | # 此代码在MIT许可证下授权。 | | | | # 完整许可证文本请查看仓库中的LICENSE文件。 | | | | |

import uuid

from typing import Dict, Any, Optional

from google.adk.agents import Agent

from google.adk.runners import InMemoryRunner

from google.adk.tools import FunctionTool

from google.genai import types

from google.adk.events import Event

# --- 定义工具函数 ---

# 这些函数模拟专业代理的行为。

def booking_handler(request: str) -> str:

"""

处理航班和酒店的预订请求。

Args:

request: 用户的预订请求。

Returns:# --- 从函数创建工具 ---

booking_tool = FunctionTool(booking_handler)

info_tool = FunctionTool(info_handler)

# 定义配备各自工具的专门子代理

booking_agent = Agent(

name="Booker",

model="gemini-2.0-flash",

description="专门处理所有航班和酒店预订请求的特化代理,通过调用预订工具来处理。",

tools=[booking_tool]

)

info_agent = Agent(

name="Info",

model="gemini-2.0-flash",

description="专门提供一般信息和回答用户问题的特化代理,通过调用信息工具来处理。",if name == “main”: import nest_asyncio nest_asyncio.apply() await main()

此脚本包含一个主要的Coordinator代理(agent)和两个专门的子代理:Booker和Info。每个专门的代理都配备了一个FunctionTool,它包装了一个模拟动作的Python函数。booking_handler函数模拟处理航班和酒店预订,而info_handler函数模拟检索一般信息。unclear_handler作为协调器无法委派请求时的后备选择,尽管当前协调器逻辑在主要的run_coordinator函数中没有明确将其用于委派失败。

Coordinator代理的主要角色,如其指令中定义的,是分析传入的用户消息并将它们委派给Booker或Info代理。这种委派由ADK的Auto-Flow机制自动处理,因为Coordinator定义了sub_agents。run_coordinator函数设置一个InMemoryRunner,创建用户和会话ID,然后使用运行器通过协调器代理处理用户请求。runner.run方法处理请求并生成事件,代码从event.content中提取最终响应文本。

main函数通过使用不同请求运行协调器来演示系统的使用,展示了它如何将预订请求委派给Booker,将信息请求委派给Info代理。

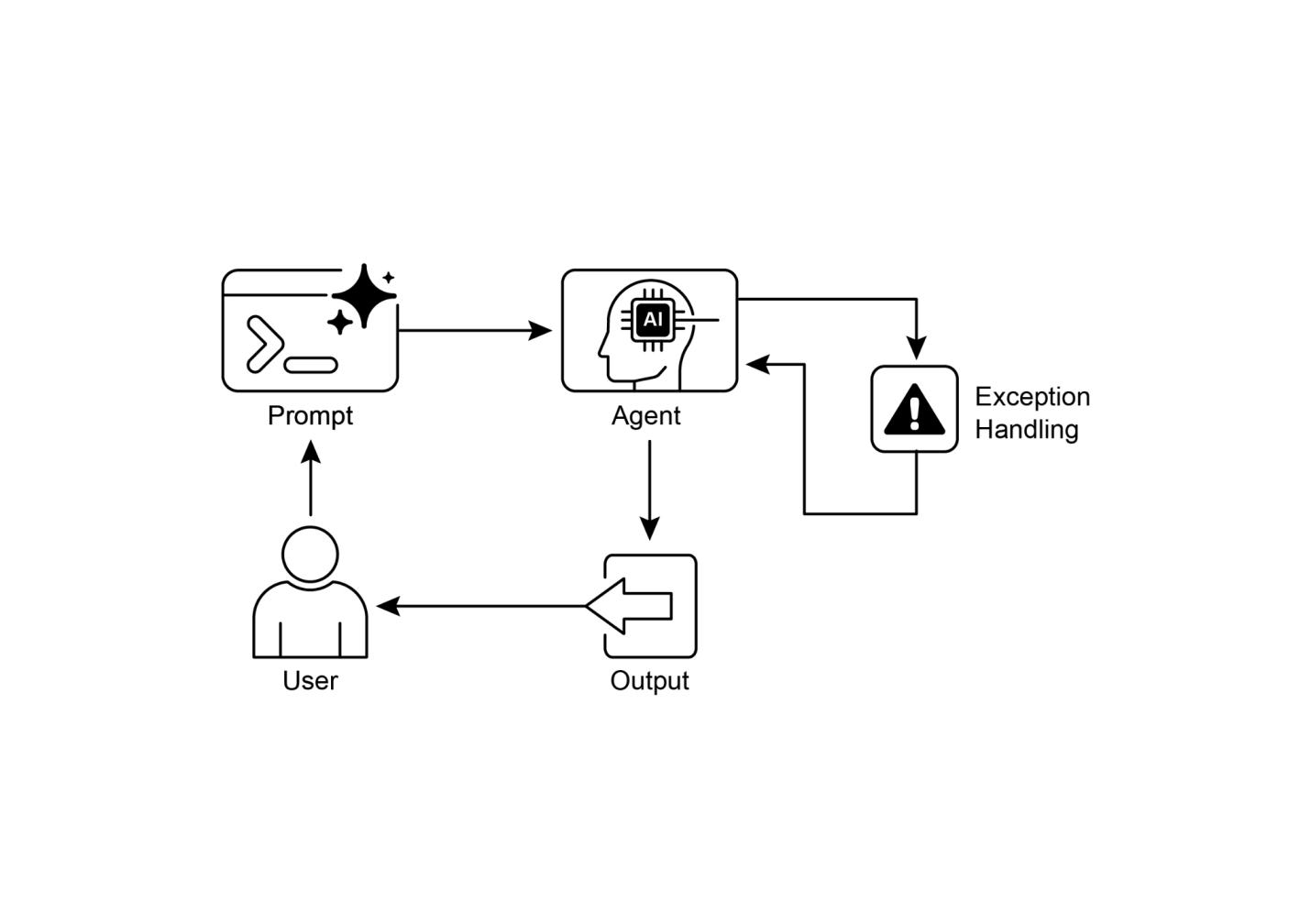

什么: 代理系统通常必须响应无法由单一线性过程处理的各种输入和情况。简单的顺序工作流缺乏根据上下文做出决策的能力。没有为特定任务选择正确工具或子过程的机制,系统就会保持僵化和非自适应状态。这种局限性使得构建能够管理现实世界用户请求复杂性和可变性的复杂应用变得困难。

为什么: 路由模式通过在代理的操作框架中引入条件逻辑提供了标准化的解决方案。它使系统能够首先分析传入查询以确定其意图或性质。基于此分析,代理动态地将控制流引导到最合适的专门工具、函数或子代理。这种决策可以由各种方法驱动,包括提示LLMs、应用预定义规则或使用基于嵌入的语义相似性。最终,路由将静态的、预定的执行路径转换为能够选择最佳可能行动的灵活且上下文感知的工作流。

经验法则: 当代理必须基于用户输入或当前状态在多个不同的工作流、工具或子代理之间做出决择时,使用路由模式。它对于需要对传入请求进行分类或分流以处理不同类型任务的应用是必要的,例如客户支持机器人区分销售咨询、技术支持和账户管理问题。

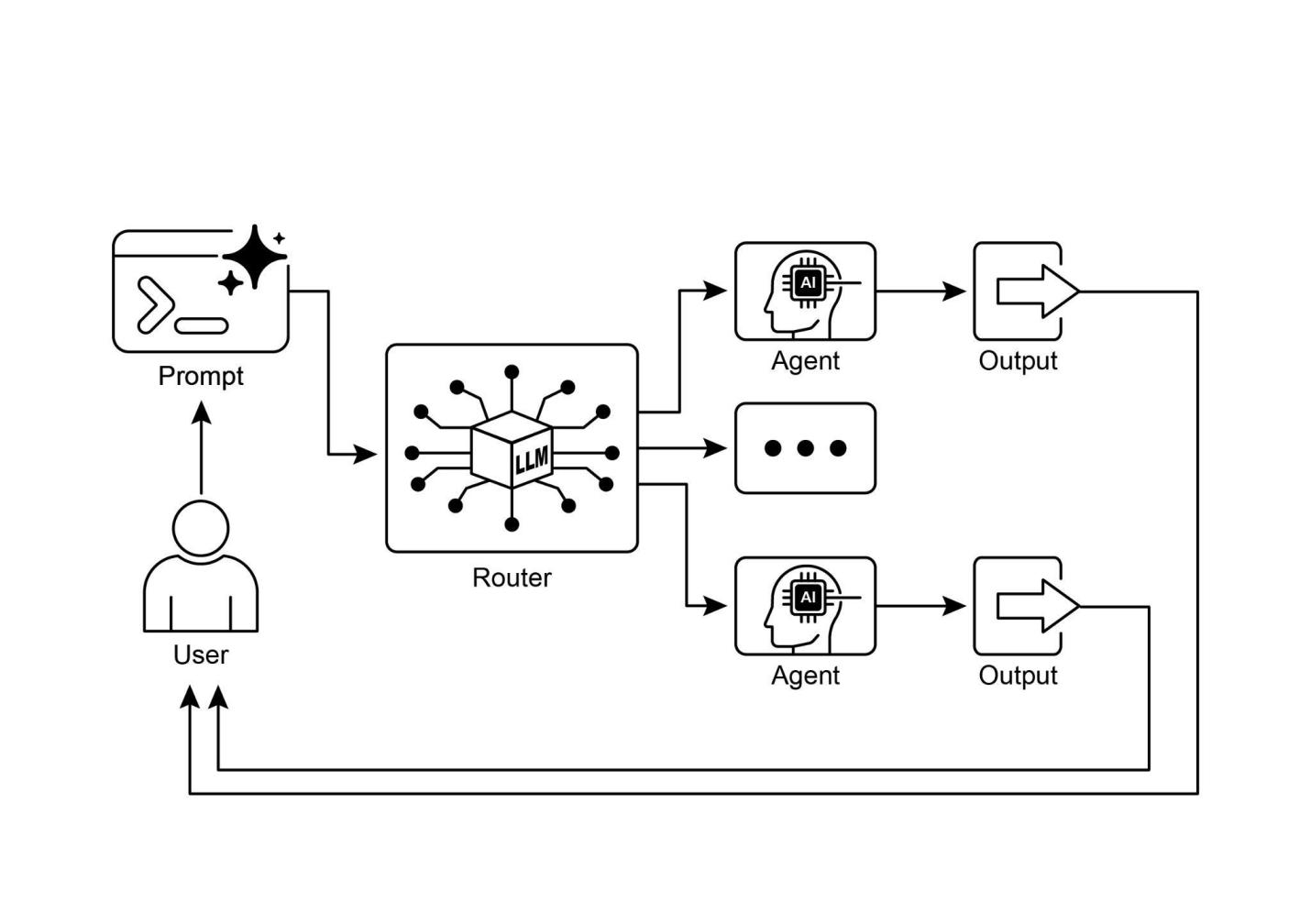

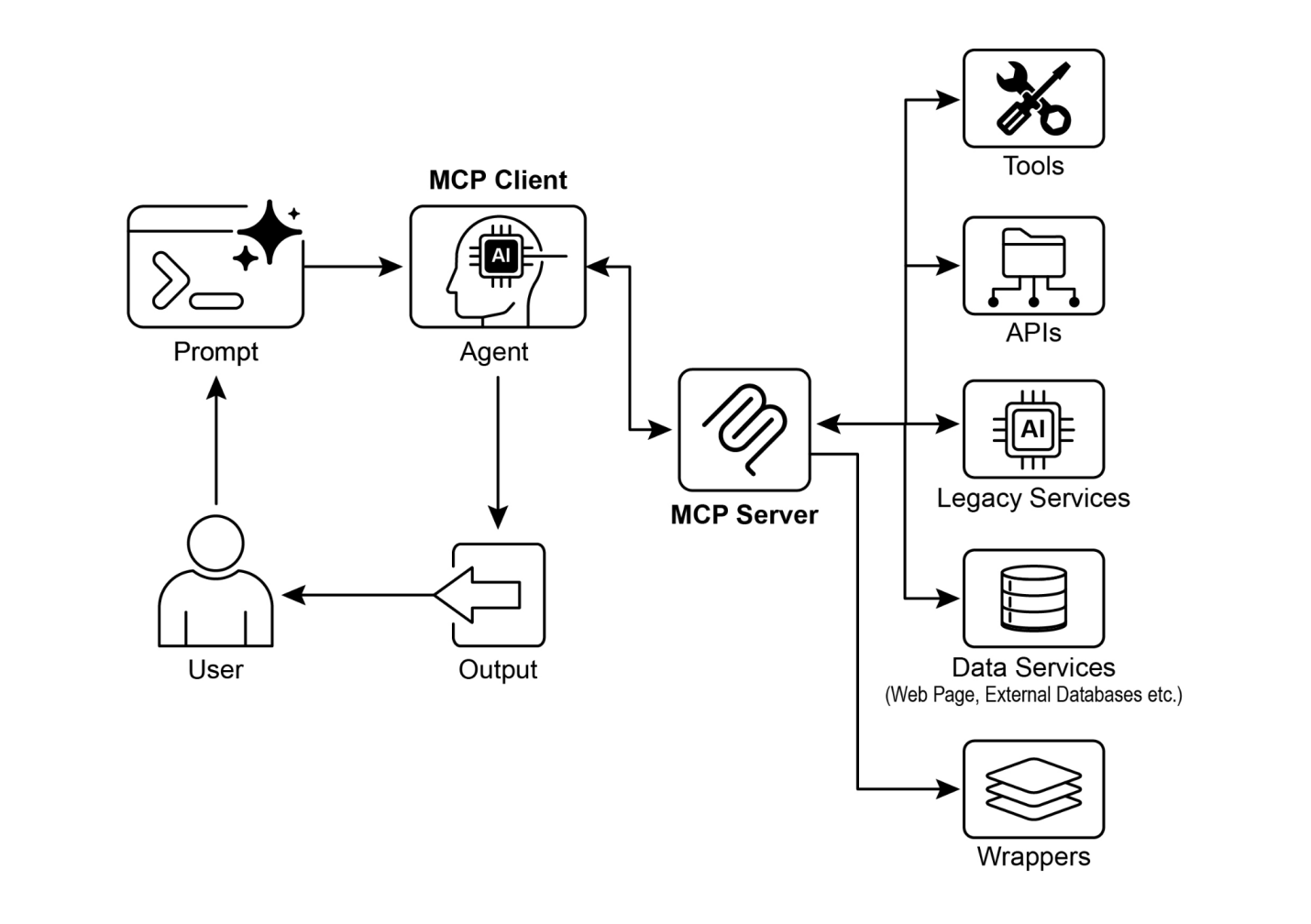

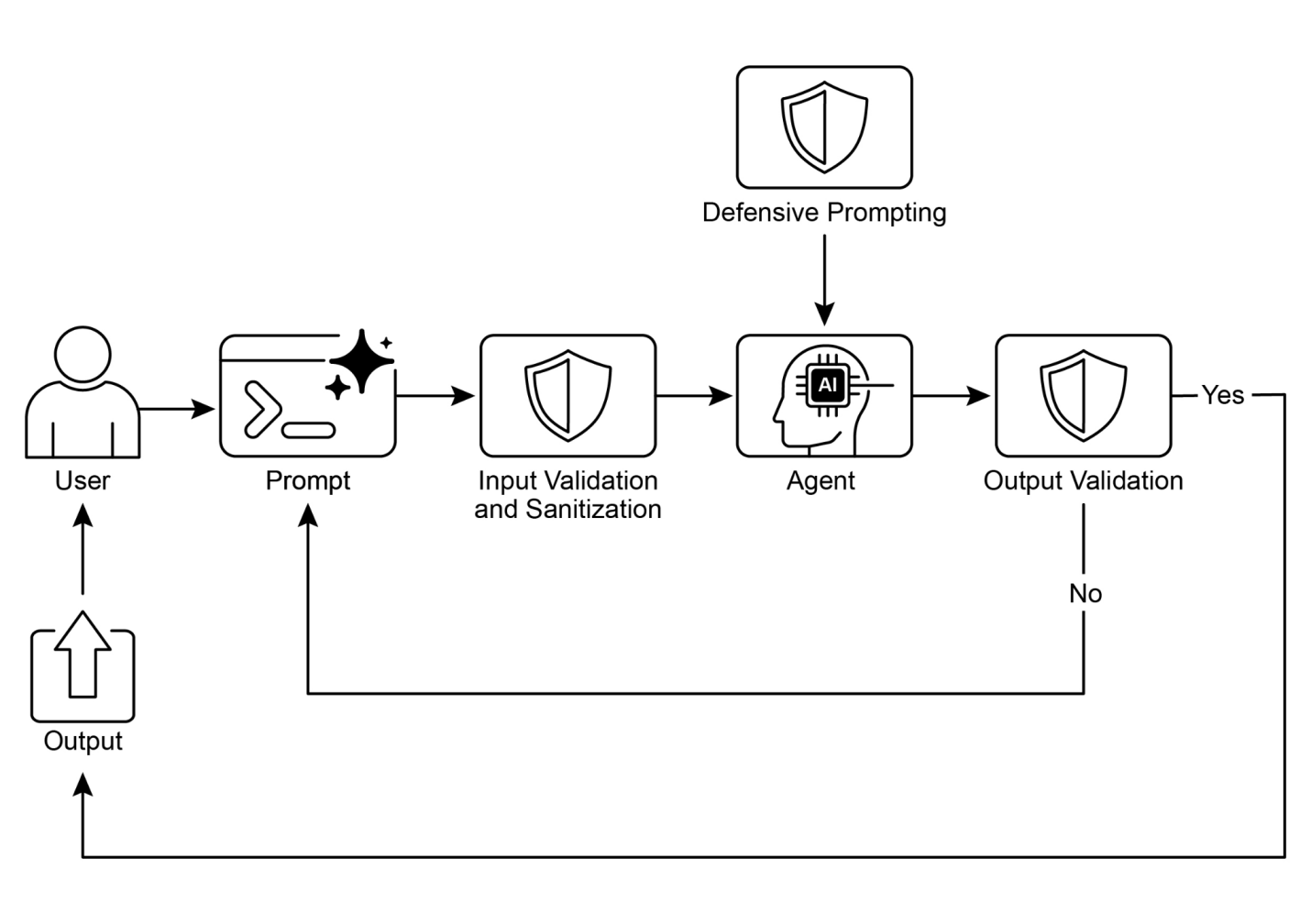

图1:路由器模式,使用LLM作为路由器

● 路由使智能体能够根据条件对工作流中的下一步进行动态决策。

● 它允许智能体处理多样化的输入并适应其行为,超越线性执行。

● 路由逻辑可以使用LLM、基于规则的系统或嵌入相似性来实现。

● LangGraph和Google ADK等框架提供结构化的方式来定义和管理智能体工作流中的路由,尽管采用了不同的架构方法。

路由模式是构建真正动态和响应式智能体系统的关键步骤。通过实现路由,我们超越了简单的线性执行流程,赋予智能体做出智能决策的能力,决定如何处理信息、响应用户输入以及利用可用的工具或子智能体。

我们已经看到路由如何在各种领域中应用,从客户服务聊天机器人到复杂的数据处理管道。分析输入并有条件地引导工作流的能力,是创建能够处理现实世界任务固有可变性的智能体的基础。

使用LangChain和Google ADK的代码示例展示了两种不同但有效的路由实现方法。LangGraph基于图的结构提供了一种可视化和明确的方式来定义状态和转换,使其非常适合具有复杂路由逻辑的复杂多步骤工作流。另一方面,Google ADK通常专注于定义不同的能力(工具),并依赖框架将用户请求路由到适当工具处理程序的能力,这对于具有明确定义的离散动作集的智能体来说更简单。

掌握路由模式对于构建能够智能导航不同场景并基于上下文提供定制响应或动作的智能体至关重要。它是创建多功能和健壮智能体应用的关键组件。

第三章:并行化

在前面的章节中,我们探讨了用于顺序工作流的提示链(Prompt Chaining)和用于动态决策和不同路径之间转换的路由。虽然这些模式是必不可少的,但许多复杂的智能体任务涉及多个子任务,这些子任务可以同时执行而不是一个接一个地执行。这就是并行化模式变得至关重要的地方。

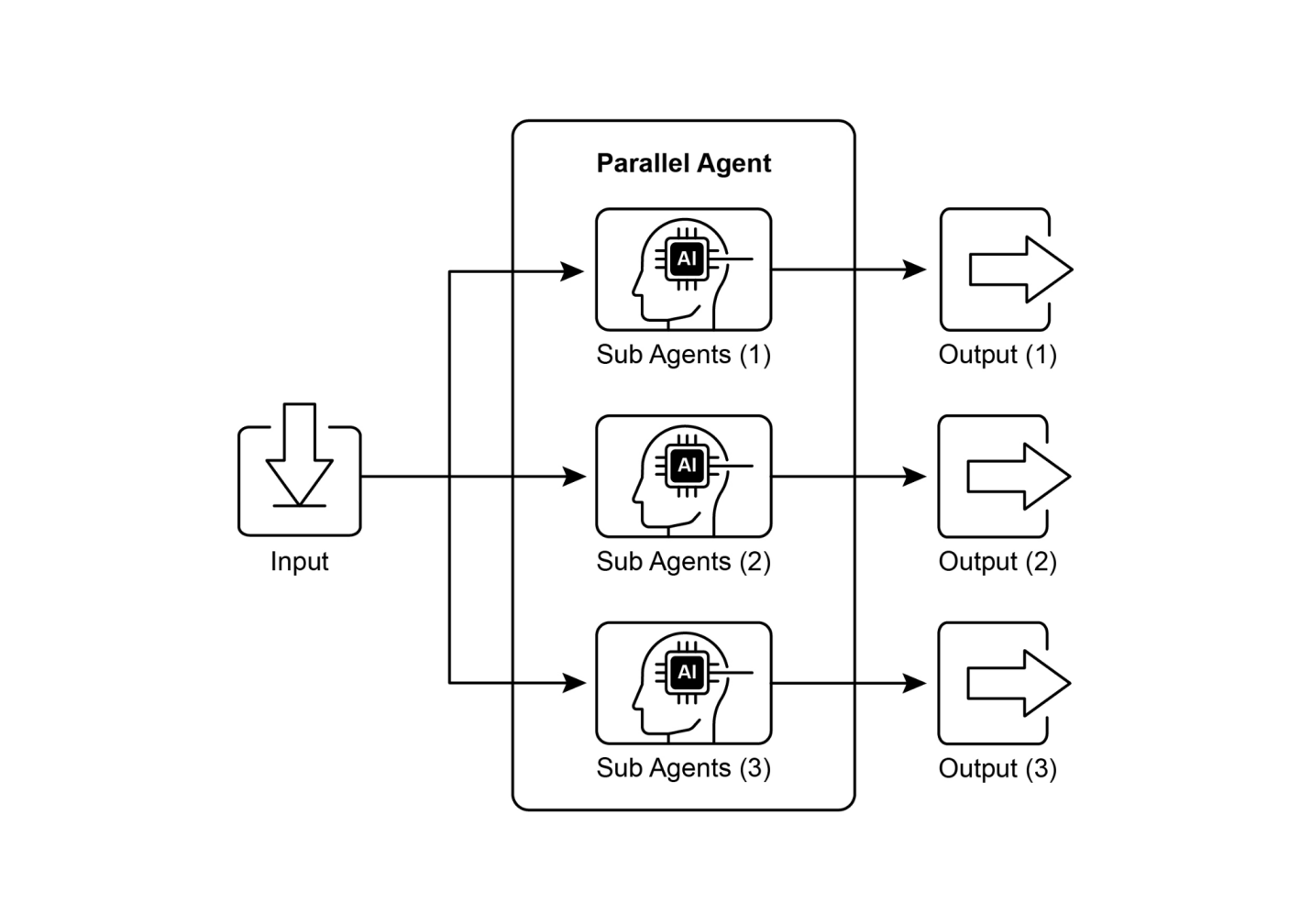

并行化涉及同时执行多个组件,如LLM调用、工具使用甚至整个子智能体(见图1)。并行执行不是等待一个步骤完成后再开始下一个步骤,而是允许独立任务同时运行,显著减少可以分解为独立部分的任务的总执行时间。

考虑一个设计用于研究主题并总结其发现的智能体。顺序方法可能是:

并行方法则可以:

核心思想是识别工作流中不依赖于其他部分输出的部分,并并行执行它们。这在处理具有延迟的外部服务(如API或数据库)时特别有效,因为您可以同时发出多个请求。

实现并行化通常需要支持异步执行或多线程/多进程的框架。现代智能体框架在设计时就考虑了异步操作,允许您轻松定义可以并行运行的步骤。

图1. 子智能体并行化示例

LangChain、LangGraph和Google ADK等框架提供了并行执行的机制。在LangChain表达式语言(LCEL)中,您可以通过使用|(用于顺序)等操作符组合可运行对象,并通过构建链或图来获得同时执行的分支,从而实现并行执行。LangGraph凭借其图结构,允许您定义可以从单个状态转换执行的多个节点,有效地在工作流中启用并行分支。Google ADK提供强大的原生机制来促进和管理智能体的并行执行,显著增强复杂多智能体系统的效率和可扩展性。ADK框架内的这种固有能力允许开发人员设计和实现多个智能体可以同时而非顺序操作的解决方案。

并行化模式对于提高智能体系统的效率和响应性至关重要,特别是在处理涉及多个独立查找、计算或与外部服务交互的任务时。它是优化复杂智能体工作流性能的关键技术。

并行化是优化智能体(agent)性能的强大模式,适用于各种应用:

同时从多个来源收集信息是经典用例。

• 用例: 研究公司的智能体。

• 并行任务: 同时搜索新闻文章、获取股票数据、检查社交媒体提及和查询公司数据库。

• 优势: 比顺序查找更快地获得全面视图。

同时应用不同分析技术或处理不同数据段。

• 用例: 分析客户反馈的智能体。

• 并行任务: 在一批反馈条目中同时运行情感分析、提取关键词、分类反馈和识别紧急问题。

• 优势: 快速提供多方面分析。

调用多个独立API或工具以收集不同类型信息或执行不同操作。

• 用例: 旅行规划智能体。

• 并行任务: 同时检查航班价格、搜索酒店可用性、查找当地活动和寻找餐厅推荐。

• 优势: 更快地呈现完整旅行计划。

并行生成复杂内容的不同部分。

• 用例: 创建营销邮件的智能体。

• 并行任务: 同时生成主题行、草拟邮件正文、查找相关图片和创建行动号召按钮文本。

• 优势: 更高效地组装最终邮件。

同时执行多个独立检查或验证。

• 用例: 验证用户输入的智能体。

• 并行任务: 同时检查邮件格式、验证电话号码、根据数据库验证地址和检查敏感词。

• 优势: 更快提供输入有效性反馈。

同时处理相同输入的不同模态(文本、图像、音频)。

• 用例: 分析包含文本和图像的社交媒体帖子的智能体。

• 并行任务: 同时分析文本的情感和关键词以及分析图像的对象和场景描述。

• 优势: 更快地整合来自不同模态的见解。

并行生成响应或输出的多个变体以选择最佳选项。

• 用例: 生成不同创意文本选项的智能体。

• 并行任务: 使用略有不同的提示词或模型同时生成文章的三个不同标题。

• 优势: 允许快速比较和选择最佳选项。

并行化是智能体设计中的基础优化技术,允许开发者通过利用独立任务的并发执行来构建更高性能和响应更快的应用。

LangChain框架内的并行执行通过LangChain表达语言(LCEL)实现。主要方法是在字典或列表结构中构建多个可运行组件。当这个集合作为输入传递给链中的后续组件时,LCEL运行时会并发执行包含的可运行组件。

在LangGraph的上下文中,这个原理应用于图的拓扑结构。并行工作流通过构建图来定义,使得多个节点在缺乏直接顺序依赖关系的情况下,可以从单个共同节点启动。这些并行路径独立执行,直到它们的结果在图中的后续汇聚点被聚合。

以下实现演示了使用LangChain框架构建的并行处理工作流。该工作流旨在响应单个用户查询时同时执行两个独立操作。这些并行进程实例化为不同的链或函数,它们各自的输出随后被聚合到统一结果中。

此实现的先决条件包括安装必需的Python包,如langchain、langchain-community和模型提供者库如langchain-openai。此外,必须在本地环境中配置所选语言模型的有效API密钥用于认证。

import os

import asyncio

from typing import Optionaltry:

# `ainvoke` 的输入是单个 'topic' 字符串,

# 然后传递给 `map_chain` 中的每个runnable。

response = await full_parallel_chain.ainvoke(topic)

print("\n--- 最终响应 ---")

print(response)

except Exception as e:

print(f"\n链执行过程中发生错误: {e}")

if __name__ == "__main__":

test_topic = "太空探索的历史"

# 在Python 3.7+中,asyncio.run是运行异步函数的标准方式。

asyncio.run(run_parallel_example(test_topic))提供的Python代码实现了一个LangChain应用程序,旨在通过利用并行执行来高效处理给定主题。请注意,asyncio提供的是并发性,而非并行性。它在单线程上通过使用事件循环来实现,该事件循环在任务空闲时(例如等待网络请求)智能地在任务之间切换。这创造了多个任务同时进行的效果,但代码本身仍然只由一个线程执行,受到Python全局解释器锁(GIL)的限制。

代码首先从langchain_openai和langchain_core导入必要的模块,包括语言模型、提示、输出解析和可运行结构的组件。代码尝试初始化一个ChatOpenAI实例,特别是使用”gpt-4o-mini”模型,并指定temperature参数来控制创造性。在语言模型初始化期间使用try-except块以确保健壮性。然后定义了三个独立的LangChain”链”,每个都设计为对输入主题执行不同的任务。第一个链用于简洁地总结主题,使用系统消息和包含主题占位符的用户消息。第二个链配置为生成与主题相关的三个有趣问题。第三个链设置为从输入主题中识别5到10个关键术语,要求以逗号分隔。这些独立的链中的每一个都包含一个针对其特定任务定制的ChatPromptTemplate,然后是初始化的语言模型和一个StrOutputParser来将输出格式化为字符串。

然后构建一个RunnableParallel块来捆绑这三个链,允许它们同时执行。这个并行runnable还包括一个RunnablePassthrough,以确保原始输入主题可用于后续步骤。为最终合成步骤定义了一个单独的ChatPromptTemplate,将摘要、问题、关键术语和原始主题作为输入来生成综合答案。完整的端到端处理链,名为full_parallel_chain,通过将map_chain(并行块)排列到合成提示中,然后是语言模型和输出解析器来创建。提供了一个异步函数run_parallel_example来演示如何调用这个full_parallel_chain。此函数将主题作为输入并使用invoke来运行异步链。最后,标准的Python

if __name__ == "__main__":

块展示了如何使用示例主题执行run_parallel_example,在这种情况下是”太空探索的历史”,使用asyncio.run来管理异步执行。

本质上,这段代码设置了一个工作流程,其中对给定主题同时进行多个LLM调用(用于总结、问题和术语),然后通过最终的LLM调用组合它们的结果。这展示了在使用LangChain的智能工作流程中并行化的核心思想。

现在让我们转向一个具体的示例,来说明这些概念在 Google ADK 框架中的应用。我们将研究如何使用 ADK 基元(primitives),如 ParallelAgent 和 SequentialAgent,来构建一个利用并发执行提高效率的智能体流程。

from google.adk.agents import LlmAgent, ParallelAgent, SequentialAgent

from google.adk.tools import google_search

GEMINI_MODEL="gemini-2.0-flash"

# --- 1. 定义研究员子智能体(并行运行) ---

# 研究员 1:可再生能源

researcher_agent_1 = LlmAgent(

name="RenewableEnergyResearcher",

model=GEMINI_MODEL,

instruction="""You are an AI Research Assistant specializing in energy.输出格式:

(基于可再生能源研究员(RenewableEnergyResearcher)的发现)

[仅对上述提供的可再生能源输入摘要进行综合和详细阐述。]

(基于电动汽车研究员(EVResearcher)的发现)

[仅对上述提供的电动汽车(EV)输入摘要进行综合和详细阐述。]

这是将要运行的主智能体(agent)。它首先执行ParallelAgent来填充状态,然后执行MergerAgent产生最终输出。

sequential_pipeline_agent = SequentialAgent(

name="ResearchAndSynthesisPipeline",

# 先运行并行研究,然后合并

sub_agents=[parallel_research_agent, merger_agent],

description="协调并行研究并综合结果。"

)

root_agent = sequential_pipeline_agent这段代码定义了一个多智能体系统,用于研究和综合可持续技术进展的信息。它设置了三个LlmAgent实例作为专门的研究人员。ResearcherAgent_1专注于可再生能源,ResearcherAgent_2研究电动汽车技术,ResearcherAgent_3调查碳捕获方法。每个研究智能体都配置为使用GEMINI_MODEL和google_search工具。它们被指示简洁地总结其发现(1-2句话)并使用output_key将这些摘要存储在会话状态中。

然后创建一个名为ParallelWebResearchAgent的ParallelAgent来并发运行这三个研究智能体。这允许研究同时进行,可能节省时间。ParallelAgent在其所有子智能体(研究人员)完成并填充状态后完成执行。

接下来,定义一个MergerAgent(也是LlmAgent)来综合研究结果。该智能体将并行研究人员存储在会话状态中的摘要作为输入。其指令强调输出必须严格基于提供的输入摘要,禁止添加外部知识。MergerAgent被设计为将合并的发现结构化为带有每个主题标题和简要总体结论的报告。

最后,创建一个名为ResearchAndSynthesisPipeline的SequentialAgent来编排整个工作流程。作为主控制器,这个主智能体首先执行ParallelAgent来执行研究。ParallelAgent完成后,SequentialAgent然后执行MergerAgent来综合收集的信息。sequential_pipeline_agent被设置为root_agent,代表运行此多智能体系统的入口点。整个过程旨在高效地并行收集来自多个来源的信息,然后将其合并为一个结构化的报告。

什么: [许多智能体工作流涉及必须完成的多个子任务以实现最终目标。纯粹的顺序执行,即每个任务等待前一个任务完成,往往效率低下且缓慢。当任务依赖于外部I/O操作(如调用不同的API或查询多个数据库)时,这种延迟成为重大瓶颈。没有并发执行机制,总处理时间就是所有单个任务持续时间的总和,阻碍了系统的整体性能和响应性。]

为什么: [并行化模式通过启用独立任务的同时执行提供了标准化解决方案。它通过识别工作流中不依赖彼此即时输出的组件(如工具使用或LLM调用)来工作。LangChain和Google ADK等智能体框架提供内置构造来定义和管理这些并发操作。例如,主进程可以调用几个并行运行的子任务,并等待它们全部完成后再进行下一步。通过同时运行这些独立任务而不是依次运行,此模式显著减少了总执行时间。]

经验法则: [当工作流包含可以同时运行的多个独立操作时使用此模式,例如从多个API获取数据、处理不同的数据块,或生成多个内容片段以供后续综合。]

视觉摘要

图2:并行化设计模式

以下是关键要点:

●[[并行化是一种并发执行独立任务以提高效率的模式。]]

●[[当任务涉及等待外部资源(如API调用)时特别有用。]]

●[[采用并发或并行架构会带来大量复杂性和成本,影响设计、调试和系统日志等关键开发阶段。]]

●[[LangChain和Google ADK等框架为定义和管理并行执行提供内置支持。]]

●[[在LangChain表达式语言(LCEL)中,RunnableParallel是并行运行多个可运行对象的关键构造。]]

●[[Google ADK可以通过LLM驱动的委托促进并行执行,其中协调器智能体(Coordinator agent)的LLM识别独立的子任务并触发专门子智能体的并发处理。]]

●[[并行化有助于减少整体延迟,使智能体系统对复杂任务更具响应性。]]

并行化模式是一种通过并发执行独立子任务来优化计算工作流的方法。这种方法减少了整体延迟,特别是在涉及多个模型推理或调用外部服务的复杂操作中。

框架为实现此模式提供了不同的机制。在LangChain中,使用RunnableParallel等构造来明确定义和同时执行多个处理链。相比之下,Google Agent Developer Kit (ADK)等框架可以通过多智能体委托实现并行化,其中主协调器模型将不同的子任务分配给可以并发操作的专门智能体。

通过将并行处理与顺序(链式)和条件(路由)控制流集成,可以构建复杂的高性能计算系统,能够高效管理多样化和复杂的任务。

以下是关于并行化模式和相关概念的进一步阅读资源:

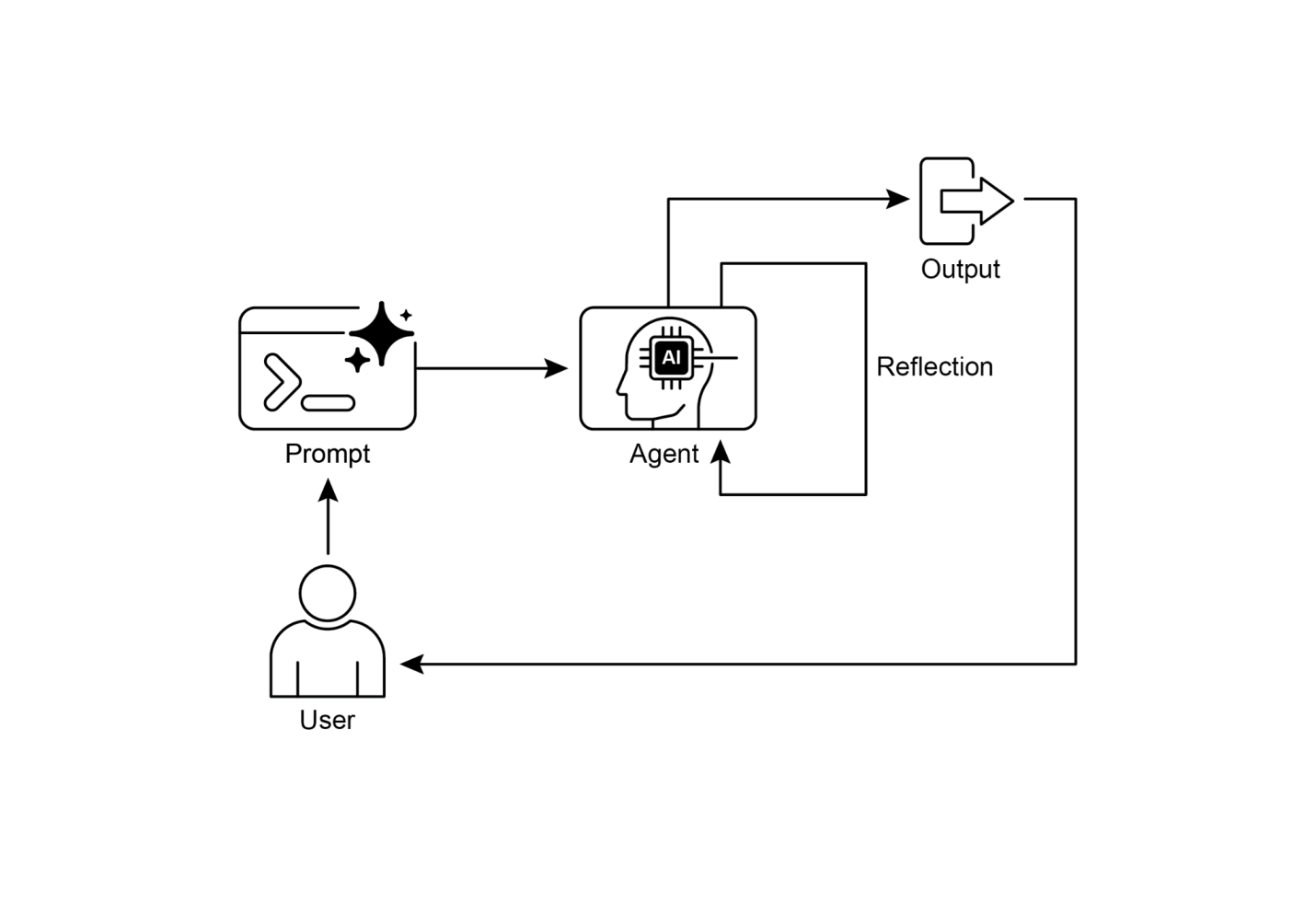

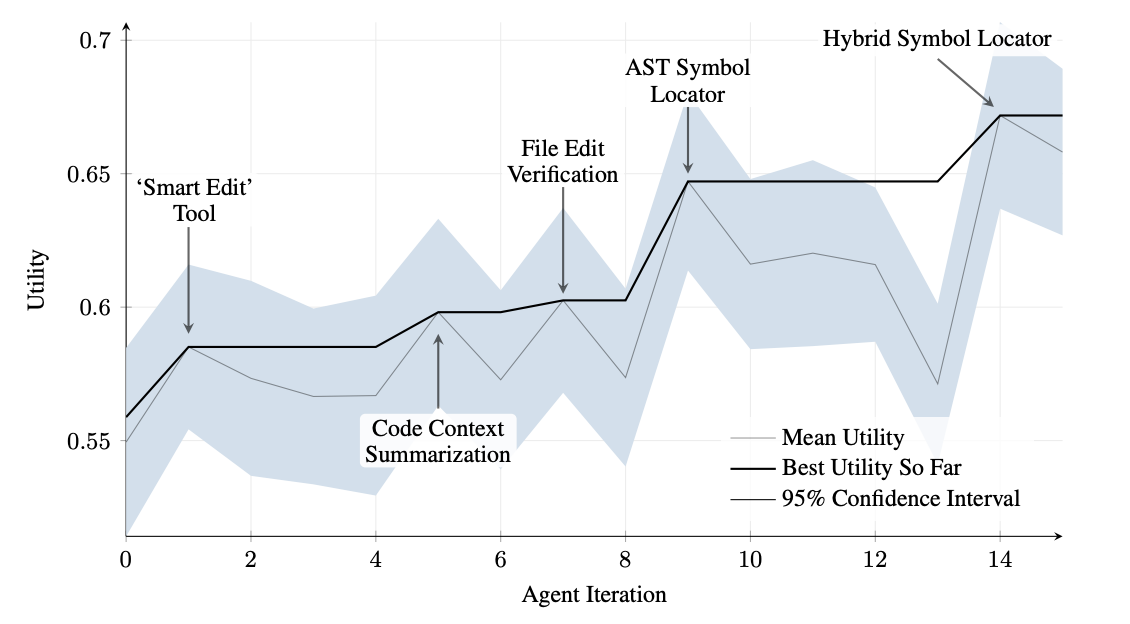

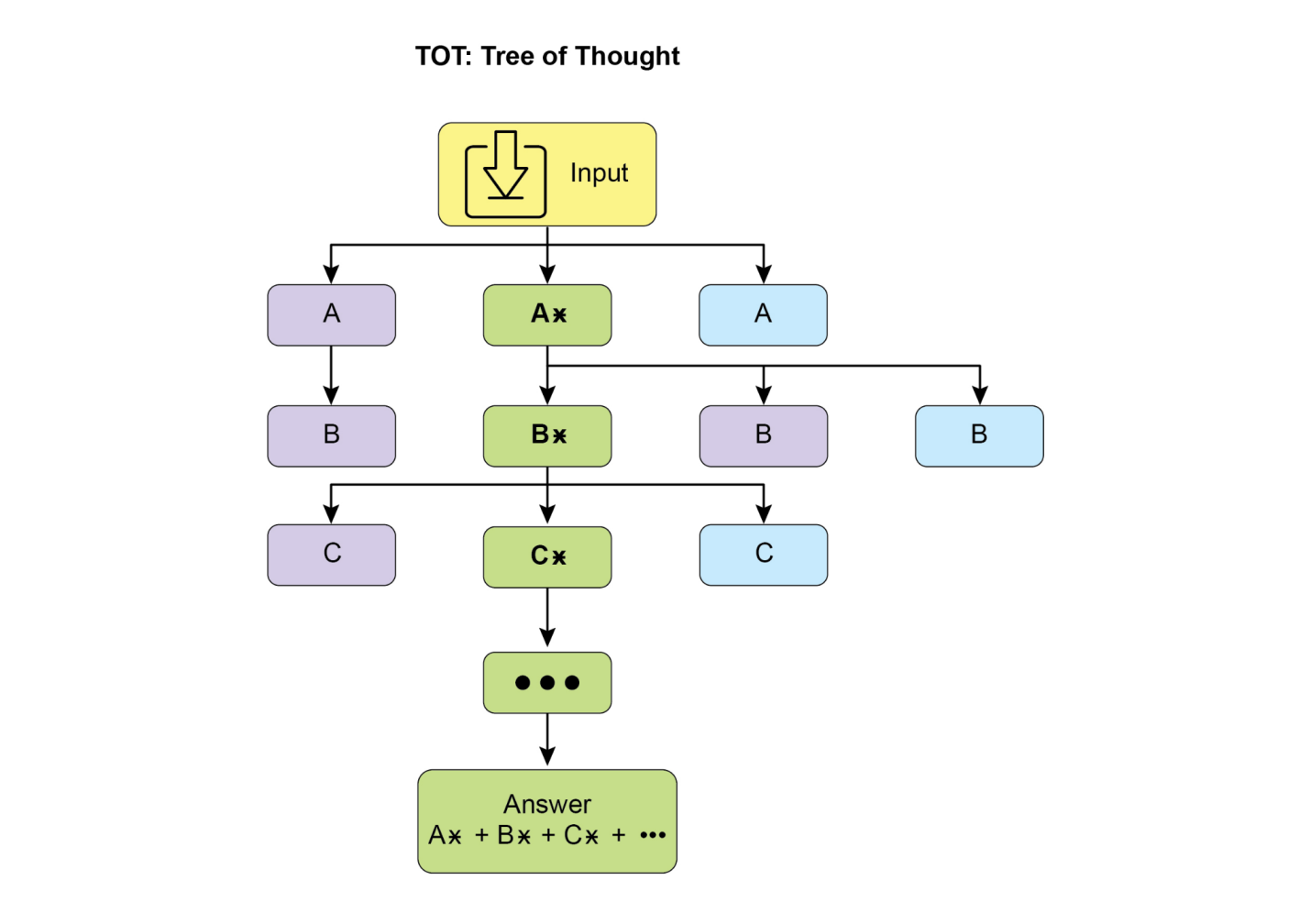

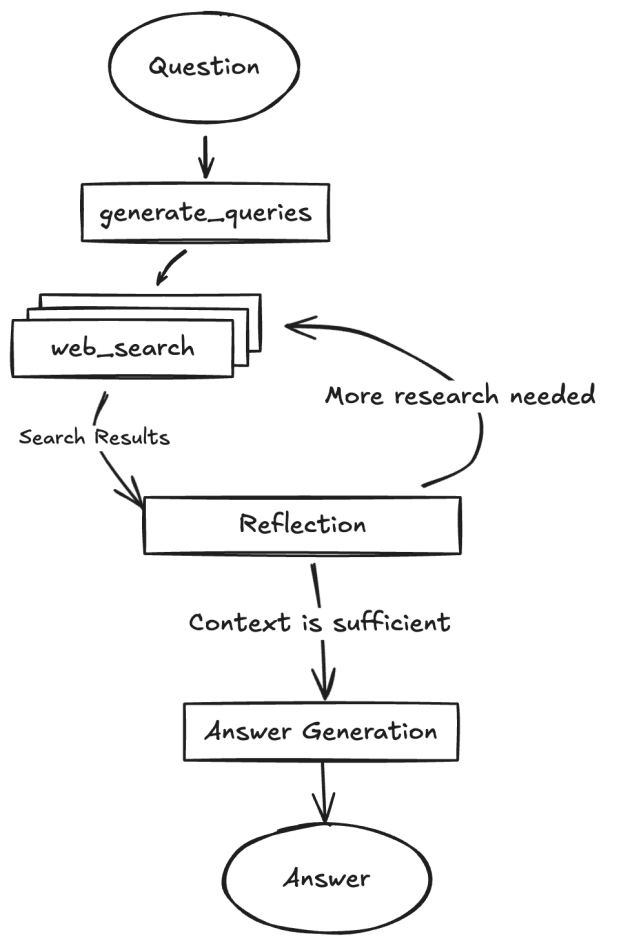

在前面的章节中,我们探讨了基本的智能体模式:用于顺序执行的链式模式、用于动态路径选择的路由模式,以及用于并发任务执行的并行化模式。这些模式使智能体能够更高效、更灵活地执行复杂任务。然而,即使有复杂的工作流,智能体的初始输出或计划可能也不是最优的、准确的或完整的。这就是反思模式发挥作用的地方。

反思模式涉及智能体评估自己的工作、输出或内部状态,并使用该评估来改进其性能或完善其响应。这是一种自我纠正或自我改进的形式,允许智能体基于反馈、内部批评或与期望标准的比较,迭代地完善其输出或调整其方法。反思有时可以由单独的智能体来促进,该智能体的特定作用是分析初始智能体的输出。

与简单的顺序链(输出直接传递给下一步)或选择路径的路由不同,反思引入了反馈循环。智能体不仅产生输出;然后它检查该输出(或生成它的过程),识别潜在问题或改进领域,并使用这些见解生成更好的版本或修改其未来行动。

该过程通常包括:

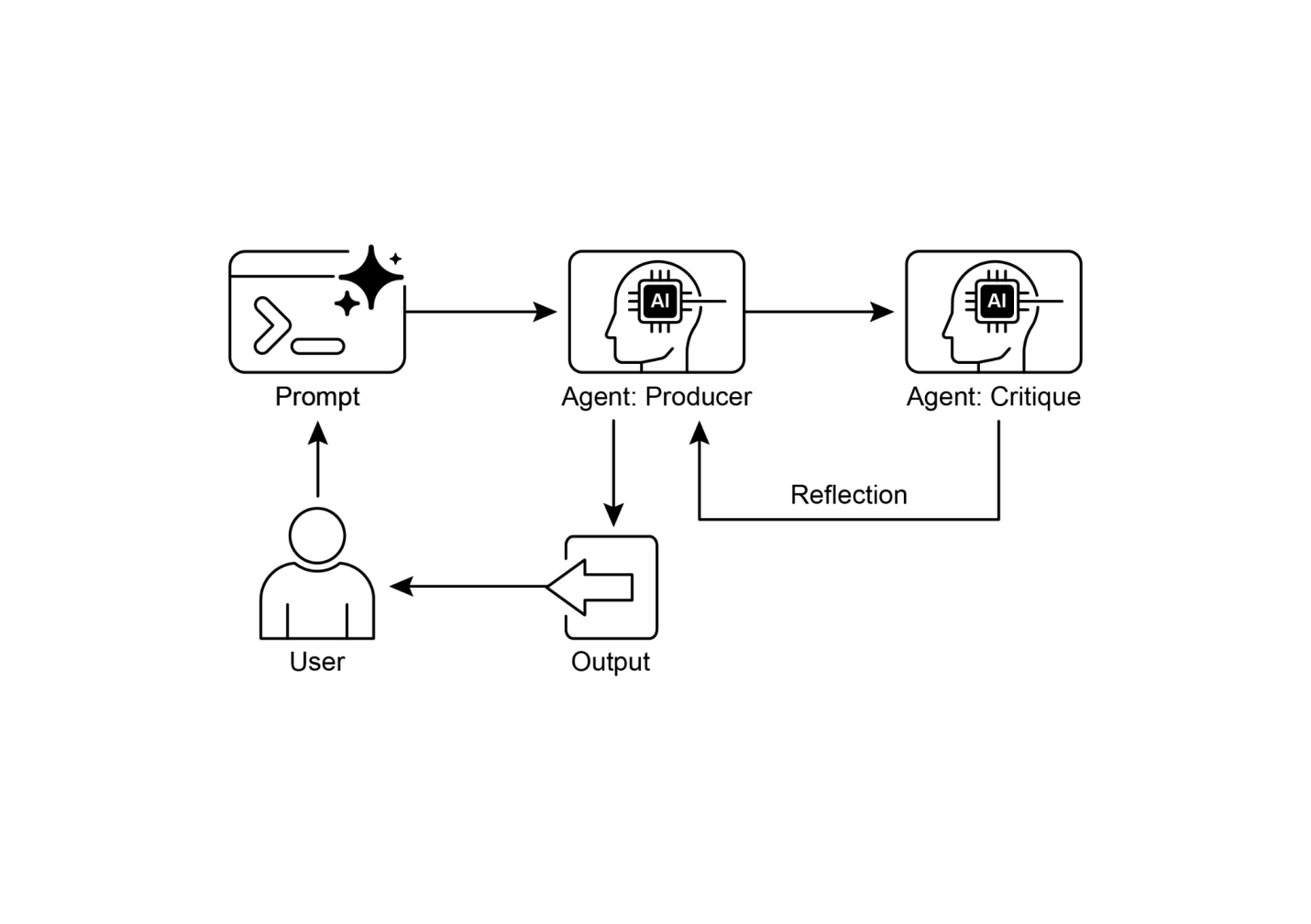

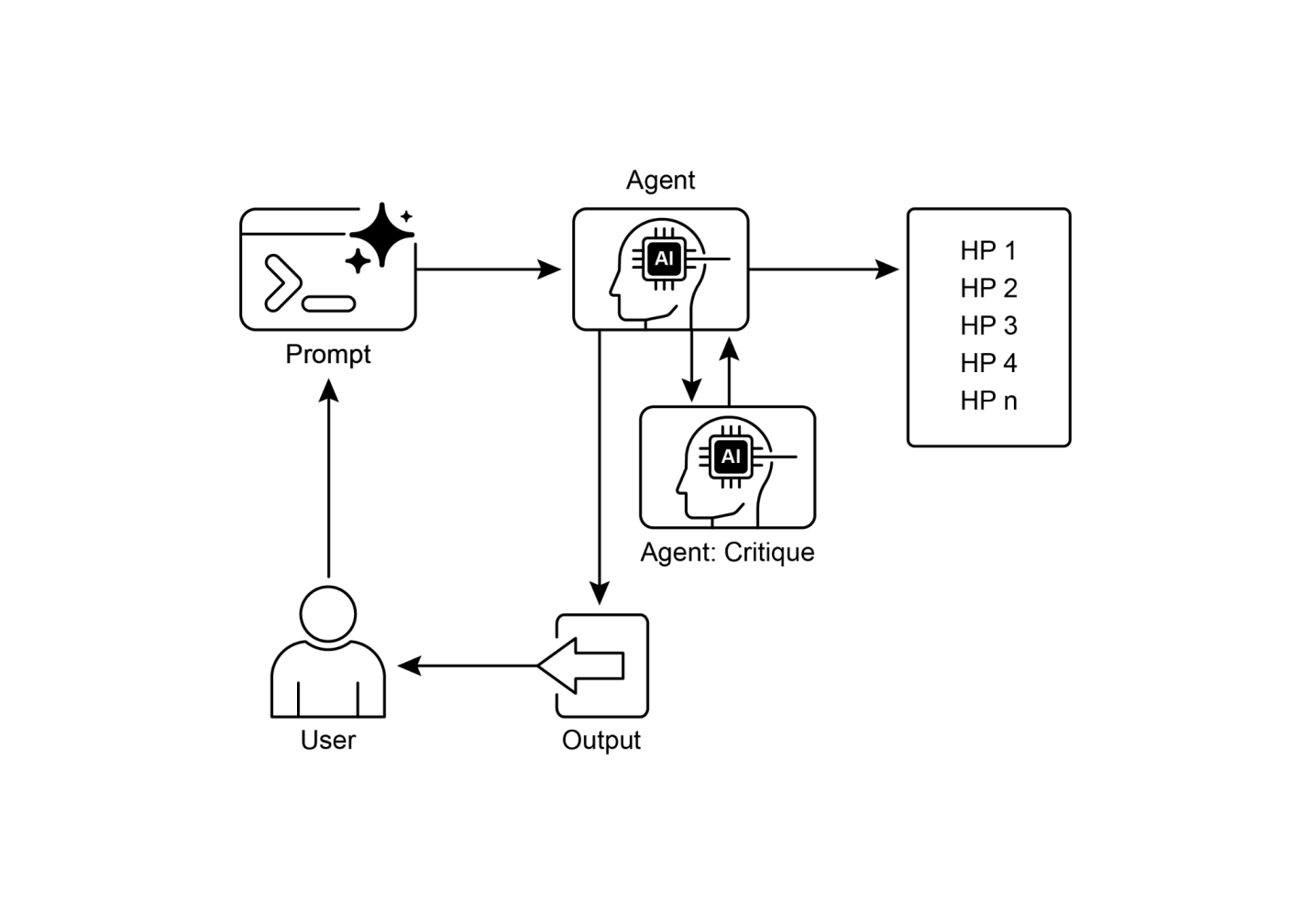

反思模式的一个关键且高效的实现将过程分为两个不同的逻辑角色:生产者和批评者。这通常被称为”生成器-批评者”或”生产者-审查者”模型。虽然单个智能体可以执行自我反思,但使用两个专门的智能体(或两个具有不同系统提示的独立LLM调用)通常会产生更稳健和无偏见的结果。

生产者智能体:该智能体的主要责任是执行任务的初始执行。它完全专注于生成内容,无论是编写代码、起草博客文章还是创建计划。它接受初始提示并产生输出的第一个版本。

批评者智能体:该智能体的唯一目的是评估生产者生成的输出。它被给予一套不同的指令,通常是一个不同的角色(例如,“你是一名高级软件工程师”,“你是一名细致的事实检查员”)。批评者的指令指导它根据特定标准分析生产者的工作,如事实准确性、代码质量、风格要求或完整性。它被设计来发现缺陷、建议改进并提供结构化反馈。

这种关注点分离是强大的,因为它防止了智能体审查自己工作时的”认知偏见”。批评者智能体以全新的视角处理输出,完全专注于发现错误和改进领域。批评者的反馈然后传回给生产者智能体,它将其作为指导来生成新的、完善的输出版本。提供的LangChain和ADK代码示例都实现了这种双智能体模型:LangChain示例使用特定的”reflector_prompt”来创建批评者角色,而ADK示例明确定义了生产者和审查者智能体。

实现反思通常需要构建智能体的工作流以包括这些反馈循环。这可以通过代码中的迭代循环,或使用支持状态管理和基于评估结果的条件转换的框架来实现。虽然单步评估和完善可以在LangChain/LangGraph、ADK或Crew.AI链中实现,但真正的迭代反思通常涉及更复杂的编排。

反射模式(Reflection pattern)对于构建能够产生高质量输出、处理细致任务并表现出一定程度的自我意识和适应性的智能体至关重要。它使智能体超越简单的指令执行,转向更复杂的问题解决和内容生成形式。

反射与目标设定和监控的交集值得注意(参见第11章)。目标为智能体的自我评估提供了最终基准,而监控则跟踪其进度。在许多实际案例中,反射可能充当纠正引擎,使用监控反馈来分析偏差并调整其策略。这种协同作用将智能体从被动执行者转变为有目的性的系统,能够适应性地工作以实现其目标。

此外,当大语言模型(LLM)保持对话记忆时(参见第8章),反射模式的效果会显著增强。这种对话历史为评估阶段提供了关键上下文,允许智能体不仅孤立地评估其输出,还能在先前交互、用户反馈和不断演变的目标的背景下进行评估。它使智能体能够从过去的批评中学习并避免重复错误。没有记忆,每次反射都是一个独立的事件;有了记忆,反射变成一个累积过程,其中每个周期都建立在上一个周期的基础上,导致更智能和更具上下文感知的改进。

反射模式在输出质量、准确性或遵守复杂约束至关重要的场景中很有价值:

改进生成的文本、故事、诗歌或营销文案。

● 用例: 智能体撰写博客文章。

○ 反射: 生成草稿,从流畅性、语调和清晰度方面进行批评,然后基于批评重写。重复此过程直到文章达到质量标准。

○ 收益: 产生更精炼和有效的内容。

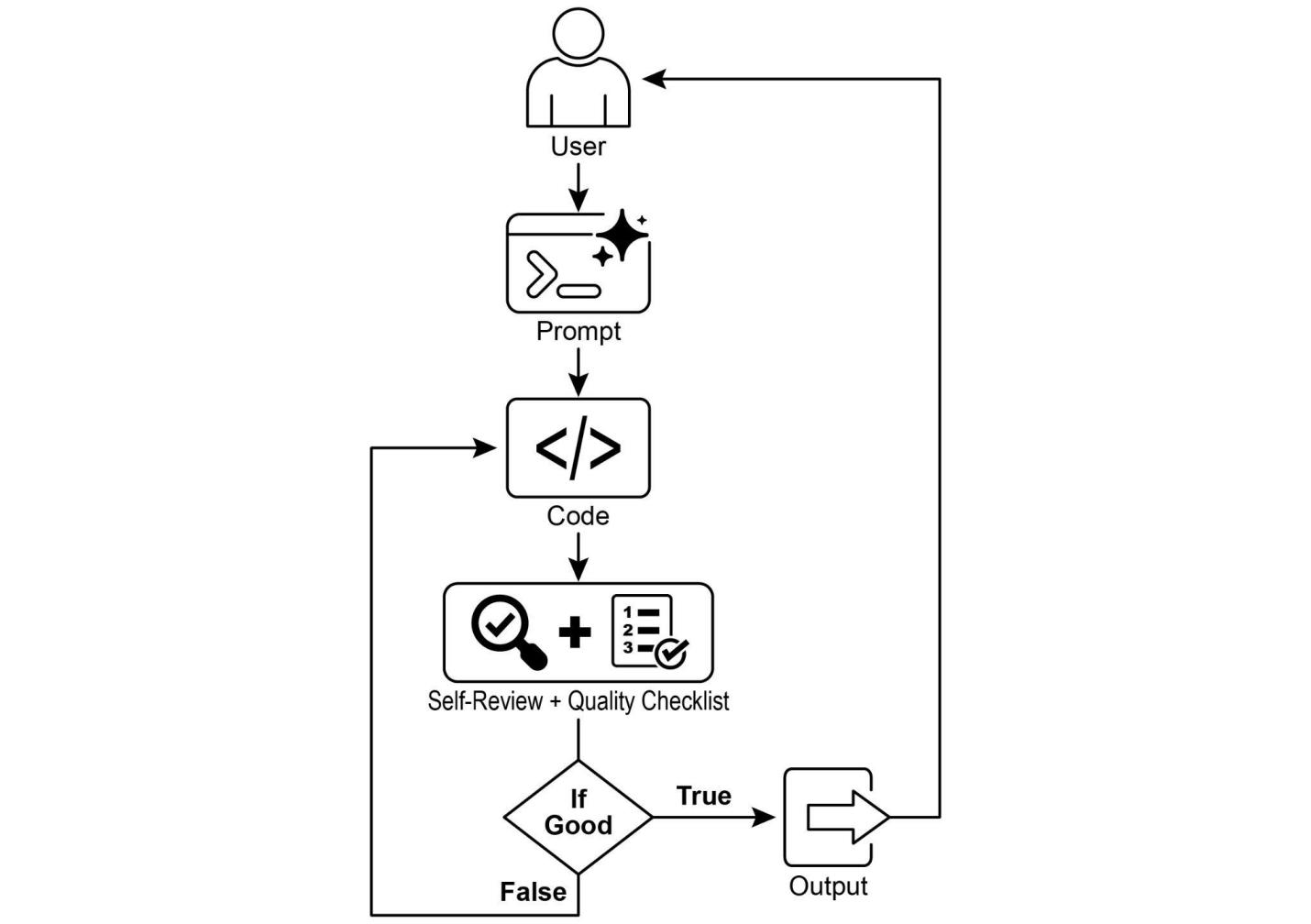

编写代码、识别错误并修复它们。

● 用例: 智能体编写Python函数。

○ 反射: 编写初始代码,运行测试或静态分析,识别错误或低效之处,然后基于发现的问题修改代码。

○ 收益: 生成更健壮和功能性的代码。

评估多步推理任务中的中间步骤或提议的解决方案。

● 用例: 智能体解决逻辑谜题。

○ 反射: 提出一个步骤,评估它是否更接近解决方案或引入矛盾,如果需要则回溯或选择不同的步骤。

○ 收益: 提高智能体在复杂问题空间中导航的能力。

改进摘要的准确性、完整性和简洁性。

● 用例: 智能体总结长文档。

○ 反射: 生成初始摘要,将其与原文档中的关键点进行比较,改进摘要以包含缺失信息或提高准确性。

○ 收益: 创建更准确和全面的摘要。

评估提议的计划并识别潜在缺陷或改进点。

● 用例: 智能体规划一系列行动来实现目标。

○ 反射: 生成计划,模拟其执行或根据约束评估其可行性,基于评估修改计划。

○ 收益: 制定更有效和现实的计划。

回顾对话中的先前轮次以保持上下文、纠正误解或提高响应质量。

● 用例: 客户支持聊天机器人。

○ 反射: 在用户响应后,回顾对话历史和最后生成的消息,以确保连贯性并准确地处理用户的最新输入。

○ 收益: 带来更自然和有效的对话。

反射为智能体系统添加了元认知层,使它们能够从自己的输出和过程中学习,从而获得更智能、可靠和高质量的结果。

实现完整的迭代反射过程需要状态管理和循环执行的机制。虽然这些在基于图的框架如LangGraph中是原生处理的,或者通过自定义程序代码处理,但单个反射周期的基本原理可以使用LCEL(LangChain表达式语言)的组合语法有效地演示。

这个示例使用Langchain库和OpenAI的GPT-4o模型实现反射循环,迭代地生成和改进一个计算数字阶乘的Python函数。该过程从任务提示开始,生成初始代码,然后基于模拟的高级软件工程师角色的批评反复反思代码,在每次迭代中改进代码,直到批评阶段确定代码是完美的或达到最大迭代次数。最后,它打印出最终改进的代码。

首先,确保您已安装必要的库:

pip install langchain langchain-community langchain-openai您还需要为您选择的语言模型设置环境和API密钥(例如,OpenAI、Google Gemini、Anthropic)。

import os

from dotenv import load_dotenv

from langchain_openai import ChatOpenAI

from langchain_core.prompts import ChatPromptTemplate

from langchain_core.messages import SystemMessage, HumanMessage

# --- 配置 ---

# 从 .env 文件加载环境变量(用于 OPENAI_API_KEY)

load_dotenv()

# 检查是否设置了 API 密钥

if not os.getenv("OPENAI_API_KEY"):

raise ValueError("在 .env 文件中未找到 OPENAI_API_KEY。请添加它。")

# 初始化聊天 LLM(大语言模型)。我们使用 gpt-4o 来获得更好的推理能力。

# 使用较低的温度以获得更确定性的输出。

llm = ChatOpenAI(model="gpt-4o", temperature=0.1)

def run_reflection_loop():

"""

演示一个多步骤AI反思循环,以逐步改进Python函数。

"""

# --- 核心任务 ---

task_prompt = """calculate_factorial 的 Python 函数。] |n 作为输入。] |[代码开始时设置环境,加载API密钥,并初始化一个强大的语言模型如GPT-4o,使用低温度参数以获得聚焦的输出。核心任务由一个提示定义,要求提供一个Python函数来计算数字的阶乘,包括文档字符串的具体要求、边界情况(0的阶乘)以及负数输入的错误处理。run_reflection_loop函数编排迭代优化过程。在循环中,第一次迭代时,语言模型根据任务提示生成初始代码。在后续迭代中,它根据前一步的批评来优化代码。一个独立的”反思者”角色,同样由语言模型扮演但使用不同的系统提示,充当高级软件工程师来批评生成的代码是否符合原始任务要求。这种批评以问题的项目符号列表形式提供,或者如果没有发现问题则使用短语’CODE_IS_PERFECT’。循环持续进行,直到批评表明代码完美或达到最大迭代次数。对话历史被维护并在每一步传递给语言模型,为生成/优化和反思阶段提供上下文。最后,脚本在循环结束后打印最后生成的代码版本。]

[现在让我们看一个使用Google ADK实现的概念代码示例。具体来说,该代码通过采用生成器-批评者结构来展示这一点,其中一个组件(生成器)产生初始结果或计划,另一个组件(批评者)提供批评反馈或批评,引导生成器朝着更精细或准确的最终输出方向发展。]

from google.adk.agents import SequentialAgent, LlmAgent

# 第一个代理生成初始草稿。

generator = LlmAgent(

name="DraftWriter",

description="在给定主题上生成初始草稿内容。",

instruction="写一个关于用户主题的简短信息性段落。",

output_key="draft_text" # 输出保存到此状态键

)

# 第二个代理批评第一个代理的草稿。

reviewer = LlmAgent(

name="FactChecker",

description="审查给定文本的事实准确性并提供结构化批评。",

instruction="""

你是一个细致的事实核查员。这段代码演示了在Google ADK(Agent Development Kit)中使用顺序代理流水线(sequential agent pipeline)来生成和审核文本的方法。它定义了两个LlmAgent实例:生成器(generator)和审核器(reviewer)。生成器代理被设计用来在给定主题上创建初始草稿段落。它被指示编写简短且信息丰富的内容,并将其输出保存到状态键draft_text中。审核器代理作为生成器产生文本的事实检查器。它被指示从draft_text中读取文本并验证其事实准确性。审核器的输出是一个结构化的字典,包含两个键:status和reasoning。status表示文本是”ACCURATE”(准确)还是”INACCURATE”(不准确),reasoning提供状态的解释说明。这个字典被保存到状态键review_output中。创建了一个名为review_pipeline的SequentialAgent来管理两个代理的执行顺序。它确保生成器先运行,然后是审核器。整个执行流程是生成器产生文本,然后保存到状态中。随后,审核器从状态中读取这个文本,执行事实检查,并将其发现(status和reasoning)保存回状态中。这个流水线允许使用独立的代理进行结构化的内容创建和审核过程。

注意:对于那些感兴趣的人,还有一个利用ADK的LoopAgent的替代实现可供选择。

在总结之前,重要的是要考虑到尽管反思模式(Reflection pattern)显著提高了输出质量,但它也带来了重要的权衡。迭代过程虽然强大,但可能导致更高的成本和延迟,因为每次改进循环可能需要新的LLM调用,这使其对时间敏感的应用程序来说并不理想。此外,该模式是内存密集型的;在每次迭代中,对话历史会扩展,包括初始输出、批评和后续改进。

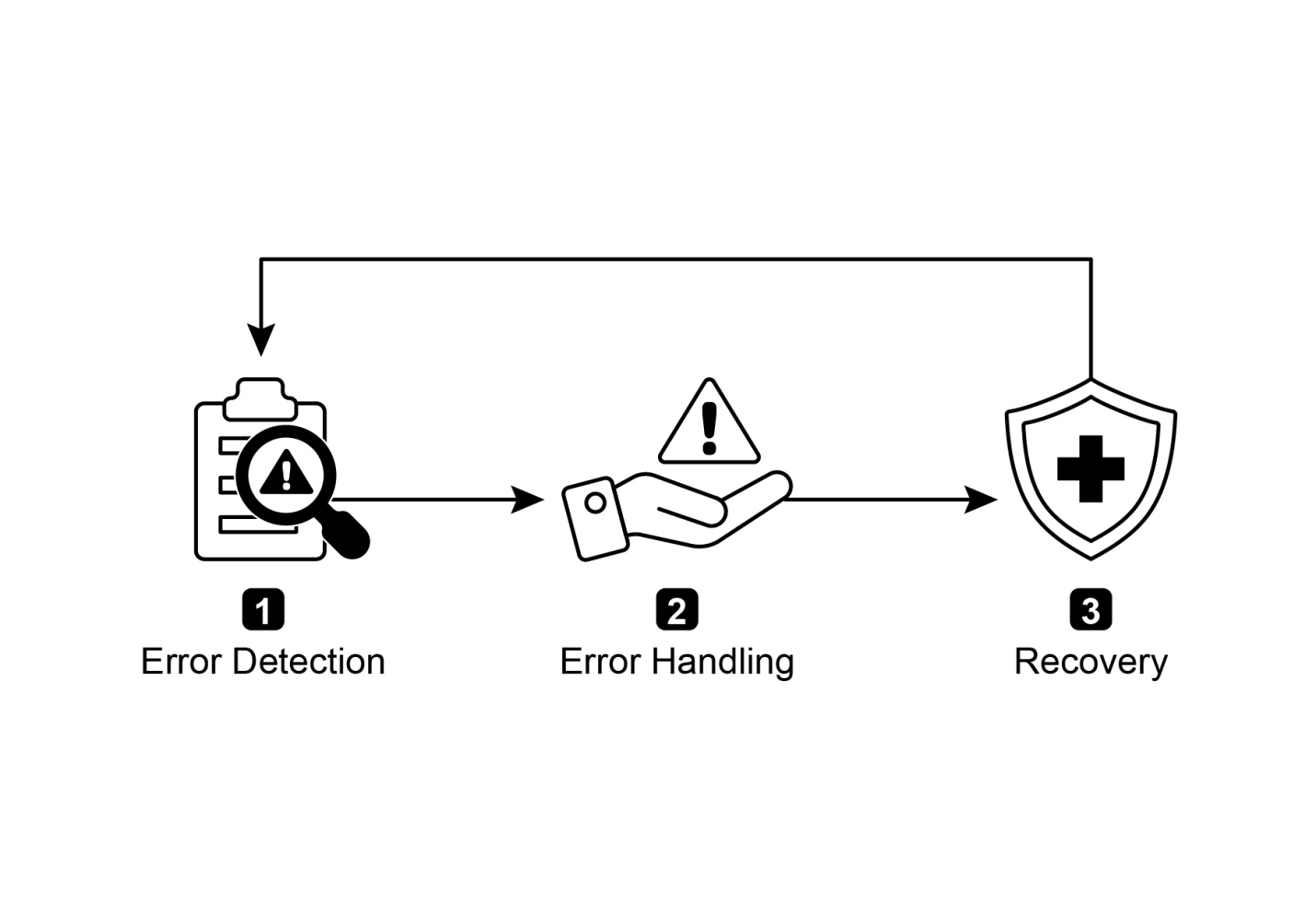

什么:代理的初始输出通常是次优的,存在不准确、不完整或未能满足复杂需求的问题。基础代理工作流缺乏内置的过程让代理识别并修复自己的错误。这通过让代理评估自己的工作来解决,或者更稳健的方法是引入一个单独的逻辑代理作为批评者,防止初始响应成为最终结果,无论其质量如何。

为什么:反思模式通过引入自我纠正和改进机制提供了解决方案。它建立了一个反馈循环,其中”生产者”代理生成输出,然后”批评者”代理(或生产者本身)根据预定义的标准对其进行评估。然后使用这种批评来生成改进的版本。这种生成、评估和改进的迭代过程逐步提高最终结果的质量,导致更准确、连贯和可靠的结果。

经验法则:当最终输出的质量、准确性和细节比速度和成本更重要时,使用反思模式。它对于生成精雕细琢的长篇内容、编写和调试代码以及创建详细计划等任务特别有效。当任务需要高客观性或通用生产者代理可能遗漏的专业化评估时,采用单独的批评者代理。

视觉总结

图1:反思设计模式,自我反思

图2:反思设计模式,生产者和批评代理

● 反思模式的主要优势是其迭代自我纠正和改进输出的能力,导致显著更高的质量、准确性和对复杂指令的遵循。

● 它涉及执行、评估/批评和改进的反馈循环。反思对于需要高质量、准确或细致入微输出的任务是必不可少的。

● 一个强大的实现是生产者-批评者模型,其中一个单独的代理(或提示的角色)评估初始输出。这种关注点分离增强了客观性,并允许更专业、结构化的反馈。

● 然而,这些好处是以增加延迟和计算费用为代价的,同时还有超过模型上下文窗口或被API服务限制的更高风险。

● 虽然完整的迭代反思通常需要有状态的工作流(如LangGraph),但可以在LangChain中使用LCEL实现单一反思步骤,将输出传递给批评和后续改进。

● Google ADK可以通过顺序工作流促进反思,其中一个代理的输出被另一个代理批评,允许后续的改进步骤。

● 这种模式使代理能够执行自我纠正并随时间增强其性能。

反思模式为代理工作流中的自我纠正提供了关键机制,使其能够进行超越单次执行的迭代改进。这通过创建一个循环来实现,系统生成输出,根据特定标准对其进行评估,然后使用该评估来产生改进的结果。这种评估可以由代理本身执行(自我反思),或者更有效的方法是由一个独特的批评者代理执行,这代表了该模式中的关键架构选择。

虽然一个完全自主的、多步骤反思过程需要一个强大的状态管理架构,但它的核心原则可以在单个生成-批判-完善循环中得到有效演示。作为一种控制结构,反思可以与其他基础模式集成,构建更强大且功能更复杂的智能体系统。

以下是关于反思模式和相关概念的进一步阅读资源:

第五章:工具使用(函数调用)

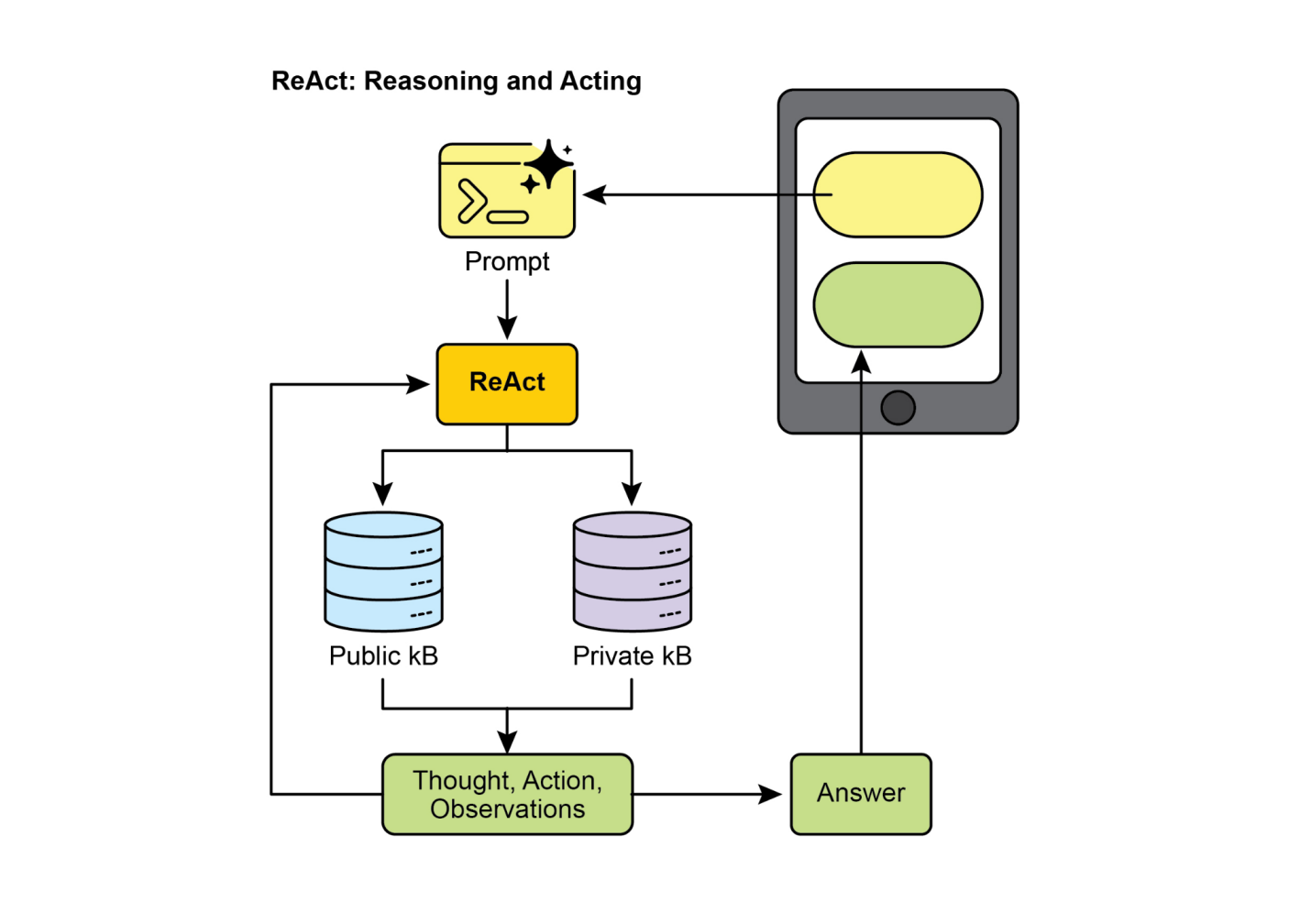

到目前为止,我们已经讨论了主要涉及编排语言模型之间交互和管理智能体内部工作流程信息流的智能体模式(链式、路由、并行化、反思)。然而,要使智能体真正有用并与现实世界或外部系统交互,它们需要具备使用工具的能力。

工具使用模式,通常通过一种称为函数调用的机制来实现,使智能体能够与外部API、数据库、服务交互,甚至执行代码。它允许智能体核心的LLM根据用户的请求或任务的当前状态来决定何时以及如何使用特定的外部函数。

该过程通常包括:

这种模式是基础性的,因为它突破了LLM训练数据的限制,允许它访问最新信息、执行内部无法完成的计算、与用户特定数据交互,或触发现实世界的行动。函数调用是连接LLM推理能力和可用外部功能广泛阵列之间的技术机制。

虽然”函数调用”准确地描述了调用特定、预定义代码函数,但考虑更广泛的”工具调用”概念是有用的。这个更宽泛的术语承认智能体的能力可以远远超出简单的函数执行。“工具”可以是传统函数,但也可以是复杂的API端点、对数据库的请求,甚至是指向另一个专业智能体的指令。这种视角允许我们设想更复杂的系统,例如,主智能体可能将复杂的数据分析任务委托给专门的”分析师智能体”,或通过其API查询外部知识库。从”工具调用”的角度思考更好地捕捉了智能体作为数字资源和其他智能实体多样化生态系统中编排者的全部潜力。

像LangChain、LangGraph和Google智能体开发工具包(ADK)等框架为定义工具并将其集成到智能体工作流程中提供了强大支持,通常利用现代LLM(如Gemini或OpenAI系列)的本机函数调用能力。在这些框架的”画布”上,您可以定义工具,然后配置智能体(通常是LLM智能体)以了解并能够使用这些工具。

工具使用是构建强大、交互式和外部感知智能体的基石模式。

工具使用模式适用于几乎任何智能体需要超越生成文本以执行操作或检索特定动态信息的场景:

访问LLM训练数据中不存在的实时数据或信息。

● 用例:天气智能体。

○[工具:[ 一个天气API,接收位置参数并返回当前天气状况。]]

○[智能体流程:[ 用户询问”伦敦的天气如何?“,LLM识别需要使用天气工具,使用”伦敦”参数调用工具,工具返回数据,LLM将数据格式化为用户友好的响应。]]

对结构化数据执行查询、更新或其他操作。

●[用例:[ 电子商务智能体(agent)。]]

○[工具:[ API调用来检查产品库存、获取订单状态或处理付款。]]

○[智能体流程:[ 用户询问”产品X有库存吗?“,LLM调用库存API,工具返回库存数量,LLM告知用户库存状态。]]

使用外部计算器、数据分析库或统计工具。

●[用例:[ 金融智能体。]]

○[工具:[ 计算器函数、股票市场数据API、电子表格工具。]]

○[智能体流程:[ 用户询问”AAPL的当前价格是多少?如果我以150美元买入100股,计算一下潜在利润?“,LLM调用股票API获取当前价格,然后调用计算器工具,获得结果,格式化响应。]]

发送邮件、消息或向外部通信服务发起API调用。

●[用例:[ 个人助理智能体。]]

○[工具:[ 邮件发送API。]]

○[智能体流程:[ 用户说”给约翰发邮件讨论明天的会议”,LLM使用从请求中提取的收件人、主题和正文调用邮件工具。]]

在安全环境中运行代码片段以执行特定任务。

●[用例:[ 编程助手智能体。]]

○[工具:[ 代码解释器。]]

○[智能体流程:[ 用户提供Python代码片段并询问”这段代码是做什么的?“,LLM使用解释器工具运行代码并分析其输出。]]

与智能家居设备、物联网(IoT)平台或其他连接系统进行交互。

●[用例:[ 智能家居智能体。]]

○[工具:[ 控制智能灯光的API。]]

○[智能体流程:[ 用户说”关闭客厅灯光”,LLM使用命令和目标设备调用智能家居工具。]]

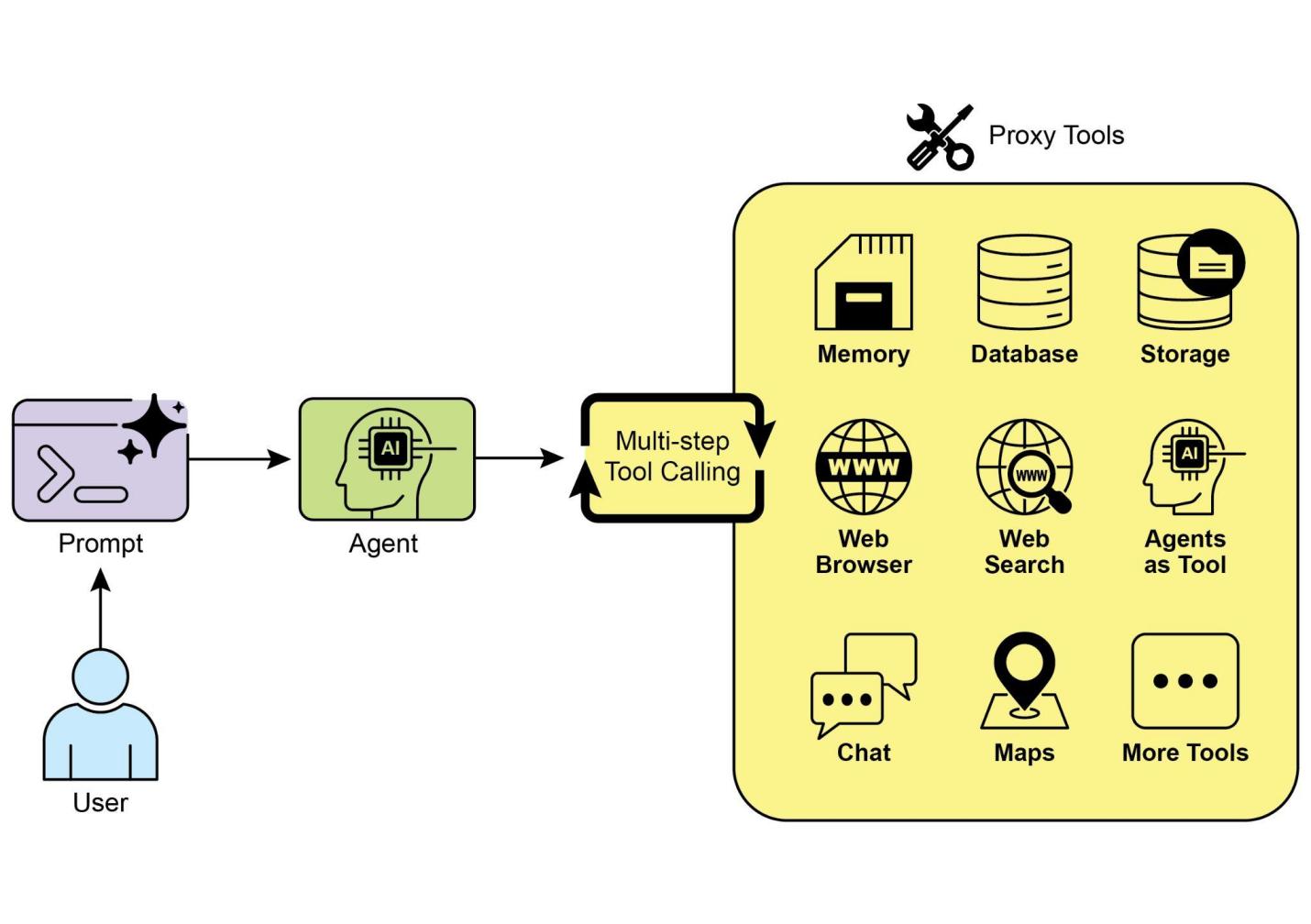

工具使用是将语言模型从文本生成器转变为能够在数字或物理世界中感知、推理和行动的智能体的关键(见图1)

图1:智能体使用工具的示例

在LangChain框架中实现工具使用是一个两阶段过程。首先,定义一个或多个工具,通常通过封装现有的Python函数或其他可运行组件来实现。随后,将这些工具绑定到语言模型,从而授予模型生成结构化工具使用请求的能力,当模型确定需要外部函数调用来满足用户查询时。

以下实现将通过首先定义一个简单函数来模拟信息检索工具来演示这一原理。接下来,将构建并配置一个智能体,使其能够根据用户输入利用此工具。此示例的执行需要安装核心LangChain库和特定模型的提供商包。此外,与所选语言模型服务的正确身份验证(通常通过在本地环境中配置的API密钥)是必要的前提条件。

+——————————————————————————————————————————————-+ | import os, getpass | | | | import asyncio | | | | import nest_asyncio | | | | from typing import List | | | | from dotenv import load_dotenv | | | | import logging | | | | | | |

|提供关于给定主题的事实信息。使用此工具查找类似| |“法国首都”或”伦敦天气?“等短语的答案。| |print(f”\n— 🛠️ 调用工具:search_information,查询:‘{query}’ —“)| |# 使用预定义结果字典模拟搜索工具。| |simulated_results = {| |”weather in london”: “伦敦当前天气多云,温度15°C。”,| |“capital of france”: “法国的首都是巴黎。”,| |“population of earth”: “地球的估计人口约为80亿人。”,| |“tallest mountain”: “珠穆朗玛峰是海拔最高的山峰。”,| |“default”: f”’{query}’的模拟搜索结果:未找到具体信息,但该主题似乎很有趣。“| |}| |result = simulated_results.get(query.lower(), simulated_results[”default”])| |print(f”— 工具结果:{result} —“)| |return result|

tools = [search_information]

if llm:

|#

此提示模板需要一个agent_scratchpad占位符用于代理的内部步骤。|

代码使用LangChain库和Google Gemini模型设置了一个工具调用代理。它定义了一个search_information工具,模拟对特定查询提供事实性答案。该工具对”伦敦天气”、“法国首都”和”地球人口”有预定义响应,对其他查询有默认响应。初始化一个ChatGoogleGenerativeAI模型,确保其具有工具调用能力。创建一个ChatPromptTemplate来指导代理的交互。使用create_tool_calling_agent函数将语言模型、工具和提示组合成一个代理。然后设置一个AgentExecutor来管理代理的执行和工具调用。定义run_agent_with_tool异步函数来用给定查询调用代理并打印结果。main异步函数准备多个查询以并发运行。这些查询设计用于测试search_information工具的特定响应和默认响应。最后,asyncio.run(main())调用执行所有代理任务。代码包括在继续代理设置和执行之前检查LLM初始化是否成功。

此代码提供了如何在CrewAI框架内实现函数调用(工具)的实际示例。它设置了一个简单场景,其中代理配备了查找信息的工具。该示例具体演示了使用此代理和工具获取模拟股票价格。

+—————————————————————————————————————————————————+ | # pip install crewai langchain-openai | | | | | | |

),

expected_output=(

[ “一个清晰的句子,说明AAPL的模拟股价。” ]

[ “例如:‘AAPL的模拟股价为$178.15。’” ]

[ “如果无法找到价格,请明确说明。”]

),

agent=financial_analyst_agent,

)

financial_crew = Crew(

agents=[financial_analyst_agent],

tasks=[analyze_aapl_task],

verbose=True # 在生产环境中设置为False以减少详细日志

)

def main():

"""运行团队的主函数。"""

# 在开始之前检查API密钥以避免运行时错误

if not os.environ.get("OPENAI_API_KEY"):

print("错误:未设置OPENAI_API_KEY环境变量。")

print("请在运行脚本之前设置它。")

return

print("\n## 启动财务团队...")

print("--------------------------------")

# kickoff方法启动执行

result = financial_crew.kickoff()

print("\n--------------------------------")

print("## 团队执行完成。")

print("\n最终结果:\n", result)

if __name__ == "__main__":

main()这段代码演示了一个使用Crew.ai库模拟金融分析任务的简单应用。它定义了一个自定义工具get_stock_price,用于模拟查找预定义股票代码的股价。该工具设计为对有效股票代码返回浮点数,对无效股票代码抛出ValueError异常。创建了一个名为financial_analyst_agent的Crew.ai代理(Agent),角色为高级金融分析师。该代理被分配了get_stock_price工具进行交互。定义了一个任务analyze_aapl_task,明确指示代理使用工具查找AAPL的模拟股价。任务描述包含了使用工具时如何处理成功和失败情况的明确指示。组建了一个工作组(Crew),由financial_analyst_agent和analyze_aapl_task组成。代理和工作组都启用了详细设置,以在执行期间提供详细的日志记录。脚本的主要部分在标准的if __name__ == “__main__”:块中使用kickoff()方法运行工作组的任务。在启动工作组之前,它检查是否设置了OPENAI_API_KEY环境变量,这是代理正常运行所必需的。工作组执行的结果(即任务的输出)随后会打印到控制台。代码还包含基本的日志配置,以便更好地跟踪工作组的操作和工具调用。它使用环境变量进行API密钥管理,但注意到在生产环境中建议使用更安全的方法。简而言之,核心逻辑展示了如何定义工具、代理和任务,以在Crew.ai中创建协作工作流。

from google.adk.agents import Agent

from google.adk.runners import Runner

from google.adk.sessions import InMemorySessionService

from google.adk.tools import google_search

from google.genai import types

import nest_asyncio

import asyncio

# 定义会话设置和代理执行所需的变量

APP_NAME="Google Search_agent"

USER_ID="user1234"

SESSION_ID="1234"

# 定义具有搜索工具访问权限的代理

root_agent = ADKAgent(此代码演示了如何创建和使用由Google ADK for Python驱动的基础代理(agent)。该代理旨在通过使用Google搜索作为工具来回答问题。首先,从IPython、google.adk和google.genai导入必要的库。定义应用程序名称、用户ID和会话ID的常量。创建一个名为”basic_search_agent”的Agent实例,包含描述其用途的说明和指令。它被配置为使用Google搜索工具,这是ADK提供的预构建工具。初始化InMemorySessionService(参见第8章)来管理代理的会话。为指定的应用程序、用户和会话ID创建新会话。实例化Runner,将创建的代理与会话服务链接。此运行器负责在会话中执行代理的交互。定义辅助函数call_agent以简化向代理发送查询和处理响应的过程。在call_agent内部,用户的查询被格式化为types.Content对象,角色为’user’。使用用户ID、会话ID和新消息内容调用runner.run方法。runner.run方法返回表示代理操作和响应的事件列表。代码遍历这些事件以找到最终响应。如果事件被识别为最终响应,则提取该响应的文本内容。然后将提取的代理响应打印到控制台。最后,使用查询”what’s the latest ai news?“调用call_agent函数来演示代理的运行。

Google ADK具有专门任务的集成组件,包括动态代码执行环境。built_in_code_execution工具为代理提供了沙盒Python解释器。这允许模型编写和运行代码来执行计算任务、操作数据结构和执行过程脚本。这种功能对于解决需要确定性逻辑和精确计算的问题至关重要,这些问题超出了单纯概率性语言生成的范围。

async def call_agent_async(query):

# Session 和 Runner

session_service = InMemorySessionService()

session = await session_service.create_session(app_name=APP_NAME, user_id=USER_ID, session_id=SESSION_ID)

runner = Runner(agent=code_agent, app_name=APP_NAME, session_service=session_service)

content = types.Content(role='user', parts=[types.Part(text=query)])

print(f"\n--- Running Query: {query} ---")

final_response_text = "No final text response captured."

try:

# 使用 run_async

async for event in runner.run_async(user_id=USER_ID, session_id=SESSION_ID, new_message=content):

print(f"Event ID: {event.id}, Author: {event.author}")

# --- 首先检查特定部分 ---

# has_specific_part = False

if event.content and event.content.parts and event.is_final_response():

for part in event.content.parts: # 遍历所有部分# 运行示例的主要异步函数

async def main():

await call_agent_async("计算 (5 + 7) * 3 的值")

await call_agent_async("10的阶乘是多少?")

# 执行主要异步函数

try:

nest_asyncio.apply()

asyncio.run(main())

except RuntimeError as e:

# 处理在已运行循环中运行 asyncio.run 时的特定错误(如 Jupyter/Colab)

if "cannot be called from a running event loop" in str(e):

print("\n在现有事件循环中运行(如 Colab/Jupyter)。")

print("请在笔记本单元格中运行 `await main()` 代替。")

# 如果在交互式环境(如笔记本)中,您可能需要运行:

# await main()

else:

raise e # 重新抛出其他运行时错误这个脚本使用了Google的Agent Development Kit (ADK)来创建一个通过编写和执行Python代码来解决数学问题的agent。它定义了一个专门被指示为计算器的LlmAgent,并为其配备了built_in_code_execution工具。主要逻辑位于call_agent_async函数中,该函数将用户查询发送给agent的runner并处理产生的事件。在这个函数内部,一个异步循环遍历事件,打印生成的Python代码及其执行结果用于调试。代码仔细区分了这些中间步骤和包含数值答案的最终事件。最后,一个main函数用两个不同的数学表达式运行agent,以展示其执行计算的能力。

这段代码定义了一个使用Python中google.adk库的Google ADK应用程序。它专门使用VSearchAgent,该agent旨在通过搜索指定的Vertex AI Search数据存储来回答问题。代码初始化了一个名为”q2_strategy_vsearch_agent”的VSearchAgent,提供了描述、要使用的模型(“gemini-2.0-flash-exp”)以及Vertex AI Search数据存储的ID。DATASTORE_ID预期作为环境变量设置。然后为agent设置一个Runner,使用InMemorySessionService来管理对话历史。定义了一个异步函数call_vsearch_agent_async来与agent交互。该函数接受一个查询,构造消息内容对象,并调用runner的run_async方法将查询发送给agent。然后该函数将agent的响应在到达时流式传输回控制台。它还打印关于最终响应的信息,包括来自数据存储的任何来源归属。包含了错误处理来捕获agent执行期间的异常,提供关于潜在问题的信息性消息,如不正确的数据存储ID或缺失的权限。提供了另一个异步函数run_vsearch_example来演示如何使用示例查询调用agent。主执行块检查是否设置了DATASTORE_ID,然后使用asyncio.run运行示例。它包含一个检查来处理代码在已经运行事件循环的环境中运行的情况,如Jupyter notebook。

import asyncio

from google.genai import types

from google.adk import agents

from google.adk.runners import Runner

from google.adk.sessions import InMemorySessionService

import os

# --- 配置 ---

# 确保你已经设置了GOOGLE_API_KEY和DATASTORE_ID环境变量

# 例如:

# os.environ["GOOGLE_API_KEY"] = "YOUR_API_KEY"

# os.environ["DATASTORE_ID"] = "YOUR_DATASTORE_ID"async def call_vsearch_agent_async(query: str):

"""初始化一个会话并流式传输代理的响应。"""

print(f"用户: {query}")

print("代理: ", end="", flush=True)

try:

# 正确构造消息内容

content = types.Content(role='user', parts=[types.Part(text=query)])

# 处理从异步运行器到达的事件

async for event in runner.run_async(

user_id=USER_ID,

session_id=SESSION_ID,

new_message=content

):

# 用于响应文本的逐个token流式传输

if hasattr(event, 'content_part_delta') and event.content_part_delta:

print(event.content_part_delta.text, end="", flush=True)

# 处理最终响应及其关联的元数据

if event.is_final_response():print() # 流式响应后的换行

if event.grounding_metadata:

print(f" (来源归属: 找到{len(event.grounding_metadata.grounding_attributions)}个来源)")

else:

print(" (未找到基础元数据)")

print("-" * 30)

except Exception as e:

print(f"\n发生错误: {e}")

print("请确保您的数据存储ID正确,并且服务账户具有必要的权限。")

print("-" * 30)

# --- 运行示例 ---

async def run_vsearch_example():

# 替换为与您的数据存储内容相关的问题

await call_vsearch_agent_async("总结Q2战略文档的要点。")

await call_vsearch_agent_async("实验室X提到了哪些安全程序?")

# --- 执行 ---

if __name__ == "__main__":

if not DATASTORE_ID:

print("错误: DATASTORE_ID环境变量未设置。")

else:try:

asyncio.run(run_vsearch_example())

except RuntimeError as e:

# 这处理在已有运行的事件循环的环境中调用asyncio.run的情况

# (例如Jupyter notebook)

if "cannot be called from a running event loop" in str(e):

print("在运行中的事件循环中跳过执行。请直接运行此脚本。")

else:

raise e总的来说,这段代码为构建利用Vertex AI Search回答基于数据存储中信息的问题的对话式AI应用程序提供了基本框架。它演示了如何定义智能体(agent)、设置运行器,并在流式传输响应的同时异步与智能体交互。重点是从特定数据存储中检索和综合信息来回答用户查询。

Vertex扩展: Vertex AI扩展是结构化的API包装器,使模型能够连接外部API进行实时数据处理和动作执行。扩展提供企业级安全性、数据隐私和性能保证。它们可用于生成和运行代码、查询网站以及分析私有数据存储中的信息等任务。Google为常见用例提供预构建扩展,如代码解释器(Code Interpreter)和Vertex AI Search,并可选择创建自定义扩展。扩展的主要优势包括强大的企业控制和与其他Google产品的无缝集成。扩展和函数调用(function calling)之间的关键区别在于执行方式:Vertex AI自动执行扩展,而函数调用需要用户或客户端手动执行。

什么: LLM是强大的文本生成器,但它们从根本上与外部世界断开连接。它们的知识是静态的,仅限于训练时的数据,缺乏执行动作或检索实时信息的能力。这种固有限制阻止它们完成需要与外部API、数据库或服务交互的任务。没有连接这些外部系统的桥梁,它们解决现实世界问题的实用性就会受到严重限制。

为什么: 工具使用模式,通常通过函数调用来实现,为这个问题提供了标准化解决方案。它的工作原理是以LLM能够理解的方式描述可用的外部函数或”工具”。基于用户请求,智能LLM随后可以决定是否需要工具,并生成指定调用哪个函数及使用什么参数的结构化数据对象(如JSON)。编排层执行此函数调用,检索结果,并将其反馈给LLM。这使LLM能够将最新的外部信息或动作结果纳入最终响应中,有效地赋予它行动的能力。

经验法则: 每当智能体需要突破LLM内部知识并与外部世界交互时,使用工具使用模式。这对于需要实时数据的任务(如查看天气、股价)、访问私有或专有信息(如查询公司数据库)、执行精确计算、运行代码或在其他系统中触发动作(如发送电子邮件、控制智能设备)是必不可少的。

视觉摘要:

图2:工具使用设计模式

● 工具使用(函数调用)允许智能体与外部系统交互并访问动态信息。

● 它涉及定义具有清晰描述和参数的工具,使LLM能够理解。

● LLM决定何时使用工具并生成结构化函数调用。

●智能框架(Agentic frameworks)执行实际的工具调用并将结果返回给大型语言模型。

●工具使用(Tool Use)对于构建能够执行现实世界操作并提供最新信息的智能体至关重要。

●LangChain使用@tool装饰器简化了工具定义,并提供create_tool_calling_agent和AgentExecutor来构建使用工具的智能体。

●Google ADK拥有许多非常有用的预构建工具,如Google搜索、代码执行和Vertex AI搜索工具。

工具使用模式是一个关键的架构原理,用于扩展大型语言模型超越其固有文本生成能力的功能范围。通过让模型具备与外部软件和数据源交互的能力,这种范式允许智能体执行操作、进行计算并从其他系统检索信息。这个过程涉及模型在确定有必要满足用户查询时生成结构化请求来调用外部工具。LangChain、Google ADK和Crew AI等框架提供了结构化的抽象和组件,促进这些外部工具的集成。这些框架管理向模型展示工具规范并解析其后续工具使用请求的过程。这简化了复杂智能体系统的开发,使其能够与外部数字环境交互并在其中采取行动。

智能行为通常不仅仅涉及对即时输入的反应。它需要前瞻性,将复杂任务分解为更小、更可管理的步骤,并制定如何实现预期结果的策略。这就是规划模式(Planning pattern)发挥作用的地方。在其核心,规划是智能体或智能体系统制定一系列动作序列以从初始状态向目标状态移动的能力。

在AI的语境中,将规划智能体视为一个专家是有帮助的,你将复杂目标委托给它。当你要求它”组织团队外出活动”时,你定义了什么——目标及其约束——但没有定义如何做。智能体的核心任务是自主规划实现该目标的路径。它必须首先理解初始状态(例如,预算、参与人数、期望日期)和目标状态(成功预订的外出活动),然后发现连接它们的最优动作序列。计划事先并不知道;它是响应请求而创建的。

这个过程的一个特征是适应性。初始计划仅仅是一个起点,不是一个刚性脚本。智能体的真正力量在于其整合新信息并引导项目绕过障碍的能力。例如,如果首选场地变得不可用或选定的餐饮服务商已满员,一个有能力的智能体不会简单地失败。它会适应。它记录新约束,重新评估其选择,并制定新计划,也许通过建议替代场地或日期。

然而,认识到灵活性和可预测性之间的权衡是至关重要的。动态规划是一个特定工具,不是通用解决方案。当问题的解决方案已经被充分理解且可重复时,将智能体约束到预定的、固定的工作流程更有效。这种方法限制智能体的自主性以减少不确定性和不可预测行为的风险,保证可靠和一致的结果。因此,使用规划智能体还是简单任务执行智能体的决定取决于一个问题:“如何做”需要被发现,还是已经已知?

规划模式是自主系统中的核心计算过程,使智能体能够合成一系列动作来实现指定目标,特别是在动态或复杂环境中。这个过程将高层目标转换为由离散的、可执行步骤组成的结构化计划。

在程序化任务自动化等领域,规划用于编排复杂工作流程。例如,新员工入职这样的业务流程可以分解为有向的子任务序列,如创建系统账户、分配培训模块和与不同部门协调。智能体生成一个计划以逻辑顺序执行这些步骤,调用必要的工具或与各种系统交互来管理依赖关系。

在机器人技术和自主导航中,规划是状态空间遍历的基础。一个系统,无论是物理机器人还是虚拟实体,都必须生成一个路径或动作序列来从初始状态转换到目标状态。这涉及优化时间或能耗等指标,同时遵守环境约束,比如避开障碍物或遵循交通规则。

这种模式对于结构化信息综合也至关重要。当需要生成复杂输出(如研究报告)时,智能体可以制定一个包含信息收集、数据总结、内容结构化和迭代优化等不同阶段的计划。同样,在涉及多步骤问题解决的客户支持场景中,智能体可以创建并遵循诊断、解决方案实施和升级的系统性计划。

本质上,规划模式允许智能体从简单的反应式动作转向目标导向的行为。它提供了解决需要连贯的相互依赖操作序列的问题所必需的逻辑框架。

以下章节将演示使用Crew AI框架实现规划器模式的实现。这种模式涉及一个智能体,它首先制定多步骤计划来处理复杂查询,然后按顺序执行该计划。

+————————————————————————————————+ | import os | | | | from dotenv import load_dotenv | | | | from crewai import Agent, Task, Crew, Process | | | | from langchain_openai import ChatOpenAI | | | | | | | | # Load environment variables from .env file for security | | | | load_dotenv() | | | | | | | | # 1. Explicitly define the language model for clarity | | | | llm = ChatOpenAI(model="gpt-4-turbo") | | | | | | | | # 2. Define a clear and focused agent | | | | planner_writer_agent = Agent( | | | | [ role='Article Planner and Writer',] | | | | [ goal='Plan and then write a concise, engaging summary on a specified topic.',] | | | | [ backstory=(] | | | | [ 'You are an expert technical writer and content strategist. '] | | | | [ 'Your strength lies in creating a clear, actionable plan before writing, '] | | | | [ 'ensuring the final summary is both informative and easy to digest.'] | | | | [ ),] | | | | [ verbose=True,] | | | | [ allow_delegation=False,] | | | | [ llm=llm # Assign the specific LLM to the agent] | | |

)

topic = “强化学习在人工智能中的重要性”

high_level_task = Task( description=( f”1. 为关于主题:’{topic}’的摘要创建一个要点计划。” f”2. 基于你的计划编写摘要,保持在200字左右。” ), expected_output=( “包含两个不同部分的最终报告:” “### 计划” “- 概述摘要主要要点的要点列表。” “### 摘要” “- 对主题的简洁且结构良好的摘要。” ), agent=planner_writer_agent, )

crew = Crew( agents=[planner_writer_agent], tasks=[high_level_task], process=Process.sequential, )

print(“## 运行规划和写作任务 ##”) result = crew.kickoff()

print(“—## 任务结果 ##—”)

+————————————————————————————————+

这段代码使用CrewAI库创建了一个AI智能体(agent),用于规划并撰写给定主题的摘要。首先导入必要的库,包括Crew.ai和langchain_openai,并从.env文件加载环境变量。明确定义了一个ChatOpenAI语言模型供智能体使用。创建了一个名为planner_writer_agent的智能体(Agent),具有特定的角色和目标:规划并撰写简洁摘要。智能体的背景故事强调了其在规划和技术写作方面的专业知识。定义了一个任务(Task),明确描述首先创建计划,然后撰写关于”强化学习在AI中的重要性”主题的摘要,并指定了预期输出的具体格式。组建了一个团队(Crew),包含智能体和任务,设置为按顺序处理。最后调用crew.kickoff()方法执行定义的任务并打印结果。

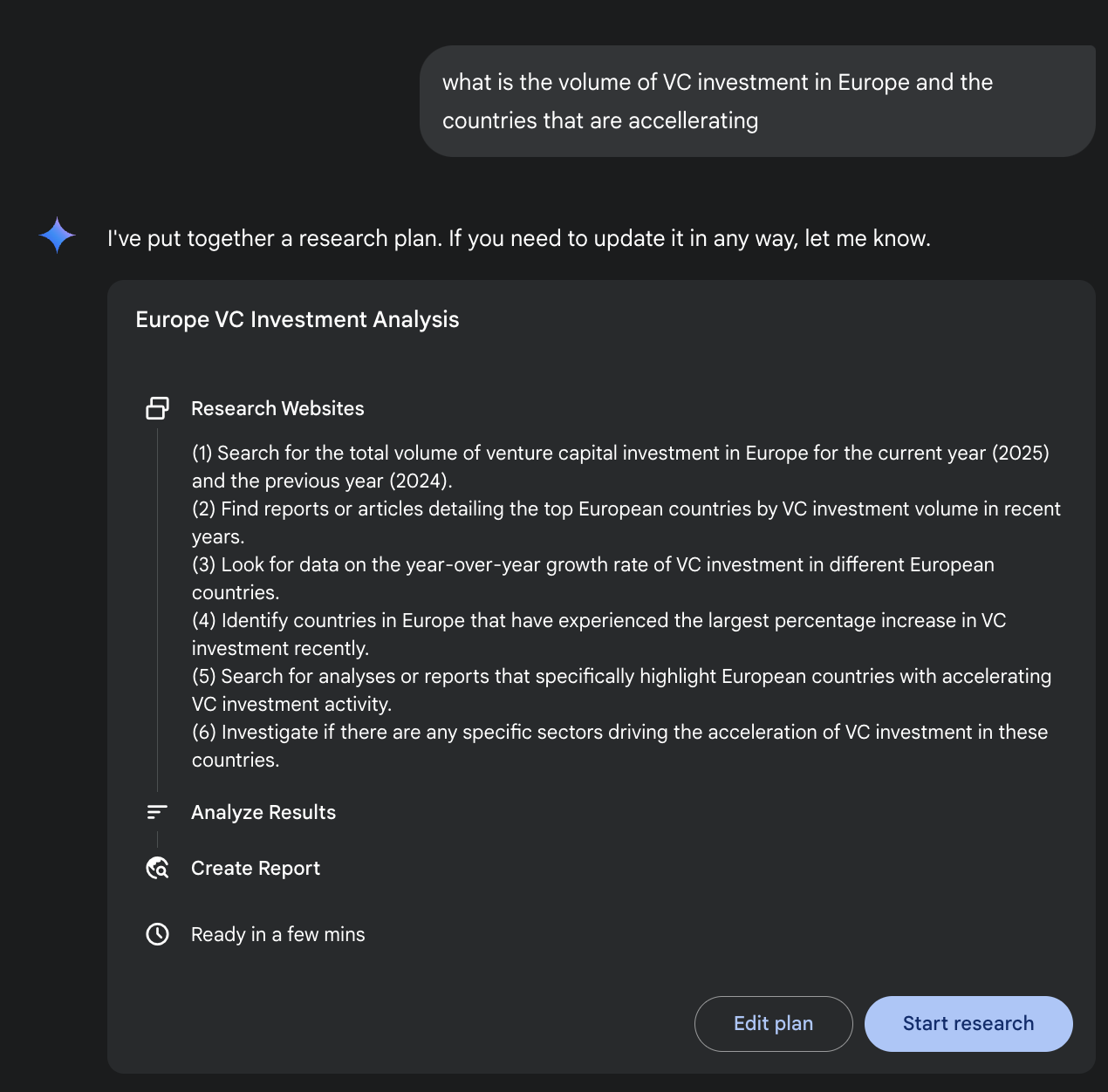

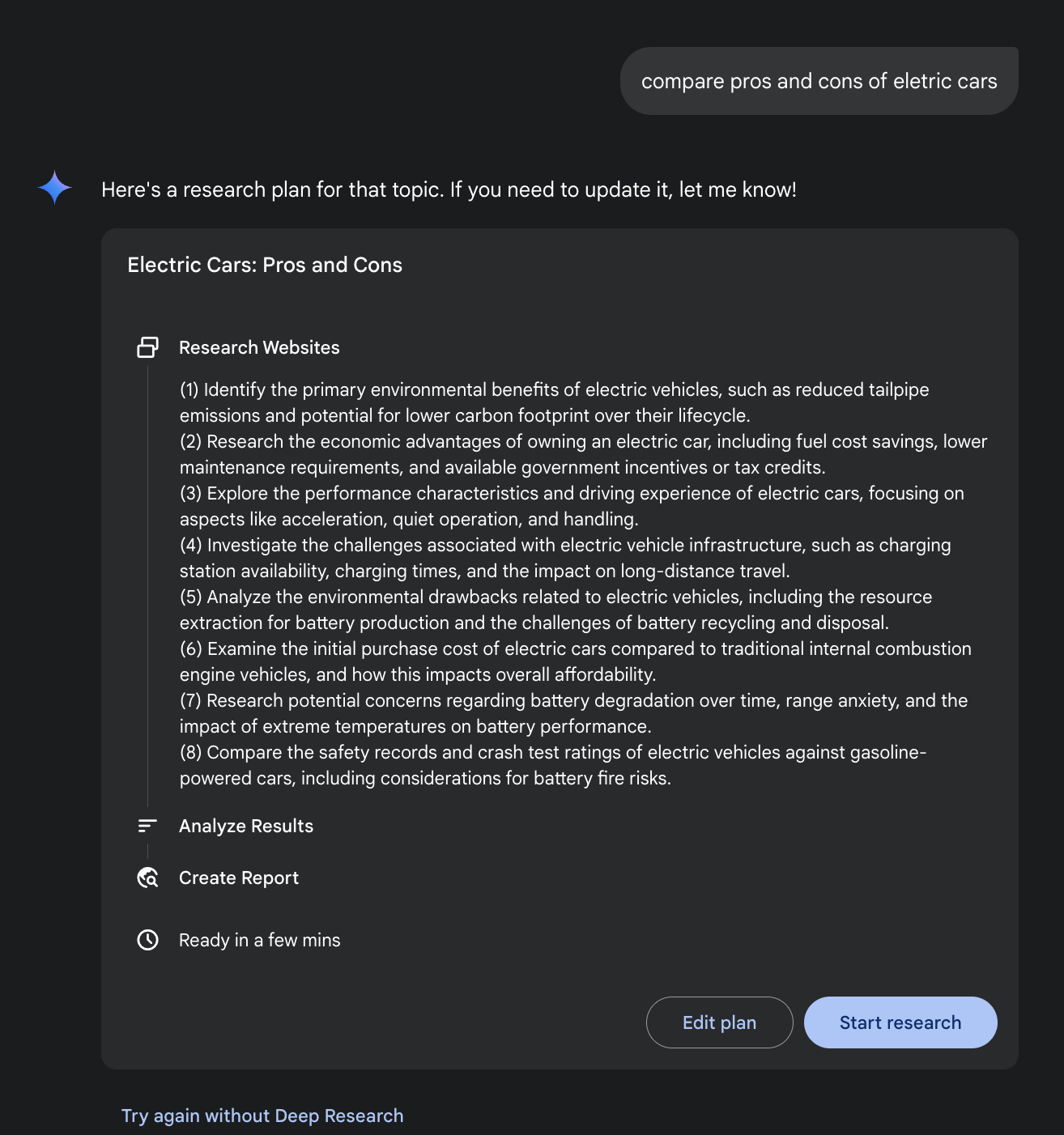

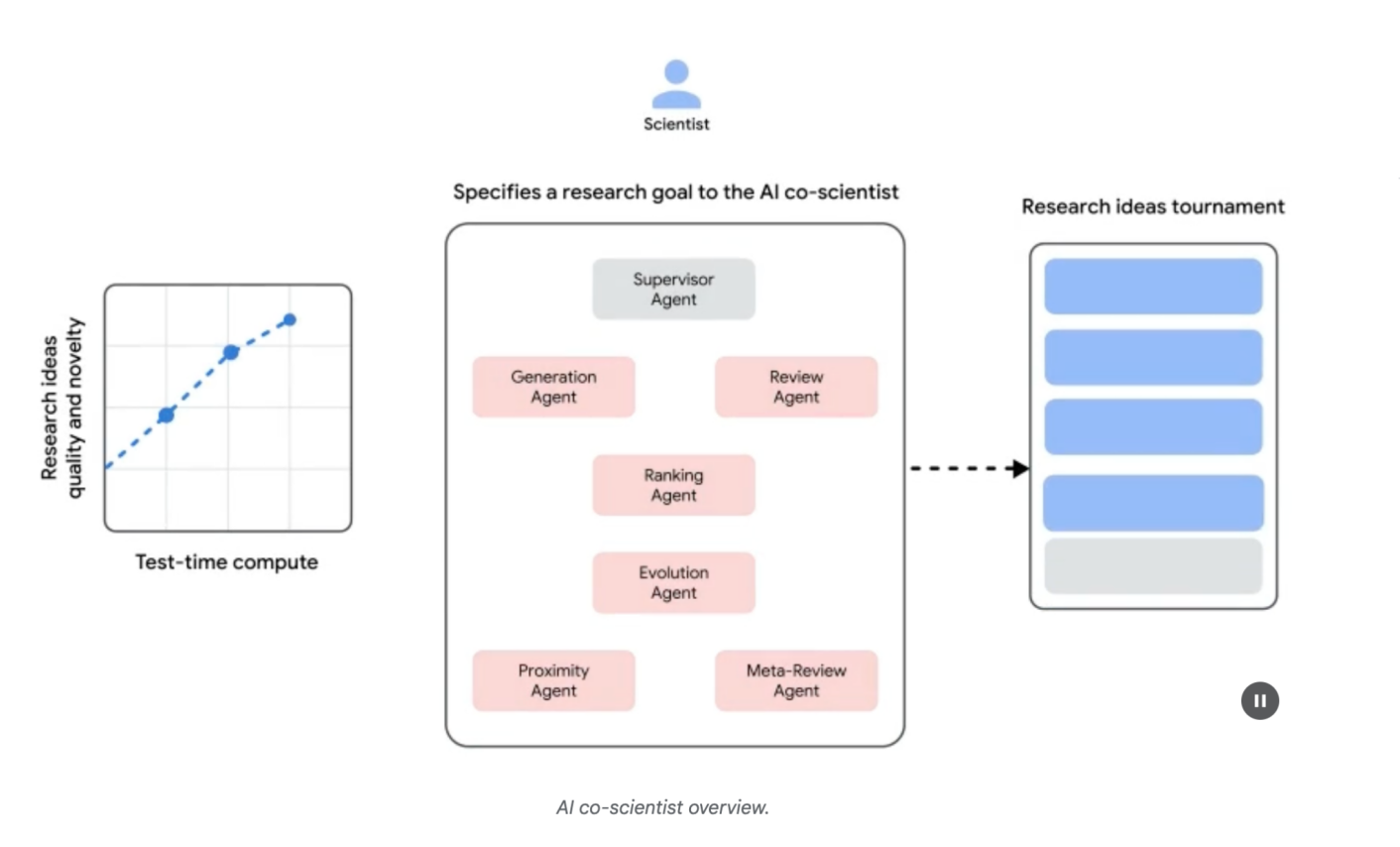

Google Gemini DeepResearch(如图1所示)是一个基于智能体的系统,专为自主信息检索和综合而设计。它通过多步智能体流水线运行,动态迭代地查询Google搜索来系统性地探索复杂主题。该系统设计用于处理大量基于网络的信息源,评估收集数据的相关性和知识空白,并执行后续搜索来解决这些问题。最终输出将经过审核的信息整合为结构化的多页摘要,并引用原始信息源。

进一步说明,该系统的运行不是单次查询-响应事件,而是一个管理化的长期运行过程。它首先将用户的提示分解为多点研究计划(如图1所示),然后呈现给用户审查和修改。这允许在执行前协作塑造研究轨迹。一旦计划获得批准,智能体流水线就启动其迭代的搜索-分析循环。这不仅仅是执行一系列预定义的搜索;智能体基于收集的信息动态制定和优化查询,主动识别知识空白、验证数据点并解决差异。

图1:Google Deep Research智能体生成执行计划,使用Google搜索作为工具。

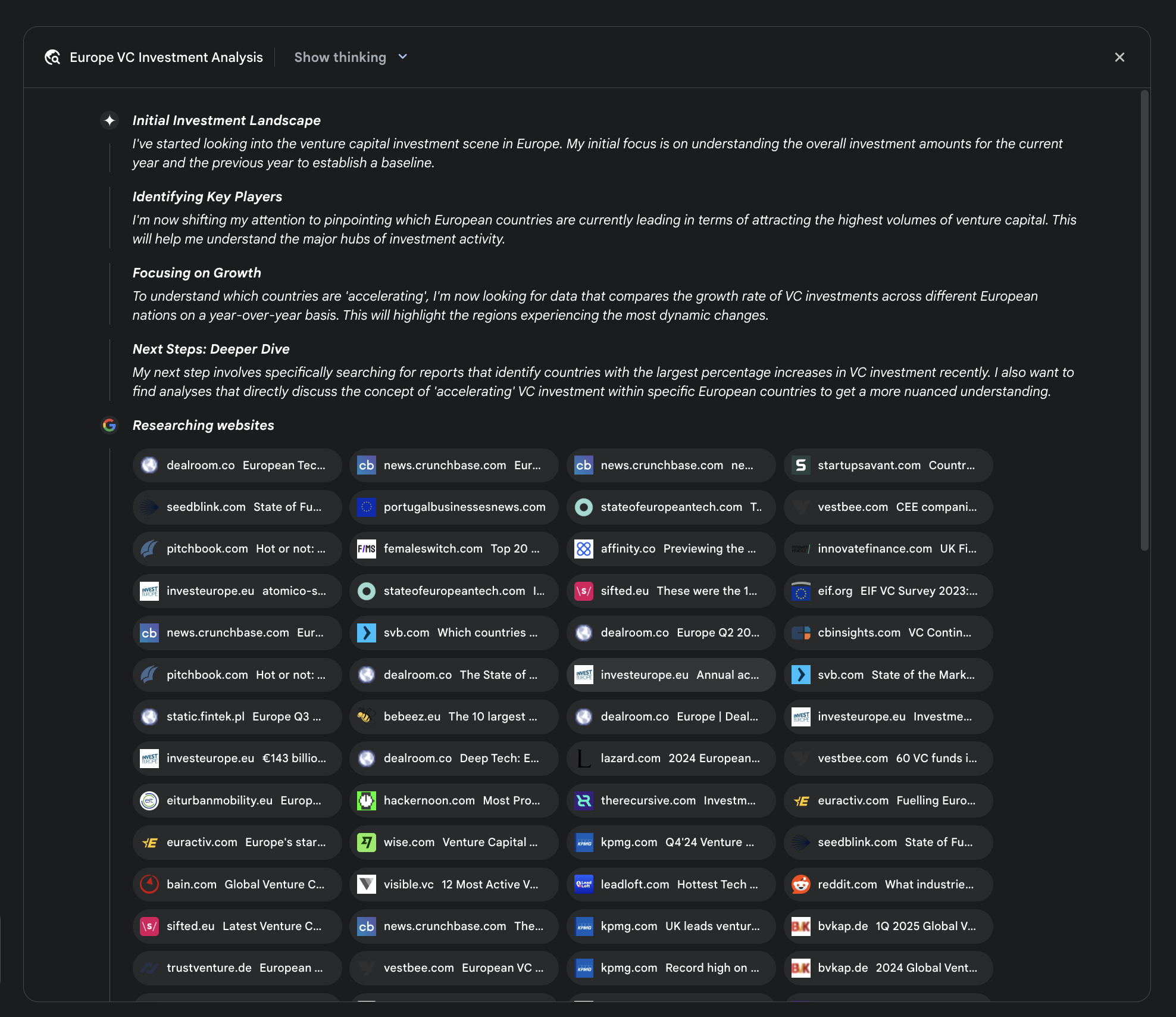

一个关键的架构组件是系统异步管理此过程的能力。这种设计确保调查过程(可能涉及分析数百个信息源)对单点故障具有韧性,并允许用户脱离并在完成时收到通知。系统还可以整合用户提供的文档,将私有信息源的信息与基于网络的研究相结合。最终输出不仅仅是发现结果的连接列表,而是结构化的多页报告。在综合阶段,模型对收集的信息进行批判性评估,识别主要主题并将内容组织为具有逻辑章节的连贯叙述。报告设计为交互式,通常包括音频概览、图表和原始引用信息源的链接等功能,允许用户验证和进一步探索。除了综合结果外,模型明确返回其搜索和咨询的完整信息源列表(如图2所示)。这些以引用形式呈现,提供完全透明度和对主要信息的直接访问。整个过程将简单查询转化为全面、综合的知识体系。

图2:Deep Research计划执行示例,使用Google搜索作为工具搜索各种网络信息源。

通过缓解手动数据获取和综合所需的大量时间和资源投资,Gemini DeepResearch为信息发现提供了更结构化和详尽的方法。该系统的价值在各个领域的复杂、多方面研究任务中尤为明显。

例如,在竞争分析中,智能体可以被指导系统性地收集和整理市场趋势数据、竞争对手产品规格、来自不同在线信息源的公众情绪以及营销策略。这个自动化过程取代了手动跟踪多个竞争对手的繁重任务,使分析师能够专注于更高层次的战略解释而非数据收集(如图3所示)。

图3:Google Deep Research智能体生成的最终输出,代表我们分析使用Google搜索作为工具获得的信息源。

同样,在学术探索中,该系统作为进行广泛文献综述的强大工具。它可以识别和总结基础论文,追踪概念在众多出版物中的发展,并映射特定领域内的新兴研究前沿,从而加速学术研究最初和最耗时的阶段。

这种方法的效率源于迭代搜索-过滤循环的自动化,这是手动研究的核心瓶颈。全面性通过系统处理比人类研究员在相当时间框架内通常可行的更大数量和多样性信息源的能力来实现。这种更广泛的分析范围有助于减少选择偏差的可能性,并增加发现不太明显但潜在关键信息的可能性,从而对主题形成更稳健和有据支撑的理解。

OpenAI Deep Research API是一个专门设计用于自动化复杂研究任务的专业工具。它使用先进的代理模型(agentic model),能够独立进行推理、规划,并从真实世界的信息源中综合信息。与简单的问答模型不同,它接受高层次的查询,自主将其分解为子问题,使用内置工具执行网络搜索,并提供结构化、引用丰富的最终报告。该API提供对整个过程的直接编程访问,在撰写时使用o3-deep-research-2025-06-26等模型进行高质量综合,以及更快的o4-mini-deep-research-2025-06-26用于对延迟敏感的应用。

Deep Research API非常有用,因为它自动化了原本需要数小时手动研究的工作,提供专业级、数据驱动的报告,适用于为商业策略、投资决策或政策建议提供信息支持。其主要优势包括:

● 结构化、有引用的输出: 它产生组织良好的报告,带有链接到源元数据的内联引用,确保声明可验证且有数据支持。

● 透明度: 与ChatGPT中的抽象过程不同,该API暴露所有中间步骤,包括代理的推理、它执行的具体网络搜索查询,以及它运行的任何代码。这允许详细调试、分析,以及更深入地理解最终答案是如何构建的。

● 可扩展性: 它支持模型上下文协议(MCP),使开发者能够将代理连接到私有知识库和内部数据源,将公共网络研究与专有信息相结合。

要使用该API,您向client.responses.create端点发送请求,指定模型、输入提示和代理可以使用的工具。输入通常包括定义代理角色和期望输出格式的system_message,以及user_query。您还必须包含web_search_preview工具,并可以选择添加其他工具,如code_interpreter或自定义MCP工具(见第10章)用于内部数据。

from openai import OpenAI

# 使用您的API密钥初始化客户端

client = OpenAI(api_key="YOUR_OPENAI_API_KEY")

# 定义代理的角色和用户的研究问题

system_message = """您是一名专业研究人员,正在准备结构化、数据驱动的报告。

专注于数据丰富的见解,使用可靠的信息源,并包含内联引用。"""

user_query = "研究司美格鲁肽(semaglutide)对全球医疗保健系统的经济影响。"

# 创建Deep Research API调用

response = client.responses.create(

model="o3-deep-research-2025-06-26",

input=[

{

"role": "developer",

"content": [{"type": "input_text", "text": system_message}]

}

]

)这个代码片段利用OpenAI API执行”深度研究”任务。它首先使用您的API密钥初始化OpenAI客户端,这对于身份验证至关重要。然后,它将AI代理的角色定义为专业研究员,并设置用户关于司美格鲁肽经济影响的研究问题。代码构建了对o3-deep-research-2025-06-26模型的API调用,提供定义的系统消息和用户查询作为输入。它还请求推理的自动摘要并启用网页搜索功能。在进行API调用后,它提取并打印最终生成的报告。

随后,它尝试访问并显示报告注释中的内联引用和元数据,包括引用文本、标题、URL和在报告中的位置。最后,它检查并打印模型采取的中间步骤的详细信息,如推理步骤、网页搜索调用(包括执行的查询)以及任何代码执行步骤(如果使用了代码解释器)。

什么: 复杂问题通常无法通过单一行动解决,需要前瞻性思维才能实现预期结果。没有结构化方法,代理系统(agentic system)难以处理涉及多个步骤和依赖关系的多方面请求。这使得将高层次目标分解为可管理的一系列较小、可执行任务变得困难。因此,系统无法有效制定策略,在面对复杂目标时导致不完整或错误的结果。

为什么: 规划模式(Planning pattern)通过让代理系统首先创建一个连贯的计划来解决目标,提供了标准化解决方案。它涉及将高层次目标分解为一系列较小的、可行的步骤或子目标。这使得系统能够管理复杂工作流程,协调各种工具,并按逻辑顺序处理依赖关系。大语言模型(LLM)特别适合这一点,因为它们可以基于其庞大的训练数据生成合理且有效的计划。这种结构化方法将简单的反应式代理转变为战略执行者,能够主动朝着复杂目标努力,甚至在必要时调整其计划。

经验法则: 当用户的请求过于复杂而无法通过单一行动或工具处理时,使用此模式。它非常适合自动化多步骤流程,如生成详细研究报告、新员工入职或执行竞争分析。无论何时任务需要一系列相互依赖的操作来达到最终综合结果时,都应应用规划模式。

可视化摘要

● 规划使代理能够将复杂目标分解为可行的、顺序的步骤。

● 它对于处理多步骤任务、工作流程自动化和在复杂环境中导航至关重要。

● 大语言模型(LLM)可以通过基于任务描述生成逐步方法来执行规划。

● 明确提示或设计需要规划步骤的任务能够在代理框架中鼓励这种行为。

● Google深度研究(Deep Research)是一个代理,代表我们分析使用Google搜索作为工具获得的来源。它进行反思、规划和执行。

总之,规划模式是一个基础组件,它将代理系统从简单的反应式响应器提升为战略性的、目标导向的执行器。现代大型语言模型为此提供了核心能力,能够自主地将高级目标分解为连贯的、可操作的步骤。这种模式可以从简单的顺序任务执行扩展,如CrewAI代理创建并遵循写作计划所示,到更复杂和动态的系统。Google DeepResearch代理体现了这种高级应用,创建基于持续信息收集而适应和演进的迭代研究计划。最终,规划为复杂问题提供了人类意图与自动执行之间的重要桥梁。通过构建解决问题的方法,这种模式使代理能够管理复杂的工作流程并提供全面、综合的结果。

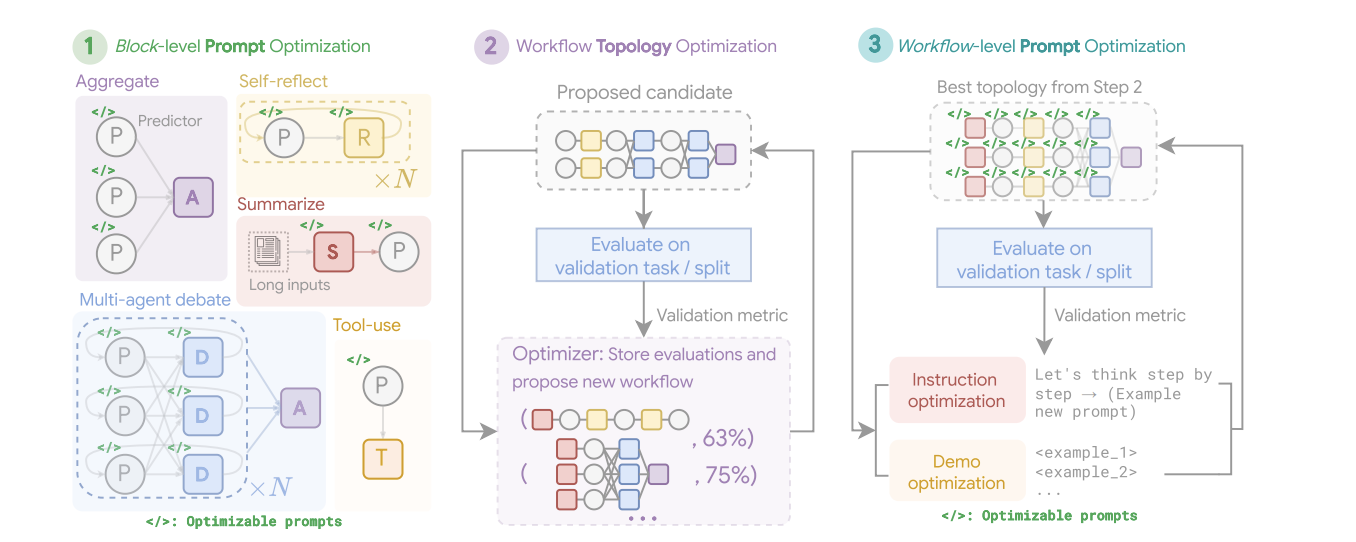

虽然单体代理架构对于明确定义的问题可能是有效的,但当面对复杂的多领域任务时,其能力往往会受到约束。多代理协作模式通过将系统构建为不同专门代理的协作集合来解决这些限制。这种方法基于任务分解的原则,将高级目标分解为离散的子问题。然后将每个子问题分配给具有最适合该任务的特定工具、数据访问或推理能力的代理。

例如,一个复杂的研究查询可能被分解并分配给研究代理进行信息检索,数据分析代理进行统计处理,以及综合代理生成最终报告。这种系统的效力不仅仅在于分工,而且关键依赖于代理间通信的机制。这需要标准化的通信协议和共享的本体论(ontology),允许代理交换数据、委派子任务,并协调它们的行动以确保最终输出的连贯性。

这种分布式架构提供了几个优势,包括增强的模块化、可扩展性和鲁棒性,因为单个代理的失败不一定会导致整个系统的完全失败。协作允许产生协同结果,其中多代理系统的集体性能超过集合中任何单个代理的潜在能力。

多代理协作模式涉及设计多个独立或半独立代理协作实现共同目标的系统。每个代理通常具有明确的角色、与整体目标一致的特定目标,以及可能访问不同的工具或知识库。这种模式的力量在于这些代理之间的交互和协同效应。

协作可以采取各种形式:

● 顺序交接: 一个代理完成任务并将其输出传递给另一个代理进行管道中的下一步(类似于规划模式,但明确涉及不同的代理)。

● 并行处理: 多个代理同时处理问题的不同部分,然后将它们的结果合并。

● 辩论与共识: 具有不同观点和信息来源的代理参与讨论以评估选项,最终达成共识或更明智的决定。

● 层次结构: 管理代理可能根据工作代理的工具访问或插件能力动态地向它们分配任务,并综合它们的结果。每个代理也可以处理相关的工具组,而不是单个代理处理所有工具。

● 专家团队: 在不同领域(如研究员、作家、编辑)具有专业知识的代理协作产生复杂输出。

● 批评-审查: 代理创建初始输出,如计划、草稿或答案。第二组代理然后从策略遵循、安全性、合规性、正确性、质量和与组织目标的一致性等方面批判性地评估这些输出。原始创建者或最终代理根据这种反馈修订输出。这种模式对于代码生成、研究写作、逻辑检查和确保道德一致性特别有效。这种方法的优势包括增强鲁棒性、提高质量,以及减少幻觉或错误的可能性。

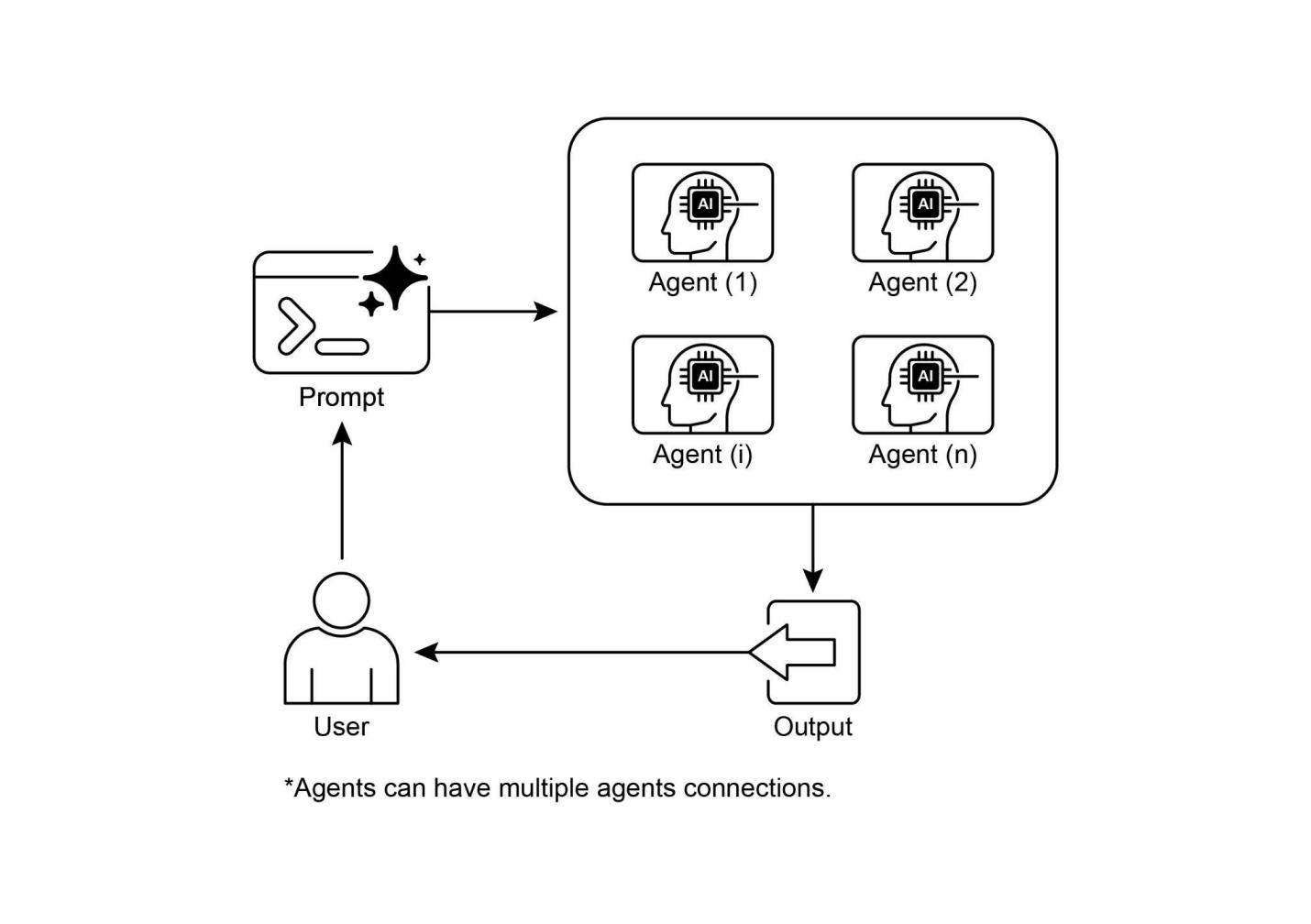

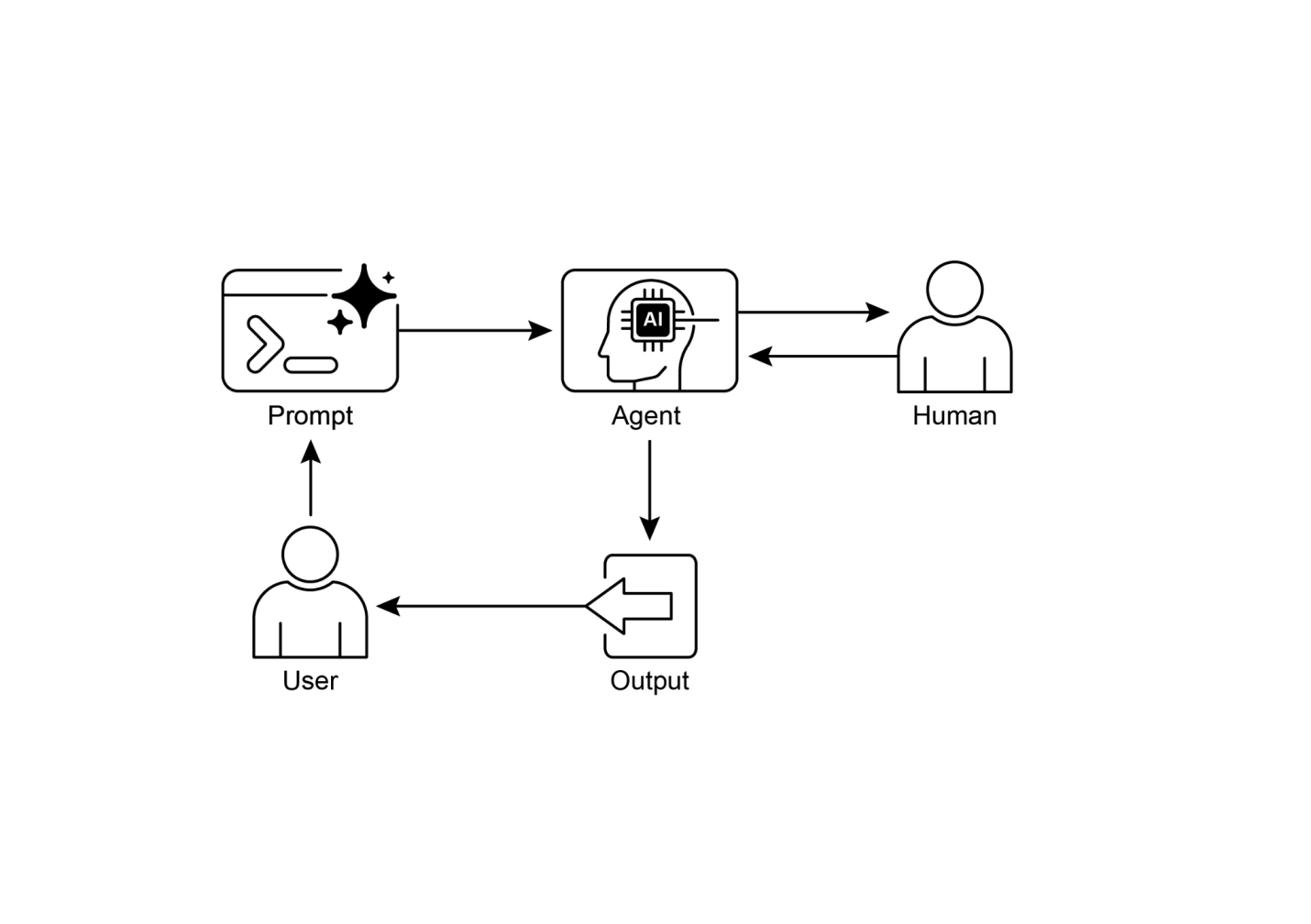

多代理系统(见图1)基本上包括代理角色和职责的划分、建立代理交换信息的通信渠道,以及制定指导其协作努力的任务流程或交互协议。

图1:多代理系统示例

诸如Crew AI和Google ADK等框架专门设计用于促进这种范式,通过为代理、任务及其交互程序的规范提供结构。这种方法对于需要各种专业知识、包含多个离散阶段或利用并发处理和跨代理信息验证优势的挑战特别有效。

多代理协作是一种强大的模式,适用于众多领域:

●[复杂研究和分析:[一个代理团队可以在研究项目上协作。一个代理可能专门搜索学术数据库,另一个专门总结发现,第三个专门识别趋势,第四个专门将信息综合成报告。这反映了人类研究团队的运作方式。]]

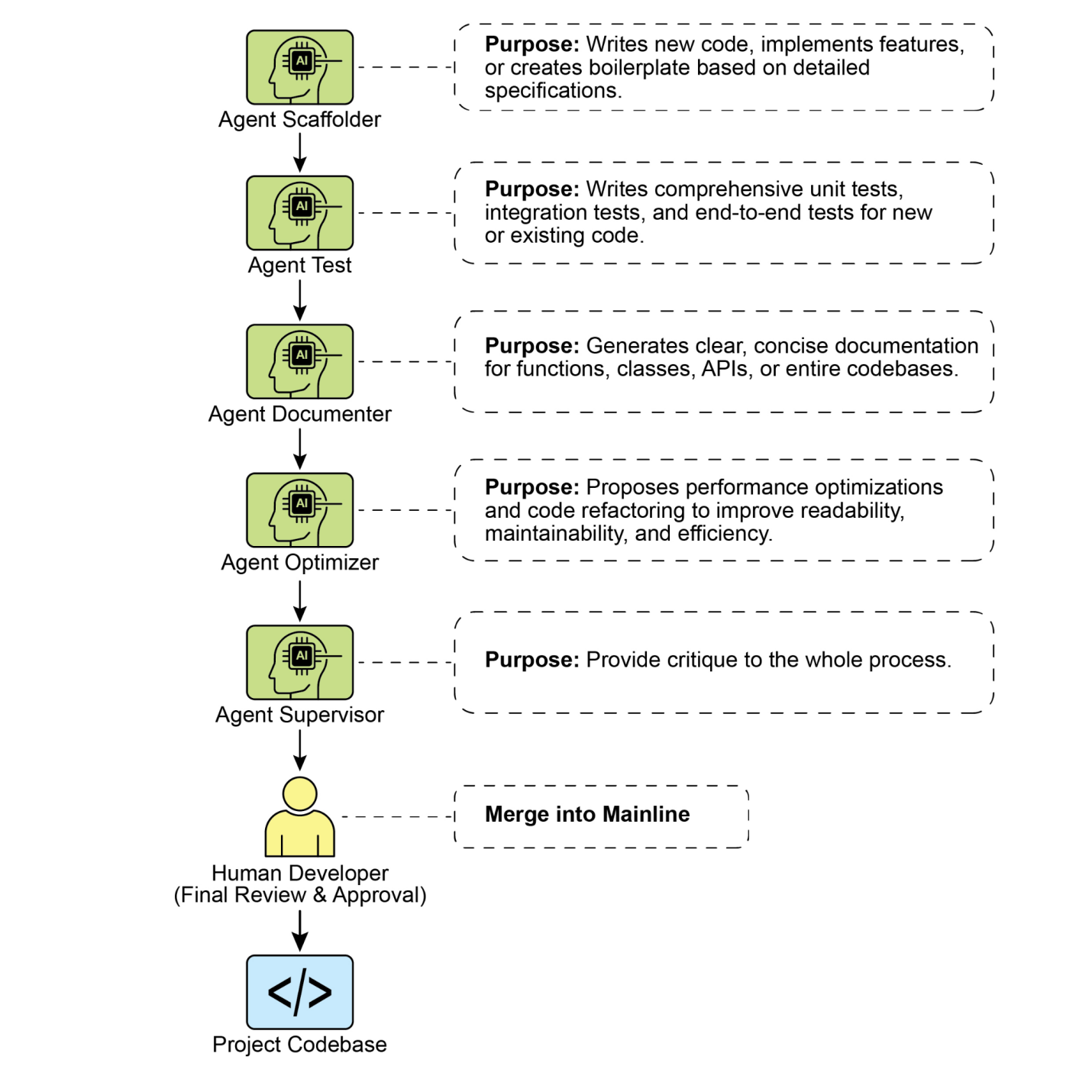

●[软件开发:[想象代理在构建软件上协作。一个代理可能是需求分析师,另一个是代码生成器,第三个是测试员,第四个是文档编写员。它们可以在彼此之间传递输出,以构建和验证组件。]]

●[创意内容生成:[创建营销活动可能涉及市场研究代理、文案代理、平面设计代理(使用图像生成工具)和社交媒体调度代理,所有这些都协同工作。]]

●[金融分析:[多代理系统可以分析金融市场。代理可能专门获取股票数据、分析新闻情绪、执行技术分析和生成投资建议。]]

●[客户支持升级:[前线支持代理可以处理初始查询,在需要时将复杂问题升级给专家代理(例如,技术专家或账单专家),演示基于问题复杂性的顺序移交。]]

●[供应链优化:[代理可以代表供应链中的不同节点(供应商、制造商、分销商),并协作优化库存水平、物流和调度,以应对需求变化或中断。]]

●[网络分析和修复[:][自主操作极大地受益于代理架构,特别是在故障定位方面。多个代理可以协作进行分诊和修复问题,建议最优行动。这些代理还可以与传统机器学习模型和工具集成,利用现有系统的同时提供生成式AI的优势。]]

能够描述专门化代理并精心编排它们的相互关系,使开发者能够构建表现出增强模块化、可扩展性以及解决单一集成代理无法克服的复杂性的系统。

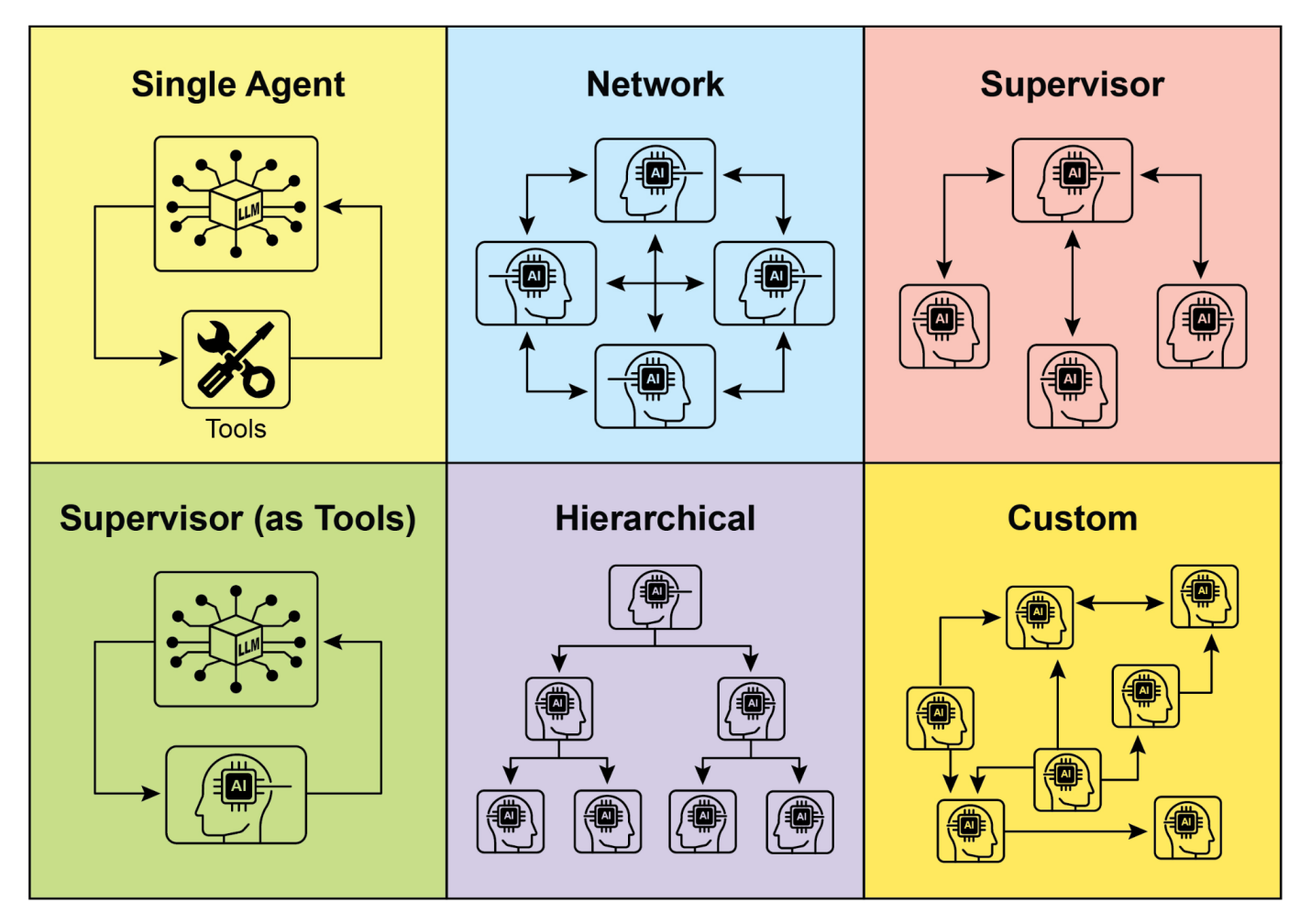

理解代理交互和通信的复杂方式是设计有效多代理系统的基础。如图2所示,存在一系列相互关系和通信模型,从最简单的单代理场景到复杂的定制协作框架。每个模型都呈现独特的优势和挑战,影响多代理系统的整体效率、稳健性和适应性。

1. 单代理:在最基本的层面上,“单代理”在没有与其他实体直接交互或通信的情况下自主运行。虽然这种模型易于实现和管理,但其能力本质上受到单个代理范围和资源的限制。它适用于可分解为独立子问题的任务,每个子问题都可由单个自给自足的代理解决。

2. 网络:“网络”模型代表了向协作迈出的重要一步,多个代理以分散的方式直接相互交互。通信通常以点对点方式进行,允许信息、资源甚至任务的共享。这种模型促进了韧性,因为一个代理的故障不一定会瘫痪整个系统。然而,管理通信开销和确保大型非结构化网络中的连贯决策制定可能具有挑战性。

3. 监督者:在”监督者”模型中,一个专用代理,即”监督者”,监督和协调一组下属代理的活动。监督者充当通信、任务分配和冲突解决的中央枢纽。这种分层结构提供了明确的权威线条,可以简化管理和控制。然而,它引入了单点故障(监督者),如果监督者被大量下属或复杂任务所淹没,可能成为瓶颈。

4. 监督者作为工具:这种模型是”监督者”概念的微妙扩展,监督者的角色不太关注直接指挥和控制,而更多地关注向其他代理提供资源、指导或分析支持。监督者可能提供工具、数据或计算服务,使其他代理能够更有效地执行任务,而不必指示它们的每一个行动。这种方法旨在利用监督者的能力,而不施加严格的自上而下控制。

“分层式”模型在监督者概念的基础上进行了扩展,创建了一个多层级的组织结构。这涉及多个层级的监督者,高层级监督者监督低层级监督者,最终在最底层是一系列操作代理。这种结构非常适合可以分解为子问题的复杂问题,每个层级都管理特定的子问题。它为可扩展性和复杂性管理提供了结构化的方法,允许在定义的边界内进行分布式决策。

图2:代理以各种方式进行沟通和交互。

“自定义式”模型代表了多代理系统设计的终极灵活性。它允许创建独特的相互关系和通信结构,精确定制以满足特定问题或应用的具体要求。这可以涉及混合方法,结合前述模型的元素,或者完全新颖的设计,这些设计源于环境的独特约束和机会。自定义模型通常源于针对特定性能指标进行优化、处理高度动态环境或将领域特定知识融入系统架构的需求。设计和实现自定义模型通常需要对多代理系统原理的深入理解,以及对通信协议、协调机制和涌现行为的仔细考虑。

总之,为多代理系统选择相互关系和通信模型是一个关键的设计决策。每种模型都提供了独特的优势和劣势,最佳选择取决于任务的复杂性、代理数量、所需的自主性水平、对健壮性的需求以及可接受的通信开销等因素。多代理系统的未来发展可能会继续探索和完善这些模型,以及开发协作智能的新范式。

这段Python代码使用CrewAI框架定义了一个AI驱动的团队来生成关于AI趋势的博客文章。它首先设置环境,从.env文件中加载API密钥。应用程序的核心包括定义两个代理:一个研究员用于查找和总结AI趋势,一个写作者用于基于研究结果创建博客文章。

相应地定义了两个任务:一个用于研究趋势,另一个用于撰写博客文章,写作任务依赖于研究任务的输出。然后将这些代理和任务组装成一个团队,指定一个顺序过程,其中任务按顺序执行。团队使用代理、任务和语言模型(特别是”gemini-2.0-flash”模型)进行初始化。主函数使用kickoff()方法执行这个团队,协调代理之间的协作以产生所需的输出。最后,代码打印团队执行的最终结果,即生成的博客文章。

import os

from dotenv import load_dotenv

from crewai import Agent, Task, Crew, Process

from langchain_google_genai import ChatGoogleGenerativeAI

def setup_environment():

"""加载环境变量并检查所需的API密钥。"""

load_dotenv()writing_task = Task(

description="根据研究结果撰写一篇500字的博客文章。文章应该引人入胜,便于普通读者理解。",

expected_output="一篇关于最新AI趋势的完整500字博客文章。",

agent=writer,

context=[research_task],

)

# 创建团队

blog_creation_crew = Crew(

agents=[researcher, writer],

tasks=[research_task, writing_task],

process=Process.sequential,

llm=llm,

verbose=2 # 设置详细程度以获得详细的团队执行日志

)+———————————————————————————————————————————————————————–+

我们现在将深入研究Google ADK框架中的更多示例,特别强调分层、并行和顺序协调范式,以及将智能体实现为操作工具。

以下代码示例演示了如何通过创建父子关系在Google ADK中建立分层智能体结构。代码定义了两种类型的智能体:LlmAgent和从BaseAgent派生的自定义TaskExecutor智能体。TaskExecutor专为特定的非LLM任务设计,在此示例中,它只是产生一个”任务成功完成”事件。名为greeter的LlmAgent使用指定的模型和指令初始化,充当友好的问候者。自定义TaskExecutor实例化为task_doer。创建了一个名为coordinator的父级LlmAgent,同样具有模型和指令。coordinator的指令引导它将问候委托给greeter,将任务执行委托给task_doer。greeter和task_doer作为子智能体添加到coordinator中,建立了父子关系。代码然后断言这种关系已正确设置。最后,它打印一条消息,表明智能体层次结构已成功创建。

+——————————————————————————————————————————————-+

这段代码展示了在Google ADK框架中使用LoopAgent建立迭代工作流的应用。代码定义了两个代理:ConditionChecker和ProcessingStep。ConditionChecker是一个自定义代理,检查会话状态中的”status”值。如果”status”为”completed”,ConditionChecker会上报一个事件来停止循环。否则,它会产生一个事件来继续循环。ProcessingStep是一个使用”gemini-2.0-flash-exp”模型的LlmAgent。其指令是执行任务,如果是最终步骤则将会话”status”设置为”completed”。创建了一个名为StatusPoller的LoopAgent。StatusPoller配置了max_iterations=10。StatusPoller包含ProcessingStep和ConditionChecker实例作为子代理。LoopAgent将按顺序执行子代理最多10次迭代,如果ConditionChecker发现状态为”completed”则停止。

import asyncio

from typing import AsyncGenerator

from google.adk.agents import LoopAgent, LlmAgent, BaseAgent

from google.adk.events import Event, EventActions

from google.adk.agents.invocation_context import InvocationContext

# 最佳实践:将自定义代理定义为完整的、自描述的类。

class ConditionChecker(BaseAgent):

"""检查会话状态中'completed'状态的自定义代理。"""

name: str = "ConditionChecker"

description: str = "检查进程是否完成并向循环发出停止信号。"此代码片段阐述了Google ADK中的SequentialAgent模式,专门为构建线性工作流而设计。

此代码使用google.adk.agents库定义了一个顺序代理管道。管道由两个代理组成:step1和step2。step1命名为”Step1_Fetch”,其输出将存储在会话状态的”data”键下。step2命名为”Step2_Process”,被指示分析存储在session.state[“data”]中的信息并提供摘要。名为”MyPipeline”的SequentialAgent编排这些子代理的执行。

当管道使用初始输入运行时,step1将首先执行。来自step1的响应将保存到会话状态的”data”键下。随后,step2将执行,根据其指令利用step1放置在状态中的信息。

这种结构允许构建工作流,其中一个代理的输出成为下一个代理的输入。这是创建多步骤AI或数据处理管道的常见模式。

from google.adk.agents import SequentialAgent, Agent

# 此代理的输出将保存到session.state["data"]

step1 = Agent(name="Step1_Fetch", output_key="data")

# 此代理将使用来自前一步的数据

# 我们指示它如何找到并使用这些数据

step2 = Agent(

name="Step2_Process",

instruction="分析state['data']中找到的信息并提供摘要。"

)

pipeline = SequentialAgent(

name="MyPipeline",

sub_agents=[step1, step2]

)

# 当管道使用初始输入运行时,Step1将执行,

# 其响应将存储在session.state["data"]中,然后

# Step2将执行,按指示使用状态中的信息。以下代码示例演示了Google ADK(ADK)中的ParallelAgent(并行代理)模式,它促进了多个代理任务的并发执行。data_gatherer被设计为并发运行两个子代理:weather_fetcher和news_fetcher。weather_fetcher代理被指示获取给定位置的天气信息并将结果存储在session.state[“weather_data”]中。类似地,news_fetcher代理被指示检索给定主题的头条新闻并将其存储在session.state[“news_data”]中。每个子代理都配置为使用”gemini-2.0-flash-exp”模型。ParallelAgent协调这些子代理的执行,允许它们并行工作。来自weather_fetcher和news_fetcher的结果将被收集并存储在会话状态中。最后,示例展示了如何在代理执行完成后从final_state访问收集的天气和新闻数据。

from google.adk.agents import Agent, ParallelAgent

# 最好将获取逻辑定义为代理的工具

# 为了简化此示例,我们将逻辑嵌入到代理的指令中。

# 在实际场景中,您会使用工具。

# 定义将并行运行的各个代理

weather_fetcher = Agent(

name="weather_fetcher",

model="gemini-2.0-flash-exp",

instruction="获取给定位置的天气信息,仅返回天气报告。",

output_key="weather_data" # 结果将存储在session.state["weather_data"]中

)

news_fetcher = Agent(

name="news_fetcher",

model="gemini-2.0-flash-exp",

instruction="获取给定主题的头条新闻,仅返回该新闻。",

output_key="news_data" # 结果将存储在session.state["news_data"]中

)

# 创建ParallelAgent来协调子代理+————————————————————————————————————–+

提供的代码段演示了 Google ADK 中的”智能体作为工具”(Agent as a Tool)范式,使一个智能体能够以类似函数调用的方式利用另一个智能体的能力。具体来说,该代码使用 Google 的 LlmAgent 和 AgentTool 类定义了一个图像生成系统。它由两个智能体组成:一个父级 artist_agent 和一个子级 image_generator_agent。generate_image 函数是一个简单的工具,用于模拟图像创建,返回模拟的图像数据。image_generator_agent 负责根据接收到的文本提示使用此工具。artist_agent 的角色是首先创造一个创意图像提示,然后通过 AgentTool 包装器调用 image_generator_agent。AgentTool 充当桥梁,允许一个智能体将另一个智能体用作工具。当 artist_agent 调用 image_tool 时,AgentTool 使用艺术家创造的提示调用 image_generator_agent。然后 image_generator_agent 使用该提示调用 generate_image 函数。最后,生成的图像(或模拟数据)通过智能体返回。这种架构展示了一个分层智能体系统,其中高级智能体编排低级专用智能体来执行任务。

+———————————————————————————————————————————–+ | from google.adk.agents import LlmAgent | | | | from google.adk.tools import agent_tool | | | | from google.genai import types | | | | | | | | # 1. 一个用于核心功能的简单函数工具 | | | | # 这遵循了将操作与推理分离的最佳实践 | | | | def generate_image(prompt: str) -> dict: | | | | [ """] | | | | [ 基于文本提示生成图像] | | | | | | | | [ Args:] | | | | [ prompt: 要生成图像的详细描述] |

# 2. 将ImageGeneratorAgent重构为LlmAgent。 | | | # 现在它正确地使用了传递给它的输入。 | | | image_generator_agent = LlmAgent( | | | | [ name="ImageGen",] | | | | [ model="gemini-2.0-flash",] | | | | [ description="基于详细文本提示生成图像。",] | | | | [ instruction=(] | | | | [ "你是一个图像生成专家。你的任务是接收用户的请求 "] |

generate_image 工具来创建图像。”] |ImageGen 工具通过您的提示生成图像。”] |什么: 复杂问题往往超出单个单体LLM代理的能力范围。单一代理可能缺乏处理多方面任务所需的多样化专业技能或特定工具访问权限。这种限制造成瓶颈,降低系统的整体效率和可扩展性。因此,处理复杂的多领域目标变得低效,可能导致不完整或次优的结果。

为什么: 多代理协作模式通过创建多个合作代理系统提供标准化解决方案。复杂问题被分解为更小、更易管理的子问题。每个子问题分配给具有精确工具和能力的专业代理来解决。这些代理通过定义的通信协议和交互模型协同工作,如顺序交接、并行工作流或分层委托。这种代理化分布式方法产生协同效应,使团队能够实现任何单一代理都无法完成的结果。

经验法则: 当任务对单一代理过于复杂且可分解为需要专业技能或工具的不同子任务时使用此模式。适用于受益于多样专业知识、并行处理或具有多个阶段的结构化工作流的问题,如复杂研究和分析、软件开发或创意内容生成。

视觉摘要

图3:多代理设计模式

● 多代理协作涉及多个代理协同工作以实现共同目标。

● 此模式利用专业角色、分布式任务和代理间通信。

● 协作可采用顺序交接、并行处理、辩论或分层结构等形式。

● 此模式适用于需要多样专业知识或多个不同阶段的复杂问题。

本章探讨了多代理协作模式,展示了在系统中编排多个专业代理的好处。我们研究了各种协作模型,强调该模式在解决跨不同领域的复杂多方面问题中的重要作用。理解代理协作自然引向对其与外部环境交互的探究。

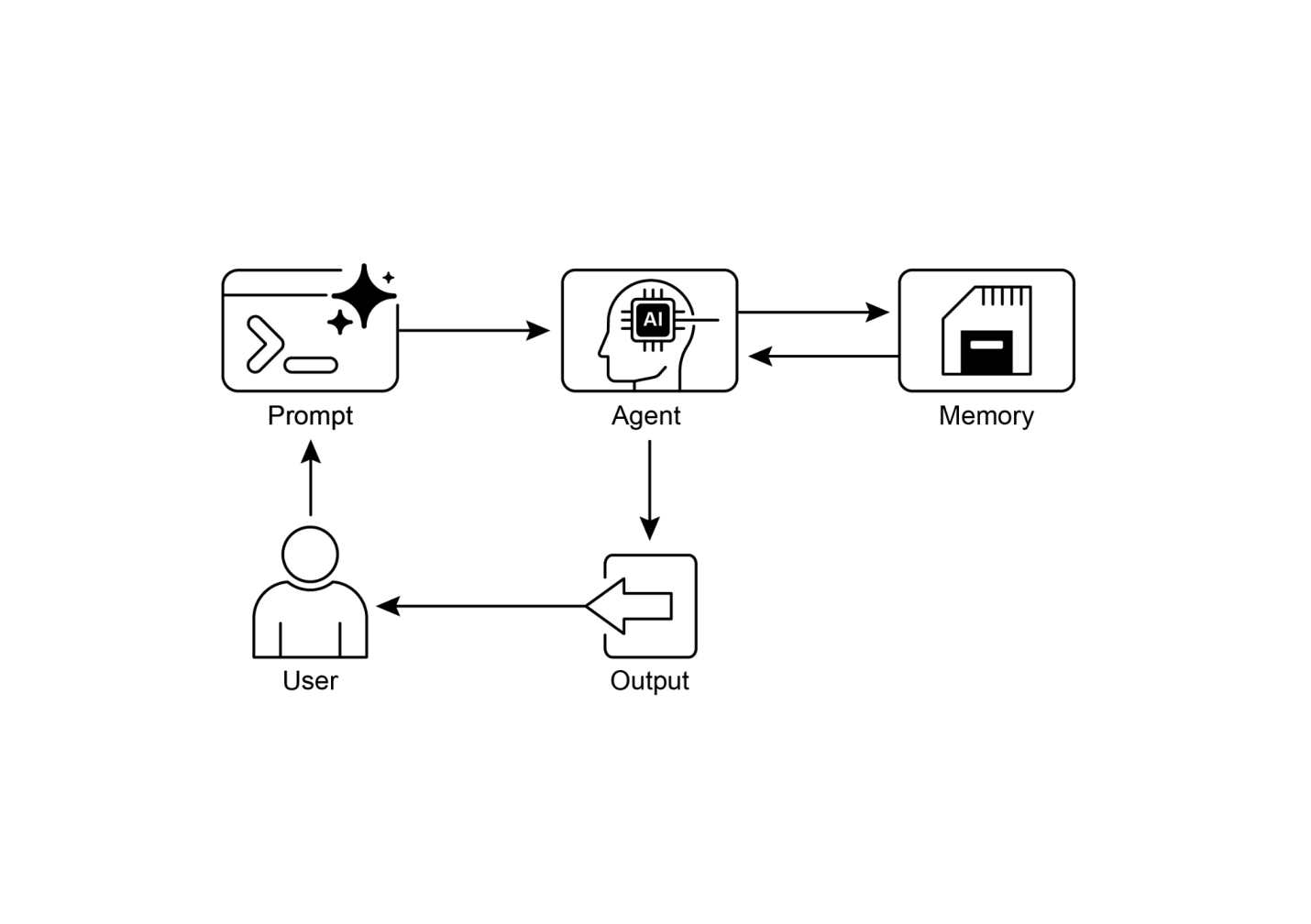

有效的内存管理对于智能代理保留信息至关重要。代理需要不同类型的内存,就像人类一样,以便高效运行。本章深入探讨内存管理,特别是解决代理的即时(短期)和持久(长期)内存需求。

在代理系统中,内存是指代理从过去的交互、观察和学习经验中保留和利用信息的能力。这种能力使代理能够做出明智决策、维持对话上下文并随时间改进。代理内存通常分为两种主要类型:

● 短期内存(上下文内存): 类似于工作内存,保存当前正在处理或最近访问的信息。对于使用大型语言模型(LLM)的代理,短期内存主要存在于上下文窗口中。此窗口包含来自当前交互的最近消息、代理回复、工具使用结果和代理反思,所有这些都为LLM的后续响应和行动提供信息。上下文窗口容量有限,限制了代理可直接访问的最近信息量。高效的短期内存管理涉及在这个有限空间内保留最相关的信息,可能通过总结较旧对话片段或强调关键细节等技术。具有”长上下文”窗口的模型的出现只是扩大了这种短期内存的大小,允许在单个交互中保存更多信息。但是,此上下文仍然是临时的,会话结束后就会丢失,并且每次处理都可能昂贵且低效。因此,代理需要单独的内存类型来实现真正的持久性,从过去的交互中回忆信息,并建立持久的知识库。

● 长期记忆(持久记忆): 这充当代理需要在各种交互、任务或延长期间保留信息的存储库,类似于长期知识库。数据通常存储在代理的即时处理环境之外,通常在数据库、知识图谱或向量数据库中。在向量数据库中,信息被转换为数字向量并存储,使代理能够基于语义相似性而非精确关键词匹配来检索数据,这一过程称为语义搜索。当代理需要从长期记忆中获取信息时,它查询外部存储,检索相关数据,并将其整合到短期上下文中以供即时使用,从而将先前知识与当前交互结合起来。

记忆管理对于代理跟踪信息并随时间智能执行至关重要。这对于代理超越基本问答能力来说是必不可少的。应用包括:

● 聊天机器人和对话AI: 维持对话流程依赖短期记忆。聊天机器人需要记住之前的用户输入以提供连贯的回应。长期记忆使聊天机器人能够回忆用户偏好、过往问题或先前讨论,提供个性化和持续的交互。

● 任务导向代理: 管理多步骤任务的代理需要短期记忆来跟踪先前步骤、当前进度和整体目标。这些信息可能存在于任务的上下文或临时存储中。长期记忆对于访问不在即时上下文中的特定用户相关数据至关重要。

● 个性化体验: 提供定制化交互的代理利用长期记忆来存储和检索用户偏好、过往行为和个人信息。这使代理能够调整其回应和建议。

● 学习和改进: 代理可以通过从过往交互中学习来改进其表现。成功策略、错误和新信息存储在长期记忆中,促进未来的适应。强化学习代理以这种方式存储学习的策略或知识。

● 信息检索(RAG): 专为回答问题而设计的代理访问知识库,即它们的长期记忆,通常在检索增强生成(Retrieval Augmented Generation, RAG)中实现。代理检索相关文档或数据来为其回应提供信息。

● 自主系统: 机器人或自动驾驶汽车需要地图、路线、物体位置和学习行为的记忆。这涉及用于即时环境的短期记忆和用于一般环境知识的长期记忆。

记忆使代理能够维持历史、学习、个性化交互,并管理复杂的、时间相关的问题。

Google代理开发工具包(Agent Developer Kit, ADK)提供了一种结构化的方法来管理上下文和记忆,包括用于实际应用的组件。牢固掌握ADK的会话(Session)、状态(State)和记忆(Memory)对于构建需要保留信息的代理至关重要。

正如在人类交互中一样,代理需要能够回忆之前的交流以进行连贯和自然的对话。ADK通过三个核心概念及其相关服务简化了上下文管理。

与代理的每次交互都可以被视为一个独特的对话线程。代理可能需要访问来自早期交互的数据。ADK将其结构化如下:

● 会话(Session): 一个单独的聊天线程,记录该特定交互的消息和操作(事件),同时存储与该对话相关的临时数据(状态)。

● 状态(session.state): 存储在会话中的数据,包含仅与当前活动聊天线程相关的信息。

● 记忆(Memory): 来源于各种过往聊天或外部来源信息的可搜索存储库,作为超出即时对话的数据检索资源。

ADK为管理构建复杂、有状态和上下文感知代理所必需的关键组件提供专门服务。会话服务(SessionService)通过处理聊天线程(会话对象)的启动、记录和终止来管理它们,而记忆服务(MemoryService)监督长期知识(记忆)的存储和检索。

会话服务和记忆服务都提供各种配置选项,允许用户根据应用需求选择存储方法。内存选项可用于测试目的,尽管数据在重启后不会持续存在。对于持久存储和可扩展性,ADK还支持数据库和基于云的服务。

ADK 中的 Session

对象用于跟踪和管理单个聊天线程。在与代理开始对话时,SessionService

生成一个 Session 对象,表示为

google.adk.sessions.Session。此对象封装了与特定对话线程相关的所有数据,包括唯一标识符(id、app_name、user_id)、以

Event

对象形式存储的事件时间记录、用于存储会话特定临时数据的状态存储区域,以及表示最后更新时间的时间戳(last_update_time)。开发者通常通过

SessionService 间接与 Session 对象交互。SessionService

负责管理对话会话的生命周期,包括启动新会话、恢复以前的会话、记录会话活动(包括状态更新)、识别活动会话以及管理会话数据的删除。ADK

提供了几个具有不同存储机制的 SessionService

实现,用于会话历史和临时数据存储,例如

InMemorySessionService,它适用于测试但不提供应用程序重启间的数据持久化。

示例:使用 InMemorySessionService这适用于本地开发和测试,不需要应用程序重启间的数据持久化from google.adk.sessions import InMemorySessionService session_service = InMemorySessionService() |

还有 DatabaseSessionService,如果你想可靠地保存到你管理的数据库。

示例:使用 DatabaseSessionService这适用于需要持久化存储的生产环境或开发环境你需要配置数据库 URL(例如,用于 SQLite、PostgreSQL 等)需要:pip install google-adk[sqlalchemy] 和数据库驱动程序(例如,PostgreSQL 用 psycopg2)from google.adk.sessions import DatabaseSessionService 使用本地 SQLite 文件的示例:db_url = “sqlite:///./my_agent_data.db” | session_service = DatabaseSessionService(db_url=db_url) |

此外,还有 VertexAiSessionService,它使用 Vertex AI 基础设施在 Google Cloud 上进行可扩展的生产部署。

+————————————————————————————————————————————————————————+ | # 示例:使用 VertexAiSessionService | | | | # 这适用于 Google Cloud Platform 上的可扩展生产环境,利用 | | | | # Vertex AI 基础设施进行会话管理 | | | | # 需要:pip install google-adk[vertexai] 和 GCP 设置/认证 | | | | from google.adk.sessions import VertexAiSessionService | | |

PROJECT_ID = "your-gcp-project-id" # 替换为您的GCP项目ID

LOCATION = "us-central1" # 替换为您期望的GCP位置

# 与此服务一起使用的app_name应该对应推理引擎ID或名称

REASONING_ENGINE_APP_NAME = "projects/your-gcp-project-id/locations/us-central1/reasoningEngines/your-engine-id" # 替换为您的推理引擎资源名称

session_service = VertexAiSessionService(project=PROJECT_ID, location=LOCATION)

# 使用此服务时,将REASONING_ENGINE_APP_NAME传递给服务方法:

# session_service.create_session(app_name=REASONING_ENGINE_APP_NAME, ...)

# session_service.get_session(app_name=REASONING_ENGINE_APP_NAME, ...)

# session_service.append_event(session, event, app_name=REASONING_ENGINE_APP_NAME)

# session_service.delete_session(app_name=REASONING_ENGINE_APP_NAME, ...)选择适当的SessionService至关重要,因为它决定了智能体的交互历史和临时数据如何存储以及它们的持久性。

每个消息交换都涉及一个循环过程:接收消息,Runner使用SessionService检索或建立Session,智能体使用Session的上下文(状态和历史交互)处理消息,智能体生成响应并可能更新状态,Runner将此封装为Event,session_service.append_event方法记录新事件并更新存储中的状态。然后Session等待下一条消息。理想情况下,当交互结束时使用delete_session方法来终止会话。此过程说明了SessionService如何通过管理Session特定的历史和临时数据来维护连续性。

在ADK中,每个Session代表一个聊天线程,包含一个状态组件,类似于智能体在特定对话期间的临时工作记忆。虽然session.events记录整个聊天历史,但session.state存储和更新与活动聊天相关的动态数据点。

从根本上说,session.state作为字典运行,以键值对的形式存储数据。其核心功能是使智能体能够保留和管理对连贯对话至关重要的详细信息,例如用户偏好、任务进度、增量数据收集或影响后续智能体行为的条件标志。

状态的结构由字符串键和可序列化Python类型的值组成,包括字符串、数字、布尔值、列表以及包含这些基本类型的字典。状态是动态的,在整个对话过程中不断演变。这些变化的持久性取决于配置的SessionService。

状态组织可以通过使用键前缀来定义数据范围和持久性。没有前缀的键是特定于会话的。

• user:前缀将数据与跨所有会话的用户ID关联。

• app:前缀指定在应用程序的所有用户之间共享的数据。

•

temp:前缀表示仅在当前处理轮次中有效的数据,不会持久存储。

Agent(智能体)通过单个session.state字典访问所有状态数据。SessionService处理数据检索、合并和持久性。在通过session_service.append_event()向会话历史记录添加Event时,应更新状态。这确保了准确的跟踪、在持久服务中的正确保存以及状态变化的安全处理。

如果您只想将Agent的最终文本响应直接保存到状态中,这是最简单的方法。当您设置LlmAgent时,只需告诉它您要使用的output_key。Runner看到这个并在追加事件时自动创建必要的操作将响应保存到状态。

让我们看一个通过output_key演示状态更新的代码示例。

# 从Google Agent Developer Kit (ADK)导入必要的类

from google.adk.agents import LlmAgent

from google.adk.sessions import InMemorySessionService, Session

from google.adk.runners import Runner

from google.genai.types import Content, Part

# 定义一个带有output_key的LlmAgent

greeting_agent = LlmAgent(

name="Greeter",

model="gemini-2.0-flash",

instruction="Generate a short, friendly greeting.",

output_key="last_greeting"

)

# --- 设置Runner和Session ---

app_name, user_id, session_id = "state_app", "user1", "session1"

session_service = InMemorySessionService()

runner = Runner(

agent=greeting_agent,

app_name=app_name,

session_service=session_service

)

session = session_service.create_session(

app_name=app_name,[ user_id=user_id,]

[ session_id=session_id]

)

print(f"Initial state: {session.state}")

# --- 运行智能体(Agent) ---

user_message = Content(parts=[Part(text="Hello")])

print("\n--- 运行智能体 ---")

for event in runner.run(

[ user_id=user_id,]

[ session_id=session_id,]

[ new_message=user_message]

):

[ if event.is_final_response():]

[ print("智能体已响应。")]

# --- 检查更新状态 ---

# 正确地在运行器完成处理所有事件*之后*检查状态。

updated_session = session_service.get_session(app_name, user_id, session_id)

print(f"\n智能体运行后的状态: {updated_session.state}")在幕后,运行器(Runner)看到您的output_key并在调用append_event时自动创建必要的带有state_delta的操作。

当您需要做更复杂的事情时——比如一次更新多个键、保存不仅仅是文本的内容、针对特定范围如user:或app:,或者进行与智能体最终文本回复无关的更新——您将手动构建状态更改字典(state_delta)并将其包含在您要追加的事件(Event)的EventActions中。让我们看一个例子:

import time

from google.adk.tools.tool_context import ToolContext

from google.adk.sessions import InMemorySessionService

# --- 定义推荐的基于工具的方法 ---

def log_user_login(tool_context: ToolContext) -> dict:

"""

在用户登录事件时更新会话状态。

"""log_user_login工具内部更新。”)] |此代码演示了用于管理应用程序中用户会话状态的基于工具的方法。它定义了一个函数log_user_login,该函数充当工具。此工具负责在用户登录时更新会话状态。

该函数接收由ADK提供的ToolContext对象,用于访问和修改会话的状态字典。在工具内部,它递增user:login_count,将task_status设置为”active”,记录user:last_login_ts(时间戳),并添加临时标志temp:validation_needed。

代码的演示部分模拟了这个工具的使用方式。它建立了一个内存会话服务并创建了一个具有预定义状态的初始会话。然后手动创建一个 ToolContext 来模拟 ADK Runner 执行工具时的环境。使用这个模拟上下文调用 log_user_login 函数。最后,代码再次检索会话以显示状态已被工具执行更新。目标是展示如何将状态更改封装在工具内部使代码比直接在工具外部操作状态更清洁和有组织。

注意,在检索会话后直接修改 session.state

字典是强烈不建议的,因为它绕过了标准的事件处理机制。这种直接更改不会记录在会话的事件历史中,可能不会被选定的

SessionService

持久化,可能导致并发问题,并且不会更新时间戳等关键元数据。更新会话状态的推荐方法是使用

LlmAgent 上的 output_key

参数(专门用于代理的最终文本响应)或在通过

session_service.append_event() 附加事件时在

EventActions.state_delta

中包含状态更改。session.state 应主要用于读取现有数据。

总结一下,在设计状态时,保持简单,使用基本数据类型,为键提供清晰的名称并正确使用前缀,避免深层嵌套,并始终使用 append_event 过程更新状态。

在代理系统中,Session 组件维护当前聊天历史(事件)的记录和特定于单个对话的临时数据(状态)。然而,为了让代理在多次交互中保留信息或访问外部数据,需要长期知识管理。这通过 MemoryService 来实现。

# 示例:使用 InMemoryMemoryService

# 这适合本地开发和测试,其中不需要跨应用程序重启的数据

# 持久性。应用程序停止时内存内容会丢失。

from google.adk.memory import InMemoryMemoryService

memory_service = InMemoryMemoryService()Session 和 State 可以概念化为单个聊天会话的短期记忆,而 MemoryService 管理的长期知识作为持久和可搜索的存储库。此存储库可能包含来自多个过去交互或外部来源的信息。MemoryService,如 BaseMemoryService 接口所定义,为管理这个可搜索的长期知识建立了标准。其主要功能包括添加信息,涉及从会话中提取内容并使用 add_session_to_memory 方法存储;以及检索信息,允许代理查询存储并使用 search_memory 方法接收相关数据。

ADK 提供了几种实现来创建这个长期知识存储。InMemoryMemoryService 提供了适合测试目的的临时存储解决方案,但数据不会跨应用程序重启保留。对于生产环境,通常使用 VertexAiRagMemoryService。此服务利用 Google Cloud 的检索增强生成(RAG)服务,实现可扩展、持久和语义搜索功能(另请参阅第14章关于RAG)。

# 示例:使用 VertexAiRagMemoryService

# 这适合在 GCP 上的可扩展生产环境,利用

# Vertex AI RAG(检索增强生成)实现持久、

# 可搜索的内存。

# 需要:pip install google-adk[vertexai],GCP# 设置/身份验证,以及 Vertex AI RAG 语料库(RAG Corpus)

from google.adk.memory import VertexAiRagMemoryService

# 您的 Vertex AI RAG 语料库(RAG Corpus)的资源名称

RAG_CORPUS_RESOURCE_NAME = "projects/your-gcp-project-id/locations/us-central1/ragCorpora/your-corpus-id" # 替换为您的语料库资源名称

# 检索行为的可选配置

SIMILARITY_TOP_K = 5 # 要检索的顶部结果数量

VECTOR_DISTANCE_THRESHOLD = 0.7 # 向量相似度阈值

memory_service = VertexAiRagMemoryService(

rag_corpus=RAG_CORPUS_RESOURCE_NAME,

similarity_top_k=SIMILARITY_TOP_K,

vector_distance_threshold=VECTOR_DISTANCE_THRESHOLD

)

# 使用此服务时,add_session_to_memory 等方法

# 和 search_memory 将与指定的 Vertex AI

# RAG 语料库(RAG Corpus)交互。在LangChain和LangGraph中,内存是创建智能且自然对话应用程序的关键组件。它允许AI智能体记住过去交互中的信息,从反馈中学习,并适应用户偏好。LangChain的内存功能通过引用存储的历史记录来丰富当前提示,然后记录最新交换以供将来使用,为此提供了基础。随着智能体处理更复杂的任务,这种能力对于效率和用户满意度都变得至关重要。

这是线程范围的,意味着它跟踪单个会话或线程内的正在进行的对话。它提供即时上下文,但完整的历史记录可能会挑战LLM的上下文窗口,可能导致错误或性能不佳。LangGraph将短期内存作为智能体状态的一部分进行管理,通过检查点器持久化,允许线程随时恢复。

这存储跨会话的用户特定或应用级数据,并在对话线程之间共享。它保存在自定义”命名空间”中,可以在任何线程中随时调用。LangGraph提供存储来保存和回忆长期记忆,使智能体能够无限期地保留知识。

LangChain提供了几种管理对话历史的工具,从手动控制到链内自动集成。

对于在正式链之外直接简单地控制对话历史记录,ChatMessageHistory类是理想的选择。它允许手动跟踪对话交换。

from langchain.memory import ChatMessageHistory

# 初始化历史记录对象

history = ChatMessageHistory()

# 添加用户和AI消息

history.add_user_message("我下周要去纽约。")

history.add_ai_message("太好了!那是一个很棒的城市。")

# 访问消息列表

print(history.messages)为了将内存直接集成到链中,ConversationBufferMemory是一个常见选择。它保存对话的缓冲区并使其可用于您的提示。它的行为可以通过两个关键参数进行自定义:

• memory_key:一个字符串,指定提示中将保存聊天历史记录的变量名。默认为”history”。

• return_messages:一个布尔值,决定历史记录的格式。 ○ 如果为False(默认),它返回单个格式化字符串,这对标准LLM是理想的。 ○ 如果为True,它返回消息对象列表,这是聊天模型的推荐格式。

from langchain.memory import ConversationBufferMemory

# 初始化内存

memory = ConversationBufferMemory()

# 保存一个对话轮次

memory.save_context({"input": "天气怎么样?"}, {"output": "今天阳光明媚。"})+————————————————————————-+

将这种内存集成到LLMChain(LLM链)中,允许模型访问对话历史记录并提供与上下文相关的回复

from langchain_openai import OpenAI from langchain.chains import LLMChain from langchain.prompts import PromptTemplate from langchain.memory import ConversationBufferMemory 1. 定义LLM和提示llm = OpenAI(temperature=0) template = “““你是一个有用的旅行代理。 之前的对话: {history} 新问题:{question} 回复:““” prompt = PromptTemplate.from_template(template) 2. 配置内存memory_key “history” 与提示中的变量匹配memory = ConversationBufferMemory(memory_key=“history”) 3. 构建链conversation = LLMChain(llm=llm, prompt=prompt, memory=memory) 4. 运行对话response = conversation.predict(question=“我想预订航班。”) print(response) response = conversation.predict(question=“顺便说一下,我叫Sam。”) print(response) response = conversation.predict(question=“我的名字是什么来着?”) print(response) |

为了提高聊天模型的效果,建议通过设置return_messages=True来使用结构化的消息对象列表。

+————————————————————————-+ | from langchain_openai import ChatOpenAI | | | | from langchain.chains import LLMChain | | |

长期记忆使系统能够在不同对话中保留信息,提供更深层次的上下文和个性化。它可以分为三种类似人类记忆的类型:

• 语义记忆:记住事实: 这涉及保留特定的事实和概念,比如用户偏好或领域知识。它用于为智能代理的回答提供依据,从而实现更加个性化和相关的交互。这些信息可以作为持续更新的用户”档案”(JSON文档)或作为单个事实文档的”集合”来管理。

• 情景记忆:记住经历: 这涉及回忆过去的事件或行动。对于AI代理来说,情景记忆通常用于记住如何完成任务。在实践中,它经常通过少样本示例提示(few-shot example prompting)来实现,智能代理从过去成功的交互序列中学习,以正确执行任务。

• 程序记忆:记住规则: 这是关于如何执行任务的记忆——智能代理的核心指令和行为,通常包含在其系统提示中。智能代理修改自己的提示以适应和改进是很常见的。一个有效的技术是”反思”(Reflection),即用当前指令和最近的交互提示智能代理,然后要求它完善自己的指令。

以下是演示智能代理如何使用反思来更新存储在LangGraph BaseStore中的程序记忆的伪代码

# 更新智能代理指令的节点

def update_instructions(state: State, store: BaseStore):

namespace = ("instructions",)

# 从存储中获取当前指令