“安德鲁期待已久的《百页机器学习》系列教科书续作是简明性的杰作。”

― Bob van Luijt,Weaviate CEO兼联合创始人

“安德鲁拥有这种近乎超自然的天赋,能够将宏伟的AI概念压缩成一口大小的’啊,现在我明白了!’的瞬间。”

― Jorge Torres,MindsDB CEO

“安德鲁用100笔精彩的笔触为我们描绘了从线性代数基础到transformer实现的旅程。”

― Florian Douetteau,Dataiku联合创始人兼CEO

“安德鲁的书是一本极其简洁、清晰和易懂的机器学习入门读物。”

― Andre Zayarni,Qdrant联合创始人兼CEO

“这是一本最全面但简洁的手册,真正理解LLM如何在底层运作。”

― Jerry Liu,LlamaIndex联合创始人兼CEO

由托马什·米科洛夫(Tomáš Mikolov)作序,文特·瑟夫(Vint Cerf)撰写封底推荐

安德鲁·布尔科夫(Andriy Burkov)

版权所有 © 2025 安德鲁·布尔科夫。保留所有权利。

先读后买: 欢迎您通过保留此版权声明来自由阅读和与他人分享此书。但是,如果您发现这本书有价值或继续使用它,您必须购买自己的副本。这确保了公平性并支持作者。

禁止未经授权使用: 在未经作者明确书面同意的情况下,本作品的任何部分——其文本、结构或衍生物——不得用于训练人工智能或机器学习模型,也不得用于在网站、应用程序或其他服务上生成任何内容。此限制适用于所有形式的自动化或算法处理。

需要许可: 如果您运营任何网站、应用程序或服务,并希望将本作品的任何部分用于上述目的——或用于个人阅读之外的任何其他用途——您必须首先获得作者的明确书面许可。不授予例外或暗示许可。

执行: 任何违反这些条款的行为都是版权侵权。可能在任何司法管辖区内进行法律追究。通过阅读或分发此书,您同意遵守这些条件。

ISBN 978-1-7780427-2-0

出版商:True Positive Inc.

献给我的家人,致以爱意

“语言是误解的源泉。” ——安托万·德·圣埃克苏佩里,《小王子》

“在数学中你不理解事物。你只是习惯了它们。”

——约翰·冯·诺伊曼

“计算机是无用的。它们只能给你答案。”

——巴勃罗·毕加索

本书采用”先读后买”原则发行

前言 [9]

序言 [11]

本书适合谁 [11]

本书不是什么 [12]

书籍结构 [13]

您应该购买这本书吗? [14]

致谢 [15]

1.1. AI和机器学习 [16]

1.2. 模型 [16]

1.3. 四步机器学习过程 [28]

1.4. 向量 [28]

1.5. 神经网络 [32]

1.6. 矩阵 [37]

1.7. 梯度下降 [40]

1.8. 自动微分 [45]

2.1. 词袋模型 [50]

2.2. 词嵌入 [63]

2.3. 字节对编码 [70]

2.4. 语言模型 [75]

2.5. 基于计数的语言模型 [77]

2.6. 评估语言模型 [84]

3.1. Elman RNN [98]

3.2. 小批量梯度下降 [100]

3.3. 编程RNN [101]

3.4. RNN作为语言模型 [104]

3.5. 嵌入层 [105]

3.6. 训练RNN语言模型 [107]

3.7. 数据集和DataLoader [111]

3.8. 训练数据和损失计算 [113]

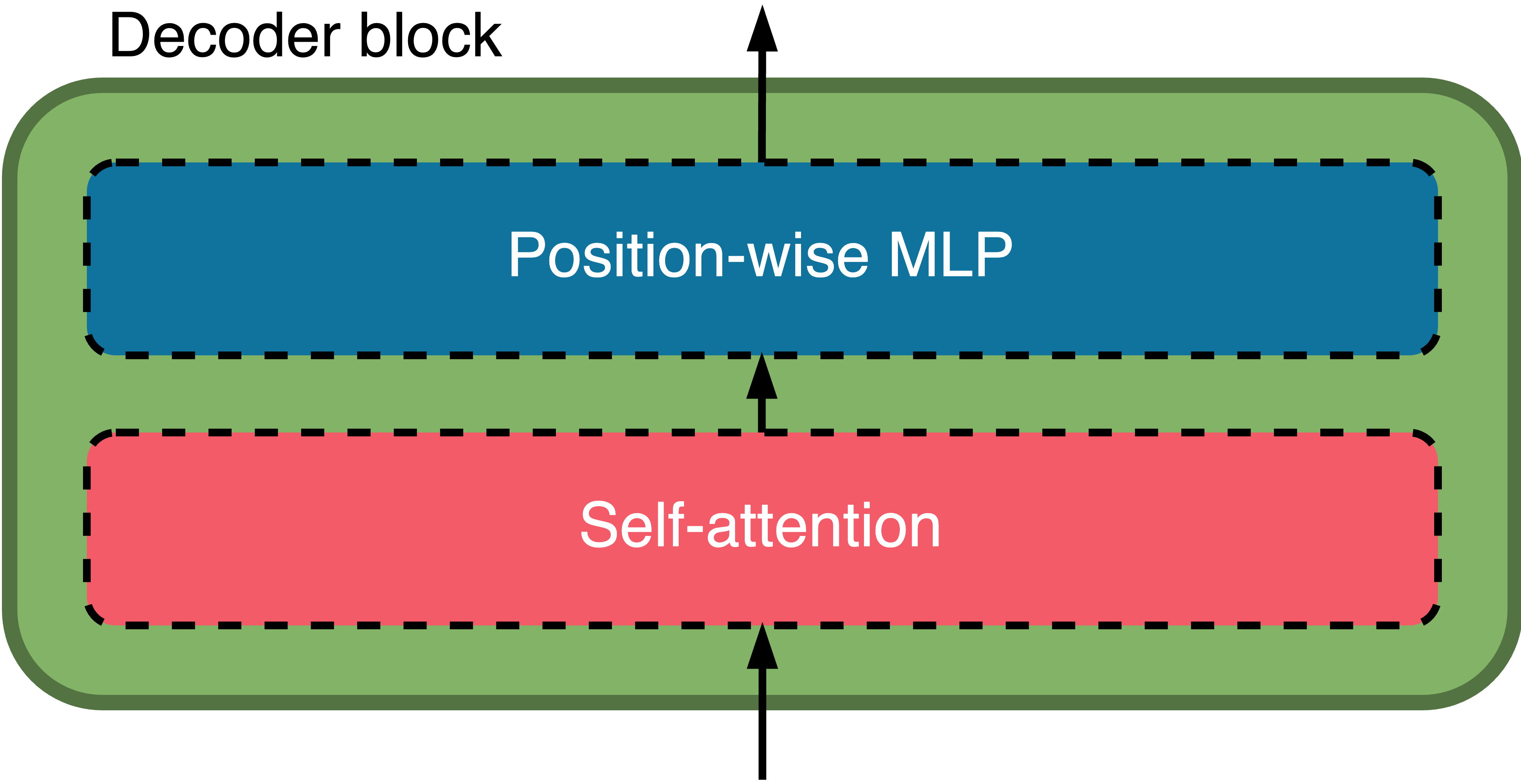

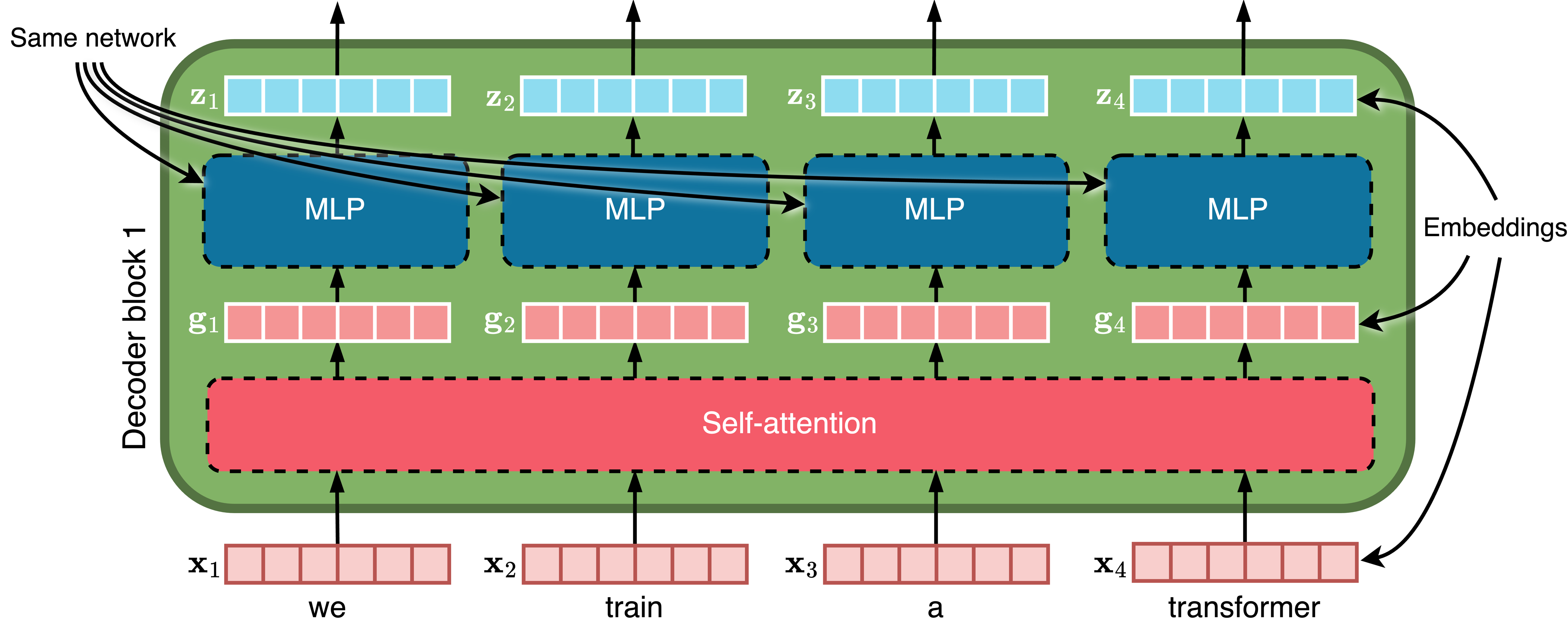

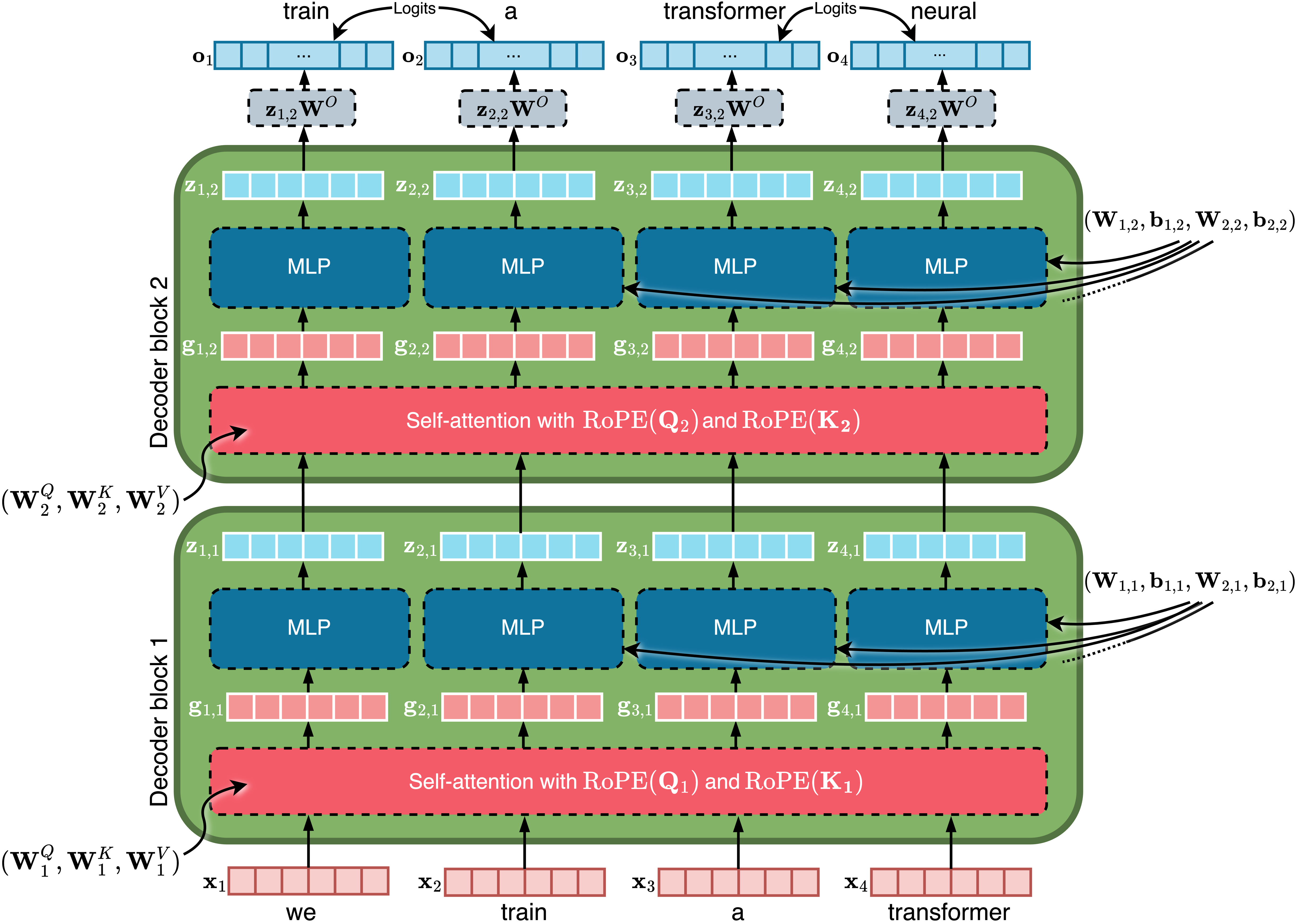

4.1. 解码器块 [117]

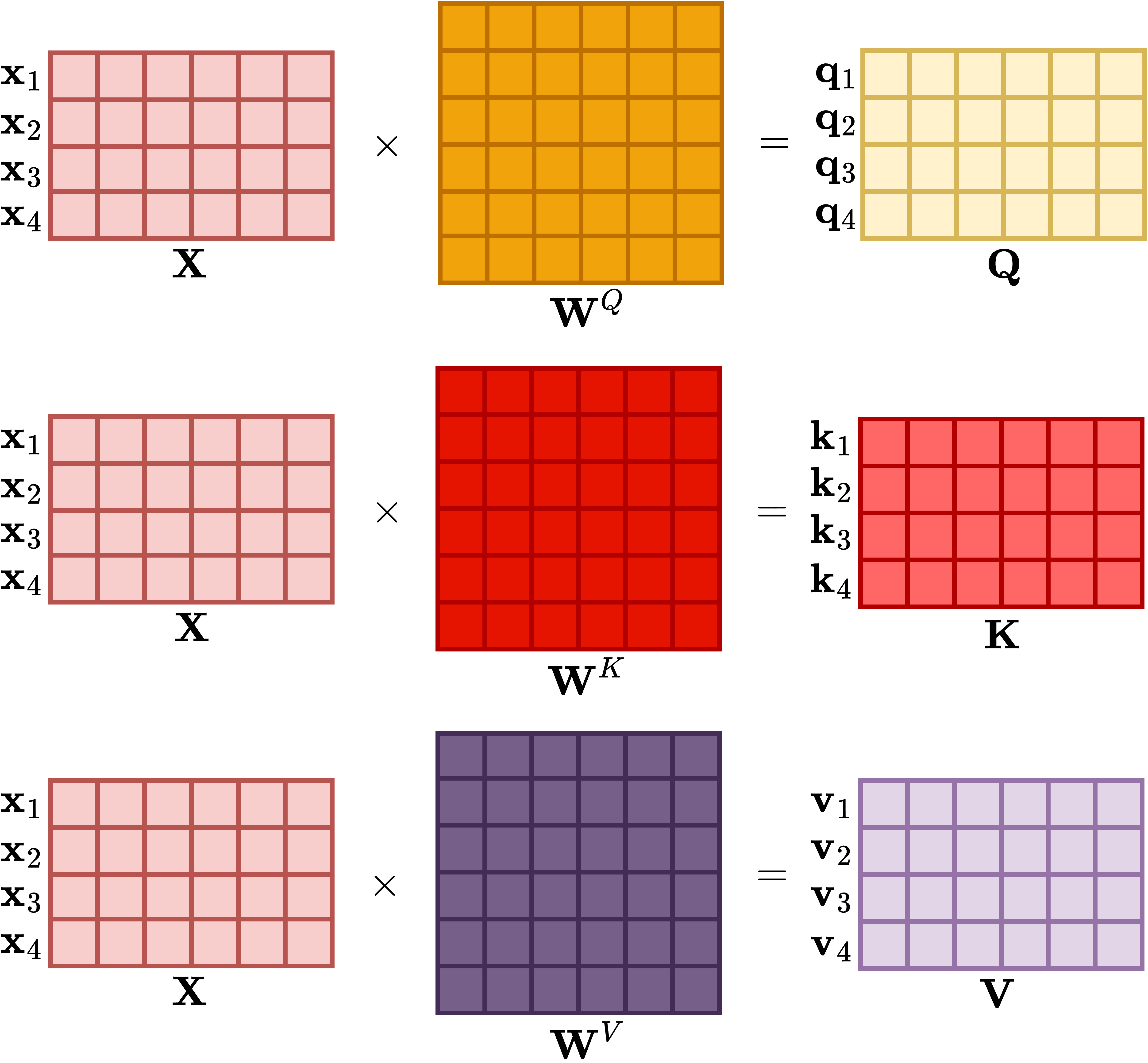

4.2. 自注意力 [119]

4.3. 位置感知多层感知器 [123]

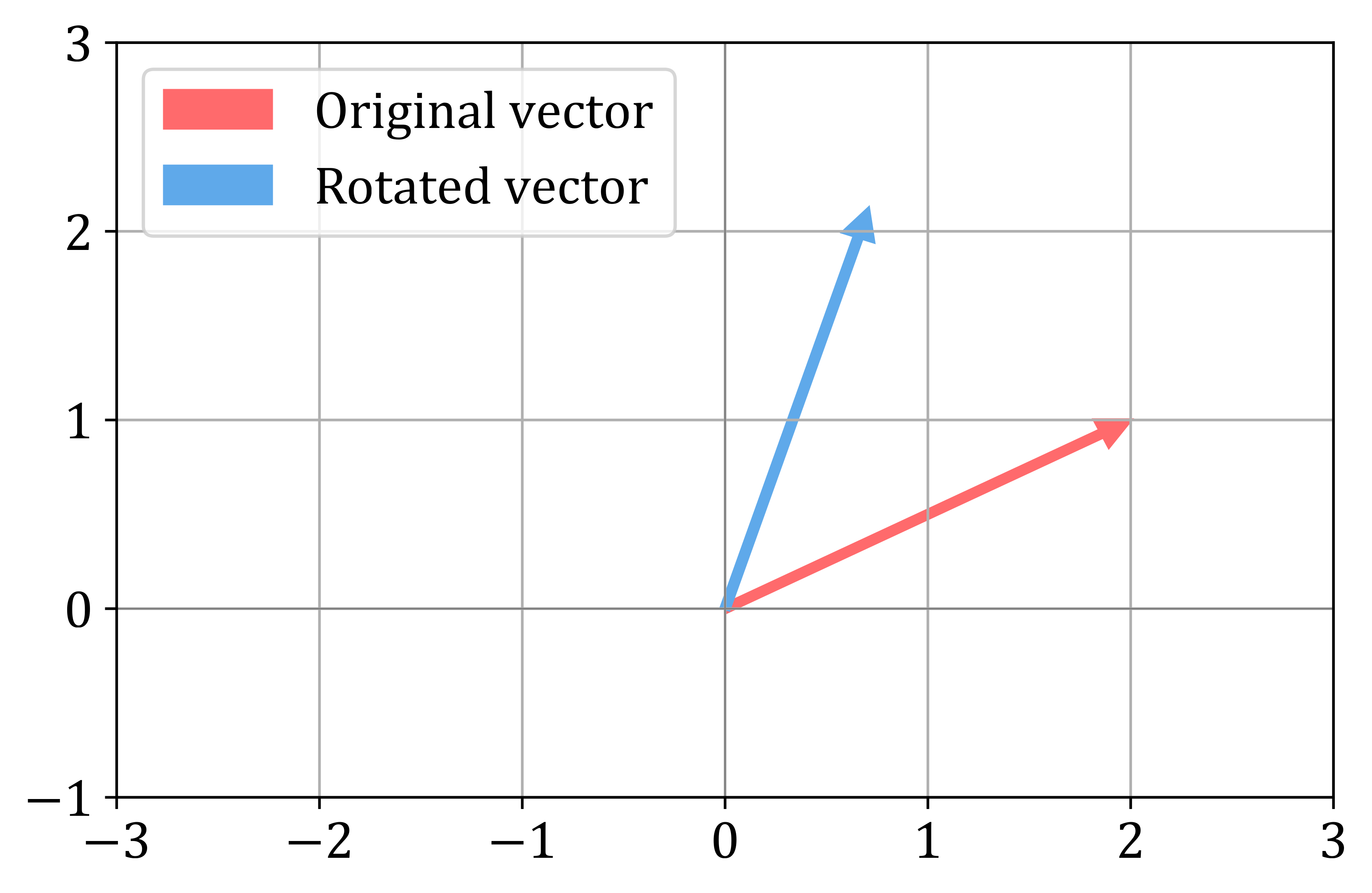

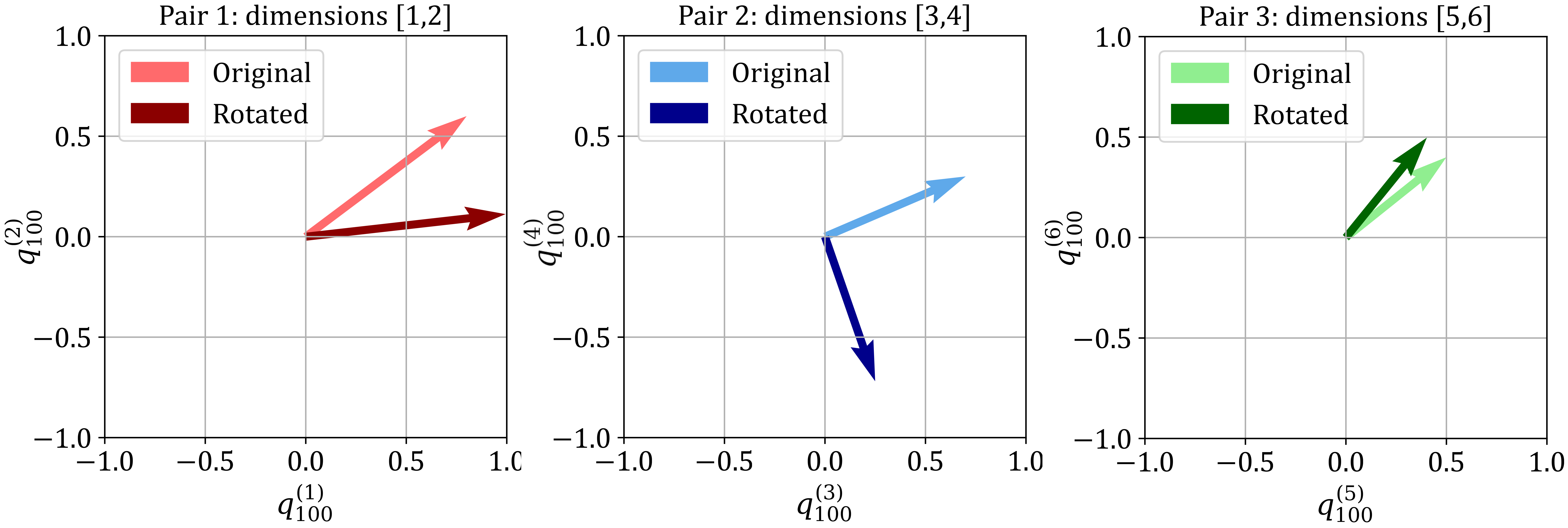

4.4. 旋转位置嵌入 [124]

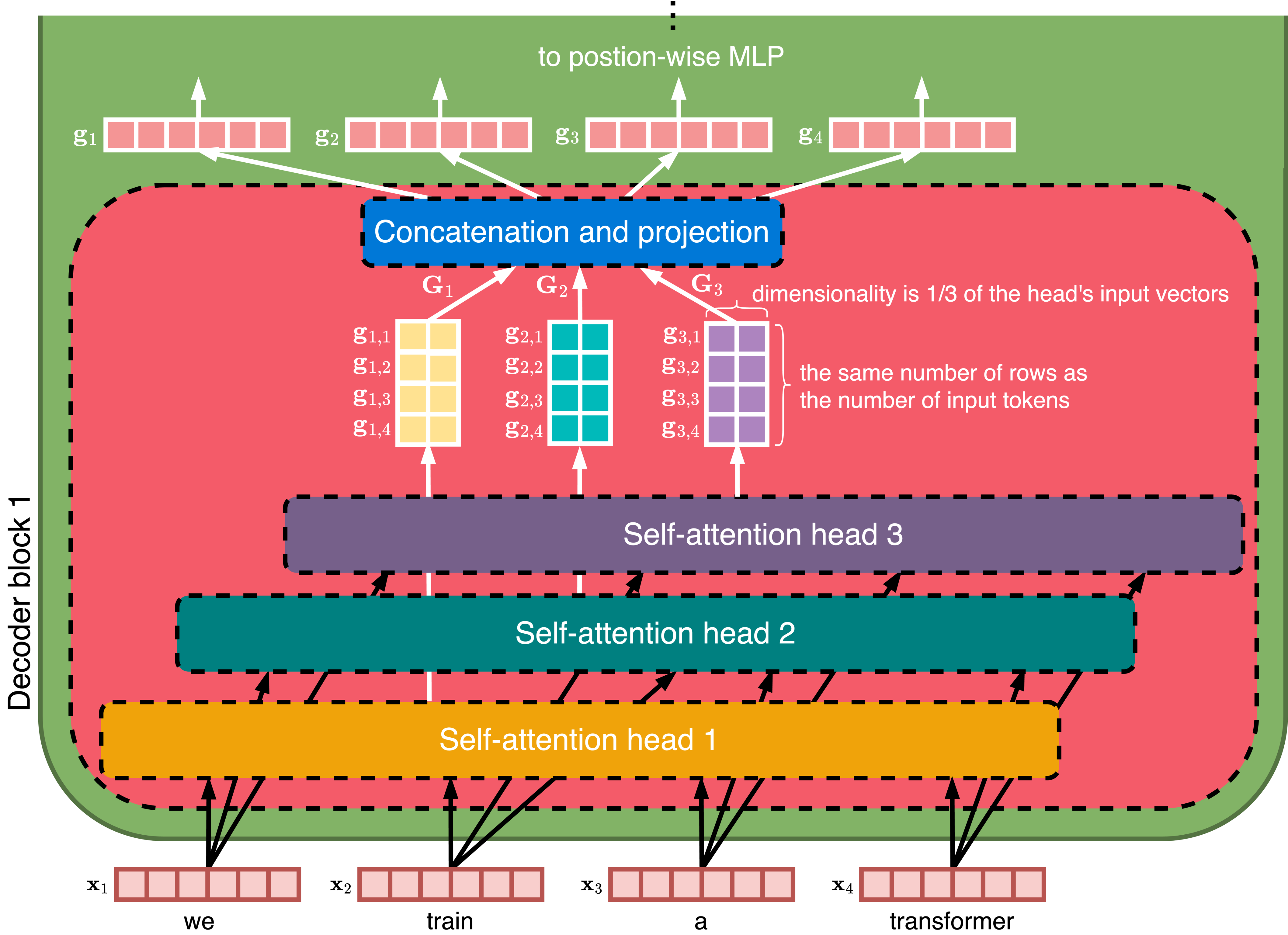

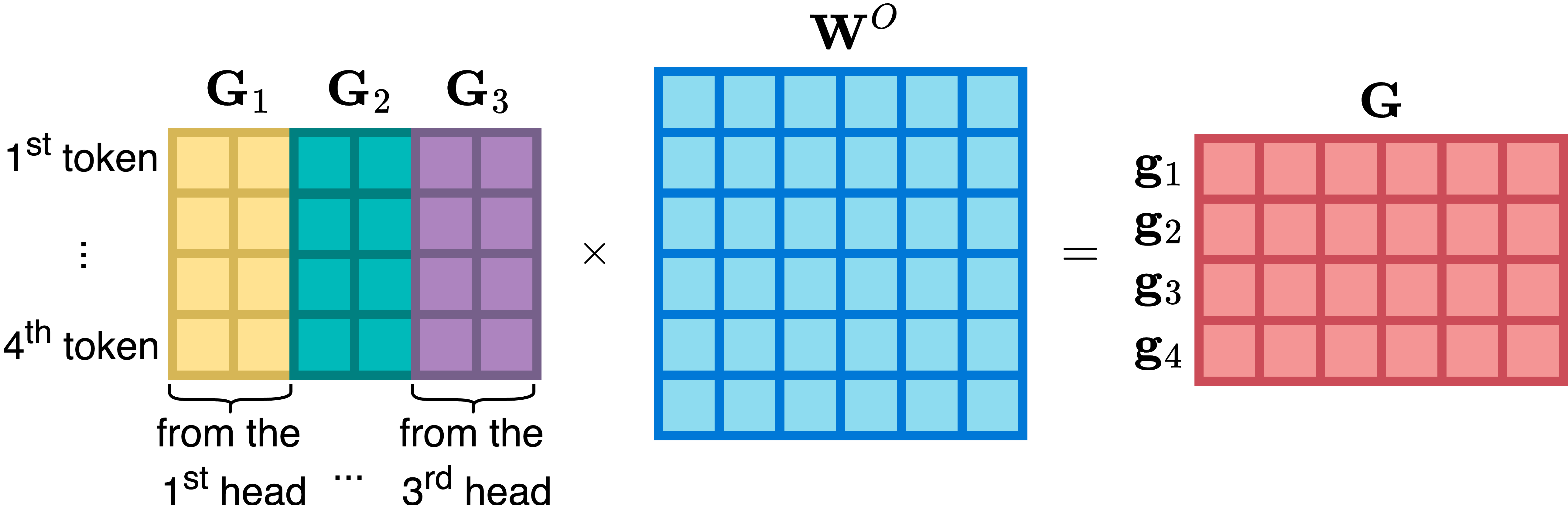

4.5. 多头注意力 [131]

4.6. 残差连接 [133]

4.7. 均方根归一化 [136]

4.8. 键值缓存 [138]

4.9. Python中的Transformer [139]

5.1. 为什么更大更好 [147]

5.2. 监督微调 [154]

5.3. 微调预训练模型 [156]

5.4. 从语言模型中采样 [171]

5.5. 低秩适应(LoRA) [176]

5.6. LLM作为分类器 [180]

5.7. 提示工程 [182]

5.8. 幻觉 [188]

5.9. LLM、版权和伦理 [191]

6.1. 专家混合 [195]

6.2. 模型合并 [195]

6.3. 模型压缩 [196]

6.4. 基于偏好的对齐 [196]

6.5. 高级推理 [196]

6.6. 语言模型安全 [197]

6.7. 视觉语言模型 [197]

6.8. 防止过拟合 [198]

6.9. 结语 [198]

6.10. 作者更多作品 [199]

索引 [201]

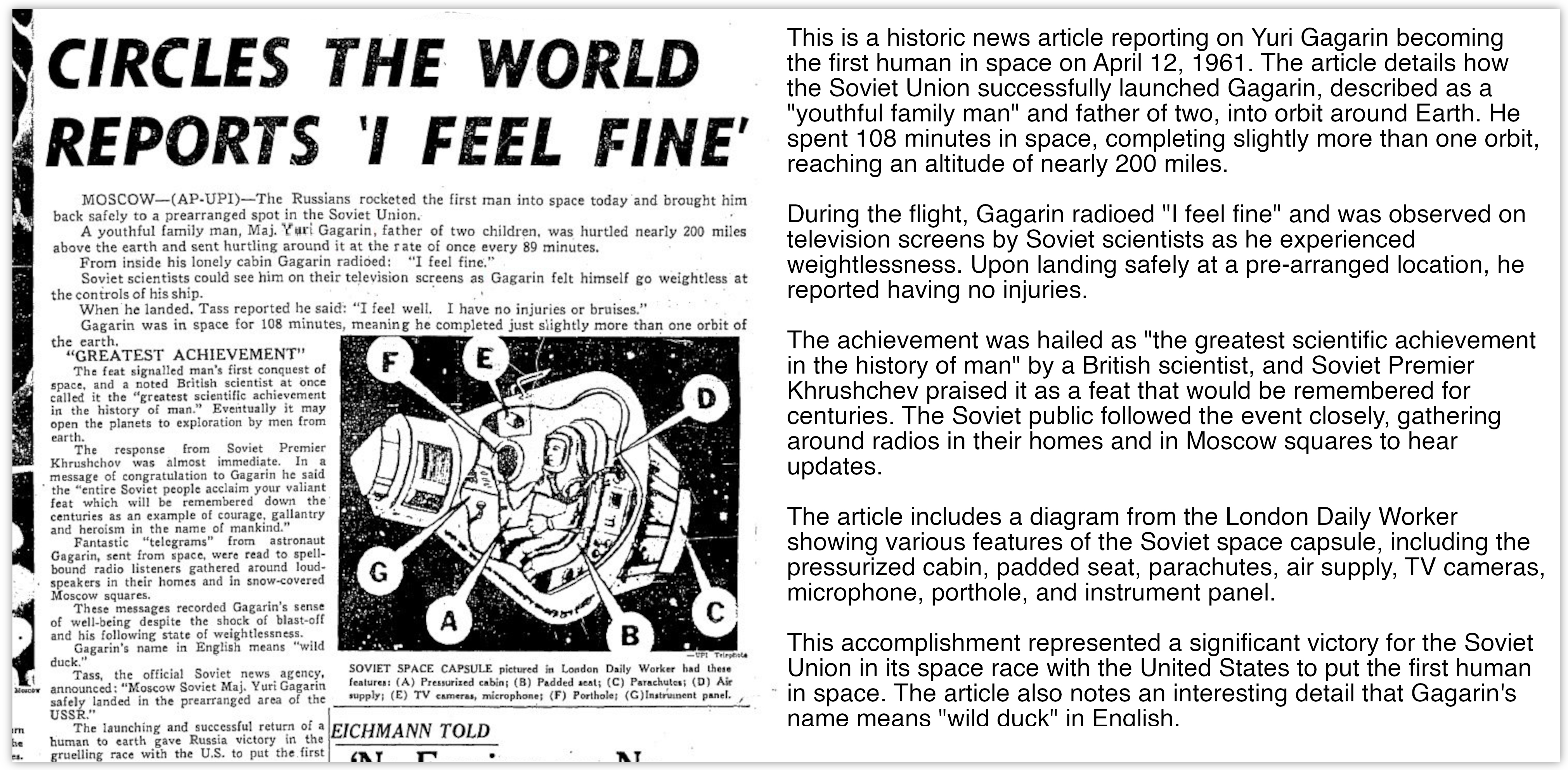

我第一次参与语言建模已经是二十年前的事了。我想改进一些数据压缩算法,发现了n-gram统计。概念非常简单,但如此难以超越!然后我很快获得了另一个动机——从童年开始,我就对人工智能感兴趣。我有一个愿景,机器能够理解我们这个世界中对我们有限的头脑来说是隐藏的模式。与这样的超级智能对话将是多么令人兴奋。我意识到语言建模可能是通向这种AI的一条路径。

我开始寻找其他分享这一愿景的人,确实找到了Solomonoff、Schmidhuber的作品,以及Matt Mahoney组织的Hutter奖竞赛。他们都曾写过关于语言建模的AI完备性,我知道我必须尝试让它发挥作用。但那时的世界与今天截然不同。语言建模被认为是一个死的研究方向,我无数次听到有人说我应该放弃,因为在大数据上没有什么能够打败n-grams。

我完成了关于神经语言模型的硕士论文,因为这些模型与我之前为数据压缩开发的模型非常相似,我确实相信可以应用于任何语言的分布式表示是正确的方向。这激怒了一位当地的语言学家,他宣称我的想法完全是胡说八道,因为语言建模必须从语言学的角度来解决,每种语言都必须区别对待。

然而,我没有放弃,继续致力于我对AI完备语言模型的愿景。就在开始攻读博士学位之前的那个夏天,我想出了从这些神经模型生成文本的想法。我对这些文本比n-grams模型生成的文本好得多感到惊讶。那是2007年夏天,我很快意识到在布尔诺理工大学中,对此感到兴奋的人实际上只有我一个。但我还是没有放弃。

在接下来的几年里,我开发了许多算法来使神经语言模型更加有用。为了让其他人相信它们的质量,我在2010年发布了开源工具包RNNLM。它包含了神经文本生成、梯度裁剪、动态评估、模型适应(现在称为微调fine-tuning)以及其他技巧如分层softmax或将低频词分割为子词单元的首次实现。然而,我最自豪的结果是当我能够在博士论文中证明神经语言模型不仅在大数据集上击败了n-grams——这在当时被广泛认为是不可能的——而且改进实际上随着训练数据量的增加而增加。这是在大约五十年的语言建模研究后首次发生,我仍然记得当我向著名研究人员展示我的工作时,他们脸上的不敢置信。

快进大约十五年,我对世界发生的巨大变化感到惊讶。思维模式完全翻转了——过去在一个死的研究方向中的一些晦涩技术现在正在蓬勃发展,并得到了世界上最大公司CEO的关注。语言模型如今无处不在。在这种炒作下,我认为比以往任何时候都更需要真正理解这项技术。

想要学习语言建模的年轻学生被信息淹没。因此,当我了解到Andriy的项目——写一本只有一百页的简短书籍来涵盖一些最重要的想法时,我感到高兴。我认为这本书对于任何语言建模新手来说都是一个很好的开始,他们渴望改进最先进的技术——如果有人告诉你语言建模中所有可能被发明的东西都已经被发现了,不要相信。

Tomáš Mikolov,捷克信息学、机器人学和控制论研究所高级研究员,word2vec和FastText的作者

我对文本的兴趣始于1990年代末的青少年时期,当时我使用Perl和HTML构建动态网站。这种早期的编码经验以及将文本组织成结构化格式的体验激发了我对文本如何被处理和转换的迷恋。多年来,我进步到构建网络爬虫和文本聚合器,开发从网页中提取结构化数据的系统。处理和理解文本的挑战引导我探索更复杂的应用,包括设计能够理解和满足用户需求的聊天机器人。

从词语中提取意义的挑战让我着迷。任务的复杂性只会激发我”破解”它的决心,使用我能掌握的每一个工具——从正则表达式和脚本语言到文本分类器和命名实体识别模型。

大语言模型(LLMs)的兴起改变了一切。计算机第一次能够与我们流畅地对话,并以令人瞩目的精确度遵循口头指令。然而,像任何工具一样,它们巨大的力量伴随着局限性。有些很容易发现,但其他的更加微妙,需要深厚的专业知识才能正确处理。试图在不完全理解你的工具的情况下建造摩天大楼只会导致一堆混凝土和钢铁。语言模型也是如此。处理大规模文本处理任务或为付费用户创建可靠产品需要精确性和知识——猜测根本不是一个选择。

我为那些像我一样被通过机器理解语言的挑战所吸引的人写了这本书。语言模型在其核心只是数学函数。然而,它们的真正潜力在理论上并不能完全被理解——你需要实现它们才能看到它们的力量以及它们的能力如何随着规模的扩大而增长。这就是为什么我决定让这本书具有实践性。

这本书服务于软件开发人员、数据科学家、机器学习工程师,以及任何对语言模型感到好奇的人。无论你的目标是将现有模型集成到应用程序中还是训练你自己的模型,你都会找到实用指导和理论基础。

考虑到其一百页的格式,本书对读者做出了某些假设。你应该有编程经验,因为所有实践示例都使用Python。

虽然熟悉PyTorch和张量(tensors)——PyTorch的基本数据类型——是有益的,但这不是必需的。如果你是这些工具的新手,本书的

wiki (thelmbook.com/wiki) 提供了简洁的介绍,包含示例和资源链接供进一步学习。这种wiki格式确保内容保持最新,并解决读者在出版后的疑问。

大学水平的数学知识会有帮助,但你不需要记住每个细节或拥有机器学习经验。本书系统性地介绍概念,从符号、定义和基本向量矩阵运算开始。然后从简单的神经网络逐步发展到更高级的主题。数学概念以直观的方式呈现,配有清晰的图表和示例来促进理解。

本书专注于理解和实现语言模型。它不会涵盖:

• 大规模训练:本书不会教你如何在分布式系统上训练大型模型或如何管理训练基础设施。

• 生产部署:模型服务、API开发、高流量扩展、监控和成本优化等主题不在涵盖范围内。代码示例专注于理解概念而非生产就绪性。

• 企业应用:本书不会指导你构建商业LLM应用程序、处理用户数据或与现有系统集成。

如果你有兴趣学习语言模型的数学基础、理解它们的工作原理、自己实现核心组件或学习如何有效地使用LLM,那么这本书适合你。但如果你主要想要在生产环境中部署模型或构建可扩展的应用程序,你可能需要用其他资源来补充本书。

为了使本书引人入胜并加深读者的理解,我决定将语言建模作为一个整体来讨论,包括在现代文献中经常被忽视的方法。虽然基于Transformer的LLM占据了聚光灯,但像基于计数的方法和循环神经网络(RNN)等早期方法在某些任务中仍然有效。

对于从零开始的人来说,从头学习Transformer架构的数学可能看起来令人生畏。通过重新审视这些基础方法,我的目标是逐步建立读者的直觉和数学理解,使向现代Transformer架构的过渡感觉像是自然的进步而不是令人畏惧的跳跃。

本书分为六章,从基础到高级主题逐步发展:

• 第1章涵盖机器学习基础,包括AI、模型、神经网络和梯度下降等关键概念。即使你已经熟悉这些主题,本章也为理解语言模型提供了重要基础。

• 第2章介绍语言建模基础,探索像词袋和词嵌入等文本表示方法,以及基于计数的语言模型和评价技术。

• 第3章专注于循环神经网络,涵盖它们的实现、训练和作为语言模型的应用。

• 第4章详细探索Transformer架构,包括自注意力、位置嵌入和实际实现等关键组件。

• 第5章考察大型语言模型(LLM),讨论为什么规模很重要、微调技术、实际应用,以及关于幻觉、版权和伦理的重要考虑。

• 第6章总结了进一步阅读高级主题,如专家混合、模型压缩、基于偏好的对齐和视觉语言模型,为持续学习提供方向。

大多数章节包含你可以运行和修改的工作代码示例。虽然书中只出现必要的代码,但完整代码在书的网站上以Jupyter笔记本形式提供,相关章节中会引用这些笔记本。笔记本中的所有代码都与Python、PyTorch和其他库的最新稳定版本兼容。

这些笔记本在Google Colab上运行,在撰写本文时,Colab提供免费访问计算资源,包括GPU和TPU。不过,这些资源不能保证且有使用限制,可能会有所变化。一些示例可能需要扩展的GPU访问,可能涉及等待可用性的时间。如果免费层级有限制,Colab的按需付费选项允许你购买计算积分以获得可靠的GPU访问。虽然按北美标准这些积分相对便宜,但根据你的位置,成本可能很大。

对于熟悉Linux命令行的人,GPU云服务通过带有一个或多个GPU的按时间付费虚拟机提供另一种选择。本书的wiki维护关于免费和付费笔记本或GPU租赁服务的最新信息。

逐字术语和块表示代码、代码片段或代码执行输出。粗体术语链接到书的术语索引,偶尔突出算法步骤。

在本书中,我们使用pip3来确保为Python 3安装包。在大多数现代系统上,如果已经为Python 3设置了pip,你可以使用pip。

像我之前的两本书一样,这本书按照先读后买的原则分发。我坚信在消费内容之前付费意味着盲目购买。在经销商那里,你可以看到并试驾汽车。在百货商店,你可以试穿衣服。同样,你应该能够在付费之前阅读一本书。

先读后买原则意味着你可以自由下载本书、阅读它,并与朋友和同事分享。如果你发现本书在工作、商业或学习中有帮助或有用—或者如果你只是喜欢阅读它—那么请购买它。

如果没有志愿编辑们的帮助,这本书不可能达到如此高的质量。我特别感谢Erman Sert、Viet Hoang Tran Duong、Alex Sherstinsky、Kelvin Sundli和Mladen Korunoski的系统性贡献。

我同样感谢Alireza Bayat Makou、Taras Shalaiko、Domenico Siciliani、Preethi Raju、Srikumar Sundareshwar、Mathieu Nayrolles、Abhijit Kumar、Giorgio Mantovani、Abhinav Jain、Steven Finkelstein、Ryan Gaughan、Ankita Guha、Harmanan Kohli、Daniel Gross、Kea Kohv、Marcus Oliveira、Tracey Mercier、Prabin Kumar Nayak、Saptarshi Datta、Gurgen R. Hayrapetyan、Sina Abdidizaji、Federico Raimondi Cominesi、Santos Salinas、Anshul Kumar、Arash Mirbagheri、Roman Stanek、Jeremy Nguyen、Efim Shuf、Pablo Llopis、Marco Celeri、Tiago Pedro和Manoj Pillai的帮助。

如果这是您第一次探索语言模型,我有点羡慕您——发现机器如何通过自然语言学习理解世界真的很神奇。

我希望您阅读这本书时能像我写作时一样享受其中。

现在拿起您的茶或咖啡,让我们开始吧!

本章首先简要概述了人工智能的发展历程,解释了什么是machine learning模型,并介绍了machine learning过程的四个步骤。然后,它涵盖了一些数学基础,如向量和矩阵,介绍了neural network,并以梯度下降和自动微分等优化方法结束。

1.1. AI和Machine Learning

人工智能(AI)这个术语最初是在1955年由John McCarthy主持的一个研讨会上提出的。研讨会上的研究人员旨在探索机器如何能够使用语言、形成概念、像人类一样解决问题并随时间改进。

1.1.1. 早期进展

该领域的第一个重大突破出现在1956年,即Logic Theorist。由Allen Newell、Herbert Simon和Cliff Shaw创建,它是第一个设计用于执行自动推理的程序,后来被描述为”第一个人工智能程序”。

Frank Rosenblatt的Perceptron(1958)是一个早期的neural network,旨在通过基于示例调整其内部参数来识别模式。Perceptron学习了一个决策边界——一条分离不同类别示例的分界线(例如,垃圾邮件与非垃圾邮件):

大约在同一时间,1959年,Arthur Samuel创造了machine learning这个术语。在他的论文《使用跳棋游戏进行Machine Learning的一些研究》中,他将machine learning描述为”编程让计算机从经验中学习”。

1960年代中期的另一个值得注意的发展是ELIZA。1967年由Joseph Weizenbaum开发,作为历史上第一个聊天机器人,ELIZA通过匹配用户文本中的模式并生成预编程的响应,给人以理解语言的错觉。尽管它很简单,但它说明了构建能够看起来像在思考或理解的机器的诱惑力。

在这一时期,对近期突破的乐观情绪很高。未来图灵奖获得者Herbert Simon体现了这种热情,他在1965年预测”机器将在二十年内能够做人类能做的任何工作”。许多专家都抱有这种乐观态度,预测真正的人类水平AI——通常被称为通用人工智能(AGI)——只需要几十年就能实现。有趣的是,这些预测保持了一致的模式:十年又十年,AGI始终保持在大约25年的地平线上:

1.1.2. AI寒冬

当研究人员试图兑现早期承诺时,他们遇到了不可预见的复杂性。许多备受瞩目的项目未能达到雄心勃勃的目标。因此,1975年至1980年期间,资金和热情显著减少,这一时期现在被称为第一个AI寒冬。

在第一个AI寒冬期间,甚至”AI”这个术语也变得有些禁忌。

许多研究人员将他们的工作重新包装为”信息学”、“基于知识的系统”或”模式识别”,以避免与AI的感知失败产生关联。

在1980年代,对专家系统——旨在复制专业人类知识的基于规则的软件——的兴趣重新兴起,承诺能够捕获和自动化领域专业知识。这些专家系统是AI研究的一个更广泛分支的一部分,被称为符号AI,通常被称为传统AI(GOFAI),自AI最早期以来一直是主导方法。GOFAI方法依赖于明确编码的规则和符号来表示知识和逻辑,虽然它们在狭义定义的领域中工作良好,但在可扩展性和适应性方面存在困难。

从1987年到2000年,AI进入了第二个寒冬期,当时符号方法的局限性导致资金减少,再次导致许多研究和开发项目被搁置或取消。

尽管遭遇这些挫折,新技术继续演进。特别是决策树,最初由John Sonquist和James Morgan在1963年引入,然后由Ross Quinlan的ID3算法在1986年推进,通过树状结构将数据分成子集。树中的每个节点代表关于数据的问题,每个分支是一个答案,每个叶子提供一个预测。虽然易于解释,但决策树容易出现过拟合,即它们过度适应训练数据,降低了在新的、未见过的数据上表现良好的能力。

1.1.3. 现代时代

在1990年代末和2000年代初,硬件的渐进改进和更大数据集的可用性(得益于互联网的广泛使用)开始让AI从第二次寒冬中复苏。Leo Breiman的随机森林算法(2001年)通过在数据的随机子集上创建多棵树然后组合它们的输出来解决决策树中的过拟合问题——显著提高了预测准确性。

支持向量机(SVMs),由Vladimir Vapnik和他的同事在1992年引入,是另一个重要的进步。SVMs识别出以最宽间隔分离不同类别数据点的最优超平面。核方法的引入允许SVMs通过将数据映射到高维空间来处理复杂的非线性模式,使找到合适的分离超平面变得更容易。这些创新使SVMs成为2000年代初机器学习研究的中心。

转折点出现在2012年左右,当时被称为深度神经网络的更先进的神经网络版本开始在语音和图像识别等领域超越其他技术。与只使用单个可学习参数”层”的简单感知机不同,这种深度学习方法堆叠多个层来解决更复杂的问题。计算能力的激增、丰富的数据和算法进步的汇聚产生了令人瞩目的突破。随着学术和商业兴趣的飙升,AI的可见度和资金投入也随之增长。

今天,AI和机器学习仍然密切相关。研究和工业界的努力继续寻求能够从数据中学习复杂任务的更强大的模型。尽管”在短短25年内”实现人类水平AI的预测一直未能实现,但AI对日常应用的影响是不可否认的。

在本书中,AI广泛指代使机器能够解决曾被认为只有人类才能解决的问题的技术,而机器学习是其关键子领域,专注于创建从示例集合中学习的算法。这些示例可以来自自然界,由人类设计,或由其他算法生成。该过程涉及收集数据集并从中构建模型,然后用它来解决问题。

我将交替使用”学习”和”机器学习”来节省键盘输入。

让我们来研究模型的确切含义以及它如何构成机器学习的基础。

模型通常用数学方程表示:

𝑦 = 𝑓(𝑥)

这里,𝑥是输入,𝑦是输出,𝑓表示𝑥的函数。函数是描述一组值如何与另一组值相关的命名规则。形式上,函数𝑓将输入从定义域映射到值域中的输出,确保每个输入都有且仅有一个输出。函数使用特定规则或公式将输入转换为输出。

在机器学习中,目标是编译一个示例的数据集并使用它们来构建𝑓,这样当𝑓应用于新的、未见过的𝑥时,它产生的𝑦能够为𝑥提供有意义的洞察。

为了根据房屋面积估算房价,数据集可能包括(面积,价格)对,如{(150,200), (200,600), … }。这里,面积以平方米为单位,价格以千为单位。

花括号表示集合。包含N个元素,范围从𝑥₁到𝑥ₙ的集合表示为{𝑥ᵢ}ᵢ₌₁ᴺ。

想象我们拥有一栋面积为250平方米(约2691平方英尺)的房子。要找到一个为这栋房子返回合理价格的函数𝑓,测试每个可能的函数是不现实的。相反,我们为𝑓选择一个特定的结构,专注于匹配这种结构的函数。

让我们将𝑓的结构定义为:

𝑓(𝑥) = 𝑤𝑥 + 𝑏, (1.1)

这是𝑥的线性函数。公式𝑤𝑥 + 𝑏是𝑥的线性变换。

符号 def= 表示”根据定义等于”或”定义为”。

对于线性函数,确定𝑓只需要两个值:𝑤和𝑏。这些被称为模型的参数或权重。

在其他文本中,𝑤可能被称为斜率、系数或权重项。类似地,𝑏可能被称为截距、常数项或偏置。在本书中,我们将坚持对𝑤使用”权重”,对𝑏使用”偏置”,因为这些术语在机器学习中广泛使用。当含义明确时,“参数”和”权重”将互换使用。

例如,当𝑤 = 2/3且𝑏 = 1时,线性函数如下所示:

这里,偏置使图形垂直移动,所以直线在𝑦 = 1处与𝑦轴相交。权重决定斜率,意味着直线每向右移动3个单位就上升2个单位。

从数学上讲,函数𝑓(𝑥) = 𝑤𝑥 + 𝑏是仿射变换,而不是线性变换,因为真正的线性变换要求𝑏 = 0。然而,在机器学习中,当参数在方程中线性出现——意味着𝑤和𝑏只与输入或常数相乘和相加,而不是相互相乘、被提升到幂次或出现在如𝑒^𝑥这样的函数内部时,我们通常称这样的模型为”线性”的。

即使对于像𝑓(𝑥) = 𝑤𝑥 + 𝑏这样简单的模型,参数𝑤和𝑏也可以取无限多个值。为了找到最佳值,我们需要一种衡量最优性的方法。一个自然的选择是在从面积估算房价时最小化平均预测误差。具体来说,我们希望𝑓(𝑥) = 𝑤𝑥 + 𝑏生成尽可能接近实际价格的预测。

设我们的数据集为{(𝑥ᵢ, 𝑦ᵢ)}ᵢ₌₁ᴺ,其中N是数据集的大小,{(𝑥₁, 𝑦₁), (𝑥₂, 𝑦₂), …, (𝑥ₙ, 𝑦ₙ)}是单个示例,每个𝑥ᵢ是输入,对应的𝑦ᵢ是目标。当示例同时包含

输入和目标值,学习过程被称为监督学习。本书专注于监督机器学习。

其他机器学习类型包括无监督学习,其中模型仅从输入中学习模式,以及强化学习,其中模型通过与环境交互并接收行为奖励或惩罚来学习。

当 𝑓(𝑥) 应用于 𝑥 时,它生成一个预测值 𝑦9。我们可以为给定示例 (𝑥, 𝑦) 定义预测误差 err(𝑦9, 𝑦) 为:

err(𝑦9, 𝑦) = (𝑦9 − 𝑦)² (1.2)

这个表达式称为平方误差,当 𝑦9 = 𝑦 时等于 0。这是有意义的:如果预测价格与实际价格匹配,则没有误差。𝑦9 偏离 𝑦 越远,误差就越大。平方确保误差始终为正,无论预测过高还是过低。

我们将 𝑤* 和 𝑏* 定义为函数 𝑓 中 𝑤 和 𝑏 的最优参数值,当它们最小化数据集上的平均价格预测误差时。该误差使用以下表达式计算:

[err(𝑦9₁, 𝑟₁) + err(𝑦9₂, 𝑦₂) + ⋯ + err(𝑦9ₙ, 𝑦ₙ)] / 𝑁

让我们通过展开每个 err(⋅) 来重写上述表达式:

[(𝑦9₁ − 𝑦₁)² + (𝑦9₂ − 𝑦₂)² + ⋯ + (𝑦9ₙ − 𝑦ₙ)²] / 𝑁

让我们将名称 𝐽(𝑤, 𝑏) 分配给我们的表达式,将其转换为函数:

𝐽(𝑤, 𝑏) = [(𝑤𝑥₁ + 𝑏 − 𝑦₁)² + (𝑤𝑥₂ + 𝑏 − 𝑦₂)² + ⋯ + (𝑤𝑥ₙ + 𝑏 − 𝑦ₙ)²] / 𝑁 (1.3)

在定义 𝐽(𝑤, 𝑏) 的方程中,它表示平均预测误差,从 1 到 𝑁 的每个 𝑖 的 𝑥ᵢ 和 𝑦ᵢ 值是已知的,因为它们来自数据集。未知数是 𝑤* 和 𝑏。为了确定最优的 𝑤 和 𝑏*,我们需要最小化 𝐽(𝑤, 𝑏)。由于这个函数是两个变量的二次函数,微积分保证它有单一的最小值。

方程 1.3 中的表达式在线性回归的机器学习问题中被称为损失函数。在这种情况下,损失函数是均方误差或MSE。

为了找到函数的最优值(最小值或最大值),我们计算它的一阶导数。当我们到达最优点时,一阶导数等于零。对于两个或更多变量的函数,如损失函数 𝐽(𝑤, 𝑏),我们计算相对于每个变量的偏导数。我们将这些表示为 ∂𝐽/∂𝑤 和 ∂𝐽/∂𝑏。

为了确定 𝑤* 和 𝑏*,我们求解以下两个方程的系统:

∂𝐽/∂𝑤 = 0 ∂𝐽/∂𝑏 = 0

我们将偏导数设为零,因为当这种情况发生时,我们处于最优点。

幸运的是,MSE函数的结构和模型的线性性允许我们解析地求解这个方程组。为了说明,考虑一个有三个示例的数据集:(𝑥₁, 𝑦₁) = (150,200),(𝑥₂, 𝑦₂) = (200,600),和 (𝑥₃, 𝑦₃) = (260,500)。对于这个数据集,损失函数是:

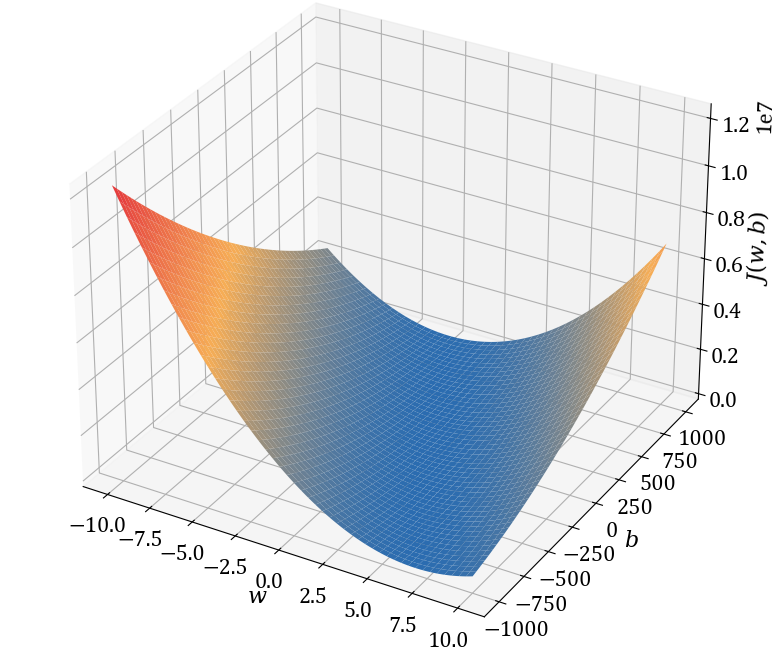

𝐽(𝑤, 𝑏) = [(150𝑤 + 𝑏 − 200)² + (200𝑤 + 𝑏 − 600)² + (260𝑤 + 𝑏 − 500)²] / 3

让我们绘制它:

导航到本书的wiki,从文件 thelmbook.com/py/1.1 检索用于生成上述图的代码,运行代码,并旋转图形以观察最小值。

现在我们需要推导 ∂𝐽/∂𝑤 和 ∂𝐽/∂𝑏 的表达式。请注意,𝐽(𝑤, 𝑏) 是以下函数的复合:

• 函数 𝑑₁ = 150𝑤 + 𝑏 − 200,𝑑₂ = 200𝑤 + 𝑏 − 600,𝑑₃ = 260𝑤 + 𝑏 − 500 是 𝑤 和 𝑏 的线性函数;

• 函数 err₁ = 𝑑₁²,err₂ = 𝑑₂²,err₃ = 𝑑₃² 是 𝑑₁、𝑑₂ 和 𝑑₃ 的二次函数;

• 函数 𝐽 = (err₁ + err₂ + err₃)/3 是 err₁、err₂ 和 err₃ 的线性函数。

函数复合意味着一个函数的输出成为另一个函数的输入。例如,对于两个函数 𝑓 和 𝑔,你首先将 𝑔 应用于 𝑥,然后将 𝑓 应用于结果。这写作 𝑓(𝑔(𝑥)),这意味着你首先计算 𝑔(𝑥),然后将该结果用作 𝑓 的输入。

在我们的损失函数 𝐽(𝑤, 𝑏) 中,过程从使用 𝑤 和 𝑏 的当前值计算 𝑑₁、𝑑₂ 和 𝑑₃ 的线性函数开始。然后将这些输出传递给二次函数 err₁、err₂ 和 err₃。最后一步是对这些结果求平均以计算 𝐽。

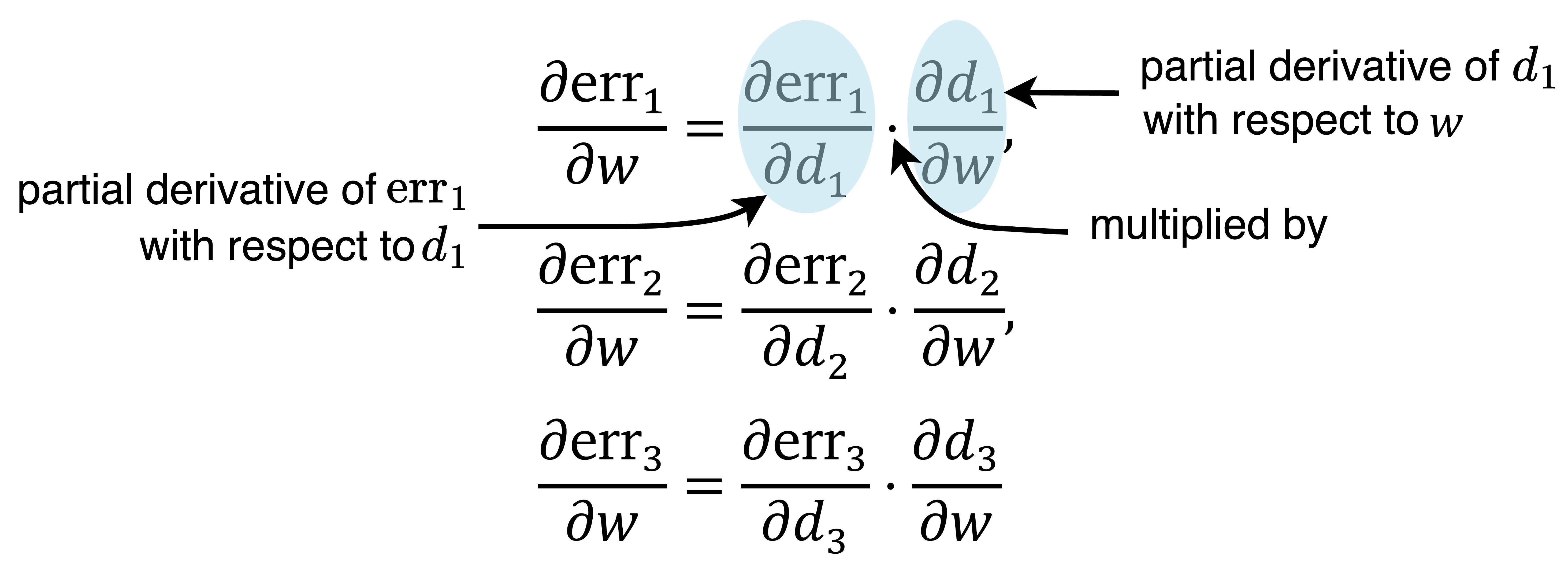

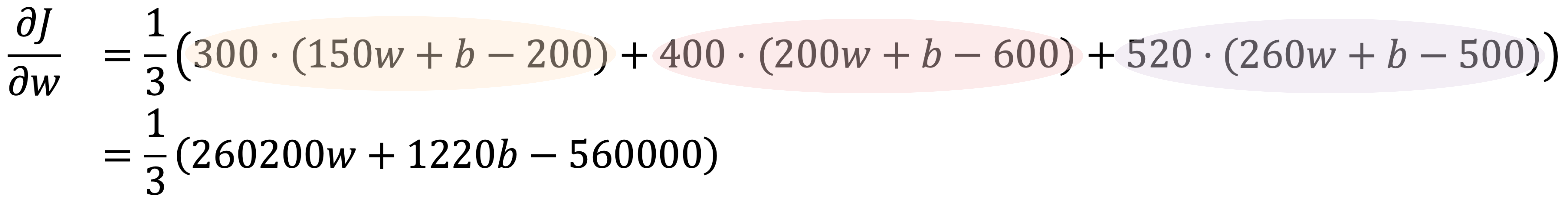

使用微分的求和法则和常数倍数法则,∂𝐽/∂𝑤 由下式给出:

∂𝐽/∂𝑤 = (1/3)(∂err₁/∂𝑤 + ∂err₂/∂𝑤 + ∂err₃/∂𝑤)

其中 ∂err₁/∂𝑤、∂err₂/∂𝑤 和 ∂err₃/∂𝑤 是 err₁、err₂ 和 err₃ 相对于 𝑤 的偏导数。

微分的求和法则指出两个函数和的导数等于它们导数的和:d/dx[𝑓(𝑥) + 𝑔(𝑥)] = d𝑓(𝑥)/dx + d𝑔(𝑥)/dx。

微分的常数倍数法则指出常数乘以函数的导数等于常数乘以函数的导数:d/dx[𝑐 ⋅ 𝑓(𝑥)] = 𝑐 ⋅ d𝑓(𝑥)/dx。

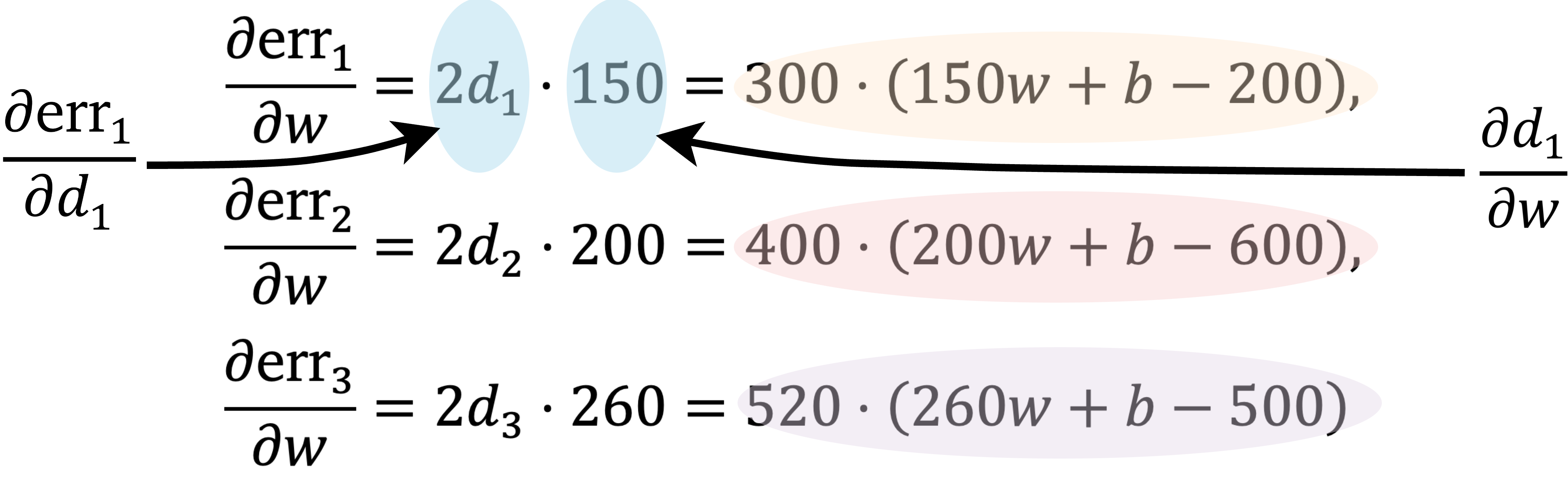

通过应用微分的链式法则,err₁、err₂ 和 err₃ 相对于 𝑤 的偏导数是:

微分的链式法则指出复合函数 𝑓(𝑔(𝑥)) 的导数,写作 d/dx[𝑓(𝑔(𝑥))],是 𝑓 相对于 𝑔 的导数与 𝑔 相对于 𝑥 的导数的乘积,即:d/dx[𝑓(𝑔(𝑥))] = (d𝑓/d𝑔) ⋅ (d𝑔/dx)。

然后,

因此,

类似地,我们找到 ∂𝐽/∂𝑏:

∂𝐽/∂𝑏 = (1/3)[2 ⋅ (150𝑤 + 𝑏 − 200) + 2 ⋅ (200𝑤 + 𝑏 − 600) + 2 ⋅ (260𝑤 + 𝑏 − 500)] = (1/3)(1220𝑤 + 6𝑏 − 2600)

将偏导数设为0得到以下方程组:

∂/∂w (260200w + 1220b - 560000) = 0

(1220w + 6b - 2600) = 0

简化方程组并使用代入法求解变量,得到最优值:w* = 2.58 和 b = -91.76。

得到的模型 f(x) = 2.58x - 91.76 如下图所示。图中包括三个样本(蓝点)、模型本身(红色实线),以及对面积为240平方米的新房屋的预测(橙色虚线)。

垂直蓝色虚线显示了模型预测误差相对于实际价格的平方根。[1] 误差越小意味着模型拟合数据越好。损失函数汇总这些误差,衡量模型与数据集的吻合程度。

当我们使用模型的训练数据集(称为训练集)计算损失时,我们得到训练损失。对于我们的模型,训练损失由方程1.3定义。使用我们学习到的参数值,现在可以计算训练集的损失:

J(2.58, -91.76) = [(2.58 · 150 - 91.76 - 200)² + (2.58 · 200 - 91.76 - 600)² + (2.58 · 260 - 91.76 - 500)²]/3 = 15403.19。

[1] 这是误差的平方根,因为我们的误差(如方程1.2中定义)是预测价格与房屋实际价格之间差值的平方。通常做法是取均方误差的平方根,因为它用与目标变量相同的单位(在这种情况下是价格)表示误差。这使得误差值更容易解释。

该值的平方根约为124.1,表示平均预测误差约为$124,100。损失值是高是低的解释取决于具体的业务背景和比较基准。神经网络和其他非线性模型(我们将在本章后面探讨)通常能达到更低的损失值。

到这一步,你应该清楚地理解监督学习涉及的四个步骤:

收集数据集:例如,(x₁, y₁) = (150,200),(x₂, y₂) = (200,600),和(x₃, y₃) = (260,500)。

定义模型结构:例如,y = wx + b。

定义损失函数:如方程1.3。

最小化损失:在数据集上最小化损失函数。

在我们的例子中,我们通过求解包含两个变量的两个方程的方程组来手动最小化损失。这种方法适用于小系统。然而,随着模型复杂性的增长——比如拥有数十亿参数的大语言模型——手动方法变得不可行。现在让我们介绍新概念来帮助解决这个挑战。

要预测房价,仅知道面积是不够的。建造年份或卧室和浴室数量等因素也很重要。假设我们使用两个属性:(1)面积和(2)卧室数量。在这种情况下,输入x变成特征向量。该向量包含两个特征,也称为维度或组件:

x = [x₁, x₂]ᵀ

在本书中,向量用小写粗体字母表示,如x或w。对于给定的房屋x,x₁表示其面积(平方米),x₂是卧室数量。

向量通常表示为一列数字,称为列向量。但在文本中,它经常写成其转置,xᵀ。转置列向量将其转换为行向量。例如,xᵀ = [x₁, x₂] 或 x = [x₁, x₂]ᵀ。

向量的维数或其大小是指它包含的组件数量。这里,x有两个组件,所以其维数是2。

有了两个特征,我们的线性模型需要三个参数:权重w₁和w₂,以及偏置b。权重可以组合成一个向量:

w = [w₁, w₂]ᵀ

线性模型可以紧凑地写为:

y = w · x + b, (1.4)

其中w · x是两个向量的点积(也称为标量积)。它定义为:

w · x = Σⱼ₌₁ᴰ wⱼxⱼ

点积将两个相同维数的向量结合产生一个标量,一个数字如22、0.67或-10.5。本书中的标量用斜体小写或大写字母表示,如x或D。表达式w · x + b将线性变换的概念推广到向量。

上面的方程使用求和符号,其中D表示输入的维数,j从1到D。例如,在2维房屋场景中,Σⱼ₌₁² wⱼxⱼ = w₁x₁ + w₂x₂。

虽然求和符号表明点积可能作为循环实现,但现代计算机处理它要高效得多。优化的线性代数库如BLAS和cuBLAS使用低级、高度优化的方法计算点积。这些库利用硬件加速和并行处理,实现远超简单循环的速度。

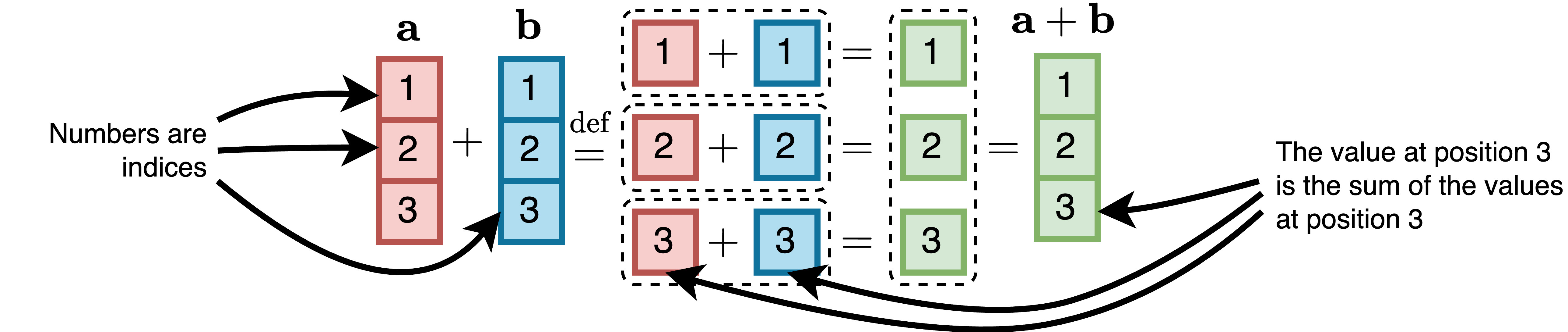

两个向量a和b的和,两者具有相同的维数D,定义为:

a + b = [a₁ + b₁, a₂ + b₂, …, aᴰ + bᴰ]ᵀ

两个3维向量和的计算如下图所示:

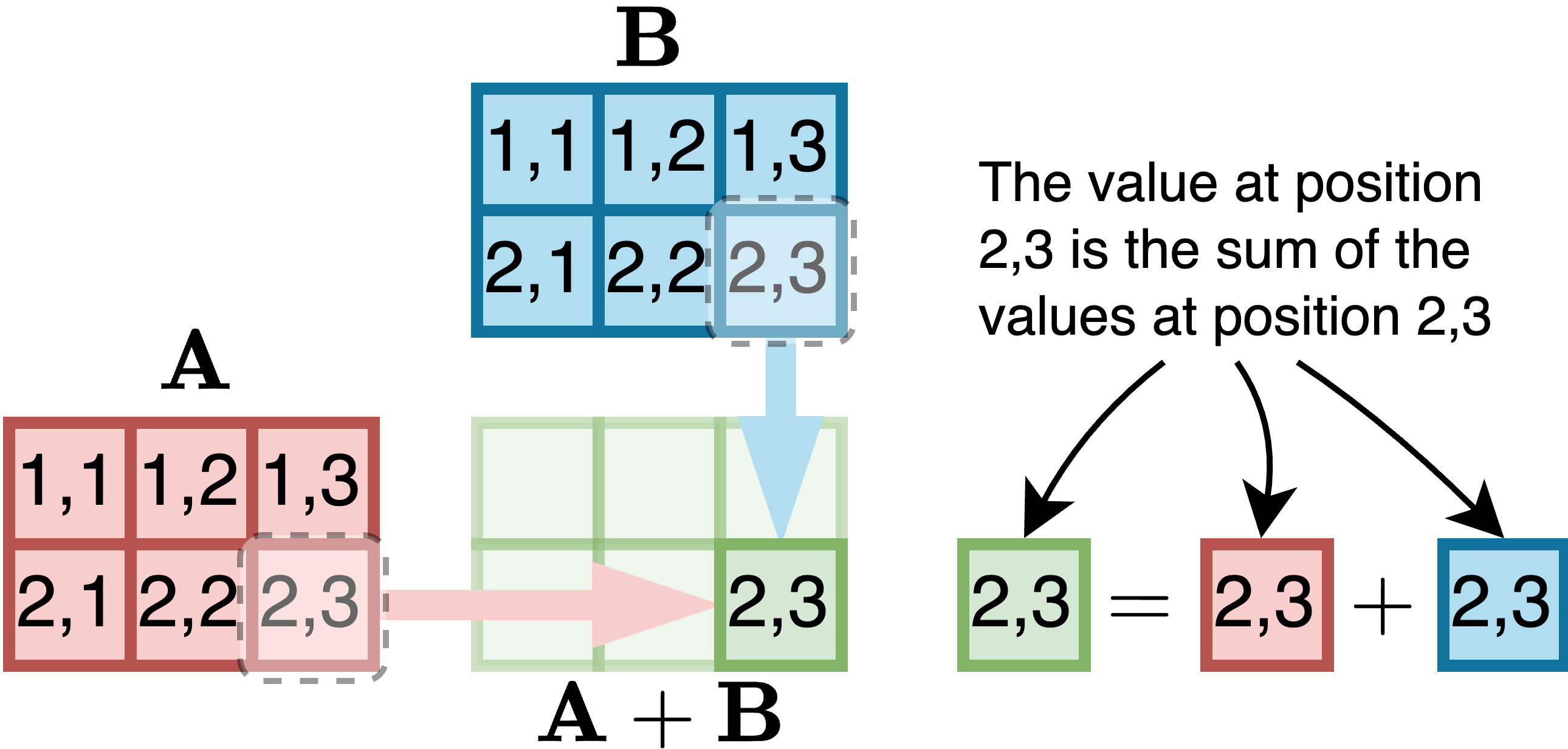

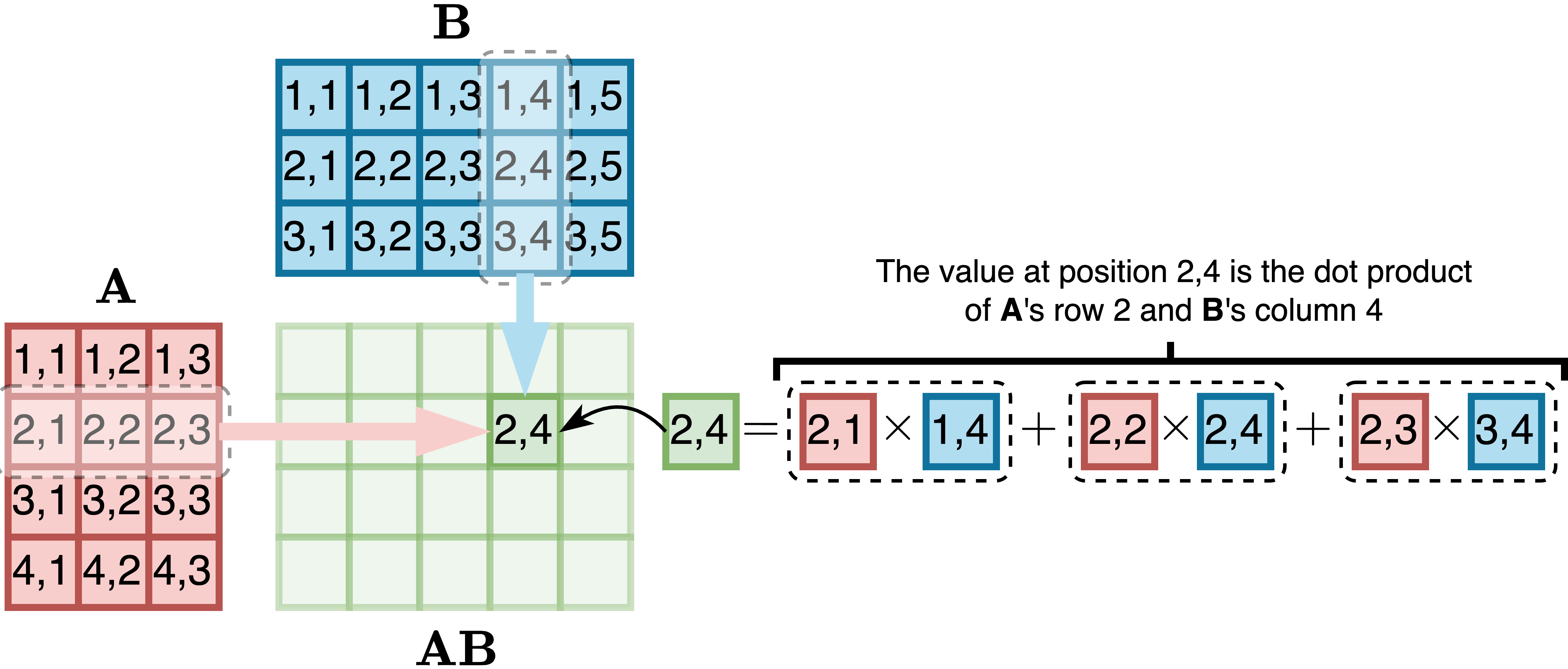

在本章的插图中,单元格中的数字表示输入或输出矩阵或向量中元素的位置。它们不表示实际值。

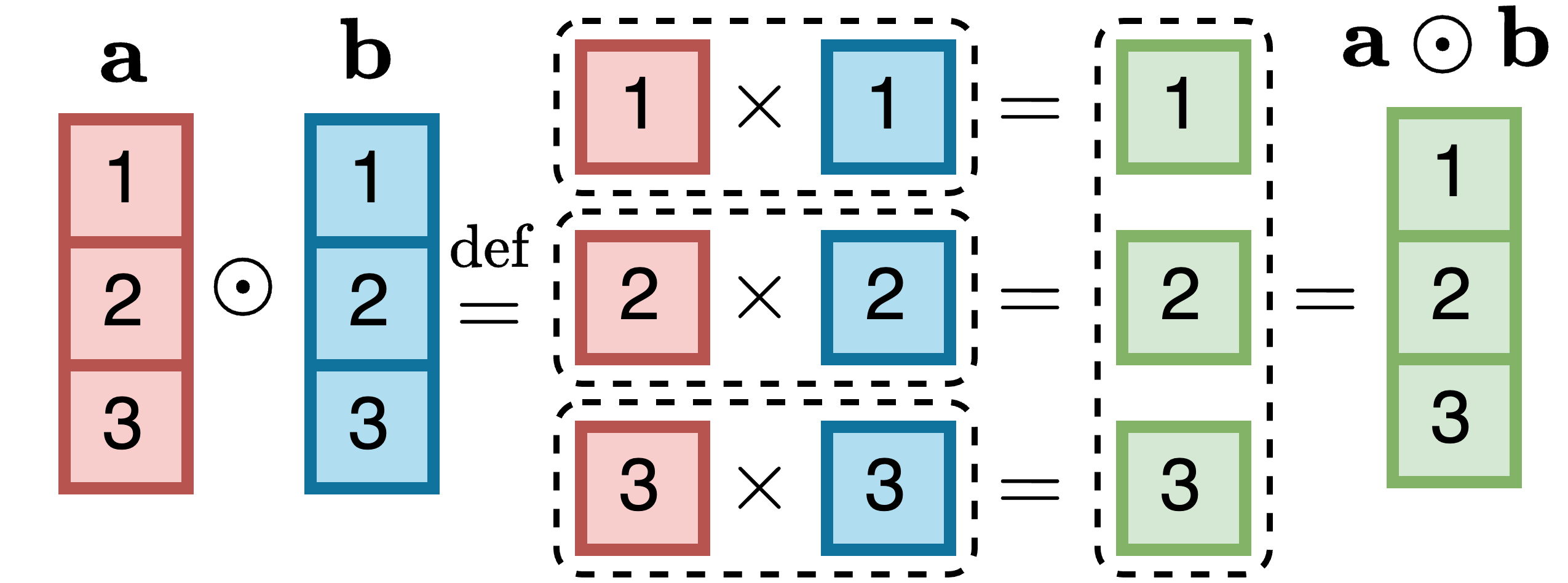

两个维数为D的向量a和b的逐元素乘积定义为:

a ⊙ b = [a₁ · b₁, a₂ · b₂, …, aᴰ · bᴰ]ᵀ

两个3维向量的逐元素乘积计算如下所示:

向量 𝐱 的范数,记作 ∥ 𝐱 ∥,表示其长度或幅度。它定义为各分量平方和的平方根:

∥ 𝐱 ∥ = √(∑x²ᵢ)

对于2维向量 𝐱,范数为:

∥ 𝐱 ∥= √(x₁² + x₂²)

两个向量 𝐱 和 𝐲 之间角度 𝜃 的余弦定义为:

cos(𝜃) = (𝐱 ⋅ 𝐲)/(∥ 𝐱 ∥∥ 𝐲 ∥)

两个向量之间角度的余弦量化了它们的相似性。例如,具有相似面积和卧室数量的两栋房屋将具有接近1的余弦相似度,否则该值会较低。余弦相似度广泛用于比较表示为embedding向量的单词或文档。这将在第2.2节中进一步讨论。

零向量的所有分量都等于零。单位向量的长度为1。要将任何非零向量 𝐱 转换为单位向量 𝐱̂,需要将向量除以其范数:

𝐱̂ = 𝐱/∥ 𝐱 ∥

用一个数除以向量会产生一个新向量,其中原向量的每个分量都被该数除。

单位向量保持原向量的方向,但长度为1。下图用2维示例演示了这一点。左侧,对齐的向量有 cos(𝜃) = 0.78。右侧,几乎正交的向量有 cos(𝜃) = −0.02。

单位向量很有价值,因为它们的点积等于它们之间角度的余弦,而计算点积是高效的。

当文档表示为单位向量时,通过计算查询向量和文档向量之间的点积,找到相似文档变得很快。这就是向量搜索引擎和像Milvus、Qdrant和Weaviate这样的库的工作原理。

随着维度增加,线性模型中的参数数量变得太大,无法手动求解。此外,在高维空间中,我们无法直观地验证数据是否遵循线性模式。即使我们能够可视化三维以上的空间,我们仍然需要更灵活的模型来处理线性模型无法拟合的数据。

下一节介绍非线性模型,重点关注神经网络。这些是理解大语言模型的关键,大语言模型是一种特定类型的神经网络架构。

神经网络与线性模型在两个关键方面不同:(1) 它对可训练线性函数的输出应用固定的非线性函数,(2) 其结构更深,通过层次结构分层组合多个函数。让我们来说明这些差异。

像 𝑤𝑥 + 𝑏 或 𝐰 ⋅ 𝐱 + 𝑏 这样的线性模型无法有效解决许多机器学习问题。即使我们将它们组合成复合函数 𝑓₁∘𝑓₂(𝑥),线性函数的复合函数仍然是线性的。这很容易验证。

让我们定义 𝑦₂ = 𝑓₂(𝑥) = 𝑎₂𝑥 和 𝑦₁ = 𝑓₁(𝑦₂) = 𝑎₁𝑦₂。这里,𝑓₁ 依赖于 𝑓₂,使其成为复合函数。我们可以重写 𝑏₁:

𝑦₁ = 𝑎₁𝑦₂ = 𝑎₁(𝑎₂𝑥) = (𝑎₁𝑎₂)𝑥

由于 𝑎₂ 和 𝑎₁ 是常数,我们可以定义 𝑎₃ = 𝑎₂𝑎₁,所以 𝑦₁ = 𝑎₃𝑥,这是线性的。

直线通常无法捕捉一维数据中的模式,如将线性回归应用于非线性数据时所示:

为了解决这个问题,我们添加非线性。对于一维输入,模型变为:

𝑦 = 𝜙(𝑤𝑥 + 𝑏)

函数 𝜙 是一个固定的非线性函数,称为激活函数。常见选择有:

ReLU(修正线性单元):ReLU(𝑧) = max(0, 𝑧),输出非负值,在神经网络中广泛使用;

Sigmoid:𝜎(𝑧) = 1/(1+e^(-z)),输出0到1之间的值,使其适用于二分类(例如,将垃圾邮件分类为1,非垃圾邮件分类为0);

Tanh(双曲正切):tanh(𝑧) = (e^z - e(-z))/(ez + e^(-z));输出-1到1之间的值。

在这些方程中,𝑒 表示欧拉数,约为2.72。

这些函数由于其数学性质、简单性和在各种应用中的有效性而被广泛使用。它们看起来是这样的:

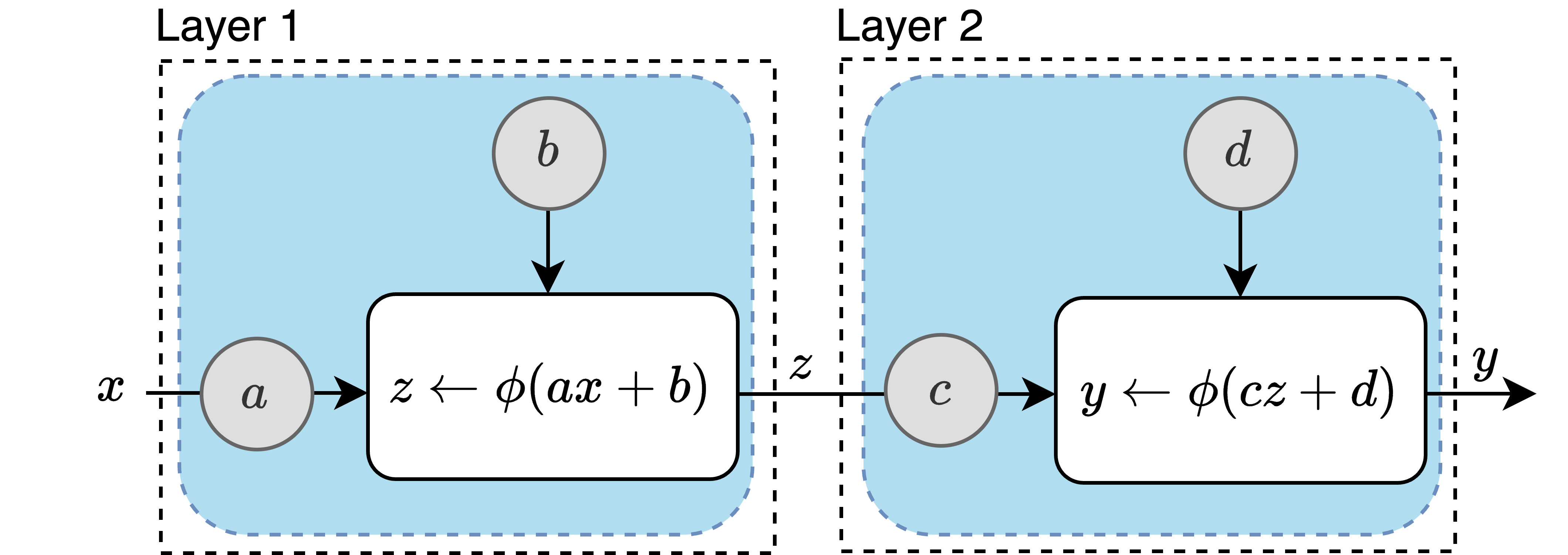

结构 𝜙(𝑤𝑥 + 𝑏) 能够学习非线性模型,但无法捕捉所有非线性曲线。通过嵌套这些函数,我们构建更具表达力的模型。例如,设 𝑓₂(𝑥) = 𝜙(𝑎𝑥 + 𝑏) 和 𝑓₁(𝑧) = 𝜙(𝑐𝑧 + 𝑑)。结合 𝑓₂ 和 𝑓₁ 的复合模型是:

𝑦 = 𝑓₁∘𝑓₂(𝑥) = 𝜙(𝑐𝜙(𝑎𝑥 + 𝑏) + 𝑑)

这里,输入 𝑥 首先使用参数 𝑎 和 𝑏 进行线性变换,然后通过非线性函数 𝜙。结果进一步用参数 𝑐 和 𝑑 进行线性变换,然后再次应用 𝜙。

下面是复合模型 𝑦 = 𝑓₁∘𝑓₂(𝑥) 的图形表示:

计算图表示模型的结构。上面的计算图显示了两个非线性单元(蓝色矩形),通常称为人工神经元。每个单元包含两个可训练参数——权重和偏置——用灰色圆圈表示。左箭头 ← 表示右边的值被赋给左边的变量。该图说明了一个具有两层的基本神经网络,每层包含一个单元。实际中的大多数神经网络都有更多层和每层多个单元。

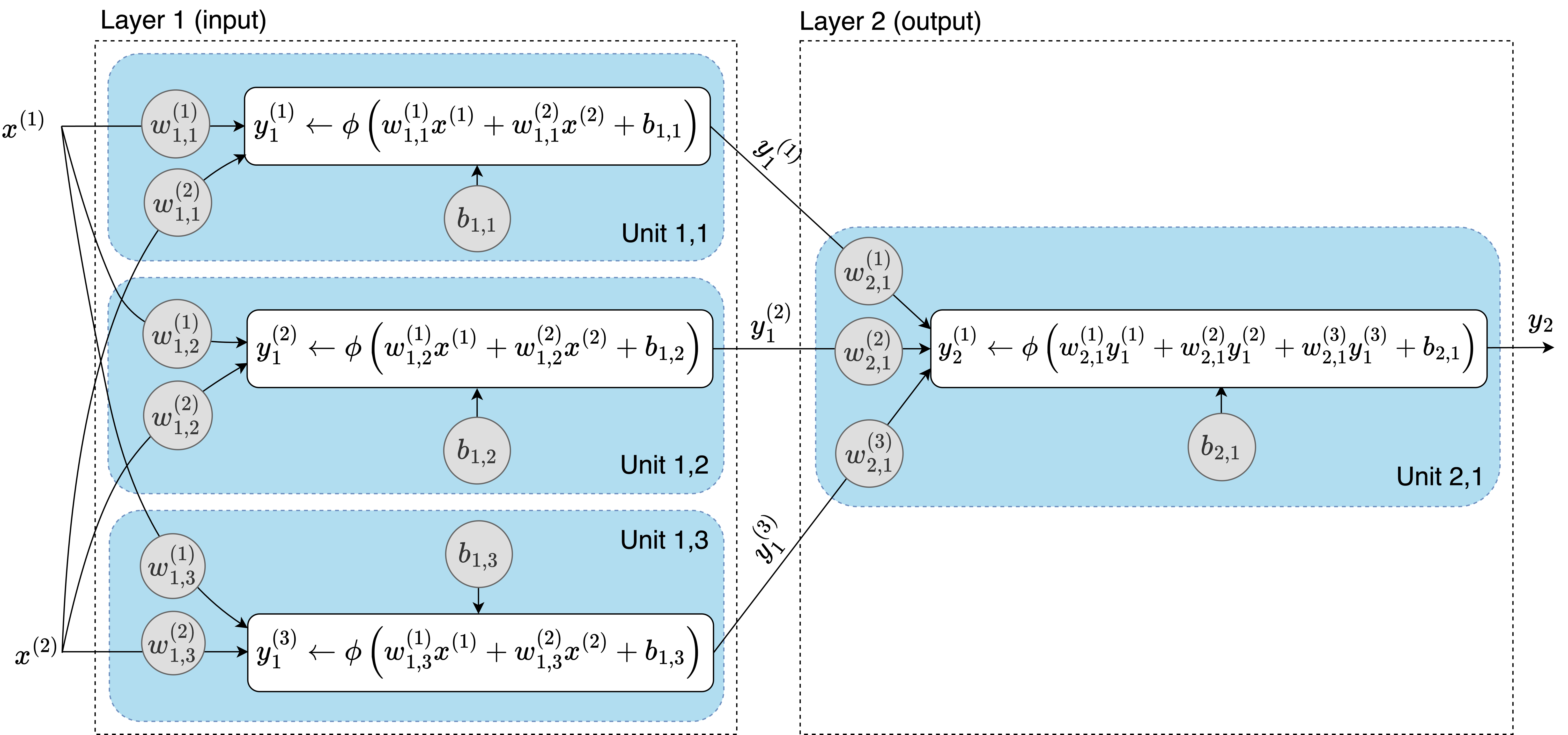

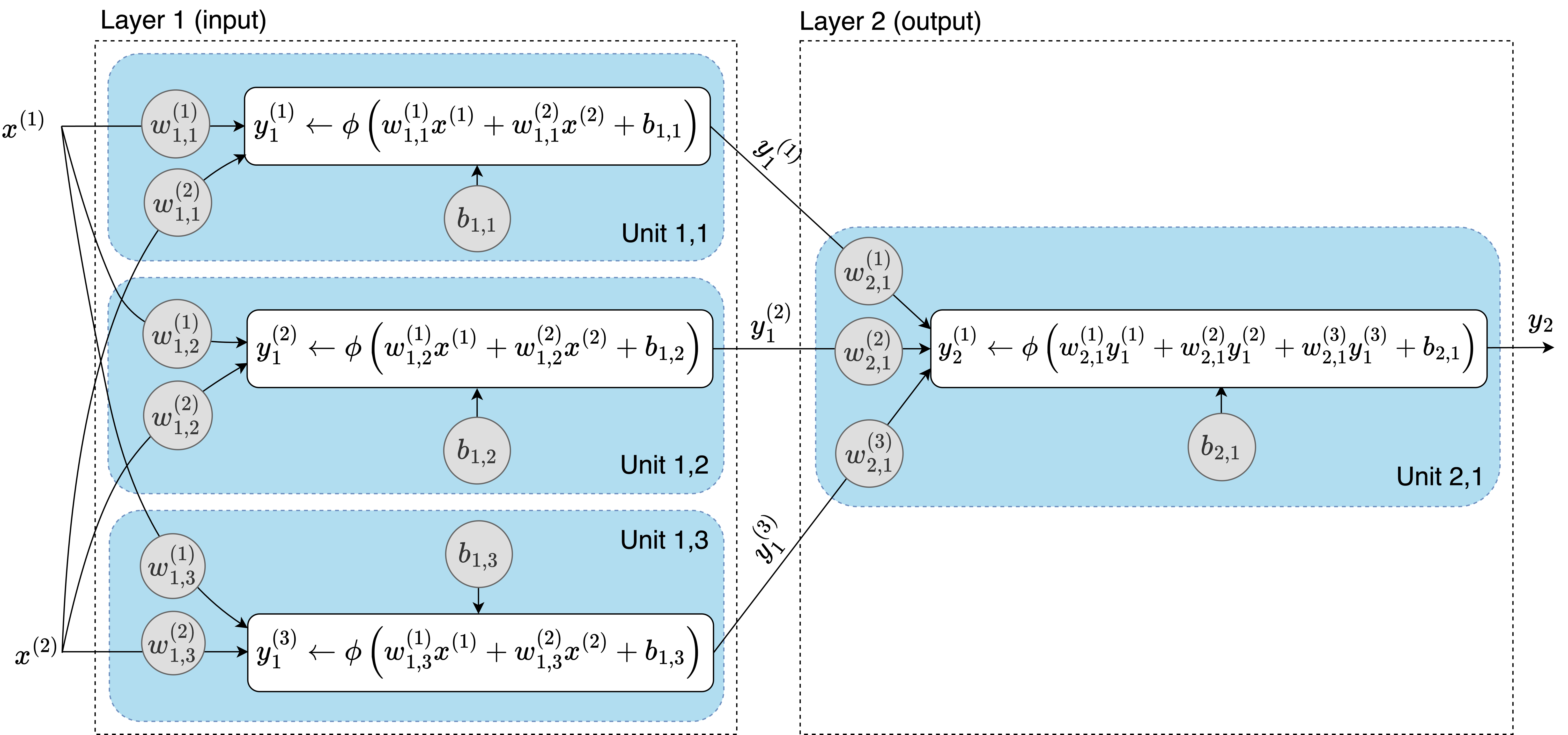

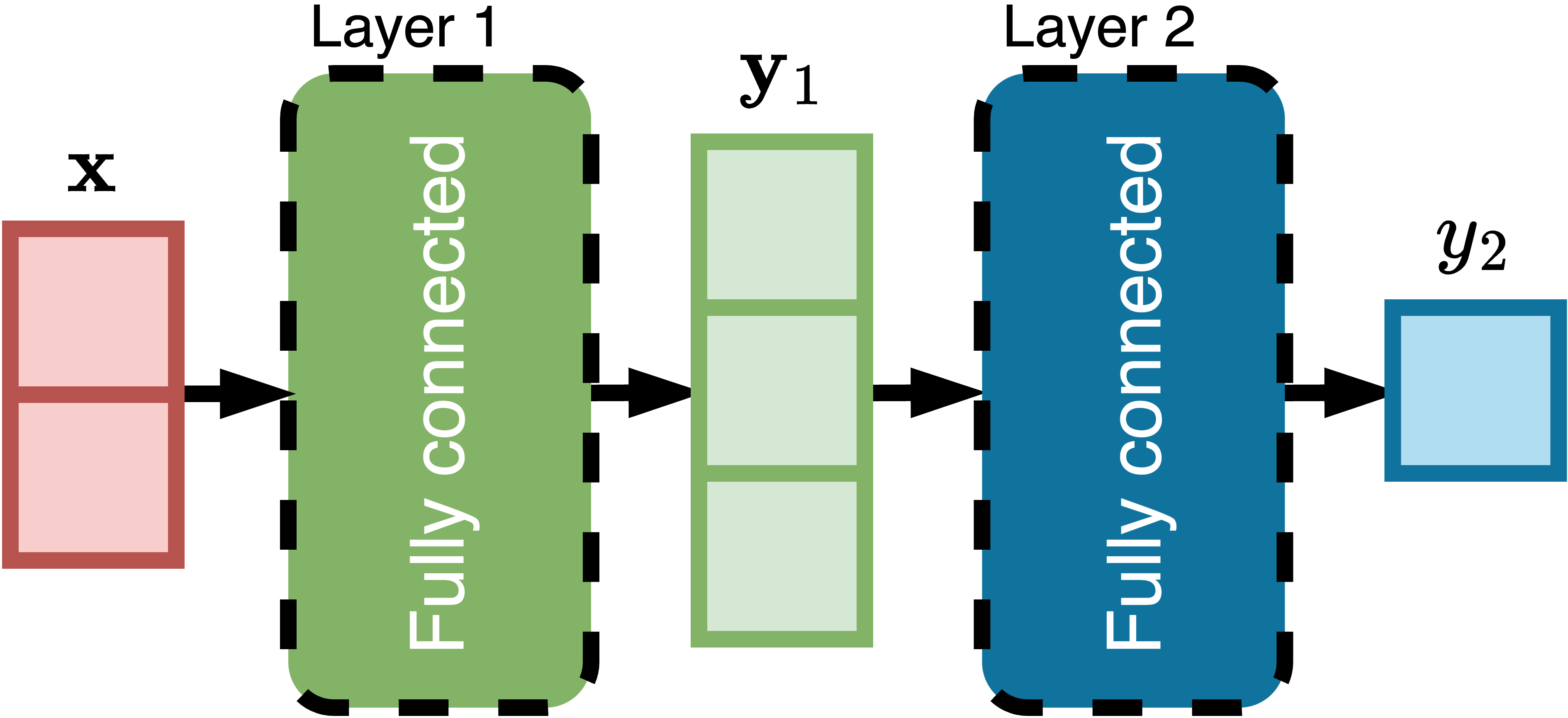

假设我们有一个二维输入,一个有三个单元的输入层,和一个有单个单元的输出层。计算图如下所示:

这种结构代表了一个前馈神经网络(FNN),其中信息以单一方向流动——从左到右——没有循环。当每一层中的单元连接到后续层中的所有单元时,如上所示,我们称之为多层感知机(MLP)。每个单元连接到相邻两层中所有单元的层被称为全连接层或密集层。

在第3章中,我们将探索循环神经网络(RNN)。与FNN不同,RNN具有循环,其中一层的输出被用作同一层的输入。

卷积神经网络(CNN)是具有卷积层的前馈神经网络,这些卷积层不是全连接的。虽然最初是为图像处理而设计的,但它们对于文本数据中的文档分类等任务也很有效。要了解更多关于CNN的信息,请参考本书wiki中的附加材料。

为了简化图表,单个神经单元可以用正方形替代。使用这种方法,上述网络可以更紧凑地表示如下:

如果你认为这个简单模型太弱,请看下面的图。它包含三个图表,展示了增加模型大小如何改善性能。左图显示了一个有2个单元的模型:一个输入,一个输出,以及ReLU激活。中图是一个有4个单元的模型:三个输入和一个输出。右图显示了一个更大的模型,有100个单元:

ReLU激活函数尽管简单,但在机器学习中是一个突破。2012年之前的神经网络依赖于平滑激活函数如tanh和sigmoid,这使得训练深度模型变得越来越困难。我们将在第4章关于Transformer神经网络架构的内容中回到这个主题。

增加参数数量有助于模型更准确地逼近数据。实验一致表明,在神经网络中增加每层的单元数或增加层数可以提高其拟合高维数据集的能力,如自然语言、语音、声音、图像和视频数据。

神经网络可以处理高维数据集,但需要大量内存和计算。天真地计算一层的变换将涉及对数千个单元中每个单元的数千个参数进行迭代,以及数十层,这既缓慢又耗费资源。使用矩阵使计算更高效。

矩阵是一个二维数字数组,排列成行和列,它将向量的概念推广到更高维度。形式上,一个有𝑚行和𝑛列的矩阵𝐀写作:

𝑎 𝑎 ⋯ 𝑎 [“,”] [“,!] [“,8]

[def] 𝑎 𝑎 ⋯ 𝑎 [!,”] [!,!] [!,8]

𝐀 = s v ⋮ ⋮ ⋱ ⋮

𝑎 𝑎 ⋯ 𝑎 [9,”] [9,!] [9,8]

这里,𝑎 代表矩阵第𝑖行第𝑗列的元素。 [$,2]

矩阵的维度表示为𝑚 × 𝑛(读作”m乘n”)。矩阵是机器学习的基础。它们紧凑地表示数据和权重,并通过加法、乘法和转置等操作实现高效计算。在本书中,矩阵用大写粗体字母表示,如𝐗或𝐖。

相同维度的两个矩阵𝐀和𝐁的和定义为逐元素:

(𝐀 + 𝐁) [def] = 𝑎 + 𝑏

[, 2][,2] [$,2]

例如,对于两个2 × 3矩阵𝐀和𝐁,加法是这样工作的:

维度为𝑚 × 𝑛的矩阵𝐀的乘积与维度为𝑛 × 𝑝的𝐁是维度为𝑚 × 𝑝的矩阵𝐂,使得第𝑖行第𝑘列的值由下式给出:

[8]

(𝐂) = U 𝑎 𝑏 [, : ][,2] [2,:]

[2%”]

例如,对于4 × 3矩阵𝐀和3 × 5矩阵𝐁,乘积是4 × 5矩阵:

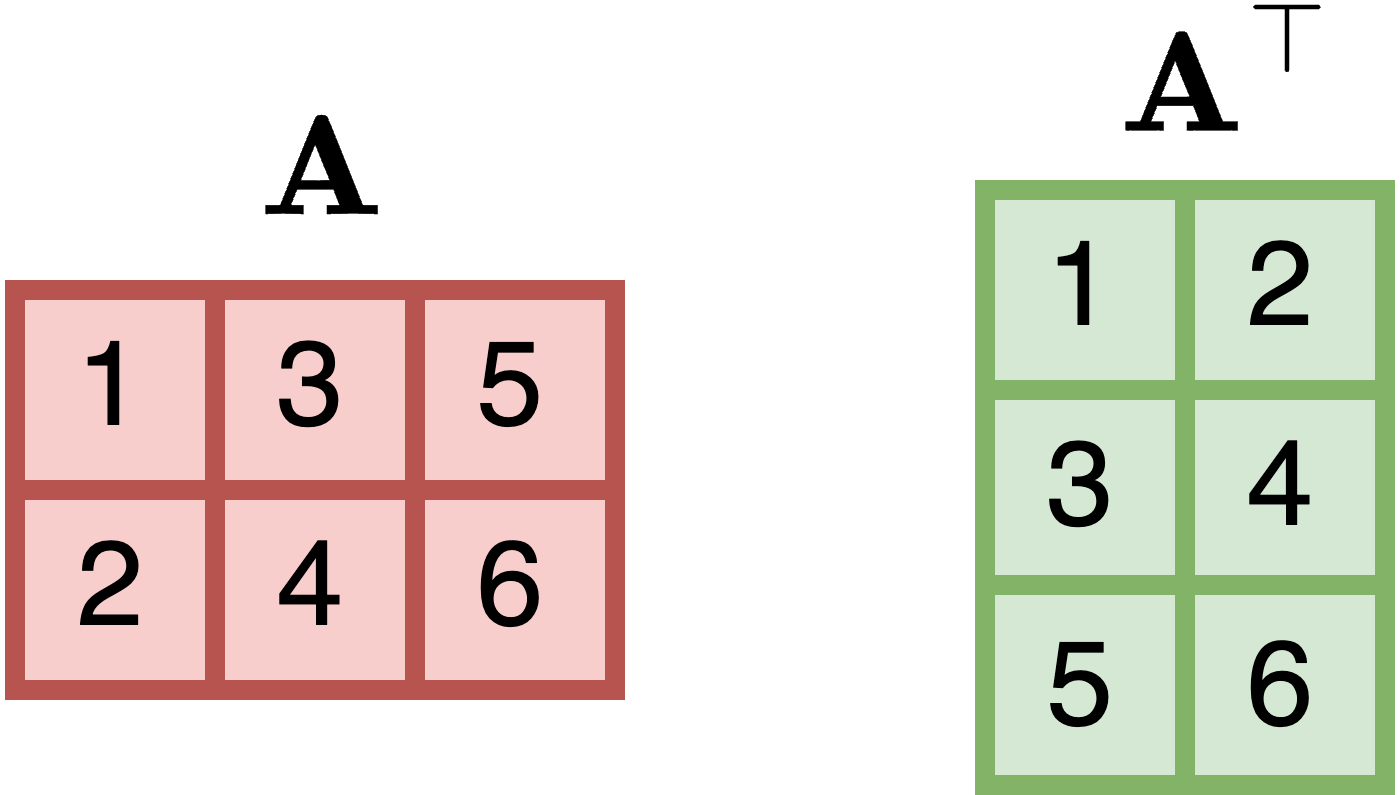

转置矩阵 [1] 𝐀交换其行和列,得到𝐀,其中:

(𝐀[1]) = 𝑎 [, 2][2,]

例如,对于2 × 3 [1] 矩阵𝐀,其转置𝐀如下所示:

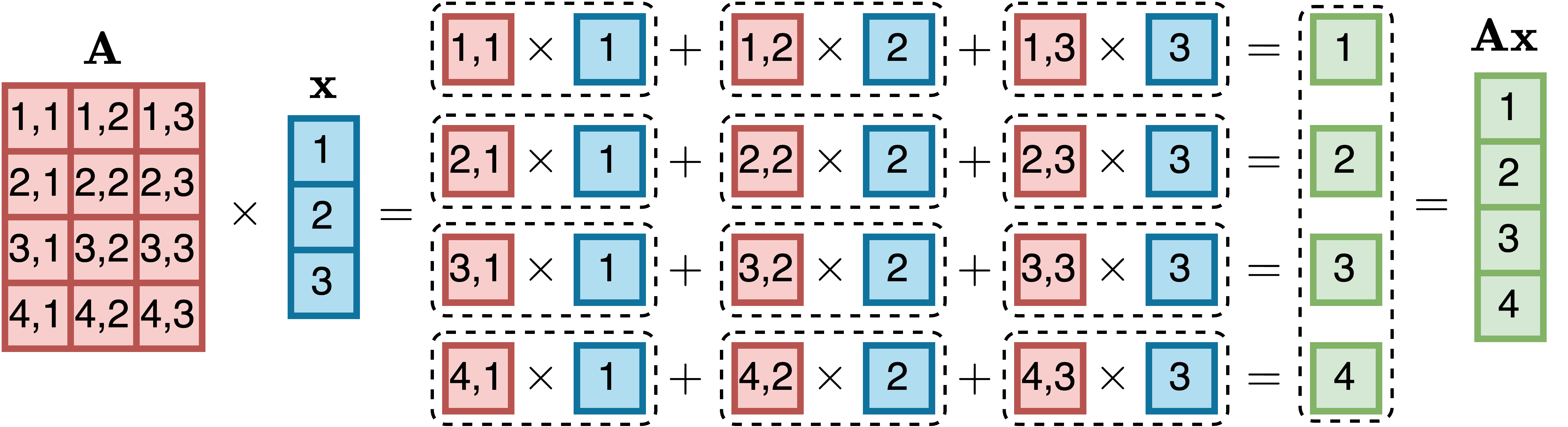

矩阵-向量乘法是矩阵乘法的特殊情况。当𝑚 × 𝑛矩阵𝐀乘以大小为𝑛的向量𝐱时,结果是具有𝑚个分量的向量𝐲 = 𝐀𝐱。结果向量𝐲的每个元素𝑦 计算为: [$]

[8]

𝑦 [(2)] = U 𝑎 𝑥

[][,2]

[2%”]

例如,4 × 3矩阵𝐀乘以3D向量𝐱产生4维向量:

神经网络全连接层中的权重和偏置可以使用矩阵和向量紧凑地表示,从而能够使用高度优化的线性代数库。因此,矩阵运算构成了神经网络训练和推理的骨干。

让我们使用矩阵记号来表达图1.1中的模型。设𝐱为2D输入特征向量。对于第一层,权重和偏置分别表示为3 × 2矩阵𝐖 和3D向量𝐛 。第一层的3D输出𝐲 由下式给出: [”] [”] [”]

𝐲 = 𝜙(𝐖 𝐱 + 𝐛 ) [(1.6) [”] [”] [”]

第二层也使用权重矩阵和偏置。第二层的输出𝑦 使用第一层的输出𝐲 计算。第二层的权重 [!] [”] 矩阵是1 × 3矩阵𝐖 。第二层的偏置是标量𝑏 。模型输出对应于第二层的输出: [!] [!,”]

𝑦 = 𝜙C𝐖 𝐲 + 𝑏 D [(1.7) [!] [!] [”] [!,”]

方程1.6和方程1.7捕获了神经网络中从输入到输出的操作,每层的输出作为下一层的输入。

神经网络通常很大且由非线性函数组成,这使得解析求解损失函数的最小值变得不可行。相反,梯度下降算法被广泛用于最小化损失,包括在大语言模型中。

考虑一个实际例子:二元分类。这个任务将输入数据分配到两个类别之一,比如判断邮件是否为垃圾邮件,或检测网站连接请求是否为DDoS攻击。

我们的训练数据集𝒟是{(𝐱_𝑖, 𝑦_𝑖)}_{𝑖=1}^𝑁,其中𝐱_𝑖是输入特征的向量,𝑦_𝑖是标签。每个𝑦_𝑖从1到𝑁索引,对于”非垃圾邮件”取值为0,对于”垃圾邮件”取值为1。一个训练良好的模型应该对垃圾邮件输入𝐱_𝑖输出接近1的𝑦̂_𝑖,对非垃圾邮件输入输出接近0。我们可以这样定义模型:

𝑦̂ = 𝜎(𝐰 ⋅ 𝐱 + 𝑏), (1.8)

其中𝐱 = [𝑥_1, 𝑥_2, …, 𝑥_𝐷]^T和𝐰 = [𝑤_1, 𝑤_2, …, 𝑤_𝐷]^T是𝐷维向量,𝑏是标量,𝜎是第1.5节中定义的sigmoid函数。

这个模型被称为逻辑回归,常用于二元分类任务。与产生从−∞到∞范围输出的线性回归不同,逻辑回归总是输出0到1之间的值。它既可以作为独立模型,也可以作为更大神经网络的输出层。

尽管已有80多年历史,逻辑回归仍然是生产环境机器学习系统中使用最广泛的算法之一。

在这种情况下,损失函数的常见选择是二元交叉熵,也称为逻辑损失。对于单个样本𝑖,二元交叉熵损失定义为:

loss(𝑦̂_𝑖, 𝑦_𝑖) = −[𝑦_𝑖 log(𝑦̂_𝑖) + (1 − 𝑦_𝑖)log(1 − 𝑦̂_𝑖)] (1.9)

在这个方程中,𝑦_𝑖表示数据集中第𝑖个样本的实际标签,𝑦̂_𝑖是预测分数,是模型对输入向量𝐱_𝑖输出的0到1之间的值。函数log表示自然对数。

损失函数通常设计为惩罚错误预测同时奖励准确预测。要理解为什么逻辑损失适用于逻辑回归,考虑两种极端情况:

loss(0,0) = −[0 ⋅ log(0) + (1 − 0) ⋅ log(1 − 0)] = −log(1) = 0

这里损失为零,这很好,因为预测与标签匹配。

loss(1,0) = −[0 ⋅ log(1) + (1 − 0) ⋅ log(1 − 1)] = −log(0)

0的对数未定义,当𝑎接近0时,−log(𝑎)趋向无穷大,代表完全错误预测的严重损失。然而,由于𝑦̂_𝑖是sigmoid的输出,总是严格保持在0和1之间而不会达到边界值,所以损失保持有限。

对于整个数据集𝒟,损失由数据集中所有样本的平均损失给出:

loss_𝒟 = −(1/𝑁)∑_{𝑖=1}^𝑁[𝑦_𝑖 log(𝑦̂_𝑖) + (1 − 𝑦_𝑖)log(1 − 𝑦̂_𝑖)] (1.10)

为了简化梯度下降推导,我们坚持使用单个样本𝑖,并通过将预测分数𝑦̂_𝑖替换为模型表达式来重写方程:

loss(𝑦̂_𝑖, 𝑦_𝑖) = −[𝑦_𝑖 log(𝜎(𝑧_𝑖)) + (1 − 𝑦_𝑖)log(1 − 𝜎(𝑧_𝑖))],其中𝑧_𝑖 = 𝐰 ⋅ 𝐱_𝑖 + 𝑏

为了最小化loss(𝑦̂_𝑖, 𝑦_𝑖),我们计算关于每个权重𝑤_𝑗和偏置𝑏的偏导数。我们将使用链式法则,因为我们有三个函数的复合:

• 函数1:𝑧_𝑖 = 𝐰 ⋅ 𝐱_𝑖 + 𝑏,带有权重𝐰和偏置𝑏的线性函数;

• 函数2:𝑦̂_𝑖 = 𝜎(𝑧_𝑖) = 1/(1 + 𝑒^{−𝑧_𝑖}),应用于𝑧_𝑖的sigmoid函数;

• 函数3:loss(𝑦̂_𝑖, 𝑦_𝑖),如方程1.9中定义,依赖于𝑦̂_𝑖。

注意𝐱_𝑖和𝑦_𝑖是给定的:𝐱_𝑖是样本𝑖的特征向量,𝑦_𝑖 ∈ {0,1}是其标签。符号𝑦_𝑖 ∈ {0,1}意味着𝑦_𝑖属于集合{0,1},在这种情况下,表示𝑦_𝑖只能是0或1。

让我们将loss(𝑦̂_𝑖, 𝑦_𝑖)记为l_𝑖。对于权重𝑤_𝑗,链式法则的应用给出:

∂l_𝑖/∂𝑤_𝑗 = ∂l_𝑖/∂𝑦̂_𝑖 ⋅ ∂𝑦̂_𝑖/∂𝑧_𝑖 ⋅ ∂𝑧_𝑖/∂𝑤_𝑗 = (𝑦̂𝑖 − 𝑦_𝑖) ⋅ 𝑥{𝑖,𝑗}

对于偏置𝑏,我们有:

∂l_𝑖/∂𝑏 = ∂l_𝑖/∂𝑦̂_𝑖 ⋅ ∂𝑦̂𝑖/∂𝑧_𝑖 ⋅ ∂𝑧_𝑖/∂𝑏 = 𝑦̂�� − 𝑦_𝑖

这就是机器学习数学的美妙之处:激活函数——sigmoid——和损失函数——交叉熵——都源自𝑒,欧拉数。它们的函数特性服务于不同目的:sigmoid范围在0和1之间,非常适合二元分类,而交叉熵跨度从0到∞,很适合作为惩罚项。当结合时,指数和对数成分优雅地抵消,产生线性函数——因计算简单性和数值稳定性而备受推崇。本书的wiki提供了完整推导。

关于𝑤_𝑗和𝑏对单个样本(𝐱_𝑖, 𝑦_𝑖)的偏导数可以通过平均所有样本的贡献来扩展到整个数据集{(𝐱_𝑖, 𝑦_𝑖)}_{𝑖=1}^𝑁。这遵循微分的求和法则和常数倍数法则:

∂loss/∂𝑤_𝑗 = (1/𝑁)∑_{𝑖=1}^𝑁[(𝑦̂𝑖 − 𝑦_𝑖) ⋅ 𝑥{𝑖,𝑗}] (1.11)

∂loss/∂𝑏 = (1/𝑁)∑_{𝑖=1}^𝑁[𝑦̂_𝑖 − 𝑦_𝑖]

这里,loss表示整个数据集的平均损失。对各个样本的损失求平均确保每个样本对总体损失的贡献相等,无论样本总数多少。

梯度是包含所有偏导数的向量。损失函数的梯度,记为∇loss,定义如下:

∇loss = [∂loss/∂𝑤_1, ∂loss/∂𝑤_2, …, ∂loss/∂𝑤_𝐷, ∂loss/∂𝑏]^T

如果梯度的某个分量为正,这意味着增加相应参数将增加损失。因此,为了最小化损失,我们应该减少该参数。

梯度下降算法使用损失函数的梯度来迭代更新权重和偏置,旨在最小化损失函数。其工作原理如下:

从参数 w 和 b 的随机值开始。

对于每个训练样本 (x, y),使用模型计算预测值 ŷ:

ŷ ← σ(w · x + b)

使用方程 1.11 计算损失函数关于每个权重 w 和偏置 b 的偏导数。

在减少损失函数的方向上调整权重和偏置。这种调整涉及在梯度相反方向上迈出一小步。步长由学习率 η 控制(下文解释):

w ← w - η ∂loss/∂w

b ← b - η ∂loss/∂b

通过将更新后的 w 和 b 值代入方程 1.10 来计算logistic损失。

重复步骤 1-4,直到设定的迭代次数(也称为步骤)或直到损失值收敛到最小值。

以下是更详细的步骤说明:

• 从参数中减去梯度是因为梯度指向损失函数中最陡上升的方向。由于我们的目标是最小化损失,所以我们向相反方向移动——因此是减法。

• 学习率 η 是一个接近 0 的正值,作为超参数——不是由模型学习的,而是手动设置的。它控制每次更新的步长,找到其最优值需要实验。

• 收敛发生在后续迭代产生的损失减少量很小时。学习率 η 在这里至关重要:太小,进展缓慢;太大,我们可能超过最小值或甚至看到损失增加。因此,选择合适的 η 对有效的梯度下降至关重要。

让我们用一个包含 12 个示例的简单数据集来说明这个过程:

(22,25), 0, (25,35), 0, (47,80), 1, (52,95), 1, (46,82), 1, (56,90), 1, (23,27), 0, (30,50), 1, (40,60), 1, (39,57), 0, (53,95), 1, (48,88), 1

在这个数据集中,x 包含两个特征:年龄(以年为单位)和收入(以千美元为单位)。目标是预测一个人是否会购买产品,标签 y 为 0(不会购买)或 1(会购买)。

下图显示了梯度下降步骤中的损失演变和结果训练模型:

左图显示了在梯度下降优化过程中损失稳步下降。右图显示了训练模型的sigmoid函数,训练样本按其 z 值(z = w · x + b)定位,其中 w 和 b 是学习到的权重和偏置。

选择 0.5 阈值是基于图中的明显分离:所有”会购买”的样本(蓝点)都在其上方,而所有”不会购买”的样本(红点)都在其下方。对于新输入 x,生成 ŷ = σ(w · x + b)。如果 ŷ < 0.5,预测”不会购买”;否则,预测”会购买”。

梯度下降优化模型参数,但需要偏导数方程。到目前为止,我们为每个模型手动计算这些导数。随着模型变得更加复杂,特别是在具有多层的神经网络中,手动推导变得不切实际。

这就是自动微分(或autograd)的用武之地。这个功能内置在PyTorch和TensorFlow等机器学习框架中,直接从定义模型的Python代码计算偏导数。这消除了手动推导,即使对于非常复杂的模型也是如此。

现代自动微分系统可以高效处理数百万变量的导数。手动计算这些导数是不可行的——仅编写方程就可能需要数年时间。

要在PyTorch中使用梯度下降,首先用pip3安装它:

$ pip3 install torch现在PyTorch已安装,让我们导入依赖项:

import torch

import torch.nn as nn

import torch.optim as optimtorch.nn模块包含创建模型的构建块。当你使用这些组件时,PyTorch自动处理导数计算。对于梯度下降等优化算法,torch.optim模块提供了你需要的功能。以下是如何在PyTorch中实现logistic回归:

model = nn.Sequential(

nn.Linear(n_inputs, n_outputs), ➊

nn.Sigmoid() ➋

)我们的模型利用了PyTorch的sequential API,它非常适合简单的前馈神经网络,其中数据按顺序流过各层。每一层的输出自然成为后续层的输入。更通用的module API,我们将在下一章中使用,可以创建具有多个输入、输出或循环的模型。

输入层在第➊行使用nn.Linear定义,具有与我们特征向量 x 大小匹配的输入维度n_inputs,而输出维度n_outputs决定了层的单元数。对于我们的买/不买分类器——一个将类别分配给输入的模型——我们将n_inputs设置为2,因为 x = [x₁, x₂]。由于输出 z 是标量,n_outputs变为1。第➋行通过sigmoid函数变换 z 以产生输出分数。

然后我们继续定义数据集,创建模型实例,建立二元交叉熵损失函数,并设置梯度下降算法:

inputs = torch.tensor([

[22, 25], [25, 35], [47, 80], [52, 95], [46, 82], [56, 90],

[23, 27], [30, 50], [40, 60], [39, 57], [53, 95], [48, 88]

], dtype=torch.float32) ➊

labels = torch.tensor([[0], [0], [1], [1], [1], [1], [0], [1], [1], [0], [1], [1 ]

], dtype=torch.float32) ➋

model = nn.Sequential(

nn.Linear(inputs.shape[1], 1),

nn.Sigmoid()

)

optimizer = optim.SGD(model.parameters(), lr=0.001) ➌ criterion = nn.BCELoss() # 二元交叉熵损失

在上述代码块中,我们定义了输入和标签。输入形成一个12行2列的矩阵,而标签是一个包含12个组件的向量。输入张量的shape属性返回其维度:

>>> inputs.shape

torch.Size([12, 2])

张量是PyTorch的核心数据结构——为CPU和GPU计算优化的多维数组。支持自动微分和灵活的数据重塑,张量构成了神经网络操作的基础。在我们的例子中,输入张量包含12个示例,每个有2个特征,而标签张量保存12个示例,每个有单一标签。按照标准惯例,示例按行排列,特征按列排列。

如果您对张量不熟悉,本书的wiki上有一个张量介绍章节。

在PyTorch中创建张量时,在第➊行指定dtype=torch.float32显式设置32位浮点精度。这种精度设置对于神经网络计算至关重要,包括权重调整、激活函数和梯度计算。

32位浮点精度不是神经网络的唯一选择。量化是一种高级技术,使用更低精度的数据类型,如16位或8位浮点数和整数,有助于减少模型大小并提高计算效率。更多信息请参考本书wiki上的模型优化和部署资源。

第➌行的optim.SGD类通过接受模型参数列表和学习率作为输入来实现梯度下降。[2] 由于我们的模型继承自nn.Module,我们可以通过其parameters方法访问所有可训练参数。

[2][ 虽然0.001是常见的默认学习率,最优值因问题和数据集而异。找到最佳速率涉及系统性测试不同值并比较模型性能。]

PyTorch通过nn.BCELoss()提供二元交叉熵损失函数。

现在,我们拥有开始训练循环所需的一切:

for step in range(500):

optimizer.zero_grad() ➊

loss = criterion(model(inputs), labels) ➋

loss.backward() ➌

optimizer.step() ➍

第➋行通过评估模型预测与训练标签来计算二元交叉熵损失(公式1.10)。然后第➌行使用反向传播计算这个损失相对于模型参数的梯度。

反向传播应用微分规则,特别是链式法则,来计算通过深度复合函数的梯度。这个算法构成神经网络训练的骨干。当PyTorch对张量进行操作时,它构建一个如图1.1(第1.5节)所示的计算图。这个图跟踪对张量执行的所有操作。loss.backward()调用促使PyTorch遍历这个图并通过链式法则计算梯度,消除了手动梯度推导和实现的需要。

数据从输入到输出通过计算图的流动构成正向传播,而通过反向传播从输出到输入的梯度计算代表反向传播。

PyTorch在权重和偏置等参数的.grad属性中累积梯度。虽然这个特性允许在参数更新之前进行多次梯度计算——对循环神经网络有用(在第3节中涵盖)——我们的实现不需要梯度累积。因此第➊行在每步开始时清除梯度。

最后,在第➍行,通过减去学习率和损失函数偏导数的乘积来更新参数值,完成前面讨论的梯度下降算法的第3步。

读者可能想知道为什么在这个二元分类问题中标签是浮点数而不是整数。原因在于PyTorch的BCELoss函数如何操作。由于模型的输出层使用sigmoid激活函数,产生0到1之间的浮点值,BCELoss期望预测和目标标签都是相同范围内的浮点数。如果我们使用torch.long等整数类型,会遇到错误,因为BCELoss不是为处理整数类型而设计的,其内部计算期望浮点数。这是BCELoss特有的——我们稍后使用的其他损失函数如CrossEntropyLoss实际上需要整数标签。

自动微分的关键优势之一是模型切换的灵活性——只要您使用PyTorch的组件,就可以轻松在不同架构之间切换。例如,您可以用通过sequential API定义的基本两层FNN替换logistic回归:

model = nn.Sequential(

nn.Linear(features.shape[1], 100),

nn.Sigmoid(),

nn.Linear(100, labels.shape[1]),

nn.Sigmoid()

)

在这个设置中,第一层的100个单元中每个包含2个权重和1个偏置,而输出层的单个单元有100个权重和1个偏置。自动微分系统内部处理梯度计算,所以其余代码保持不变。

在下一章中,我们研究表示和处理文本数据。我们从bag-of-words和词嵌入等基本方法开始,将文档转换为数值格式,然后介绍基于计数的语言建模。

语言建模需要将文本转换为计算机可以处理的数字。在本章中,我们将探索如何将单词和文档转换为数字格式,介绍语言建模的基础知识,并研究基于计数的模型作为我们的第一个架构。最后,我们将介绍测量语言模型性能的技术。

让我们从将文本转换为机器学习可用数据的最古老但有效的技术之一开始:词袋模型。

假设您有一组文档,并希望预测每个文档的主要主题。当主题预先定义时,这个任务被称为分类。只有两个可能的主题时,它被称为二元分类,如第1.7节所述。有两个以上主题时,我们称之为多类分类。

在多类分类中,数据集由对{(𝐱, 𝑦 ∈ {1, … , 𝐶}, 𝑁 表示样本数量,𝐶 表示可能类别的数量)}组成。每个𝐱可能是一个文本文档,𝑦是一个整数,表示其主题——例如,1表示”音乐”,2表示”科学”,或3表示”电影”。

机器不像人类那样处理文本。要在文本上使用机器学习,我们首先需要将文档转换为数字。每个文档成为一个特征向量,其中每个特征是一个标量。

将文档集合转换为特征向量的常见且有效的方法是词袋模型(BoW)。以下是它如何处理10个简单文档集合的方法:

ID 文本

1 电影对每个人都很有趣。

2 看电影是很大的乐趣。

3 今天享受一部精彩的电影。

4 研究既有趣又重要。 5 学习数学非常重要。 6 科学发现很有趣。

ID 文本

7 摇滚很棒,值得聆听。

8 听音乐很有趣。

9 音乐对每个人都很有趣。

10 听民间音乐!

在机器学习中使用的文本文档集合称为语料库。应用于语料库的词袋方法涉及两个关键步骤:

创建词汇表:列出语料库中所有唯一的单词以创建词汇表。

文档向量化:将每个文档转换为特征向量,其中每个维度代表词汇表中的一个单词。该值表示单词在文档中的存在、缺失或频率。

对于10个文档的语料库,词汇表通过按字母顺序列出所有唯一单词来构建。这涉及移除标点符号、将单词转换为小写并消除重复项。处理后,我们得到:

词汇表 = [“a”, “and”, “are”, “discovery”, “enjoy”, “everyone”, “folk”, “for”, “fun”, “great”, “important”, “interesting”, “is”, “learning”, “listen”, “math”, “movie”, “movies”, “music”, “research”, “rock”, “science”, “to”, “today”, “very”, “watching”]

将文档分割成小的不可分割部分称为分词,每个部分是一个词元。有不同的分词方法。我们通过单词对10个文档的语料库进行分词。有时,将单词分解为更小的单位是有用的,称为子词,以保持词汇表大小可管理。例如,我们可能将”interesting”分割为”interest”和”-ing”,而不是将”interesting”包含在词汇表中。子词分词的一种方法是字节对编码,我们将在本章中介绍。分词方法的选择取决于语言、数据集和模型,最佳方法通过实验找到。

所有英语单词表面形式的计数——如do、does、doing和did——揭示了数百万种可能性。具有更复杂词法的语言有更大的数量。仅一个芬兰语名词就可以采用2,000-3,000种不同形式来表达各种格和数的组合。使用子词提供了一个实用的解决方案,因为在词汇表中存储每种表面形式会消耗过多的内存和计算资源。

单词是词元的一种类型,所以”词元”和”单词”经常作为文档的最小不可分割单位互换使用。在本书中,当区别重要时,上下文会使其清楚。虽然词袋方法可以处理单词和子词,但它最初是为单词设计的——因此得名。

特征向量可以组织成文档-词项矩阵(DTM)。这里,行代表文档,列代表词元。下面是10个文档语料库的部分文档-词项矩阵。它只包含一部分词元以适应页面宽度:

[Doc ] a [and … ] [fun ] [… ] [listen ] [math … ] [science ] [… watching ]

[1 ] [0 ] [0 ] [… ] [1 ] [… ] [0 ] [0 ] [… ] [0 ] [… ] [0 ]

[2 ] [0 ] [0 ] [… ] [1 ] [… ] [0 ] [0 ] [… ] [0 ] [… ] [1 ]

[3 ] [1 ] [0 ] [… ] [0 ] [… ] [0 ] [0 ] [… ] [0 ] [… ] [0 ]

4 [0 ] [1 ] [… ] [0 ] [… ] [0 ] [0 ] [… ] [0 ] [… ] [0 ]

[5 ] [0 ] [0 ] [… ] [0 ] [… ] [0 ] [1 ] [… ] [0 ] [… ] [0 ]

[6 ] [0 ] [0 ] [… ] [0 ] [… ] [0 ] [0 ] [… ] [1 ] [… ] [0 ]

[7 ] [0 ] [0 ] [… ] [0 ] [… ] [1 ] [0 ] [… ] [0 ] [… ] [0 ]

[8 ] [0 ] [0 ] [… ] [1 ] [… ] [1 ] [0 ] [… ] [0 ] [… ] [0 ]

[9 ] [0 ] [0 ] [… ] [1 ] [… ] [0 ] [0 ] [… ] [0 ] [… ] [0 ]

[10 ] [0 ] [0 ] [… ] [0 ] [… ] [1 ] [0 ] [… ] [0 ] [… ] [0 ]

在上述DTM中,1表示词元出现在文档中,而0表示不出现。例如,文档2(“看电影是很大的乐趣。”)的特征向量𝐱是:

𝐱[1] = [0,0,0,0,0,0,0,0,1,1,0,0,1,0,0,0,0,1,0,0,0,0,0,0,0,1]。

在自然语言中,词频遵循齐普夫定律,指出单词的频率与其在频率中的排名成反比

表格——例如,第二频繁的词出现次数是最频繁词的一半。我们有三个类别:1表示电影,2表示音乐,3表示科学。虽然二元分类器通常使用sigmoid激活函数配合二元交叉熵损失,如第1.7节所讨论的,涉及三个或更多类别的任务通常采用softmax激活函数配合交叉熵损失。

通常最频繁的一个。因此,文档-词项矩阵通常是稀疏的,主要包含零值。

神经网络可以训练使用这些特征向量来预测文档的主题。让我们来做这件事。第一步是为文档分配标签,这个过程称为标注。标注可以手动完成或通过算法辅助。当使用算法时,通常需要人工验证来确认准确性。在这里,我们将通过阅读每个文档并从三个选项中选择最合适的主题来手动标注文档。

文档 文本 类别ID 类别名称 1 电影对每个人都很有趣。 1 电影 2 看电影很有趣。 1 电影 3 今天享受一部精彩的电影。 1 电影 4 研究很有趣且重要。 3 科学 5 学习数学非常重要。 3 科学 6 科学发现很有趣。 3 科学 7 摇滚音乐很棒。 2 音乐 8 听音乐很有趣。 2 音乐 9 音乐对每个人都很有趣。 2 音乐 10 听民间音乐! 2 音乐

先进的聊天语言模型通过专家模型小组实现高度准确的自动文档标注。使用三个LLM,当两个或更多为文档分配相同标签时,就采用该标签。如果三个都不同意,要么人工决定,要么第四个模型来打破平局。在许多商业环境中,手动标注正在变得过时,因为LLM提供更快且通常更可靠的标注。

softmax函数定义为:

softmax(𝐳, 𝑘) = 𝑒^𝑧_𝑘 / ∑_(𝑖=1)^𝐷 𝑒^𝑧_𝑖

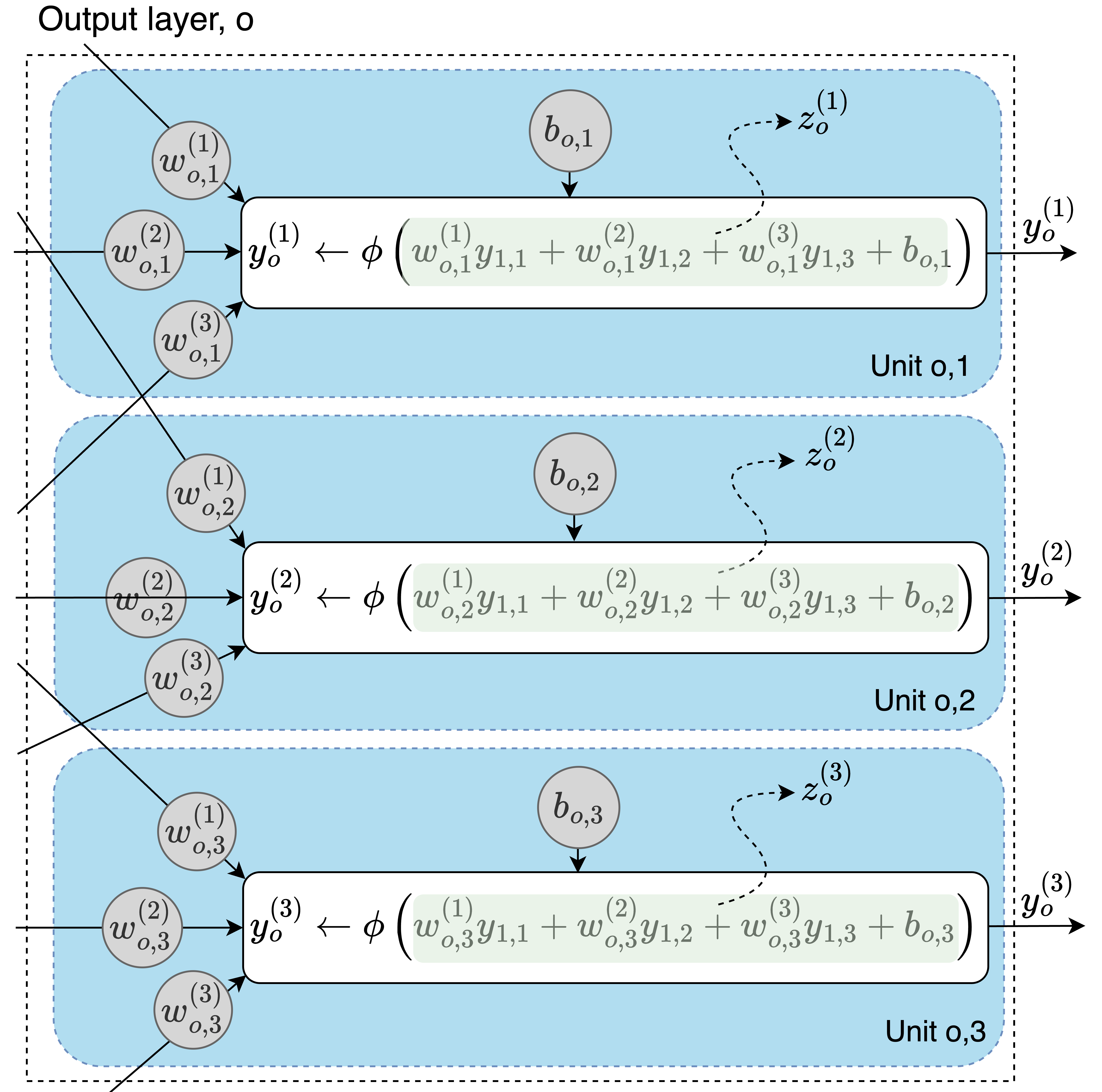

这里,𝐳是logits的𝐷维向量,𝑘是计算softmax的索引,𝑒是欧拉数。Logits是神经网络在应用激活函数之前的原始输出,如下所示:

类别标签在分类中是任意且无序的。你可以以任何方式为类别分配数字,只要映射对所有示例保持一致,模型的性能就不会改变。

图中显示了神经网络的输出层,标记为𝑜。logits 𝑧_𝑘,对于𝑘 ∈ {1,2,3},是浅绿色的值。这些表示在应用激活函数之前单元的输出。

向量𝐳表示为𝐳 = [𝑧_1, 𝑧_2, 𝑧_3]。

例如,图中单元𝑜_2的softmax计算为:

softmax(𝐳, 2) = 𝑒^𝑧_2 / (𝑒^𝑧_1 + 𝑒^𝑧_2 + 𝑒^𝑧_3)

Softmax将向量转换为离散概率分布(DPD),确保∑_𝑘=1^𝐶 softmax(𝐳, 𝑘) = 1。DPD为有限集合中的值分配概率,其总和等于1。有限集合包含可数的不同元素。例如,在具有类别1、2和3的分类任务中,这些类别构成一个有限集合。softmax函数将每个类别映射到一个概率,这些概率总和为1。

让我们逐步计算概率。假设我们有三个logits,𝐳 = [2.0, 1.0, 0.5],表示文档分类为电影、音乐或科学。

首先,计算每个logit的𝑒^𝑧_𝑘:

𝑒^𝑧_1 = 𝑒^2.0 ≈ 7.39, 𝑒^𝑧_2 = 𝑒^1.0 ≈ 2.72, 𝑒^𝑧_3 = 𝑒^0.5 ≈ 1.65

接下来,将这些值相加:∑_𝑖=1^3 𝑒^𝑧_𝑖 = 7.39 + 2.72 + 1.65 ≈ 11.76。

现在使用softmax公式,softmax(𝐳, 𝑘) = 𝑒^𝑧_𝑘 / ∑_𝑖=1^3 𝑒^𝑧_𝑖,来计算概率:

Pr(电影) = 7.39/11.76 ≈ 0.63, Pr(音乐) = 2.72/11.76 ≈ 0.23, Pr(科学) = 1.65/11.76 ≈ 0.14

神经网络softmax输出更好地描述为”概率得分”而非真正的统计概率,尽管它们总和为一并类似于类别似然。与logistic回归或朴素贝叶斯模型不同,神经网络不产生真正的类别概率。然而,为了简单起见,我将在本书中将这些概率得分称为”概率”。

交叉熵损失衡量预测概率与真实分布的匹配程度。真实分布通常是独热向量(one-hot vector),只有一个元素等于1(正确类别),其他地方为0。例如,具有3个类别的独热编码如下:

类别 独热向量 1 [1,0,0] 2 [0,1,0] 3 [0,0,1]

单个示例的交叉熵损失为:

loss(𝐲̂, 𝐲) = -∑_(𝑘=1)^𝐶 𝑦_𝑘 log(𝑦̂_𝑘),

其中𝐶是类别数,𝐲是独热编码的真实标签,𝐲̂是预测概率。这里,𝑦_𝑘和𝑦̂_𝑘分别表示𝐲和𝐲̂的第𝑘个元素。

由于𝐲是独热编码的,只有对应于正确类别的项对求和有贡献。因此求和通过保留仅该单项来简化。让我们简化它。假设正确类别是𝑐,所以𝑦_𝑐 = 1且对于所有𝑘 ≠ 𝑐,𝑦_𝑘 = 0。在求和中,只有𝑘 = 𝑐的项将为非零。方程简化为:

loss(𝐲̂, 𝐲) = -log(𝑦̂_𝑐) (2.1)

这种简化形式表明损失对应于分配给正确类别的概率的负对数。对于𝑁个示例,平均损失为:

loss = -(1/𝑁) ∑_(𝑖=1)^𝑁 log(𝑦̂_𝑐_𝑖),

其中𝑐_𝑖是第𝑖个示例的正确类别索引。

当在输出层与softmax一起使用时,交叉熵损失引导网络为正确类别分配高概率,同时降低错误类别的概率。

对于具有三个类别(电影、音乐和科学)的文档分类示例,网络生成三个logits。这些logits通过softmax函数转换为每个类别的概率。然后在这些分数和真实的独热编码标签之间计算交叉熵损失。

让我们通过训练一个简单的两层神经网络来将文档分类为三个类别来说明这一点。我们首先导入依赖项、设置随机种子并定义数据集:

import re, torch, torch.nn as nn

torch.manual_seed(42) ➊

docs = [

"Movies are fun for everyone.", "Watching movies is great fun.",

...

"Listen to folk music!"

]

labels = [1, 1, 1, 3, 3, 3, 2, 2, 2, 2]

num_classes = len(set(labels))在第➊行设置随机种子确保PyTorch运行时随机数生成的一致性。这保证了可重现性,允许您将性能变化归因于代码或超参数修改,而不是随机变化。可重现性对于团队合作也至关重要,使协作者能够在相同条件下检查问题。

接下来,我们使用两种方法将文档转换为词袋:tokenize,将输入文本分割为小写单词,以及get_vocabulary,构建词汇表:

def tokenize(text):

return re.findall(r"\w+", text.lower()) ➊

def get_vocabulary(texts):

tokens = {token for text in texts for token in tokenize(text)} ➋

return {word: idx for idx, word in enumerate(sorted(tokens))} ➌在第➊行中,正则表达式+从文本中提取单个单词。正则表达式是用于定义搜索模式的字符序列。模式+匹配”单词字符”序列,如字母、数字和下划线。

Python的re模块中的findall函数应用正则表达式并返回输入字符串中所有匹配项的列表。在这种情况下,它提取所有单词。

在第➋行中,通过遍历每个文档并使用相同的正则表达式提取单词,将语料库转换为一组tokens。在第➌行中,这些tokens按字母顺序排序并映射到唯一索引,形成词汇表。

构建词汇表后,下一步是定义将文档转换为特征向量的特征提取函数:

def doc_to_bow(doc, vocabulary):

tokens = set(tokenize(doc))

bow = [0] * len(vocabulary)

for token in tokens:

if token in vocabulary:

bow[vocabulary[token]] = 1

return bowdoc_to_bow函数接受一个文档字符串和一个词汇表,并返回文档的词袋表示。

现在,让我们将我们的文档和标签转换为数字:

vectors = torch.tensor(

[doc_to_bow(doc, vocabulary) for doc in docs],

dtype=torch.float32

)

labels = torch.tensor(labels, dtype=torch.long) - 1 ➊形状为(10, 26)的vectors张量将10个文档表示为行,26个词汇表tokens表示为列,而形状为(10,)的labels张量包含每个文档的类别标签。标签使用整数索引而不是独热编码,因为PyTorch的交叉熵损失函数(nn.CrossEntropyLoss)期望这种格式。

第➊行使用torch.long将标签转换为64位整数。-1调整将我们原始的类别1、2、3转换为索引0、1、2,这与PyTorch的期望一致,即对于模型和损失函数如CrossEntropyLoss,类别索引从0开始。

PyTorch为模型定义提供了两个API:sequential API和module API。虽然我们在第1.8节中使用了简单的nn.Sequential API来定义我们的模型,但现在我们将探索使用更灵活的nn.Module API构建多层感知器:

input_dim = len(vocabulary)

hidden_dim = 50

output_dim = num_classes

class SimpleClassifier(nn.Module):

def __init__(self, input_dim, hidden_dim, output_dim):

super().__init__()

self.fc1 = nn.Linear(input_dim, hidden_dim)

self.relu = nn.ReLU()

self.fc2 = nn.Linear(hidden_dim, output_dim)

def forward(self, x):

x = self.fc1(x) ➊

x = self.relu(x) ➋

x = self.fc2(x) ➌

return x

model = SimpleClassifier(input_dim, hidden_dim, output_dim)SimpleClassifier类实现了一个具有两层的前馈神经网络。其构造函数定义了网络组件:

一个全连接层self.fc1,将大小为input_dim(等于词汇表大小)的输入映射到50个(hidden_dim)输出。

一个ReLU激活函数引入非线性。

第二个全连接层self.fc2,将50个中间输出减少到output_dim,即唯一标签的数量。

forward方法描述了前向传播,其中输入流经各层:

• 在第➊行中,形状为(10, 26)的输入x传递给第一个全连接层,将其转换为形状(10, 50)。

• 在第➋行中,该层的输出通过ReLU激活函数,保持形状(10, 50)。

• 在第➌行中,结果发送到第二个全连接层,从形状(10, 50)减少到(10, 3),产生带有logits的模型最终输出。

当您将输入数据传递给模型实例时,会自动调用forward方法,如下所示:model(input)。

虽然SimpleClassifier省略了最终的softmax层,但这是有意的——PyTorch的CrossEntropyLoss为了稳定性在内部结合了softmax和交叉熵损失。这种设计消除了在模型前向传播中显式softmax的需要。

定义了我们的模型后,如第1.8节所述,下一步是定义损失函数、选择梯度下降算法并设置训练循环:

criterion = nn.CrossEntropyLoss() optimizer = torch.optim.SGD(model.parameters(), lr=0.001)

for step in range(3000):

optimizer.zero_grad()

loss = criterion(model(vectors), labels)

loss.backward()

optimizer.step()

如您所见,训练循环与第1.8节中的完全相同。训练完成后,我们可以在新文档上测试模型:

new_docs = [

"Listening to rock music is fun.", "I love science very much."

]

class_names = ["Cinema", "Music", "Science"]

new_doc_vectors = torch.tensor(

[doc_to_bow(new_doc, vocabulary) for new_doc in new_docs] ,

dtype=torch.float32

)

with torch.no_grad(): ➊

outputs = model(new_doc_vectors) ➋

predicted_ids = torch.argmax(outputs, dim=1) + 1 ➌

for i, new_doc in enumerate(new_docs):

print(f'[{]new_doc[}]: [{]class_names[predicted_ids[i].item() -1][}]')

输出:

Listening to rock is fun.: Music I love scientific research.: Science

第➊行中的torch.no_grad()语句禁用了默认的梯度跟踪。虽然梯度在训练期间对于更新模型参数至关重要,但在测试或推理期间却不需要。由于这些阶段不涉及参数更新,禁用梯度跟踪可以节省内存并加快计算速度。注意,术语”测试”、“推理”和”评估”在指代对未见数据生成预测时经常可以互换使用。

在第➋行中,模型在推理期间同时处理所有输入,就像在训练期间一样。这种并行处理方法利用了向量化操作,与逐个处理输入相比,大大减少了计算时间。

我们只关心最终标签,而不是模型返回的logits。在第➌行中,torch.argmax识别最高logit的索引,对应预测的类别。加1是为了补偿之前从基于1的索引到基于0的索引的转换。

虽然词袋方法具有简单性和实用性,但它也有显著的局限性。最重要的是,它无法捕获token的顺序或上下文。考虑”the cat chased the dog”和”the dog chased the cat”如何产生相同的表示,尽管它们传达的是相反的含义。

N-grams为这一挑战提供了解决方案。N-gram由文本中的𝑛个连续token组成。考虑句子”Movies are fun for everyone”——其bigrams(2-grams)包括”Movies are”、“are fun”、“fun for”和”for everyone”。通过保留token序列,n-grams保留了单个token无法捕获的上下文信息。

然而,使用n-grams是有代价的。词汇表大幅扩展,增加了模型训练的计算成本。此外,模型需要更大的数据集来有效学习扩展的可能n-grams集合的权重。

词袋方法的另一个局限性是它如何处理词汇表外的单词。当一个单词在推理期间出现但在训练期间不存在——因此不在词汇表中——它无法在特征向量中表示。同样,该方法在处理同义词和近义词时也存在困难。像”movie”和”film”这样的单词被处理为完全不同的术语,迫使模型为每个单词学习单独的参数。由于标记数据通常获取成本高昂,导致标记数据集相当小,如果模型能够识别并集体处理具有相似含义的单词会更有效率。

Word embeddings通过将语义相似的单词映射到相似的向量来解决这个问题。

考虑之前的文档3(“Enjoy a great movie today.”)。我们可以将这个词袋(BoW)分解为表示单个单词的one-hot向量:

BoW 1 0 0 0 1 0 0 0 0 1 0 0 0 0 0 0 1 0 0 0 0 0 0 1 0 0 enjoy 0 0 0 0 1 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 a [1 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 ]

great 0 0 0 0 0 0 0 0 0 1 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 movie 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 1 0 0 0 0 0 0 0 0 0 today 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 1 0 0 如我们所见,文档的词袋向量是其单词的one-hot向量的和。现在,让我们检查文本”Films are my passion.”的one-hot向量和BoW向量:

BoW 0 0 1 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 films 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 are [0 0 1 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 ]

my [0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 ]

pas- [0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 ]

sion

这里有两个关键问题。首先,即使一个单词存在于训练数据和词汇表中,one-hot编码将其简化为零向量中的单个1,这给分类器几乎没有有意义的信息来学习。

其次,在上述文档中,大多数one-hot编码的单词向量没有添加价值,因为四分之三变成了零向量——表示词汇表中缺失的单词。

更好的方法是让模型理解”films”虽然在训练中未见过,但与”movies”具有语义含义。这将允许”films”的特征向量与”movies”类似地被处理。这种方法需要能够捕获单词之间语义关系的单词表示。

Word embeddings通过将单词表示为密集向量而不是稀疏one-hot向量来克服词袋模型的局限性。这些低维表示包含主要是非零值,相似的单词具有表现出高余弦相似度的embeddings。这些embeddings是从跨越数百万到数亿文档的大量无标签数据集中学习的。

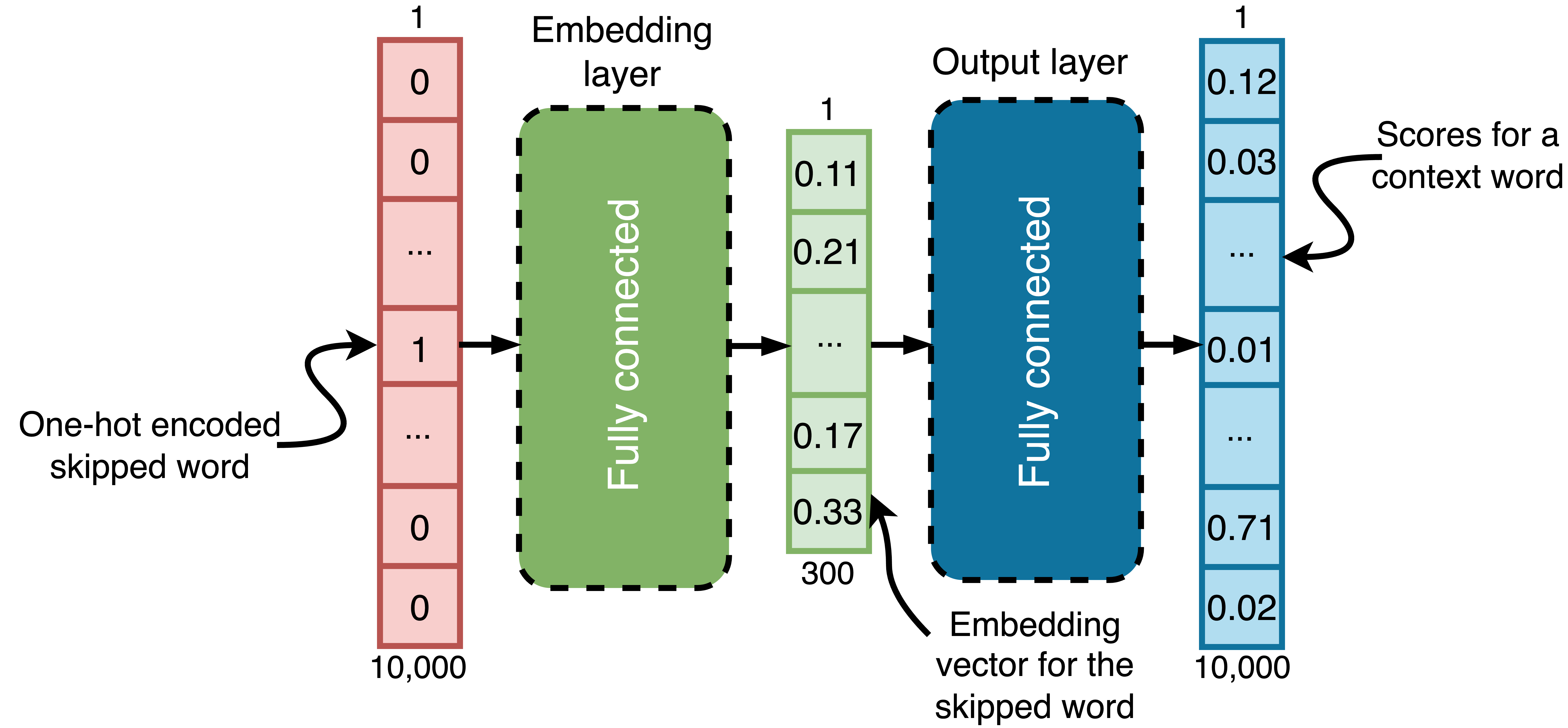

Word2vec是一种广泛使用的embedding学习算法,存在两种变体。我们将检查skip-gram公式。

Skip-grams 是跳过一个单词的词序列。例如,在 “Professor Alan Turing’s * advanced computer science” 中,缺失的单词(标记为 *)可能是 “research”、“work” 或 “theories”——这些词在上下文中合适,尽管它们不是完全同义词。训练模型从周围上下文预测这些跳过的单词有助于它学习单词之间的语义关系。

这个过程也可以反向进行:跳过的单词可以用来预测其上下文单词。这是 skip-gram算法 的基础。

skip-gram大小指定包含多少个上下文单词。对于大小为5,这意味着跳过单词前后各两个单词。以下是我们句子中大小为5的skip-grams示例,跳过不同的单词(标记为 *):

Skip-gram 跳过的单词 professor alan * research advanced turing’s alan turing’s * advanced computer research turing’s research * computer science advanced

如果语料库词汇表包含10,000个单词,带有300个单元嵌入层的skip-gram模型如下所示:

这是一个skip-gram大小为5且嵌入层为300个单元的skip-gram模型。如你所见,该模型使用one-hot编码的跳过单词来预测上下文单词,通过两个连续的全连接层处理输入。它不会一次预测所有上下文单词,而是为每个单词分别进行预测。

以下是它如何处理skip-gram “professor alan * research advanced” 和跳过单词 “turing’s” 的过程。我们将skip-gram转换为4个训练对:

跳过单词(输入) 上下文单词(目标) 位置 turing’s professor −2 turing’s alan −1 turing’s research +1 turing’s advanced +2

对于每对跳过和上下文单词,比如 (turing’s, professor),模型:

对于给定的上下文单词,输出层在词汇表上产生概率向量。每个值表示该词汇表单词成为上下文单词的可能性。

好奇的读者可能会注意到:如果每个训练对的输入保持不变——比如 “turing’s”——为什么输出会不同?这是一个很好的观察!对于相同的输入,输出确实是相同的。但是,损失计算因每个上下文单词而异。

当使用 chat language models 时,你可能注意到相同的问题经常产生不同的答案。虽然这可能暗示模型是非确定性的,但这并不准确。LLM从根本上是一个神经网络,类似于skip-gram模型但参数更多。表面的随机性来自这些模型用于生成文本的方式。在生成过程中,单词基于其预测概率进行采样。虽然高概率单词更有可能被选择,但低概率单词仍可能被选中。这种采样过程创造了我们在响应中观察到的变化。我们将在第5章讨论采样。

skip-gram模型使用 cross-entropy 作为其损失函数,就像前面讨论的三类文本分类器一样,但处理10,000个类别——词汇表中每个单词一个类别。对于训练集中的每个skip-gram,模型分别计算每个上下文单词的损失,比如围绕 “turing’s” 的四个单词,然后平均这些损失以同时接收所有上下文单词预测的反馈。

这种训练方法使模型能够捕获有意义的单词关系,即使在不同训练对中使用相同输入时也是如此。

这里有一个例子。对于输入单词 “turing’s”,假设模型为不同词汇表单词分配这些概率:professor (0.1), alan (0.15), research (0.2), advanced (0.05)。在训练模型时,每个输入-目标单词对都对损失函数有贡献。例如,当训练数据中 “turing’s” 与 “professor” 出现时,损失致力于增加0.1的分数。类似地,当与 “alan” 配对时,损失致力于增加0.15,与 “research” 配对增加0.2,与 “advanced” 配对增加0.05。

在反向传播期间,模型调整其权重以使这些分数对给定的上下文单词更高。例如,更新后的分数可能是:professor: 0.11, alan: 0.17, research: 0.22, advanced: 0.07,而其他词汇表单词的分数略有下降。

一旦训练完成,输出层被丢弃。嵌入层然后作为新的输出层。当给定one-hot编码的输入单词时,模型产生一个300维向量——这就是词嵌入。

Word2vec只是从大型文本语料库学习词嵌入的一种方法。其他方法,如 GloVe 和 FastText,提供替代方法,专注于捕获全局共现统计或子词信息以创建更稳健的嵌入。

使用词嵌入表示文本比词袋模型具有明显优势。一个优势是 降维,它将单词表示从词汇表大小(如在one-hot编码中)压缩到小向量,通常在100到1000维之间。这使得在机器学习任务中处理非常大的语料库变得可行。

语义相似性 是词嵌入的另一个优势。具有相似含义的单词被映射到在嵌入空间中彼此接近的向量。例如,考虑Google在包含约1000亿单词的新闻语料库上训练的word2vec嵌入。在下面的图表中,“Moscow” 和 “Beijing”,或 “Russia” 和 “China”,由彼此靠近的点表示。这反映了它们的语义关系:

该图显示了国家及其首都的300维嵌入向量的2D投影。含义相关的词聚集在一起,而连接城市与其各自国家的近似平行线揭示了它们的语义关系。

skip-gram模型即使在没有直接共现的情况下,当词出现在相似上下文中时也能捕获语义相似性。例如,如果模型对”films”和”movies”产生不同的概率,损失函数会驱使它预测相似的概率,因为上下文词经常重叠。通过反向传播,这些词的嵌入层输出会收敛。

4 这些嵌入可以通过搜索”GoogleNews-vectors-negative300.bin.gz”在线找到。书籍wiki上有备份:https://www.thelmbook.com/data/word-vectors

在词嵌入之前,WordNet(1985年在普林斯顿创建)试图通过将词组织成同义词集合并记录它们之间的语义链接来捕获词关系。虽然有效,但这些手工制作的映射无法扩展到大词汇量,也无法捕获基于嵌入方法自然出现的词使用中的微妙模式。

由于无法直接可视化300维向量,我们使用了一种叫做主成分分析(PCA)的降维技术将它们投影到二维,称为第一和第二主成分。

降维算法在保持向量关系的同时压缩高维向量。上图中的第一和第二主成分保留了词之间的语义连接,揭示了它们的关系。

有关PCA和其他降维方法的资源,请查看书籍wiki上列出的推荐材料。

词嵌入捕获词的含义及其与其他词的关系。它们是许多自然语言处理(NLP)任务的基础。例如,神经语言模型将文档编码为词嵌入矩阵。每行对应一个词的嵌入向量,其在矩阵中的位置反映该词在文档中的位置。

word2vec嵌入支持有意义的算术运算(如”king − man + woman ≈ queen”)的发现是一个关键时刻,揭示了神经网络可以在向量运算产生词义变化的空间中编码语义关系。这使得发明能够对词进行复杂数学运算的神经网络(如大型语言模型所做的)只是时间问题。

然而,现代语言模型通常使用子词——比完整单词更小的token。在转向语言模型——本书的主要主题——之前,让我们首先研究字节对编码,一种广泛使用的子词tokenization方法。

字节对编码(BPE)是一种tokenization算法,通过将词分解为称为子词的更小单元来解决处理词汇外词的挑战。

BPE最初是一种数据压缩技术,通过将词视为字符序列而适用于NLP。它将最频繁的符号对——字符或子词——合并为新的子词单元。这一过程持续进行,直到词汇表达到目标大小。

以下是基本的BPE算法:

使用文本语料库。将语料库中的每个词分割为单个字符。例如,词”hello”变成”h e l l o”。初始词汇表由语料库中所有唯一字符组成。

继续迭代合并,直到词汇表达到所需大小。

该算法很简单,但直接在大型语料库上实现是低效的。在每次合并后重新计算符号对或更新整个语料库在计算上是昂贵的。

一种更高效的方法是用语料库中所有唯一词及其计数初始化词汇表。使用这些词计数计算对计数,并通过合并最流行的对来迭代更新词汇表。让我们编写代码:

from collections import defaultdict

def initialize_vocabulary(corpus):

vocabulary = defaultdict(int)

charset = set()

for word in corpus:

word_with_marker = '_' + word ➊

characters = list(word_with_marker) ➋

charset.update(characters) ➌

tokenized_word = ' '.join(characters) ➍

vocabulary[tokenized_word] += 1 ➎

return vocabulary, charset该函数生成一个词汇表,将词表示为字符序列并跟踪它们的计数。给定一个语料库(词列表),它返回两个输出:vocabulary,一个将每个词——用字符间空格tokenized——映射到其计数的字典,以及charset,语料库中所有唯一字符的集合。

工作原理如下:

• 第➊行在每个词的开头添加词边界标记”_”

区分开头的子词和中间的子词。例如,“restart” 中的 “_re” 与 “agree” 中的 “re” 是不同的。这有助于从使用模型生成的 token 重新构建句子。当一个 token 以 “_” 开头时,它标记着一个新单词的开始,需要在它前面添加一个空格。

• 第➋行将每个单词拆分为单个字符。

• 第➌行用单词中遇到的任何新字符更新字符集。

• 第➍行用空格连接字符以创建单词的分词版本。例如,单词 “hello” 变成 _ h e l l o。

• 第➎行将 tokenized_word 添加到词汇表中,其计数递增。

初始化后,BPE 迭代地合并词汇表中最频繁的 token 对(双字符组)。通过移除这些对之间的空格,它形成逐渐更长的 token。

def get_pair_counts(vocabulary):

pair_counts = defaultdict(int)

for tokenized_word, count in vocabulary.items(): tokens = tokenized_word.split() ➊

for i in range(len(tokens) -1):

pair = (tokens[i], tokens[i + 1]) ➋

pair_counts[pair] += count ➌

return pair_counts

该函数计算相邻 token 对在分词词汇表单词中出现的频率。输入词汇表将分词单词映射到它们的计数,输出是 token 对及其总计数的字典。

对于词汇表中的每个 tokenized_word,我们在第➊行将其拆分为 token。嵌套循环在第➋行形成相邻的 token 对,并在第➌行按单词的计数递增它们的计数。

def merge_pair(vocabulary, pair):

new_vocabulary = {}

bigram = re.escape(' '.join(pair)) ➊

pattern = re.compile([r"(? + bigram + [r"(?!\S)"]) ➋]

for tokenized_word, count in vocabulary.items(): new_tokenized_word = pattern.sub("".join(pair), token

ized_word) ➌

new_vocabulary[new_tokenized_word] = count

return new_vocabulary

该函数在词汇表的所有分词单词中合并输入 token 对。它返回一个新词汇表,其中该对的每次出现都被合并成单个 token。例如,如果该对是 ('e', 'l'),分词单词是 “_ h e l l o”,合并 'e' 和 'l' 会移除它们之间的空格,结果是 “_ h el l o”。

在第➊行,re.escape 函数自动为字符串中的特殊字符(如 ., *, 或 ?)添加反斜杠,因此它们被解释为字面字符,而不是在正则表达式中具有特殊含义。

第➋行的正则表达式只匹配完整的 token 对。它通过检查匹配前后是否没有非空白字符来确保双字符组不是更大单词的一部分。例如 “good morning” 在 “this is good morning” 中匹配,但在 “thisis-good morning” 中不匹配,其中 “good” 是 “thisisgood” 的一部分。

表达式 (?是负向后查找和负向前查找断言,确保双字符组独立存在。

后查找检查双字符组前面没有非空白字符,意味着它跟在空白或文本开头之后。前查找同样确保双字符组后面没有非空白字符,意味着它在空白或文本结尾之前。它们一起防止双字符组成为更长单词的一部分。

最后,在第➌行,函数使用 pattern.sub() 将匹配模式的所有出现替换为连接的对,创建新的分词单词。

下面的函数实现了 BPE 算法,迭代地合并最频繁的 token 对,直到没有合并剩余或达到目标词汇表大小:

def byte_pair_encoding(corpus, vocab_size):

vocabulary, charset = initialize_vocabulary(corpus)

merges = []

tokens = set(charset)

while len(tokens) < vocab_size: ➊ pair_counts = get_pair_counts(vocabulary)

if not pair_counts: ➋

break

most_frequent_pair = max(pair_counts, key=pair_counts .get) ➌

merges.append(most_frequent_pair)

vocabulary = merge_pair(vocabulary, most_frequent_pai r) ➍

new_token = ''.join(most_frequent_pair) ➎

tokens.add(new_token) ➏

return vocabulary, merges, charset, tokens

该函数处理语料库以产生分词器所需的组件。它初始化词汇表和字符集,创建一个空的合并列表来存储合并操作,并将 tokens 设置为初始字符集。随着时间推移,tokens 增长以包括分词器能够生成的所有唯一 token。

第➊行的循环继续,直到分词器支持的 token 数量达到 vocab_size 或没有剩余对可以合并。第➋行检查是否没有更多有效对,在这种情况下循环退出。第➌行找到最频繁的 token 对,在第➍行在整个词汇表中合并以在第➎行创建新 token。这个新 token 在第➏行添加到 tokens 集合中,合并记录在 merges 中。

该函数返回四个输出:更新的词汇表、合并操作列表、原始字符集和最终的唯一 token 集合。

下面的函数使用经过训练的分词器对单词进行分词:

def tokenize_word(word, merges, vocabulary, charset, unk_toke n=""):

word = '_' + word

if word in vocabulary:

return [word]

tokens = [char if char in charset else unk_token for char in word]

for left, right in merges: i = 0

while i < len(tokens) -1:

if tokens[i:i+2] == [left, right]:

tokens[i:i+2] = [left + right]

else:

i += 1

return tokens 该函数使用byte_pair_encoding的merges、vocabulary和charset对单词进行tokenization。单词首先被加上前缀。如果加前缀的单词存在于vocabulary中,则将其作为唯一token返回。否则,将单词分割为字符,将任何不在charset中的字符替换为unk_token。然后使用merges中规则的顺序对这些字符进行迭代合并。

为了对文本进行tokenization,我们首先基于空格将其分割为单词,然后单独对每个单词进行tokenization。thelmbook.com/nb/2.1 notebook包含了使用新闻语料库训练BPE tokenizer的代码。使用在notebook中训练的tokenizer对句子“Let’s proceed to the language modeling chapter.”进行tokenization后的版本是:

["_Let", "'", "s", "_proceed", "_to", "_the", "_language", "_ model", "ing", "_part", "."]

这里,“let’s”和”modeling”被分解为subwords。这表明它们在训练数据中相对稀少,目标vocabulary大小较小(我设置了5000个tokens)。

tokenize_word算法由于嵌套循环而效率低下:它在第➍行遍历所有merges,同时在第➎行检查每个token对。然而,由于现代语言模型的vocabulary超过100,000个tokens,大多数输入单词存在于vocabulary中,绕过了subword tokenization。notebook的优化版本使用缓存和预计算数据结构来消除这些嵌套循环,将tokenization时间从0.0549秒减少到0.0037秒。虽然实际性能因系统而异,但优化方法始终提供更好的速度。

对于没有空格的语言(如中文)或多语言模型,通常跳过基于空格的初始tokenization。相反,文本被分割为单个字符。从那里开始,BPE照常进行,合并最频繁的字符或token对以形成subwords。

我们现在准备研究语言建模的核心思想。我们将从传统的基于计数的方法开始,在后续章节中涵盖基于神经网络的技术。

语言模型通过基于先前tokens估计条件概率来预测序列中的下一个token。它为所有可能的下一个tokens分配概率,从而能够选择最可能的一个。这种能力支持文本生成、机器翻译和语音识别等任务。在大型无标签文本语料库上训练,语言模型学习语言中的统计模式,使它们能够用于生成类人文本。

形式上,对于𝐿个tokens的序列𝐬(𝑡₁, 𝑡₂, …, 𝑡ₗ),语言模型计算:

PrC𝑡ₗ₊₁ = 𝑡 |𝐬 = (𝑡₁, 𝑡₂, …, 𝑡ₗ)D (2.2)

这里,Pr表示vocabulary上下一个token的条件概率分布。条件概率量化了在另一个事件已经发生的情况下一个事件发生的可能性。在语言模型中,它反映了给定前面的token序列,特定token成为下一个token的概率。这个序列通常被称为输入序列、context或prompt。

以下记号等价于方程2.2:

Pr(𝑡ₗ₊₁|𝑡₁, 𝑡₂, …, 𝑡ₗ) 或 Pr(𝑡ₗ₊₁|𝐬) (2.3)

我们将根据上下文选择不同的记号,从简洁到详细。

对于任何token 𝑡和序列𝐬,条件概率满足Pr(𝑡|𝐬) ≥ 0,意味着概率总是非负的。此外,vocabulary 𝒱中所有可能下一个tokens的概率必须求和为1:∑ₜ∈𝒱 Pr(𝑡|𝐬) = 1。这确保模型输出vocabulary上的有效离散概率分布。

为了说明,让我们考虑一个包含5个单词的vocabulary 𝒱:“are”、“cool”、“language”、“models”和”useless”。对于序列𝐬 = (language, models, are),语言模型可以为𝒱中每个可能的下一个单词输出以下概率:

PrC𝑡 = are|𝐬 = (language, models, are)D = 0.01

PrC𝑡 = cool|𝐬 = (language, models, are)D = 0.77

PrC𝑡 = language|𝐬 = (language, models, are)D = 0.02

PrC𝑡 = models|𝐬 = (language, models, are)D = 0.15

PrC𝑡 = useless|𝐬 = (language, models, are)D = 0.05

该示例演示了语言模型如何为每个潜在的下一个单词在其vocabulary上分配概率,其中”cool”获得最高概率。这些概率求和为1,形成有效的离散概率分布。

这种类型的模型是自回归语言模型,也称为因果语言模型。自回归涉及仅使用序列中元素的前驱来预测该元素。这样的模型在文本生成方面表现出色,包括基于Transformer的chat语言模型(chat LMs)和本书中讨论的所有语言模型。

相比之下,掩码语言模型,如BERT——一个开创性的基于Transformer的模型——使用不同的方法。这些模型预测序列中故意掩码的tokens,利用前面和后面的context。这种双向方法特别适合文本分类和命名实体识别等任务。

在神经网络成为语言建模标准之前,传统方法依赖于统计技术。这些基于计数的模型,仍在智能手机自动完成中使用,基于从语料库中学习的单词或n-gram频率计数来估计单词序列的概率。为了更好地理解这些方法,让我们实现一个简单的基于计数的语言模型。

我们将专注于三元组模型(𝑛 = 3)来说明这是如何工作的。在三元组模型中,token的概率基于前面两个tokens计算:

Pr(𝑡ᵢ|𝑡ᵢ₋₂, 𝑡ᵢ₋₁) = C(𝑡ᵢ₋₂, 𝑡ᵢ₋₁, 𝑡ᵢ) / C(𝑡ᵢ₋₂, 𝑡ᵢ₋₁) (2.4)

其中 𝐶(⋅) 表示训练数据中 n-gram 的出现次数计数。

例如,如果三元组(trigram) “language models rock” 在语料库中出现 50 次,而 “language models” 总共出现 200 次,那么:

Pr(rock|language, models) = = 0.25

这意味着在我们的训练数据中,“rock” 跟在 “language models” 后面的概率为 25%。

方程 2.4 是给定上下文条件下token概率的最大似然估计(MLE)。它衡量一个三元组相对于共享相同两个token历史的所有三元组的相对频率。

随着训练语料库的增大,MLE 对于频繁出现的 n-gram 变得更加可靠。这符合基本的统计原理:更大的数据集产生更准确的估计。

然而,有限大小的语料库带来了一个问题:我们在实践中可能遇到的一些 n-gram 可能不会出现在训练数据中。例如,如果三元组 “language models sing” 从未在我们的语料库中出现,那么根据 MLE,它的概率将为零:

Pr(sing|language, models ) = = 0

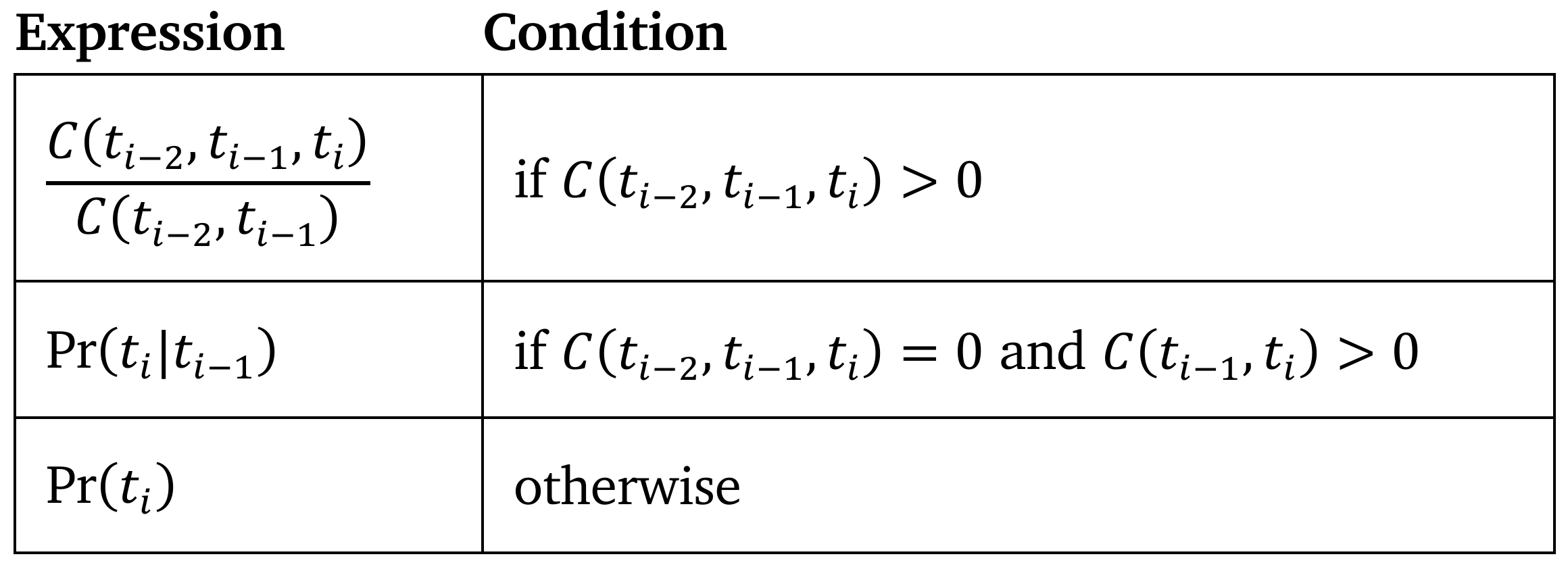

这是有问题的,因为它给任何包含未见过的 n-gram 的序列分配零概率,即使它是一个有效的短语。为了解决这个问题,存在几种技术,其中之一是回退(backoff)。思路很简单:如果没有观察到高阶 n-gram(例如三元组),我们就”回退”到低阶 n-gram(例如二元组)。概率 Pr(𝑡|𝑡, 𝑡) 由以下表达式之一给出,具体取决于条件是否为真:

这里,𝐶(𝑡, 𝑡, 𝑡) 是三元组 (𝑡, 𝑡, 𝑡) 的计数,𝐶(𝑡, 𝑡) 和 𝐶(𝑡, 𝑡) 分别是二元组 (𝑡, 𝑡) 和 (𝑡, 𝑡) 的计数。二元组概率和一元组概率计算如下:

Pr(𝑡|𝑡) = 𝐶(𝑡, 𝑡)/𝐶(𝑡), Pr(𝑡) = (𝐶(𝑡) + 1)/(𝑊 + 𝑉)

其中 𝐶(𝑡) 是token 𝑡 的计数,𝑊 是语料库中token的总数,𝑉 是词汇表大小。

向 𝐶(𝑡) 添加 1,称为加一平滑或拉普拉斯平滑,解决了语料库中不存在的token的零概率问题。如果我们使用实际频率 Pr(𝑡) = 𝐶(𝑡)/𝑊,任何在语料库中找不到的token都将具有零概率,当模型遇到有效但未见过的token时会产生问题。拉普拉斯平滑通过给每个token计数添加 1 来解决这个问题,确保所有token,包括未见过的token,都获得一个小的非零概率。分母通过添加 𝑉 来调整,以考虑分子中引入的额外计数。

现在,让我们在 CountLanguageModel 类中实现一个带有回退的语言模型(我们将在下一节中实现拉普拉斯平滑):

class CountLanguageModel:

def __init__(self, n): ➊ self.n = n self.ngram_counts = [{} for _ in range(n)] ➋ self.total_unigrams = 0

def predict_next_token(self, context): ➌ for n in range(self.n, 1, -1): ➍ if len(context) >= n -1: ➎ context_n = tuple(context[-(n -1):]) ➏ counts = self.ngram_counts[n -1].get(context_n) if counts: return max(counts.items(), key=lambda x: x[1])[0]

unigram_counts **=** self.ngram_counts\[0\].get(())

**if** unigram_counts:

**return** max(unigram_counts.items(), key**=lambda** x: x\[1\])\[0\]

**return** None在第 ➊ 行,模型用 n 参数初始化,定义最大 n-gram 阶数(例如,n=3 表示三元组)。第 ➋ 行的 ngram_counts 列表存储一元组、二元组、三元组等的 n-gram 频率字典,在训练期间填充。对于 n=3,给定语料库 “Language models are powerful. Language models are useful.” 转换为小写并移除标点符号,self.ngram_counts 将包含:

ngram_counts[0] = {(): {"language": 2, "models": 2, "are": 2, "powerful": 1, "useful": 1}}

ngram_counts[1] = {("language",): {"models": 2}, ("models",): {"are": 2}, ("are",): {"powerful": 1, "useful": 1}, ("powerful",): {"language": 1}}

ngram_counts[2] = {("language", "models"): {"are": 2}, ("models", "are"): {"powerful": 1, "useful": 1}, ("are", "powerful"): {"language": 1}, ("powerful", "language"): {"models": 1}}

predict_next_token 方法使用回退来预测下一个token。从第 ➍ 行的最高 n-gram 阶数开始,它检查上下文是否包含足够的token用于此 n-gram 阶数(第 ➎ 行)。如果是,它在第 ➏ 行提取上下文并尝试在 ngram_counts 中找到匹配。如果没有找到匹配,它回退到低阶 n-gram 或默认使用一元组计数。例如,给定 context=["language", "models", "are"] 和 n=3:

• 第一次迭代:context_n = ("models", "are") • 第二次迭代(如果需要):context_n = ("are",) • 最后手段:使用空元组键 () 的一元组计数

如果找到匹配的上下文,该方法返回该上下文计数最高的token。对于输入 ["language", "models"],它将返回 "are",这是 ngram_counts[2] 中键 ("language", "models") 的值中计数最高的token。然而,对于输入 ["english", "language"],它不会在 ngram_counts[2] 中找到键 ("english", "language"),因此它将回退到 ngram_counts[1] 并返回 "models",这是键 ("language",) 的值中计数最高的token。

现在,让我们定义训练模型的方法:

def train(model, tokens): model.total_unigrams = len(tokens) for n in range(1, model.n + 1): ➊ counts = model.ngram_counts[n -1] for i in range(len(tokens) - n + 1): context = tuple(tokens[i:i + n -1]) ➋ next_token = tokens[i + n -1] ➌

if context not in counts:

counts[context] = defaultdict(int)

counts[context][next_token] = counts[context][next_token] + 1

train方法接受一个模型(CountLanguageModel的实例)和一个token列表(训练语料库)作为输入。它使用这些token更新模型中的n-gram计数。

在第➊行中,该方法迭代n-gram阶数从1到model.n(包含)。对于每个n,它从token序列生成该阶数的n-gram并计算它们的出现次数。

第➋行和第➌行提取上下文及其后续token,构建一个嵌套字典,其中每个上下文映射到后续token及其计数的字典。这些计数存储在model.ngram_counts中,predict_next_token方法稍后使用它来基于上下文进行预测。

现在,让我们训练模型:

set_seed(42)

n = set_hyperparameters()

data_url = “https://www.thelmbook.com/data/brown” train_corpus, test_corpus = download_and_prepare_data(data_url)

model = CountLanguageModel(n) train(model, train_corpus)

perplexity = compute_perplexity(model, test_corpus) print(f”\nPerplexity on test corpus: [{]perplexity[:.2f}]“)

contexts = [ “i will build a”, “the best place to”, “she was riding a”]

for context in contexts: words = tokenize(context) next_word = model.predict_next_token(words) print(f”\nContext: [{]context[}]“) print(f”Next token: [{]next_word[}]“)

该模型的完整实现,包括检索和处理训练数据的方法,可在thelmbook.com/nb/2.2笔记本中找到。在download_and_prepare_data方法中,语料库被下载、转换为小写、分词为单词,并以90/10的比例分为训练和测试分区。让我们花一点时间理解为什么最后一步是关键的。

在机器学习中,使用整个数据集进行训练无法评估模型是否泛化良好。一个常见问题是过拟合,即模型在训练数据上表现出色,但在未见过的新数据上难以做出准确预测。

将数据集分为训练集和测试集是控制过拟合的标准做法。它包括两个步骤:(1) 打乱数据和 (2) 将其分为两个子集。较大的子集称为训练数据,用于训练模型,而较小的子集称为测试数据,用于评估模型在未见示例上的性能。

测试集需要足够的大小来可靠地估计模型性能。测试比例为0.1到0.3(整个数据集的10%到30%)是常见的,尽管这因数据集大小而异。对于非常大的数据集,即使较小的测试集比例也会产生足够的示例来提供可靠的性能估计。

训练数据来自Brown Corpus,这是一个包含1961年出版的美国英语文本中超过100万个单词的集合。该语料库在语言学研究中经常使用。

当您运行代码时,您将看到以下输出:

Perplexity on test corpus: 299.06

Context: i will build a Next word: wall

Context: the best place to Next word: live

Context: she was riding a Next word: horse

暂时忽略perplexity数字;我们稍后会讨论它。基于计数的语言模型可以产生合理的即时续写,使它们适用于自动完成系统。然而,它们有显著的局限性。这些模型通常使用单词分词的语料库,因为它们的n-gram大小通常很小(最多𝑛 = 5)。超出这个范围需要太多内存并导致处理速度变慢。子词分词虽然更高效,但会产生许多仅代表单词片段的n-gram,降低下一个单词预测的质量。

单词级分词产生另一个重大缺陷:基于计数的模型无法处理词汇表外(out-of-vocabulary, OOV)单词。这类似于第2.1节讨论的词袋方法中看到的问题。例如,考虑上下文:“according to WHO, COVID-19 is a”。如果”COVID-19”不在训练数据中,模型会反复回退,直到它只依赖于”is a”,严重限制了有意义预测的上下文。

基于计数的模型也无法捕获语言中的长距离依赖关系。虽然现代Transformer模型可以处理数千个token,但使用1000个token的上下文训练基于计数的模型需要存储从𝑛 = 1到𝑛 = 1000的所有n-gram的计数,需要令人望而却步的内存量。

此外,这些模型在训练后无法适应下游任务,因为它们的n-gram计数是固定的,任何调整都需要在新数据上重新训练。

这些局限性导致了高级方法的发展,特别是基于神经网络的语言模型,它们在现代自然语言处理中基本上取代了基于计数的模型。像循环神经网络和Transformer这样的方法,我们将在接下来的两章中讨论,能够有效处理更长的上下文,产生连贯且上下文感知的文本。在探索这些方法之前,让我们看看如何评估语言模型的质量。

评估语言模型可以衡量它们的性能并允许比较模型。通常使用几种指标和技术。让我们看看主要的几种。

Perplexity是评估语言模型的广泛使用指标。它衡量模型预测文本的能力。较低的perplexity值表示更好的模型——对其预测更有信心的模型。Perplexity定义为测试集中每个token的平均负对数似然的指数:

Perplexity(𝒟, 𝑘) = exp − U log PrC𝑡 |𝑡 , … , 𝑡 D¡ [$] [IJK(",$6:)] [$6"] (2.5) 𝐷 [$%"] 1 [3]

这里,𝒟 表示测试集,𝐷 是其中token的总数,𝑡 是第[$] 𝑖 个token,PrC𝑡 |𝑡 , … , 𝑡 D 是模型在给定大小为𝑘的前置上下文窗口的情况下分配给[$] [IJK(",$6:)] [$6"] 𝑡 的概率,其中max(1, 𝑖 − 𝑘)确保[$]当没有足够的前置token来填充上下文窗口时,我们从第一个token开始。

符号[,] exp(𝑥) 和 𝑒(其中𝑒是欧拉数)是等价的。

公式2.5中的负对数似然(NLL)是我们语言模型分配的概率的负对数。当模型处理诸如”language models are”这样的文本并为下一个词”cool”分配0.77的概率时,NLL将是−log(0.77)。之所以称为”负”对数似然,是因为我们取对数的负值,而”似然”指的是模型计算的这些条件概率。在语言建模中,NLL有两个目的:它在训练过程中充当损失函数,帮助模型学习更好的概率分布(我们将在下一章训练循环神经网络语言模型时看到),以及如困惑度公式所示,它帮助我们评估模型预测文本的能力。

困惑度可以通过其几何平均公式更直观地理解。一组数字的几何平均是其乘积的𝐷次方根(其中𝐷是值的数量),困惑度是逆概率的几何平均:

["]

[3] [3] 1

Perplexity (𝒟, 𝑘) = ¢£ ¤

[$%"] PrC𝑡 |𝑡 , … , 𝑡 D [$] [IJK(",$6:)] [$6"]

这种形式表明困惑度代表了模型在预测每个token时”困惑”的加权平均因子。困惑度为10意味着平均而言,模型的不确定性相当于在每一步都必须在10种可能性中均匀选择。

如果语言模型对大小为𝑉的词汇表中的每个token分配相等的概率,其困惑度等于𝑉。这为困惑度提供了一个直观的上界——模型不能比为所有可能token分配相等似然时更加不确定。

虽然上面显示的困惑度的两种表述在数学上是等价的(证明可在本书的wiki上找到),但指数形式在计算上更方便,因为它通过对数将乘积转换为求和,使计算在数值上更稳定。

让我们使用词级tokenization的示例文本来计算困惑度,忽略标点符号:“We are evaluating a language model for English.” 为了简化,我们假设最多三个词的上下文。我们首先根据模型提供的三个词的前置上下文确定每个词的概率。以下是概率:

Pr(We ) = 0.10

Pr(are ∣ We) = 0.20

Pr(evaluating ∣ We, are) = 0.05

Pr(a ∣ We, are, evaluating) = 0.50

Pr(language ∣ are, evaluating, a) = 0.30

Pr(model ∣ evaluating, a, language) = 0.40

Pr (for ∣ a, language, model) = 0.15

Pr(English ∣ language, model, for) = 0.25

使用这些概率,我们计算每个词的负对数似然:

−logC𝑃( We)D = −log(0.10) ≈ 2.30

−logC𝑃( are ∣ We)D = −log(0.20) ≈ 1.61

−logC𝑃( evaluating ∣ We, are)D = −log(0.05) ≈ 3.00

−logC𝑃(a ∣ We, are, evaluating)D = −log(0.50) ≈ 0.69

−logC𝑃( language ∣ are, evaluating, a )D = −log(0.30) ≈ 1.20

−logC𝑃( model ∣ evaluating, a, language )D = −log(0.40) ≈ 0.92

−logC𝑃( for ∣ a, language, model)D = −log(0.15) ≈ 1.90

−logC𝑃(English ∣ language, model, for )D = −log(0.25) ≈ 1.39

接下来,我们将这些值相加,然后除以词数(8)来得到平均值:

(2.30 + 1.61 + 3.00 + 0.69 + 1.20 + 0.92 + 1.90 + 1.39)/8 ≈ 1.63

最后,我们对平均负对数似然取指数来获得困惑度:

𝑒 [".L&] ≈ 5.10

因此,该模型在这段文本上使用3词上下文的困惑度约为5.10。这意味着平均而言,模型的行为就像它为每个预测从大约5个等可能的选项中选择一样。

现在,让我们计算上一节中基于计数的模型的困惑度。为此,必须更新模型以返回给定特定上下文的token概率。将此函数添加到我们之前实现的CountLanguageModel中:

def get_probability(self, token, context):

for n in range(self.n, 1, -1): ➊

if len(context) >= n -1:

context_n = tuple(context[-(n -1):])

counts = self.ngram_counts[n -1].get(context_n)

if counts: ➋

total = sum(counts.values()) ➌

count = counts.get(token, 0)

if count > 0:

return count / total ➍

unigram_counts = self.ngram_counts[0].get(()) ➎

86 count = unigram_counts.get(token, 0)

V = len(unigram_counts)

return (count + 1) / (self.total_unigrams + V) ➏

get_probability函数类似于predict_next_token。两者都反向循环遍历n-gram阶数(第➊行)并提取相关上下文(context_n)。如果context_n在n-gram计数中匹配(第➋行),函数检索token计数。如果不存在匹配,它回退到较低阶的n-gram,最终到unigram(第➎行)。

与直接返回最可能token的predict_next_token不同,get_probability计算token的概率。在第➌行中,total是跟随上下文的token计数之和,充当分母。第➍行将token计数除以total来计算其概率。如果不存在更高阶匹配,第➏行使用加一平滑与unigram计数。

compute_perplexity方法计算语言模型对token序列的困惑度。它接受三个参数:模型、token序列和上下文大小:

def compute_perplexity(model, tokens, context_size):

if not tokens:

return float('inf')

total_log_likelihood = 0

num_tokens = len(tokens)

for i in range(num_tokens): ➊ context_start = max(0, i - context_size) context = tuple(tokens[context_start:i]) ➋ word = tokens[i]

probability = model.get_probability(word, context)

total_log_likelihood += math.log(probability) ➌

average_log_likelihood = total_log_likelihood / num_tokens ➍

perplexity = math.exp(-average_log_likelihood) ➎

return perplexity

在第➊行,函数遍历序列中的每个token。对于每个token:

• 第➋行提取其上下文,使用它之前最多context_size个token。

表达式max(0, i - context_size)确保索引保持在边界内,就像公式2.5中一样。

• 在第➌行,将token概率的对数添加到累积对数似然中。模型的get_probability方法处理概率计算。

处理完所有token后,第➍行通过将总对数似然除以token数量来计算平均对数似然。

最后,在第➎行,计算困惑度作为负平均对数似然的指数,如公式2.5中所述。

通过将此方法应用于thelm-book.com/nb/2.2笔记本中的test_corpus序列,我们观察到以下输出:

测试语料库的困惑度:299.06

这个困惑度非常高。例如,GPT-2的困惑度约为20,而现代LLM的值低于5。稍后,我们将计算基于RNN和Transformer的模型的困惑度,并将它们与这个基于计数的模型的困惑度进行比较。

困惑度是评估在大型无标签数据集上训练的语言模型的标准指标,通过测量它们在上下文中预测下一个token的能力。这些模型被称为预训练模型或基础模型。正如我们将在大型语言模型章节中讨论的,它们执行特定任务或回答问题的能力来自监督微调。这种额外的训练使用标记数据集,其中输入上下文与目标输出匹配,如答案或特定任务的结果。这使得问题解决能力成为可能。

困惑度不是评估微调模型的理想指标。相反,需要将模型输出与参考文本(通常称为真实情况)进行比较的指标。一个常见的选择是ROUGE(面向召回的要点评估研究)。ROUGE广泛用于摘要和机器翻译等任务。它通过测量生成文本和参考文本之间的重叠(如token或n-gram)来评估文本质量。ROUGE有几个变体,每个都关注文本相似性的不同方面。在这里,我们将讨论三个广泛使用的:ROUGE-1、ROUGE-N和ROUGE-L。

ROUGE-N评估生成文本和参考文本之间n-gram的重叠,N表示n-gram的长度。最常用的版本之一是ROUGE-1。

ROUGE-1测量生成文本和参考文本之间unigram(单个token)的重叠。作为面向召回的指标(因此ROUGE中的”R”),它评估在生成输出中捕获了多少参考文本。

召回率是匹配token与参考文本中token总数的比率:

[def] 匹配token数量召回率 = 参考文本中token总数

正式地,ROUGE-1定义为:

ROUGE-1 [def] ∑ ∑ count [(.,M)∈𝒟] (𝑡, 𝑔) [E∈M] = ∑ length (𝑟) [(.,M)∈𝒟]

这里,𝒟是(生成文本,参考文本)对的数据集,count (𝑡, 𝑔)计算参考文本𝑟中的token𝑡在生成文本𝑔中出现的频率,分母是所有参考文本中的总token数。

为了理解这个计算,考虑一个简单的例子:

参考文本 生成文本大型语言模型对文本处理非常重要。 大型语言模型在处理文本方面很有用。

让我们使用词级分词并计算:

• 匹配词:大型、语言、模型、处理、文本(5个词)

• 参考文本中的总词数:9

• ROUGE-1:≈ 0.56

ROUGE-1分数0.56意味着参考文本中大约一半以上的词出现在生成文本中。然而,仅这个数字价值不大。ROUGE分数只有在比较不同语言模型在同一测试集上的表现时才有用,因为它们指示哪个模型更有效地捕获参考文本的内容。

ROUGE-N将ROUGE指标从unigram扩展到n-gram,同时使用相同的公式。

ROUGE-L依赖于最长公共子序列(LCS)。这是在生成文本和参考文本中都以相同顺序出现的最长token序列,无需相邻。

设𝑔和𝑟为长度分别为𝐿_g和𝐿_r的生成文本和参考文本。那么:

召回率 = LCS(𝑔, 𝑟)/𝐿_r [def],精确率 = LCS(𝑔, 𝑟)/𝐿_g [def]

这里,LCS(𝑔, 𝑟)表示生成文本𝑔和参考文本𝑟之间LCS中的token数。召回率测量LCS捕获的参考文本比例,而精确率测量生成文本中与参考文本匹配的比例。召回率和精确率被组合成单一指标如下:

ROUGE-L [def] = (1 + 𝛽²) × 召回率_LCS × 精确率_LCS / (召回率_LCS + 𝛽² × 精确率_LCS)

这里,𝛽控制ROUGE-L分数中精确率和召回率之间的权衡。由于ROUGE偏向召回率,𝛽通常设置得很高,如8。

让我们重新审视用于说明ROUGE-L的两个文本。对于这些句子,有两个有效的最长公共子序列,每个长度为5个词:

LCS 1 LCS 2 大型、语言、模型、文本 大型、语言、模型、处理

两个子序列都是在两个句子中以相同顺序出现的最长词汇序列,但不一定是连续的。当存在多个LCS选项时,ROUGE-L可以使用其中任何一个,因为它们的长度相同。

计算过程如下。LCS的长度是5个词。参考文本长度为9个词,生成文本长度为8个词。因此,召回率和精确率为:

召回率 = ≈ 0.56,精确率 = ≈ 0.63 [LCS] [LCS] 5 5

9 8

当𝛽 = 8时,ROUGE-L为:

ROUGE-L = ≈ 0.56 [!] 0.56 + 8 (1 + 8[!]) ⋅ 0.56 ⋅ 0.63 ⋅ 0.63

ROUGE分数范围从0到1,其中1表示生成文本与参考文本完全匹配。然而,即使是优秀的摘要或翻译在实践中也很少接近1。

选择合适的ROUGE指标取决于任务:

• ROUGE-1和ROUGE-2是标准的起始点。ROUGE-1使用unigram重叠检查整体内容相似性,而ROUGE-2使用bigram匹配评估局部流畅性和短语准确性。

• 在评估句子结构和流畅性方面的文本质量时,ROUGE-L比ROUGE-1或ROUGE-2更受青睐,特别是在摘要和翻译任务中,因为它捕获以相同相对顺序出现的最长匹配词序列,更好地反映语法连贯性。

• 在保持较长模式至关重要的情况下——如维护技术术语或习语——更高阶的指标如ROUGE-3或ROUGE-4可能更相关。

多种指标的组合,如ROUGE-1、ROUGE-2和ROUGE-L,通常能提供更平衡的评估,涵盖内容重叠和结构灵活性。

但请记住,ROUGE有局限性。它衡量词汇重叠但不衡量语义相似性或事实正确性。为了解决这些不足,ROUGE通常与人工评估或其他方法配合使用,以更全面地评估文本质量。

自动化指标很有用,但人工评估仍然是评估语言模型的必要手段。人类可以评估自动化指标经常忽略的品质,如流畅性和准确性。人工评估的两种常见方法是Likert量表评分和Elo评分。

Likert量表评分涉及使用固定的、通常对称的量表为输出分配分数。评估者通过选择分数来判断质量,通常从-2到2,每个量表点对应一个描述性标签。例如,-2可能表示”强烈不同意”或”差”,而2可能表示”强烈同意”或”优秀”。量表是对称的,因为它在中性中点附近包含相等水平的同意和不同意,使正面和负面回应更容易解释。

Likert量表在评估语言模型输出的不同方面具有灵活性,如流畅性、连贯性、相关性和准确性。例如,评估者可以分别对句子的语法正确性和与提示的相关性进行评分,都使用-2到2的量表。

但是,该方法有局限性。一个问题是中心倾向偏差(central tendency bias),即一些评估者避免极端分数而坚持量表中间值。另一个挑战是评估者对量表解释的不一致性——一些人可能为异常输出保留2分,而其他人可能将其分配给任何高质量回应。

为了缓解这些问题,研究人员通常涉及多个评估者,为同一评估者以不同方式表述类似问题,并使用清楚定义每个量表点的详细标准。

让我们使用一个场景来说明Likert量表评估,其中对机器生成的新闻文章摘要进行评估。

人工评估者将模型生成的摘要与原始文章进行比较。他们使用5点Likert量表在三个方面进行评分:连贯性、信息性和事实准确性。

例如,考虑左侧的新闻文章和右侧的生成摘要:

评估者根据摘要如何有效满足这三个标准来评估摘要。

评估连贯性——即摘要的组织程度、可读性和逻辑连接程度——的量表可能如下所示:

非常差 差 可接受 好 优秀

-2 -1 0 1 2

评估信息性的量表,即摘要如何捕获原始文章的本质和要点,可能如下所示:

不具信息性 略具信息性 中等信息性 很具信息性 极具信息性

-2 -1 0 1 2

评估事实准确性——即摘要如何精确地表示来自原始文章的事实和数据——的量表可能如下所示:

一些不准确

非常低 之处 大部分准确 准确 非常准确 完美

-2 -1 0 1 2

在这个例子中,评估者会为三个方面各选择一个选项。在量表每个点使用描述性锚点有助于在评估者之间标准化理解。

在从多个评估者收集各种摘要的评分后,研究人员通过几种方法分析数据:

• 计算所有摘要和评估者在每个方面的平均分数,以获得整体性能指标。

• 比较模型不同版本的分数以跟踪改进。

• 分析不同方面之间的相关性(例如,高连贯性是否与高事实准确性相关?)。

虽然Likert量表评分最初是为人类设计的,但先进的聊天语言模型(chat LMs)的兴起意味着评估者现在可以是人类或语言模型。

成对比较(Pairwise comparison)是一种方法,其中两个输出并排评估,根据特定标准选择更好的一个。这简化了决策制定,特别是当输出质量相似或变化很小时。

该方法建立在相对判断比绝对判断更容易的原则之上。二元选择通常比绝对评分产生更一致和可靠的结果。

在实践中,评估者比较成对的输出,例如翻译、摘要或答案,并根据连贯性、信息性或事实准确性等标准决定哪个更好。

例如,在机器翻译评估中,评估者比较每个源句子的成对翻译,选择哪一个更好地保留了目标语言中的原始含义。通过在许多配对中重复此过程,评估者可以比较不同的模型或版本。

成对比较通过让每个评估者评估多个配对来帮助对模型或模型版本进行排名,每个模型与其他模型进行多次比较。这种重复最小化了个人偏见,产生了更可靠的评估。一个相关的方法是排名,评估者按质量对多个响应进行排序。排名比成对比较需要更少的努力,同时仍然捕获相对质量。

成对比较的结果通常进行统计分析以确定模型之间的显著差异。这种分析的常用方法是Elo评级系统。

Elo评级,最初由Arpad Elo在1960年为国际象棋选手排名而创建,可以适用于语言模型评估。该系统基于直接比较中的”胜利”和”失败”分配评级,量化相对模型性能。

在语言模型评估中,所有模型通常从初始评级开始,通常设置为1500。当比较两个模型时,使用它们当前的评级计算一个模型”获胜”的概率。每次比较后,根据实际结果与预期结果更新它们的评级。

具有评级Elo(A)的模型A战胜具有评级Elo(B)的模型B的概率是:

Pr(A wins) = 1 / (1 + 101)

Elo公式中的值400充当缩放因子,在评级差异和获胜概率之间创建对数关系。Arpad Elo选择这个数字确保400分的评级差异反映了有利于更高评级国际象棋选手的10:1赔率。虽然最初为国际象棋设计,但这个缩放因子在其他环境中已被证明有效,包括语言模型评估。

比赛后,使用以下公式更新评级:

Elo(A) ← Elo(A) + k × [score(A) - Pr(A wins)],

其中k(通常在4到32之间)控制最大评级变化,score(A)反映结果:胜利为1,失败为0,平局为0.5。

考虑一个包含三个模型的例子:LM_A、LM_B和LM_C。我们将根据它们生成连贯文本续写的能力来评估它们。假设它们的初始评级是:

Elo(LM_A) = 1500 Elo(LM_B) = 1500

Elo(LM_C) = 1500

我们将在此例中使用k = 32。

考虑这个提示:“科学家们震惊地发现…”

LM_A的续写:“…亚马逊雨林中一个新的蝴蝶物种。它的翅膀与他们以前见过的任何东西都不同。”

LM_B的续写:“…他们出土的古代文物正在发出微弱的脉动光。他们无法解释其来源。”

LM_C的续写:“…他们实验的结果与他们认为对量子力学的所有了解相矛盾。”

假设我们进行成对比较并得到以下结果:

这些比较后的最终评级:

Elo(LM_A) = 1499 Elo(LM_B) = 1470 Elo(LM_C) = 1531

Elo评级量化了模型相对于彼此的表现。在这种情况下,LM_C最强,其次是LM_A,LM_B排名最后。

性能不是从单一比赛判断的。相反,使用多个成对比赛。这限制了个别比较中随机波动或偏见的影响,给出了每个模型性能的更好估计。

各种提示或输入确保在不同背景和任务中进行评估。当涉及人类评估者时,几个评估者评估每个比较以减少个人偏见。

为了避免顺序效应,比较的顺序和输出的呈现都是随机的。Elo评级在每次比较后更新。

需要多少场比赛才能使结果可靠?没有适用于所有情况的通用数字。作为一般指导原则,一些研究人员建议每个模型应该参与至少100-200次比较,才能认为Elo评级稳定,理想情况下需要500+次比较才能获得高置信度。然而,对于高风险评估或比较非常相似的模型时,可能需要数千次比较。

统计方法可以用来计算模型Elo评级的置信区间。解释这些技术超出了本书的范围。对于感兴趣的读者,Bradley-Terry模型和bootstrap重采样是很好的起点。两者都有很好的文档记录,相关资源链接在本书的wiki上。

Elo评分提供了一个连续的尺度来对模型进行排名,使得跟踪增量改进变得更加容易。该系统对战胜强对手的奖励比战胜弱对手的奖励更多,并且它可以处理不完整的比较数据,这意味着不是每个模型都需要与其他每个模型进行比较。然而,𝑘值的选择显著影响评分的波动性;选择不当的𝑘值可能会损害评估的稳定性。

为了解决这些限制,Elo评分经常与其他评估方法一起使用。例如,研究人员可能使用Elo评分在成对比较中对模型进行排名,同时收集Likert量表评分来评估绝对质量。这种组合方法可以更全面地了解语言模型的性能。

现在我们已经介绍了语言建模和评估方法,让我们探索一个更高级的模型架构:循环神经网络(RNN)。RNN在处理文本方面取得了重大进展。它们引入了在长序列上维持上下文的能力,使得创建更强大的语言模型成为可能。

在本章中,我们探索循环神经网络,这是一个革命性改变了序列数据处理的基础架构。虽然Transformer已经在许多应用中占据主导地位,但首先理解RNN提供了一个理想的跳板——它们优雅的设计引入了关键的序列处理概念,使得Transformer数学更加直观。我们将研究RNN的结构和在语言建模中的应用,为更高级的架构建立基本基础。

循环神经网络或RNN,是一种为序列数据设计的神经网络。与前馈神经网络不同,RNN在其连接中包含循环,使信息能够从序列中的一个步骤传递到下一个步骤。这使得它们非常适合时间序列分析、自然语言处理和其他序列数据问题等任务。

为了说明RNN的序列性质,让我们考虑一个具有单个单元的神经网络。考虑输入文档“Learning from text is cool.” 忽略大小写和标点符号,表示该文档的矩阵如下:

单词 嵌入向量 learning [0.1,0.2,0.6] from [0.2,0.1,0.4] text [0.1,0.3,0.3] is [0.0,0.7,0.1] cool [0.5,0.2,0.7] PAD [0.0,0.0,0.0]

矩阵的每一行代表在神经网络训练期间学习到的单词嵌入。单词的顺序得到保留。矩阵维度为(序列长度,嵌入维度)。序列长度指定文档中单词的最大数量。较短的文档用填充标记(如本例中的PAD)填充,而较长的文档则被截断。填充使用虚拟嵌入,通常是零向量。

更正式地,矩阵看起来像这样:

⎡ ⎤ 0.2 0.1 0.4 0.1 0.2 0.6

𝐗 = ⎥ 0.0 0.7 0.1 ⎢ ⎢0.1 0.3 0.3 ⎢ ⎥ ⎥

⎢0.5 0.2 0.7⎥ ⎣0.0 0.0 0.0⎦

在这里,我们有五个3D嵌入向量,𝐱₁, … , 𝐱₅,代表文档中的每个单词。例如,𝐱₁ = [0.1,0.2,0.6],𝐱₂ = [0.2,0.1,0.4],依此类推。第六个向量是填充向量。

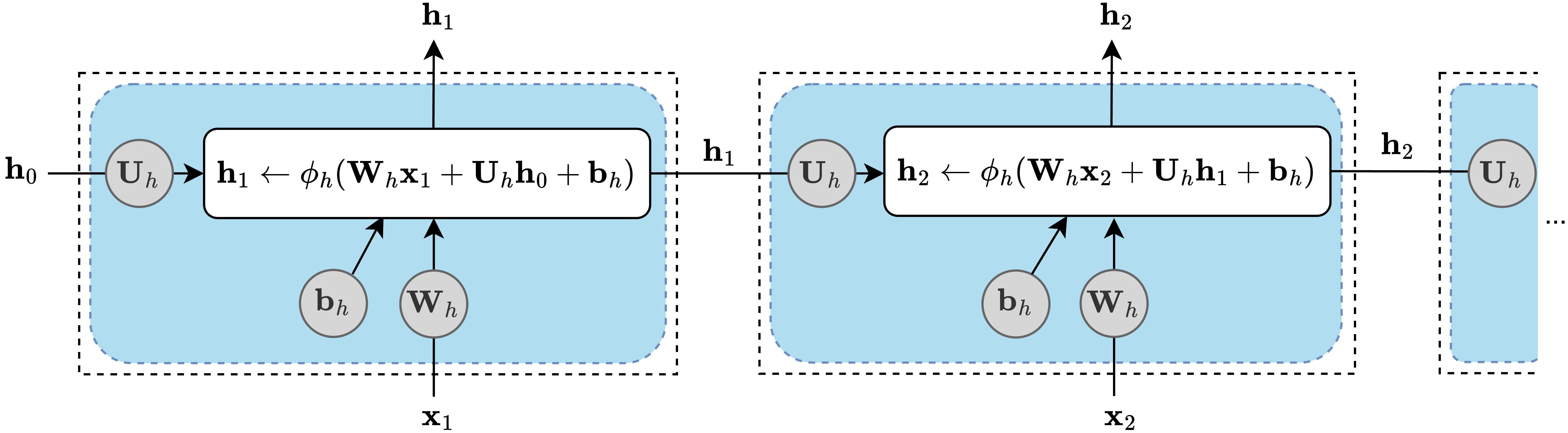

Elman RNN,由Jeffrey Locke Elman在1990年作为简单循环神经网络引入,逐个处理嵌入向量序列,如下所示:

在每个时间步𝑡,当前输入嵌入𝐱ₜ和先前的隐藏状态𝐡ₜ₋₁通过将它们与可训练的权重矩阵𝐖ᵢₕ和𝐔ₕₕ相乘,加上偏置向量𝐛ₕ,并产生更新的隐藏状态𝐡ₜ来结合。与输出标量的MLP单元不同,RNN单元输出向量并充当整个层。初始隐藏状态𝐡₀通常是零向量。隐藏状态是一个记忆向量,它捕获序列中先前步骤的信息。在每个步骤使用当前输入和过去状态进行更新,它帮助神经网络使用早期单词的上下文来预测句子中的下一个单词。

为了加深网络,我们添加第二个RNN层。第一层的输出𝐡ₜ成为第二层的输入,第二层的输出是网络的最终输出:

图3.1:两层Elman RNN。第一层的输出作为第二层的输入。

在编码RNN模型之前,我们需要讨论输入数据的形状。在第1.7节中,我们对每个梯度下降步骤使用整个数据集。在这里,以及对于训练所有未来的模型,我们将采用小批量梯度下降,这是大型模型和数据集的广泛使用方法。小批量梯度下降计算较小数据子集上的导数,这加快了学习速度并减少了内存使用。

使用小批量梯度下降,数据形状组织为(批次大小,序列长度,嵌入维度)。这种结构将训练集分成固定大小的小批量,每个小批量包含具有一致长度的嵌入序列。(从这一点开始,“批次”和”小批量”将可互换使用。)

例如,如果批次大小为2,序列长度为4,嵌入维度为3,小批量可以表示为:

batch = [seq₁,₁ seq₁,₂ seq₁,₃ seq₁,₄] [seq₂,₁ seq₂,₂ seq₂,₃ seq₂,₄]

这里,seqᵢ,ⱼ,对于𝑖 ∈ {1,2}和𝑗 ∈ {1, … ,4}是一个嵌入向量。

让我们为每个序列设置以下嵌入:

seq₁: [0.1,0.2,0.3] [0.4,0.5,0.6] [0.7,0.8,0.9] [1.0,1.1,1.2]

seq₂: [1.3,1.4,1.5] [1.6,1.7,1.8] [1.9,2.0,2.1] [2.2,2.3,2.4]

小批量将如下所示:

batch [0.1,0.2,0.3] [0.4,0.5,0.6] [0.7,0.8,0.9] [1.0,1.1,1.2] = RS [”] [1.3,1.4,1.5] [1.6,1.7,1.8] [1.9,2.0,2.1] [2.2,2.3,2.4]

在梯度下降的每一步中,我们:

Mini-batch梯度下降相比每步使用整个训练集通常能实现更快的收敛。它通过利用现代硬件的并行处理能力,高效地处理大型模型和数据集。在PyTorch中,模型要求输入数据的第一个维度是batch维度,即使batch中只有一个样本。

让我们实现一个Elman RNN单元:

import torch

import torch.nn as nn

class ElmanRNNUnit(nn.Module):

def __init__(self, emb_dim): super().__init__()

self.Uh = nn.Parameter(torch.randn(emb_dim, emb_dim)) ➊

self.Wh = nn.Parameter(torch.randn(emb_dim, emb_dim)) ➋

self.b = nn.Parameter(torch.zeros(emb_dim)) ➌

def forward(self, x, h):

return torch.tanh(x @** self.Wh +** h @** self.Uh +** self.b)

➍

在构造函数中:

• 第➊行和第➋行使用随机值初始化self.Uh和self.Wh,这是隐藏状态和输入向量的权重矩阵。

• 第➌行将偏置向量self.b设置为零。

在forward方法中,第➍行处理每个时间步的计算。它处理当前输入x和前一个隐藏状态h,两者的形状都是(batch_size, emb_dim),将它们与权重矩阵和偏置结合,并应用tanh激活函数。输出是新的隐藏状态,形状也是(batch_size, emb_dim)。

@符号是PyTorch中的矩阵乘法运算符。我们使用x @ self.Wh而不是self.Wh @ x,这是因为PyTorch在矩阵乘法中处理batch维度的方式。当处理批量输入时,x的形状是(batch_size, emb_dim),而self.Wh的形状是(emb_dim, emb_dim)。记住从第1.6节中学到的,两个矩阵要能相乘,左矩阵的列数必须等于右矩阵的行数。这在x @ self.Wh中得到了满足。

现在,让我们定义ElmanRNN类,它使用ElmanRNNUnit作为核心构建块实现一个两层Elman RNN:

class ElmanRNN(nn.Module):

def __init__(self, emb_dim, num_layers): super().__init__()

self.emb_dim = emb_dim

self.num_layers = num_layers

self.rnn_units = nn.ModuleList(

[ElmanRNNUnit(emb_dim) for _ in range(num_layers) ]

) ➊

def forward(self, x):

batch_size, seq_len, emb_dim = x.shape ➋

h_prev = [

torch.zeros(batch_size, emb_dim, device=x.device) ➌

for _ in range(self.num_layers)

]

outputs = []

for t in range(seq_len): ➍

input_t = x[:, t]

for l, rnn_unit in enumerate(self.rnn_units):

h_new = rnn_unit(input_t, h_prev[l])

h_prev[l] = h_new # 更新隐藏状态

input_t = h_new # 下一层的输入

outputs.append(input_t) # 收集输出

return torch.stack(outputs, dim=1) ➎

在构造函数的第➊行中,我们通过创建一个包含ElmanRNNUnit实例的ModuleList来初始化RNN层——每层一个实例。使用ModuleList而不是常规Python列表确保父模块(ElmanRNN)正确注册所有RNN单元参数。这保证了在父模块上调用.parameters()或.to(device)会包含ModuleList中所有模块的参数。

在forward方法中:

• 第➋行从输入张量x中提取batch_size、seq_len和emb_dim。

• 第➌行用零张量初始化所有层的隐藏状态h_prev。列表中每个隐藏状态的形状是(batch_size, emb_dim)。

我们将每层的隐藏状态存储在列表中而不是多维张量中,因为我们需要在处理过程中修改它们。张量的就地修改可能会破坏PyTorch的自动微分系统,这可能导致错误的梯度计算。

• 第➍行遍历输入序列中的时间步t。对于每个t: o 提取时间t的输入:input_t = x[:, t]。 o 对于每层l: § 从input_t和h_prev[l]计算新的隐藏状态h_new。 § 更新隐藏状态:h_prev[l] = h_new(就地更新)。 § 设置input_t = h_new以传递给下一层。 o 添加最后一层的输出:outputs.append(input_t)。

• 处理完所有时间步后,第➎行通过沿时间维度堆叠将outputs列表转换为张量。结果张量的形状是(batch_size, seq_len, emb_dim)。

基于RNN的语言模型使用ElmanRNN作为其构建块:

class RecurrentLanguageModel(nn.Module):

def __init__(self, vocab_size, emb_dim, num_layers, pad_idx):

super().__init__()

self.embedding = nn.Embedding(

vocab_size,

emb_dim,

padding_idx=pad_idx

) ➊

self.rnn = ElmanRNN(emb_dim, num_layers)

self.fc = nn.Linear(emb_dim, vocab_size)

def forward(self, x):

embeddings = self.embedding(x)

rnn_output = self.rnn(embeddings)

logits = self.fc(rnn_output)

return logits

RecurrentLanguageModel类集成了三个组件:嵌入层、前面定义的ElmanRNN和最终的线性层。

在构造函数中,第➊行定义了嵌入层。该层将输入token索引转换为密集向量。padding_idx参数确保填充token由零向量表示。(我们将在下一节中介绍嵌入层。)

接下来,我们初始化自定义的ElmanRNN,指定embedding维度和层数。最后,我们添加一个全连接层,将RNN的输出转换为序列中每个token的词汇表大小的logits。

在forward方法中:

• 我们将输入x通过embedding层。输入x的形状为

(batch_size, seq_len),输出embeddings的形状为(batch_size, seq_len, emb_dim)。

• 然后我们将嵌入的输入通过ElmanRNN,获得

形状为(batch_size, seq_len, emb_dim)的rnn_output。

• 最后,我们将全连接层应用到RNN输出上,为序列中每个位置的词汇表中的每个token产生logits。输出logits的形状为(batch_size, seq_len, vocab_size)。

embedding层,在PyTorch中实现为nn.Embedding,将词汇表中的token索引映射到密集的固定大小向量。它充当可学习的查找表,其中每个token被分配一个唯一的embedding向量。在训练过程中,这些向量被调整以捕获token有意义的数值表示。

让我们看看embedding层是如何工作的。想象一个有五个token的词汇表,索引从0到4。我们希望每个token都有一个3D embedding向量。首先,我们创建一个embedding层:

import torch

import torch.nn as nn

vocab_size = 5 # 唯一token的数量 emb_dim = 3 # 每个embedding向量的大小 emb_layer = nn.Embedding(vocab_size, emb_dim)

embedding层用随机值初始化embedding矩阵E。在这种情况下,矩阵有5行(每个token一行)和3列(embedding维度):

E = ⎢ 0.8 −0.5⎥ 0.7 0.1 −0.2 ⎢ ⎡ ⎤ −0.3 0.2 −0.4 0.1 ⎥

⎢−0.6 0.5 0.4⎥ ⎣ 0.9 −0.7 0.3⎦

E中的每一行代表词汇表中特定token的embedding向量。

现在,让我们输入一个token索引序列:

token_indices = torch.tensor([0, 2, 4])

embedding层检索E中对应输入索引的行:

0.2 −0.4 0.1

Embeddings = ¸ 0.7 0.1 −0.2¹

0.9 −0.7 0.3

这个输出是一个矩阵,其行数等于输入序列长度,列数等于embedding维度:

embeddings = embedding_layer(token_indices) print(embeddings)

输出可能看起来像这样:

tensor([[ 0.2, -0.4, 0.1],

[ 0.7, 0.1, -0.2],

[ 0.9, -0.7, 0.3]])

embedding层也可以管理padding token。Padding确保mini-batch中的序列具有相同长度。为了防止模型在训练期间更新padding token的embeddings,该层将它们映射到保持不变的零向量。例如,我们可以如下定义padding索引:

emb_layer = nn.Embedding(vocab_size, emb_dim, padding_idx=0)

通过这种配置,token 0(padding token)的embedding始终是[0,0,0][1]。

给定输入:

token_indices = torch.tensor([0, 2, 4]) embeddings = emb_layer(token_indices) print(embeddings)

结果将是:

tensor([[ 0.0, 0.0, 0.0], # Padding token

[ 0.7, 0.1, -0.2], # Token 2 embedding

[ 0.9, -0.7, 0.3]]) # Token 4 embedding

在现代语言模型中,词汇表通常包含数十万个token,embedding维度通常是数千。这使得embedding矩阵成为模型的重要组成部分,有时包含多达20亿个参数。

首先导入库并定义实用函数:

import torch, torch.nn as nn

def set_seed(seed):

random.seed(seed)

torch.manual_seed(seed)

torch.cuda.manual_seed_all(seed) ➊

torch.backends.cudnn.deterministic = True ➊

torch.backends.cudnn.benchmark = False ➌

set_seed函数通过设置Python随机种子、PyTorch CPU种子以及在第➊行设置所有GPU(图形处理单元)的CUDA种子来强制可重现性。CUDA是NVIDIA的并行计算平台和API,通过利用GPU的强大功能在计算中实现显著的性能改进。使用torch.cuda.manual_seed_all确保一致的基于GPU的随机行为,而第➋和➌行禁用CUDA的自动调谐器并强制使用确定性算法,保证在不同GPU模型上得到相同的结果。

模型类准备就绪后,我们将训练神经语言模型。首先,我们安装transformers包——一个开源库,提供API和工具来轻松下载、训练和使用Hugging Face Hub中的预训练模型:

$ pip3 install transformers

该包提供了一个用于训练的Python API,可与PyTorch和TensorFlow一起使用。现在,我们只需要它来获取tokenizer。

现在我们导入transformers,设置tokenizer,定义超参数值,准备数据,并实例化模型、损失函数和优化器对象:

from transformers import AutoTokenizer

device = torch.device("cuda" if torch.cuda.is_available() else "cpu") ➊

tokenizer = AutoTokenizer.from_pretrained(

"microsoft/Phi-3.5-mini-instruct"

) ➋

vocab_size = len(tokenizer) ➌

emb_dim, num_layers, batch_size, learning_rate, num_epochs = get_hyperparameters()

data_url = "https://www.thelmbook.com/data/news" train_loader, test_loader = download_and_prepare_data(

data_url, batch_size, tokenizer) ➍

model = RecurrentLanguageModel(

vocab_size, emb_dim, num_layers, tokenizer.pad_token_id )

initialize_weights(model) ➎ model.to(device)

criterion = nn.CrossEntropyLoss(ignore_index=tokenizer.pad_token_id) ➏

optimizer = torch.optim.AdamW(model.parameters(), lr=learning_rate)

第➊行检测CUDA设备(如果可用)。否则,默认使用CPU。

CUDA不是唯一可用于训练神经网络的GPU加速框架——PyTorch还提供对check的原生支持

ing availability of MPS (Apple Metal) through its is_available()

方法的可用性检查。不过在本书中,我们将使用CUDA,因为它仍然是机器学习加速最广泛使用的平台。

Hugging Face Hub上的大多数模型都包含用于训练它们的tokenizer。第➋行初始化Phi 3.5 mini tokenizer。它使用byte-pair encoding算法在大型文本语料库上进行训练,词汇表大小为32,064。

第➌行获取tokenizer的词汇表大小。第➍行下载并准备数据集——来自在线文章的新闻句子集合——对它们进行标记化并创建DataLoader对象。我们很快会探索DataLoader。现在,将它们视为批次上的迭代器。

第➎行初始化模型参数。初始参数值可以极大地影响训练过程。它们可以影响训练进展的速度和最终损失值。某些初始化技术,如Xavier初始化,在实践中显示出良好的结果。实现此方法的initialize_weights函数在notebook中定义。

第➏行使用ignore_index参数创建损失函数。这确保不会为填充标记计算损失。

现在,让我们看看训练循环:

for epoch in range(num_epochs): ➊

model.train() ➋

for batch in train_loader: ➌ input_seq, target_seq = batch input_seq = input_seq.to(device) ➍ target_seq = target_seq.to(device) ➎ batch_size_current, seq_len = input_seq.shape ➏ optimizer.zero_grad()

output = model(input_seq)

output = output.reshape(batch_size_current * seq_len, vocab_size) ➐

target = target_seq.reshape(batch_size_current * seq_len) ➑

loss = criterion(output, target) ➒

loss.backward()

optimizer.step()

第➊行遍历epochs。epoch是对整个数据集的一次完整遍历。多个epochs的训练可以改善模型,特别是在训练数据有限的情况下。epochs的数量是一个hyperparameter(超参数),你可以根据模型在测试集上的性能来调整。

第➋行在每个epoch开始时调用model.train(),将模型设置为训练模式。这对于具有在训练与evaluation(评估)期间表现不同的层的模型很重要。

虽然我们的RNN模型不使用这样的层,但调用model.train()确保模型正确配置用于训练。这避免了意外行为并保持一致性,特别是如果未来的更改添加了依赖于模式的层。

第➌行遍历批次。每个批次是一个元组:一个张量包含输入序列,另一个包含目标序列。第➍行和第➎行将这些张量移动到与模型相同的设备上。如果模型和数据在不同的设备上,PyTorch会引发错误。

第➏行从input_seq获取批次大小和序列长度(target_seq具有相同的形状)。这些维度需要将模型的输出张量(batch_size_current, seq_len, vocab_size)和目标张量(batch_size_current, seq_len)重塑为与cross-entropy损失函数兼容的形状。在第➐行中,输出被重塑为(batch_size_current * seq_len, vocab_size),在第➑行中,目标被展平为batch_size_current * seq_len,允许第➒行中的损失计算同时处理批次中的所有标记并返回每个标记的平均损失。

这就完成了训练循环的实现。完整的RNN语言模型训练实现在thelmbook.com/nb/3.1 notebook中。现在,让我们检查使这种批处理成为可能的DataLoader和Dataset类。

如前所述,download_and_prepare_data函数返回两个loader对象:train_loader和test_loader。我让你将它们视为数据批次上的迭代器。但它们到底是什么?

这些类被设计用来在训练期间高效地管理数据。虽然本书不专注于数据加载和操作,但简要说明对于清晰度很重要。

Dataset类作为实际数据源的接口。通过实现其__len__方法,你可以获得数据集的大小。通过定义__getitem__,你可以访问单个示例。这些示例可以来自许多”物理”源:文件、数据库,甚至是动态生成的数据。

让我们看一个例子。假设我们有一个名为data.jsonl的JSONL文件,其中每行都是一个包含两个输入特征和一个标签的JSON对象。以下是几行可能的样子:

{"feature1": 1.0, "feature2": 2.0, "label": 3.0} {"feature1": 4.0, "feature2": 5.0, "label": 9.0} [...]

以下是如何创建自定义Dataset来读取此文件:

import json

import torch

from torch.utils.data import Dataset

class JSONDataset(Dataset):

def __init__(self, file_path): self.data = []

with open(file_path, 'r') as f:

for line in f:

item = json.loads(line)

features = [item['feature1'], item['feature2' ]]

label = item['label']

self.data.append((features, label))

def __len__(self):

return len(self.data)

def __getitem__(self, idx): features, label = self.data[idx] features = torch.tensor(features, dtype=torch.float32

)

label = torch.tensor(label, dtype=torch.long)

return features, label

在这个例子中:

• __init__读取文件并将数据存储在内存中,

• __len__返回示例的总数,

• __getitem__检索单个示例并将其转换为张量。

我们可以这样访问单个示例:

dataset = JSONDataset('data.jsonl') features, label = dataset[0]

DataLoader 与 Dataset 配合使用来管理诸如批处理、洗牌和并行加载数据等任务。例如:

from torch.utils.data import DataLoader

dataset = JSONLDataset('data.jsonl') ➊

data_loader = DataLoader(

dataset,

batch_size=32, # 每批次样本数量

shuffle=True, # 每个epoch洗牌数据

num_workers=0 # 数据加载的子进程数量

) ➋

num_epochs = 5

for epoch in range(num_epochs):

for batch_features, batch_labels in data_loader: ➌

print(f"Batch features shape: {batch_features.shape}")

print(f"Batch labels shape: {batch_labels.shape}")

# 将batch_features和batch_labels输入到你的模型中第➊行创建了一个Dataset实例。第➋行然后将dataset包装在DataLoader中。最后,第➌行对DataLoader进行了五个epoch的迭代。通过设置shuffle=True,数据在每个epoch的批处理前都会被洗牌。这防止了模型学习训练数据的顺序。

通过num_workers=0,数据加载在主进程中进行。这种简单的设置可能不是最高效的,特别是对于大型数据集。为num_workers使用正值会让PyTorch生成相应数量的工作进程,实现并行数据加载。这可以通过防止数据加载成为瓶颈来显著加速训练。

输出:

Batch features shape: torch.Size([32, 2])

Batch labels shape: torch.Size([32])通过使用设计良好的Dataset和DataLoader,你可以扩展训练管道来处理大型数据集,使用并行工作器优化数据加载,并尝试不同的批处理策略。这种方法简化了训练过程,让你可以专注于模型设计和优化。

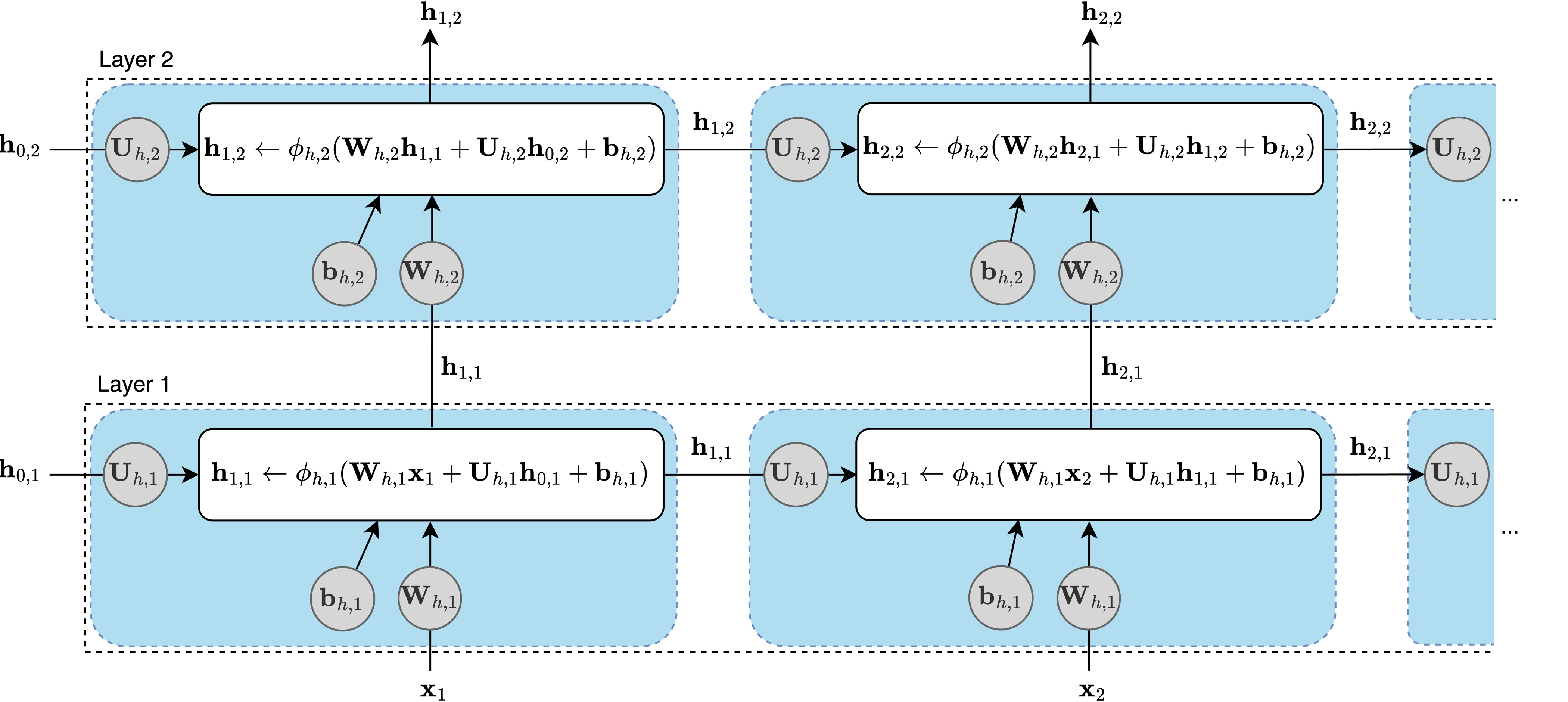

在研究神经语言模型时,理解训练样本的结构是一个关键方面。文本语料库被分割成重叠的输入和目标序列。每个输入序列与一个偏移一个token的目标序列对齐。这种设置训练模型预测序列中每个位置的下一个词。

例如,以句子“We train a recurrent neural network as a language model.”为例。使用Phi 3.5 mini分词器对其进行分词后,我们得到:

["_We", "_train", "_a", "_rec", "urrent", "_neural", "_network", "_as", "_a", "_language", "_model", "."]为了创建一个训练样本,我们通过将token向前偏移一个位置来将句子转换为输入和目标序列:

输入:["_We", "_train", "_a", "_rec", "urrent", "_neural", "_network", "_as", "_a", "_language", "_model"]

目标:["_train", "_a", "_rec", "urrent", "_neural", "_network", "_as", "_a", "_language", "_model", "."]

训练样本不需要是完整的句子。现代语言模型处理长度达到其上下文窗口(context window)长度的序列——它们一次能处理的最大token数(如8192)。窗口限制了模型在文本中连接关系的距离。训练将文本分割成窗口大小的块,每个目标序列比其输入偏移一个token。

在训练过程中,RNN一次处理一个token,逐层更新其隐藏状态。在每一步,它生成旨在预测序列中下一个token的logits。每个logit对应一个词汇表token,并使用softmax转换为概率。然后使用这些概率来计算损失。

每个训练样本产生多个预测和损失。例如,模型首先处理”_We”并通过为所有词汇表token分配概率来尝试预测”_train”。使用”_train”的概率计算损失,如公式2.1中定义的。接下来,模型处理”_train”来预测”_a”,产生另一个损失。这对输入序列中的每个token都会继续。对于上述示例,模型进行11次预测并计算11个损失。

损失在训练样本中的token和批次中的所有样本之间取平均。然后在反向传播中使用平均损失表达式来更新模型的参数。

让我们用一些虚构的数字来分解每个位置的损失计算:

• 位置1: - 目标token:“_train” - “_train”的logit:-0.5 - 对logits应用softmax后,假设”_train”的概率是0.1 - 根据公式2.1对总损失的贡献是-log(0.1) = 2.30

• 位置2: - 目标token:“_a” - “_a”的logit:3.2 - softmax后,“_a”的概率:0.05 - 损失贡献:-log(0.05) = 2.99

• 位置3: - “_rec”的概率:0.02 - 损失贡献:-log(0.02) = 3.91

• 位置4: - “urrent”的概率:0.34 - 损失贡献:-log(0.34) = 1.08

我们继续直到计算最终token(句号)的损失贡献:

• 位置11: - 目标token:“.” - “.”的logit:-1.2 - softmax后,“.”的概率:0.11 - 损失贡献:-log(0.11) = 2.21

最终损失通过取这些值的平均值来计算:

(2.30 + 2.99 + 3.91 + 1.08 + ⋯ + 2.21) / 11 = 2.11(假设值)

在训练过程中,目标是最小化这个损失。这涉及改进模型,使其为每个位置的正确目标token分配更高的概率。

训练基于RNN的语言模型的完整代码可以在thelmbook.com/nb/3.1找到。我使用了以下超参数值:emb_dim = 128, num_layers = 2, batch_size = 128, learning_rate = 0.001, 和 num_epochs = 1。

以下是在后期训练步骤中为提示“The President”生成的三个续写:

The President refused to comment on the best news in the five on BBC .

总统一直是一个”非常严重”和”不可接受”的。

总统办公室不是第一次能够带头。